In 2021 lanceerden we AWS ondersteunt proactieve services kader van de AWS Enterprise-ondersteuning plan. Sinds de introductie hebben we honderden klanten geholpen hun workloads te optimaliseren, vangrails te plaatsen en de zichtbaarheid van de kosten en het gebruik van hun machine learning-workloads te verbeteren.

In deze reeks berichten delen we geleerde lessen over het optimaliseren van kosten in Amazon Sage Maker. In dit bericht richten we ons op SageMaker-trainingsbanen.

SageMaker-trainingsbanen

SageMaker-trainingstaken zijn asynchrone batchprocessen met ingebouwde functies voor training en optimalisatie van ML-modellen.

Met SageMaker-trainingstaken kunt u uw eigen algoritme meenemen of kiezen uit meer dan 25 ingebouwde algoritmen. SageMaker ondersteunt verschillende gegevensbronnen en toegangspatronen, gedistribueerde training inclusief heterogene clusters, evenals functies voor experimentbeheer en automatische afstemming van modellen.

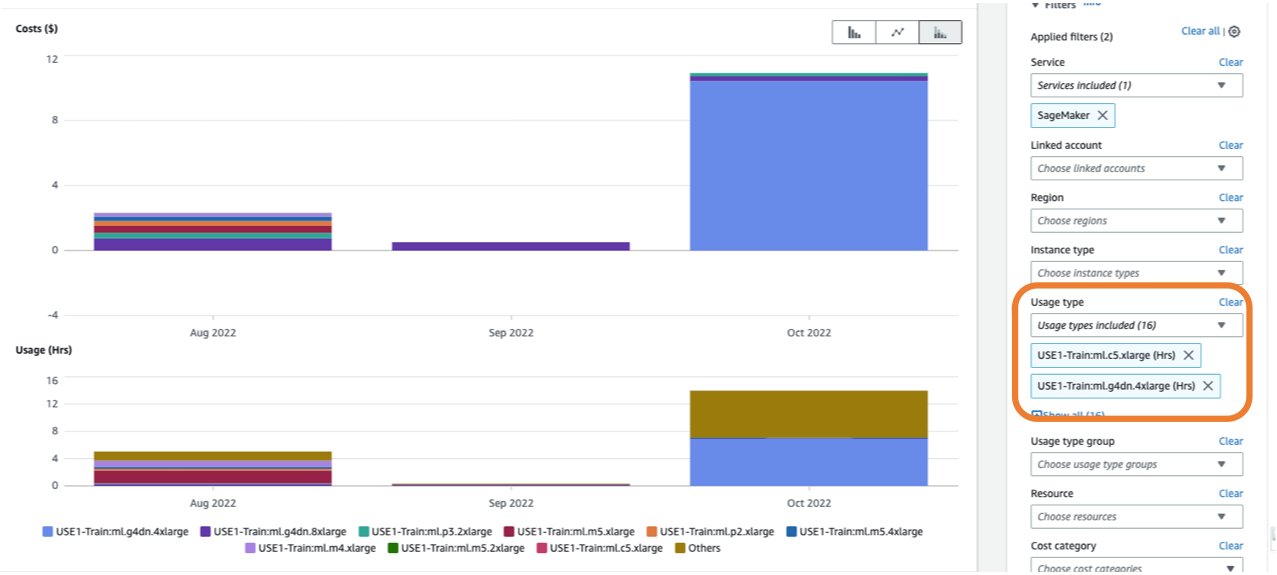

De kosten van een trainingstaak zijn gebaseerd op de bronnen die u gebruikt (exemplaren en opslag) voor de duur (in seconden) dat die instanties worden uitgevoerd. Dit is inclusief de tijd dat de training plaatsvindt en, als je de warm zwembad functie, de keep-alive-periode die u configureert. In Deel 1, hebben we laten zien hoe u aan de slag kunt gaan AWS-kostenverkenner om mogelijkheden voor kostenoptimalisatie in SageMaker te identificeren. U kunt trainingskosten filteren door een filter toe te passen op het gebruikstype. De namen van deze gebruikstypen zijn als volgt:

REGION-Train:instanceType(bijvoorbeeld,USE1-Train:ml.m5.large)REGION-Train:VolumeUsage.gp2(bijvoorbeeld,USE1-Train:VolumeUsage.gp2)

Om een uitsplitsing van uw opleidingskosten in Kostenverkenner te bekijken, kunt u invullen train: als voorvoegsel voor Gebruikstype:. Als u alleen filtert op gebruikte uren (zie de volgende schermafbeelding), genereert Cost Explorer twee grafieken: Cost en Usage. Deze weergave helpt u prioriteit te geven aan uw optimalisatiemogelijkheden en te identificeren welke instanties langlopend en kostbaar zijn.

Voordat u een bestaande trainingstaak optimaliseert, raden we u aan de best practices in te volgen Kosten optimaliseren voor machine learning met Amazon SageMaker: test uw code lokaal en gebruik lokale modus gebruik voor het testen waar mogelijk vooraf getrainde modellen en overweeg Managed Spot Training (wat de kosten tot 90% kan optimaliseren ten opzichte van On-Demand-exemplaren).

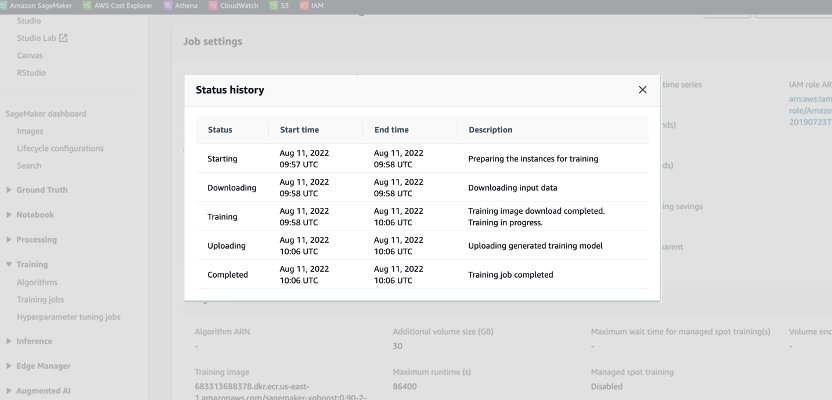

Wanneer een On-Demand-taak wordt gestart, doorloopt deze vijf fasen: starten, downloaden, trainen, uploaden en voltooid. U kunt die fasen en beschrijvingen zien op de pagina met trainingstaken op de SageMaker-console.

Vanuit prijsperspectief worden er kosten in rekening gebracht voor de download-, trainings- en uploadfasen.

Het herzien van deze fasen is een eerste stap om te bepalen waar u uw opleidingskosten kunt optimaliseren. In dit bericht bespreken we de download- en trainingsfasen.

Fase downloaden

In het voorgaande voorbeeld duurde de downloadfase minder dan een minuut. Als het downloaden van gegevens echter een grote factor is in uw trainingskosten, moet u rekening houden met de gegevensbron die u gebruikt en de toegangsmethoden. SageMaker-trainingstaken ondersteunen standaard drie gegevensbronnen: Amazon elastisch bestandssysteem (Amazone EFS), Amazon eenvoudige opslagservice (Amazon S3), en Amazon FSx voor Luster. Voor Amazon S3 biedt SageMaker drie beheerde manieren waarop uw algoritme toegang heeft tot de training: Bestandsmodus (waarbij gegevens worden gedownload naar de instantieblokopslag), Pipe-modus (gegevens worden naar de instantie gestreamd, waardoor de downloadfase wordt geëlimineerd) en Fast File-modus (combineert het gebruiksgemak van de bestaande File-modus met de prestaties van Pipe-modus). Raadpleeg voor gedetailleerde hulp bij het kiezen van de juiste gegevensbron en toegangsmethoden Kies de beste gegevensbron voor uw Amazon SageMaker-trainingstaak.

Bij gebruik van beheerde spottraining worden eventuele herhaalde downloadfasen die zijn opgetreden als gevolg van een onderbreking niet in rekening gebracht (u betaalt dus slechts één keer voor de duur van de gegevensdownload).

Het is belangrijk op te merken dat hoewel SageMaker-trainingstaken de door ons genoemde gegevensbronnen ondersteunen, ze niet verplicht zijn. In uw trainingscode kunt u elke methode implementeren voor het downloaden van de trainingsgegevens van elke bron (op voorwaarde dat de trainingsinstantie er toegang toe heeft). Er zijn andere manieren om de downloadtijd te versnellen, zoals het gebruik van de Boto3 API met multiprocessing om bestanden gelijktijdig te downloaden, of het gebruik van bibliotheken van derden zoals WebDataset of s5cmd voor sneller downloaden van Amazon S3. Voor meer informatie, zie S3-workloads parallel maken met s5cmd.

Trainingsfase

Het optimaliseren van de kosten van de trainingsfase bestaat uit het optimaliseren van twee vectoren: het kiezen van de juiste infrastructuur (instantiefamilie en grootte) en het optimaliseren van de training zelf. We kunnen trainingsinstanties grofweg in twee categorieën verdelen: versnelde GPU-gebaseerd, meestal voor deep-learning-modellen, en CPU-gebaseerd voor algemene ML-frameworks. Raadpleeg voor hulp bij het selecteren van de juiste instantiefamilie voor training Zorg voor efficiënte rekenbronnen op Amazon SageMaker. Als uw training GPU-instanties vereist, raden we u aan de video te raadplegen Hoe u Amazon EC2 GPU-instanties selecteert voor diep leren.

Als algemene leidraad: als uw werklast een NVIDIA GPU vereist, ontdekten we dat klanten aanzienlijke kostenbesparingen behalen met twee Amazon Elastic Compute-cloud (Amazon EC2) instantietypen: ml.g4dn en ml.g5. De ml.g4dn is uitgerust met NVIDIA T4 en biedt bijzonder lage kosten per geheugen. De ml.g5-instantie is uitgerust met NVIDIA A10g Tensor Core en heeft de laagste kosten per CUDA-flop (fp32).

AWS biedt specifieke kostenbesparende functies voor deep learning-trainingen:

Om uw instantie de juiste grootte te geven en te optimaliseren, moet u eerst kijken naar de Amazon Cloud Watch statistieken die de trainingstaken genereren. Voor meer informatie, zie SageMaker-taken en eindpuntstatistieken. U kunt CloudWatch verder gebruiken aangepaste algoritmestatistieken om de trainingsprestaties te volgen.

Deze statistieken kunnen knelpunten of overbevoorrading van resources aangeven. Als u bijvoorbeeld een hoog CPU-gebruik waarneemt met een laag GPU-gebruik, kunt u het probleem oplossen door te gebruiken heterogene clusters. Een ander voorbeeld is het zien van een consistent laag CPU-gebruik gedurende de taakduur. Dit kan leiden tot een kleinere instantie.

Als u gebruik maakt gedistribueerde training, moet u verschillende distributiemethoden testen (toren, Ring-AllReduce, gespiegeld, enzovoort) om het maximale gebruik te valideren en uw raamwerkparameters dienovereenkomstig af te stemmen (zie bijvoorbeeld Best practices voor TensorFlow 1.x acceleratietraining op Amazon SageMaker). Het is belangrijk om te benadrukken dat u de SageMaker-distributie-API en bibliotheken kunt gebruiken SageMaker gedistribueerde gegevens parallel, SageMaker-model parallel en SageMaker Gedeelde gegevens parallel, die zijn geoptimaliseerd voor de AWS-infrastructuur en helpen de trainingskosten te verlagen.

Houd er rekening mee dat gedistribueerde training niet noodzakelijkerwijs lineair wordt geschaald en mogelijk enige overhead met zich meebrengt, wat van invloed is op de algehele runtime.

Voor deep learning-modellen gebruikt een andere optimalisatietechniek gemengde precisie. Gemengde precisie kan de training versnellen, waardoor zowel de trainingstijd als het geheugengebruik worden verminderd met minimale tot geen invloed op de modelnauwkeurigheid. Voor meer informatie, zie de Train met Data Parallel en Model Parallel sectie in Gedistribueerde training in Amazon SageMaker.

Ten slotte kan het optimaliseren van raamwerkspecifieke parameters een aanzienlijke impact hebben op het optimaliseren van het trainingsproces. Automatische afstemming van SageMaker-modellen vindt hyperparameters die het beste presteren, zoals gemeten door een objectieve maatstaf die u kiest. Door de trainingstijd in te stellen als een objectieve maatstaf en een raamwerkconfiguratie als hyperparameters, kunnen knelpunten worden weggenomen en de totale trainingstijd worden verkort. Raadpleeg voor een voorbeeld van het optimaliseren van de standaard TensorFlow-instellingen en het verwijderen van een CPU-bottleneck Aerobotics verbetert de trainingssnelheid met 24 keer per monster met Amazon SageMaker en TensorFlow.

Een andere mogelijkheid om zowel de download- als de verwerkingstijd te optimaliseren, is door te overwegen om te trainen op een subset van uw gegevens. Als uw gegevens bestaan uit meerdere dubbele vermeldingen of functies met weinig informatiewinst, kunt u mogelijk trainen op een subset van gegevens en de download- en trainingstijd verkorten, evenals een kleinere instantie gebruiken en Amazon elastische blokwinkel (Amazon EBS) volume. Zie voor een voorbeeld Gebruik een gegevensgerichte benadering om de hoeveelheid gegevens die nodig is om Amazon SageMaker-modellen te trainen, te minimaliseren. Ook, Amazon SageMaker-gegevens Wrangler kan de analyse en creatie van trainingsmonsters vereenvoudigen. Voor meer informatie, zie Maak willekeurige en gestratificeerde voorbeelden van gegevens met Amazon SageMaker Data Wrangler.

SageMaker-foutopsporing

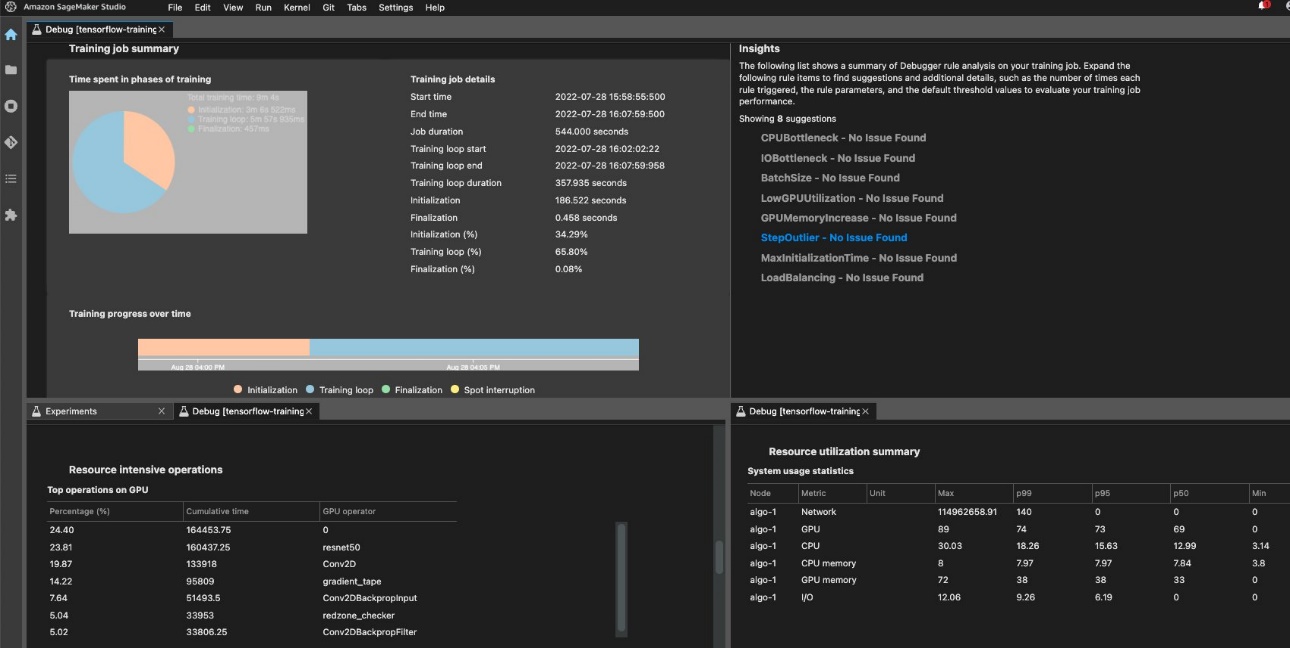

Om efficiënte training en gebruik van middelen te garanderen, kan SageMaker uw trainingstaak profileren met behulp van Amazon SageMaker-foutopsporing. Debugger-aanbiedingen ingebouwde regels om te waarschuwen voor veelvoorkomende problemen die van invloed zijn op uw training, zoals CPU-bottleneck, GPU-geheugentoename of I/O-bottleneck, of u kunt uw eigen regels maken. U kunt het gegenereerde rapport openen en analyseren in Amazon SageMaker Studio. Voor meer informatie, zie: Amazon SageMaker Debugger-gebruikersinterface in Amazon SageMaker Studio-experimenten. De volgende schermafbeelding toont de Debugger-weergave in Studio.

U kunt inzoomen op de Python-operators en -functies (de Topbewerkingen op GPU sectie) die worden uitgevoerd om de trainingstaak uit te voeren. De ingebouwde regels van Debugger voor het profileren van watchframework-operatiegerelateerde problemen, waaronder overmatige trainingsinitialisatietijd als gevolg van het downloaden van gegevens voordat de training begint en uitschieters in de duur van stappen in trainingslussen. Houd er rekening mee dat hoewel het gebruik van de ingebouwde regels gratis is, de kosten voor aangepaste regels van toepassing zijn op basis van de instantie die u configureert voor de duur van de trainingstaak en de opslag die eraan is gekoppeld.

Conclusie

In dit bericht hebben we advies gegeven over kostenanalyse en best practices bij het trainen van ML-modellen met behulp van SageMaker-trainingstaken. Naarmate machine learning zich in alle sectoren als een krachtige tool vestigt, moet training en het uitvoeren van ML-modellen kosteneffectief blijven. SageMaker biedt een brede en diepe functieset om elke stap in de ML-pijplijn te vergemakkelijken en biedt mogelijkheden voor kostenoptimalisatie zonder de prestaties of flexibiliteit te beïnvloeden.

Over de auteurs

Deepali Rajale is een Senior AI/ML-specialist bij AWS. Ze werkt samen met zakelijke klanten en biedt technische begeleiding met best practices voor het implementeren en onderhouden van AI/ML-oplossingen in het AWS-ecosysteem. Ze heeft met een breed scala aan organisaties gewerkt aan verschillende use-cases voor deep learning met NLP en computervisie. Ze is gepassioneerd over het versterken van organisaties om generatieve AI te gebruiken om hun gebruikservaring te verbeteren. In haar vrije tijd houdt ze van films, muziek en literatuur.

Deepali Rajale is een Senior AI/ML-specialist bij AWS. Ze werkt samen met zakelijke klanten en biedt technische begeleiding met best practices voor het implementeren en onderhouden van AI/ML-oplossingen in het AWS-ecosysteem. Ze heeft met een breed scala aan organisaties gewerkt aan verschillende use-cases voor deep learning met NLP en computervisie. Ze is gepassioneerd over het versterken van organisaties om generatieve AI te gebruiken om hun gebruikservaring te verbeteren. In haar vrije tijd houdt ze van films, muziek en literatuur.

Uri Rosenberg is de AI & ML Specialist Technical Manager voor Europa, het Midden-Oosten en Afrika. Uri is gevestigd in Israël en werkt om zakelijke klanten in staat te stellen alles wat met ML te maken heeft, te ontwerpen, bouwen en op schaal te gebruiken. In zijn vrije tijd houdt hij van fietsen, wandelen en toenemende entropie.

Uri Rosenberg is de AI & ML Specialist Technical Manager voor Europa, het Midden-Oosten en Afrika. Uri is gevestigd in Israël en werkt om zakelijke klanten in staat te stellen alles wat met ML te maken heeft, te ontwerpen, bouwen en op schaal te gebruiken. In zijn vrije tijd houdt hij van fietsen, wandelen en toenemende entropie.

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoAiStream. Web3 gegevensintelligentie. Kennis versterkt. Toegang hier.

- De toekomst slaan met Adryenn Ashley. Toegang hier.

- Koop en verkoop aandelen in PRE-IPO-bedrijven met PREIPO®. Toegang hier.

- Bron: https://aws.amazon.com/blogs/machine-learning/part-4-analyze-amazon-sagemaker-spend-and-determine-cost-optimization-opportunities-based-on-usage-part-4-training-jobs/

- : heeft

- :is

- :niet

- :waar

- $UP

- 1

- 100

- 2021

- 24

- 7

- a

- in staat

- Over

- versneld

- toegang

- dienovereenkomstig

- nauwkeurigheid

- over

- Extra

- adres

- invloed hebben op

- die van invloed

- Afrika

- AI

- AI / ML

- Alarm

- algoritme

- algoritmen

- Alles

- ook

- Hoewel

- Amazone

- Amazon EC2

- Amazon Sage Maker

- Amazon SageMaker Studio

- Amazon Web Services

- bedragen

- an

- analyse

- analyseren

- en

- Nog een

- elke

- api

- Solliciteer

- Het toepassen van

- nadering

- ZIJN

- AS

- At

- Automatisch

- AWS

- gebaseerde

- BE

- vaardigheden

- BEST

- 'best practices'

- Groot

- Blok

- zowel

- Storing

- brengen

- bouw

- ingebouwd

- by

- CAN

- gevallen

- categorieën

- opgeladen

- Kies

- het kiezen van

- code

- combines

- Gemeen

- Voltooid

- Berekenen

- computer

- Computer visie

- Configuratie

- Overwegen

- consequent

- bestaat uit

- troosten

- Kern

- Kosten

- kostenbesparingen

- kostenefficient

- kostbaar

- Kosten

- bedekt

- en je merk te creëren

- het aanmaken

- gewoonte

- Klanten

- gegevens

- deep

- diepgaand leren

- Standaard

- het inzetten

- Design

- gedetailleerd

- Bepalen

- anders

- bespreken

- verdeeld

- gedistribueerde training

- distributie

- doet

- Nee

- beneden

- Download

- twee

- duur

- elk

- gemak

- makkelijk te gebruiken

- oosten

- ecosysteem

- doeltreffend

- elimineren

- machtigen

- empowering

- Endpoint

- verhogen

- verzekeren

- Enter

- Enterprise

- uitgerust

- vestigt

- Europa

- voorbeeld

- bestaand

- ervaring

- experiment

- ontdekkingsreiziger

- faciliterende

- factor

- familie

- SNELLE

- sneller

- Kenmerk

- Voordelen

- Dien in

- Bestanden

- filter

- vondsten

- Voornaam*

- First Look

- Focus

- volgend

- volgt

- Voor

- gevonden

- Achtergrond

- frameworks

- Gratis

- oppompen van

- functies

- verder

- Krijgen

- Algemeen

- voortbrengen

- gegenereerde

- het genereren van

- generatief

- generatieve AI

- krijgen

- Goes

- GPU

- GPU's

- grafieken

- leiding

- Hebben

- he

- hulp

- geholpen

- haar

- Hoge

- Markeer

- zijn

- HOURS

- Hoe

- How To

- Echter

- HTML

- http

- HTTPS

- Honderden

- identificeren

- if

- Impact

- impact

- uitvoeren

- belangrijk

- verbeteren

- in

- omvat

- Inclusief

- Laat uw omzet

- meer

- aangeven

- industrieën

- informatie

- Infrastructuur

- instantie

- in

- voorstellen

- Introductie

- waarbij

- Israël

- kwestie

- problemen

- IT

- HAAR

- zelf

- Jobomschrijving:

- Vacatures

- jpg

- Houden

- gelanceerd

- leiden

- geleerd

- leren

- minder

- Lessen

- Lessons Learned

- Hefboomwerking

- bibliotheken

- als

- literatuur

- plaatselijk

- Kijk

- Laag

- laagste

- machine

- machine learning

- Het handhaven

- beheerd

- management

- manager

- verplicht

- maximaal

- Geheugen

- vermeld

- methode

- methoden

- metriek

- Metriek

- Midden

- Midden-Oosten

- macht

- minimaal

- minuut

- gemengd

- ML

- Mode

- model

- modellen

- monitor

- meer

- meestal

- Films

- meervoudig

- Muziek

- namen

- nodig

- behoeften

- nlp

- geen

- Nvidia

- doel van de persoon

- opgetreden

- of

- Aanbod

- on

- On-Demand

- EEN

- Slechts

- besturen

- Operations

- exploitanten

- Kansen

- kansen

- optimalisatie

- Optimaliseer

- geoptimaliseerde

- optimaliseren

- or

- bestellen

- organisaties

- uit

- over

- totaal

- het te bezitten.

- pagina

- Parallel

- parameters

- deel

- vooral

- hartstochtelijk

- patronen

- Uitvoeren

- prestatie

- periode

- perspectief

- fase

- pijp

- pijpleiding

- plaats

- plan

- Plato

- Plato gegevensintelligentie

- PlatoData

- zwembad

- mogelijk

- Post

- Berichten

- krachtige

- praktijken

- precisie

- prijsstelling

- prioriteren

- Proactieve

- processen

- verwerking

- Profiel

- profilering

- mits

- biedt

- het verstrekken van

- Python

- willekeurige

- reeks

- adviseren

- verminderen

- vermindering

- blijven

- verwijderen

- het verwijderen van

- herhaald

- verslag

- vereisen

- nodig

- vereist

- hulpbron

- Resources

- rechts

- ruw

- reglement

- lopen

- lopend

- sagemaker

- besparing

- Bespaar geld

- Scale

- seconden

- sectie

- zien

- te zien

- selecteren

- senior

- -Series

- Diensten

- reeks

- het instellen van

- settings

- versnipperd

- Delen

- ze

- moet

- vertoonde

- Shows

- aanzienlijke

- Eenvoudig

- vereenvoudigen

- sinds

- Maat

- kleinere

- So

- Oplossingen

- sommige

- bron

- bronnen

- specialist

- specifiek

- snelheid

- besteden

- Spot

- gestart

- Start

- starts

- Stap voor

- mediaopslag

- gestreamd

- studio

- dergelijk

- ondersteuning

- proactief ondersteunen

- steunen

- neemt

- Technisch

- tensorflow

- proef

- Testen

- neem contact

- dat

- De

- hun

- Er.

- daarbij

- Deze

- ze

- spullen

- van derden

- dit

- die

- drie

- Door

- overal

- niet de tijd of

- keer

- naar

- nam

- tools

- Tower

- Trainen

- Trainingen

- twee

- type dan:

- types

- ui

- Uploaden

- Gebruik

- .

- gebruikt

- gebruik

- BEVESTIG

- divers

- Video

- Bekijk

- zichtbaarheid

- visie

- volume

- Bekijk de introductievideo

- manieren

- we

- web

- webservices

- GOED

- wanneer

- welke

- breed

- Grote range

- wil

- Met

- zonder

- werkte

- Bedrijven

- X

- You

- Your

- youtube

- zephyrnet