Introductie

Bij machine learning is de wisselwerking tussen bias en variantie een fundamenteel concept dat de prestaties van elk voorspellend model beïnvloedt. Het verwijst naar de delicate balans tussen vertekeningsfout en variantiefout van een model, aangezien het onmogelijk is om beide tegelijkertijd te minimaliseren. Het vinden van de juiste balans is cruciaal voor het bereiken van optimale modelprestaties.

In dit korte artikel definiëren we bias en variantie, leggen we uit hoe ze een machine learning-model beïnvloeden en geven we praktisch advies over hoe hiermee in de praktijk om te gaan.

Bias en variantie begrijpen

Laten we, voordat we ingaan op de relatie tussen bias en variantie, definiëren wat deze termen vertegenwoordigen in machine learning.

Biasfout verwijst naar het verschil tussen de voorspelling van een model en de juiste waarden die het probeert te voorspellen (grondwaarheid). Met andere woorden, bias is de fout die een model begaat als gevolg van onjuiste aannames over de onderliggende gegevensdistributie. High bias-modellen zijn vaak te simplistisch en slagen er niet in de complexiteit van de gegevens vast te leggen, wat leidt tot onderfitting.

Variantiefout daarentegen verwijst naar de gevoeligheid van het model voor kleine fluctuaties in de trainingsgegevens. Modellen met hoge variantie zijn te complex en hebben de neiging om in de ruis in de gegevens te passen in plaats van in het onderliggende patroon, wat leidt tot overfitting. Dit resulteert in slechte prestaties op nieuwe, ongeziene gegevens.

Hoge bias kan leiden tot underfitting, waarbij het model te eenvoudig is om de complexiteit van de gegevens vast te leggen. Het maakt sterke aannames over de gegevens en slaagt er niet in om de ware relatie tussen invoer- en uitvoervariabelen vast te leggen. Aan de andere kant kan een hoge variantie leiden tot overfitting, waarbij het model te complex is en de ruis in de gegevens leert in plaats van de onderliggende relatie tussen input- en outputvariabelen. Overfitting-modellen hebben dus de neiging om de trainingsgegevens te nauw aan te sluiten en zullen niet goed generaliseren naar nieuwe gegevens, terwijl underfitting-modellen niet eens in staat zijn om de trainingsgegevens nauwkeurig aan te passen.

Zoals eerder vermeld, zijn vertekening en variantie gerelateerd, en een goed model balanceert tussen vertekeningsfout en variantiefout. De wisselwerking tussen bias en variantie is het proces van het vinden van de optimale balans tussen deze twee bronnen van fouten. Een model met lage bias en lage variantie zal waarschijnlijk goed presteren op zowel training als nieuwe gegevens, waardoor de totale fout wordt geminimaliseerd.

De wisselwerking tussen bias en variantie

Het bereiken van een balans tussen de complexiteit van het model en het vermogen om te generaliseren naar onbekende gegevens is de kern van de wisselwerking tussen bias en variantie. Over het algemeen zal een complexer model een lagere vertekening maar een hogere variantie hebben, terwijl een eenvoudiger model een hogere vertekening maar een lagere variantie zal hebben.

Aangezien het onmogelijk is om vertekening en variantie tegelijkertijd te minimaliseren, is het vinden van de optimale balans daartussen cruciaal bij het bouwen van een robuust machine learning-model. Als we bijvoorbeeld de complexiteit van een model vergroten, vergroten we ook de variantie. Dit komt omdat een complexer model waarschijnlijker past bij de ruis in de trainingsgegevens, wat zal leiden tot overfitting.

Aan de andere kant, als we het model te simpel houden, vergroten we de bias. Dit komt omdat een eenvoudiger model niet in staat zal zijn om de onderliggende relaties in de gegevens vast te leggen, wat zal leiden tot onderfitting.

Het doel is om een model te trainen dat complex genoeg is om de onderliggende relaties in de trainingsgegevens vast te leggen, maar niet zo complex dat het past bij de ruis in de trainingsgegevens.

Bias-variantie-afweging in de praktijk

Om modelprestaties te diagnosticeren, berekenen en vergelijken we doorgaans de trein- en validatiefouten. Een handig hulpmiddel om dit te visualiseren is een plot van de leercurves, die de prestaties van het model op zowel de trein als validatiegegevens tijdens het trainingsproces weergeeft. Door deze curven te onderzoeken, kunnen we bepalen of een model overfitting (hoge variantie), onderfitting (hoge bias) of goed passend (optimale balans tussen bias en variantie) is.

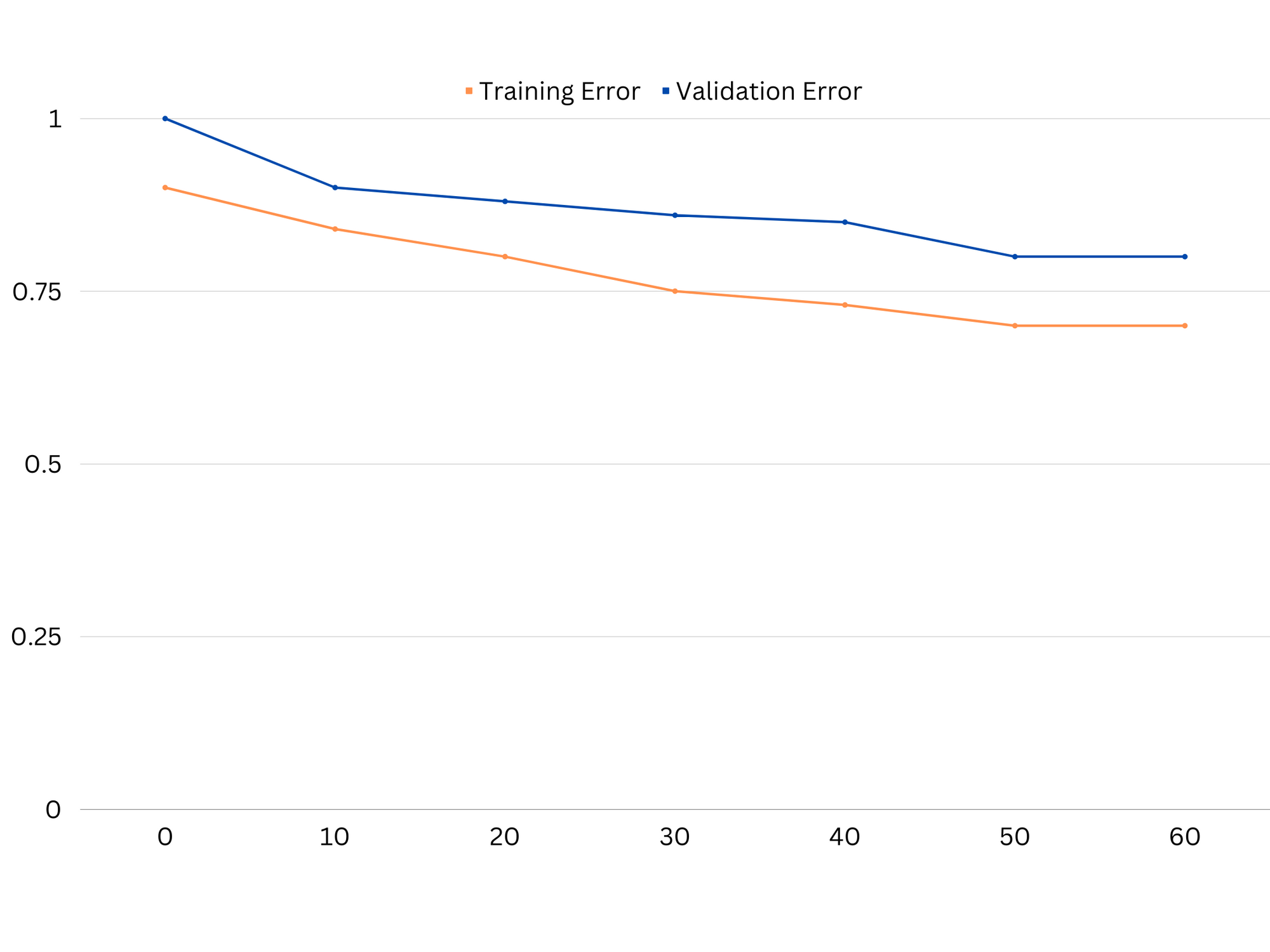

Voorbeeld van leercurven van een ondermaats model. Zowel de treinfout als de validatiefout zijn hoog.

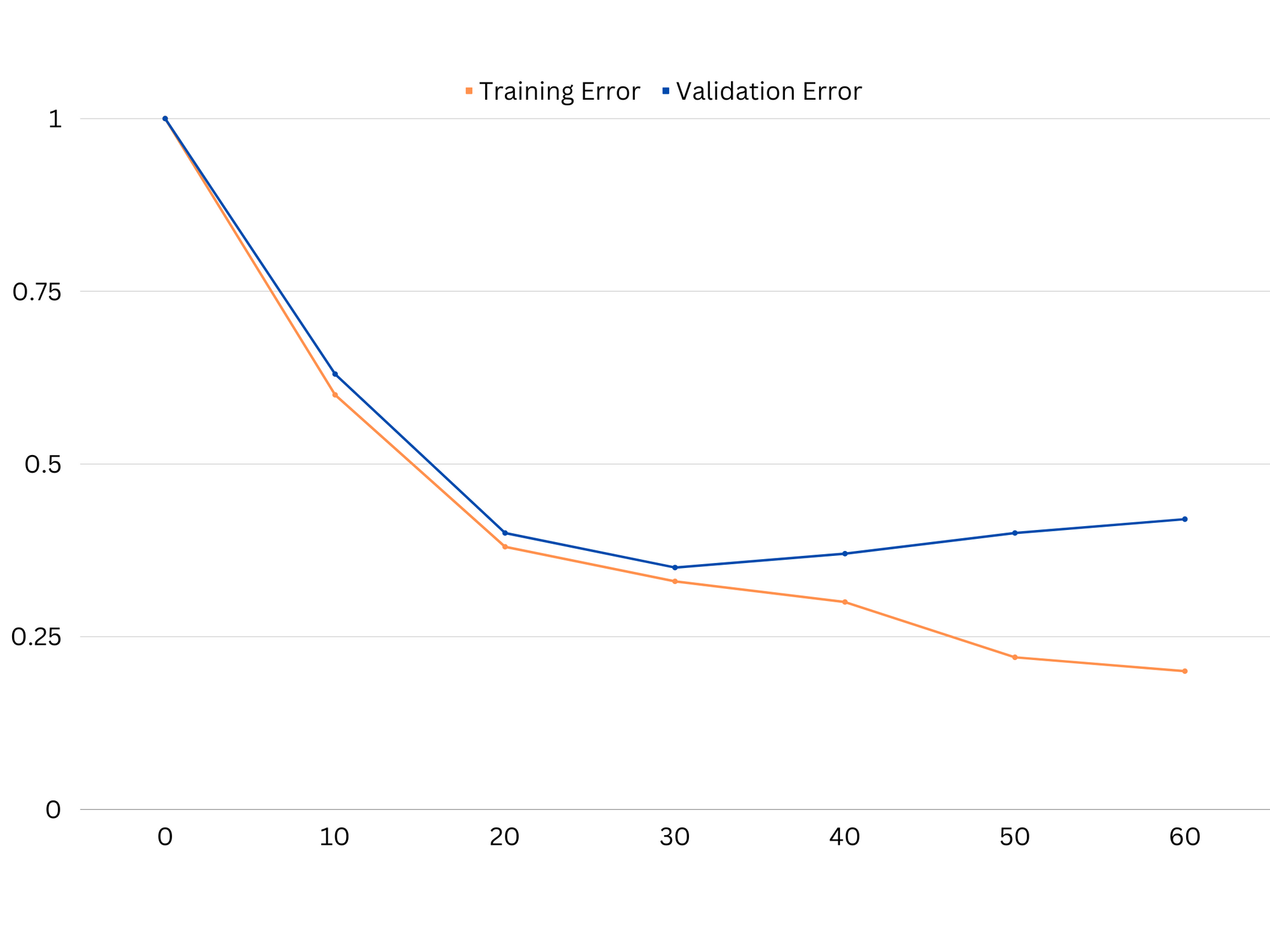

In de praktijk suggereren lage prestaties op zowel trainings- als validatiegegevens dat het model te simpel is, wat leidt tot ondergeschiktheid. Aan de andere kant, als het model zeer goed presteert op de trainingsgegevens maar slecht op de testgegevens, is de modelcomplexiteit waarschijnlijk te hoog, wat resulteert in overfitting. Om underfitting aan te pakken, kunnen we proberen de modelcomplexiteit te vergroten door meer functies toe te voegen, het leeralgoritme te wijzigen of andere hyperparameters te kiezen. In het geval van overfitting moeten we overwegen het model te regulariseren of technieken zoals kruisvalidatie te gebruiken om de generalisatiemogelijkheden te verbeteren.

Voorbeeld van leercurven van een overfittingmodel. De treinfout neemt af terwijl de validatiefout begint toe te nemen. Het model kan niet generaliseren.

Regularisatie is een techniek die kan worden gebruikt om de variantiefout in machine learning-modellen te verminderen, waardoor de wisselwerking tussen bias en variantie kan worden aangepakt. Er zijn een aantal verschillende regularisatietechnieken, elk met hun eigen voor- en nadelen. Enkele populaire regularisatietechnieken zijn nokregressie, lassoregressie en elastische netregularisatie. Al deze technieken helpen overfitting te voorkomen door een strafterm toe te voegen aan de objectieve functie van het model, wat extreme parameterwaarden ontmoedigt en eenvoudigere modellen aanmoedigt.

Ridge regressie, ook bekend als L2-regularisatie, voegt een strafterm toe die evenredig is met het kwadraat van de modelparameters. Deze techniek resulteert meestal in modellen met kleinere parameterwaarden, wat kan leiden tot verminderde variantie en verbeterde generalisatie. Het voert echter geen kenmerkselectie uit, dus alle kenmerken blijven in het model.

Bekijk onze praktische, praktische gids voor het leren van Git, met best-practices, door de industrie geaccepteerde normen en bijgevoegd spiekbriefje. Stop met Googlen op Git-commando's en eigenlijk leren het!

lasso-regressie, of L1-regularisatie, voegt een strafterm toe die evenredig is met de absolute waarde van de modelparameters. Deze techniek kan leiden tot modellen met schaarse parameterwaarden, waardoor kenmerkselectie effectief wordt uitgevoerd door sommige parameters op nul te zetten. Dit kan resulteren in eenvoudigere modellen die gemakkelijker te interpreteren zijn.

Elastische netregularisatie is een combinatie van zowel L1- als L2-regularisatie, waardoor een evenwicht tussen nok- en lasso-regressie mogelijk is. Door de verhouding tussen de twee straftermen te regelen, kan elastisch net de voordelen van beide technieken bereiken, zoals verbeterde generalisatie en kenmerkselectie.

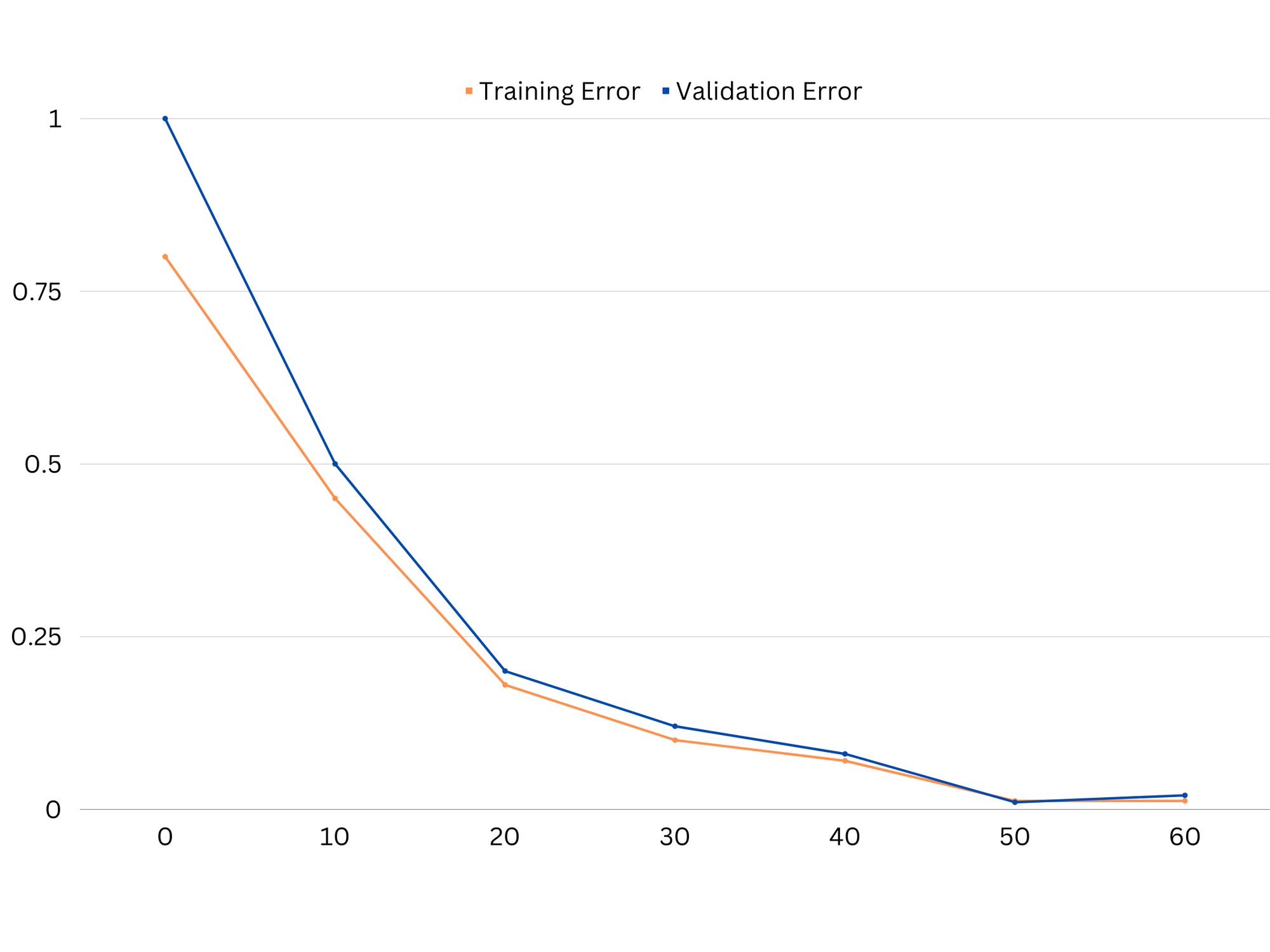

Voorbeeld van leercurves van een goed passend model.

Conclusies

De wisselwerking tussen bias en variantie is een cruciaal concept in machine learning dat de effectiviteit en goedheid van een model bepaalt. Hoewel hoge bias leidt tot onderfitting en hoge variantie tot overfitting, is het vinden van de optimale balans tussen beide noodzakelijk voor het bouwen van robuuste modellen die goed generaliseren naar nieuwe gegevens.

Met behulp van leercurves is het mogelijk om overfitting- of underfittingproblemen te identificeren, en door de complexiteit van het model af te stemmen of regularisatietechnieken te implementeren, is het mogelijk om de prestaties op zowel trainings- en validatiegegevens als testgegevens te verbeteren.

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoAiStream. Web3 gegevensintelligentie. Kennis versterkt. Toegang hier.

- De toekomst slaan met Adryenn Ashley. Toegang hier.

- Koop en verkoop aandelen in PRE-IPO-bedrijven met PREIPO®. Toegang hier.

- Bron: https://stackabuse.com/the-bias-variance-trade-off-in-machine-learning/

- :is

- :niet

- :waar

- 1

- 12

- 20

- 8

- a

- vermogen

- in staat

- Over

- absoluut

- nauwkeurig

- Bereiken

- het bereiken van

- werkelijk

- toe te voegen

- adres

- Voegt

- voordelen

- advies

- invloed hebben op

- die van invloed

- algoritme

- Alles

- Het toestaan

- ook

- an

- en

- elke

- ZIJN

- dit artikel

- AS

- Balance

- saldi

- BE

- omdat

- betekent

- tussen

- vooringenomenheid

- grens

- zowel

- Gebouw

- maar

- by

- berekenen

- CAN

- mogelijkheden

- vangen

- geval

- veranderende

- het kiezen van

- van nabij

- combinatie van

- vergelijken

- complex

- ingewikkeldheid

- concept

- Overwegen

- het regelen van

- Kern

- te corrigeren

- cruciaal

- gegevens

- transactie

- vermindert

- Bepalen

- bepaalt

- verschil

- anders

- displays

- distributie

- doet

- twee

- elk

- Vroeger

- gemakkelijker

- effectief

- effectiviteit

- moedigt

- genoeg

- fout

- fouten

- Zelfs

- Onderzoeken

- voorbeeld

- Verklaren

- extreem

- bij gebreke

- mislukt

- Kenmerk

- Voordelen

- het vinden van

- geschikt

- fitting

- schommelingen

- Focus

- Voor

- functie

- fundamenteel

- Algemeen

- Git

- doel

- goed

- Ground

- gids

- hand

- hands-on

- Hebben

- hulp

- het helpen van

- Hoge

- hoger

- zweven

- Hoe

- How To

- Echter

- HTTPS

- identificeren

- if

- uitvoering

- onmogelijk

- verbeteren

- verbeterd

- in

- Anders

- omvatten

- inclusief

- Laat uw omzet

- meer

- invoer

- in

- Introductie

- IT

- HAAR

- Houden

- bekend

- L1

- l2

- leiden

- leidend

- Leads

- leren

- laten

- LG

- als

- Waarschijnlijk

- ll

- Laag

- te verlagen

- machine

- machine learning

- MERKEN

- vermeld

- minimaliseren

- model

- modellen

- meer

- noodzakelijk

- netto

- New

- Geluid

- aantal

- doel van de persoon

- of

- vaak

- on

- optimale

- or

- Overige

- onze

- uit

- uitgang

- het te bezitten.

- parameter

- parameters

- Patronen

- Uitvoeren

- prestatie

- uitvoerend

- presteert

- Plato

- Plato gegevensintelligentie

- PlatoData

- arm

- Populair

- mogelijk

- PRAKTISCH

- praktijk

- voorspellen

- voorspelling

- voorkomen

- problemen

- zorgen voor

- liever

- verhouding

- verminderen

- Gereduceerd

- verwijst

- verwant

- verwantschap

- Relaties

- blijven

- vertegenwoordigen

- resultaat

- verkregen

- Resultaten

- rechts

- Ring

- robuust

- s

- selectie

- Gevoeligheid

- het instellen van

- Shadow

- vel

- Bermuda's

- moet

- Eenvoudig

- gelijktijdig

- Klein

- kleinere

- So

- sommige

- bronnen

- vierkant

- Stapelmisbruik

- normen

- stop

- sterke

- dergelijk

- Stelt voor

- technieken

- termijn

- termen

- proef

- neem contact

- dat

- De

- hun

- Ze

- Er.

- Deze

- ze

- dit

- overal

- naar

- ook

- tools

- Totaal

- Trainen

- Trainingen

- overgang

- waar

- waarheid

- proberen

- twee

- typisch

- niet in staat

- die ten grondslag liggen

- onbekend

- gebruikt

- gebruik

- bevestiging

- waarde

- Values

- zeer

- we

- GOED

- Wat

- of

- welke

- en

- wil

- Met

- woorden

- zephyrnet

- nul