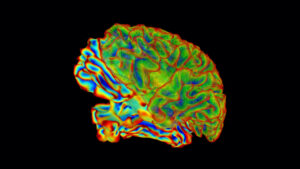

Taal en spraak zijn hoe we onze innerlijke gedachten uitdrukken. Maar neurowetenschappers hebben net de behoefte aan hoorbare spraak omzeild, althans in het laboratorium. In plaats daarvan maakten ze rechtstreeks gebruik van de biologische machine die taal en ideeën genereert: de hersenen.

Met behulp van hersenscans en een flinke dosis machinaal leren ontwikkelde een team van de Universiteit van Texas in Austin een 'taaldecoder' die de kern vastlegt van wat een persoon hoort, alleen op basis van hun hersenactiveringspatronen. Verre van een one-trick pony, kan de decoder ook ingebeelde spraak vertalen en zelfs beschrijvende ondertitels genereren voor stomme films met behulp van neurale activiteit.

Hier is de kicker: de methode vereist geen operatie. In plaats van te vertrouwen op geïmplanteerde elektroden, die luisteren naar elektrische uitbarstingen rechtstreeks van neuronen, gebruikt de neurotechnologie functionele magnetische resonantiebeeldvorming (fMRI), een volledig niet-invasieve procedure, om hersenkaarten te genereren die overeenkomen met taal.

Voor alle duidelijkheid, de technologie is niet gedachtenlezen. In elk geval produceert de decoder parafrases die het algemene idee van een zin of alinea weergeven. Het reproduceert niet elk afzonderlijk woord. Maar dat is ook de kracht van de decoder.

"We denken dat de decoder iets diepers vertegenwoordigt dan talen", zei hoofdonderzoeksauteur Dr. Alexander Huth in een persconferentie. "We kunnen het algemene idee herstellen ... en zien hoe het idee evolueert, zelfs als de exacte woorden verloren gaan."

De studie, deze week gepubliceerd in Nature Neuroscience, vertegenwoordigt een krachtige eerste stap naar niet-invasief hersen-machine-interfaces voor het decoderen van taal - een notoir moeilijk probleem. Met verdere ontwikkeling zou de technologie degenen die het vermogen om te spreken hebben verloren, kunnen helpen hun vermogen om met de buitenwereld te communiceren terug te krijgen.

Het werk opent ook nieuwe wegen om te leren hoe taal in de hersenen wordt gecodeerd, en voor AI-wetenschappers om in de "zwarte doos" van machine learning-modellen te graven die spraak en taal verwerken.

"Het zat er lang aan te komen ... we waren nogal geschokt dat dit zo goed werkte als het doet", zei Huth.

Decodeertaal

Het vertalen van hersenactiviteit naar spraak is niet nieuw. Een eerdere studie gebruikte elektroden rechtstreeks in de hersenen van patiënten met verlamming. Door te luisteren naar het elektrische geratel van de neuronen, kon het team de volledige woorden van de patiënt reconstrueren.

Huth besloot een alternatieve, zij het gedurfde, route te nemen. In plaats van te vertrouwen op neurochirurgie, koos hij voor een niet-invasieve benadering: fMRI.

"De verwachting onder neurowetenschappers in het algemeen dat je dit soort dingen kunt doen met fMRI is vrij laag", zegt Huth.

Er zijn genoeg redenen. In tegenstelling tot implantaten die rechtstreeks gebruikmaken van neurale activiteit, meet fMRI hoe het zuurstofgehalte in het bloed verandert. Dit wordt het BOLD-signaal genoemd. Omdat actievere hersengebieden meer zuurstof nodig hebben, fungeren BOLD-reacties als een betrouwbare proxy voor neurale activiteit. Maar het komt met problemen. De signalen zijn traag in vergelijking met het meten van elektrische bursts en de signalen kunnen ruis bevatten.

Toch heeft fMRI een enorm voordeel in vergelijking met hersenimplantaten: het kan de hele hersenen met hoge resolutie bewaken. Vergeleken met het verzamelen van gegevens van een goudklompje in één regio, biedt het een overzicht in vogelvlucht van cognitieve functies op een hoger niveau, waaronder taal.

Met het decoderen van taal maakten de meeste eerdere onderzoeken gebruik van de motorische cortex, een gebied dat bepaalt hoe de mond en het strottenhoofd bewegen om spraak te genereren, of meer "oppervlakteniveau" in taalverwerking voor articulatie. Het team van Huth besloot één abstractie hoger te gaan: het rijk van gedachten en ideeën.

In het onbekende

Het team realiseerde zich vanaf het begin dat ze twee dingen nodig hadden. Ten eerste een dataset van hoogwaardige hersenscans om de decoder te trainen. Twee, een machine learning-framework om de gegevens te verwerken.

Om de hersenkaartdatabase te genereren, lieten zeven vrijwilligers hun hersenen herhaaldelijk scannen terwijl ze luisterden naar podcastverhalen terwijl hun neurale activiteit werd gemeten in een MRI-machine. In een gigantische, luidruchtige magneet liggen is voor niemand leuk, en het team zorgde ervoor dat de vrijwilligers geïnteresseerd en alert bleven, aangezien aandacht een rol speelt bij het decoderen.

Voor elke persoon werd de resulterende enorme dataset ingevoerd in een raamwerk dat werd aangedreven door machine learning. Dankzij de recente explosie van machine learning-modellen die helpen bij het verwerken van natuurlijke taal, kon het team die middelen benutten en de decoder gemakkelijk bouwen.

Het heeft meerdere componenten. De eerste is een coderingsmodel dat gebruikmaakt van de originele GPT, de voorloper van de immens populaire ChatGPT. Het model neemt elk woord en voorspelt hoe de hersenen zullen reageren. Hier heeft het team GPT verfijnd met in totaal meer dan 200 miljoen woorden uit Reddit-opmerkingen en podcasts.

Dit tweede deel maakt gebruik van een populaire techniek in machine learning genaamd Bayesiaanse decodering. Het algoritme raadt het volgende woord op basis van een eerdere reeks en gebruikt het geraden woord om de daadwerkelijke reactie van de hersenen te controleren.

Een podcastaflevering had bijvoorbeeld 'mijn vader heeft het niet nodig...' als verhaallijn. Toen het als prompt in de decoder werd ingevoerd, kwam het met mogelijke antwoorden: "veel", "goed", "sinds", enzovoort. Door de voorspelde hersenactiviteit van elk woord te vergelijken met die van het daadwerkelijke woord, kon de decoder de hersenactiviteitspatronen van elke persoon aanscherpen en fouten corrigeren.

Na het herhalen van het proces met de best voorspelde woorden, leerde het decoderingsaspect van het programma uiteindelijk de unieke "neurale vingerafdruk" van elke persoon voor hoe ze taal verwerken.

Een neurovertaler

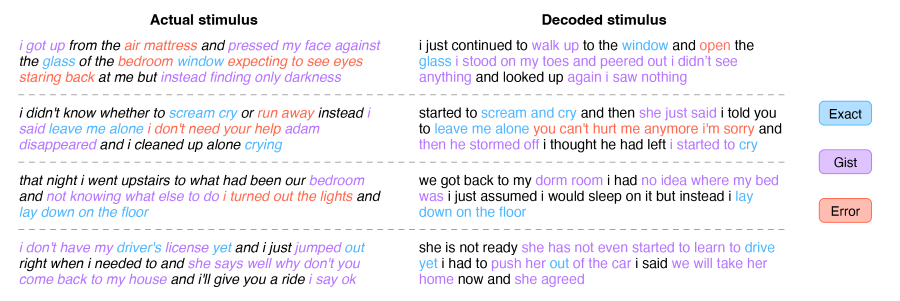

Als proof of concept heeft het team de gedecodeerde antwoorden vergeleken met de eigenlijke verhaaltekst.

Het kwam verrassend dichtbij, maar alleen voor de algemene kern. Een verhaallijn, "we beginnen verhalen uit te wisselen over ons leven, we komen allebei uit het noorden", werd bijvoorbeeld gedecodeerd als "we begonnen te praten over onze ervaringen in het gebied waarin hij werd geboren, ik kwam uit het noorden."

Deze parafrasering wordt verwacht, legt Huth uit. Omdat fMRI nogal luidruchtig en traag is, is het bijna onmogelijk om elk woord vast te leggen en te decoderen. De decoder krijgt een mengelmoes van woorden en moet hun betekenissen ontwarren met behulp van functies zoals zinswendingen.

Ideeën daarentegen zijn meer permanent en veranderen relatief langzaam. Omdat fMRI een vertraging heeft bij het meten van neurale activiteit, legt het abstracte concepten en gedachten beter vast dan specifieke woorden.

Deze aanpak op hoog niveau heeft voordelen. Hoewel de decoder niet getrouw is, legt hij een hoger niveau van taalrepresentatie vast dan eerdere pogingen, ook voor taken die niet beperkt zijn tot alleen spraak. In één test keken de vrijwilligers zonder enig geluid naar een geanimeerde clip van een meisje dat werd aangevallen door draken. Met alleen hersenactiviteit beschreef de decoder de scène vanuit het perspectief van de hoofdrolspeler als een op tekst gebaseerd verhaal. Met andere woorden, de decoder was in staat om visuele informatie rechtstreeks te vertalen in een verhaal op basis van een weergave van taal die is gecodeerd in hersenactiviteit.

Evenzo reconstrueerde de decoder ook ingebeelde verhalen van één minuut van de vrijwilligers.

Na meer dan tien jaar aan de technologie te hebben gewerkt, "was het schokkend en opwindend toen het eindelijk werkte", zei Huth.

Hoewel de decoder niet bepaald gedachten leest, was het team voorzichtig met het beoordelen van de mentale privacy. In een reeks tests ontdekten ze dat de decoder alleen werkte met de actieve mentale deelname van de vrijwilligers. Door deelnemers te vragen om zeven te tellen, verschillende dieren een naam te geven of mentaal hun eigen verhalen te construeren, degradeerde de decoder snel, zei eerste auteur Jerry Tang. Met andere woorden, de decoder kan "bewust worden weerstaan".

Voorlopig werkt de technologie pas na maanden van zorgvuldige hersenscans in een luid zoemende machine terwijl hij volkomen stil ligt – nauwelijks haalbaar voor klinisch gebruik. Het team werkt aan het vertalen van de technologie naar fNIRS (functionele nabij-infraroodspectroscopie), dat het zuurstofniveau in het bloed in de hersenen meet. Hoewel het een lagere resolutie heeft dan fMRI, is fNIRS veel draagbaarder, omdat de belangrijkste hardware een badmutsachtig apparaat is dat gemakkelijk onder een hoodie past.

“Met aanpassingen zouden we de huidige opzet moeten kunnen vertalen naar fNIRS-groothandel”, aldus Huth.

Het team is ook van plan nieuwere taalmodellen te gebruiken om de nauwkeurigheid van de decoder te vergroten en mogelijk verschillende talen te overbruggen. Omdat talen een gedeelde neurale representatie in de hersenen hebben, zou de decoder in theorie de ene taal kunnen coderen en de neurale signalen kunnen gebruiken om deze in een andere taal te decoderen.

Het is een "opwindende toekomstige richting", zei Huth.

Krediet van het beeld: Jerry Tang/Martha Morales/De Universiteit van Texas in Austin

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoAiStream. Web3 gegevensintelligentie. Kennis versterkt. Toegang hier.

- De toekomst slaan met Adryenn Ashley. Toegang hier.

- Bron: https://singularityhub.com/2023/05/02/this-brain-activity-decoder-translates-ideas-into-text-using-only-scans/

- : heeft

- :is

- :niet

- $UP

- 200

- a

- vermogen

- in staat

- Over

- SAMENVATTING

- abstractie

- nauwkeurigheid

- Handelen

- Activering

- actieve

- activiteit

- Na

- tegen

- AI

- Alarm

- Alexander

- algoritme

- alleen

- ook

- alternatief

- Hoewel

- onder

- an

- en

- dieren

- Nog een

- elke

- iedereen

- nadering

- ZIJN

- GEBIED

- AS

- verschijning

- At

- pogingen

- aandacht

- austin

- auteur

- gebaseerde

- Bayesian

- BE

- omdat

- wezen

- BEST

- Betere

- bloed

- pin

- boost

- geboren

- zowel

- Hersenen

- Hersenactiviteit

- BRUG

- Briefing

- bouw

- maar

- by

- Dit betekent dat we onszelf en onze geliefden praktisch vergiftigen.

- kwam

- CAN

- vangen

- captures

- verzorging

- voorzichtig

- geval

- verandering

- ChatGPT

- controle

- duidelijk

- Klinisch

- Sluiten

- cognitieve

- komt

- opmerkingen

- communiceren

- vergeleken

- vergelijken

- compleet

- componenten

- concept

- concepten

- bouwen

- contrast

- controles

- te corrigeren

- kon

- Credits

- Actueel

- Pa

- gegevens

- Database

- decennium

- beslist

- decodering

- diepere

- beschreven

- ontwikkelde

- Ontwikkeling

- apparaat

- DEED

- anders

- moeilijk

- DIG

- richting

- direct

- do

- doet

- Nee

- elk

- gemakkelijk

- Geheel

- aflevering

- Zelfs

- uiteindelijk

- Alle

- evolueert

- precies

- voorbeeld

- opwindend

- verwachting

- verwacht

- Ervaringen

- uitgelegd

- explosie

- uitdrukkelijk

- factoren

- ver

- uitvoerbaar

- Voordelen

- Fed

- trouw

- Tot slot

- Voornaam*

- Voor

- gevonden

- Achtergrond

- oppompen van

- vol

- leuke

- functioneel

- verder

- verdere ontwikkeling

- toekomst

- verzameling

- Algemeen

- voortbrengen

- gegenereerde

- genereert

- krijgen

- reus

- Girl

- Go

- geraden

- HAD

- Hardware

- harnas

- Hebben

- met

- he

- hulp

- geholpen

- hier

- Hoge

- high-level

- hoogwaardige

- hoger

- Hoe

- HTTPS

- i

- idee

- ideeën

- if

- Imaging

- onmogelijk

- in

- Anders

- Inclusief

- informatie

- verkrijgen in plaats daarvan

- geïnteresseerd

- in

- IT

- voor slechts

- Houden

- Soort

- laboratorium

- taal

- Talen

- leiden

- geleerd

- leren

- minst

- Niveau

- niveaus

- als

- Beperkt

- Lijn

- Het luisteren

- Lives

- lang

- lange tijd

- verloren

- Laag

- te verlagen

- machine

- machine learning

- Hoofd

- kaart

- Maps

- massief

- massief

- max-width

- betekenissen

- maatregelen

- het meten van

- mentaal

- methode

- miljoen

- denken

- deskundigen

- fouten

- model

- modellen

- monitor

- maanden

- meer

- meest

- motor

- mond

- beweging

- Films

- MRI

- meervoudig

- naam

- VERHAAL

- Naturel

- NATUUR

- bijna

- Noodzaak

- nodig

- behoeften

- neuronen

- neurochirurgie

- New

- volgende

- noorden

- nu

- of

- on

- EEN

- Slechts

- begin

- opent

- or

- bestellen

- origineel

- Overige

- onze

- buiten

- over

- totaal

- het te bezitten.

- Zuurstof

- deel

- deelnemers

- deelname

- patiënt

- patiënten

- patronen

- perks

- blijvend

- persoon

- perspectief

- ontpit

- planning

- Plato

- Plato gegevensintelligentie

- PlatoData

- Overvloed

- Podcast

- podcasts

- Populair

- potentieel

- mogelijk

- energie

- aangedreven

- krachtige

- voorganger

- voorspeld

- voorspelt

- pers

- mooi

- vorig

- privacy

- probleem

- problemen

- verwerking

- Programma

- bewijs

- proof of concept voor

- biedt

- volmacht

- gepubliceerde

- Duwen

- snel

- liever

- Lees

- lezing

- realiseerde

- rijk

- redenen

- recent

- Herstellen

- herwinnen

- regio

- regio

- relatief

- betrouwbaar

- HERHAALDELIJK

- vertegenwoordiging

- vertegenwoordigt

- vereisen

- Resolutie

- resonantie

- Resources

- Reageren

- antwoord

- reacties

- weg

- Zei

- scène

- wetenschappers

- Tweede

- zien

- zin

- Volgorde

- -Series

- setup

- zeven

- gedeeld

- geschokt

- moet

- Signaal

- signalen

- sinds

- single

- Langzaam

- traag

- So

- iets

- Geluid

- spreken

- specifiek

- Spectroscopie

- toespraak

- begin

- gestart

- prikkel

- Blog

- Verhaal

- studies

- Studie

- ondertitels

- Chirurgie

- Nemen

- neemt

- praat

- Tik

- Afgetapt

- taken

- team

- Technologie

- proef

- testen

- Texas

- neem contact

- Bedankt

- dat

- De

- De omgeving

- hun

- ze

- ding

- spullen

- denken

- dit

- deze week

- die

- niet de tijd of

- naar

- nam

- Totaal

- handel

- Trainen

- vertalen

- twee

- voor

- unieke

- universiteit-

- anders

- .

- gebruikt

- gebruik

- Bekijk

- vrijwilligers

- vs

- was

- Bekeken

- we

- week

- GOED

- waren

- Wat

- wanneer

- welke

- en

- WIE

- groothandel

- wil

- Met

- zonder

- Woord

- woorden

- Mijn werk

- werkte

- werkzaam

- Bedrijven

- wereld

- nog

- You

- zephyrnet