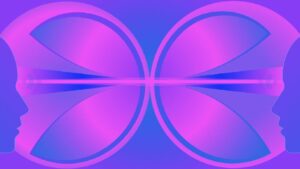

Een jongeman draagt een met elektroden bezaaide pet vol draden en leest stilletjes een zin in zijn hoofd. Even later komt er een Siri-achtige stem binnen, probeert zijn gedachten in tekst te vertalen, “Ja, ik wil graag een kom kippensoep, alstublieft.” Het is het nieuwste voorbeeld van computers die iemands gedachten in woorden en zinnen vertalen.

Eerder hebben onderzoekers implantaten die operatief in de hersenen zijn geplaatst of omvangrijke, dure machines gebruikt om hersenactiviteit in tekst te vertalen. De nieuwe aanpak, gepresenteerd op de NeurIPS-conferentie van deze week door onderzoekers van de University of Technology Sydney, is indrukwekkend vanwege het gebruik van een niet-invasieve EEG-cap en het potentieel om verder te generaliseren dan één of twee mensen.

Het team bouwde een AI-model genaamd DeWave dat is getraind op hersenactiviteit en taal en koppelde dit aan een groot taalmodel – de technologie achter ChatGPT – om hersenactiviteit in woorden om te zetten. In een voordruk geplaatst op arXiv, versloeg het model eerdere topscores voor EEG-gedachte-naar-tekstvertaling met een nauwkeurigheid van ongeveer 40 procent. Chin-Teng Lin, corresponderende auteur op het papier, vertelde MSN ze hebben recentelijk de nauwkeurigheid verhoogd tot 60 procent. De resultaten worden nog steeds door vakgenoten beoordeeld.

Hoewel er nog een lange weg te gaan is als het gaat om de betrouwbaarheid, laat het vooruitgang zien in niet-invasieve methoden voor het lezen en vertalen van gedachten in taal. Het team gelooft dat hun werk een stem kan geven aan degenen die niet langer kunnen communiceren vanwege een blessure of ziekte, of kunnen worden gebruikt om machines, zoals lopende robots of robotarmen, met alleen gedachten te besturen.

Raad eens wat ik denk

Misschien herinnert u zich de krantenkoppen over ‘gedachtenlezende’ machines die gedachten met hoge snelheid naar tekst vertalen. Dat komt omdat dergelijke inspanningen nauwelijks nieuw zijn.

Eerder dit jaar ontdekten Stanford-onderzoekers beschreven werk met een patiënt, Pat Bennett, die door ALS het vermogen om te spreken had verloren. Na het implanteren van vier sensoren in twee delen van haar hersenen en uitgebreide training kon Bennett communiceren door haar gedachten te hebben omgezet naar tekst met een snelheid van 62 woorden per minuut– een verbetering ten opzichte van het record van 2021 van hetzelfde team van 18 woorden per minuut.

Het is een verbazingwekkend resultaat, maar hersenimplantaten kunnen riskant zijn. Wetenschappers zouden graag een soortgelijk resultaat willen bereiken zonder operatie.

In nog een studie dit jaar, wendden onderzoekers van de Universiteit van Texas in Austin zich tot een hersenscantechnologie genaamd fMRI. In het onderzoek moesten patiënten heel stil liggen in een machine die de bloedstroom in hun hersenen registreerde terwijl ze naar verhalen luisterden. Nadat ze deze gegevens hadden gebruikt om een algoritme te trainen, gedeeltelijk gebaseerd op de voorloper van ChatGPT, GPT-1, gebruikte het team het systeem om te raden wat deelnemers hoorden op basis van hun hersenactiviteit.

De nauwkeurigheid van het systeem was niet perfect, het vereiste veel maatwerk voor elke deelnemer, en fMRI-machines zijn omvangrijk en duur. Toch diende het onderzoek als een proof of concept dat gedachten op niet-invasieve wijze kunnen worden gedecodeerd, en dat de nieuwste AI-technieken dit kunnen helpen verwezenlijken.

De sorteerhoed

In Harry Potter, worden studenten in schoolgebouwen gesorteerd door een magische hoed die gedachten leest. Wij dreuzels nemen onze toevlucht tot grappig uitziende badmutsen die doorprikt zijn door draden en elektroden. Deze apparaten staan bekend als elektro-encefalograaf (EEG)-kappen en lezen en registreren de elektrische activiteit in onze hersenen. In tegenstelling tot hersenimplantaten vereisen ze geen operatie, maar zijn ze aanzienlijk minder nauwkeurig. De uitdaging is dus om signaal van ruis te scheiden om een bruikbaar resultaat te krijgen.

In de nieuwe studie gebruikte het team twee datasets met eye-tracking en EEG-opnamen van respectievelijk 12 en 18 mensen terwijl ze tekst lazen. Dankzij eye-trackinggegevens kon het systeem de hersenactiviteit per woord opsplitsen. Dat wil zeggen dat wanneer de ogen van een persoon van het ene woord naar het volgende flitsen, dit betekent dat er een pauze moet zijn tussen de hersenactiviteit die bij dat woord hoort en de activiteit die bij het volgende hoort.

Vervolgens trainden ze DeWave op deze gegevens, en na verloop van tijd leerde het algoritme bepaalde hersengolfpatronen met woorden te associëren. Ten slotte werden de hersengolf-naar-woord-associaties van het algoritme terugvertaald in zinnen, met behulp van een vooraf getraind groot taalmodel genaamd BART – verfijnd om de unieke output van het model te begrijpen.

In tests presteerde DeWave beter dan de beste algoritmen in deze categorie, zowel wat betreft de vertaling van ruwe hersengolven als hersengolven opgesplitst per woord. Deze laatste waren nauwkeuriger, maar bleven nog steeds ver achter bij de vertaling tussen talen – zoals Engels en Frans – en spraakherkenning. Ze ontdekten ook dat het algoritme op dezelfde manier presteerde bij de deelnemers. Eerdere experimenten leverden vaak resultaten op voor één persoon of vereisten extreem maatwerk.

Het team zegt dat het onderzoek meer bewijs levert dat grote taalmodellen kunnen helpen bij het vooruitbrengen van brein-naar-tekst-systemen. Hoewel ze in het officiële onderzoek een relatief antiek algoritme gebruikten, hebben ze in aanvullend materiaal resultaten van grotere modellen opgenomen, waaronder Meta's originele Llama-algoritme. Interessant genoeg verbeterden de grotere algoritmen de resultaten niet veel.

“Dit onderstreept de complexiteit van het probleem en de uitdagingen van het overbruggen van hersenactiviteiten met LLM’s”, schreven de auteurs, waarin ze opriepen tot genuanceerder onderzoek in de toekomst. Toch hoopt het team dat ze hun eigen systeem verder kunnen pushen, misschien wel tot 90 procent nauwkeurigheid.

Het werk laat vooruitgang in het veld zien.

"Mensen willen EEG al heel lang in tekst omzetten en het model van het team vertoont opmerkelijk veel correctheid", vertelde Craig Jin van de Universiteit van Sydney. MSN. “Een aantal jaren geleden waren de conversies van EEG naar tekst complete onzin.”

Krediet van het beeld: University of Technology Sydney

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoData.Network Verticale generatieve AI. Versterk jezelf. Toegang hier.

- PlatoAiStream. Web3-intelligentie. Kennis versterkt. Toegang hier.

- PlatoESG. carbon, CleanTech, Energie, Milieu, Zonne, Afvalbeheer. Toegang hier.

- Plato Gezondheid. Intelligentie op het gebied van biotech en klinische proeven. Toegang hier.

- Bron: https://singularityhub.com/2023/12/12/this-mind-reading-cap-can-translate-thoughts-to-text-thanks-to-ai/

- :is

- $UP

- 12

- 2021

- 40

- 60

- a

- vermogen

- Over

- nauwkeurigheid

- accuraat

- over

- activiteiten

- activiteit

- bevorderen

- Na

- geleden

- AI

- algoritme

- algoritmen

- alleen

- ook

- Hoewel

- verbazingwekkend

- bedragen

- an

- en

- ZIJN

- armen

- AS

- Associëren

- geassocieerd

- verenigingen

- At

- austin

- auteur

- auteurs

- terug

- gebaseerde

- BE

- overtreffen

- omdat

- geweest

- achter

- wezen

- gelooft

- tussen

- Verder

- bloed

- zowel

- Hersenen

- Hersenactiviteit

- Breken

- breaks

- overbrugging

- bebouwd

- maar

- by

- Dit betekent dat we onszelf en onze geliefden praktisch vergiftigen.

- bellen

- CAN

- pet

- caps

- Categorie

- uitdagen

- uitdagingen

- ChatGPT

- communiceren

- compleet

- ingewikkeldheid

- computers

- concept

- Conferentie

- contrast

- conversies

- converteren

- Overeenkomend

- kon

- Craig

- Credits

- maatwerk

- gegevens

- datasets

- systemen

- directe

- Ziekte

- twee

- elk

- inspanningen

- Engels

- voorbeeld

- duur

- experimenten

- uitgebreid

- extreem

- Ogen

- veld-

- Tot slot

- stroom

- Voor

- gevonden

- vier

- oppompen van

- grappig

- verder

- toekomst

- krijgen

- Geven

- Go

- HAD

- gebeuren

- hoed

- Hebben

- met

- hoofd

- Headlines

- gehoor

- zwaar

- hulp

- geholpen

- haar

- Hoge

- zijn

- hoopt

- huizen

- HTML

- HTTPS

- indrukwekkend

- verbeteren

- verbetering

- in

- inclusief

- Inclusief

- letsel

- in

- IT

- HAAR

- bekend

- taal

- Groot

- groter

- later

- laatste

- geleerd

- minder

- Leugen

- als

- lin

- gekoppeld

- Lama

- lang

- lange tijd

- langer

- op zoek

- verloren

- liefde

- machine

- Machines

- maken

- man

- materiaal

- Mei..

- middel

- methoden

- deskundigen

- minuut

- model

- modellen

- Moments

- meer

- MSN

- veel

- New

- volgende

- geen

- Geluid

- of

- officieel

- on

- EEN

- or

- origineel

- onze

- Resultaat

- overtrof

- over

- het te bezitten.

- Papier

- deel

- deelnemer

- deelnemers

- bijzonder

- onderdelen

- patiënt

- patiënten

- patronen

- peer-reviewed

- Mensen

- voor

- procent

- uitgevoerd

- misschien

- persoon

- Plato

- Plato gegevensintelligentie

- PlatoData

- dan

- geplaatst

- potentieel

- gepresenteerd

- vorig

- Voorafgaand

- probleem

- Voortgang

- bewijs

- proof of concept voor

- Duwen

- Rauw

- Lees

- lezing

- onlangs

- erkenning

- record

- opname

- relatief

- betrouwbaarheid

- opmerkelijk

- niet vergeten

- verslag

- vereisen

- nodig

- onderzoek

- onderzoekers

- toevlucht

- respectievelijk

- resultaat

- Resultaten

- Riskant

- robots

- ruw

- dezelfde

- zegt

- School

- wetenschappers

- sensor

- zin

- apart

- geserveerd

- moet

- Shows

- Signaal

- gelijk

- evenzo

- Plak

- spreken

- toespraak

- Spraakherkenning

- snelheid

- stanford

- Still

- Blog

- Leerlingen

- Studie

- dergelijk

- Chirurgie

- sydney

- system

- Systems

- team

- Technologie

- termen

- testen

- Texas

- tekst

- Bedankt

- dat

- De

- De toekomst

- hun

- harte

- Er.

- Deze

- ze

- dit

- dit jaar

- die

- niet de tijd of

- naar

- vertelde

- top

- Trainen

- getraind

- Trainingen

- vertalen

- Vertaling

- BEURT

- Gedraaid

- twee

- underscores

- begrijpen

- unieke

- universiteit-

- .

- gebruikt

- gebruik

- zeer

- Stem

- wandel

- willen

- Wave

- golven

- Manier..

- we

- waren

- Wat

- wanneer

- WIE

- Met

- zonder

- Woord

- woorden

- Mijn werk

- zou

- schreef

- jaar

- jaar

- jong

- youtube

- zephyrnet