De gezondheid van een individu is een ongelooflijk persoonlijk onderwerp, en naar de dokter gaan kan een intimiderende en stressvolle ervaring zijn. Dit geldt met name voor mensen die deel uitmaken van groepen die het medische systeem historisch gezien heeft gefaald. Deze structurele problemen in de gezondheidszorg zijn doorgedrongen in de algoritmen die steeds vaker worden gebruikt bij de diagnose en behandeling van patiënten. CCC organiseerde een panel, "Gezondheidsgelijkheid: hoe kunnen algoritmen en gegevens schade beperken, niet verergeren?" die deze kwesties behandelden. De panelleden waren Dr. Amaka Eneanya (Fresenius Medical Care), Dr. Mona Singh (Princeton University), Dr. Melanie Moses (University of New Mexico) en Dr. Katie Siek (Indiana University).

De gezondheid van een individu is een ongelooflijk persoonlijk onderwerp, en naar de dokter gaan kan een intimiderende en stressvolle ervaring zijn. Dit geldt met name voor mensen die deel uitmaken van groepen die het medische systeem historisch gezien heeft gefaald. Deze structurele problemen in de gezondheidszorg zijn doorgedrongen in de algoritmen die steeds vaker worden gebruikt bij de diagnose en behandeling van patiënten. CCC organiseerde een panel, "Gezondheidsgelijkheid: hoe kunnen algoritmen en gegevens schade beperken, niet verergeren?" die deze kwesties behandelden. De panelleden waren Dr. Amaka Eneanya (Fresenius Medical Care), Dr. Mona Singh (Princeton University), Dr. Melanie Moses (University of New Mexico) en Dr. Katie Siek (Indiana University).

Dr. Eneanya begon het panel door te bespreken hoe een vergelijking systematisch nieraandoeningen onderschattese in zwarte Amerikanen voor tientallen jaren. Ze legde uit dat in de VS alle patiënten met een nierziekte in een register worden opgenomen. De prevalentie van de ziekte is de afgelopen decennia over het algemeen toegenomen, en voor zwarte individuen is de ziekte zelfs nog vaker voorkomend en ernstiger.

Dr. Eneanya schetste deze raciale/etnische verschillen in risicofactoren en uitkomsten voor chronische nierziekte (CKD) (Eneanya ND et al. Natuur Rev NepH. 2021, Renal Data System in de Verenigde Staten.):

- De prevalentie van diabetes is het hoogst onder zwarte individuen in vergelijking met andere raciale groepen

- Zwarte en Spaanse personen worden op jongere leeftijd gediagnosticeerd in vergelijking met blanke personen

- Zwarte individuen hebben significant hogere percentages hypertensie in vergelijking met blanke individuen

- Hypertensiecontrole is minder onder zwarte en Spaanse individuen in vergelijking met blanke individuen

- Zwarte individuen krijgen minder vaak nefrologische zorg voordat ze met dialyse beginnen in vergelijking met andere raciale groepen

- Risico op het ontwikkelen van nierfalen waarvoor dialyse of niertransplantatie nodig is

- 4 keer hoger bij zwarte versus blanke individuen

- 1.3 keer hoger bij Spaanse versus blanke individuen

- Zwarte individuen krijgen minder snel een niertransplantatie in vergelijking met andere raciale groepen

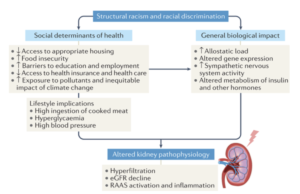

Structureel racisme draagt bij aan slechte gezondheidsresultaten van niergerelateerde ziekten, legde Dr. Eneanya uit (Eneanya ND et al. Natuur Rev NepH. 2021.):

Welke leefgewoonten u zich kunt veroorloven, zoals wat u eet, en biologische effecten zoals de stress van racisme en discriminatie leiden allemaal tot metabolische veranderingen in het lichaam, wat kan leiden tot een verminderde nierfunctie.

Dr. Eneanya ging in op een voorbeeld van hoe een algoritme dat momenteel door clinici wordt gebruikt, gevolgen heeft voor de echte wereld. De eGFR-vergelijking is een algoritme dat wordt gebruikt om te bepalen hoe sterk de nierfunctie van een patiënt is. Een hogere eGFR staat voor een betere nierfunctie. Het eGFR-niveau van een patiënt bepaalt of ze in aanmerking komen voor bepaalde behandelingen en, misschien wel het meest cruciaal, een niertransplantatie. Het algoritme laat echter zien dat een zwarte en niet-zwarte persoon die dezelfde leeftijd en hetzelfde geslacht hebben en dezelfde creatininemeting hebben (een bloedtest die de nierfunctie meet), verschillende eGFR-waarden hebben. Het algoritme berekent dat een zwarte persoon een hogere eGFR, zogenaamd superieure nierfunctie, heeft dan de niet-zwarte persoon. Dit beperkt de behandeling waarvoor ze in aanmerking komen en betekent dat ze zieker moeten zijn om de hulp te krijgen waar ze recht op zouden moeten hebben.

Dr. Eneanya legde de geschiedenis uit van het algoritme dat onthult waarom het op deze verkeerd gerichte manier berekent: een studie uit 1999 schreef hogere serumcreatinine toe aan zwarte individuen vanwege de onjuiste veronderstelling dat ze een hogere spiermassa hadden. De studie ontwikkelde de eerste eGFR-vergelijking die in de Verenigde Staten wordt gebruikt en omvatte een vermenigvuldigingsfactor van het "zwarte ras" die een hogere eGFR veroorzaakt bij zwarte individuen. Het gebruik van de eGFR is problematisch omdat clinici iemands ras moeten beoordelen op basis van uiterlijk of medische gegevens (waarbij mogelijk ras wordt vermeld als een overgebleven aanname van een eerdere clinicus). Er is ook geen onderscheid voor individuen van gemengd ras, of een methode om ze te classificeren.

Dr. Eneanya was een auteur van een artikel dat de manier veranderde waarop eGFR wordt berekend in de gezondheidszorg door te pleiten voor een vergelijking die geen rekening houdt met ras in de schatting (Inker LA, Eneanya ND, et al. NEJM 2021, Delgado C, et al. JAS 2021). Dr. Eneanya en haar collega's keerden terug naar de oorspronkelijke studie uit 1999 en verwijderden ras uit de vergelijking en voegden er andere input aan toe. Tegenwoordig gebruikt ⅓ van de ziekenhuizen en klinieken in de VS de nieuwe vergelijking, en het United Network for Organ Sharing (UNOS) heeft in juni 2022 met name alle transplantatiecentra beperkt tot het gebruik van de op ras gebaseerde vergelijking. In januari gingen ze nog een stap verder 2023 en verklaarde dat alle Amerikaanse transplantatiecentra verplicht zijn om alle zwarte patiënten op de wachtlijst voor niertransplantatie te beoordelen en hun wachtlijsttijd aan te passen als deze wordt beïnvloed door de op ras gebaseerde eGFR-vergelijking. Dr. Eneanya specificeerde dat hoewel UNOS deel uitmaakt van de federale regering, de regering niet direct betrokken was bij het besluit om het gebruik van de op ras gebaseerde vergelijking te verbieden.

Afgezien van de universele acceptatie van de nieuwe eGFR-vergelijking, had Dr. Eneanya nog een paar toekomstige benaderingen die zij beschouwt als de sleutel tot eerlijke toegang tot de behandeling van nieraandoeningen:

- Beleid en processen ontwikkelen om de toegang tot preventieve zorg voor chronische nieraandoeningen te verbeteren

- Ontwikkel beleid om de toegang tot niertransplantatie te verbeteren

- Onderzoek omgevingseffecten (bijv. stress, discriminatie) op nierfunctie en ziekteprogressie

- Transparantie bij het bespreken van nierfunctiebepaling met patiënten (inclusief beperkingen van eGFR-vergelijkingen)

Dr. Eneanya legde uit dat het uit de weg ruimen van stereotypen over zwart ras neerkomt op het elimineren van drogredenen en nepnieuws die geen wetenschappelijke basis hebben. De curricula van medische scholen veranderen bijvoorbeeld om aan te tonen dat er geen antropologische basis is dat er meer spiermassa is in het ene ras dan in het andere. De media hebben deze ontkrachte mythe ook goed gedeeld, en Dr. Eneanya heeft zelfs geraadpleegd over een Grey's Anatomy-aflevering waarin de verwoestende gevolgen van de eGFR-vergelijking voor zwarte patiënten die een niertransplantatie nodig hebben, werden benadrukt.

Dr. Singh vervolgde het gesprek over gezondheidsverschillen door uit te leggen dat zwarte individuen in de VS hogere sterftecijfers voor kanker hebben dan blanke individuen. Dit feit illustreert dat er veel uitdagingen zijn waarmee medische professionals en computeronderzoekers het hoofd moeten bieden, en dat er ook veel mogelijkheden zijn om methoden te ontwikkelen die de bestaande ongelijkheden niet vergroten.

Dr. Singh legde eerst de biologie van kanker uit: “Kanker is een ziekte waarbij onze eigen cellen mutaties krijgen waardoor ze ongecontroleerd kunnen groeien. Dus als we de moleculaire onderbouwing van kanker bij ÉÉN individu willen begrijpen, kunnen we kijken naar het genoom van zijn of haar kankercellen en zijn of haar niet-kankercellen, en de sequentie. Zodra we normale en kankercellen hebben gesequenced, kunnen we de genomen vergelijken en ontdekken welke mutaties we in kankercellen hebben verkregen, en dit kan ons een hint geven over welke veranderingen relevant kunnen zijn voor de kanker van die persoon. Dit is precies wat er in de afgelopen 15 jaar of zo is gedaan, waarbij de tumoren van tienduizenden individuen zijn gesequenced en mutaties in hen zijn geïdentificeerd.

Vrijwel iedereen kent wel iemand bij wie kanker is vastgesteld, en er is geen universele remedie. Dr. Singh besprak vervolgens echter de belofte van precisie-oncologie, waarbij een wetenschapper de tumor van een patiënt sequenteert, hun DNA-mutaties identificeert en computationele analyse uitvoert om te bepalen welke veranderingen kunnen worden gericht. Immunotherapie is een benadering om iemands eigen immuunsysteem te benutten om hun tumoren aan te pakken. Een veelbelovende opkomende immunotherapie is het ontwerpen van vaccins die zijn gepersonaliseerd voor elk individu en deze vaccins roepen een immuunrespons op tegen hun tumoren.

Dr. Singh legt uit dat de manier waarop dit werkt, is dat elk van onze immuunsystemen 6 verschillende kopieën heeft van de klassieke major histocompatibility complex (MHC) klasse I-genen. Er zijn meer dan 13,000 verschillende MHC-varianten van deze genen, dus elke persoon heeft een andere set MHC-genen. Sommige mutaties in kankercellen resulteren in "vreemde" eiwitten en sommige hiervan kunnen worden gebonden door de MHC's van een individu. Deze complexen van MHC gebonden met een fragment van een van kanker afkomstig eiwit worden herkend door immuuncellen en kunnen een immuunrespons activeren. Dit is zeer persoonlijk omdat de tumor van elk individu verschillende mutaties kan hebben en elk individu verschillende MHC's heeft. Wetenschappers gebruiken machine learning om te voorspellen welke MHC-varianten welke peptiden binden, wat hopelijk de werkzaamheid van immunotherapie zal bevorderen en uiteindelijk zal leiden tot het ontwerp van gepersonaliseerde neo-antigeenvaccins.

De verscheidenheid aan MHC-genen varieert enorm over de hele wereld, legt Dr. Singh uit. Aan de meeste MHC-allelen zijn geen bindende gegevens gekoppeld, en degenen die wel gegevens over hun binding hebben, zijn bevooroordeeld ten gunste van sommige raciale groepen. Het is belangrijk om bij het testen van een dataset niet alleen te focussen op de algehele prestaties, maar ook om subpopulaties van data in overweging te nemen, zodat iedereen gelijke toegang heeft tot de potentiële voordelen van dit onderzoek.

De trainingsset moet worden geanalyseerd op vertekening voordat deze wordt toegepast. Bovendien kunnen methoden om de prestaties van ongeziene gegevens te schatten, vertekening aan het licht brengen in de gegevens waarop is getraind. Het op een onbevooroordeelde manier verzamelen van gegevens is essentieel om de kans op vooringenomenheid later bij het gebruik van het algoritme te beperken. Gebieden voor toekomstig werk aan dit onderwerp zijn gericht op alternatieve trainingsprocedures en algoritmische strategieën voor gerichte gegevensverzameling. Over het algemeen is het van cruciaal belang om prioriteit te geven aan de ontwikkeling van eerlijke benaderingen van precisiegeneeskunde, zodat therapieën en onderzoek stroomafwaarts billijk zijn.

Dr. Moses sprak vervolgens en ze contextualiseerde hoe de eGFR- en MHC-peptidebindingsalgoritmen passen in een groter ecosysteem van hoe medische algoritmen sociale resultaten beïnvloeden. Ze legt uit dat wetenschappers algoritmen en AI gebruiken om resultaten te voorspellen waar we om geven op basis van proxy's die gemakkelijk kunnen worden gemeten, en die proxy's kunnen onnauwkeurig zijn. Om medische algoritmen nog gecompliceerder te maken, zijn ze voortdurend op onvoorspelbare manieren met elkaar in wisselwerking, zodat de volledige reikwijdte van algoritmen voor de diagnose van een patiënt doorgaans onduidelijk is. Daarom is het cruciaal om voorzichtig te zijn met het gebruik van algoritmen, vooral omdat wanneer de algoritmen falen, ze zeer schadelijk kunnen zijn voor de meest kwetsbaren.

Uitzoeken op wie een algoritme van invloed is en waarom is een belangrijk onderdeel van medische rechtvaardigheid. Dr. Moses doet een stapje terug en definieert billijkheid. De gemeenschappelijke afbeelding gebruikt om billijkheid van gelijkheid te onderscheiden, met individuen met 3 verschillende lengtes die worstelen om een honkbalwedstrijd te zien en verschillende manieren om hen te ondersteunen, is zelfs gebrekkig in de 3e afbeelding die de barrière wegneemt omdat het suggereert dat er iets inherent is aan de persoon met betrekking tot waarom ze de steun nodig hebben in plaats van sociale redenen die de ongelijkheid in de eerste plaats kunnen hebben veroorzaakt.

Dr. Moses liet een alternatieve afbeelding zien om te definiëren hoe gelijkheid eruitziet in een samenleving met systemische onrechtvaardigheid (Copyright 2020 door Nicolás E. Barceló en Sonya Shadravan (kunstenaar: Aria Ghalili)):

Deze afbeelding laat zien dat niet iedereen kan profiteren van het feit dat de barrière wordt weggenomen, maar dat er diepgewortelde problemen zijn die moeten worden aangepakt om rechtvaardigheid te bereiken.

Computerwetenschappers moeten altijd rekening houden met deze belangrijke context, betoogt dr. Moses. Het is vaak moeilijk om de aannames te identificeren die aanwezig waren bij het maken van algoritmen, zelfs met de meest eenvoudige algoritmen. Het is ook gemakkelijk om een statistische correlatie te gebruiken om een uitkomst te voorspellen en aan te nemen dat correlatie gelijk is aan oorzakelijk verband, maar dat is een misvatting.

Dr. Moses vervolgt met het geven van concrete voorbeelden van onbillijke algoritmen die tegenwoordig in de samenleving in andere domeinen worden gebruikt. Bijvoorbeeld algoritmen in het strafrechtsysteem die borgtocht vervangen door voorlopige hechtenis. Het is de bedoeling dat het proces een gegevensgestuurde, onbevooroordeelde methode is om degenen vast te houden die een gevaar vormen of een hoog risico lopen om niet voor het proces te verschijnen. De algoritmen hebben echter veel tekortkomingen in zowel het vermogen van het algoritme om eerlijke en nauwkeurige voorspellingen te doen als de vooroordelen van het systeem waarvan het algoritme deel uitmaakt, inclusief vooringenomen invoer en vooringenomen interpretaties van uitvoer. Een ander voorbeeld van hoe raciale vooroordelen in het strafrechtsysteem worden bestendigd door algoritmen, is software voor gezichtsherkenning. Hoewel is aangetoond dat gezichtsherkenning het minst nauwkeurig is bij het identificeren van vrouwelijke gezichten met een donkere huidskleur, zijn het zwarte mannengezichten die het vaakst verkeerd worden geïdentificeerd door deze algoritmen, wat leidt tot valse arrestaties. Dit laat zien hoe vooringenomenheid die de ene groep (zwarte vrouwen) het meest treft in termen van nauwkeurige classificatie, de grootste impact kan hebben op een andere groep (zwarte mannen) vanwege vooroordelen in het strafrechtsysteem

Algoritmen kunnen menselijke vooroordelen verergeren en kunnen ook worden verworpen als ze het oordeel niet versterken dat je zou hebben gemaakt zonder het algoritme te raadplegen. Dit geldt ook voor bevooroordeelde algoritmen in de geneeskunde. Pulsoximeters zijn bijvoorbeeld minder nauwkeurig in het detecteren van zuurstofniveaus in een donkere huid, wat kan leiden tot een onderdiagnose van luchtwegaandoeningen zoals ernstige COVID. Het gebruik van de hoeveelheid geld die aan gezondheidszorg wordt uitgegeven als maatstaf voor hoe gezond iemand is, is een andere onbillijke maatstaf. De voorbeelden die Dr. Eneanya en Dr. Singh beschreven, de eGFR-nierontziende nierfunctiestoornis bij Afro-Amerikanen, en genomische datasets die de Europese afkomst oververtegenwoordigd, zijn andere prominente voorbeelden van bevooroordeelde algoritmen in de geneeskunde die gevaarlijke stroomafwaartse gevolgen hebben voor de getroffen mensen. De eGFR-vergelijking werd gebruikt om gevangenen te identificeren die ziek genoeg waren om tijdens COVID uit de gevangenis te worden vrijgelaten, wat ertoe leidde dat een Afro-Amerikaanse man vrijlating werd geweigerd omdat zijn nierfunctie werd overschat.

Feedback kan algoritmen verbeteren of hun schade verergeren. Algoritmen zijn geen eenrichtingsverkeer, aangezien ze gericht zijn op het voorspellen van gedrag op basis van gegevens en de voorspelling van het ene jaar is van invloed op de gegevens van het volgende jaar. Algoritmen moeten gericht zijn op het verminderen van vooroordelen in de loop van de tijd; borgtochthoorzittingen zouden bijvoorbeeld verdachten moeten helpen opdagen voor het proces in plaats van mislukkingen te voorspellen; politie moet gericht zijn op het terugdringen van zowel criminaliteit als valse arrestaties. Algoritmen die in verschillende domeinen worden gebruikt, mogen nooit in steen gebeiteld worden, omdat er feedback zal zijn tussen mensen, algoritmen en sociale context.

Dr. Moses stelde ook aanvullende wegen voorwaarts voor: vooringenomenheid uit datasets verwijderen, aannames in twijfel trekken, systemische vooringenomenheid omkeren (niet versterken), evalueren met een verscheidenheid aan perspectieven, transparante en verklaarbare algoritmen eisen en geleidelijke, adaptieve implementaties gebruiken. De algemene perceptie is dat algoritmen op de een of andere manier vooroordelen wegnemen, maar in werkelijkheid codificeren ze vaak vooroordelen en moeten we op onze hoede zijn voor algoritmen en hun resultaten.

Het laatste deel van het panel was een Q&A. Moderator Dr. Siek trapte de sessie af met de vraag: "Hoe kunnen algoritmen en gegevens de schade niet verergeren?"

- Dr. Eneanya: Als een onderzoeker stopt met ras bij het zoeken naar onderscheidende factoren in een algoritme, is dat lui en wetenschappelijk ongeldig. Genetisch lijken mensen meer op elkaar tussen rassen dan binnen. Het is belangrijker om na te denken over biologische kenmerken die daadwerkelijk van invloed zijn op een menselijk systeem zoals nieren. Bij het testen van de pulsoximeter hadden onderzoekers bijvoorbeeld een dermatoloog moeten raadplegen om pulsoximeters te testen en te valideren op basis van verschillende huidtinten - in plaats van één type apparaat te gebruiken voor mensen met verschillende huidtinten.

- Dr. Moses: We zouden dezelfde benadering moeten gebruiken voor het valideren van algoritmen nadat ze in gebruik zijn genomen. Door ras te erkennen als een sociale constructie, kan worden opgemerkt dat blinde onderzoeken naar ras impact hebben. Het is belangrijk om te zoeken naar onderscheid tussen groepen om mogelijke ongelijkheden te identificeren die het algoritme versterkt. Moet u evalueren of het algoritme problemen minimaliseert of verbetert?

- Dr. Singh: Ras mag nooit als input worden gebruikt, maar het kan wel worden gebruikt om outputs te evalueren op vooringenomenheid. Als we niet aan ras zouden denken, zouden we niet eens kunnen zeggen dat er gezondheidsverschillen zijn. Het verzamelen van genomische gegevens en het categoriseren op basis van afkomst is ook een gebrekkige methodologie. We moeten ervoor zorgen dat we evalueren of methoden goed werken in verschillende populaties.

- Dr. Eneanya: Wanneer we een onderzoekspopulatie diversifiëren, moeten we afstappen van het alleen maar binnenhalen van groepen blanke of zwarte mensen. We moeten naar meer verschillen binnen deze groepen kijken, zoals factoren als sociale status, geslacht, seksualiteit, enz. We moeten naar het hele plaatje kijken en niet alleen naar diversiteitsdatasets op basis van ras.

- Dr. Moses: Algoritmen zijn precies de soorten tools die ons daarbij zouden moeten helpen, er zijn veel potentiële computerstrategieën die kunnen helpen.

- Dr. Singh: Ik ben het ermee eens dat algoritmen hier een grote rol spelen, dus hoe geven we prioriteit aan het verzamelen van gegevens? We moeten heel goed nadenken over hoe we dat doen.

Een toehoorder vroeg vervolgens: "Zijn er, gezien de grote haast om algoritmen te ontwikkelen op basis van huidige datasets met vooroordelen, manieren om vooringenomenheid in het algoritme tegen te gaan, behalve het wegwerken van vooroordelen in de dataset?"

- Dr. Singh: Het is moeilijk om vooringenomenheid in een dataset te overwinnen; het is een actief onderzoeksgebied. Het is gemakkelijk om steekproefgegevens te over- of onderschatten. Er zijn verschillende manieren om ML-modellen te trainen waarbij het algemene doel (meestal een functie die u probeert te minimaliseren, meestal met behulp van de hele dataset) is hoe optimalisatie eruit zou moeten zien.

- Dr. Eneanya: Van veel medische algoritmen wordt aangenomen dat ze ras moeten opnemen om preciezer te zijn. Mensen moeten echter kritisch onderzoeken waarom ras überhaupt wordt geïntroduceerd? Door ras als variabele te verwijderen, verandert de prestatie van het algoritme niet zoveel als u misschien denkt. Betekent het (klinisch) iets als de resultaten slechts een heel klein beetje veranderen na het verwijderen van een variabele zoals ras?

- Dr. Singh: Het betekent vooral niets als je trainingsset en de set waarop je het gebruikt heel verschillend zijn.

Dr. Siek stelde de panelleden voor met een andere vraag: "Als we dit allemaal opnieuw zouden kunnen doen, wat zouden we dan anders doen?"

- Dr. Eneanya: Stoppen met ras bij het evalueren van redenen voor verschillen in gezondheidsuitkomsten had niet mogen gebeuren. Bijvoorbeeld met creatinine niveaus, zouden we moeten nadenken over wat nog meer invloed kan hebben op creatinine? We hebben betere datasets nodig, waarvoor vertrouwen in gemeenschappen moet worden opgebouwd. Dit kan lijken op het verbeteren van de diversiteit van onderzoekspopulaties, het evalueren van hoe uw studiepersoneel eruit ziet, enz. Voor subsidies van het National Institute of Health zijn steeds meer gemeenschapspartners en specialisten op het gebied van gezondheidsgelijkheid nodig als onderdeel van het onderzoeksteam. We moeten de oude sets veranderen, maar we moeten in de toekomst ook betere sets bouwen. We kunnen alleen zoveel doen door te proberen opnieuw te configureren wat er is.

- Dr. Moses: Naast wat we zouden kunnen doen als we opnieuw zouden beginnen, beschouw ik algoritmen graag als spiegels van de samenleving. Ze worden door iedereen op internet getraind. Door dat te gebruiken als input voor het volgende algoritmeniveau, kunnen we bepalen waar de vooroordelen zijn, waarom ze er zijn en wat de toekomstige impact is. We moeten ons afvragen hoe we deze kwantitatieve hulpmiddelen kunnen gebruiken om erachter te komen hoe we deze situaties kunnen oplossen in plaats van ze te verergeren.

- Dr. Singh: Veel genomen die zijn verzameld, vertegenwoordigen niet de algemene bevolking. We moeten beginnen met betrokkenheid van diverse groepen mensen.

De laatste vraag van het publiek was: “Totdat we een punt bereiken waarop we een compleet genoombeeld van alle mensen hebben, zal er enthousiasme zijn om ML en algoritmen te gebruiken. Wat zijn echte dingen op het niveau van peer review die we nu kunnen doen, zodat we ze niet over 30 jaar hoeven te repareren?”

- Dr. Eneanya: Perfect is de vijand van goed. We moeten ons best doen. We kunnen vooroordelen identificeren en vervolgens ons best doen om verder te gaan. Er zijn barrières die niets te maken hebben met klinische algoritmen. Alleen het eGFR-algoritme repareren door ras te verwijderen, lost de verschillen in nierziekten niet op. Er moet veel worden gedaan aan de multivariabele aspecten van repressie.

- Dr. Moses: Het werk dat u [Dr. Eneanya] hebben gedaan om het algoritme voor iedereen opnieuw te ontwerpen, is precies hoe we verder moeten. We moeten het systeem repareren. Ook gebruikmakend van het feit dat het gerepareerd moest worden; het was gemakkelijk om de vooringenomenheid in de vergelijking te zien. De niervergelijking dient als een spiegel voor een samenleving die toestond dat ras werd gecodeerd op een manier die Afro-Amerikanen tientallen jaren benadeelde. De vooringenomenheid in die vergelijking was expliciet en opzettelijk. Het zal in de toekomst veel moeilijker zijn om bias te identificeren in complexere algoritmen.

Blijf op de hoogte voor nog een door de AAAS 2023 CCC gesponsorde panelsamenvatting!

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- Platoblockchain. Web3 Metaverse Intelligentie. Kennis versterkt. Toegang hier.

- Bron: https://feeds.feedblitz.com/~/733934357/0/cccblog~Health-Equity-How-Can-Algorithms-and-Data-Mitigate-Not-Exacerbate-Harms-AAAS-Panel-Recap/

- :is

- $UP

- 000

- 1

- 1999

- 2020

- 2021

- 2022

- 2023

- 7

- a

- vermogen

- in staat

- Over

- toegang

- accuraat

- Bereiken

- verwerven

- verworven

- over

- actieve

- werkelijk

- Extra

- Voegt

- Adoptie

- bevorderen

- pleiten voor

- invloed hebben op

- Afrikaanse

- Na

- Leeftijden

- AI

- AL

- algoritme

- algoritmische

- algoritmen

- Alles

- toestaat

- alternatief

- altijd

- Amerikaans

- Amerikanen

- onder

- bedragen

- analyse

- anatomie

- en

- Nog een

- verschijnen

- toegepast

- nadering

- benaderingen

- ZIJN

- GEBIED

- gebieden

- Argumenten

- gebied

- arrestaties

- dit artikel

- kunstenaar

- AS

- aspecten

- geassocieerd

- aanname

- At

- gehoor

- auteur

- terug

- borgtocht

- ban

- barrière

- barrières

- Baseball

- gebaseerde

- basis

- BE

- omdat

- begon

- wezen

- voordeel

- betekent

- BEST

- Betere

- tussen

- Verder

- vooringenomenheid

- binden

- verbindend

- biologie

- Beetje

- Zwart

- bloed

- lichaam

- Gebonden

- Bringing

- bouw

- Gebouw

- by

- berekend

- berekent

- CAN

- Kanker

- Kankercellen

- verzorging

- voorzichtig

- categoriseren

- veroorzaakt

- oorzaken

- ccc

- Cellen

- Centra

- zeker

- uitdagingen

- verandering

- Wijzigingen

- veranderende

- kenmerken

- klasse

- classificatie

- classificeren

- Klinisch

- clinici

- collega's

- Het verzamelen van

- Collectie

- komst

- Gemeen

- Gemeenschappen

- Community-gebaseerd

- vergelijken

- vergeleken

- compleet

- complex

- ingewikkeld

- computergebruik

- Gevolgen

- Overwegen

- permanent

- bouwen

- consulting

- verband

- voortgezet

- blijft

- onder controle te houden

- Gesprek

- auteursrecht

- Correlatie

- kon

- Covidien

- het aanmaken

- Misdrijf

- Crimineel

- cruciaal

- cruciaal

- genezen

- Actueel

- Op dit moment

- GEVAAR

- gevaarlijk

- gegevens

- gegevensset

- gegevenssets

- datasets

- decennia

- beslissing

- verlagen

- deep

- gedaagden

- definieert

- Vraag

- demonstreert

- implementaties

- beschreven

- Design

- hechtenis

- bepaling

- Bepalen

- bepaalt

- verwoestende

- ontwikkelen

- ontwikkelde

- het ontwikkelen van

- Ontwikkeling

- apparaat

- Diabetes

- verschillen

- anders

- onderscheiden

- moeilijk

- direct

- verdisconteerd

- besproken

- bespreken

- Ziekte

- ziekten

- diversen

- Verscheidenheid

- dna

- dokter

- Nee

- domeinen

- Dont

- beneden

- gedreven

- gedurende

- e

- elk

- gemakkelijk

- eten

- ecosysteem

- duurt

- uitgewerkte

- geschikt

- elimineren

- genoeg

- ingevoerd

- enthousiasme

- milieu

- gelijkheid

- Is gelijk aan

- vergelijkingen

- billijkheid

- vooral

- essentieel

- schatting

- etc

- Nederlands

- schatten

- evalueren

- Zelfs

- iedereen

- precies

- voorbeeld

- voorbeelden

- is een voorbeeld

- bestaand

- ervaring

- uitgelegd

- uitleggen

- Verklaart

- Gezicht

- gezichten

- gelaats

- gezichtsherkenning

- factoren

- FAIL

- Mislukt

- Storing

- eerlijk

- nep

- nep-nieuws

- Favor

- Federaal

- Federale overheid

- feedback

- vrouw

- weinig

- Figuur

- finale

- Voornaam*

- geschikt

- Bepalen

- vast

- gebrekkig

- Focus

- gericht

- Voor

- Naar voren

- oppompen van

- vol

- functie

- verder

- Bovendien

- toekomst

- spel

- Geslacht

- krijgen

- het krijgen van

- Geven

- Vrijgevigheid

- wereldbol

- doel

- gaan

- goed

- goede baan

- Overheid

- geleidelijk

- subsidies

- Grafisch

- beste

- Groep

- Groep

- Groeien

- gebeurd

- Hard

- schadelijk

- Harms

- harnas

- Hebben

- Gezondheid

- gezondheidssubsidies

- gezondheidszorg

- gezond

- hoogten

- hulp

- hier

- hoog risico

- hoger

- hoogst

- Gemarkeerd

- zeer

- historisch

- geschiedenis

- Hopelijk

- ziekenhuizen

- Hoe

- How To

- Echter

- HTTPS

- reusachtig

- menselijk

- Mensen

- hypertensie

- i

- geïdentificeerd

- identificeert

- identificeren

- het identificeren van

- beeld

- Immuunsysteem

- immunotherapie

- Impact

- beïnvloed

- Effecten

- verslechtering

- belangrijk

- verbeteren

- het verbeteren van

- in

- Anders

- onnauwkeurig

- omvatten

- Inclusief

- Incorporated

- Laat uw omzet

- meer

- in toenemende mate

- ongelooflijk

- individueel

- individuen

- inherent

- invoer

- instantie

- Instituut

- aandachtig

- interactie

- Internet

- intimiderend

- geïntroduceerd

- betrokken zijn

- betrokkenheid

- problemen

- IT

- Januari

- Jobomschrijving:

- rechter

- gerechtigheid

- Houden

- sleutel

- nier

- Groot

- groter

- leiden

- leidend

- leren

- leftover

- Niveau

- niveaus

- Lifestyle

- als

- Waarschijnlijk

- LIMIT

- beperkingen

- grenzen

- opgesomd

- Kijk

- ziet eruit als

- op zoek

- LOOKS

- lot

- machine

- machine learning

- gemaakt

- groot

- maken

- maken

- man

- manier

- veel

- Massa

- max-width

- middel

- maatregel

- maatregelen

- Media

- medisch

- medische zorg

- geneeskunde

- lid

- Heren

- methode

- Methodologie

- methoden

- Mexico

- macht

- denken

- minimaliseren

- spiegel

- Verzachten

- gemengd

- ML

- modellen

- wijzigen

- moleculair

- monetair

- geld

- meer

- meest

- beweging

- ga vooruit

- bewegend

- nationaal

- NATUUR

- Noodzaak

- nodig

- behoeften

- netwerk

- New

- nieuws

- volgende

- een

- in het bijzonder

- of

- vaak

- Oud

- on

- EEN

- Kansen

- kansen

- optimalisatie

- bestellen

- Georganiseerd

- origineel

- Overige

- Resultaat

- geschetst

- totaal

- Overwinnen

- het te bezitten.

- Zuurstof

- paneel

- deel

- partners

- verleden

- patiënt

- patiënten

- turen

- Mensen

- perceptie

- prestatie

- presteert

- misschien

- persoon

- persoonlijk

- Gepersonaliseerde

- perspectieven

- beeld

- plaats

- Plato

- Plato gegevensintelligentie

- PlatoData

- Spelen

- punt

- beleidsmaatregelen door te lezen.

- policing

- arm

- bevolking

- populaties

- potentieel

- nauwkeurig

- Precies

- precisie

- voorspellen

- voorspelling

- Voorspellingen

- presenteren

- heersend

- vorig

- Voorafgaand

- prioriteren

- gevangenis

- gevangenen

- problemen

- procedures

- processen

- professionals

- vooraanstaand

- belofte

- veelbelovend

- voorgestelde

- Eiwit

- Eiwitten

- volmacht

- pols

- zetten

- Q & A

- kwantitatief

- vraag

- Race

- Raciale vooroordeel

- racisme

- Tarieven

- liever

- vast

- echte wereld

- Realiteit

- redenen

- samenvatting

- ontvangen

- recent

- erkenning

- erkend

- archief

- verminderen

- register

- versterken

- los

- uitgebracht

- relevante

- verwijderen

- verwijderd

- het verwijderen van

- vervangen

- vertegenwoordigen

- vertegenwoordigt

- nodig

- vereist

- onderzoek

- onderzoeker

- onderzoekers

- antwoord

- hernieuwd

- begrensd

- resultaat

- Resultaten

- onthullen

- onthult

- omkeren

- beoordelen

- bevrijden

- Risico

- risicofactoren

- Rol

- haast

- dezelfde

- School

- wetenschappelijk

- Wetenschapper

- wetenschappers

- ziet

- Volgorde

- Serum

- bedient

- Sessie

- reeks

- Sets

- streng

- delen

- moet

- tonen

- getoond

- Shows

- aanzienlijk

- gelijk

- situaties

- Huid

- So

- Social

- Maatschappij

- Software

- OPLOSSEN

- sommige

- Iemand

- iets

- specialisten

- gespecificeerd

- besteed

- Medewerkers

- begin

- Start

- Staten

- statistisch

- Status

- Stap voor

- STONE

- stoppen

- eenvoudig

- strategieën

- straat

- spanning

- sterke

- structureel

- Worstelen

- studies

- Studie

- onderwerpen

- dergelijk

- Stelt voor

- superieur

- ondersteuning

- system

- systemische

- Systems

- Nemen

- neemt

- doelwit

- doelgerichte

- team

- termen

- proef

- Testen

- dat

- De

- De toekomst

- hun

- Ze

- daarom

- Deze

- spullen

- duizenden kosten

- niet de tijd of

- naar

- vandaag

- ook

- tools

- onderwerp

- Trainen

- getraind

- Trainingen

- transparant

- behandeling

- proces

- waar

- Trust

- types

- typisch

- Tenslotte

- ontdekken

- voor

- onderbouwing

- begrijpen

- United

- Verenigde Staten

- Universeel

- universiteit-

- onvoorspelbaar

- us

- Gebruik

- .

- doorgaans

- BEVESTIG

- variëteit

- Tegen

- Kwetsbaar

- Manier..

- manieren

- GOED

- Wat

- Wat is

- welke

- en

- wit

- WIE

- geheel

- wil

- Met

- binnen

- zonder

- Dames

- Mijn werk

- Bedrijven

- zou

- geschreven

- jaar

- You

- Jonger

- Your

- zephyrnet