Webinhoud die automatisch door AI wordt gegenereerd, wordt door Google Search gerangschikt op basis van zijn kwaliteit, bevestigde de internettitan deze week, nadat hij eerder had gesuggereerd dat het de door de computer gemaakte pagina's zou dekken.

Vorig jaar Google Search Advocate John Mueller zei het gebruik van machine-learningtools om tekst te produceren is "in wezen hetzelfde als gewoon woorden door elkaar schudden" om de bots van Google te bespelen en de positie van een pagina in de zoekresultaten kunstmatig op te krikken. Door AI gegenereerde inhoud zou dus als spam worden behandeld zoals het zou zijn uitgegaan van van lage kwaliteit of nutteloos zijn; websites die dat soort lui materiaal hosten, zouden lager in de resultaten verschijnen of helemaal niet.

Maar Google is sindsdien van gedachten veranderd en heeft zijn regels bijgewerkt. "Het is belangrijk om te erkennen dat niet al het gebruik van automatisering, inclusief het genereren van AI, spam is", luidt het zei in een memo aan webontwikkelaars op woensdag.

“Automatisering wordt bij uitgeverijen al lang gebruikt om bruikbare inhoud te creëren. AI kan op spannende nieuwe manieren helpen met het genereren van nuttige inhoud.”

Volgens Google is software in het verleden door uitgevers en website-eigenaren gebruikt om zaken als 'sportuitslagen, weersvoorspellingen en transcripties' uit te voeren. En dat klopt: de Associated Press heeft dat bijvoorbeeld geautomatiseerde de productie van artikelen over de financiële resultaten van bedrijven, sportwedstrijden en soortgelijke dingen die kunnen worden gemaakt op basis van sjablonen.

"AI heeft het vermogen om nieuwe niveaus van expressie en creativiteit aan te drijven, en om te dienen als een essentieel hulpmiddel om mensen te helpen geweldige inhoud voor het web te maken", voegde Google eraan toe.

De Chrome-maker gaat nu door met het rangschikken van inhoud die vier kwaliteiten demonstreert die het EEAT noemde: expertise, ervaring, autoriteit en betrouwbaarheid, ongeacht hoe dat materiaal is gemaakt. Het gebruik van AI om inhoud te genereren om zoekmachineoptimalisatie te exploiteren en zoekresultaten te manipuleren, is echter verboden, net als bij door mensen geschreven spam.

“Passend gebruik van AI of automatisering is niet in strijd met onze richtlijnen. Dit betekent dat het niet wordt gebruikt om inhoud te genereren, in de eerste plaats om zoekrangschikkingen te manipuleren tegen ons spambeleid', bevestigde Google.

De verandering komt nadat de zoekgigant van plan is om het te gaan gebruiken deMDA AI-technologie om de zoekopdrachten van mensen te beantwoorden en automatisch samenvattingen van informatie en andere tekst te genereren. Heet op de hielen van Microsoft, Google aangekondigd is van plan dit model dinsdag in zijn zoeksystemen te integreren.

In feite gaat Google zijn op LaMDA gebaseerde chatbot Bard aanbieden als een conversatie-interface voor het zoeken op internet en het opzoeken van informatie. En als het goed is dat Bard automatisch tekst verzendt, zou het misschien een beetje hypocriet zijn om alle door AI gemaakte pagina's als spam neer te schieten.

In plaats van op verschillende websites te klikken en informatie te doorzoeken, beantwoordt Bard invoervragen door webpagina's samen te vatten. Langs dezelfde lijnen, Microsoft ook geplaagd de wereld met een voorproefje van zijn AI-aangedreven zoeken: de Windows-gigant heeft een groot taalmodel, gebouwd door OpenAI, naar verluidt krachtiger dan ChatGPT en gebaseerd op GPT-3.5, geïntegreerd in Bing. Nieuwe zoek- en tekstgeneratiemogelijkheden komen ook naar de Edge-webbrowser.

Dit alles zal naar verwachting geleidelijk worden uitgerold, en alleen dan kunnen we beoordelen hoe goed het werkt.

De technologie is in opkomst. Ontwikkelaars zijn nog steeds aan het uitzoeken hoe ze kunnen voorkomen dat deze modellen valse informatie verspreiden als gedemonstreerd door Google's Bard. In een demo beweerde het model ten onrechte dat NASA's James Webb Space Telescope (JWST) "de allereerste foto's maakte van een planeet buiten ons eigen zonnestelsel", een prestatie die feitelijk werd bereikt door de Very Large Telescope van de European Southern Observatory jaren voordat de JWST werd gelanceerd. Meer dan $ 120 miljard van de marktkapitalisatie van Google werd kort na de fout weggevaagd.

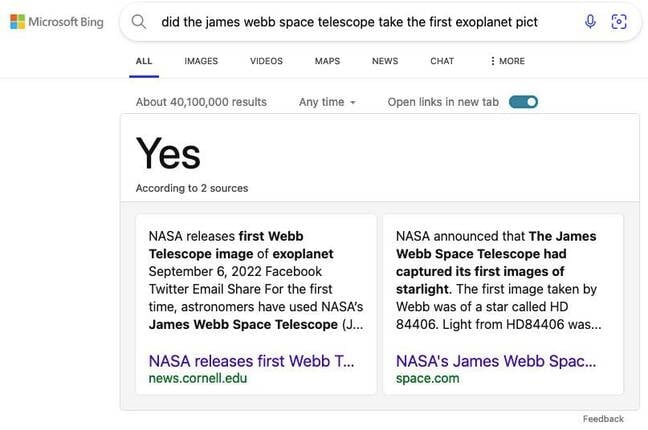

Microsoft's geüpgradede Bing lijkt ook met deze vraag te worstelen. Toen we vroegen of de JWST de eerste foto's van exoplaneten had gemaakt, zei het ja en linkte het naar twee bronnen die dit niet helemaal ondersteunden. Hoewel het waar is dat de telescoop de eerste foto's heeft gemaakt van een nooit eerder geziene exoplaneet, is het niet de eerste telescoop die de allereerste foto van exoplaneten maakt.

Hoe AI-aangedreven zoeken het gezicht van internet zal veranderen, valt nog te bezien. Sommigen vragen zich al af of dit de ondergang zou kunnen betekenen voor uitgevers die afhankelijk zijn van banneradvertenties. In plaats van op websites te klikken om informatie te vinden, zullen de nieuwe Bing en Bard het gewoon samenvatten, waardoor het aantal oogballen op pagina's wordt verminderd.

Uitgevers en site-eigenaren kunnen in het stof worden gelaten, zoals Niemen Lab, de journalistieke stichting van Harvard bekend. Netizens bezoeken geen pagina's, waardoor het vermogen van uitgevers om advertentievertoningen vast te leggen en inkomsten te innen, wordt ondermijnd.

Zullen deze modellen echt nuttig zijn en kunnen we allemaal minder tijd besteden aan surfen op internet? Of zullen ze ons op een dwaalspoor brengen omdat ze geen nauwkeurige informatie kunnen genereren, vragen we ons af. ®

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- Platoblockchain. Web3 Metaverse Intelligentie. Kennis versterkt. Toegang hier.

- Bron: https://go.theregister.com/feed/www.theregister.com/2023/02/09/google_reverses_ai_page_spam/

- 7

- a

- capaciteiten

- vermogen

- Over

- Volgens

- accuraat

- bereikt

- werkelijk

- Ad

- toegevoegd

- advertenties

- advocaat

- Na

- tegen

- AI

- AI-powered

- Alles

- al

- bedragen

- en

- beantwoorden

- verschijnen

- passend

- rond

- artikelen

- helpen

- geassocieerd

- webmaster.

- Automatisering

- banner

- gebaseerde

- omdat

- vaardigheden

- Miljard

- Bing

- Beetje

- bots

- browser

- Bladeren

- bebouwd

- kan niet

- pet

- mogelijkheden

- verandering

- Chatbot

- ChatGPT

- Chrome

- beweerde

- verzamelen

- komst

- BEVESTIGD

- content

- voortzetten

- spraakzaam

- Bedrijven

- kon

- en je merk te creëren

- aangemaakt

- creativiteit

- kritisch

- demonstreert

- ontwikkelaars

- anders

- ondergang

- beneden

- nagesynchroniseerde

- Stof

- rand

- Motor

- fout

- in wezen

- Nederlands

- opwindend

- exoplanet

- verwacht

- ervaring

- expertise

- Exploiteren

- Gezicht

- prestatie

- financieel

- VIND DE PLEK DIE PERFECT VOOR JOU IS

- Voornaam*

- eerste ooit

- Foundation

- oppompen van

- spel

- voortbrengen

- gegenereerde

- generatie

- reus

- gaan

- Kopen Google Reviews

- Google Search

- geleidelijk

- groot

- richtlijnen

- harvard

- hulp

- Hosting

- Populair

- Hoe

- How To

- Echter

- HTTPS

- belangrijk

- in

- Inclusief

- onjuist

- info

- informatie

- invoer

- instantie

- verkrijgen in plaats daarvan

- integreren

- geïntegreerde

- Interface

- Internet

- IT

- James Webb Space Telescope

- John

- journalistiek

- rechter

- Soort

- laboratorium

- taal

- Groot

- gelanceerd

- leiden

- niveaus

- lijnen

- gekoppeld

- lang

- Kijk

- op zoek

- Laag

- maker

- Markt

- Marktkapitalisatie

- materiaal

- middel

- Memo

- Microsoft

- denken

- model

- modellen

- meer

- NASA

- ontluikend

- New

- observatorium

- bieden

- OpenAI

- optimalisatie

- Overige

- buiten

- het te bezitten.

- eigenaren

- verleden

- Mensen

- beeld

- Foto's

- vliegtuig

- plannen

- Plato

- Plato gegevensintelligentie

- PlatoData

- energie

- krachtige

- pers

- voorkomen

- die eerder

- in de eerste plaats

- produceren

- geproduceerd

- productie

- uitgevers

- Reclame

- pomp

- kwaliteiten

- kwaliteit

- vraag

- gerangschikt

- herkennen

- record

- vermindering

- achteloos

- stoffelijk overschot

- Resultaten

- inkomsten

- Rollen

- reglement

- Zei

- dezelfde

- omvang

- Ontdek

- zoekmachine

- zoeken

- lijkt

- dienen

- schieten

- binnenkort

- gelijk

- sinds

- website

- Snappen

- sluipen

- Software

- zonne-

- Zonnestelsel

- sommige

- bronnen

- Zuidelijk

- Tussenruimte

- spam

- SPELLEN

- besteden

- Sport

- begin

- Still

- samenvatten

- ondersteuning

- system

- Systems

- Technologie

- telescoop

- templates

- De

- de wereld

- spullen

- deze week

- Door

- niet de tijd of

- Titan

- naar

- ook

- tools

- tools

- waar

- dinsdag

- bijgewerkt

- opgewaardeerd

- us

- .

- manieren

- Weer

- web

- web browser

- Website

- websites

- woensdag

- week

- of

- welke

- en

- wil

- ruiten

- Won

- woorden

- Bedrijven

- wereld

- zou

- jaar

- jaar

- youtube

- zephyrnet