Als iemand je een feit vertelt dat je al weet, hebben ze je in wezen helemaal niets verteld. Terwijl als ze een geheim doorgeven, het eerlijk is om te zeggen dat er echt iets is gecommuniceerd.

Dit onderscheid vormt de kern van de informatietheorie van Claude Shannon. Geïntroduceerd in een baanbrekend artikel uit 1948, "Een wiskundige communicatietheorie”, biedt het een rigoureus wiskundig raamwerk voor het kwantificeren van de hoeveelheid informatie die nodig is om een bericht nauwkeurig te verzenden en te ontvangen, zoals bepaald door de mate van onzekerheid over wat het beoogde bericht zou kunnen zeggen.

Dat wil zeggen, het is tijd voor een voorbeeld.

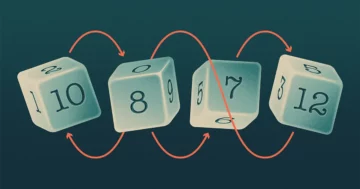

In één scenario heb ik een trucmunt - het is aan beide kanten kop. Ik ga het twee keer omdraaien. Hoeveel informatie is er nodig om het resultaat te communiceren? Helemaal geen, want voordat je het bericht ontvangt, heb je de volledige zekerheid dat beide flips opduiken.

In het tweede scenario doe ik mijn twee salto's met een normale munt - kop aan de ene kant, munt aan de andere kant. We kunnen het resultaat communiceren met behulp van binaire code: 0 voor kop, 1 voor staart. Er zijn vier mogelijke berichten — 00, 11, 01, 10 — en elk vereist twee stukjes informatie.

Dus, wat is het punt? In het eerste scenario had je volledige zekerheid over de inhoud van het bericht en waren er nul bits nodig om het te verzenden. In de tweede had je een kans van 1 op 4 om het juiste antwoord te raden - 25% zekerheid - en het bericht had twee stukjes informatie nodig om die dubbelzinnigheid op te lossen. Meer in het algemeen geldt dat hoe minder je weet over wat de boodschap zal zeggen, hoe meer informatie er nodig is om over te brengen.

Shannon was de eerste persoon die deze relatie wiskundig nauwkeurig maakte. Hij legde het vast in een formule die het minimum aantal bits berekent - een drempel die later de Shannon-entropie wordt genoemd - dat nodig is om een bericht te communiceren. Hij toonde ook aan dat als een afzender minder bits gebruikt dan het minimum, het bericht onvermijdelijk vervormd raakt.

"Hij had een geweldige intuïtie dat informatie wordt gemaximaliseerd wanneer je het meest verbaasd bent over iets te leren," zei Tara Javidi, een informatietheoreticus aan de Universiteit van Californië, San Diego.

De term "entropie" is ontleend aan de natuurkunde, waarbij: entropie is een maat voor wanorde. Een wolk heeft een hogere entropie dan een ijsblokje, omdat een wolk veel meer manieren biedt om watermoleculen te rangschikken dan de kristallijne structuur van een kubus. Op een analoge manier heeft een willekeurig bericht een hoge Shannon-entropie - er zijn zoveel mogelijkheden voor hoe de informatie kan worden gerangschikt - terwijl een bericht dat een strikt patroon volgt een lage entropie heeft. Er zijn ook formele overeenkomsten in de manier waarop entropie wordt berekend in zowel de natuurkunde als de informatietheorie. In de natuurkunde omvat de formule voor entropie het nemen van een logaritme van mogelijke fysieke toestanden. In de informatietheorie is het de logaritme van mogelijke gebeurtenisuitkomsten.

De logaritmische formule voor Shannon-entropie logenstraft de eenvoud van wat het vastlegt - omdat een andere manier om over Shannon-entropie te denken is als het aantal ja-of-nee-vragen dat gemiddeld nodig is om de inhoud van een bericht vast te stellen.

Stel je bijvoorbeeld twee weerstations voor, één in San Diego, de andere in St. Louis. Elk wil de zevendaagse voorspelling voor zijn stad naar de ander sturen. San Diego is bijna altijd zonnig, wat betekent dat je veel vertrouwen hebt in wat de voorspelling zal zeggen. Het weer in St. Louis is onzekerder - de kans op een zonnige dag is dichter bij 50-50.

Hoeveel ja-of-nee-vragen zijn er nodig om elke zevendaagse voorspelling te verzenden? Voor San Diego zou een winstgevende eerste vraag kunnen zijn: zijn alle zeven dagen van de voorspelling zonnig? Als het antwoord ja is (en de kans is groot), heb je de hele prognose in één vraag bepaald. Maar met St. Louis moet je je bijna dag voor dag een weg banen door de weersvoorspelling: Is de eerste dag zonnig? Hoe zit het met de tweede?

Hoe meer zekerheid er is over de inhoud van een bericht, hoe minder ja-of-nee-vragen je gemiddeld nodig hebt om het te bepalen.

Om nog een voorbeeld te nemen, overweeg twee versies van een alfabetspel. In de eerste heb ik willekeurig een letter uit het Engelse alfabet gekozen en ik wil dat je het raadt. Als u de best mogelijke gokstrategie gebruikt, kost het u gemiddeld 4.7 vragen om deze te krijgen. (Een nuttige eerste vraag zou zijn: "Staat de letter in de eerste helft van het alfabet?")

In de tweede versie van het spel, in plaats van de waarde van willekeurige letters te raden, probeer je letters in echte Engelse woorden te raden. Nu kunt u uw schatting aanpassen om te profiteren van het feit dat sommige letters vaker voorkomen dan andere ("Is het een klinker?") gevolgd door u). Shannon berekende dat de entropie van de Engelse taal 2.62 bits per letter is (of 2.62 ja-of-nee-vragen), veel minder dan de 4.7 die je nodig zou hebben als elke letter willekeurig zou verschijnen. Anders gezegd, patronen verminderen onzekerheid, waardoor het mogelijk is om veel te communiceren met relatief weinig informatie.

Merk op dat u in dit soort voorbeelden betere of slechtere vragen kunt stellen. Shannon-entropie stelt een onschendbare bodem: het is het absolute minimum aantal bits, of ja-of-nee-vragen, dat nodig is om een boodschap over te brengen.

"Shannon liet zien dat er zoiets bestaat als de snelheid van het licht, een fundamentele limiet", zei Javidi. "Hij toonde aan dat Shannon-entropie een fundamentele limiet is voor hoeveel we een bron kunnen comprimeren, zonder risico op vervorming of verlies."

Tegenwoordig dient Shannon-entropie als maatstaf in veel toegepaste omgevingen, waaronder informatiecompressietechnologie. Dat je bijvoorbeeld een groot filmbestand kunt zippen, heeft te maken met het feit dat pixelkleuren een statistisch patroon hebben, zoals Engelse woorden dat doen. Ingenieurs kunnen probabilistische modellen bouwen voor patronen van pixelkleuren van het ene frame naar het andere. De modellen maken het mogelijk om de Shannon-entropie te berekenen door gewichten toe te kennen aan patronen en vervolgens de logaritme van het gewicht te nemen voor alle mogelijke manieren waarop pixels kunnen verschijnen. Die waarde vertelt je de limiet van "verliesloze" compressie - het absolute maximum dat de film kan worden gecomprimeerd voordat je informatie over de inhoud begint te verliezen.

De prestaties van elk compressiealgoritme kunnen met deze limiet worden vergeleken. Als je er verre van bent, heb je een prikkel om harder te werken om een beter algoritme te vinden. Maar als je er dichtbij bent, weet je dat de informatiewetten van het universum je ervan weerhouden om veel beter te doen.