Dit is een opinieredactioneel commentaar van Aleksandar Svetski, auteur van "The UnCommunist Manifesto" en oprichter van het op Bitcoin gerichte taalmodel Spirit of Satoshi.

Taalmodellen zijn een en al rage, en veel mensen nemen gewoon basismodellen (meestal ChatGPT of iets dergelijks) en verbinden ze vervolgens met een vectordatabase, zodat wanneer mensen hun "model" een vraag stellen, het antwoord contextueel reageert uit deze vectordatabase.

Wat is een vector-database? Ik zal dat in een toekomstig essay gedetailleerder uitleggen, maar een eenvoudige manier om het te begrijpen is als een verzameling informatie die is opgeslagen als stukjes data, die een taalmodel kan bevragen en gebruiken om betere antwoorden te produceren. Stel je ‘The Bitcoin Standard’ voor, opgesplitst in paragrafen en opgeslagen in deze vectordatabase. U stelt dit nieuwe ‘model’ een vraag over de geschiedenis van het geld. Het onderliggende model zal feitelijk de database bevragen, het meest relevante stukje context selecteren (een paragraaf uit “The Bitcoin Standard”) en dit vervolgens invoeren in de prompt van het onderliggende model (in veel gevallen ChatGPT). Het model zou dan moeten reageren met een more relevante antwoord. Dit is cool en werkt in sommige gevallen goed, maar lost de onderliggende problemen van mainstream ruis en vooroordelen waaraan de onderliggende modellen tijdens hun training onderhevig zijn, niet op.

Dit is wat we proberen te doen bij Spirit of Satoshi. We hebben ongeveer zes maanden geleden een model gebouwd zoals hierboven beschreven, dat je kunt gaan uitproberen hier. Je zult merken dat het bij sommige antwoorden niet slecht is, maar het kan geen gesprek voeren, en het presteert erg slecht als het gaat om shitcoinery en dingen die een echte Bitcoiner zou weten.

Daarom hebben we onze aanpak veranderd en bouwen we vanaf nul een volledig taalmodel. In dit essay zal ik daar een beetje over praten, om je een idee te geven van wat het inhoudt.

Een meer 'gebaseerd' Bitcoin-taalmodel

De missie om een meer "gebaseerd" taalmodel te bouwen gaat door. Het is bewezen meer betrokken te zijn dan zelfs ik had gedacht, niet van een “technisch ingewikkeld” standpunt, maar meer vanuit a "verdomme dit is vervelend" standpunt.

Het draait allemaal om gegevens. En niet de kwantiteit van data, maar de kwaliteit en het formaat van data. Je hebt er waarschijnlijk nerds over horen praten, en je stelt het pas echt op prijs als je het spul daadwerkelijk aan een model begint te geven en je een resultaat krijgt... wat niet per se was wat je wilde.

De datapijplijn is waar al het werk is. Je moet verzamelen en kapelaan de gegevens, dan moet je extract Het. Dan moet je programmatisch schoon (het is onmogelijk om handmatig een eerste keer opschonen uit te voeren).

Vervolgens neem je deze programmatisch opgeschoonde, onbewerkte gegevens en het moet transformeren het in meerdere gegevens formaten (denk aan vraag-en-antwoordparen, of semantisch coherente brokken en paragrafen). Dit moet je ook programmatisch doen als je te maken hebt met heel veel gegevens, wat het geval is voor een taalmodel. Grappig genoeg zijn andere taalmodellen eigenlijk goed voor deze taak! Je gebruikt taalmodellen om nieuwe taalmodellen te bouwen.

Dan, omdat er waarschijnlijk heel veel rommel achterblijft en irrelevante rommel die wordt gegenereerd door welk taalmodel je ook hebt gebruikt om de gegevens programmatisch te transformeren, je moet een intensievere schoon.

Deze is waar je menselijke hulp nodig hebt, want in dit stadium lijkt het erop dat mensen nog steeds de enige wezens op de planeet zijn met het vermogen om onderscheid te maken en te bepalen kwaliteit. Algoritmen kunnen dit min of meer doen, maar nog niet zo goed met taal – vooral in meer genuanceerde, vergelijkende contexten – en dat is waar Bitcoin vierkant zit.

Hoe dan ook, het is ongelooflijk moeilijk om dit op grote schaal te doen, tenzij je een leger mensen hebt om je te helpen. Dat leger mensen kunnen huurlingen zijn die door iemand worden betaald, zoals OpenAI heeft meer geld dan God, of het kunnen missionarissen zijn, wat de Bitcoin-gemeenschap over het algemeen is (we hebben hier bij Spirit of Satoshi veel geluk en dankbaar voor). Individuen doorlopen gegevensitems en selecteren één voor één of ze de gegevens willen behouden, weggooien of wijzigen.

Zodra de gegevens dit proces hebben doorlopen, krijg je aan de andere kant iets schoons. Natuurlijk zijn er hier meer fijne kneepjes. U moet er bijvoorbeeld voor zorgen dat slechte actoren die uw opruimproces proberen te verpesten, worden verwijderd of dat hun inbreng wordt weggegooid. Je kunt dat op verschillende manieren doen, en iedereen doet het een beetje anders. Je kunt mensen op weg naar binnen screenen, je kunt een soort intern opschoningsconsensusmodel bouwen zodat er aan drempels moet worden voldaan om gegevensitems te behouden of weg te gooien, enz. Bij Spirit of Satoshi doen we een mix van beide, en ik denk dat we de komende maanden zullen zien hoe effectief het is.

Nu ... als je eenmaal deze prachtige schone gegevens hebt aan het einde van dit "pijpleiding,” dan moet je formaat het nog een keer ter voorbereiding op “opleiding" een model.

In deze laatste fase komen de grafische verwerkingseenheden (GPU's) in het spel, en dat is echt waar de meeste mensen aan denken als ze horen over het bouwen van taalmodellen. Alle andere dingen die ik heb behandeld, worden over het algemeen genegeerd.

Deze home-stretch-fase omvat het trainen van een reeks modellen en het spelen met de parameters, de gegevensmengsels, het aantal gegevens, de modeltypen, enz. Dit kan snel duur worden, dus je kunt het beste verdomd goede gegevens hebben en je ' Het is beter om te beginnen met kleinere modellen en zo omhoog te bouwen.

Het is allemaal experimenteel, en wat je aan de andere kant krijgt is... een resultaat…

Het is ongelooflijk wat wij mensen verzinnen. Hoe dan ook…

Bij Spirit of Satoshi is ons resultaat nog in de maak, en we werken er op een aantal manieren aan:

- We vragen vrijwilligers om ons te helpen bij het verzamelen en beheren van de meest relevante gegevens voor het model. Dat doen we bij De Nakamoto-opslagplaats. Dit is een opslagplaats van elk boek, essay, artikel, blog, YouTube-video en podcast over en gerelateerd aan Bitcoin, en randapparatuur zoals het werk van Friedrich Nietzsche, Oswald Spengler, Jordan Peterson, Hans-Hermann Hoppe, Murray Rothbard, Carl Jung, de Bijbel, enz.

U kunt daar naar alles zoeken en toegang krijgen tot de URL, het tekstbestand of de pdf. Als een vrijwilliger iets niet kan vinden, of vindt dat het opgenomen moet worden, kan hij een record 'toevoegen'. Als ze echter troep toevoegen, wordt het niet geaccepteerd. Idealiter dienen vrijwilligers de gegevens in als een .txt-bestand, samen met een link.

- Leden van de gemeenschap kunnen dat ook help ons daadwerkelijk de gegevens op te schonen en sats te verdienen. Weet je nog die zendingsfase die ik noemde? Nou, dit is het. Als onderdeel hiervan introduceren we een hele toolbox, en deelnemers kunnen 'FUD buster', 'rankantwoorden' en allerlei andere dingen spelen. Voorlopig is het een soort Tinder-achtige bewaar/weggooi/commentaar-ervaring op de data-interface om op te ruimen wat er in de pijplijn zit.

Dit is een manier voor mensen die jaren hebben besteed aan het leren kennen en begrijpen van Bitcoin om dat "werk" om te zetten in sats. Nee, ze zullen niet rijk worden, maar ze kunnen helpen bijdragen aan iets dat ze een waardig project vinden, en onderweg iets verdienen.

Waarschijnlijkheidsprogramma's, geen AI

In een paar eerdere essays heb ik betoogd dat 'kunstmatige intelligentie' een gebrekkige term is, want terwijl het is kunstmatig, het is niet intelligent - en bovendien is de angstporno rond kunstmatige algemene intelligentie (AGI) volkomen ongegrond omdat er letterlijk geen risico bestaat dat dit ding spontaan bewust wordt en ons allemaal doodt. Een paar maanden verder en ik ben er nog meer van overtuigd.

Ik denk terug aan het uitstekende artikel van John Carter “Ik ben al verveeld met generatieve AI” en hij was zo raak.

Er is echt niets magisch of intelligents aan dit AI-gedoe. Hoe meer we ermee spelen, hoe meer tijd we besteden aan het bouwen van onze eigen, hoe meer we beseffen dat er hier geen gevoel is. Er vindt geen echt denken of redeneren plaats. Er is geen agentschap. Dit zijn slechts 'waarschijnlijkheidsprogramma's'.

De manier waarop ze zijn geëtiketteerd en de gebruikte termen, of het nu "AI" of "machine" is leren' of 'agenten', is eigenlijk waar de meeste angst, onzekerheid en twijfel schuilt.

Deze labels zijn slechts een poging om een reeks processen te beschrijven die echt anders zijn dan alles wat een mens doet. Het probleem met taal is dat we het onmiddellijk beginnen te antropomorfiseren om het te begrijpen. En daarbij is het het publiek of de luisteraar die het monster van Frankenstein tot leven wekt.

AI heeft geen leven anders dan wat je het met je eigen fantasie geeft. Dit is vrijwel hetzelfde met elke andere denkbeeldige, eschatologische dreiging.

(Voeg voorbeelden in over klimaatverandering, buitenaardse wezens of wat er ook gebeurt op Twitter/X.)

Dit is natuurlijk erg handig voor globo-homo bureaucraten die zo'n tool/programma/machine voor hun eigen doeleinden willen gebruiken. Ze draaien al verhalen en verhalen voordat ze konden lopen, en dit is pas de laatste die ze draaien. En omdat de meeste mensen lemmingen zijn en zullen geloven wat iemand die een paar IQ-punten slimmer klinkt dan zij te zeggen heeft, zullen ze dat in hun voordeel gebruiken.

Ik herinner me dat ik sprak over regelgeving die in de pijplijn zit. Ik heb gemerkt dat er vorige week of de week ervoor nu "officiële richtlijnen" of iets dergelijks zijn voor generatieve AI - met dank aan onze bureaucratische opperheren. Wat dit betekent, weet eigenlijk niemand. Het is gemaskeerd in dezelfde onzinnige taal als al hun andere voorschriften. Het nettoresultaat is, nogmaals, "We schrijven de regels, we mogen de tools gebruiken zoals we willen, je moet het gebruiken zoals we je vertellen, of anders."

Het meest belachelijke is dat een stel mensen hierover juichten, denkend dat ze op de een of andere manier veiliger waren voor het denkbeeldige monster dat er nooit was. In feite zullen ze deze bureaus waarschijnlijk crediteren voor "ons redden van AGI", omdat het nooit is uitgekomen.

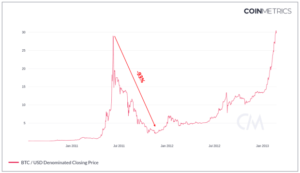

Het doet me hieraan denken:

Toen ik de bovenstaande foto op Twitter plaatste, vertelde het aantal idioten dat oprecht geloofde dat het vermijden van deze catastrofes het gevolg was van toegenomen bureaucratische tussenkomst, me alles wat ik moest weten over het niveau van collectieve intelligentie op dat platform.

Niettemin, hier zijn we. Alweer. Zelfde verhaal, nieuwe personages.

Helaas - daar kunnen we weinig aan doen, behalve ons concentreren op onze eigen dingen. We blijven doen wat we van plan waren te doen.

Ik ben minder enthousiast geworden over "GenAI" in het algemeen, en ik heb het gevoel dat veel van de hype aan het afnemen is nu de aandacht van mensen weer naar buitenaardse wezens en politiek gaat. Ik ben er ook minder van overtuigd dat hier iets substantieel transformerends aan de hand is - althans in de mate die ik zes maanden geleden dacht. Misschien krijg ik ongelijk. Ik denk wel dat deze tools een latent, onbenut potentieel hebben, maar het is gewoon dat: latent.

Ik denk dat we realistischer moeten zijn over wat ze zijn (in plaats van kunstmatige intelligentie is het beter om ze "waarschijnlijkheidsprogramma's" te noemen) en dat zou kunnen betekenen dat we minder tijd en energie besteden aan droombeelden en ons meer richten op het bouwen van nuttige toepassingen. In die zin blijf ik nieuwsgierig en voorzichtig optimistisch dat er iets werkelijkheid wordt, en ik geloof dat ergens in de nexus van Bitcoin, waarschijnlijkheidsprogramma's en protocollen zoals Nostr, iets heel nuttigs zal ontstaan.

Ik heb goede hoop dat we daaraan kunnen deelnemen, en ik zou het leuk vinden als u er ook aan deelneemt als u geïnteresseerd bent. Daartoe zal ik jullie allemaal met rust laten, en ik hoop dat dit een nuttig inzicht van 10 minuten was in wat er nodig is om een taalmodel te bouwen.

Dit is een gastpost van Aleksander Svetski. Geuite meningen zijn volledig van henzelf en komen niet noodzakelijkerwijs overeen met die van BTC Inc of Bitcoin Magazine.

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoData.Network Verticale generatieve AI. Versterk jezelf. Toegang hier.

- PlatoAiStream. Web3-intelligentie. Kennis versterkt. Toegang hier.

- PlatoESG. Automotive / EV's, carbon, CleanTech, Energie, Milieu, Zonne, Afvalbeheer. Toegang hier.

- Plato Gezondheid. Intelligentie op het gebied van biotech en klinische proeven. Toegang hier.

- ChartPrime. Verhoog uw handelsspel met ChartPrime. Toegang hier.

- BlockOffsets. Eigendom voor milieucompensatie moderniseren. Toegang hier.

- Bron: https://bitcoinmagazine.com/culture/how-to-build-your-own-bitcoin-language-model

- : heeft

- :is

- :niet

- :waar

- $UP

- 7

- a

- in staat

- Over

- boven

- aanvaard

- toegang

- actoren

- daadwerkelijk

- werkelijk

- toevoegen

- Voordeel

- weer

- agentschappen

- agentschap

- AGI

- geleden

- AI

- algoritmen

- vreemdelingen

- Alles

- langs

- al

- ook

- am

- bedragen

- an

- en

- beantwoorden

- antwoorden

- elke

- iets

- gebruiken

- toepassingen

- waarderen

- nadering

- ZIJN

- betoogde

- Leger

- rond

- dit artikel

- kunstmatig

- kunstmatige algemene intelligentie

- kunstmatige intelligentie

- AS

- At

- aandacht

- gehoor

- auteur

- terug

- slecht

- BE

- prachtige

- omdat

- worden

- worden

- geweest

- vaardigheden

- beginnen

- wezen

- geloof

- geloofd wie en wat je bent

- BEST

- Betere

- vooringenomenheid

- Beetje

- Bitcoin

- Bitcoin Community

- Bitcoin Magazine

- bitcoin standaard

- Blend

- blends

- Blog

- boek

- Bored

- zowel

- BTC

- BTC Inc.

- bouw

- Gebouw

- bebouwd

- Bos

- bureaucratisch

- maar

- by

- Bellen

- CAN

- kan niet

- Carl

- geval

- gevallen

- rampen

- behoedzaam

- verandering

- veranderd

- tekens

- ChatGPT

- Klimaat

- Klimaatverandering

- verzamelen

- Collectie

- Collective

- hoe

- komt

- komst

- gemeenschap

- compleet

- Wij verbinden

- Overeenstemming

- verband

- contexten

- voortzetten

- blijft

- bijdragen

- Gesprek

- overtuigd

- Coole

- kon

- Koppel

- Type cursus

- bedekt

- Credits

- CrunchBase

- nieuwsgierig

- gegevens

- Database

- dag

- omgang

- achten

- Mate

- beschrijven

- beschreven

- detail

- Bepalen

- onderscheiden

- do

- doet

- Nee

- doen

- Dont

- twijfelen

- beneden

- dromen

- gedurende

- verdienen

- Hoofdartikel

- effectief

- anders

- te voorschijn komen

- einde

- energie-niveau

- genoeg

- verzekeren

- geheel

- vooral

- ESSAY

- etc

- Zelfs

- Event

- Alle

- iedereen

- voorbeeld

- voorbeelden

- uitstekend

- opgewonden

- duur

- ervaring

- experimenteel

- Verklaren

- uitgedrukt

- feit

- angst

- voeden

- voelen

- weinig

- Dien in

- finale

- VIND DE PLEK DIE PERFECT VOOR JOU IS

- gebrekkig

- Focus

- Voor

- formaat

- Foundation

- oprichter

- oppompen van

- vol

- grappig

- Bovendien

- toekomst

- Algemeen

- algemene intelligentie

- algemeen

- gegenereerde

- generatief

- generatieve AI

- echt

- krijgen

- Geven

- Go

- Goes

- gaan

- goed

- GPU's

- dankbaar

- Gast

- Gast Bericht

- HAD

- Hans Hermann Hoppe

- Happening

- Hard

- Hebben

- he

- horen

- gehoord

- hulp

- hier

- geschiedenis

- houden

- hoop

- hoopvol

- Hoe

- How To

- http

- HTTPS

- menselijk

- Mensen

- Hype

- i

- ZIEK

- idee

- ideaal

- if

- denkbeeldig

- verbeelding

- beeld

- per direct

- onmogelijk

- in

- inclusief

- meer

- ongelooflijk

- ongelooflijk

- individuen

- informatie

- ingangen

- inzicht

- verkrijgen in plaats daarvan

- Intelligentie

- Intelligent

- geïnteresseerd

- Interface

- intern

- tussenkomst

- in

- fijne kneepjes

- betrokken zijn

- problemen

- IT

- artikelen

- John

- Jordan

- Jordan Peterson

- jpg

- voor slechts

- Houden

- gehouden

- Soort

- blijven

- labels

- taal

- Achternaam*

- laatste

- leren

- minst

- Verlof

- links

- minder

- Niveau

- ligt

- Life

- als

- Waarschijnlijk

- LINK

- luisteraar

- Elke kleine stap levert grote resultaten op!

- ladingen

- lot

- liefde

- magazine

- Hoofdstroom

- maken

- maken

- handmatig

- veel

- veel mensen

- materialiseren

- Materie

- me

- gemiddelde

- middel

- Leden

- vermeld

- voldaan

- Microsoft

- macht

- Missie

- model

- modellen

- wijzigen

- geld

- maanden

- meer

- meest

- beweegt

- veel

- meervoudig

- Murray

- Dan moet je

- Nakamoto

- verhalen

- nodig

- noodzakelijk

- Noodzaak

- nodig

- behoeften

- netto

- nooit

- New

- band

- geen

- Geluid

- Onze

- niets

- Merk op..

- nu

- of

- korting

- vaak

- on

- eens

- EEN

- Slechts

- naar

- OpenAI

- Advies

- Meningen

- Optimistisch

- or

- bestellen

- Overige

- onze

- uit

- het te bezitten.

- betaald

- paren

- parameters

- deel

- deelnemers

- Mensen

- mensen

- presteert

- misschien

- randapparatuur

- Peterson

- beeld

- stuk

- pijp

- pijpleiding

- vliegtuig

- platform

- Plato

- Plato gegevensintelligentie

- PlatoData

- Spelen

- spelen

- Podcast

- punten

- politiek

- Post

- geplaatst

- potentieel

- voorbereiding

- vorig

- waarschijnlijk

- probleem

- processen

- verwerking

- produceren

- Programma's

- project

- protocollen

- bewezen

- doeleinden

- kwaliteit

- hoeveelheid

- Quantum

- vraag

- snel

- Woede

- Rauw

- vast

- realistisch

- realiseren

- werkelijk

- record

- reflecteren

- Regulatie

- reglement

- verwant

- relevante

- blijven

- niet vergeten

- bewaarplaats

- Reageren

- reacties

- resultaat

- terugkeer

- Rijk

- Risico

- Rollen

- reglement

- veiliger

- dezelfde

- Satoshi

- clausule

- ervaren

- Scale

- krassen

- scherm

- Ontdek

- zien

- lijkt

- zin

- -Series

- reeks

- moet

- gelijk

- Eenvoudig

- sinds

- zit

- ZES

- Zes maanden

- kleinere

- slimmer

- So

- OPLOSSEN

- sommige

- Iemand

- iets

- ergens

- besteden

- besteed

- spinnen

- geest

- spleet

- Spot

- Stadium

- standaard

- standpunt

- Start

- Still

- opgeslagen

- Blog

- Verhaal

- onderwerpen

- voorleggen

- wezenlijk

- dergelijk

- nabijgelegen

- Nemen

- neemt

- het nemen

- Talk

- praat

- vertellen

- termijn

- termen

- neem contact

- dat

- De

- hun

- Ze

- harte

- Er.

- Deze

- ze

- ding

- spullen

- denken

- het denken

- dit

- die

- toch?

- gedachte

- bedreiging

- Door

- niet de tijd of

- naar

- Toolbox

- tools

- in de richting van

- Trainingen

- Transformeren

- transformatieve

- proberen

- X

- types

- Onzekerheid

- die ten grondslag liggen

- begrijpen

- begrip

- eenheden

- anders

- onaangeboord

- tot

- URL

- us

- .

- gebruikt

- zeer

- Video

- vrijwilliger

- vrijwilligers

- willen

- gezocht

- was

- Manier..

- manieren

- we

- webp

- week

- GOED

- Wat

- wat

- wanneer

- of

- welke

- en

- WIE

- geheel

- Waarom

- wil

- Met

- Mijn werk

- werkzaam

- Bedrijven

- zou

- schrijven

- Verkeerd

- jaar

- nog

- You

- Your

- youtube

- zephyrnet