Bias-detectie in gegevens en modeluitkomsten is een fundamentele vereiste voor het bouwen van verantwoorde modellen voor kunstmatige intelligentie (AI) en machine learning (ML). Helaas is het detecteren van vooringenomenheid geen gemakkelijke taak voor de overgrote meerderheid van de beoefenaars vanwege het grote aantal manieren waarop het kan worden gemeten en verschillende factoren die kunnen bijdragen aan een vertekend resultaat. Een onevenwichtige bemonstering van de trainingsgegevens kan bijvoorbeeld resulteren in een model dat minder nauwkeurig is voor bepaalde subsets van de gegevens. Bias kan ook worden geïntroduceerd door het ML-algoritme zelf - zelfs met een goed uitgebalanceerde trainingsdataset kunnen de resultaten bepaalde subsets van de gegevens bevoordelen in vergelijking met de andere.

Om vooringenomenheid te detecteren, moet u een grondig begrip hebben van verschillende soorten vooroordelen en de bijbehorende bias-statistieken. Op het moment van schrijven van bijv. Amazon SageMaker verduidelijken biedt 21 verschillende statistieken om uit te kiezen.

In dit bericht gebruiken we een use-case voor inkomensvoorspelling (het voorspellen van gebruikersinkomsten uit invoerfuncties zoals opleiding en aantal gewerkte uren per week) om verschillende soorten vooroordelen en de bijbehorende statistieken in SageMaker Clarify aan te tonen. We ontwikkelen ook een raamwerk om u te helpen beslissen welke statistieken van belang zijn voor uw toepassing.

Inleiding tot SageMaker Clarify

ML-modellen worden steeds vaker gebruikt om beslissingen te helpen nemen op verschillende domeinen, zoals financiële dienstverlening, gezondheidszorg, onderwijs en human resources. In veel situaties is het belangrijk om te begrijpen waarom het ML-model een specifieke voorspelling deed en ook of de voorspellingen beïnvloed werden door vooringenomenheid.

SageMaker Clarify biedt tools voor beide behoeften, maar in dit bericht richten we ons alleen op de bias-detectiefunctionaliteit. Voor meer informatie over verklaarbaarheid, kijk op Bundesliga Match Facts xGoals uitleggen met Amazon SageMaker Clarify.

SageMaker Clarify maakt deel uit van Amazon Sage Maker, een volledig beheerde service voor het bouwen, trainen en implementeren van ML-modellen.

Voorbeelden van vragen over vooringenomenheid

Om de discussie te onderbouwen, volgen hier enkele voorbeeldvragen die ML-bouwers en hun belanghebbenden kunnen hebben met betrekking tot vooringenomenheid. De lijst bestaat uit enkele algemene vragen die relevant kunnen zijn voor meerdere ML-toepassingen, evenals vragen over specifieke toepassingen zoals het ophalen van documenten.

U kunt zich afvragen, gezien de groepen die in de trainingsgegevens geïnteresseerd zijn (bijvoorbeeld mannen versus vrouwen), welke statistieken ik moet gebruiken om de volgende vragen te beantwoorden:

- Komt de groepsrepresentatie in de trainingsgegevens overeen met de echte wereld?

- Bevoordelen de doellabels in de trainingsgegevens de ene groep boven de andere door er positievere labels aan toe te kennen?

- Heeft het model verschillende nauwkeurigheid voor verschillende groepen?

- Heeft het model in een model dat tot doel heeft gekwalificeerde kandidaten voor werving te identificeren, dezelfde nauwkeurigheid voor verschillende groepen?

- Haalt het model in een model dat tot doel heeft documenten op te halen die relevant zijn voor een invoerquery, in dezelfde verhouding relevante documenten op uit verschillende groepen?

In de rest van dit bericht ontwikkelen we een raamwerk voor het beantwoorden van deze en andere vragen via de statistieken die beschikbaar zijn in SageMaker Clarify.

Gebruik case en context

Dit bericht gebruikt een bestaand voorbeeld van een SageMaker Clarify-taak van de Eerlijkheid en verklaarbaarheid met SageMaker Clarify notebook en verklaart de gegenereerde bias-metrische waarden. De notebook traint een XGBoost-model op de UCI-gegevensset voor volwassenen (Dua, D. en Graff, C. (2019). UCI Machine Learning-opslagplaats. Irvine, CA: Universiteit van Californië, School of Information and Computer Science).

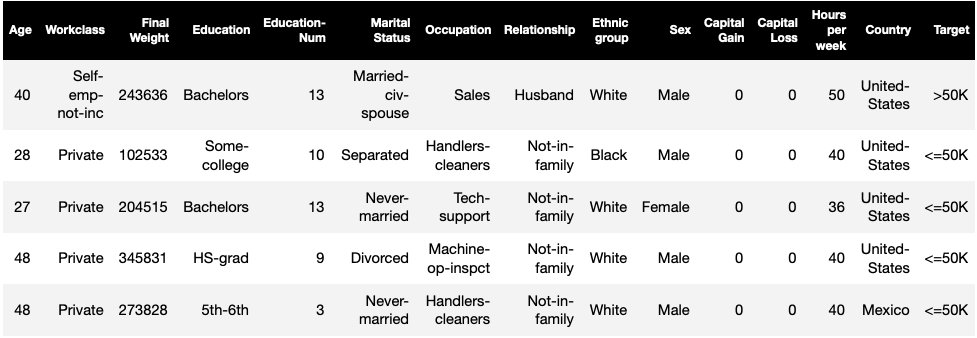

De ML-taak in deze dataset is om te voorspellen of een persoon een jaarinkomen heeft van meer of minder dan $ 50,000. De volgende tabel toont enkele exemplaren met hun kenmerken. Het meten van bias in inkomensvoorspelling is belangrijk omdat we deze voorspellingen zouden kunnen gebruiken om beslissingen te nemen zoals kortingsaanbiedingen en gerichte marketing.

Bias terminologie

Laten we, voordat we dieper duiken, enkele essentiële terminologie doornemen. Voor een volledige lijst met termen, zie Amazon SageMaker verduidelijkt voorwaarden voor vooringenomenheid en eerlijkheid.

- label – De doelfunctie waarvoor het ML-model is getraind om te voorspellen. Een waargenomen label verwijst naar de labelwaarde die wordt waargenomen in de gegevens die worden gebruikt om het model te trainen of te testen. EEN voorspeld label is de waarde die wordt voorspeld door het ML-model. Labels kunnen binair zijn en worden vaak gecodeerd als 0 en 1. We nemen aan dat 1 een gunstig of positief label vertegenwoordigt (bijvoorbeeld een inkomen van meer dan of gelijk aan $ 50,000), en 0 een ongunstig of negatief label vertegenwoordigt. Labels kunnen ook uit meer dan twee waarden bestaan. Zelfs in deze gevallen vormen een of meer van de waarden gunstige labels. Voor de eenvoud beschouwt dit bericht alleen binaire labels. Voor details over het omgaan met labels met meer dan twee waarden en labels met continue waarden (bijvoorbeeld in regressie), zie Whitepaper over eerlijkheid en verklaarbaarheid van Amazon AI.

- Facet – Een kolom of kenmerk ten aanzien waarvan bias wordt gemeten. In ons voorbeeld is het facet

sexen heeft twee waarden:womanenman, gecodeerd alsfemaleenmalein de gegevens (deze gegevens zijn geëxtraheerd uit de volkstelling van 1994 en dwingen een binaire optie af). Hoewel de post een enkel facet met slechts twee waarden beschouwt, voor meer complexe gevallen waarbij meerdere facetten of facetten met meer dan twee waarden betrokken zijn, zie Whitepaper over eerlijkheid en verklaarbaarheid van Amazon AI. - Vooringenomenheid – Een aanzienlijke onbalans in de invoergegevens of modelvoorspellingen over verschillende facetwaarden. Wat "aanzienlijk" is, hangt af van uw toepassing. Voor de meeste statistieken betekent een waarde van 0 dat er geen onbalans is. Bias-statistieken in SageMaker Clarify zijn onderverdeeld in twee categorieën:

- Voortrainen – Indien aanwezig, duidt pre-training bias alleen op onevenwichtigheden in de gegevens.

- Na training – Post-training bias houdt bovendien rekening met de voorspellingen van de modellen.

Laten we elke categorie afzonderlijk bekijken.

Vooringenomenheid voor de training

Pre-training bias-statistieken in SageMaker Clarify beantwoorden de volgende vraag: Hebben alle facetwaarden een gelijke (of vergelijkbare) weergave in de gegevens? Het is belangrijk om de gegevens te inspecteren op vooringenomenheid vóór de training, omdat dit zich kan vertalen in vooringenomenheid na de training in de modelvoorspellingen. Een model dat bijvoorbeeld is getraind op onevenwichtige gegevens waarbij één facetwaarde zeer zelden voorkomt, kan een aanzienlijk slechtere nauwkeurigheid vertonen voor die facetwaarde. Gelijke vertegenwoordiging kan worden berekend over het volgende:

- De volledige trainingsgegevens, ongeacht de labels

- De subset van de trainingsgegevens met alleen positieve labels

- Elk etiket afzonderlijk

De volgende afbeelding geeft een overzicht van hoe elke statistiek in elk van de drie categorieën past.

Sommige categorieën bestaan uit meer dan één metriek. De basisstatistieken (grijze vakken) beantwoorden de vraag over vooringenomenheid in die categorie in de eenvoudigste vorm. Metrieken in witte vakken dekken bovendien speciale gevallen (bijvoorbeeld de paradox van Simpson) en gebruikersvoorkeuren (bijvoorbeeld gericht op bepaalde delen van de bevolking bij het berekenen van voorspellende prestaties).

Representatie van facetwaarden ongeacht labels

De enige statistiek in deze categorie is Klasse-onbalans (CI). Het doel van deze metriek is om te meten of alle facetwaarden een gelijke representatie hebben in de gegevens.

CI is het verschil in de fractie van de gegevens die wordt gevormd door de twee facetwaarden. In onze voorbeelddataset, voor het facet sex, blijkt uit de uitsplitsing (weergegeven in het cirkeldiagram) dat vrouwen 32.4% van de trainingsgegevens uitmaken, terwijl mannen 67.6% uitmaken. Als resultaat:

CI = 0.676 - 0.324 = 0.352

Een ernstig hoge klasse-onbalans kan leiden tot slechtere voorspellende prestaties voor de facetwaarde met een kleinere representatie.

Weergave van facetwaarden alleen op het niveau van positieve labels

Een andere manier om gelijke representatie te meten is om te controleren of alle facetwaarden een vergelijkbare fractie monsters met positief waargenomen labels bevatten. Positieve labels bestaan uit gunstige resultaten (bijvoorbeeld verstrekte lening, geselecteerd voor de baan), dus door positieve labels afzonderlijk te analyseren, kunt u beoordelen of de gunstige beslissingen gelijkmatig zijn verdeeld.

In onze voorbeeldgegevensset vallen de waargenomen labels uiteen in positieve en negatieve waarden, zoals weergegeven in de volgende afbeelding.

11.4% van alle vrouwen en 31.4% van alle mannen hebben het positieve label (donker gearceerd gebied in de linker- en rechterbalk). Het verschil in positieve verhoudingen in labels (DPL) meet dit verschil.

DPL = 0.314 - 0.114 = 0.20

De geavanceerde metriek in deze categorie, Conditional Demographic Disparity in Labels (CDDL), meet de verschillen in de positieve labels, maar stratificeert ze met betrekking tot een andere variabele. Deze statistiek helpt bij de controle voor de Simpsons paradox Simpson, een geval waarin een berekening over de hele gegevens vooringenomenheid vertoont, maar de vooringenomenheid verdwijnt wanneer de gegevens worden gegroepeerd met betrekking tot enige neveninformatie.

De 1973 Toelatingsonderzoek UC Berkeley geeft een voorbeeld. Volgens de gegevens werden mannen vaker toegelaten dan vrouwen. Bij onderzoek op het niveau van de afzonderlijke universitaire afdelingen werden vrouwen echter in elk departement met een vergelijkbaar of hoger percentage toegelaten. Deze observatie kan worden verklaard door de Simpson's paradox, die hier ontstond doordat vrouwen zich aanmeldden op scholen die competitiever waren. Als gevolg hiervan werden in het algemeen minder vrouwen toegelaten dan mannen, hoewel ze school voor school met een vergelijkbaar of hoger percentage werden toegelaten.

Voor meer details over hoe CDDL wordt berekend, zie: Whitepaper over eerlijkheid en verklaarbaarheid van Amazon AI.

Facetwaardeweergave op het niveau van elk label afzonderlijk

Gelijkheid in vertegenwoordiging kan ook worden gemeten voor elk afzonderlijk label, niet alleen voor het positieve label.

Metrieken in deze categorie berekenen het verschil in de labeldistributie van verschillende facetwaarden. De labelverdeling voor een facetwaarde bevat alle waargenomen labelwaarden, samen met de fractie monsters met de waarde van dat label. In de figuur met labelverdelingen heeft bijvoorbeeld 88.6% van de vrouwen een negatief waargenomen label en 11.4% een positief waargenomen label. Dus de labelverdeling voor vrouwen is [0.886, 0.114] en voor mannen is [0.686, 0.314].

De basismetriek in deze categorie, Kullback-Leibler divergentie (KL), meet dit verschil als:

KL = [0.686 x log(0.686/0.886)] + [0.314 x log(0.314/0.114)] = 0.143

De geavanceerde statistieken in deze categorie, Jensen-Shannon divergentie (JS), Lp-norm (LP), Total Variation Distance (TVD) en Kolmogorov-Smirnov (KS), meten ook het verschil tussen de verdelingen, maar hebben verschillende wiskundige eigenschappen. Behoudens speciale gevallen, zullen ze inzichten opleveren die vergelijkbaar zijn met die van KL. Hoewel de KL-waarde bijvoorbeeld oneindig kan zijn wanneer een facetwaarde geen samples met een bepaald label bevat (bijvoorbeeld geen mannen met een negatief label), vermijdt JS deze oneindige waarden. Voor meer informatie over deze verschillen, zie: Whitepaper over eerlijkheid en verklaarbaarheid van Amazon AI.

Relatie tussen DPL (categorie 2) en op distributie gebaseerde statistieken van KL/JS/LP/TVD/KS (categorie 3)

Op distributie gebaseerde statistieken zijn natuurlijker van toepassing op niet-binaire labels. Voor binaire labels, vanwege het feit dat onbalans in het positieve label kan worden gebruikt om de onbalans in negatief label te berekenen, leveren de distributiestatistieken dezelfde inzichten als DPL. Daarom kunt u in dergelijke gevallen gewoon DPL gebruiken.

Vooringenomenheid na de training

Post-training bias-statistieken in SageMaker Clarify helpen ons twee belangrijke vragen te beantwoorden:

- Worden alle facetwaarden even snel weergegeven in positieve (gunstige) modelvoorspellingen?

- Heeft het model vergelijkbare voorspellende prestaties voor alle facetwaarden?

De volgende afbeelding laat zien hoe de metrieken op elk van deze vragen passen. De tweede vraag kan verder worden uitgesplitst afhankelijk van op welk label de prestatie wordt gemeten.

Gelijke vertegenwoordiging in positieve modelvoorspellingen

Metrieken in deze categorie controleren of alle facetwaarden een vergelijkbare fractie monsters bevatten met een positief voorspeld label door het model. Deze klasse van metrieken lijkt sterk op de pre-trainingsstatistieken van DPL en CDDL - het enige verschil is dat deze categorie voorspelde labels in plaats van waargenomen labels beschouwt.

In onze voorbeelddataset krijgt 4.5% van alle vrouwen het positieve label toegewezen door het model en 13.7% van alle mannen het positieve label.

De basisstatistiek in deze categorie, Verschil in positieve proporties in voorspelde labels (DPPL), meet het verschil in de positieve klastoewijzingen.

DPPL = 0.137 - 0.045 = 0.092

Merk op hoe in de trainingsgegevens een hogere fractie van de mannen een positief waargenomen label had. Op een vergelijkbare manier krijgt een hogere fractie mannen een positief voorspeld label toegewezen.

Door naar de geavanceerde statistieken in deze categorie te gaan, meet Disparate Impact (DI) dezelfde ongelijkheid in positieve klasopdrachten, maar in plaats van het verschil berekent het de verhouding:

DI = 0.045 / 0.137 = 0.328

Zowel DI als DPPL brengen kwalitatief vergelijkbare inzichten over, maar verschillen in sommige hoekgevallen. Verhoudingen hebben bijvoorbeeld de neiging tot zeer grote getallen te exploderen als de noemer klein is. Neem een voorbeeld van de getallen 0.1 en 0.0001. De verhouding is 0.1/0.0001 = 10,000 terwijl het verschil 0.1 – 0.0001 ≈ 0.1 is. In tegenstelling tot de andere metrieken waar een waarde van 0 geen vertekening impliceert, komt voor DI geen vertekening overeen met een waarde van 1.

Voorwaardelijke demografische ongelijkheid in voorspelde labels (CDDPL) meet de ongelijkheid in de representatie van facetwaarden in het positieve label, maar net als de pre-trainingsmetriek van CDDL, controleert het ook voor de Simpson-paradox.

Counterfactual Fliptest (FT) meet of vergelijkbare steekproeven van de twee facetwaarden vergelijkbare beslissingen van het model krijgen. Een model dat verschillende beslissingen toewijst aan twee steekproeven die op elkaar lijken maar verschillen in de facetwaarden, kan als vertekend worden beschouwd omdat de facetwaarde het ongunstige (negatieve) label krijgt toegewezen. Gegeven de eerste facetwaarde (vrouwen), wordt beoordeeld of vergelijkbare leden met de andere facetwaarde (mannen) een andere modelvoorspelling hebben. Vergelijkbare leden worden gekozen op basis van het k-nearest-buuralgoritme.

Gelijke prestaties

De modelvoorspellingen kunnen een vergelijkbare representatie hebben in positieve labels van verschillende facetwaarden, maar de modelprestaties op deze groepen kunnen aanzienlijk verschillen. In veel toepassingen kan het wenselijk zijn om vergelijkbare voorspellende prestaties te hebben voor verschillende facetwaarden. De statistieken in deze categorie meten het verschil in voorspellende prestaties tussen facetwaarden.

Omdat de gegevens op veel verschillende manieren kunnen worden gesegmenteerd op basis van de waargenomen of voorspelde labels, zijn er veel verschillende manieren om voorspellende prestaties te meten.

Gelijke voorspellende prestaties, ongeacht labels

Je zou de modelprestaties op alle gegevens kunnen beschouwen, ongeacht de waargenomen of voorspelde labels - dat wil zeggen, de algehele nauwkeurigheid.

De volgende afbeeldingen laten zien hoe het model invoer van de twee facetwaarden in onze voorbeeldgegevensset classificeert. True-negatieven (TN) zijn gevallen waarin zowel het waargenomen als het voorspelde label 0 was. Valse positieven (FP) zijn misclassificaties waarbij het waargenomen label 0 was maar het voorspelde label 1. True positives (TP) en fout-negatieven (FN) zijn gedefinieerd op dezelfde manier.

|

|

Voor elke facetwaarde is de algehele modelprestatie, dat wil zeggen de nauwkeurigheid voor die facetwaarde:

Nauwkeurigheid = (TN + TP) / (TN + FP + FN + TP)

Met deze formule is de nauwkeurigheid voor vrouwen 0.930 en voor mannen 0.815. Dit leidt tot de enige statistiek in deze categorie, Nauwkeurigheidsverschil (AD):

AD = 0.815 - 0.930 = -0.115

AD = 0 betekent dat de nauwkeurigheid voor beide groepen gelijk is. Grotere (positieve of negatieve) waarden duiden op grotere verschillen in nauwkeurigheid.

Gelijke prestaties alleen op positieve labels

U kunt de analyse van de modelprestaties beperken tot alleen positieve labels. Als de toepassing bijvoorbeeld gaat over het detecteren van defecten aan een assemblagelijn, kan het wenselijk zijn om te controleren of niet-defecte onderdelen (positief label) van verschillende soorten (facetwaarden) in hetzelfde tempo als niet-defect worden geclassificeerd. Deze hoeveelheid wordt recall of true positive rate genoemd:

Terugroepen = TP / (TP + FN)

In onze voorbeelddataset is de terugroepactie voor vrouwen 0.389 en de terugroepactie voor mannen 0.425. Dit leidt tot de basismetriek in deze categorie, het Recall Difference (RD):

RD = 0.425 - 0.389 = 0.036

Laten we nu eens kijken naar de drie geavanceerde statistieken in deze categorie, zien welke gebruikersvoorkeuren ze coderen en hoe ze verschillen van de basisstatistiek van RD.

Ten eerste, in plaats van de prestatie te meten op de positief geobserveerde labels, zou je deze kunnen meten op de positief voorspelde labels. Gegeven een facetwaarde, zoals vrouwen, en alle steekproeven met die facetwaarde die door het model als positief worden voorspeld, hoeveel worden er dan daadwerkelijk als positief geclassificeerd? Deze hoeveelheid wordt acceptatiegraad (AR) of precisie genoemd:

AR = TP / (TP + FP)

In ons voorbeeld is de AR voor vrouwen 0.977 en de AR voor mannen 0.970. Dit leidt tot het verschil in acceptatiegraad (DAR):

DAR = 0.970 - 0.977 = -0.007

Een andere manier om bias te meten, is door de vorige twee statistieken te combineren en te meten hoeveel meer positieve voorspellingen de modellen aan een facetwaarde toewijzen in vergelijking met de waargenomen positieve labels. SageMaker Clarify meet dit voordeel door het model als de verhouding tussen het aantal waargenomen positieve labels voor die facetwaarde en het aantal voorspelde positieve labels, en verwijst ernaar als voorwaardelijke acceptatie (CA):

CA = (TP + FN) / (TP + FP)

In ons voorbeeld is de CA voor vrouwen 2.510 en voor mannen 2.283. Het verschil in CA leidt tot de laatste statistiek in deze categorie, Difference in Conditional Acceptance (DCA):

DCA = 2.283 - 2.510 = -0.227

Gelijke prestaties alleen op negatieve labels

Op een manier die vergelijkbaar is met positieve labels, kan bias ook worden berekend als het prestatieverschil op de negatieve labels. Het afzonderlijk beschouwen van negatieve labels kan in bepaalde toepassingen belangrijk zijn. In ons voorbeeld van defectdetectie willen we bijvoorbeeld defecte onderdelen (negatief label) van verschillende soorten (facetwaarde) in hetzelfde tempo detecteren.

De basismetriek in deze categorie, specificiteit, is analoog aan de terugroepstatistiek (true positive rate). Specificiteit berekent de nauwkeurigheid van het model op monsters met deze facetwaarde die een waargenomen negatief label hebben:

specificiteit = TN / (TN + FP)

In ons voorbeeld (zie de verwarringstabellen) is de specificiteit voor vrouwen en mannen respectievelijk 0.999 en 0.994. Bijgevolg is de Specificiteitsverschil: (SD) is:

SD = 0.994 - 0.999 = -0.005

Verdergaand, net als de acceptatiegraad, is de analoge hoeveelheid voor negatieve labels - het afwijzingspercentage (RR) -:

RR = TN / (TN + FN)

De RR voor vrouwen is 0.927 en voor mannen is 0.791, wat leidt tot het verschil in afwijzingspercentage (DRR):

DRR = 0.927 - 0.791 = -0.136

Ten slotte is de negatieve label-analoog van voorwaardelijke acceptatie, de voorwaardelijke afwijzing (CR), de verhouding tussen het aantal waargenomen negatieve labels voor die facetwaarde en het aantal voorspelde negatieve labels:

CR = (TN + FP) / (TN + FN)

De CR voor vrouwen is 0.928 en voor mannen 0.796. De laatste statistiek in deze categorie is het verschil in voorwaardelijke afwijzing (DCR):

DCR = 0.796 - 0.928 = 0.132

Gelijke prestaties op positieve versus negatieve labels

SageMaker Clarify combineert de vorige twee categorieën door rekening te houden met de prestatieverhouding van het model op de positieve en negatieve labels. Specifiek berekent SageMaker Clarify voor elke facetwaarde de verhouding tussen valse negatieven (FN) en valse positieven (FP). In ons voorbeeld is de FN/FP-verhouding voor vrouwen 679/10 = 67.9 en voor mannen 3678/84 = 43.786. Dit leidt tot de meetwaarde Treatment Equality (TE), die het verschil meet tussen de FP/FN-ratio:

TE = 67.9 - 43.786 = 24.114

De volgende schermafbeelding laat zien hoe u SageMaker Clarify kunt gebruiken met: Amazon SageMaker Studio om de waarden, bereiken en korte beschrijvingen van verschillende bias-statistieken weer te geven.

Vragen over vooringenomenheid: met welke statistieken moet u beginnen?

Denk aan de voorbeeldvragen over vooringenomenheid aan het begin van dit bericht. Nadat u de statistieken uit verschillende categorieën heeft doorgenomen, kunt u de vragen opnieuw bekijken. Om de eerste vraag te beantwoorden, die betrekking heeft op de representaties van verschillende groepen in de trainingsdata, zou je kunnen beginnen met de Class Imbalance (CI) metric. Op dezelfde manier kunt u voor de resterende vragen beginnen met respectievelijk te kijken naar het verschil in positieve proporties in labels (DPL), nauwkeurigheidsverschil (AD), verschil in acceptatiepercentage (DAR) en terugroepverschil (RD).

Bias zonder facetwaarden

Voor het gemak van de expositie heeft deze beschrijving van post-trainingsstatistieken de Generalized Entropy Index (GE) -metriek uitgesloten. Deze statistiek meet vertekening zonder rekening te houden met de facetwaarde, en kan nuttig zijn bij het beoordelen hoe de modelfouten worden verdeeld. Voor details, zie: Gegeneraliseerde entropie (GE).

Conclusie

In dit bericht heb je gezien hoe de 21 verschillende statistieken in SageMaker Clarify bias meten in verschillende stadia van de ML-pijplijn. U leerde over verschillende statistieken via een use case voor inkomensvoorspelling, hoe u statistieken voor uw use case kiest en met welke u zou kunnen beginnen.

Ga aan de slag met uw verantwoorde AI-reis door vooringenomenheid in uw ML-modellen te beoordelen met behulp van de demo-notebook Eerlijkheid en verklaarbaarheid met SageMaker Clarify. U kunt de gedetailleerde documentatie voor SageMaker Clarify, inclusief de formele definitie van metrieken, vinden op: Wat is eerlijkheid en modelverklaarbaarheid voor voorspellingen van machine learning?. Voor de open-source implementatie van de bias-statistieken, raadpleeg de: aws-sagemaker-clarify GitHub-repository. Voor een gedetailleerde bespreking inclusief beperkingen, zie: Whitepaper over eerlijkheid en verklaarbaarheid van Amazon AI.

Over de auteurs

Bilal Zafar is Applied Scientist bij AWS en werkt aan Fairness, Explainability en Security in Machine Learning.

Bilal Zafar is Applied Scientist bij AWS en werkt aan Fairness, Explainability en Security in Machine Learning.

Denis V Batalov is Solutions Architect voor AWS, gespecialiseerd in Machine Learning. Hij werkt sinds 2005 bij Amazon. Denis is gepromoveerd op het gebied van AI. Volg hem op Twitter: @dbatalov.

Michelle Donini is Sr Applied Scientist bij AWS. Hij leidt een team van wetenschappers die werken aan verantwoorde AI en zijn onderzoeksinteresses zijn Algorithmic Fairness en Explainable Machine Learning.

Michelle Donini is Sr Applied Scientist bij AWS. Hij leidt een team van wetenschappers die werken aan verantwoorde AI en zijn onderzoeksinteresses zijn Algorithmic Fairness en Explainable Machine Learning.

- AI

- ai kunst

- ai kunst generator

- je hebt een robot

- Amazon Sage Maker

- kunstmatige intelligentie

- certificering van kunstmatige intelligentie

- kunstmatige intelligentie in het bankwezen

- kunstmatige intelligentie robot

- kunstmatige intelligentie robots

- kunstmatige intelligentiesoftware

- AWS-machine learning

- blockchain

- blockchain conferentie ai

- vindingrijk

- conversatie kunstmatige intelligentie

- crypto conferentie ai

- van dall

- diepgaand leren

- google ai

- machine learning

- Plato

- plato ai

- Plato gegevensintelligentie

- Plato-spel

- PlatoData

- platogamen

- schaal ai

- syntaxis

- zephyrnet