Kunstmatige intelligentie (AI) is een snel evoluerend veld met het potentieel om vele aspecten van de samenleving te verbeteren en te transformeren. In 2023 is het tempo van de adoptie van AI-technologieën verder versneld met de ontwikkeling van krachtige basismodellen (FM’s) en een daaruit voortvloeiende vooruitgang in generatieve AI-mogelijkheden.

Bij Amazon hebben we meerdere generatieve AI-diensten gelanceerd, zoals Amazonebodem en Amazon Code Whisperer, en hebben een reeks zeer capabele generatieve modellen beschikbaar gemaakt via Amazon SageMaker JumpStart. Deze diensten zijn ontworpen om onze klanten te ondersteunen bij het ontsluiten van de opkomende mogelijkheden van generatieve AI, waaronder verbeterde creativiteit, gepersonaliseerde en dynamische contentcreatie en innovatief ontwerp. Ze kunnen AI-beoefenaars ook in staat stellen de wereld te begrijpen als nooit tevoren, door taalbarrières, klimaatverandering aan te pakken, wetenschappelijke ontdekkingen te versnellen en meer.

Om het volledige potentieel van generatieve AI te realiseren, is het echter belangrijk om zorgvuldig na te denken over eventuele risico’s. In de eerste plaats komt dit ten goede aan de belanghebbenden van het AI-systeem door het bevorderen van een verantwoorde en veilige ontwikkeling en inzet, en door het aanmoedigen van de vaststelling van proactieve maatregelen om de potentiële impact aan te pakken. Bijgevolg is het opzetten van mechanismen om risico’s te beoordelen en te beheren een belangrijk proces dat AI-beoefenaars moeten overwegen en is het een kerncomponent geworden van veel opkomende AI-industriestandaarden (bijvoorbeeld ISO 42001 , ISO 23894 en NIST RMF) en wetgeving (zoals EU AI-wet).

In dit bericht bespreken we hoe u het potentiële risico van uw AI-systeem kunt beoordelen.

Wat zijn de verschillende risiconiveaus?

Hoewel het misschien gemakkelijker is om een individueel machine learning (ML)-model en de bijbehorende risico's afzonderlijk te bekijken, is het belangrijk om de details van de specifieke toepassing van een dergelijk model en de bijbehorende gebruikscasus te overwegen als onderdeel van een compleet AI-systeem. . In feite is een typisch AI-systeem waarschijnlijk gebaseerd op meerdere verschillende ML-modellen die samenwerken, en een organisatie wil mogelijk meerdere verschillende AI-systemen bouwen. Bijgevolg kunnen risico’s voor elke gebruikssituatie en op verschillende niveaus worden geëvalueerd, namelijk modelrisico, AI-systeemrisico en ondernemingsrisico.

Ondernemingsrisico omvat het brede spectrum aan risico's waarmee een organisatie te maken kan krijgen, inclusief financiële, operationele en strategische risico's. Het AI-systeemrisico richt zich op de impact die gepaard gaat met de implementatie en werking van AI-systemen, terwijl het ML-modelrisico specifiek betrekking heeft op de kwetsbaarheden en onzekerheden die inherent zijn aan ML-modellen.

In dit bericht concentreren we ons vooral op de risico's van AI-systemen. Het is echter belangrijk op te merken dat alle verschillende niveaus van risicobeheer binnen een organisatie in overweging moeten worden genomen en op elkaar moeten worden afgestemd.

Hoe wordt het AI-systeemrisico gedefinieerd?

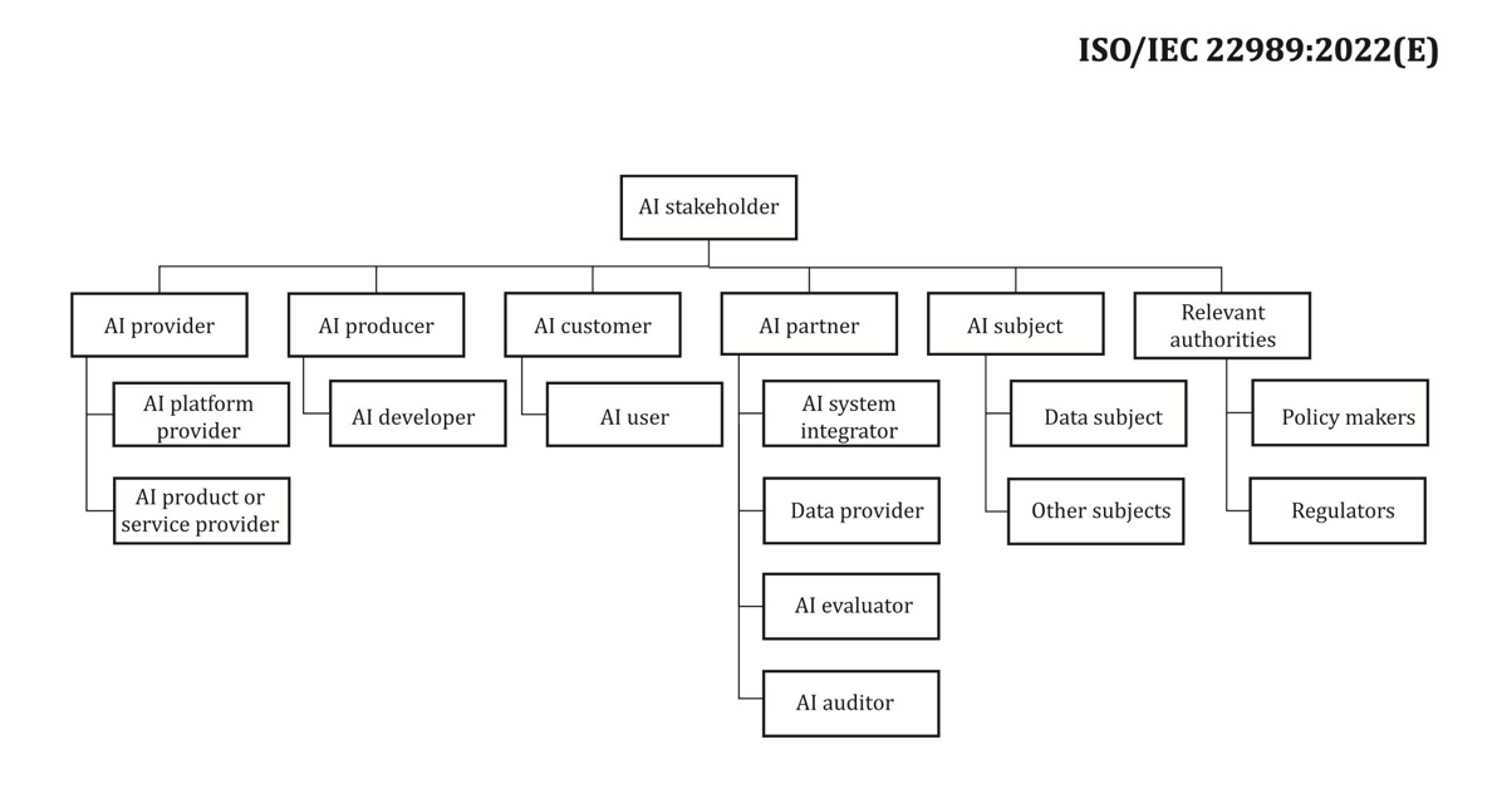

Risicobeheer in de context van een AI-systeem kan een manier zijn om het effect van onzekerheid of potentiële negatieve gevolgen te minimaliseren, terwijl het ook mogelijkheden biedt om de positieve gevolgen te maximaliseren. Risico zelf is geen potentiële schade, maar het effect van onzekerheid op doelstellingen. Volgens de NIST-kader voor risicobeheer (NIST RMF) kan het risico worden geschat als een multiplicatieve maatstaf voor de waarschijnlijkheid dat een gebeurtenis zal plaatsvinden, getimed door de omvang van de gevolgen van de overeenkomstige gebeurtenis.

Er zijn twee aspecten aan risico: inherent risico en restrisico. Inherent risico vertegenwoordigt de hoeveelheid risico die het AI-systeem vertoont als er geen mitigaties of controles zijn. Residueel risico omvat de resterende risico's nadat rekening is gehouden met mitigatiestrategieën.

Houd er altijd rekening mee dat risicobeoordeling een mensgerichte activiteit is die inspanningen van de hele organisatie vereist; Deze inspanningen variëren van het garanderen dat alle relevante belanghebbenden bij het beoordelingsproces worden betrokken (zoals product-, engineering-, wetenschaps-, verkoop- en beveiligingsteams) tot het beoordelen hoe sociale perspectieven en normen de waargenomen waarschijnlijkheid en gevolgen van bepaalde gebeurtenissen beïnvloeden.

Waarom zou uw organisatie zich druk maken over risico-evaluatie?

Het opzetten van risicobeheerkaders voor AI-systemen kan de samenleving als geheel ten goede komen door het veilige en verantwoorde ontwerp, de ontwikkeling en de werking van AI-systemen te bevorderen. Kaders voor risicobeheer kunnen organisaties ook ten goede komen door het volgende:

- Verbeterde besluitvorming – Door inzicht te krijgen in de risico’s die aan AI-systemen zijn verbonden, kunnen organisaties betere beslissingen nemen over hoe ze deze risico’s kunnen beperken en hoe ze AI-systemen op een veilige en verantwoorde manier kunnen gebruiken

- Verbeterde nalevingsplanning – Een raamwerk voor risicobeoordeling kan organisaties helpen bij de voorbereiding op de vereisten voor risicobeoordeling in relevante wet- en regelgeving

- Vertrouwen opbouwen – Door aan te tonen dat zij stappen ondernemen om de risico’s van AI-systemen te beperken, kunnen organisaties hun klanten en stakeholders laten zien dat zij zich inzetten om AI op een veilige en verantwoorde manier in te zetten

Hoe risico inschatten?

Als eerste stap moet een organisatie overwegen om de AI-gebruikscasus te beschrijven die moet worden beoordeeld en alle relevante belanghebbenden te identificeren. Een use case is een specifiek scenario of situatie die beschrijft hoe gebruikers omgaan met een AI-systeem om een bepaald doel te bereiken. Bij het maken van een use case-beschrijving kan het nuttig zijn om het bedrijfsprobleem dat wordt opgelost te specificeren, de betrokken belanghebbenden op te sommen, de workflow te karakteriseren en details te geven over de belangrijkste inputs en outputs van het systeem.

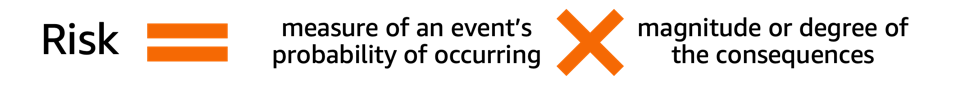

Als het om belanghebbenden gaat, is het gemakkelijk om er een paar over het hoofd te zien. De volgende figuur is een goed startpunt om de rollen van AI-stakeholders in kaart te brengen.

Bron: “Informatietechnologie – Kunstmatige intelligentie – Concepten en terminologie van kunstmatige intelligentie”.

Een belangrijke volgende stap in de risicobeoordeling van het AI-systeem is het identificeren van potentieel schadelijke gebeurtenissen die verband houden met de use case. Bij het overwegen van deze gebeurtenissen kan het nuttig zijn om na te denken over verschillende dimensies van verantwoorde AI, zoals bijvoorbeeld eerlijkheid en robuustheid. Verschillende belanghebbenden kunnen in verschillende mate en op verschillende dimensies worden beïnvloed. Een laag robuustheidsrisico voor een eindgebruiker zou bijvoorbeeld het resultaat kunnen zijn van een AI-systeem dat kleine verstoringen vertoont, terwijl een laag eerlijkheidsrisico veroorzaakt zou kunnen worden doordat een AI-systeem verwaarloosbaar verschillende outputs produceert voor verschillende demografische groepen.

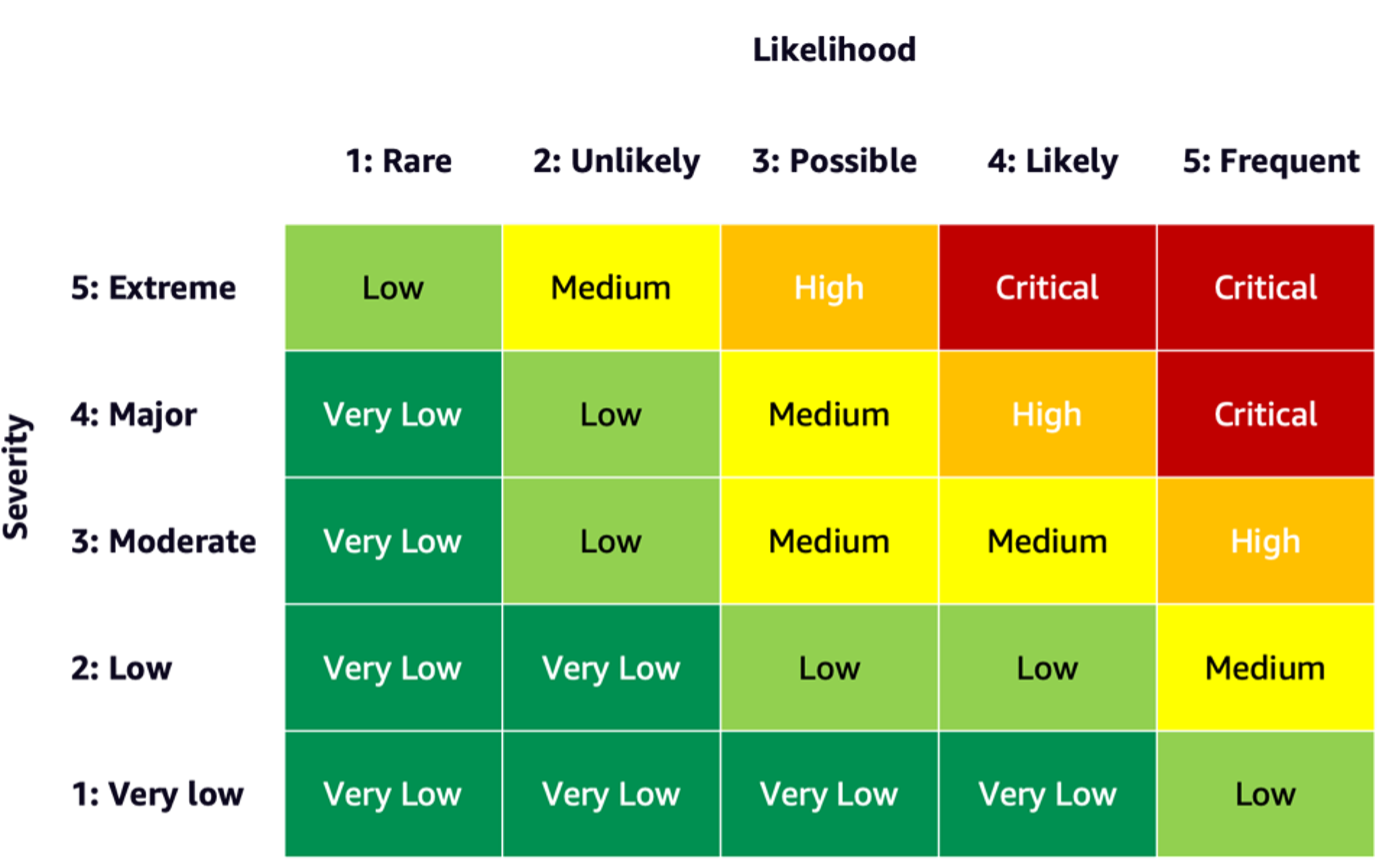

Om het risico van een gebeurtenis in te schatten, kunt u een waarschijnlijkheidsschaal gebruiken in combinatie met een ernstschaal om zowel de waarschijnlijkheid van optreden als de mate van gevolgen te meten. Een nuttig startpunt bij het ontwikkelen van deze schalen zou de NIST RMF kunnen zijn, die voorstelt om kwalitatieve niet-numerieke categorieën te gebruiken, variërend van zeer laag tot zeer hoog risico of semi-kwantitatieve beoordelingsprincipes, zoals schalen (zoals 1-10), bins of anderszins. representatieve cijfers. Nadat u de waarschijnlijkheids- en ernstschalen voor alle relevante dimensies hebt gedefinieerd, kunt u een risicomatrixschema gebruiken om het algehele risico per belanghebbenden langs elke relevante dimensie te kwantificeren. De volgende afbeelding toont een voorbeeld van een risicomatrix.

Met behulp van deze risicomatrix kunnen we een gebeurtenis met een lage ernst en een zeldzame waarschijnlijkheid van optreden beschouwen als een zeer laag risico. Houd er rekening mee dat de initiële beoordeling een schatting zal zijn van het inherente risico, en dat risicobeperkende strategieën kunnen helpen de risiconiveaus verder te verlagen. Het proces kan vervolgens worden herhaald om een beoordeling te genereren voor het eventuele resterende restrisico per gebeurtenis. Als er meerdere gebeurtenissen binnen dezelfde dimensie zijn geïdentificeerd, kan het nuttig zijn om het hoogste risiconiveau te kiezen om een definitieve beoordelingssamenvatting te maken.

Aan de hand van de definitieve beoordelingssamenvatting zullen organisaties moeten definiëren welke risiconiveaus acceptabel zijn voor hun AI-systemen en relevante regelgeving en beleid in overweging moeten nemen.

AWS-toezegging

Door afspraken met de Witte Huis en UNWij willen onder andere onze kennis en expertise delen om het verantwoorde en veilige gebruik van AI te bevorderen. In deze zin vertegenwoordigde Adam Selipsky van Amazon onlangs AWS op de AI-veiligheidstop waarbij staatshoofden en leiders uit de industrie aanwezig waren, wat een verdere demonstratie is van onze toewijding om samen te werken aan de verantwoorde vooruitgang van kunstmatige intelligentie.

Conclusie

Naarmate AI zich blijft ontwikkelen, wordt risicobeoordeling steeds belangrijker en nuttiger voor organisaties die AI op verantwoorde wijze willen bouwen en inzetten. Door een raamwerk voor risicobeoordeling en een plan voor risicobeperking op te zetten, kunnen organisaties het risico op potentiële AI-gerelateerde incidenten verminderen en vertrouwen bij hun klanten winnen, en profiteren van voordelen zoals verbeterde betrouwbaarheid, verbeterde eerlijkheid voor verschillende demografische groepen, en meer.

Ga uw gang en ga aan de slag met het ontwikkelen van een risicobeoordelingskader in uw organisatie en deel uw mening in de opmerkingen.

Bekijk ook een overzicht van generatieve AI-risico’s gepubliceerd op Amazon Science: Verantwoorde AI in het generatieve tijdperken ontdek het scala aan AWS-services die u kunnen ondersteunen bij uw risicobeoordeling en mitigatietraject: Amazon SageMaker verduidelijken, Amazon SageMaker-modelmonitor, AWS CloudTrailAlsmede de model-bestuurskader.

Over de auteurs

Mia C. Mayer is een Applied Scientist en ML-docent aan de AWS Machine Learning University; waar ze de veiligheid, uitlegbaarheid en eerlijkheid van Machine Learning- en AI-systemen onderzoekt en doceert. Gedurende haar carrière heeft Mia verschillende universitaire outreachprogramma's opgezet, trad ze op als gastdocent en keynote speaker, en presenteerde ze op tal van grote leerconferenties. Ook helpt ze interne teams en AWS-klanten op weg met hun verantwoorde AI-reis.

Mia C. Mayer is een Applied Scientist en ML-docent aan de AWS Machine Learning University; waar ze de veiligheid, uitlegbaarheid en eerlijkheid van Machine Learning- en AI-systemen onderzoekt en doceert. Gedurende haar carrière heeft Mia verschillende universitaire outreachprogramma's opgezet, trad ze op als gastdocent en keynote speaker, en presenteerde ze op tal van grote leerconferenties. Ook helpt ze interne teams en AWS-klanten op weg met hun verantwoorde AI-reis.

Denis V Batalov is een 17-jarige Amazon-veteraan en gepromoveerd in machine learning. Denis werkte aan spannende projecten als Search Inside the Book, Amazon Mobile-apps en Kindle Direct Publishing. Sinds 2013 heeft hij als Solutions Architect AWS-klanten geholpen bij het adopteren van AI/ML-technologie. Momenteel is Denis een Worldwide Tech Leader voor AI/ML die verantwoordelijk is voor het functioneren van AWS ML Specialist Solutions Architects wereldwijd. Denis is een veelgevraagd spreker in het openbaar, je kunt hem volgen op Twitter @dbatalov.

Denis V Batalov is een 17-jarige Amazon-veteraan en gepromoveerd in machine learning. Denis werkte aan spannende projecten als Search Inside the Book, Amazon Mobile-apps en Kindle Direct Publishing. Sinds 2013 heeft hij als Solutions Architect AWS-klanten geholpen bij het adopteren van AI/ML-technologie. Momenteel is Denis een Worldwide Tech Leader voor AI/ML die verantwoordelijk is voor het functioneren van AWS ML Specialist Solutions Architects wereldwijd. Denis is een veelgevraagd spreker in het openbaar, je kunt hem volgen op Twitter @dbatalov.

Dr. Sara Liu is een Senior Technical Program Manager bij het AWS Responsible AI-team. Ze werkt samen met een team van wetenschappers, datasetleiders, ML-ingenieurs, onderzoekers en andere multifunctionele teams om de lat voor verantwoorde AI binnen de AI-services van AWS hoger te leggen. Haar huidige projecten omvatten het ontwikkelen van AI-servicekaarten, het uitvoeren van risicobeoordelingen voor verantwoorde AI, het creëren van hoogwaardige evaluatiedatasets en het implementeren van kwaliteitsprogramma's. Ze helpt ook interne teams en klanten te voldoen aan de evoluerende AI-industrienormen.

Dr. Sara Liu is een Senior Technical Program Manager bij het AWS Responsible AI-team. Ze werkt samen met een team van wetenschappers, datasetleiders, ML-ingenieurs, onderzoekers en andere multifunctionele teams om de lat voor verantwoorde AI binnen de AI-services van AWS hoger te leggen. Haar huidige projecten omvatten het ontwikkelen van AI-servicekaarten, het uitvoeren van risicobeoordelingen voor verantwoorde AI, het creëren van hoogwaardige evaluatiedatasets en het implementeren van kwaliteitsprogramma's. Ze helpt ook interne teams en klanten te voldoen aan de evoluerende AI-industrienormen.

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoData.Network Verticale generatieve AI. Versterk jezelf. Toegang hier.

- PlatoAiStream. Web3-intelligentie. Kennis versterkt. Toegang hier.

- PlatoESG. carbon, CleanTech, Energie, Milieu, Zonne, Afvalbeheer. Toegang hier.

- Plato Gezondheid. Intelligentie op het gebied van biotech en klinische proeven. Toegang hier.

- Bron: https://aws.amazon.com/blogs/machine-learning/learn-how-to-assess-risk-of-ai-systems/

- : heeft

- :is

- :niet

- :waar

- 100

- 118

- 150

- 2013

- 2023

- 33

- 7

- a

- Over

- versneld

- versnellen

- aanvaardbaar

- Volgens

- Bereiken

- over

- activiteit

- Adam

- adres

- adopteren

- Adoptie

- bevorderen

- vordering

- beïnvloed

- Na

- vooruit

- AI

- AI-risico's

- AI-diensten

- AI-systemen

- AI / ML

- uitgelijnd

- Alles

- langs

- ook

- Amazone

- Amazon Web Services

- onder

- bedragen

- an

- en

- elke

- Aanvraag

- toegepast

- apps

- architecten

- ZIJN

- kunstmatig

- kunstmatige intelligentie

- AS

- aspecten

- schatten

- geëvalueerd

- Het beoordelen

- beoordeling

- assessments

- geassocieerd

- At

- opkomst

- Beschikbaar

- AWS

- AWS-machine learning

- bars

- barrières

- gebaseerde

- BE

- worden

- worden

- wezen

- voordeel

- betekent

- Betere

- bins

- boek

- breed

- bouw

- bedrijfsdeskundigen

- maar

- by

- CAN

- mogelijkheden

- in staat

- captures

- Kaarten

- verzorging

- Carrière

- voorzichtig

- geval

- categorieën

- veroorzaakt

- zeker

- verandering

- karakteriseren

- controle

- Klimaat

- Klimaatverandering

- samenwerken

- combinatie van

- komt

- opmerkingen

- toegewijd

- compleet

- nakoming

- bestanddeel

- concepten

- uitvoeren

- conferenties

- Gevolgen

- bijgevolg

- Overwegen

- beschouwd

- aangezien

- content

- content creatie

- verband

- blijft

- controles

- Kern

- Overeenkomend

- kon

- en je merk te creëren

- Wij creëren

- het aanmaken

- creativiteit

- multifunctionele teams

- Actueel

- Op dit moment

- Klanten

- datasets

- beslissingen

- toewijding

- bepalen

- gedefinieerd

- Mate

- demografisch

- Demografie

- demonstrating

- implementeren

- inzet

- beschrijven

- beschrijving

- Design

- ontworpen

- gegevens

- het ontwikkelen van

- Ontwikkeling

- anders

- Afmeting

- Afmeting

- directe

- bespreken

- verstoringen

- dynamisch

- elk

- verdienen

- gemakkelijker

- En het is heel gemakkelijk

- effect

- inspanningen

- opkomende

- in staat stellen

- omvat

- bemoedigend

- opdrachten

- Engineering

- Ingenieurs

- verbeterde

- zorgen

- Enterprise

- gevestigd

- oprichting

- schatting

- geschat

- geëvalueerd

- evaluatie

- Event

- EVENTS

- evoluerende

- voorbeeld

- opwindend

- exposeren

- vertoont

- expertise

- Verken

- Gezicht

- feit

- factoring

- eerlijkheid

- veld-

- Figuur

- finale

- financieel

- Voornaam*

- Focus

- richt

- volgen

- volgend

- Voor

- vooral

- Foundation

- Achtergrond

- frameworks

- veelvuldig

- oppompen van

- vol

- functionerende

- verder

- voortbrengen

- generatief

- generatieve AI

- krijgen

- Wereldwijd

- doel

- goed

- bestuur

- Groep

- Gast

- schaden

- schadelijk

- Hebben

- he

- hoofden

- hulp

- geholpen

- nuttig

- helpt

- haar

- Hoge

- hoogwaardige

- hoogst

- zeer

- hem

- Hoe

- How To

- Echter

- HTML

- HTTPS

- geïdentificeerd

- identificeren

- if

- Impact

- Effecten

- uitvoering

- uitvoering

- belangrijk

- verbeteren

- verbeterd

- in

- inclusief

- Inclusief

- in toenemende mate

- individueel

- -industrie

- industriestandaarden

- beïnvloeden

- inherent

- eerste

- innovatieve

- ingangen

- binnen

- Intelligentie

- interactie

- intern

- betrekken

- betrokken zijn

- ISO

- isolatie

- IT

- zelf

- jpg

- Houden

- sleutel

- Grondtoon

- Keynote speaker

- kennis

- taal

- Groot

- gelanceerd

- Wetten

- leider

- leiders

- Leads

- LEARN

- leren

- Wetgeving

- Niveau

- niveaus

- waarschijnlijkheid

- Waarschijnlijk

- lijnen

- Lijst

- op zoek

- Laag

- te verlagen

- machine

- machine learning

- gemaakt

- maken

- beheer

- management

- manager

- veel

- kaart

- Matrix

- Maximaliseren

- Mei..

- maatregel

- maatregelen

- mechanismen

- Maak kennis met

- macht

- denken

- minder

- Verzachten

- verzachting

- ML

- Mobile

- mobiele apps

- model

- modellen

- meer

- meervoudig

- namelijk

- behoeften

- negatief

- nooit

- volgende

- NIST

- normen

- nota

- nummers

- vele

- doelstellingen

- voorval

- voorkomend

- of

- on

- operatie

- operationele

- Kansen

- or

- organisatie

- organisaties

- Overige

- Overig

- anders-

- onze

- uit

- uitgangen

- overtreffen

- totaal

- overzicht

- Tempo

- deel

- bijzonder

- pad

- voor

- waargenomen

- Gepersonaliseerde

- perspectieven

- phd

- kiezen

- plan

- Plato

- Plato gegevensintelligentie

- PlatoData

- punt

- beleidsmaatregelen door te lezen.

- positief

- Post

- potentieel

- mogelijk

- krachtige

- Voorbereiden

- gepresenteerd

- in de eerste plaats

- principes

- Proactieve

- probleem

- producerende

- Product

- Programma

- Programma's

- projecten

- Het bevorderen van

- zorgen voor

- het verstrekken van

- publiek

- gepubliceerde

- Reclame

- kwalitatieve

- kwaliteit

- verhogen

- reeks

- variërend

- snel

- BIJZONDER

- waardering

- realiseren

- oogsten

- onlangs

- verminderen

- reflecteren

- met betrekking tot

- reglement

- relevante

- betrouwbaarheid

- resterende

- herhaald

- vertegenwoordiger

- vertegenwoordigd

- vertegenwoordigt

- Voorwaarden

- vereist

- onderzoekers

- onderzoeken

- verantwoordelijk

- verantwoorde

- resultaat

- verkregen

- Risico

- risico-evaluatie

- risicobeheer

- risico's

- robuustheid

- rollen

- veilig

- Veiligheid

- sagemaker

- verkoop

- dezelfde

- Scale

- balans

- scenario

- schema

- Wetenschap

- wetenschappelijk

- Wetenschapper

- wetenschappers

- Ontdek

- beveiligen

- veiligheid

- senior

- zin

- service

- Diensten

- verscheidene

- Delen

- delen

- ze

- moet

- tonen

- Shows

- sinds

- situatie

- Social

- Maatschappij

- Oplossingen

- sommige

- Spreker

- specialist

- specifiek

- specifiek

- Spectrum

- stakeholders

- stakeholders

- normen

- begin

- gestart

- Start

- Land

- Stap voor

- Stappen

- strategisch

- strategieën

- dergelijk

- Stelt voor

- OVERZICHT

- ondersteuning

- system

- Systems

- het nemen

- team

- teams

- tech

- Technisch

- Technologies

- Technologie

- dat

- De

- de wereld

- hun

- harte

- Er.

- Deze

- ze

- dit

- die

- Door

- overal

- Timed

- naar

- samen

- Transformeren

- Trust

- X

- twee

- typisch

- onzekerheden

- Onzekerheid

- begrip

- universiteit-

- ontgrendelen

- .

- use case

- gebruikers

- gebruik

- zeer

- veteraan

- kwetsbaarheden

- we

- web

- webservices

- GOED

- Wat

- wanneer

- terwijl

- welke

- en

- wil

- Met

- binnen

- werkte

- workflow

- werkzaam

- Bedrijven

- wereld

- wereldwijd

- You

- Your

- zephyrnet