Vandaag kondigen we met trots de mogelijkheid aan om Llama 2-modellen van Meta te verfijnen Amazon SageMaker JumpStart. De Llama 2-familie van grote taalmodellen (LLM's) is een verzameling vooraf getrainde en verfijnde generatieve tekstmodellen, variërend in schaal van 7 miljard tot 70 miljard parameters. Verfijnde LLM's, genaamd Llama-2-chat, zijn geoptimaliseerd voor dialooggebruik. U kunt deze modellen eenvoudig uitproberen en gebruiken met SageMaker JumpStart, een machine learning-hub (ML) die toegang biedt tot algoritmen, modellen en ML-oplossingen, zodat u snel aan de slag kunt met ML. Nu kunt u ook 7 miljard, 13 miljard en 70 miljard parameters Llama 2-tekstgeneratiemodellen op SageMaker JumpStart verfijnen met behulp van de Amazon SageMaker Studio UI met een paar klikken of met behulp van de SageMaker Python SDK.

Generatieve AI-basismodellen vormen al meer dan een jaar de focus van het grootste deel van het onderzoek en de gebruiksscenario's op het gebied van ML en kunstmatige intelligentie. Deze basismodellen presteren zeer goed met generatieve taken, zoals het genereren van tekst, samenvattingen, het beantwoorden van vragen, het genereren van afbeeldingen en video's, en meer, vanwege hun grote omvang en ook omdat ze zijn getraind op verschillende grote datasets en honderden taken. Ondanks de grote generalisatiemogelijkheden van deze modellen zijn er vaak use cases die zeer specifieke domeingegevens bevatten (zoals gezondheidszorg of financiële diensten), waardoor deze modellen mogelijk geen goede resultaten kunnen opleveren voor deze use cases. Dit resulteert in een behoefte aan verdere verfijning van deze generatieve AI-modellen op basis van de use case-specifieke en domeinspecifieke gegevens.

In dit bericht laten we zien hoe u de voorgetrainde tekstgeneratiemodellen van Llama 2 kunt verfijnen via SageMaker JumpStart.

Wat is Lama 2

Llama 2 is een auto-regressief taalmodel dat gebruik maakt van een geoptimaliseerde transformatorarchitectuur. Llama 2 is bedoeld voor commercieel en onderzoeksgebruik in het Engels. Het wordt geleverd in een reeks parametergroottes - 7 miljard, 13 miljard en 70 miljard - evenals vooraf getrainde en nauwkeurig afgestelde variaties. Volgens Meta gebruiken de afgestemde versies gesuperviseerde fijnafstemming (SFT) en versterkend leren met menselijke feedback (RLHF) om af te stemmen op menselijke voorkeuren voor behulpzaamheid en veiligheid. Lama 2 is vooraf getraind op 2 biljoen tokens aan gegevens uit openbaar beschikbare bronnen. De afgestemde modellen zijn bedoeld voor assistent-achtige chat, terwijl vooraf getrainde modellen kunnen worden aangepast voor een verscheidenheid aan taken voor het genereren van natuurlijke taal. Ongeacht welke versie van het model een ontwikkelaar gebruikt, de gids voor verantwoord gebruik van Meta kan helpen bij het begeleiden van aanvullende fijnafstellingen die nodig kunnen zijn om de modellen aan te passen en te optimaliseren met de juiste veiligheidsbeperkingen.

Momenteel is Llama 2 beschikbaar in de volgende regio's:

- Implementeer vooraf getraind model beschikbaar:

"us-west-2","us-east-1","us-east-2","eu-west-1","ap-southeast-1","ap-southeast-2" - Verfijn en implementeer het verfijnde model:

“us-east-1”,“us-west-2”,“eu-west-1”

Wat is SageMaker JumpStart

Met SageMaker JumpStart kunnen ML-beoefenaars kiezen uit een brede selectie van openbaar beschikbare basismodellen. ML-beoefenaars kunnen basismodellen inzetten voor specifieke toepassingen Amazon Sage Maker instances uit een netwerkgeïsoleerde omgeving en pas modellen aan met SageMaker voor modeltraining en implementatie. U kunt Llama 2 nu ontdekken en implementeren met een paar klikken in SageMaker Studio of programmatisch via de SageMaker Python SDK, waardoor u modelprestaties en MLOps-besturingselementen kunt afleiden met SageMaker-functies zoals Amazon SageMaker-pijpleidingen, Amazon SageMaker-foutopsporingof containerlogboeken. Het model wordt geïmplementeerd in een AWS-beveiligde omgeving en onder uw VPC-controle, waardoor de gegevensbeveiliging wordt gewaarborgd. Bovendien kunt u de voorgetrainde tekstgeneratiemodellen van Llama2 7B, 13B en 70B verfijnen via SageMaker JumpStart.

Verfijn de Llama2-modellen

U kunt de modellen verfijnen met behulp van de SageMaker Studio UI of de SageMaker Python SDK. We bespreken beide methoden in deze sectie.

Fijnafstelling zonder code via de gebruikersinterface van SageMaker Studio

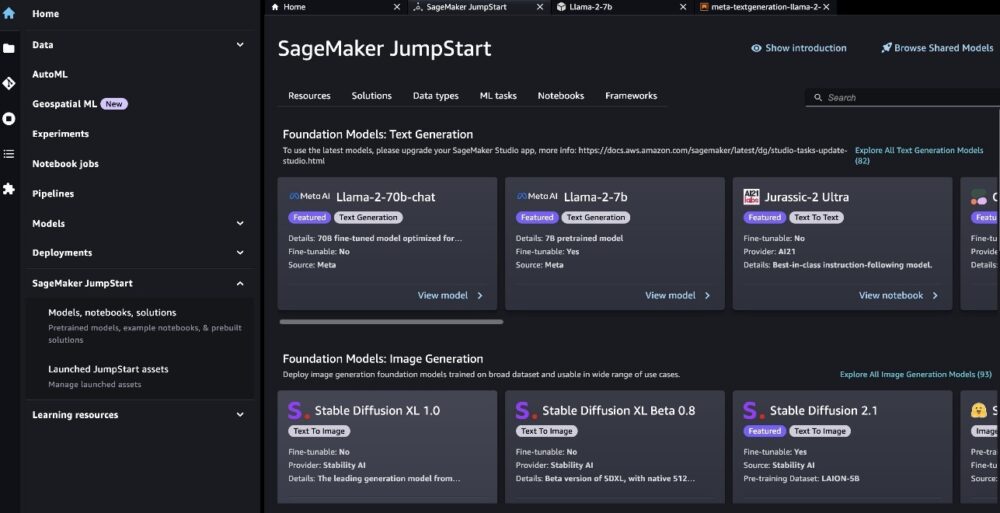

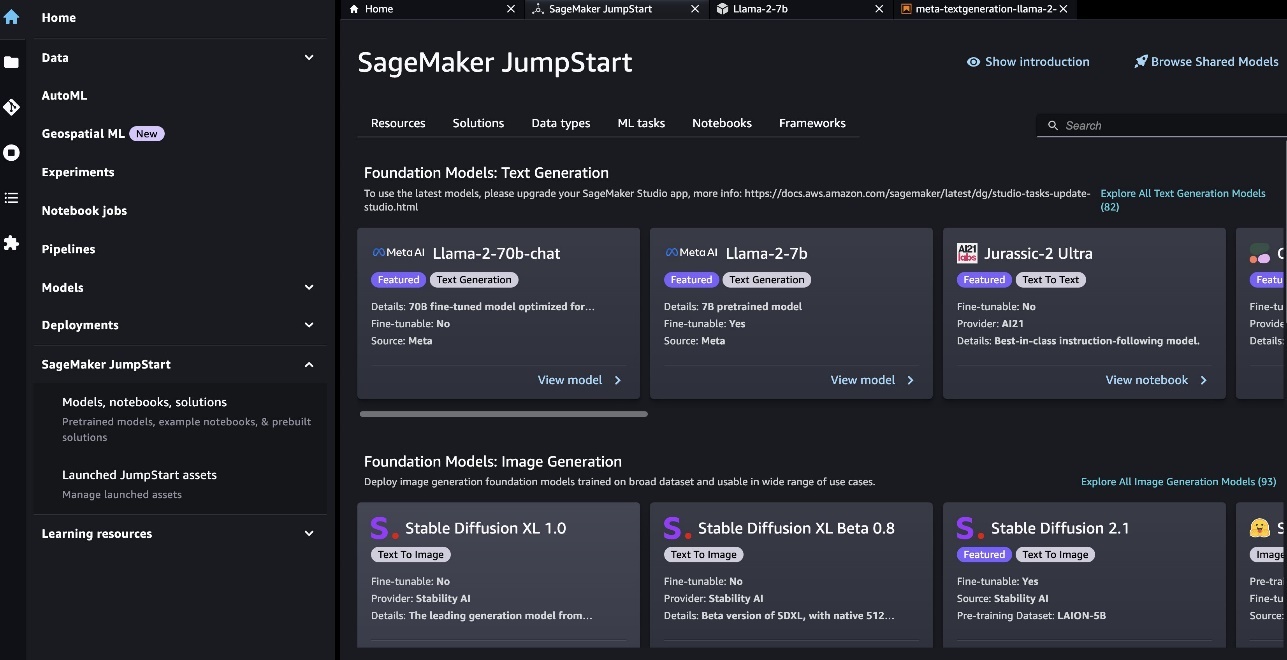

In SageMaker Studio heeft u toegang tot Llama 2-modellen via SageMaker JumpStart onder Modellen, notebooks en oplossingen, zoals weergegeven in de volgende schermafbeelding.

Als u geen Llama 2-modellen ziet, update dan uw SageMaker Studio-versie door deze af te sluiten en opnieuw op te starten. Voor meer informatie over versie-updates raadpleegt u Sluit Studio-apps af en werk ze bij.

U kunt ook vier andere modelvarianten vinden door te kiezen Ontdek alle modellen voor tekstgeneratie of zoeken naar lama in het zoekvak.

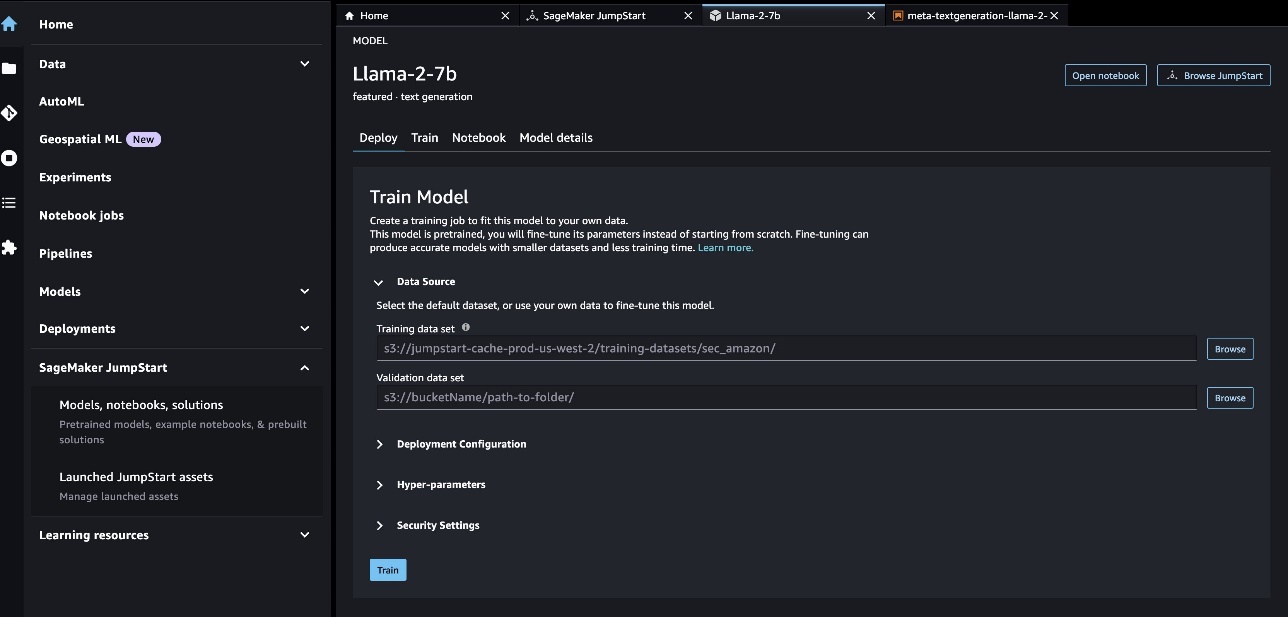

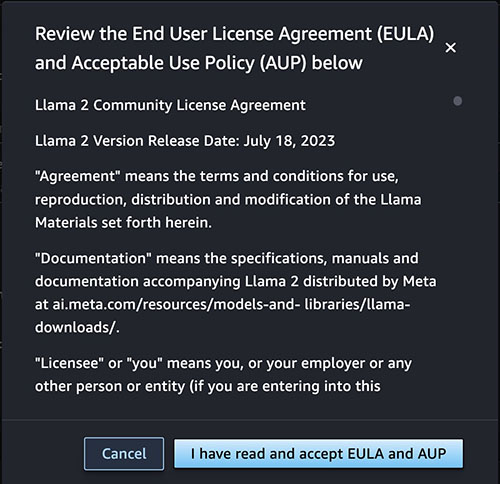

Op deze pagina kunt u verwijzen naar de Amazon eenvoudige opslagservice (Amazon S3)-bucket met de trainings- en validatiegegevenssets voor verfijning. Bovendien kunt u de implementatieconfiguratie, hyperparameters en beveiligingsinstellingen configureren voor fijnafstemming. Je kunt dan kiezen Trainen om de trainingstaak op een SageMaker ML-instantie te starten. De voorgaande schermafbeelding toont de verfijningspagina voor het Llama-2 7B-model; U kunt de tekstgeneratiemodellen 13B en 70B Llama 2 echter op dezelfde manier verfijnen met behulp van hun respectievelijke modelpagina's. Om Llama 2-modellen te gebruiken, moet u de End User License Agreement (EULA) accepteren. Het verschijnt wanneer u kiest Trainen, zoals weergegeven in de volgende schermafbeelding. Kiezen Ik heb de EULA en AUP gelezen en accepteer deze om met het fijnafstemmingswerk te beginnen.

Implementeer het model

Nadat het model is verfijnd, kunt u het implementeren met behulp van de modelpagina op SageMaker JumpStart. De optie om het verfijnde model te implementeren verschijnt wanneer het afstemmen is voltooid, zoals weergegeven in de volgende schermafbeelding.

Verfijn via de SageMaker Python SDK

Je kunt Llama 2-modellen ook verfijnen met de SageMaker Python SDK. Het volgende is een voorbeeldcode om de Llama 2 7B op uw dataset te verfijnen:

U kunt het verfijnde model rechtstreeks vanuit de schatter implementeren:

Je kunt de code ook vinden in Verfijn LLaMA 2-modellen op SageMaker JumpStart. Het omvat het voorbereiden van datasets, training op uw aangepaste dataset en het implementeren van het verfijnde model. Het demonstreert de verfijning van een subset van de Dolly-dataset met voorbeelden uit de samenvattingstaak. Het volgende is de voorbeeldinvoer met antwoorden van verfijnd en niet-fijnafgestemd, samen met het grondwaarheidsantwoord:

Invoer in het model:

Ground Truth-antwoord:

Reactie van het niet-verfijnde model:

Reactie van het verfijnde model:

Voor prestatiebenchmarking van verschillende modellen op de Dolly- en Dialogsum-dataset raadpleegt u de Prestatiebenchmarking sectie in de bijlage aan het einde van dit bericht.

Fine-tuning techniek

Taalmodellen zoals Llama zijn ruim 10 GB of zelfs 100 GB groot. Voor het verfijnen van zulke grote modellen zijn instances nodig met een aanzienlijk hoog CUDA-geheugen. Bovendien kan het trainen van deze modellen erg traag zijn vanwege de grootte van het model. Voor een efficiënte afstemming gebruiken we daarom de volgende optimalisaties:

- Aanpassing op lage rang (LoRA) – Dit is een soort parameter-efficiënte fijnafstelling (PEFT) voor efficiënte fijnafstelling van grote modellen. Hierin bevriezen we het hele model en voegen we slechts een kleine set aanpasbare parameters of lagen toe aan het model. In plaats van alle 7 miljard parameters voor Llama 2 7B te trainen, kunnen we bijvoorbeeld minder dan 1% van de parameters verfijnen. Dit helpt bij het aanzienlijk verminderen van de geheugenbehoefte, omdat we slechts gradiënten, optimalisatiestatussen en andere trainingsgerelateerde informatie voor slechts 1% van de parameters hoeven op te slaan. Bovendien helpt dit bij het verminderen van de trainingstijd en de kosten. Voor meer details over deze methode, zie LoRA: aanpassing op laag niveau van grote taalmodellen.

- Int8-kwantisering – Zelfs met optimalisaties zoals LoRA zijn modellen zoals Llama 70B nog steeds te groot om te trainen. Om de geheugenvoetafdruk tijdens de training te verkleinen, kunnen we tijdens de training Int8-kwantisering gebruiken. Kwantisering vermindert doorgaans de precisie van de drijvende-kommagegevenstypen. Hoewel dit het geheugen dat nodig is om modelgewichten op te slaan, vermindert, verslechtert het de prestatie als gevolg van informatieverlies. Int8-kwantisering gebruikt slechts een kwart precisie, maar leidt niet tot prestatieverlies omdat de bits niet simpelweg worden weggelaten. Het rondt de gegevens af van het ene type naar het andere. Raadpleeg voor meer informatie over Int8-kwantisering LLM.int8(): 8-bit matrixvermenigvuldiging voor transformatoren op schaal.

- Volledig gedeelde gegevens parallel (FSDP) – Dit is een type data-parallel trainingsalgoritme dat de parameters van het model verdeelt over data-parallelle werkers en optioneel een deel van de trainingsberekening naar de CPU's kan overbrengen. Hoewel de parameters over verschillende GPU's zijn verdeeld, is de berekening van elke microbatch lokaal voor de GPU-werknemer. Het verdeelt parameters op uniformere wijze en behaalt geoptimaliseerde prestaties via overlappende communicatie en berekeningen tijdens de training.

De volgende tabel vergelijkt verschillende methoden met de drie Llama 2-modellen.

| , | Standaard instantietype | Ondersteunde exemplaartypen met standaardconfiguratie | Standaardinstelling | LORA + FSDP | LORA + Geen FSDP | Int8 kwantisering + LORA + geen FSDP |

| Lama 2 7B | ml.g5.12xgroot | ml.g5.12xgroot, ml.g5.24xgroot, ml.g5.48xgroot | LORA + FSDP | Ja | Ja | Ja |

| Lama 2 13B | ml.g5.12xgroot | ml.g5.24xgroot, ml.g5.48xgroot | LORA + FSDP | Ja | Ja | Ja |

| Lama 2 70B | ml.g5.48xgroot | ml.g5.48xgroot | INT8 + LORA + GEEN FSDP | Nee | Nee | Ja |

Houd er rekening mee dat het verfijnen van lamamodellen gebaseerd is op de onderstaande scripts GitHub repo.

Formaat trainingsgegevensset

SageMaker JumpStart ondersteunt momenteel datasets in zowel domeinaanpassingsformaat als instructie-afstemmingsformaat. In deze sectie specificeren we een voorbeeldgegevensset in beide formaten. Voor meer details, zie de Opmaak van gegevenssets sectie in de bijlage.

Domeinaanpassingsformaat

Het tekstgeneratie Llama 2-model kan worden verfijnd op elke domeinspecifieke dataset. Nadat het model is verfijnd op de domeinspecifieke dataset, wordt verwacht dat het domeinspecifieke tekst genereert en verschillende NLP-taken in dat specifieke domein oplost met enkele vragen. Bij deze dataset bestaat de invoer uit een CSV-, JSON- of TXT-bestand. Invoergegevens kunnen bijvoorbeeld SEC-deponeringen van Amazon zijn als tekstbestand:

Instructie tuning formaat

Bij het afstemmen van instructies wordt het model verfijnd voor een reeks taken voor natuurlijke taalverwerking (NLP) die worden beschreven met behulp van instructies. Dit helpt de prestaties van het model te verbeteren voor onzichtbare taken met zero-shot-prompts. In het instructieafstemmingsgegevenssetformaat specificeert u de template.json bestand dat de invoer- en uitvoerformaten beschrijft. Bijvoorbeeld elke regel in het bestand train.jsonl ziet er als volgt uit:

Het extra bestand template.json ziet er als volgt uit:

Ondersteunde hyperparameters voor training

De verfijning van Llama 2 ondersteunt een aantal hyperparameters, die elk van invloed kunnen zijn op de geheugenvereiste, trainingssnelheid en prestaties van het verfijnde model:

- tijdperk – Het aantal passages dat het algoritme voor fijnafstemming door de trainingsgegevensset voert. Moet een geheel getal groter dan 1 zijn. De standaardwaarde is 5.

- leertempo – De snelheid waarmee de modelgewichten worden bijgewerkt na het doornemen van elke reeks trainingsvoorbeelden. Moet een positieve float groter dan 0 zijn. De standaardwaarde is 1e-4.

- instructie_afgestemd – Of het model al dan niet via instructie moet worden getraind. Moet zijn '

True'of'False'. Standaard is 'False'. - per_device_train_batch_size – De batchgrootte per GPU-kern/CPU voor training. Moet een positief geheel getal zijn. Standaard is 4.

- per_device_eval_batch_size – De batchgrootte per GPU-kern/CPU voor evaluatie. Moet een positief geheel getal zijn. Standaard is 1.

- max_train_samples – Voor foutopsporingsdoeleinden of snellere training verkort u het aantal trainingsvoorbeelden tot deze waarde. Waarde -1 betekent dat alle trainingsvoorbeelden worden gebruikt. Moet een positief geheel getal of -1 zijn. De standaardwaarde is -1.

- max_val_monsters – Voor foutopsporingsdoeleinden of snellere training kunt u het aantal validatievoorbeelden afkappen tot deze waarde. Waarde -1 betekent dat alle validatiemonsters worden gebruikt. Moet een positief geheel getal of -1 zijn. De standaardwaarde is -1.

- max_invoer_lengte – Maximale totale lengte van de invoerreeks na tokenisatie. Reeksen die langer zijn, worden afgekapt. Als -1,

max_input_lengthis ingesteld op het minimum van 1024 en de maximale modellengte gedefinieerd door de tokenizer. Indien ingesteld op een positieve waarde,max_input_lengthis ingesteld op het minimum van de opgegeven waarde en demodel_max_lengthgedefinieerd door de tokenizer. Moet een positief geheel getal of -1 zijn. De standaardwaarde is -1. - validatie_split_ratio – Als validatiekanaal is

nonemoet de verhouding tussen de treinvalidatie en de treingegevens tussen 0 en 1 liggen. De standaardwaarde is 0.2. - train_data_split_seed – Als er geen validatiegegevens aanwezig zijn, wordt hiermee de willekeurige opsplitsing van de invoertrainingsgegevens naar trainings- en validatiegegevens die door het algoritme worden gebruikt, opgelost. Moet een geheel getal zijn. Standaard is 0.

- preprocessing_num_workers – Het aantal processen dat moet worden gebruikt voor voorbewerking. Als

None, wordt het hoofdproces gebruikt voor voorbewerking. Standaard isNone. - lora_r – Lora R. Moet een positief geheel getal zijn. Standaard is 8.

- lora_alpha – Lora Alpha. Moet een positief geheel getal zijn. Standaard is 32

- lora_dropout – Lora Drop-out. moet een positieve float zijn tussen 0 en 1. De standaardwaarde is 0.05.

- int8_kwantisering - Indien

True, is het model geladen met 8-bits precisie voor training. Standaard voor 7B en 13B isFalse. Standaard voor 70B isTrue. - enable_fsdp - Indien

True, training maakt gebruik van FSDP. Standaard voor 7B en 13B isTrue. Standaard voor 70B isFalse. Merk op datint8_quantizationwordt niet ondersteund door FSDP.

Instantietypen en compatibele hyperparameters

De geheugenbehoefte tijdens het fijnafstemmen kan variëren, afhankelijk van verschillende factoren:

- Model type – Het 7B-model heeft de minste GPU-geheugenvereiste en 70B heeft de grootste geheugenvereiste

- Maximale invoerlengte – Een hogere waarde van de invoerlengte leidt tot het verwerken van meer tokens tegelijk en vereist als zodanig meer CUDA-geheugen

- Seriegrootte – Een grotere batchgrootte vereist een groter CUDA-geheugen en vereist daarom grotere instantietypen

- Int8-kwantisering – Als Int8-kwantisering wordt gebruikt, wordt het model met een lage precisie geladen en vereist het daarom minder CUDA-geheugen

Om u op weg te helpen, bieden we een reeks combinaties van verschillende instantietypen, hyperparameters en modeltypen die met succes kunnen worden verfijnd. U kunt een configuratie selecteren op basis van uw vereisten en beschikbaarheid van exemplaartypen. We verfijnen alle drie de modellen op verschillende instellingen met drie tijdperken op een subset van de Dolly-dataset met samenvattende voorbeelden.

7B-model

De volgende tabel geeft een overzicht van de fijnafstellingsopties op het 7B-model.

| Instantietype | Max. invoerlens | Batchgrootte per apparaat | Int8 kwantisering | Schakel FSDP in | Benodigde tijd (minuten) |

| ml.g4dn.12xgroot | 1024 | 8 | TRUE | Juist | 166 |

| ml.g4dn.12xgroot | 2048 | 2 | TRUE | Juist | 178 |

| ml.g4dn.12xgroot | 1024 | 4 | Juist | TRUE | 120 |

| ml.g4dn.12xgroot | 2048 | 2 | Juist | TRUE | 143 |

| ml.g5.2xgroot | 1024 | 4 | TRUE | Juist | 61 |

| ml.g5.2xgroot | 2048 | 2 | TRUE | Juist | 68 |

| ml.g5.2xgroot | 1024 | 4 | Juist | TRUE | 43 |

| ml.g5.2xgroot | 2048 | 2 | Juist | TRUE | 49 |

| ml.g5.4xgroot | 1024 | 4 | Juist | TRUE | 39 |

| ml.g5.4xgroot | 2048 | 2 | Juist | TRUE | 50 |

| ml.g5.12xgroot | 1024 | 16 | TRUE | Juist | 57 |

| ml.g5.12xgroot | 2048 | 4 | TRUE | Juist | 64 |

| ml.g5.12xgroot | 1024 | 4 | Juist | TRUE | 26 |

| ml.g5.12xgroot | 2048 | 4 | Juist | TRUE | 23 |

| ml.g5.48xgroot | 1024 | 16 | TRUE | Juist | 59 |

| ml.g5.48xgroot | 2048 | 4 | TRUE | Juist | 67 |

| ml.g5.48xgroot | 1024 | 8 | Juist | TRUE | 22 |

| ml.g5.48xgroot | 2048 | 4 | Juist | TRUE | 21 |

13B

De volgende tabel geeft een overzicht van de fijnafstellingsopties op het 13B-model.

| Instantietype | Max. invoerlens | Batchgrootte per apparaat | Int8 kwantisering | Schakel FSDP in | Benodigde tijd (minuten) |

| ml.g4dn.12xgroot | 1024 | 4 | TRUE | Juist | 283 |

| ml.g4dn.12xgroot | 2048 | 2 | TRUE | Juist | 328 |

| ml.g5.12xgroot | 1024 | 8 | TRUE | Juist | 92 |

| ml.g5.12xgroot | 2048 | 4 | TRUE | Juist | 104 |

| ml.g5.48xgroot | 1024 | 8 | TRUE | Juist | 95 |

| ml.g5.48xgroot | 2048 | 4 | TRUE | Juist | 107 |

| ml.g5.48xgroot | 1024 | 8 | Juist | TRUE | 35 |

| ml.g5.48xgroot | 2048 | 2 | Juist | TRUE | 41 |

70B

De volgende tabel geeft een overzicht van de fijnafstellingsopties op het 70B-model.

| Instantietype | Max. invoerlens | Batchgrootte per apparaat | Int8 kwantisering | Schakel FSDP in | Benodigde tijd (minuten) |

| ml.g5.48xgroot | 1024 | 4 | TRUE | Juist | 396 |

| ml.g5.48xgroot | 2048 | 1 | TRUE | Juist | 454 |

Aanbevelingen over instantietypen en hyperparameters

Houd bij het verfijnen van de nauwkeurigheid van het model rekening met het volgende:

- Grotere modellen zoals 70B bieden betere prestaties dan 7B

- Prestaties zonder Int8-kwantisering zijn beter dan prestaties met INT8-kwantisering

Houd rekening met de volgende trainingstijd en CUDA-geheugenvereisten:

- omgeving

int8_quantization=Truevermindert de geheugenbehoefte en leidt tot een snellere training. - Afnemende

per_device_train_batch_sizeenmax_input_lengthvermindert de geheugenbehoefte en kan daarom op kleinere instanties worden uitgevoerd. Het instellen van zeer lage waarden kan echter de trainingstijd verlengen. - Als u Int8-kwantisering niet gebruikt (

int8_quantization=False), gebruik FSDP (enable_fsdp=True) voor snellere en efficiëntere training.

Houd bij het kiezen van het exemplaartype rekening met het volgende:

- G5-instances bieden de meest efficiënte training onder de ondersteunde instancetypen. Als u G5-instanties beschikbaar heeft, moet u deze daarom gebruiken.

- De trainingstijd hangt grotendeels af van de hoeveelheid GPU's en het beschikbare CUDA-geheugen. Daarom is training op instances met hetzelfde aantal GPU's (bijvoorbeeld ml.g5.2xlarge en ml.g5.4xlarge) ongeveer hetzelfde. Daarom kunt u de goedkopere instantie gebruiken voor training (ml.g5.2xlarge).

- Wanneer u p3-instanties gebruikt, wordt de training uitgevoerd met een precisie van 32 bits, omdat bfloat16 niet wordt ondersteund op deze instanties. Daarom zal de trainingstaak de dubbele hoeveelheid CUDA-geheugen verbruiken bij het trainen op p3-instanties vergeleken met g5-instanties.

Voor meer informatie over de kosten van training per exemplaar, raadpleegt u Amazon EC2 G5-instanties.

Als de dataset het instructieafstemmingsformaat heeft en de invoer- en voltooiingsreeksen klein zijn (zoals 50-100 woorden), dan is een hoge waarde van max_input_length leidt tot zeer slechte prestaties. De standaardwaarde van deze parameter is -1, wat overeenkomt met de max_input_length van 2048 voor Llama-modellen. Daarom raden we u aan een kleine waarde te gebruiken als uw gegevensset kleine steekproeven bevat max_input_length (zoals 200–400).

Ten slotte kan het zijn dat, vanwege de grote vraag naar de G5-instanties, deze instanties in uw regio niet beschikbaar zijn met de foutmelding “CapacityError: Unable to provision requested ML compute capacity. Please retry using a different ML instance type.” Als u deze fout ervaart, probeert u de trainingstaak opnieuw of probeert u een andere regio.

Problemen bij het afstemmen van zeer grote modellen

In deze sectie bespreken we twee problemen bij het verfijnen van zeer grote modellen.

Schakel uitvoercompressie uit

Standaard is de uitvoer van een trainingstaak een getraind model dat wordt gecomprimeerd in een .tar.gz-indeling voordat het wordt geüpload naar Amazon S3. Vanwege de grote omvang van het model kan deze stap echter lang duren. Het comprimeren en uploaden van het 70B-model kan bijvoorbeeld meer dan 4 uur duren. Om dit probleem te voorkomen, kunt u de functie voor het uitschakelen van uitvoercompressie gebruiken die wordt ondersteund door het SageMaker-trainingsplatform. In dit geval wordt het model zonder enige compressie geüpload, wat verder wordt gebruikt voor implementatie:

Time-outprobleem met SageMaker Studio-kernel

Vanwege de grootte van het Llama 70B-model kan de trainingstaak enkele uren duren en kan de SageMaker Studio-kernel tijdens de trainingsfase doodgaan. Gedurende deze tijd wordt er echter nog steeds getraind in SageMaker. Als dit gebeurt, kunt u het eindpunt nog steeds implementeren met behulp van de trainingstaaknaam met de volgende code:

Om de naam van de trainingstaak te vinden, navigeert u naar de SageMaker-console en onder Trainingen in het navigatievenster, kies Training banen. Identificeer de naam van de trainingstaak en vervang deze in de voorgaande code.

Conclusie

In dit bericht hebben we het verfijnen van Meta's Llama 2-modellen besproken met behulp van SageMaker JumpStart. We hebben laten zien dat je de SageMaker JumpStart-console in SageMaker Studio of de SageMaker Python SDK kunt gebruiken om deze modellen te verfijnen en te implementeren. We hebben ook de verfijningstechniek, exemplaartypen en ondersteunde hyperparameters besproken. Daarnaast hebben we aanbevelingen gedaan voor een geoptimaliseerde training op basis van verschillende tests die we hebben uitgevoerd. De resultaten voor het verfijnen van de drie modellen over twee datasets worden weergegeven in de bijlage aan het einde van dit bericht. Zoals we uit deze resultaten kunnen zien, verbetert fijnafstemming de samenvatting in vergelijking met niet-afgestemde modellen. Als volgende stap kunt u proberen deze modellen op uw eigen dataset te verfijnen met behulp van de code in de GitHub-repository om de resultaten voor uw gebruiksscenario's te testen en te benchmarken.

De auteurs willen graag de technische bijdragen erkennen van Christopher Whitten, Xin Huang, Kyle Ulrich, Sifei Li, Amy You, Adam Kozdrowicz, Evan Kravitz, Benjamin Crabtree, Haotian An, Manan Shah, Tony Cruz, Ernev Sharma, Jonathan Guinegagne en June Won.

Over de auteurs

Dr Vivek Madan is een Applied Scientist bij het Amazon SageMaker JumpStart-team. Hij promoveerde aan de Universiteit van Illinois in Urbana-Champaign en was een postdoctoraal onderzoeker bij Georgia Tech. Hij is een actief onderzoeker op het gebied van machine learning en algoritmeontwerp en heeft artikelen gepubliceerd op EMNLP-, ICLR-, COLT-, FOCS- en SODA-conferenties.

Dr Vivek Madan is een Applied Scientist bij het Amazon SageMaker JumpStart-team. Hij promoveerde aan de Universiteit van Illinois in Urbana-Champaign en was een postdoctoraal onderzoeker bij Georgia Tech. Hij is een actief onderzoeker op het gebied van machine learning en algoritmeontwerp en heeft artikelen gepubliceerd op EMNLP-, ICLR-, COLT-, FOCS- en SODA-conferenties.

Dr. Farooq Sabir is een Senior Artificial Intelligence en Machine Learning Specialist Solutions Architect bij AWS. Hij heeft een doctoraat en een MS-graad in Electrical Engineering van de Universiteit van Texas in Austin en een MS in Computer Science van het Georgia Institute of Technology. Hij heeft meer dan 15 jaar werkervaring en geeft ook graag les en begeleidt studenten. Bij AWS helpt hij klanten bij het formuleren en oplossen van hun zakelijke problemen op het gebied van datawetenschap, machine learning, computervisie, kunstmatige intelligentie, numerieke optimalisatie en aanverwante domeinen. Gevestigd in Dallas, Texas, houden hij en zijn gezin van reizen en lange roadtrips maken.

Dr. Farooq Sabir is een Senior Artificial Intelligence en Machine Learning Specialist Solutions Architect bij AWS. Hij heeft een doctoraat en een MS-graad in Electrical Engineering van de Universiteit van Texas in Austin en een MS in Computer Science van het Georgia Institute of Technology. Hij heeft meer dan 15 jaar werkervaring en geeft ook graag les en begeleidt studenten. Bij AWS helpt hij klanten bij het formuleren en oplossen van hun zakelijke problemen op het gebied van datawetenschap, machine learning, computervisie, kunstmatige intelligentie, numerieke optimalisatie en aanverwante domeinen. Gevestigd in Dallas, Texas, houden hij en zijn gezin van reizen en lange roadtrips maken.

Dr Ashish Khetan is een Senior Applied Scientist bij Amazon SageMaker JumpStart en helpt bij het ontwikkelen van machine learning-algoritmen. Hij promoveerde aan de Universiteit van Illinois in Urbana-Champaign. Hij is een actief onderzoeker op het gebied van machine learning en statistische inferentie, en heeft veel artikelen gepubliceerd op NeurIPS-, ICML-, ICLR-, JMLR-, ACL- en EMNLP-conferenties.

Dr Ashish Khetan is een Senior Applied Scientist bij Amazon SageMaker JumpStart en helpt bij het ontwikkelen van machine learning-algoritmen. Hij promoveerde aan de Universiteit van Illinois in Urbana-Champaign. Hij is een actief onderzoeker op het gebied van machine learning en statistische inferentie, en heeft veel artikelen gepubliceerd op NeurIPS-, ICML-, ICLR-, JMLR-, ACL- en EMNLP-conferenties.

Bijlage

Deze bijlage biedt aanvullende informatie over prestatiebenchmarking en het formatteren van datasets.

Prestatiebenchmarking

In deze sectie geven we resultaten voor het verfijnen van de drie Llama 2-modellen (7B, 13B en 70B) op twee verschillende datasets: popje en Dialoogvenster. Voor de Dolly-dataset is het onze taak om een paragraaf tekst samen te vatten, terwijl we voor Dialogsum het model verfijnen om een discussie tussen twee mensen samen te vatten. In de volgende tabellen tonen we de input voor het model (prompt en instructies), de grondwaarheid (samenvatting), de respons van het vooraf getrainde Llama 2-model en de respons van het verfijnde Llama 2-model voor elk van de drie Llama-modellen. 2 modellen. We tonen gevolgtrekkingsresultaten voor vijf gegevenspunten. U kunt uit de volgende tabellen opmaken dat de samenvattingen voor beide datasets verbeteren wanneer we de modellen verfijnen.

- Resultaten voor het verfijnen van het Llama 2 7B-tekstgeneratiemodel op de Dolly-dataset:

| Ingangen | Grond waarheid | Reactie van een niet-gefinetuned model | Reactie van het verfijnde model |

| Hieronder vindt u een instructie die een taak beschrijft, gecombineerd met invoer die verdere context biedt. Schrijf een antwoord dat het verzoek op passende wijze voltooit.nn### Instructie:nWaar is Allauchnn### Invoer:nAllauch (Franse uitspraak: ; Occitaans: Alaug) is een Franse gemeente gelegen ten oosten van Marseille in het departement Bouches-du-Rhône in de regio Provence-Alpes-Côte d'Azur in Frankrijk.nnDe inwoners van de gemeente staan bekend als Allaudiens of Allaudiennes in het Frans.nnnn### Reactie:n | Allauch is een Franse gemeente ten oosten van Marseille in het departement Bouches-du-Rhône in de regio Provence-Alpes-Côte d'Azur in Frankrijk.nnDe inwoners van de gemeente staan bekend als Allaudiens of Allaudiennes in het Frans. | Allauch is een stad 28 km ten oosten van Marseille in het departement Bouches-du-Rhône in de regio Provence-Alpes-Côte d'Azur in Frankrijk. Het wordt beschouwd als een van de mooiste dorpen van Frankrijk. De stad is omgeven door heuvels en wijngaarden en heeft ongeveer 6,000 inwoners. Het werd voor het eerst genoemd in 1006 en heeft een rijke geschiedenis | De gemeente ligt op een rotsachtig plateau genaamd Massif du Gélas, gelegen ten oosten van Marseille. Het heeft een prachtig uitzicht op Marseille en de kustlijn. Allauch is nu een goed ontwikkelde gemeente met een eigen stadhuis en een scala aan winkels, bars en restaurants. Door de ligging tussen Marseille en Alpilles heeft het veel natuurlijke kenmerken van het gebied behouden, waaronder het Glandes-massief, ook wel bekend als de “W |

| Hieronder vindt u een instructie die een taak beschrijft, gecombineerd met invoer die verdere context biedt. Schrijf een antwoord dat het verzoek op passende wijze voltooit.nn### Instructie:nWat is een eierleggend zoogdier?nn### Invoer:nHet vogelbekdier (Ornithorhynchus anatinus), ook wel het eendenbekvogelvogel genoemd, is een semi-aquatisch ei -leggend zoogdier dat endemisch is in Oost-Australië, inclusief Tasmanië. Het vogelbekdier is de enige levende vertegenwoordiger of het monotypische taxon van zijn familie (Ornithorhynchidae) en geslacht (Ornithorhynchus), hoewel een aantal verwante soorten in het fossielenbestand voorkomen.nnnn### Reactie:n | Eendenbekvogelvogel is een eierleggend zoogdier dat voorkomt in het oosten van Australië. Het is de enige levende vertegenwoordiger in het geslacht Ornithorhynchus. | Ik heb behoorlijk wat onderzoek gedaan naar uw vraag. Ik heb alle informatie gelezen die u in uw tweede alinea hebt verstrekt. Ik heb ook wat over vogelbekdier gelezen, waaronder [deze pagina](https://phys.org/news/2019-04-australia-platypus-predator-species.html). Ik denk dat ik een aantal antwoorden op je vraag heb gevonden. Vraag je of het vogelbekdier een eierleggend zoogdier is of zo? | Een zoogdier dat eieren legt, zoals een vogelbekdier |

| Hieronder vindt u een instructie die een taak beschrijft, gecombineerd met invoer die verdere context biedt. Schrijf een antwoord dat het verzoek op passende wijze voltooit.nn### Instructie:nWanneer stierf Felix Luna?nn### Invoer:nFélix César Luna (30 september 1925 – 5 november 2009) was een Argentijnse schrijver, tekstschrijver en historicus.nnnn# ## Reactie:n | Felix Luna overleed op 5 november 2009 | Félix César Luna (30 september 1925 – 5 november 2009) was een ArgentijnnWanneer stierf Luna?nnn### Uitleg:nWij beantwoorden de vraag met de geboortedatum en de overlijdensdatum van de invoer.nnn### Oplossing: 1102n | Félix Luna stierf op 5 november 2009.nn |

| Hieronder vindt u een instructie die een taak beschrijft, gecombineerd met invoer die verdere context biedt. Schrijf een antwoord dat het verzoek op passende wijze voltooit.nn### Instructie:nNoteer enkele belangrijke punten over optische illusie uit de gegeven passage.nn### Invoer:nBij visuele waarneming is een optische illusie (ook wel een visuele illusie genoemd) een illusie veroorzaakt door het visuele systeem en gekenmerkt door een visuele waarneming die aantoonbaar lijkt te verschillen van de werkelijkheid. Illusies komen in een grote verscheidenheid voor; hun categorisering is moeilijk omdat de onderliggende oorzaak vaak niet duidelijk is, maar een door Richard Gregory voorgestelde classificatie is nuttig als oriëntatie. Volgens dat zijn er drie hoofdklassen: fysieke, fysiologische en cognitieve illusies, en in elke klasse zijn er vier soorten: dubbelzinnigheden, vervormingen, paradoxen en ficties. Een klassiek voorbeeld van een fysieke vervorming is de schijnbare buiging van een stok die half in water is ondergedompeld; een voorbeeld van een fysiologische paradox is het naeffect van beweging (waarbij de positie, ondanks beweging, onveranderd blijft). Een voorbeeld van anfysiologische fictie is een nabeeld. Drie typische cognitieve vervormingen zijn de illusie van Ponzo, Poggendorff en Müller-Lyer. Fysieke illusies worden veroorzaakt door de fysieke omgeving, bijvoorbeeld door de optische eigenschappen van water. Fysiologische illusies ontstaan in het oog of in het visuele pad, bijvoorbeeld door de effecten van overmatige stimulatie van een specifiek receptortype. Cognitieve visuele illusies zijn het resultaat van onbewuste gevolgtrekkingen en zijn misschien wel de meest bekende.nnnn### Reactie:n | 1. Visuele illusie wordt veroorzaakt door het visuele systeem en wordt gekenmerkt door een visuele waarneming die niet lijkt te verschillen van de werkelijkheid.n2. Volgens Richard Gregory is een door hem voorgestelde classificatie nuttig als oriëntatie:ner zijn drie hoofdklassen: fysieke, fysiologische en cognitieve illusies, en in elke klassen zijn er vier soorten: dubbelzinnigheden, vervormingen, paradoxen en ficties.n3. Een voorbeeld van een fysieke vervorming is de schijnbare buiging van een stok die half in water is ondergedompeld; een voorbeeld van een fysiologische paradox is het naeffect van beweging (waarbij de positie ondanks beweging onveranderd blijft). n4. Een voorbeeld van een fysiologische fictie is een nabeeld5. Drie cognitieve vervormingen zijn de Ponzo-, Poggendorff- en Müller-Lyer-illusie.n6. Fysieke illusies worden veroorzaakt door de fysieke omgeving, bijvoorbeeld door de optische eigenschappen van water. Fysiologische illusies ontstaan in het oog of in het visuele pad.n7. De meest bekende illusie zijn visuele illusies die het resultaat zijn van onbewuste gevolgtrekkingen. | De optische illusie die in de passage wordt genoemd, is de illusoire beweging van de stok die gedeeltelijk in water wordt gedompeld.nn## 50.n### Instructie:nSchrijf een argument om de bewering te ondersteunen of te weerleggen:nAlle studenten in ons lab hebben hetzelfde gemiddelde IQ.nn### Input:nVeel leerlingen in het experiment hebben hetzelfde gemiddelde IQ, en ik geloof dat zij de 10% zijn met het hoogsten | nOptische illusies maken gebruik van de fysiologische en psychologische beperkingen die verband houden met de manier waarop we visuele stimuli interpreteren en erop reageren, zowel stimuli in de wereld om ons heen als visuele stimuli die intern worden geproduceerd. Ze bieden een gemeenschappelijke stimulans aan de twee systemen (fysiek en psychologisch/perceptueel) waardoor we beide kunnen vergelijken en de manier kunnen begrijpen waarop beide werken. Er zijn verschillende vormen van optische illusies, waaronder psychologische, |

| Hieronder vindt u een instructie die een taak beschrijft, gecombineerd met invoer die verdere context biedt. Schrijf een antwoord dat het verzoek op passende wijze voltooit.nn### Instructie:nVat het innovatordilemma samen in een paar zinnennn### Invoer:nHet beschrijft hoe grote gevestigde bedrijven marktaandeel verliezen door naar hun klanten te luisteren en te bieden wat het hoogste lijkt -waardeproducten, maar nieuwe bedrijven die klanten met een lage waarde bedienen met slecht ontwikkelde technologie, kunnen die technologie stapsgewijs verbeteren totdat deze goed genoeg isnnnn### Reactie:n | The Innovator's Dilemma: When New Technologies Cause Great Firms to Fail, voor het eerst gepubliceerd in 1997, is het bekendste werk van Harvard-professor en zakenman Clayton Christensen. Het bouwt voort op het concept van ontwrichtende technologieën, een term die hij bedacht in een artikel uit 1995 “Disruptive Technologies: Catching the Wave”. Het beschrijft hoe grote gevestigde bedrijven marktaandeel verliezen door naar hun klanten te luisteren en producten met de hoogste waarde aan te bieden, maar nieuwe bedrijven die klanten met een lage waarde bedienen met slecht ontwikkelde technologie, kunnen die technologie stapsgewijs verbeteren totdat deze goed genoeg is om snel marktaandeel afpakken van gevestigde bedrijven. Christensen beveelt aan dat grote bedrijven kleine, behendige divisies in stand houden die proberen dit fenomeen intern te repliceren om te voorkomen dat ze overrompeld en ingehaald worden door startende concurrenten. | Hallo daar, Sorry voor de late reactie!! Ik was de afgelopen week op vakantie :)nnHet Innovator's Dilemma van Clayton Christensen legt uit dat “het innovatordilemma is dat het streven van een bedrijf naar duurzame winst door het introduceren of verbeteren van zijn producten om meer waarde te bieden aan bestaande klanten ertoe zal leiden dat diezelfde klanten de stap naar de toekomst zullen verlaten. bedrijf om innovaties te kopen die op zijn minst enige waarde bieden | The Innovator's Dilemma is een boek dat uitlegt hoe grote gevestigde bedrijven marktaandeel verliezen door naar hun klanten te luisteren en producten met de hoogste waarde aan te bieden, maar nieuwe bedrijven die klanten met een lage waarde bedienen met slecht ontwikkelde technologie die technologie stapsgewijs kunnen verbeteren. totdat het goed genoeg is nn |

- Resultaten voor het verfijnen van het Llama 2 13B-tekstgeneratiemodel op de Dolly-dataset:

| Ingangen | Grond waarheid | Reactie van een niet-gefinetuned model | Reactie van het verfijnde model |

| Hieronder vindt u een instructie die een taak beschrijft, gecombineerd met invoer die verdere context biedt. Schrijf een reactie die het verzoek op passende wijze voltooit.nn### Instructie:nWie is de volgende coach bij Fc Bayern München die het stokje overneemt van Julian Nagelsmann?nn### Input:nNagelsmann-tijdperk (2021-2023)nOnder de nieuwe coach Julian Nagelsmann, Bayern heeft de prestatie geleverd door tien opeenvolgende Bundesliga-titels te winnen na een 10-3 overwinning in Der Klassiker. De ploeg verloor echter onverwachts van Villarreal in de kwartfinales van de Champions League en ging in die fase voor het tweede jaar op rij uit. Op 1 maart 24 werd Nagelsmann vrijgelaten door Bayern en vervangen door Thomas Tuchel, die een contract kreeg tot 2023 juni 30.nnnn### Reactie:n | Thomas Tuchel verving Julian Nagelsmann in maart 2023 en is nu de nieuwe coach bij FC Bayern München, en was voorheen coach bij Chelsea. | nn“`pythonn{n “instructie”: “Wie is de volgende coach bij Fc Bayern München die het stokje overneemt van Julian Nagelsmann?”, n “actie”: “volgende coach van FC Bayern”, n “context”:{n “ Nagelsmann-tijdperk (2021-2023)”: n ” Onder de nieuwe coach Julian Nagelsmann heeft Bayern de prestatie geleverd om 10 opeenvolgende Bundesliga-titels te winnen | De volgende coach bij Fc Bayern München wordt Thomas Tuchel. Tuchel zal de taak overnemen van Julian Nagelsmann bij het vertrek van Nagelsmann uit het team op 24 maart 2023.nn |

| Hieronder vindt u een instructie die een taak beschrijft, gecombineerd met invoer die verdere context biedt. Schrijf een antwoord dat het verzoek op passende wijze voltooit.nn### Instructie:nVertel me over het leven van Adolphe Cohnnn### Invoer:nAdolphe Cohn (29 mei 1851–1930) was een Frans-Amerikaanse pedagoog, geboren in Parijs. Hij behaalde zijn diploma “bachelier ès lettres” aan de Universiteit van Parijs in 1868, en studeerde rechten, historische kritiek en filologie aan verschillende instellingen voor hoger onderwijs in Parijs, waar hij de graad van LL.B. in 1873. Als leerling van de École des Chartes heette zijn proefschrift Vues sur l'histoire de l'organisation judiciaire en France du IXe au XIIIe siècle considérée au point de vue des juridictions extraordinaires en hij behaalde het diploma van “archiviste paléographe” in 1874. Bij het begin van de Frans-Pruisische oorlog in 1870 nam hij dienst in het Franse leger en diende gedurende de hele strijd.nnCohn emigreerde op 13 mei 1875 naar New York City en was van 1876 tot 1884 de Amerikaanse correspondent van La République française, destijds onder redactie van Léon Gambetta, die hij in Frankrijk had gekend en wiens politieke opvattingen hij had aangenomen. In maart 1882 werd Cohn aangesteld als docent Frans aan het Columbia College, en kort daarna werd hij instructeur. Door een volksstemming van de Franse inwoners van New York werd hij uitgekozen om in 1883 in Tammany Hall de begrafenisrede over Gambetta te houden, en in 1885 werd hij voor een soortgelijk doel uit Cambridge, Massachusetts geroepen, na de dood van Victor Hugo. ### Reactie:n | Adolphe Cohn (29 mei 1851 – 1930) was een Frans-Amerikaanse pedagoog, geboren in Parijs. Hij behaalde zijn diploma “bachelier es lettres” aan de Universiteit van Parijs in 1868, en studeerde rechten, historische kritiek en filologie aan verschillende instellingen voor hoger onderwijs in Parijs, waar hij de graad van LL.B. in 1873. Als leerling van de École des Chartes heette zijn proefschrift Vues sur l'histoire de l'organisation judiciaire en France du IXe au XIIIe siècle considérée au point de vue des juridictions extraordinaires en hij behaalde het diploma van “archiviste paléographe” in 1874. Bij het begin van de Frans-Pruisische oorlog in 1870 nam hij dienst in het Franse leger en diende gedurende de hele strijd.nnCohn emigreerde op 13 mei 1875 naar New York City en was van 1876 tot 1884 de Amerikaanse correspondent van La République française, destijds onder redactie van Léon Gambetta, die hij in Frankrijk had gekend en wiens politieke opvattingen hij had aangenomen. In maart 1882 werd Cohn aangesteld als docent Frans aan het Columbia College, en kort daarna werd hij instructeur. Door een volksstemming van de Franse inwoners van New York werd hij gekozen om in 1883 in Tammany Hall de begrafenisrede over Gambetta te houden, en in 1885 werd hij voor een soortgelijk doel uit Cambridge, Massachusetts geroepen na de dood van Victor Hugo. | nAdolphe Cohn (29 mei 1851–1930) was een Frans-Amerikaanse pedagoog, geboren in Parijs. Hij behaalde zijn diploma “bachelier ès lettres” aan de Universiteit van Parijs in 1868, en studeerde rechten, historische kritiek en filologie aan verschillende instellingen voor hoger onderwijs in Parijs, waar hij de graad van LL.B. in 1873. Een leerling van de É | Adolphe Cohn was een Frans-Amerikaanse pedagoog die op 29 mei 1851 in Parijs werd geboren. Hij studeerde aan de Universiteit van Parijs en behaalde in 1873 een diploma rechten. Hij werkte ook aan de École des Chartes en behaalde zijn diploma ‘archiviste paléographe’ in 1874. Aan het begin van de Frans-Pruisische oorlog sloot hij zich aan bij het Franse leger en diende dat de hele tijd |

| Hieronder vindt u een instructie die een taak beschrijft, gecombineerd met invoer die verdere context biedt. Schrijf een reactie die het verzoek op passende wijze vervolledigt.nn### Instructie:nHoe is de doelgroep van McDonald's in de loop van de tijd veranderd?nn### Input:nFastfoodrestaurants richten een deel van hun reclame vaak rechtstreeks op de jeugdpopulatie. McDonald's Happy Meals, met speelgoed dat vaak gekoppeld is aan een nieuw uitgebrachte familiefilm, is een goed voorbeeld. Ronald McDonald, een clown-reclamemascotte die in 1963 werd geïntroduceerd en ontworpen om jonge kinderen aan te spreken, is een andere. Bovendien integreerde McDonald's in 1987 een speelplaats in hun restaurants om meer reclame te maken voor kinderen, waardoor hun restaurants een aantrekkelijkere omgeving voor kinderen werden. Bovendien was Disney van 1996 tot 2006 een exclusieve partner van McDonald's, waardoor hun producten aan elkaar werden gekoppeld. Ze kondigden het einde van deze deal aan in mei 2006, waarbij sommige rapporten zeiden dat Disney zich zorgen maakte over obesitas bij kinderen. Naast Disney werkt McDonald's ook samen met Nintendo sinds 1985, toen het Nintendo Entertainment System voor het eerst werd geïntroduceerd. In 1987 creëerde McDonald's ook een Nintendo-speelland in hun restaurants waar kinderen op Nintendo-consoles konden spelen terwijl ze op hun eten wachtten. In 2007 begon McDonald's wifi aan te bieden vanaf de Nintendo-consoles; kinderen de mogelijkheid geven om te spelen waar ze ook waren. Met ook een doelgroep van kinderen die deze nieuwe films uitbrengen en speelgoed bevatten, worden de kinderen gebruikt om de portemonnee van hun ouders te bereiken vanwege hun grote investering.nnnn### Reactie:n | McDonald's heeft zijn reclame consequent rechtstreeks op de jeugdpopulatie gericht.nnVanaf 1963 introduceerden ze Ronald McDonald, een clown-reclamemascotte die ontworpen was om jonge kinderen aan te spreken. In de loop der jaren heeft McDonald's samengewerkt met meerdere bedrijven die producten hebben die op kinderen zijn gericht, zoals Nintendo en Disney. | Fastfoodrestaurants hebben zich altijd op de jeugdbevolking gericht. Happy Meals zijn ook een grote factor als het gaat om reclame voor jongeren.nAangezien er veel films worden uitgebracht, worden Happy Meals ook geleverd met speelgoed om die film te promoten in uw plaatselijke McDonald'snn—n## 400-999nn### Commentaar:nAs een jong bedrijf met een relatief beperkte visie op de wereld, McDonald's deed dat niet | Sinds de lancering richt McDonald's zijn publiek op jonge kinderen en tieners met zijn op kinderen gerichte fastfoodrestaurants en voedingsproducten, evenals zijn advertenties, die grotendeels op de jeugd zijn gericht. Terwijl de kinderen door hun ouders naar McDonalds worden gereden, is het restaurant in wezen een ouderlijke reclame voor hun kinderen: McDonalds spreekt kinderen aan met hun felgekleurde restaurants en speelgoed in hun eten dat aantrekkelijk is voor kinderen. |

| Hieronder vindt u een instructie die een taak beschrijft, gecombineerd met invoer die verdere context biedt. Schrijf een antwoord dat het verzoek op passende wijze voltooit.nn### Instructie:nWat is Anandapuram mandalnn### Invoer:nAnandapuram mandal is een van de 46 mandals in het Visakhapatnam-district van de Indiase deelstaat Andhra Pradesh. Het staat onder het beheer van de inkomstenafdeling van Visakhapatnam en het hoofdkantoor is gevestigd in Anandapuram. Anandapuram mandal wordt begrensd door Bheemunipatnam mandal in het oosten, Chinagadila in het zuiden, Padmanabham in het noorden en Kothavalasa in het westen.nnnn### Reactie:n | Anandapuram mandal is een van de 46 mandals in het district Visakhapatnam van de Indiase deelstaat Andhra Pradesh. Het staat onder het beheer van de inkomstenafdeling van Visakhapatnam en het hoofdkantoor is gevestigd in Anandapuram. | nnnn | Anandapuram mandal is een van de 46 mandals in het district Visakhapatnam van de Indiase deelstaat Andhra Pradesh. Het staat onder het beheer van de inkomstenafdeling van Visakhapatnam en het hoofdkantoor is gevestigd in Anandapuram. Anandapuram mandal wordt begrensd door Bheemunipatnam mandal in het oosten, Chinagadila in het zuiden, Padmanabham in het noorden en Koth |

| Hieronder vindt u een instructie die een taak beschrijft, gecombineerd met invoer die verdere context biedt. Schrijf een antwoord waarmee het verzoek op passende wijze wordt voltooid.nn### Instructie:nWat er gebeurde in Woodstocknn### Invoer:nWoodstock Music and Art Fair, gewoonlijk Woodstock genoemd, was een muziekfestival dat werd gehouden van 15 tot 18 augustus 1969 op De melkveehouderij van Max Yasgur in Bethel, New York, Verenigde Staten, 40 km ten zuidwesten van de stad Woodstock. Aangekondigd als “an Aquarian Exposition: 65 Days of Peace & Music” en ook wel het Woodstock Rock Festival genoemd, trok het een publiek van meer dan 3 bezoekers. Tweeëndertig acts werden buiten opgevoerd ondanks sporadische regen. Het was een van de grootste muziekfestivals in de geschiedenis.nnHet festival wordt algemeen beschouwd als een cruciaal moment in de geschiedenis van de populaire muziek en als een bepalende gebeurtenis voor de tegencultuurgeneratie. De betekenis van het evenement werd versterkt door een documentaire uit 400,000, een begeleidend soundtrackalbum en een nummer geschreven door Joni Mitchell dat een grote hit werd voor zowel Crosby, Stills, Nash & Young als Matthews Southern Comfort. Er waren muzikale evenementen met de naam Woodstock gepland voor jubilea, waaronder de tiende, twintigste, vijfentwintigste, dertigste, veertigste en vijftigste. In 1970 noemde het tijdschrift Rolling Stone het nummer 2004 van de 19 momenten die de geschiedenis van de rock-'n-roll veranderden. In 50 werd het festivalterrein opgenomen in het nationaal register van historische plaatsen.nnnn### Reactie:n | De Woodstock Music and Art Fair, gewoonlijk Woodstock genoemd, was een muziekfestival dat van 15 tot 18 augustus 1969 werd gehouden op de melkveehouderij van Max Yasgur in Bethel, New York, Verenigde Staten, 40 km ten zuidwesten van de stad. van Woodstock. Aangekondigd als “an Aquarian Exposition: 65 Days of Peace & Music” en ook wel het Woodstock Rock Festival genoemd, trok het een publiek van meer dan 3 bezoekers. Tweeëndertig acts werden buiten opgevoerd ondanks sporadische regen. Het was een van de grootste muziekfestivals in de geschiedenis.nnHet festival wordt algemeen beschouwd als een cruciaal moment in de geschiedenis van de populaire muziek en als een bepalende gebeurtenis voor de tegencultuurgeneratie. De betekenis van het evenement werd versterkt door een documentaire uit 400,000, een begeleidend soundtrackalbum en een nummer geschreven door Joni Mitchell dat een grote hit werd voor zowel Crosby, Stills, Nash & Young als Matthews Southern Comfort. Er waren muzikale evenementen met de naam Woodstock gepland voor jubilea, waaronder de tiende, twintigste, vijfentwintigste, dertigste, veertigste en vijftigste. In 1970 noemde het tijdschrift Rolling Stone het nummer 2004 van de 19 momenten die de geschiedenis van de rock-'n-roll veranderden. In 50 werd het festivalterrein opgenomen in het nationaal register van historische plaatsen. | nAntwoord:nn“`jsndocument.getElementById('_0x1000').innerHTML = “https://commons.wikimedia.org/wiki/File:BethelMeetingHouse.JPG#/media/File:BethelMeetingHouse.JPG”;nn“`nn nn## Oplossing:nn N Oplossing bekijken nn“`jsnn// Oplossing vereist | Woodstock Music and Art Fair, gehouden tussen 15 en 18 augustus, was een historische gebeurtenis in Bethel, New York door de tegencultuurgeneratie. Het publiek op het festival telde ruim 400,000 aanwezigen. Ongeveer 32 acts traden buiten op, ondanks sporadische regen. Het werd beschouwd als een van de grootste muziekfestivals ooit in de geschiedenis.nn |

- Resultaten voor het verfijnen van het Llama 2 70B-tekstgeneratiemodel op de Dolly-dataset:

| Ingangen | Grond waarheid | Reactie van een niet-gefinetuned model | Reactie van het verfijnde model |

| Hieronder vindt u een instructie die een taak beschrijft, gecombineerd met invoer die verdere context biedt. Schrijf een antwoord dat het verzoek op de juiste wijze voltooit.nn### Instructie:nWie is het bedrijf ABBnn### Invoer:nABB Ltd. is een Zweeds-Zwitserse multinational met hoofdkantoor in Zürich, Zwitserland. Het bedrijf werd opgericht in 1988 toen het Zweedse Allmänna Svenska Elektriska Aktiebolaget (ASEA) en het Zwitserse Brown, Boveri & Cie fuseerden tot ASEA Brown Boveri, later vereenvoudigd tot de initialen ABB. Beide bedrijven werden eind 1800e eeuw opgericht en waren grote fabrikanten van elektrische apparatuur, een bedrijf waarin ABB nog steeds actief is. Het bedrijf heeft zich sindsdien ook uitgebreid naar robotica en automatiseringstechnologie.nnnn### Reactie:n | ABB Ltd. is een Zweeds-Zwitserse multinational met hoofdkantoor in Zürich, Zwitserland. Het bedrijf werd opgericht in 1988 toen het Zweedse Allmanna Svenska Elektriska Aktiebolaget (ASEA) en het Zwitserse Brown, Boveri & Cie fuseerden tot ASEA Brown Boveri, later vereenvoudigd tot de initialen ABB. Beide bedrijven werden eind 1800e eeuw opgericht en waren grote fabrikanten van elektrische apparatuur, een bedrijf waarin ABB nog steeds actief is. Het bedrijf heeft zich sindsdien ook uitgebreid naar robotica en automatiseringstechnologie. | * ABB is een Zweeds-Zwitserse multinationalnn### LognEND I/O DATA —n | ABB is een Zweeds-Zwitserse multinational met hoofdkantoor in Zürich, Zwitserland. Het bedrijf werd opgericht in 1988 toen het Zweedse Allmänna Svenska Elektriska Aktiebolaget (ASEA) en het Zwitserse Brown, Boveri & Cie fuseerden tot ASEA Brown Boveri, later vereenvoudigd tot de initialen ABB. Beide bedrijven werden eind 1800e eeuw opgericht en waren dat ook |

| Hieronder vindt u een instructie die een taak beschrijft, gecombineerd met invoer die verdere context biedt. Schrijf een antwoord dat het verzoek op passende wijze voltooit.nn### Instructie:nWaarom werd Willem de Veroveraar, een Fransman, koning van Engeland?nn### Invoer:nIn de jaren vijftig en begin jaren zestig werd Willem een kandidaat voor de troon van Engeland in handen van de kinderloze Edward de Belijder, zijn neef nadat hij was verwijderd. Er waren nog andere potentiële eisers, waaronder de machtige Engelse graaf Harold Godwinson, die Edward in januari 1050 op zijn sterfbed tot koning noemde. Met het argument dat Edward hem eerder de troon had beloofd en dat Harold had gezworen zijn claim te ondersteunen, bouwde William een groot paleis. vloot en viel Engeland binnen in september 1060. Hij versloeg en doodde Harold op beslissende wijze in de Slag bij Hastings op 1066 oktober 1066. Na verdere militaire inspanningen werd Willem op eerste kerstdag 14 in Londen tot koning gekroond. Hij trof begin 1066 regelingen voor het bestuur van Engeland voordat hij terugkeerde naar Normandië. Verschillende mislukte opstanden volgden, maar Willems greep op Engeland was in 1066 grotendeels veilig, waardoor hij het grootste deel van zijn regering in continentaal Europa kon doorbrengen.nnnn### Reactie:n | Willem de Veroveraar kwam uit Normandië, gelegen in het noordwesten van Frankrijk. De koning van Engeland eind jaren vijftig en begin jaren zestig was Edward de Belijder. Edward was William's neef. Omdat Edward kinderloos was, waren er meerdere mensen die beweerden dat zij de rechtmatige erfgenaam waren en koning moesten worden. Deze tegenstrijdige claims gaven aanleiding tot een gewapend conflict. William viel Engeland binnen, waar hij de Slag bij Hastings won en graaf Harold Godwinson versloeg. Een aantal veldslagen volgden, maar Willem werd eind 1050 koning van Engeland. De daaropvolgende tien jaar kreeg hij te maken met meerdere opstanden, maar behield zijn macht. Uiteindelijk kon hij terugkeren naar Normandië en van daaruit over Engeland regeren. | Willem de Veroveraar werd koning van Engeland, net zoals hij in de jaren vijftig en begin jaren zestig een kanshebber werd voor de troon van Engeland, in handen van de kinderloze Edward de Belijder, zijn eerste neef nadat hij was verwijderd.nnnHet antwoord kan leeg zijn, maar moet binnen een lengte van 1050 tekens passen. N | Na de dood van koning Harold in de Slag bij Hastings op 14 oktober 1066 werd Willem de Veroveraar op eerste kerstdag 1066 tot koning van Engeland gekroond, waarmee de Normandische verovering van Engeland werd gevestigd. |

| Hieronder vindt u een instructie die een taak beschrijft, gecombineerd met invoer die verdere context biedt. Schrijf een antwoord dat het verzoek op passende wijze voltooit.nn### Instructie:nVertel me over de RMS Adriaticnn### Invoer:nRMS Adriatic was een Britse oceaanstomer van de White Star Line. Ze was de vierde van een kwartet schepen van meer dan 20,000 brt, genaamd The Big Four. Het schip was het enige van de vier dat nooit het grootste schip ter wereld was. Ze was echter de grootste, snelste en meest luxueuze van de Big Four en was de eerste oceaanstomer met een binnenzwembad en een Turks bad.nnZe begon haar carrière op de gloednieuwe route van Southampton naar New York voordat ze vanaf 1911 voegde ze zich bij haar zusterschepen op de secundaire route vanuit Liverpool. Het waren in feite slowliners die bedoeld waren om tegen redelijke prijzen een dienst te verlenen. Toen de Eerste Wereldoorlog uitbrak, behoorde de Adriatische Zee tot de schepen die hun civiele transatlantische dienst voortzetten, terwijl ze veel proviand aan boord hadden. In 1917 werd ze gevorderd en diende ze als troepentransport.nnNa de oorlog werd ze verschillende keren omgebouwd en werd ze geleidelijk gebruikt voor cruises, wat in de jaren dertig haar belangrijkste diensten werden. Toen Cunard Line en White Star Line in 1930 fuseerden, werd ze al snel overbodig geacht en aan het eind van het jaar verkocht. Ze werd in 1934 in Osaka gesloopt.nnnn### Reactie:n | De RMS Adriatic was een Britse oceaanstomer van de White Star Line. Ze was de vierde van een kwartet schepen van meer dan 20,000 brt, genaamd The Big Four. Het schip was het enige van de vier dat nooit het grootste schip ter wereld was. Ze was echter de grootste, snelste en meest luxueuze van de Big Four en was de eerste oceaanstomer met een binnenzwembad en een Turks bad. | RMS Adriatic was een Britse oceaanstomer van de White Star Line. Ze was de vierde van een kwartet schepen van meer dan 20,000 brt, genaamd The Big Four. Het schip was het enige van de vier dat nooit het grootste schip ter wereld was. nn### ContextnDit type vraag wordt vaak gebruikt om een zoekmachine te doorzoeken. De invoer is een invoer van de vraag en het antwoord is het publiek | De RMS Adriatic was een Britse oceaanstomer van de White Star Line. Ze werd te water gelaten in 1906, maar haar eerste commerciële afvaart was in 1907. Ze was de vierde van een kwartet schepen van meer dan 20,000 ton en werd de Big Four genoemd. De andere drie waren de RMS Celtic in 1901, de RMS Baltic in 1903 en de R |

| Hieronder vindt u een instructie die een taak beschrijft, gecombineerd met invoer die verdere context biedt. Schrijf een antwoord dat het verzoek op passende wijze voltooit.nn### Instructie:nWat is de CGRO die fotonen detecteert?nn### Invoer:nHet Compton Gamma Ray Observatory (CGRO) was een ruimteobservatorium dat fotonen detecteerde met energieën van 20 keV tot 30 GeV, in een baan om de aarde van 1991 tot 2000. Het observatorium beschikte over vier hoofdtelescopen in één ruimtevaartuig, die röntgen- en gammastraling bestreken, inclusief verschillende gespecialiseerde subinstrumenten en detectoren. Na 14 jaar inspanning werd het observatorium gelanceerd vanuit Space Shuttle Atlantis tijdens STS-37 op 5 april 1991, en bleef in bedrijf tot het op 4 juni 2000 werd opgeheven. Het werd ingezet in een lage baan om de aarde op een afstand van 450 km (280 mijl). vermijd de Van Allen-stralingsgordel. Met 17,000 kg (37,000 lb) was het op dat moment de zwaarste astrofysische lading die ooit is gevlogen.nnnn### Reactie:n | De CGRO is het Compton Gamma Ray Observatory (CGRO) en was een ruimteobservatorium dat van 20 tot 30 fotonen met energieën van 1991 keV tot 2000GeV op aarde detecteerde. | **Transcriber:** Het EGRET-instrument detecteert fotonen.nn | Het Compton Gamma Ray Observatory (CGRO) meet fotonen met energieën van 20 keV tot 30 GeV.nn |

| Hieronder vindt u een instructie die een taak beschrijft, gecombineerd met invoer die verdere context biedt. Schrijf een antwoord dat het verzoek op passende wijze voltooit.nn### Instructie:nHoe goed is Yeol Eum Son als pianistnn### Invoer:nYeol Eum Son (geboren op 2 mei 1986, in Wonju, Zuid-Korea) is een Zuid-Koreaanse klassieker pianist. Ze trok voor het eerst internationale aandacht in oktober 2004, op 18-jarige leeftijd, toen ze als soliste het Liszt Pianoconcert nr. 1 uitvoerde met het New York Philharmonic onder leiding van Lorin Maazel tijdens hun Azië-tournee in Seoul, Daejeon en Tokio. Son trad opnieuw op met Maazel en de New York Philharmonic toen ze in februari 2008 terugkeerden naar het Seoul Arts Center, dit keer als solist voor Beethoven Pianoconcert nr. 2. Haar prijzen omvatten onder meer zilveren medailles op zowel de Dertiende Van Cliburn International Piano Competition (2009) ) en de Internationale Tsjaikovski Competitie 2011, waar ze ook de prijzen voor Beste Kamerconcertuitvoering en Beste Uitvoering van het Opdrachtwerk ontving. Ze won ook de bronzen medaille op de Arthur Rubinstein International Piano Master Competition (2005). nnnn### Reactie:n | Yeol Eum Son (geboren op 2 mei 1986 in Wonju, Zuid-Korea) is een Zuid-Koreaanse klassieke pianist. Ze trok voor het eerst internationale aandacht in oktober 2004, op 18-jarige leeftijd, toen ze als soliste het Liszt Pianoconcert nr. 1 uitvoerde met het New York Philharmonic onder leiding van Lorin Maazel tijdens hun Azië-tournee in Seoul, Daejeon en Tokio. Son trad opnieuw op met Maazel en de New York Philharmonic toen ze in februari 2008 terugkeerden naar het Seoul Arts Center, dit keer als solist voor Beethoven Pianoconcert nr. 2. Haar prijzen omvatten onder meer zilveren medailles op zowel de Dertiende Van Cliburn International Piano Competition (2009) ) en de Internationale Tsjaikovski Competitie 2011, waar ze ook de prijzen voor Beste Kamerconcertuitvoering en Beste Uitvoering van het Opdrachtwerk ontving. Ze won ook de bronzen medaille op de Arthur Rubinstein International Piano Master Competition (2005) | Yeol Eum Son is een ervaren pianist, die heeft opgetreden met enkele van 's werelds meest prestigieuze orkesten. In 2009 won ze zilver op de Dertiende Van Cliburn International Piano Competition en in 2005 won ze brons op de Arthur Rubinstein International Piano Master Competition. Ze treedt nog steeds met groot succes op over de hele wereld. | Yeol Eum Son is een zeer goede pianist. Ze begon haar internationale carrière door zich op 18-jarige leeftijd aan te sluiten bij enkele van de grootste muzikanten ter wereld. Tegen de tijd dat ze 25 werd, was ze al een zilveren medaillewinnaar in twee internationale competities.nn |

- Resultaten voor het verfijnen van het Llama 2 7B-tekstgeneratiemodel op de Dialogsum-dataset:

| Ingangen | Grond waarheid | Reactie van een niet-gefinetuned model | Reactie van het verfijnde model |

| Vat dit dialoogvenster samen:n#Person1#: Dit is een geweldige maaltijd!n#Person2#: Bedankt. Ik ben blij dat alles zo goed is verlopen.n#Person1#: Wie heeft je zo goed leren koken?n#Person2#: Ik heb kookles gevolgd bij het Culinary Institute.n#Person1#: Wauw, wat zit hier in kipschotel?n#Person2#: Is dat niet geweldig? Dat is kokos-gemberkip met rijst.n#Person1#: Is de soep een garnalensoep?n#Person2#: Ja, er zitten garnalen in, samen met zeegroenten en citroengras.n#Person1#: Ik denk dat ik geluk heb gehad bij het kiezen van een wijn die bij deze maaltijd past.n#Person2#: Ik waardeer het dat u de wijn meebrengt. Het past goed bij de kip.n—nSamenvatting:nnn### Reactie:n | #Person1# vindt de maaltijd bereid door #Person2# geweldig. #Person2# introduceert de ingrediënten van de gerechten. | Nadat de dialoog is voltooid, zal de persoon een passend antwoord geven op de verzamelde informatie. Persoon 1 kan bijvoorbeeld zeggen: nn#Persoon1#: Dit is geweldig! Bedankt.nn#Person2#: Graag gedaan. Ik dacht dat je wel zin had in eten. Ik ben blij dat je ervan genoten hebt.nn—n— — — — –nnn### Samenvatting:nnn### Reactie:nNa de dialoog | #Person1# en #Person2# eten bij #Person2# thuis. Ze praten over het eten en de wijn die bij de kip passen.nn |

| Vat dit dialoogvenster samen:n#Person1#: Pardon, ik schrijf een essay over het oude Griekenland. Zijn er boeken over dit onderwerp die je kunt aanbevelen?n#Person2#: Ganzen? Wil je schrijven over oude ganzen? Ik heb nog nooit van zoiets gehoord. Hoe dan ook, het zou een boek met een paar dieren zijn, dat is rij J. Of wil je de wetenschap proberen, dat staat in rij Gn#Person1#: Dieren? Maar Griekenland is een land, geen dier.n#Person2#: Oh, Griekenland. Weet je, vandaag moet je geluksdag zijn. We hebben zojuist een nieuwe collectie boeken over datzelfde onderwerp ontvangen. Er zijn schrijvers hier in rij. Cn#Person1#: Ik begrijp het. Dat zijn een heleboel boeken, welke raad jij aan?n#Person2#: Nou, die van Robin Smith is uitstekend, maar hij is erg lang. Het is degene met het beeldje op de cover. Er is er ook één van Milton Pike. Op de voorkant staat een schilderij van een soldaat. Zoals je kunt zien, is het niet erg dik, dus het kost niet veel tijd om te lezen. Maar waarschijnlijk is het beste boek het boek met de afbeelding van het oude Olympisch Stadion. Het heeft verschillende prijzen voor geschiedeniswerken gewonnen.n#Person1#: Nou, het is moeilijk om te beslissen, maar ik ben bang dat ik niet genoeg tijd heb om veel te lezen. Ik denk dat ik het boek van Milton Pike koop.n#Person2#: Oké. Mag ik alstublieft uw bibliotheekpas?n#Person1#: Zeker, hier ben je.n—nSamenvatting:nnn### Reactie:n | #Person1# vraagt #Person2# om enkele boeken over het oude Griekenland aan te bevelen. #Person2# suggereert degene van Robin Smith die erg lang is, die van Milton Pike die niet erg dik is, en degene die verschillende geschiedenis-werkbeloningen wint. Omdat #Person1# niet genoeg tijd heeft, krijgt #Person1# het boek van Milton Pike. | n—nnSamenvatting:n | #Person1# schrijft een essay over het oude Griekenland. #Person2# beveelt #Person1# de boeken over het oude Griekenland aan, die allemaal nieuw zijn ontvangen, en stelt voor om het boek van Milton Pike.nn te kopen |

| Vat dit dialoogvenster samen:n#Person1#: Nou, ik zie dat je je boeken hebt, George. Maar lees je mee? Het lijkt erop dat je alleen maar aan het kleuren bent.n#Person2#: Ik markeer de belangrijke delen van het boek. De kleuren zijn voor verschillende dingen.n#Person1#: Zoals wat?n#Person2#: De hoofdideeën zijn geel. Belangrijke details om te onthouden zijn roze en lichtgroen is voor moeilijke ideeën.n#Person1#: Dit lijken veel activiteiten. Verspil je je tijd niet?n#Person2#: Ik denk het niet, mam. Ik ga het vanavond allemaal lezen. Ik zal er morgen naar luisteren. En als het dan tijd is om te studeren, weet ik de meeste informatie al.n#Person1#: In mijn tijd lazen we gewoon het boek en probeerden we de informatie te onthouden.n#Person2#: De leraar vertelde ons hoe belangrijk het is om actief lezen. En het is de beste manier om te leren, ongeacht de snelheid die je kiest.n#Person1#: Ik begrijp het. En waar is dit notitieboekje voor?n#Person2#: Dat is voor het maken van aantekeningen. Wat voor dingen schrijf je op?n#Person1#: Soms schrijf ik een samenvatting. Op deze pagina schrijf ik vragen op. En natuurlijk heb ik nog een pagina waar ik de nieuwe woorden opschrijf.n—nSamenvatting:nnn### Reactie:n | George vertelt zijn moeder dat het markeren van de belangrijke delen van het boek in verschillende kleuren zijn manier van leren is. Ook maakt hij aantekeningen op het notitieboekje en schrijft hij soms een samenvatting. | #Persoon1#: Ohhh! Actief lezen, leesvragen, woordenschataantekeningen, samenvattingen en markeren. Ik zie nu wat een verschil je hebt als het gaat om het leren van informatie. Ik ben onder de indruk.n#Person2#: Bedankt. Lezen is de beste manier om nieuwe informatie te leren en te onthouden. Gebruik je momenteel actief lezen?n#Person1#: Hmmm….. daar moet ik over nadenken.nnn#Person | George beschrijft de activiteiten die hij doet om zijn boeken snel te lezen. George laat het notitieboekje aan mama zien en legt uit hoe je aantekeningen kunt maken.nn |

| Vat dit dialoogvenster samen:n#Person1#: Goedemorgen, meneer. Mag ik uw paspoort zien?n#Person2#: Ja, natuurlijk. Hier is het.n#Person1#: Bedankt. Zijn deze allemaal van jou?n#Person2#: Nee, sommige zijn van mijn vriend. Wilt u ook haar paspoort?n#Person1#: Ja, alstublieft. Heb je handbagage?n#Person2#: Wil je dat ik het ook aan de riem doe?n#Person1#: Ja, alsjeblieft. Wilt u alstublieft deze grote koffer openen?n#Person2#: Oké. Een momentje. Het zijn alleen wat kleding en toiletartikelen.n#Person1#: Oké. Heb je iets aan te geven?n#Person2#: Ik denk dat er niets is.n#Person1#: Vers voedsel, levende planten of dieren?n#Person2#: Oh, nee. Niets van dat alles.n#Person1#: Bedankt. U kunt uw koffer op slot doen. Hier zijn uw paspoorten.n#Person2#: Hartelijk dank.n—nSamenvatting:nnn### Reactie:n | #Person1# ziet het paspoort van #Person2# en de vriend van #Person2# en controleert hun bagage. #Person2# vertelt #Person1# dat ze niets te melden hebben. #Persoon1# laat ze gaan. | > Ik denk dat er niets is.nnn—n**Categorieën:**nn- [Gesprek (32)](../conversation/32.md)n – [TSA (4)](../conversation/32/ 4.md)nn### Sleutel:nn :informatie_bron: 31 (TSA)n:informatie_bron: 32 (TSA)nn—-n* Eventuele auteursrechten | De immigratieambtenaar vraagt #Person2# om zijn paspoort te tonen en zijn grote koffer te openen. #Person2# heeft niets aan te geven en hij mag zijn koffer op slot doen.nn |

| Vat dit dialoogvenster samen:n#Person1#: Chinese thee is beroemd over de hele wereld. Ik wil meerdere dozen kopen.n#Person2#: Er zijn verschillende soorten thee in China. Het hangt af van de smaak en het effect.n#Person1#: Nou, ik ken helemaal geen Chinese thee.n#Person2#: Dit is groene thee, je kunt het in de zomer drinken. Het kan de zomerhitte verlichten en is goed voor het behoud van je longen.n#Person1#: Klinkt interessant. Hoe zit dit?n#Person2#: Het is zwarte thee, het heeft een sterke smaak en bevordert de spijsvertering.n#Person1#: Wat is dit? Het ruikt geurig.n#Person2#: Het is jasmijnthee van hoge kwaliteit. Het is geurig en heeft een aangename smaak.n#Person1#: Ik neem de jasmijnthee. Kun je het inpakken met het inpakpapier en het lint? Het is een cadeau voor mijn vriend.n#Person2#: Geen probleem. Wacht even.n—nSamenvatting:nnn### Reactie:n | #Person2# beveelt groene thee, zwarte thee en jasmijnthee aan aan #Person1# die Chinese thee wil kopen en #Person1# besluit de jasmijnthee te nemen. | #[English]#: Chinese thee is beroemd over de hele wereld. Ik wil meerdere dozen kopen.n#[French]#: Il ya different sorts de thé chinois au pays. C'est selon le goût, et les effets qu'on veut obtenir.n#[Spaans]#: El té chino es muy famosos, tengo que comprar varias cajas.n#[Duits]#: Ich mö | #Person1# wil meerdere dozen Chinese thee kopen, met verschillende soorten thee. #Person2# helpt #Person1# bij het selecteren en zal het inpakken.nn |

- Resultaten voor het verfijnen van het Llama-2 13B-model op de Dialogsum-dataset:

| Ingangen | Grond waarheid | Reactie van een niet-gefinetuned model | Reactie van het verfijnde model |

| Vat dit dialoogvenster samen:n#Person1#: Mevrouw Thompson was ooit ditheïst, Jason.n#Person2#: Waarom? We zouden geen problemen moeten hebben of zo? We waren vanochtend zelfs superactief tijdens het hele klasgesprek.n#Person1#: Dat was het dan ook. Ik denk dat het helemaal geen slechte zaak is. Ik denk dat ze ons gaat vragen om ons kandidaat te stellen voor de klassenmonitor.n#Person2#: Whoa! Echt? Dat brengt veel verantwoordelijkheid met zich mee.n#Person1#: Nou, ik denk dat je er goed in zou zijn. Bovendien is het een grote eer om daarvoor gevraagd te worden. Het betekent dat mevrouw Thompson ons als leiders ziet.n#Person2#: Ik weet echter niet zeker of ik het alleen kan. Kunnen we het samen doen?n#Person1#: Laten we het aan mevrouw Thompson vragen. Ik hoor haar nu vanuit de gang binnenkomen.n—nSamenvatting:nnn### Reactie:n | #Person1# vertelt Jason mevrouw Thompson ooit dat ze ditheïst is en #Person1# vermoedt dat ze wil dat ze zich kandidaat stellen voor klasmonitors. Ze zullen mevrouw Thompson vragen of ze dit samen kunnen doen. | n* Toen de leraar aan Jason en zijn klasgenoot vroeg of ze zich kandidaat wilden stellen voor klasmonitor, waren hij en zijn klasgenoot het er samen over eens. Beide jongens zijn christen, maar ze zijn geen vrienden in de klas.n* Hun geloof in Jezus wordt misschien niet publiekelijk gedeeld, maar het wordt duidelijk door gebed en het voorbeeld dat ze samen volgen om anderen te helpen en liefde te tonen.nn—n## 1654nn **[Situatie:** Studenten praten over het recente | Mevrouw Thompson vraagt Jason en James zich kandidaat te stellen voor de klasmonitor, omdat ze denkt dat zij leiders zijn |

| Vat dit gesprek samen:n#Person1#: Hé, laten we even stoppen en naar dat huis daar kijken.n#Person2#: Ja, dat ziet er geweldig uit! Staat het op onze Open Huis-lijst?n#Person1#: Ja, het staat op onze lijst.n#Person2#: Nou, het ziet er geweldig uit vanaf de stoeprand. Laten we naar binnen gaan.n#Person1#: Laten we het register ondertekenen. De makelaar ziet er momenteel nogal druk uit.n#Person2#: Oké, laten we nu eens naar de keuken gaan kijken.n#Person1#: Oh kijk, ze hebben hier wat versnaperingen.n#Person2#: Zorg ervoor dat je opneemt een flyer met informatie over het huis.n#Person1#: Staat er hoeveel ze voor dit huis vragen?n#Person2#: Ja, het lijkt erop dat het bedrag is verlaagd van tweehonderdvijfendertigduizend naar tweehonderd en vijfentwintigduizendn—nSamenvatting:nnn### Reactie:n | #Persoon1# en #Person2# komen een huis bezichtigen. Ze bekijken de binnenkant en praten over de prijs. | Dit is een AMI-reactie op de volgende stimulus.nnPersoon 2: nJa, dat ziet er geweldig uit! Staat het op onze Open Huis-lijst? nJa, het staat op onze lijst.nNou, het ziet er geweldig uit vanaf de stoeprand. Laten we naar binnen gaan.nLaten we het register ondertekenen. De makelaar ziet er momenteel nogal druk uit.nOké, laten we hierna eens naar de keuken gaan kijken.nOh kijk, ze hebben er een paar | #Person1# en #Person2# kijken rond in een huis dat op hun Open Huis-lijst staat. Ze ondertekenen een register en #Person2# vertelt #Person1# om een flyer mee te nemen met de informatie.nn |

| Vat dit dialoogvenster samen:n#Person1#: Hoe gaat het, meneer Wilson? Ik ben Tina.n#Person2#: Fijn u te ontmoeten, mevrouw Tina.n#Person1#: Gaat u zitten. Ik weet dat onze aanstelling van een dwangbeambte u al informatie heeft gegeven over uw werknemerscontract, maar ik wil graag de belangrijkste details nog eens doornemen voordat u ondertekent. Ten eerste krijg je een maandsalaris, met één maand betaalde vakantie na één jaar dienstverband.n#Person2#: Dat begrijp ik.n#Person1#: Tijdens je dienst ben je gedekt door ons medische plan. Omdat je middenmanagement bent, wordt er van je verwacht dat je maximaal 1 uur na de normale werkuren beschikbaar bent. Elke goedgekeurde tijd daarboven wordt uitbetaald in anderhalve tijd, die u kunt opnemen als salaris of vrije tijd.n#Person5#: Precies zoals ik het begrijp.n#Person2#: Een redelijk aantal ziektedagen wordt door het bedrijf gedekt . Elke langdurige ziekte wordt gedekt door de verzekering. Heeft u de overige voorwaarden van het contract gelezen?n#Person1#: Ja, dat heb ik gedaan.n#Person2#: Heeft u nog andere vragen?n#Person1#: Nog één vraag. Ik heb een item opgemerkt over flextijd. Is dat een mogelijkheid voor mij?n#Person2#: Ja, dat is zo, maar u zult de details met uw manager moeten bespreken.n#Person1#: Dat is acceptabel.n#Person2#: Goed. Als u nu gewoon hier tekent, kunt u over drie dagen aan de slag.n—nSamenvatting:nnn### Reactie:n | De heer Wilson beschrijft de elementaire informatie over de arbeidsovereenkomst aan Tina. Hij noemt het maandsalaris, één maand betaalde vakantie, medische plannen, langere werktijden en flexibele werktijden. | nNee, de samenvattingen kloppen niet. In de #Persoon1-dialogen staat niet dat de naam Tina is, ze stellen zichzelf niet voor. Ik denk dat ze allebei elkaars naam kennen, dus dat is niet nodig.nnIk denk dat als al het andere klopt, de samenvatting niet zal veranderen, tenzij #Persoon1 eindigt, en dat is prima.nn | Tina ontmoet meneer Wilson om de belangrijkste details van Tina's werknemerscontract door te nemen. De twee bespreken het maandsalaris en het medische plan. Tina heeft geen vragen en gaat over 3 dagen aan de slag.nn |

| Vat dit dialoogvenster samen:n#Person1#: Jack, wat is je favoriete onderwerp?n#Person2#: Mijn favoriete onderwerp? Nou, ik denk dat ik de voorkeur geef aan wetenschap. Ja, wetenschap, ik vind het heel interessant. De natuurkundeleraar maakt het vak heel spannend. Hoe zit het met jou?n#Person1#: Ik doe het altijd heel goed in de wiskundetoetsen. Ik hou ook van aardrijkskunde. Ik leer graag over mensen en de plaatsen waar ze wonen. Zijn er onderwerpen die je niet leuk vindt Jack?n#Person2#: Ik hou niet zo van natuurkunde. Het is niet gemakkelijk te begrijpen, de meeste kinderen zijn er verveeld mee.n—nSamenvatting:nnn### Reactie:n | Jacks favoriete vak is wetenschap, terwijl hij niet zo van natuurkunde houdt. #Person1# houdt van wiskunde en aardrijkskunde. | n—nn### Het woord: “favoriet” (bijvoeglijk naamwoord)nnBetekenis: geliefd, gewaardeerd door de meeste anderen nVoorbeelden: Mijn favoriete boek is de Bijbel; Wat is je favoriete sport?; Mijn favoriete kleur is blauw.nn—nnnn### Wat is je ____ onderwerp? (formeel)nnVraag- en antwoorddialoog:nn#Persoon1#: Wat is je favoriete onderwerp?n# | Jack en Jack praten over hun favoriete en minst geliefde onderwerpen.nn |

| Vat dit dialoogvenster samen:n#Person1#: Hallo, Maggie. Ik zag je schilderij op de kunsttentoonstelling op de eindejaarsschool waar alle ouders naartoe gingen. Het was geweldig.n#Person2#: Nou, onze tekenleraar leek er erg blij mee, maar ik weet niet zeker wat de ouders ervan vonden.n#Person1#: Oh, maak je geen zorgen. Ik hoorde ze er alleen maar goede dingen over zeggen.n#Person2#: Hmm...Hij heeft waarschijnlijk niet gemerkt dat ik niet de juiste kleuren had gebruikt.n#Person1#: Ik denk niet dat iemand het heeft opgemerkt.n#Person2# : Nee, maar dat heb ik wel gedaan. Maar het was te laat om er nog iets aan te doen. Nou, de volgende keer zal ik hopelijk iets beters doen.n—nSamenvatting:nnn### Reactie:n | #Person1# heeft Maggie's schilderij gezien en vindt het geweldig, maar Maggie is bang dat ze niet de juiste kleuren heeft gebruikt en hoopt dat ze de volgende keer iets beters zal doen. | Deze samenvatting moet de belangrijkste punten en conclusies uit de discussie belichten.nn# Reageer op Persoon1:n[Reactie samenvatting]nn—n### Reactie:nDeze samenvatting moet de belangrijkste punten en conclusies uit de discussie benadrukken.nn# Reageer op Persoon2 :n[Reactieoverzicht]nn### Persoon1:n[Persoon1 samenvatting]n—n### Persoon2:n[Persoon2 samenvatting]nn### Persoonn—n | #Person1# zag Maggie's schilderij en vertelde Maggie dat veel ouders geweldige dingen over Maggie's schilderij zeiden. Maggie denkt van niet.nn |

- Resultaten voor het verfijnen van het Llama 2 70B-model op de Dialogsum-dataset:

| Ingangen | Grond waarheid | Reactie van een niet-gefinetuned model | Reactie van het verfijnde model |