Terwijl organisaties modellen inzetten voor productie, zijn ze voortdurend op zoek naar manieren om de prestaties van hun basismodellen (FM's) te optimaliseren die draaien op de nieuwste versnellers, zoals AWS Inferentie en GPU's, zodat ze hun kosten kunnen verlagen en de responslatentie kunnen verlagen om eindgebruikers de beste ervaring te bieden. Sommige FM's maken echter niet volledig gebruik van de accelerators die beschikbaar zijn bij de instances waarop ze worden ingezet, wat leidt tot een inefficiënt gebruik van hardwarebronnen. Sommige organisaties implementeren meerdere FM's op dezelfde instantie om alle beschikbare accelerators beter te kunnen benutten, maar dit vereist een complexe infrastructuurorkestratie die tijdrovend en moeilijk te beheren is. Wanneer meerdere FM's dezelfde instantie delen, heeft elke FM zijn eigen schaalbehoeften en gebruikspatronen, waardoor het een uitdaging is om te voorspellen wanneer u instanties moet toevoegen of verwijderen. Het ene model kan bijvoorbeeld worden gebruikt om een gebruikerstoepassing aan te drijven waarbij het gebruik op bepaalde uren kan pieken, terwijl een ander model een consistenter gebruikspatroon kan hebben. Naast het optimaliseren van de kosten willen klanten de beste eindgebruikerservaring bieden door de latentie te verminderen. Om dit te doen, implementeren ze vaak meerdere exemplaren van een FM om tegelijkertijd verzoeken van gebruikers af te handelen. Omdat FM-uitvoer kan variëren van een enkele zin tot meerdere alinea's, varieert de tijd die nodig is om het inferentieverzoek te voltooien aanzienlijk, wat leidt tot onvoorspelbare pieken in de latentie als de verzoeken willekeurig tussen instanties worden gerouteerd. Amazon Sage Maker ondersteunt nu nieuwe inferentiemogelijkheden waarmee u de implementatiekosten en latentie kunt verlagen.

U kunt nu op inferentiecomponenten gebaseerde eindpunten maken en machine learning-modellen (ML) implementeren op een SageMaker-eindpunt. Een inferentiecomponent (IC) vat uw ML-model samen en stelt u in staat CPU's, GPU's of AWS-neuron versnellers en schaalbeleid per model. Inferentiecomponenten bieden de volgende voordelen:

- SageMaker zal modellen optimaal op ML-instanties plaatsen en verpakken om het gebruik te maximaliseren, wat tot kostenbesparingen leidt.

- SageMaker schaalt elk model op en neer op basis van uw configuratie om te voldoen aan de vereisten van uw ML-toepassing.

- SageMaker zal schalen om instanties dynamisch toe te voegen en te verwijderen om ervoor te zorgen dat er capaciteit beschikbaar is, terwijl inactieve rekenkracht tot een minimum wordt beperkt.

- U kunt terugschalen naar nul exemplaren van een model om bronnen vrij te maken voor andere modellen. U kunt ook opgeven dat belangrijke modellen altijd geladen en klaar voor verkeer moeten blijven.

Met deze mogelijkheden kunt u de implementatiekosten van modellen gemiddeld met 50% verlagen. De kostenbesparingen zijn afhankelijk van uw werklast en verkeerspatronen. Laten we een eenvoudig voorbeeld nemen om te illustreren hoe het verpakken van meerdere modellen op één eindpunt het gebruik kan maximaliseren en kosten kan besparen. Stel dat u een chattoepassing heeft die toeristen helpt lokale gebruiken en best practices te begrijpen, gebouwd met behulp van twee varianten van Llama 2: de ene afgestemd op Europese bezoekers en de andere afgestemd op Amerikaanse bezoekers. We verwachten verkeer voor het Europese model tussen 00:01–11:59 UTC en het Amerikaanse model tussen 12:00–23:59 UTC. In plaats van deze modellen op hun eigen speciale instances te implementeren waar ze de helft van de tijd inactief blijven, kunt u ze nu op één eindpunt implementeren om kosten te besparen. Je kunt het Amerikaanse model terugschalen naar nul als dat niet nodig is om capaciteit vrij te maken voor het Europese model, en omgekeerd. Hierdoor kunt u uw hardware efficiënt gebruiken en verspilling voorkomen. Dit is een eenvoudig voorbeeld waarbij gebruik wordt gemaakt van twee modellen, maar u kunt dit idee eenvoudig uitbreiden door honderden modellen op één eindpunt te plaatsen, dat automatisch meegroeit met uw werklast.

In dit bericht laten we u de nieuwe mogelijkheden zien van IC-gebaseerde SageMaker-eindpunten. We begeleiden u ook bij het implementeren van meerdere modellen met behulp van inferentiecomponenten en API's. Ten slotte beschrijven we enkele van de nieuwe observatiemogelijkheden en hoe u beleid voor automatisch schalen voor uw modellen instelt en het schalen van instanties voor uw eindpunten beheert. U kunt modellen ook implementeren via onze nieuwe, vereenvoudigde, interactieve gebruikerservaring. We ondersteunen ook geavanceerde routeringsmogelijkheden om de latentie en prestaties van uw inferentieworkloads te optimaliseren.

Bouw blokken

Laten we eens dieper kijken en begrijpen hoe deze nieuwe mogelijkheden werken. Het volgende is enkele nieuwe terminologie voor SageMaker-hosting:

- Inferentiecomponent – Een SageMaker-hostingobject dat u kunt gebruiken om een model op een eindpunt te implementeren. U kunt een gevolgtrekkingscomponent maken door het volgende op te geven:

- Het SageMaker-model of de specificatie van een SageMaker-compatibele afbeelding en modelartefacten.

- Vereisten voor rekenbronnen, die de behoeften van elk exemplaar van uw model specificeren, inclusief CPU-kernen, hostgeheugen en aantal versnellers.

- Modelexemplaar – Een runtime-kopie van een inferentiecomponent die verzoeken kan verwerken.

- Automatisch schalen van beheerde exemplaren – Een SageMaker-hostingmogelijkheid om het aantal rekeninstanties dat voor een eindpunt wordt gebruikt, op of af te schalen. Het schalen van instanties reageert op het schalen van gevolgtrekkingscomponenten.

Om een nieuwe inferentiecomponent te maken, kunt u een containerimage en een modelartefact opgeven, of u kunt SageMaker-modellen gebruiken die u mogelijk al hebt gemaakt. U moet ook de vereisten voor rekenbronnen opgeven, zoals het aantal host-CPU-kernen, hostgeheugen of het aantal accelerators dat uw model moet uitvoeren.

Wanneer u een inferentiecomponent implementeert, kunt u dit opgeven MinCopies om ervoor te zorgen dat het model al is geladen in de hoeveelheid die u nodig heeft, klaar om aan uw verzoeken te voldoen.

U hebt ook de mogelijkheid om uw beleid zo in te stellen dat kopieën van inferentiecomponenten naar nul worden geschaald. Als er bijvoorbeeld geen belasting op een IC draait, wordt de modelkopie verwijderd. Hierdoor kunnen bronnen vrijkomen die kunnen worden vervangen door actieve werklasten om het gebruik en de efficiëntie van uw eindpunt te optimaliseren.

Naarmate de gevolgtrekkingsverzoeken toenemen of afnemen, kan het aantal exemplaren van uw IC's ook omhoog of omlaag worden geschaald op basis van uw beleid voor automatisch schalen. SageMaker zorgt voor de plaatsing om de verpakking van uw modellen te optimaliseren op basis van beschikbaarheid en kosten.

Als u bovendien automatisch schalen van beheerde instanties inschakelt, zal SageMaker rekeninstanties schalen op basis van het aantal inferentiecomponenten dat op een bepaald moment moet worden geladen om verkeer te bedienen. SageMaker zal de instances opschalen en uw instances en inferentiecomponenten inpakken om de kosten te optimaliseren, terwijl de modelprestaties behouden blijven. Hoewel we het gebruik van beheerde instantie-schaling aanbevelen, heeft u ook de mogelijkheid om de schaling zelf te beheren, mocht u dat willen, via automatisch schalen van toepassingen.

SageMaker zal de inferentiecomponenten opnieuw in evenwicht brengen en de instanties verkleinen als ze niet langer nodig zijn voor inferentiecomponenten, waardoor u kosten bespaart.

Overzicht van API's

SageMaker heeft een nieuwe entiteit geïntroduceerd genaamd de InferenceComponent. Hierdoor worden de details van het hosten van het ML-model losgekoppeld van het eindpunt zelf. De InferenceComponent Hiermee kunt u belangrijke eigenschappen opgeven voor het hosten van het model, zoals het SageMaker-model dat u wilt gebruiken of de containerdetails en modelartefacten. U geeft ook het aantal exemplaren op van de componenten zelf die moeten worden geïmplementeerd, en het aantal vereiste versnellers (GPU's, Inf of Trn-accelerators) of CPU (vCPU's). Dit biedt u meer flexibiliteit om één eindpunt te gebruiken voor een willekeurig aantal modellen dat u er in de toekomst op wilt implementeren.

Laten we eens kijken naar de Boto3 API-aanroepen om een eindpunt te maken met een inferentiecomponent. Houd er rekening mee dat er enkele parameters zijn die we later in dit bericht bespreken.

Het volgende is voorbeeldcode voor CreateEndpointConfig:

Het volgende is voorbeeldcode voor CreateEndpoint:

Het volgende is voorbeeldcode voor CreateInferenceComponent:

Deze ontkoppeling van InferenceComponent naar een eindpunt biedt flexibiliteit. U kunt meerdere modellen op dezelfde infrastructuur hosten en deze toevoegen of verwijderen als uw vereisten veranderen. Elk model kan indien nodig afzonderlijk worden bijgewerkt. Bovendien kunt u modellen schalen op basis van uw zakelijke behoeften. InferenceComponent Hiermee kunt u ook de capaciteit per model regelen. Met andere woorden: u kunt bepalen hoeveel exemplaren van elk model u wilt hosten. Dankzij deze voorspelbare schaling kunt u voldoen aan de specifieke latentievereisten voor elk model. Algemeen, InferenceComponent geeft u veel meer controle over uw gehoste modellen.

In de volgende tabel laten we een vergelijking naast elkaar zien van de aanpak op hoog niveau voor het maken en aanroepen van een eindpunt zonder InferenceComponent en InferenceComponent. Houd er rekening mee dat CreateModel() nu optioneel is voor IC-gebaseerde eindpunten.

| Stap voor | Op modellen gebaseerde eindpunten | Op componenten gebaseerde eindpunten |

| 1 | CreëerModel(…) | CreateEndpointConfig(…) |

| 2 | CreateEndpointConfig(…) | Eindpunt maken(…) |

| 3 | Eindpunt maken(…) | CreateInferenceComponent(…) |

| 4 | Eindpunt aanroepen(…) | InvokeEndpoint(InferneceComponentName=’waarde’…) |

De introductie van InferenceComponent Hiermee kunt u op modelniveau schalen. Zien Duik in het automatisch schalen van instanties en IC's voor meer informatie over hoe InferenceComponent werkt met automatisch schalen.

Wanneer u het SageMaker-eindpunt aanroept, kunt u nu de nieuwe parameter opgeven InferenceComponentName om het gewenste te raken InferenceComponentName. SageMaker zorgt voor het routeren van het verzoek naar de instantie die het aangevraagde host InferenceComponentName. Zie de volgende code:

Standaard gebruikt SageMaker willekeurige routering van de verzoeken naar de instanties die uw eindpunt ondersteunen. Als u de routering van de minst openstaande verzoeken wilt inschakelen, kunt u de routeringsstrategie instellen in de eindpuntconfiguraties RoutingConfig:

Minst openstaande aanvragen routeren routes naar de specifieke instanties die meer capaciteit hebben om aanvragen te verwerken. Dit zorgt voor een meer uniforme taakverdeling en resourcegebruik.

Naast CreateInferenceComponent, zijn de volgende API's nu beschikbaar:

DescribeInferenceComponentDeleteInferenceComponentUpdateInferenceComponentListInferenceComponents

InferenceComponent-logboeken en -statistieken

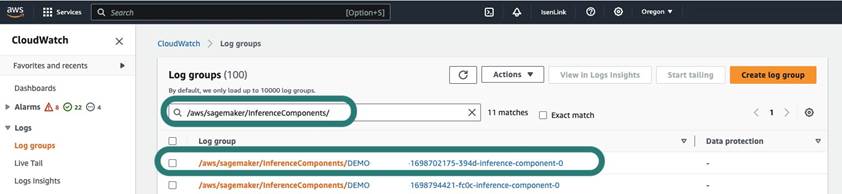

InferenceComponent logboeken bevinden zich in /aws/sagemaker/InferenceComponents/<InferenceComponentName>. Alle logboeken die naar stderr en stdout in de container worden verzonden, worden naar deze logboeken verzonden Amazon Cloud Watch.

Met de introductie van op IC gebaseerde eindpunten hebt u nu de mogelijkheid om aanvullende instantiestatistieken, statistische gegevens over gevolgtrekkingscomponenten en aanroepstatistieken te bekijken.

Voor SageMaker-instanties kunt u nu de GPUReservation en CPUReservation metrische gegevens om de bronnen te zien die zijn gereserveerd voor een eindpunt op basis van de gevolgtrekkingscomponenten die u hebt geïmplementeerd. Deze statistieken kunnen u helpen bij het bepalen van de grootte van uw beleid voor eindpunten en automatische schaling. U kunt ook de verzamelde statistieken bekijken die zijn gekoppeld aan alle modellen die op een eindpunt zijn geïmplementeerd.

SageMaker geeft ook statistieken weer op het niveau van de gevolgtrekkingscomponenten, wat een gedetailleerder beeld kan geven van het gebruik van bronnen voor de gevolgtrekkingscomponenten die u hebt geïmplementeerd. Hierdoor kunt u een beeld krijgen van de totale benutting van hulpbronnen, zoals GPUUtilizationNormalized en GPUMemoryUtilizationNormalized voor elke inferentiecomponent die u hebt geïmplementeerd en die mogelijk nul of veel exemplaren bevat.

Ten slotte biedt SageMaker aanroepstatistieken, die nu aanroepen voor inferentiecomponenten aggregaat volgen (Invocations) of per exemplaar geïnstantieerd (InvocationsPerCopy)

Voor een uitgebreide lijst met statistieken raadpleegt u SageMaker Endpoint-aanroepstatistieken.

Automatisch schalen op modelniveau

Om het automatische schalingsgedrag dat we hebben beschreven te implementeren, definieert u bij het maken van de SageMaker-eindpuntconfiguratie en de inferentiecomponent respectievelijk het initiële aantal exemplaren en het initiële aantal modelkopieën. Nadat u het eindpunt en de bijbehorende IC's hebt gemaakt, moet u, om automatisch schalen op IC-niveau toe te passen, eerst het schaaldoel registreren en vervolgens het schaalbeleid aan de IC koppelen.

Bij het implementeren van het schaalbeleid gebruiken we SageMakerInferenceComponentInvocationsPerCopy, een nieuwe statistiek geïntroduceerd door SageMaker. Het legt het gemiddelde aantal aanroepen per modelkopie per minuut vast.

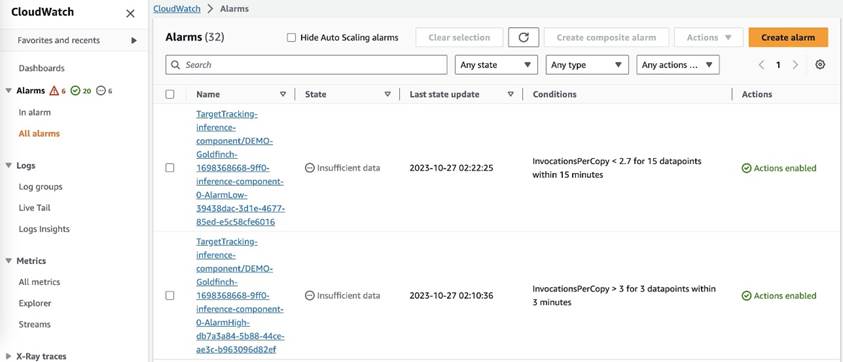

Nadat u het schaalbeleid hebt ingesteld, maakt SageMaker twee CloudWatch-alarmen voor elk doel voor automatisch schalen: één om uitschalen te activeren bij een alarm gedurende 3 minuten (drie datapunten van 1 minuut) en één om opschalen te activeren bij een alarm gedurende 15 minuten (15 gegevenspunten van 1 minuut), zoals weergegeven in de volgende schermafbeelding. De tijd om de schaalactie te activeren is doorgaans 1 à 2 minuten langer dan die minuten, omdat het tijd kost voordat het eindpunt de statistieken naar CloudWatch publiceert, en het ook tijd kost om AutoScaling reageren. De afkoelperiode is de hoeveelheid tijd, in seconden, nadat een in- of uitschaalactiviteit is voltooid voordat een andere uitschaalactiviteit kan starten. Als de afkoelperiode voor het uitschalen korter is dan de updatetijd van het eindpunt, heeft dit geen effect, omdat het niet mogelijk is om een SageMaker-eindpunt bij te werken wanneer het zich in Bijwerken statuut.

Houd er rekening mee dat u bij het instellen van automatische schaling op IC-niveau ervoor moet zorgen dat de MaxInstanceCount parameter is gelijk aan of kleiner dan het maximale aantal IC's dat dit eindpunt kan verwerken. Als uw eindpunt bijvoorbeeld is geconfigureerd om slechts één exemplaar in de eindpuntconfiguratie te hebben en dit exemplaar slechts maximaal vier exemplaren van het model kan hosten, dan MaxInstanceCount moet gelijk zijn aan of kleiner dan 4. U kunt echter ook de beheerde automatische schalingsmogelijkheid van SageMaker gebruiken om het aantal exemplaren automatisch te schalen op basis van het vereiste aantal modelkopieën om aan de behoefte aan meer rekenbronnen te voldoen. Het volgende codefragment laat zien hoe u het schalen van beheerde exemplaren instelt tijdens het maken van de eindpuntconfiguratie. Op deze manier zal SageMaker, wanneer het automatisch schalen op IC-niveau een groter aantal exemplaren vereist om de modelkopieën te hosten, het exemplaarnummer automatisch uitschalen om het schalen op IC-niveau succesvol te laten zijn.

U kunt meerdere beleidsregels voor automatisch schalen toepassen op hetzelfde eindpunt, wat betekent dat u het traditionele beleid voor automatisch schalen kunt toepassen op de eindpunten die zijn gemaakt met IC's en omhoog en omlaag kunt schalen op basis van de andere eindpuntstatistieken. Voor meer informatie, zie Optimaliseer uw machine learning-implementaties met automatisch schalen op Amazon SageMaker. Hoewel dit mogelijk is, raden we u toch aan het schalen van beheerde exemplaren te gebruiken in plaats van zelf het schalen te beheren.

Conclusie

In dit bericht hebben we een nieuwe functie in SageMaker-inferentie geïntroduceerd waarmee u het gebruik van rekeninstanties kunt maximaliseren, naar honderden modellen kunt schalen en de kosten kunt optimaliseren, terwijl u voorspelbare prestaties levert. Bovendien hebben we een overzicht van de API's gegeven en u laten zien hoe u inferentiecomponenten voor uw workloads kunt configureren en implementeren.

Wij ondersteunen ook geavanceerde routeringsmogelijkheden om de latentie en prestaties van uw inferentieworkloads te optimaliseren. SageMaker kan u helpen uw inferentieworkloads te optimaliseren voor kosten en prestaties en u granulariteit op modelniveau te bieden voor beheer. Wij hebben een aangemaakt set notitieboekjes dat laat je zien hoe je drie verschillende modellen kunt implementeren, verschillende containers kunt gebruiken en beleid voor automatisch schalen kunt toepassen in GitHub. We moedigen u aan om te beginnen met notebook 1 en vandaag nog aan de slag te gaan met de nieuwe SageMaker-hostingmogelijkheden!

Over de auteurs

James Park is oplossingsarchitect bij Amazon Web Services. Hij werkt samen met Amazon.com om technologische oplossingen op AWS te ontwerpen, bouwen en implementeren, en heeft een bijzondere interesse in AI en machine learning. In zijn vrije tijd gaat hij graag op zoek naar nieuwe culturen, nieuwe ervaringen en blijft hij op de hoogte van de nieuwste technologische trends. Je kunt hem vinden op LinkedIn.

James Park is oplossingsarchitect bij Amazon Web Services. Hij werkt samen met Amazon.com om technologische oplossingen op AWS te ontwerpen, bouwen en implementeren, en heeft een bijzondere interesse in AI en machine learning. In zijn vrije tijd gaat hij graag op zoek naar nieuwe culturen, nieuwe ervaringen en blijft hij op de hoogte van de nieuwste technologische trends. Je kunt hem vinden op LinkedIn.

Melanie Li, PhD, is een Senior AI/ML-specialist TAM bij AWS in Sydney, Australië. Ze helpt zakelijke klanten oplossingen te bouwen met behulp van de modernste AI/ML-tools op AWS en biedt begeleiding bij het ontwerpen en implementeren van ML-oplossingen met best practices. In haar vrije tijd houdt ze ervan om de natuur te verkennen en tijd door te brengen met familie en vrienden.

Melanie Li, PhD, is een Senior AI/ML-specialist TAM bij AWS in Sydney, Australië. Ze helpt zakelijke klanten oplossingen te bouwen met behulp van de modernste AI/ML-tools op AWS en biedt begeleiding bij het ontwerpen en implementeren van ML-oplossingen met best practices. In haar vrije tijd houdt ze ervan om de natuur te verkennen en tijd door te brengen met familie en vrienden.

Marc Karp is een ML-architect bij het Amazon SageMaker Service-team. Hij richt zich op het helpen van klanten bij het ontwerpen, implementeren en beheren van ML-workloads op schaal. In zijn vrije tijd houdt hij van reizen en nieuwe plekken ontdekken.

Marc Karp is een ML-architect bij het Amazon SageMaker Service-team. Hij richt zich op het helpen van klanten bij het ontwerpen, implementeren en beheren van ML-workloads op schaal. In zijn vrije tijd houdt hij van reizen en nieuwe plekken ontdekken.

Alan Tan is Senior Product Manager bij SageMaker en leidt inspanningen op het gebied van grote modelinferentie. Hij heeft een passie voor het toepassen van machine learning op het gebied van analytics. Buiten zijn werk geniet hij van het buitenleven.

Alan Tan is Senior Product Manager bij SageMaker en leidt inspanningen op het gebied van grote modelinferentie. Hij heeft een passie voor het toepassen van machine learning op het gebied van analytics. Buiten zijn werk geniet hij van het buitenleven.

Raghu Ramesha is een Senior ML Solutions Architect bij het Amazon SageMaker Service-team. Hij richt zich op het helpen van klanten bij het op grote schaal bouwen, implementeren en migreren van ML-productieworkloads naar SageMaker. Hij is gespecialiseerd in machine learning, AI en computer vision-domeinen, en heeft een masterdiploma in computerwetenschappen van UT Dallas. In zijn vrije tijd houdt hij van reizen en fotografie.

Raghu Ramesha is een Senior ML Solutions Architect bij het Amazon SageMaker Service-team. Hij richt zich op het helpen van klanten bij het op grote schaal bouwen, implementeren en migreren van ML-productieworkloads naar SageMaker. Hij is gespecialiseerd in machine learning, AI en computer vision-domeinen, en heeft een masterdiploma in computerwetenschappen van UT Dallas. In zijn vrije tijd houdt hij van reizen en fotografie.

Rupinder Grewal is een Sr Ai/ML Specialist Solutions Architect bij AWS. Hij richt zich momenteel op het bedienen van modellen en MLOps op SageMaker. Voorafgaand aan deze functie heeft hij gewerkt als Machine Learning Engineer voor het bouwen en hosten van modellen. Naast zijn werk speelt hij graag tennis en fietst hij graag op bergpaden.

Rupinder Grewal is een Sr Ai/ML Specialist Solutions Architect bij AWS. Hij richt zich momenteel op het bedienen van modellen en MLOps op SageMaker. Voorafgaand aan deze functie heeft hij gewerkt als Machine Learning Engineer voor het bouwen en hosten van modellen. Naast zijn werk speelt hij graag tennis en fietst hij graag op bergpaden.

Dhawal Patel is een Principal Machine Learning Architect bij AWS. Hij heeft gewerkt met organisaties variërend van grote ondernemingen tot middelgrote startups aan problemen met betrekking tot gedistribueerde computing en kunstmatige intelligentie. Hij richt zich op Deep learning inclusief NLP en Computer Vision domeinen. Hij helpt klanten bij het bereiken van high-performance modelinferentie op SageMaker.

Dhawal Patel is een Principal Machine Learning Architect bij AWS. Hij heeft gewerkt met organisaties variërend van grote ondernemingen tot middelgrote startups aan problemen met betrekking tot gedistribueerde computing en kunstmatige intelligentie. Hij richt zich op Deep learning inclusief NLP en Computer Vision domeinen. Hij helpt klanten bij het bereiken van high-performance modelinferentie op SageMaker.

Saurabh Trikande is Senior Product Manager voor Amazon SageMaker Inference. Hij heeft een passie voor het werken met klanten en wordt gemotiveerd door het doel om machine learning te democratiseren. Hij richt zich op kernuitdagingen met betrekking tot het inzetten van complexe ML-applicaties, multi-tenant ML-modellen, kostenoptimalisaties en het toegankelijker maken van de inzet van deep learning-modellen. In zijn vrije tijd houdt Saurabh van wandelen, leren over innovatieve technologieën, TechCrunch volgen en tijd doorbrengen met zijn gezin.

Saurabh Trikande is Senior Product Manager voor Amazon SageMaker Inference. Hij heeft een passie voor het werken met klanten en wordt gemotiveerd door het doel om machine learning te democratiseren. Hij richt zich op kernuitdagingen met betrekking tot het inzetten van complexe ML-applicaties, multi-tenant ML-modellen, kostenoptimalisaties en het toegankelijker maken van de inzet van deep learning-modellen. In zijn vrije tijd houdt Saurabh van wandelen, leren over innovatieve technologieën, TechCrunch volgen en tijd doorbrengen met zijn gezin.

Lakshmi Ramakrishnan is een hoofdingenieur bij het Amazon SageMaker Machine Learning (ML)-platformteam in AWS en levert technisch leiderschap voor het product. Hij heeft ruim negen jaar in verschillende technische functies bij Amazon gewerkt. Hij heeft een Bachelor of Engineering-graad in Informatietechnologie van het National Institute of Technology, Karnataka, India en een Master of Science-graad in Computerwetenschappen van de University of Minnesota Twin Cities.

Lakshmi Ramakrishnan is een hoofdingenieur bij het Amazon SageMaker Machine Learning (ML)-platformteam in AWS en levert technisch leiderschap voor het product. Hij heeft ruim negen jaar in verschillende technische functies bij Amazon gewerkt. Hij heeft een Bachelor of Engineering-graad in Informatietechnologie van het National Institute of Technology, Karnataka, India en een Master of Science-graad in Computerwetenschappen van de University of Minnesota Twin Cities.

David Negenda is een Senior Software Development Engineer bij het Amazon SageMaker-team en werkt momenteel aan het verbeteren van productie-machine learning-workflows en het lanceren van nieuwe inferentiefuncties. In zijn vrije tijd probeert hij zijn kinderen bij te houden.

David Negenda is een Senior Software Development Engineer bij het Amazon SageMaker-team en werkt momenteel aan het verbeteren van productie-machine learning-workflows en het lanceren van nieuwe inferentiefuncties. In zijn vrije tijd probeert hij zijn kinderen bij te houden.

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoData.Network Verticale generatieve AI. Versterk jezelf. Toegang hier.

- PlatoAiStream. Web3-intelligentie. Kennis versterkt. Toegang hier.

- PlatoESG. carbon, CleanTech, Energie, Milieu, Zonne, Afvalbeheer. Toegang hier.

- Plato Gezondheid. Intelligentie op het gebied van biotech en klinische proeven. Toegang hier.

- Bron: https://aws.amazon.com/blogs/machine-learning/reduce-model-deployment-costs-by-50-on-average-using-sagemakers-latest-features/

- : heeft

- :is

- :niet

- :waar

- $UP

- 1

- 10

- 100

- 114

- 12

- 13

- 15%

- 150

- 16

- 22

- 360

- 362

- 500

- 7

- 9

- a

- vermogen

- in staat

- Over

- samenvattingen

- versnellers

- beschikbaar

- Volgens

- Bereiken

- Actie

- actieve

- activiteit

- toevoegen

- toe te voegen

- toevoeging

- Extra

- Daarnaast

- adres

- vergevorderd

- Na

- tegen

- aggregaat

- AI

- AI / ML

- Alan

- alarm

- Alles

- toelaten

- toestaat

- al

- ook

- Hoewel

- altijd

- Amazone

- Amazon Sage Maker

- Amazon Web Services

- Amazon.com

- Amerikaans

- bedragen

- an

- analytics

- en

- Nog een

- elke

- api

- APIs

- Aanvraag

- toepassingen

- Solliciteer

- Het toepassen van

- nadering

- ZIJN

- GEBIED

- kunstmatig

- kunstmatige intelligentie

- AS

- Associëren

- geassocieerd

- At

- Australië

- auto

- webmaster.

- beschikbaarheid

- Beschikbaar

- gemiddelde

- vermijd

- AWS

- steun

- gebaseerde

- BE

- omdat

- vaardigheden

- gedrag

- betekent

- BEST

- 'best practices'

- Betere

- tussen

- bouw

- Gebouw

- bebouwd

- bedrijfsdeskundigen

- maar

- by

- Dit betekent dat we onszelf en onze geliefden praktisch vergiftigen.

- oproepen

- CAN

- mogelijkheden

- bekwaamheid

- in staat

- Inhoud

- captures

- zeker

- uitdagingen

- uitdagend

- verandering

- Kies

- Steden

- code

- COM

- vergelijking

- compleet

- voltooit

- complex

- bestanddeel

- componenten

- uitgebreid

- Berekenen

- computer

- Computer Science

- Computer visie

- computergebruik

- Configuratie

- geconfigureerd

- consequent

- permanent

- consumeren

- Containers

- containers

- onder controle te houden

- Kern

- Overeenkomend

- Kosten

- kostenbesparingen

- Kosten

- kon

- en je merk te creëren

- aangemaakt

- creëert

- Wij creëren

- het aanmaken

- Op dit moment

- Klanten

- douane

- Dallas

- gegevens

- data punten

- Datum

- verlagen

- toegewijd aan

- deep

- diepgaand leren

- diepere

- Standaard

- bepalen

- Mate

- delven

- Democratiserend

- demonstreert

- Afhankelijk

- implementeren

- ingezet

- het inzetten

- inzet

- implementaties

- beschreven

- Design

- gewenste

- detail

- gegevens

- Bepalen

- Ontwikkeling

- anders

- moeilijk

- verdeeld

- distributed computing

- do

- domeinen

- Dont

- beneden

- gedurende

- dynamisch

- elk

- gemakkelijk

- effect

- doeltreffendheid

- efficiënt

- inspanningen

- in staat stellen

- ingeschakeld

- maakt

- aanmoedigen

- Endpoint

- ingenieur

- Engineering

- verzekeren

- Enterprise

- bedrijven

- entiteit

- gelijk

- Nederlands

- voorbeeld

- verwachten

- ervaring

- Ervaringen

- Verken

- Verkennen

- verlengen

- familie

- Kenmerk

- Voordelen

- veld-

- VIND DE PLEK DIE PERFECT VOOR JOU IS

- Voornaam*

- Flexibiliteit

- richt

- volgend

- Voor

- Foundation

- vier

- Gratis

- vrienden

- oppompen van

- geheel

- Bovendien

- toekomst

- krijgen

- gif

- GitHub

- Geven

- gegeven

- geeft

- doel

- GPU

- GPU's

- korrelig

- leiding

- Helft

- handvat

- handen

- Hardware

- Hebben

- he

- hulp

- het helpen van

- helpt

- haar

- Hoge

- high-level

- hem

- zijn

- Hit

- houdt

- gastheer

- gehost

- Hosting

- HOURS

- Hoe

- How To

- Echter

- http

- HTTPS

- Honderden

- idee

- Idle

- if

- illustreren

- beeld

- uitvoeren

- uitvoering

- belangrijk

- het verbeteren van

- in

- Anders

- Inclusief

- Laat uw omzet

- onafhankelijk

- Indië

- ondoeltreffend

- informatie

- informatietechnologie

- Infrastructuur

- eerste

- innovatieve

- innovatieve technologieën

- instantie

- verkrijgen in plaats daarvan

- Instituut

- Intelligentie

- interactieve

- belang

- in

- geïntroduceerd

- Introductie

- IT

- HAAR

- zelf

- jpg

- Houden

- houden

- sleutel

- kinderen

- Groot

- Grote ondernemingen

- tot slot

- Wachttijd

- later

- laatste

- lancering

- Leadership

- leidend

- leren

- minst

- Niveau

- als

- Lijst

- Lama

- laden

- lokaal

- gelegen

- langer

- Kijk

- op zoek

- houdt

- machine

- machine learning

- maken

- maken

- beheer

- beheerd

- management

- manager

- beheren

- veel

- meester

- master's

- Maximaliseren

- maximaal

- Mei..

- middel

- Maak kennis met

- Geheugen

- metriek

- Metriek

- trekken

- minimum

- minuut

- minuten

- ML

- MLops

- model

- modellen

- meer

- gemotiveerde

- Berg

- veel

- meervoudig

- nationaal

- NATUUR

- Noodzaak

- nodig

- behoeften

- New

- nlp

- geen

- nota

- notitieboekje

- nu

- aantal

- object

- of

- bieden

- vaak

- on

- EEN

- Slechts

- naar

- Optimaliseer

- optimaliseren

- Keuze

- or

- orkestratie

- organisaties

- Overige

- onze

- uit

- buiten

- uitgangen

- buiten

- uitstekend

- over

- totaal

- het te bezitten.

- Pakken

- Parallel

- parameter

- parameters

- bijzonder

- hartstochtelijk

- Patronen

- patronen

- voor

- prestatie

- periode

- phd

- fotografie

- plaats

- plaatsing

- plaatsen

- plan

- platform

- Plato

- Plato gegevensintelligentie

- PlatoData

- spelen

- punten

- beleidsmaatregelen door te lezen.

- beleidsmaatregelen

- mogelijk

- Post

- energie

- praktijken

- voorspellen

- Voorspelbaar

- het behoud van

- Principal

- Voorafgaand

- problemen

- Product

- product manager

- productie

- vastgoed

- zorgen voor

- mits

- biedt

- het verstrekken van

- publiceren

- hoeveelheid

- willekeurige

- reeks

- variërend

- Reageren

- reageert

- klaar

- herbalanceren

- adviseren

- verminderen

- vermindering

- verwijzen

- registreren

- verwant

- verwijderen

- het verwijderen van

- vervangen

- te vragen

- verzoeken

- vereisen

- nodig

- Voorwaarden

- vereist

- gereserveerd

- hulpbron

- Resources

- respectievelijk

- antwoord

- Rol

- rollen

- wegen

- routing

- lopen

- lopend

- runtime

- sagemaker

- SageMaker Inferentie

- dezelfde

- Bespaar

- Bespaar geld

- ervaren

- Scale

- balans

- scaling

- Wetenschap

- seconden

- zien

- op zoek naar

- senior

- verzonden

- zin

- dienen

- service

- Diensten

- serveer-

- reeks

- het instellen van

- verscheidene

- Delen

- ze

- moet

- tonen

- vertoonde

- getoond

- aanzienlijk

- Eenvoudig

- vereenvoudigd

- single

- zitten

- Maat

- kleinere

- snipper

- So

- Software

- software development

- Oplossingen

- sommige

- specialist

- specialiseert

- specifiek

- specificatie

- besteden

- Uitgaven

- aar

- spikes

- begin

- Startups

- state-of-the-art

- Status

- verblijven

- Still

- Strategie

- geslaagd

- dergelijk

- het leveren van

- ondersteuning

- steunen

- zeker

- sydney

- tafel

- Nemen

- neemt

- doelwit

- team

- TechCrunch

- Technisch

- Technologies

- Technologie

- tennis

- terminologie

- neem contact

- dat

- De

- De omgeving

- De toekomst

- hun

- Ze

- harte

- Er.

- Deze

- ze

- dit

- die

- drie

- Door

- niet de tijd of

- naar

- tools

- spoor

- traditioneel

- verkeer

- Reizend

- Trends

- leiden

- tweeling

- twee

- begrijpen

- universiteit-

- onvoorspelbaar

- bijwerken

- bijgewerkt

- Gebruik

- .

- gebruikt

- Gebruiker

- Gebruikerservaring

- gebruikers

- toepassingen

- gebruik

- doorgaans

- GMT

- gebruik maken van

- vice

- Bekijk

- visie

- bezoekers

- lopen

- walkthrough

- willen

- Afval

- Manier..

- manieren

- we

- web

- webservices

- GOED

- wanneer

- terwijl

- welke

- en

- wil

- Met

- zonder

- woorden

- Mijn werk

- werkte

- workflows

- werkzaam

- Bedrijven

- jaar

- You

- Your

- jezelf

- zephyrnet

- nul