Jeg er en stor fan av Anthony Bourdains reiseshow Ukjente deler. I hver episode besøker kokken avsidesliggende landsbyer over hele verden, og dokumenterer livene, maten og kulturene til regionale stammer med et åpent hjerte og sinn.

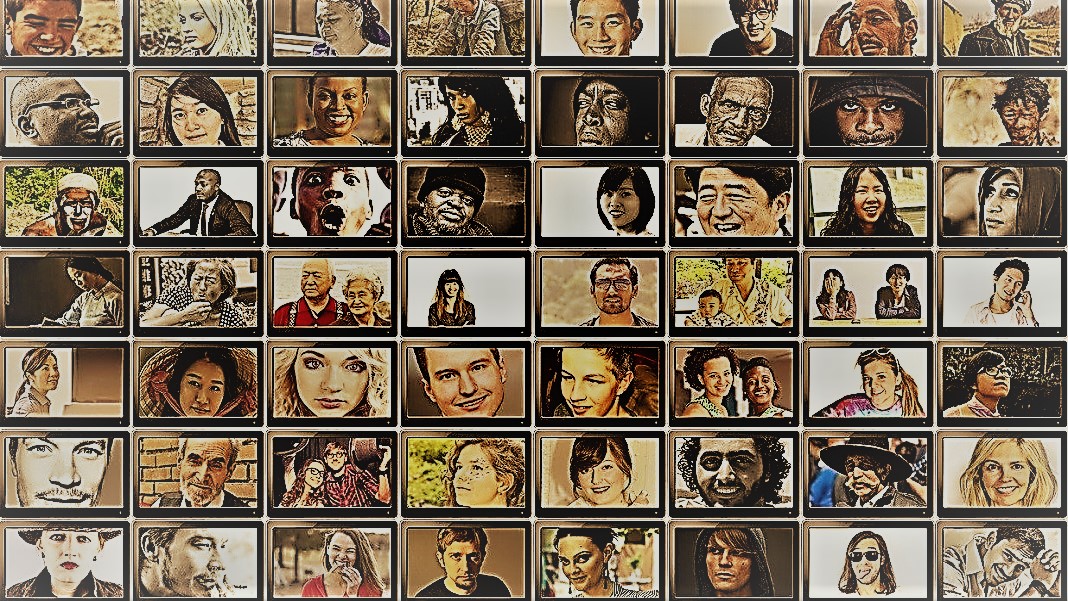

Showet gir et innblikk i menneskehetens forbløffende mangfold. Samfunnsvitere har et lignende mål – å forstå atferden til forskjellige mennesker, grupper og kulturer – men bruker en rekke metoder i kontrollerte situasjoner. For begge er stjernene i disse aktivitetene fagene: mennesker.

Men hva om du erstattet mennesker med AI chatbots?

Ideen høres absurd ut. Likevel, takket være bruken av ChatGPT og andre store språkmodeller (LLM), flørter samfunnsvitere med ideen om å bruke disse verktøyene til raskt å konstruere forskjellige grupper av "simulerte mennesker" og kjøre eksperimenter for å undersøke deres oppførsel og verdier som en proxy til sine biologiske kolleger.

Hvis du forestiller deg digitalt gjenskapte menneskesinn, er det ikke det. Ideen er å utnytte ChatGPTs ekspertise på å etterligne menneskelige svar. Fordi modellene skraper enorme mengder nettdata – blogger, Youtube-kommentarer, fanfiction, bøker – fanger de lett opp forhold mellom ord på flere språk. Disse sofistikerte algoritmene kan også dekode nyanserte aspekter av språket, som ironi, sarkasme, metaforer og emosjonelle toner, et kritisk aspekt ved menneskelig kommunikasjon i enhver kultur. Disse styrkene setter LLMs opp til å etterligne flere syntetiske personligheter med et bredt spekter av tro.

Enda en bonus? Sammenlignet med menneskelige deltakere, blir ikke ChatGPT og andre LLM-er slitne, noe som lar forskere samle inn data og teste teorier om menneskelig atferd med enestående hastighet.

Selv om ideen er kontroversiell, har den allerede støtte. En fersk artikkel gjennomgang av det begynnende feltet fant at i visse nøye utformede scenarier, var ChatGPTs svar korrelert med svarene til omtrent 95 prosent av menneskelige deltakere.

AI "kan endre spillet for samfunnsvitenskapelig forskning," sa Dr. Igor Grossman ved University of Waterloo, som sammen med sine kolleger nylig skrev en artikkel om et blikk fremover i Vitenskap. Nøkkelen for bruk Homo silicus i forskning? Forsiktig bias management og data troskap, sa teamet.

Undersøke det menneskelige samfunnssinnet

Hva er egentlig samfunnsvitenskap?

Enkelt sagt, det er å studere hvordan mennesker – enten som individer eller som en gruppe – oppfører seg under forskjellige omstendigheter, hvordan de samhandler med hverandre og utvikler seg som en kultur. Det er en paraply av akademisk aktivitet med flere grener: økonomi, statsvitenskap, antropologi og psykologi.

Disiplinen tar for seg et bredt spekter av temaer som er fremtredende i dagens tidsånd. Hva er effekten av sosiale medier på mental helse? Hva er nåværende offentlige holdninger til klimaendringer når alvorlige værepisoder øker? Hvordan verdsetter ulike kulturer kommunikasjonsmetoder – og hva utløser misforståelser?

Et samfunnsvitenskapelig studium starter med et spørsmål og en hypotese. En av mine favoritter: tolererer kulturer kroppslukt annerledes? (Tuller ikke, emnet har blitt studert ganske mye, og ja, det er en forskjell!)

Forskere bruker deretter en rekke metoder, som spørreskjemaer, atferdstester, observasjon og modellering for å teste ideene deres. Spørreundersøkelser er et spesielt populært verktøy, fordi spørsmålene kan utformes og undersøkes strengt og enkelt nå et bredt spekter av mennesker når de distribueres på nettet. Forskere analyserer deretter skriftlige svar og henter innsikt i menneskelig atferd. Med andre ord er en deltakers bruk av språk avgjørende for disse studiene.

Så hvordan passer ChatGPT inn?

"Homo Silicus"

For Grossman representerer LLM-ene bak chatbots som ChatGPT eller Googles Bard en enestående mulighet til å redesigne samfunnsvitenskapelige eksperimenter.

Fordi de er trent på massive datasett, kan LLM-er "representere et stort utvalg av menneskelige erfaringer og perspektiver," sa forfatterne. Fordi modellene «strammer rundt» fritt uten grenser over internett – som folk som ofte reiser internasjonalt – kan de ta i bruk og vise et bredere spekter av svar sammenlignet med rekrutterte menneskelige subjekter.

ChatGPT blir heller ikke påvirket av andre medlemmer av en studie eller blir sliten, noe som muligens lar den generere mindre partiske svar. Disse egenskapene kan være spesielt nyttige i "høyrisikoprosjekter" - for eksempel ved å etterligne svarene til mennesker som bor i land i krig eller under vanskelige regimer gjennom innlegg på sosiale medier. På sin side kan svarene informere om intervensjoner i den virkelige verden.

På samme måte kan LLM-er som er trent på kulturelle varme emner som kjønnsidentitet eller feilinformasjon reprodusere forskjellige teoretiske eller ideologiske tankeganger for å informere politikk. I stedet for møysommelig å spørre hundretusenvis av menneskelige deltakere, kan AI raskt generere svar basert på nettbasert diskurs.

Bortsett fra potensielle virkelige bruksområder, kan LLM-er også fungere som digitale emner som samhandler med menneskelige deltakere i samfunnsvitenskapelige eksperimenter, noe som ligner på ikke-spillerfigurer (NPC) i videospill. For eksempel kan LLM adoptere forskjellige "personligheter" og samhandle med menneskelige frivillige over hele verden online ved å bruke tekst ved å stille dem det samme spørsmålet. Fordi algoritmer ikke sover, kan den kjøre 24/7. De resulterende dataene kan da hjelpe forskere med å utforske hvordan ulike kulturer vurderer lignende informasjon og hvordan meninger – og feilinformasjon – spres.

Baby trinn

Ideen om å bruke chatbots i stedet for mennesker i studier er ennå ikke mainstream.

Men det er tidlige bevis på at det kan fungere. EN fortrykkstudie utgitt denne måneden fra Georgia Tech, Microsoft Research og Olin College fant at en LLM replikerte menneskelige svar i en rekke klassiske psykologiske eksperimenter, inkludert den beryktede Milgram sjokkeksperimenter.

Likevel gjenstår et kritisk spørsmål: hvor godt kan disse modellene virkelig fange et menneskes respons?

Det er flere snublesteiner.

Først er kvaliteten på algoritmen og treningsdataene. Det meste av nettinnhold domineres av bare en håndfull språk. En LLM trent på disse dataene kan lett etterligne følelsen, perspektivet eller til og med moralsk dømmekraft til folk som bruker disse språkene – i sin tur arve skjevhet fra treningsdataene.

"Denne skjevhetsreproduksjonen er en stor bekymring fordi den kan forsterke selve forskjellene samfunnsvitere streber etter å avdekke i sin forskning," sa Grossman.

Noen forskere bekymrer seg også for at LLM-er er rettferdige oppstøtende hva de blir fortalt. Det er antitesen til en samfunnsvitenskapelig studie, der hovedpoenget er å fange menneskeheten i all dens mangfoldige og komplekse skjønnhet. På den annen side er ChatGPT og lignende modeller kjent for å "hallusinere,” som lager informasjon som høres plausibel ut, men som er falsk.

For nå er "store språkmodeller avhengige av 'skygger' av menneskelige erfaringer," sa Grossman. Fordi disse AI-systemene stort sett er svarte bokser, er det vanskelig å forstå hvordan eller hvorfor de genererer visse responser – litt urovekkende når de bruker dem som menneskelige proxyer i atferdseksperimenter.

Til tross for begrensninger tillater "LLMs samfunnsvitere å bryte fra tradisjonelle forskningsmetoder og nærme seg arbeidet deres på innovative måter," sa forfatterne. Som et første skritt kan Homo silicus hjelpe med idédugnad og raskt teste hypoteser, med lovende hypoteser som blir ytterligere validert i menneskelige populasjoner.

Men for at samfunnsvitenskapen virkelig skal ønske AI velkommen, må det være åpenhet, rettferdighet og lik tilgang til disse kraftige systemene. LLM-er er vanskelige og dyre å trene, med nyere modeller i økende grad stengt bak heftige betalingsmurer.

"Vi må sikre at samfunnsvitenskapelige LLM-er, som alle vitenskapelige modeller, er åpen kildekode, noe som betyr at deres algoritmer og ideelt sett data er tilgjengelige for alle å granske, teste og modifisere," sa studieforfatter Dr. Dawn Parker ved University of Waterloo. "Bare ved å opprettholde åpenhet og replikerbarhet kan vi sikre at AI-assistert samfunnsvitenskapelig forskning virkelig bidrar til vår forståelse av menneskelig erfaring."

Bilde Credit: Gerd Altmann / Pixabay

- SEO-drevet innhold og PR-distribusjon. Bli forsterket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk deg selv. Tilgang her.

- PlatoAiStream. Web3 Intelligence. Kunnskap forsterket. Tilgang her.

- PlatoESG. Bil / elbiler, Karbon, CleanTech, Energi, Miljø, Solenergi, Avfallshåndtering. Tilgang her.

- BlockOffsets. Modernisering av eierskap for miljøkompensasjon. Tilgang her.

- kilde: https://singularityhub.com/2023/07/25/chatgpt-is-replacing-humans-in-studies-on-human-behavior-and-its-working-surprisingly-well/

- : har

- :er

- :ikke

- $OPP

- 23

- a

- Om oss

- akademisk

- adgang

- tvers

- Handling

- adoptere

- advent

- AI

- algoritme

- algoritmer

- Alle

- tillate

- tillate

- allerede

- også

- beløp

- an

- analysere

- og

- Anthony

- tilnærming

- ER

- Arizona

- Array

- Artikkel

- AS

- aspektet

- aspekter

- At

- forfatter

- forfattere

- tilgjengelig

- basert

- BE

- Beauty

- fordi

- vært

- atferd

- bak

- være

- tro

- mellom

- Bias

- forutinntatt

- Bit

- Svart

- Blocks

- kroppen

- Bonus

- grenser

- både

- bokser

- brainstorm

- grener

- Break

- men

- by

- CAN

- fangst

- forsiktig

- viss

- endring

- tegn

- chatbots

- ChatGPT

- omstendigheter

- Klima

- Klima forandringer

- kollegaer

- samle

- Høyskole

- kommentarer

- Kommunikasjon

- sammenlignet

- komplekse

- Bekymring

- konstruere

- innhold

- bidrar

- kontrolleres

- kontroversiell

- kunne

- land

- kreditt

- kritisk

- kritisk aspekt

- kulturell

- Kultur

- Gjeldende

- dato

- datasett

- designet

- utvikle

- forskjellig

- vanskelig

- digitalt

- digitalt

- Vise

- distribueres

- diverse

- Mangfold

- do

- gjør

- ikke

- ikke

- dr

- tegne

- hver enkelt

- Tidlig

- lett

- Økonomi

- enorm

- sikre

- episode

- lik

- spesielt

- evaluere

- Selv

- Hver

- nøyaktig

- eksempel

- dyrt

- erfaring

- Erfaringer

- eksperimenter

- ekspertise

- utforske

- rettferdighet

- falsk

- vifte

- Fiction

- fidelity

- felt

- Først

- passer

- mat

- Til

- funnet

- fra

- videre

- spill

- Games

- Kjønn

- generere

- Georgia

- få

- Glimpse

- globus

- Googles

- Gruppens

- hånd

- håndfull

- Ha

- Helse

- Hjerte

- hjelpe

- HOT

- Hvordan

- HTML

- http

- HTTPS

- stort

- menneskelig

- Menneskelig erfaring

- Menneskeheten

- Mennesker

- Hundrevis

- Tanken

- ideelt sett

- Ideer

- Identitet

- if

- Påvirkning

- in

- I andre

- Inkludert

- Øke

- stadig

- individer

- beryktet

- påvirket

- informere

- informasjon

- innovative

- innsikt

- samhandle

- inn

- ironi

- IT

- DET ER

- jpg

- bare

- nøkkel

- kjent

- Språk

- språk

- stor

- i stor grad

- mindre

- i likhet med

- begrensninger

- Bor

- levende

- LLM

- Hoved

- Mainstream

- Vedlike

- større

- Making

- ledelse

- massive

- Kan..

- betyr

- Media

- medlemmer

- mental

- Mental Helse

- metoder

- Microsoft

- tankene

- sinn

- feil~~POS=TRUNC

- modellering

- modeller

- modifisere

- Måned

- moralsk

- mest

- flere

- må

- my

- begynnende

- Trenger

- Nei.

- nå

- mange

- of

- ofte

- on

- ONE

- seg

- på nett

- åpen

- åpen kildekode

- Opportunity

- or

- Annen

- vår

- deltakere

- Ansatte

- prosent

- Personligheter

- perspektiv

- prospektet

- plato

- Platon Data Intelligence

- PlatonData

- plausibel

- Point

- Politikk

- politisk

- Populær

- populasjoner

- innlegg

- potensielt

- kraftig

- probe

- fremtredende

- lovende

- bevis

- gir

- proxy

- Psykologi

- offentlig

- forfølgelse

- kvalitet

- spørsmål

- spørsmål

- område

- raskt

- heller

- å nå

- virkelige verden

- virkelig

- nylig

- nylig

- redesign

- dietter

- regional

- Relasjoner

- utgitt

- avhengige

- forblir

- fjernkontroll

- erstattet

- replikerbarhet

- replikert

- representere

- reproduksjon

- forskning

- svar

- svar

- resulterende

- omtrent

- Kjør

- Sa

- samme

- scenarier

- Skoler

- Vitenskap

- VITENSKAPER

- vitenskapelig

- forskere

- sentiment

- sett

- flere

- alvorlig

- Vis

- lignende

- ganske enkelt

- situasjoner

- sove

- selskap

- sosiale medier

- Sosiale medier innlegg

- samfunnsmessig

- noe

- sofistikert

- fart

- Stjerner

- starter

- Trinn

- styrker

- streber

- studier

- Studer

- Studerer

- snuble

- slik

- støtte

- syntetisk

- Systemer

- takler

- Pek

- lag

- tech

- test

- tester

- enn

- Takk

- Det

- De

- deres

- Dem

- deretter

- teoretiske

- Der.

- Disse

- de

- denne

- De

- selv om?

- trodde

- tusener

- Gjennom

- trøtt

- til

- verktøy

- verktøy

- temaer

- mot

- tradisjonelle

- Tog

- trent

- Kurs

- Åpenhet

- reiser

- plagsom

- virkelig

- SVING

- paraply

- avdekke

- etter

- forstå

- forståelse

- universitet

- enestående

- bruke

- bruker

- ved hjelp av

- validert

- verdi

- Verdier

- variasjon

- enorme

- veldig

- undersøkt

- video

- videospill

- Besøk

- frivillige

- krig

- måter

- we

- Vær

- velkommen

- VI VIL

- Hva

- når

- hvilken

- HVEM

- hvorfor

- bred

- Bred rekkevidde

- bredere

- Wikipedia

- vil

- med

- uten

- ord

- Arbeid

- virker

- bekymring

- skrevet

- ja

- ennå

- Du

- youtube

- zeitgeist

- zephyrnet