I dette innlegget viser vi hvordan du trener, distribuerer og forutsier skader på naturkatastrofer med Amazon SageMaker med geospatiale muligheter. Vi bruker de nye SageMaker geospatiale egenskapene til å generere nye slutningsdata for å teste modellen. Mange offentlige og humanitære organisasjoner trenger rask og nøyaktig situasjonsforståelse når en katastrofe inntreffer. Å kjenne alvorlighetsgraden, årsaken og plasseringen av skaden kan hjelpe til med den første responderens responsstrategi og beslutningstaking. Mangelen på nøyaktig og rettidig informasjon kan bidra til en ufullstendig eller feilrettet hjelpeinnsats.

Ettersom frekvensen og alvorlighetsgraden av naturkatastrofer øker, er det viktig at vi utstyrer beslutningstakere og førstehjelpere med rask og nøyaktig skadevurdering. I dette eksemplet bruker vi geospatiale bilder for å forutsi skader på naturkatastrofer. Geospatiale data kan brukes i umiddelbar etterkant av en naturkatastrofe for raskt å identifisere skader på bygninger, veier eller annen kritisk infrastruktur. I dette innlegget viser vi deg hvordan du trener og distribuerer en geospatial segmenteringsmodell som skal brukes til klassifisering av katastrofeskader. Vi deler applikasjonen inn i tre emner: modelltrening, modelldistribusjon og slutning.

Modelltrening

I dette tilfellet bygde vi en tilpasset PyTorch-modell ved hjelp av Amazon SageMaker for bildesegmentering av bygningsskader. De geospatiale egenskapene i SageMaker inkluderer opplærte modeller som du kan bruke. Disse innebygde modellene inkluderer skysegmentering og fjerning, og landdekkesegmentering. For dette innlegget trener vi en tilpasset modell for skadesegmentering. Vi trente først SegFormer-modellen på data fra xView2-konkurransen. SegFormer er en transformatorbasert arkitektur som ble introdusert i 2021-avisen SegFormer: Enkel og effektiv design for semantisk segmentering med transformatorer. Den er basert på transformatorarkitekturene som er ganske populære med arbeidsbelastninger for naturlig språkbehandling; Imidlertid er SegFormer-arkitekturen bygget for semantisk segmentering. Den kombinerer både den transformatorbaserte koderen og en lettvektsdekoder. Dette gir bedre ytelse enn tidligere metoder, samtidig som det gir betydelig mindre modellstørrelser enn tidligere metoder. Både forhåndstrente og utrente SegFormer-modeller er tilgjengelige fra det populære transformatorbiblioteket Hugging Face. For denne brukssaken laster vi ned en forhåndstrent SegFormer-arkitektur og trener den på et nytt datasett.

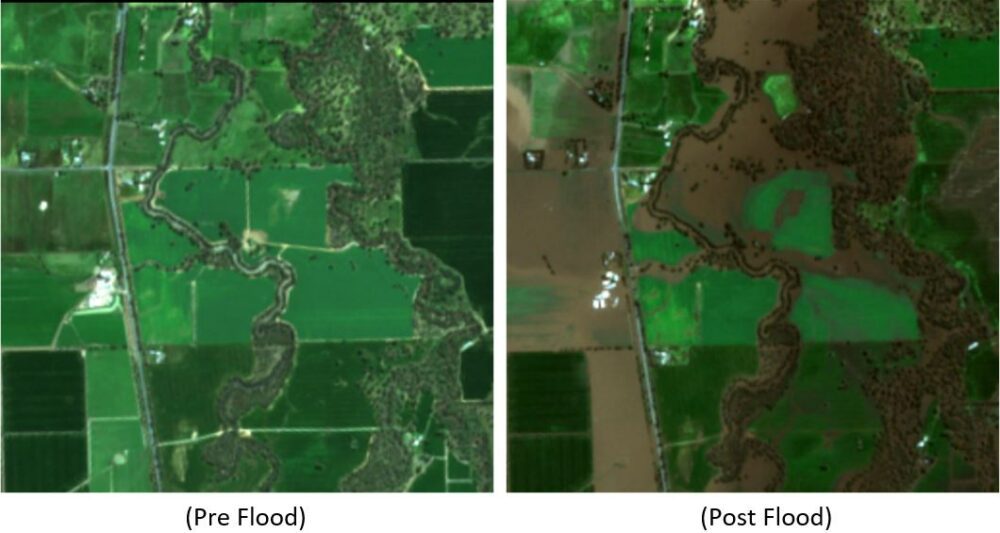

Datasettet som brukes i dette eksemplet kommer fra xView2 datavitenskapskonkurranse. Denne konkurransen ga ut xBD datasett, et av de største og høyeste offentlig tilgjengelige datasettene med høyoppløselige satellittbilder annotert med bygningens plassering og skadescore (klasser) før og etter naturkatastrofer. Datasettet inneholder data fra 15 land, inkludert 6 typer katastrofer (jordskjelv/tsunami, flom, vulkanutbrudd, skogbrann, vind) med geospatiale data som inneholder 850,736 45,362 bygningsanmerkninger over 2 XNUMX km^XNUMX med bilder. Følgende bilde viser et eksempel på datasettet. Dette bildet viser bildet etter en katastrofe med segmenteringsmasken for bygningsskader lagt over. Hvert bilde inkluderer følgende: satellittbilde før katastrofe, bygningssegmenteringsmaske før katastrofe, satellittbilde etter katastrofe og bygningssegmenteringsmaske etter katastrofe med skadeklasser.

I dette eksemplet bruker vi bare bilder før og etter katastrofe for å forutsi skadeklassifiseringen etter katastrofe (segmenteringsmaske). Vi bruker ikke segmenteringsmaskene før katastrofen. Denne tilnærmingen ble valgt for enkelhets skyld. Det finnes andre alternativer for å nærme seg dette datasettet. En rekke av de vinnende tilnærmingene for xView2-konkurransen brukte en to-trinns løsning: For det første, forutsi segmenteringsmasken for bygningen før katastrofen. Bygningskonturene og etterskadebildene brukes så som input for å forutsi skadeklassifiseringen. Vi overlater dette til leseren for å utforske andre modelleringsmetoder for å forbedre klassifisering og deteksjonsytelse.

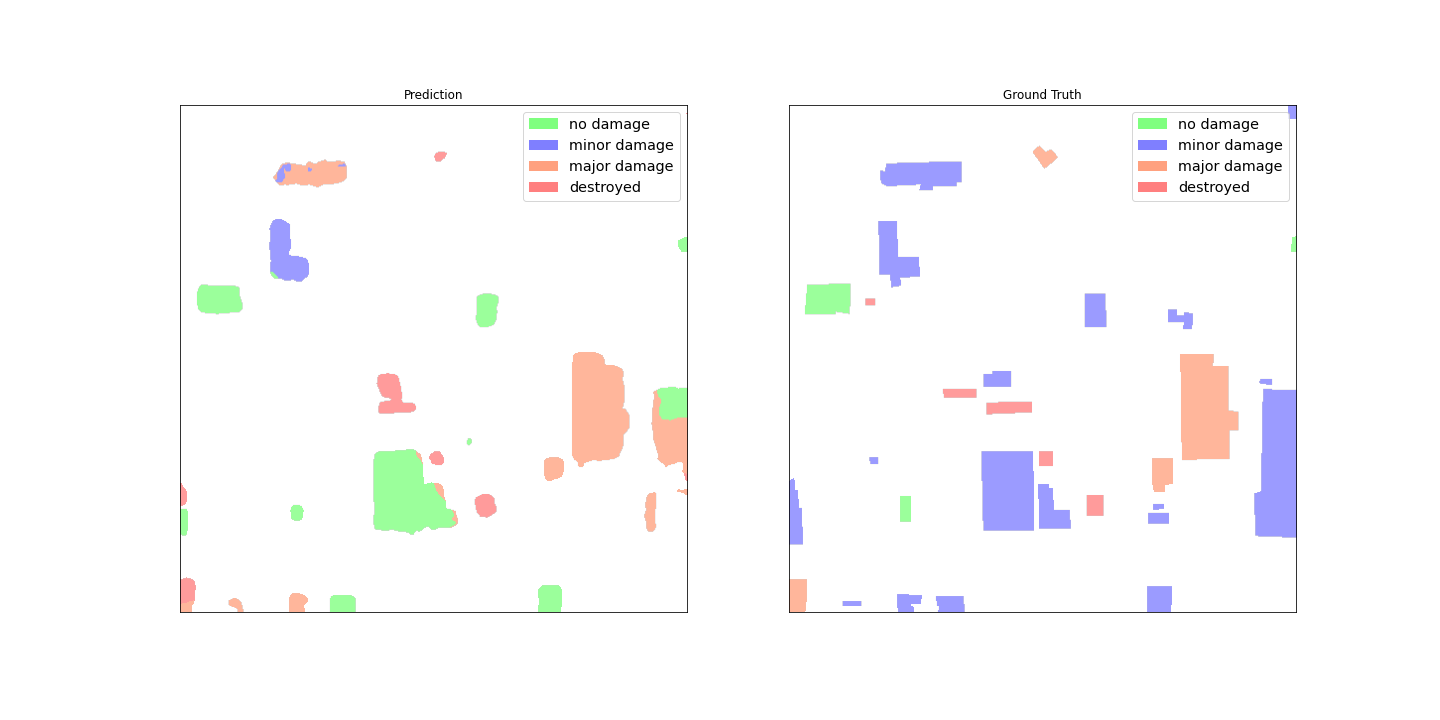

Den ferdigtrente SegFormer-arkitekturen er bygget for å akseptere et enkelt trefarget kanalbilde som input og sender ut en segmenteringsmaske. Det er en rekke måter vi kunne ha modifisert modellen for å akseptere både før- og post-satellittbildene som input, men vi brukte en enkel stableteknikk for å stable begge bildene sammen til et seksfarget kanalbilde. Vi trente modellen ved å bruke standard forstørrelsesteknikker på xView2 treningsdatasettet for å forutsi segmenteringsmasken etter katastrofe. Merk at vi endret størrelsen på alle inndatabildene fra 1024 til 512 piksler. Dette var for å ytterligere redusere romlig oppløsning av treningsdataene. Modellen ble trent med SageMaker ved å bruke en enkelt p3.2xlarge GPU-basert instans. Et eksempel på den trente modellens utgang er vist i de følgende figurene. Det første settet med bilder er bildene før og etter skade fra valideringssettet.

De følgende figurene viser den forutsagte skademasken og jordsannhetsskademasken.

Ved første øyekast ser det ut til at modellen ikke gir gode resultater sammenlignet med sannhetsdataene. Mange av bygningene er feilklassifisert, forvirrende mindre skader uten skade og viser flere klassifiseringer for en enkelt bygningskontur. Et interessant funn ved gjennomgang av modellens ytelse er imidlertid at den ser ut til å ha lært å lokalisere byggeskadeklassifiseringen. Hver bygning kan klassifiseres i No Damage, Minor Damage, Major Damageeller Destroyed. Den spådde skademasken viser at modellen har klassifisert den store bygningen i midten til det meste No Damage, men øverste høyre hjørne er klassifisert som Destroyed. Denne skadelokaliseringen i underbygningen kan hjelpe hjelpepersonell ytterligere ved å vise de lokaliserte skadene per bygning.

Modellutplassering

Den trente modellen ble deretter distribuert til et asynkront SageMaker-slutningsendepunkt. Merk at vi valgte et asynkront endepunkt for å tillate lengre inferenstider, større nyttelastinndata og muligheten til å skalere endepunktet ned til null forekomster (ingen kostnader) når det ikke er i bruk. Følgende figur viser høynivåkoden for asynkron endepunktdistribusjon. Vi komprimerer først den lagrede PyTorch-tilstandsordboken og laster opp de komprimerte modellartefaktene til Amazon enkel lagringstjeneste (Amazon S3). Vi lager en SageMaker PyTorch-modell som peker på vår slutningskode og modellartefakter. Inferenskoden kreves for å laste og betjene modellen vår. For mer informasjon om den nødvendige tilpassede slutningskoden for en SageMaker PyTorch-modell, se Bruk PyTorch med SageMaker Python SDK.

Følgende figur viser koden for den automatiske skaleringspolicyen for det asynkrone inferensendepunktet.

Merk at det er andre endepunktalternativer, for eksempel sanntid, batch og serverløs, som kan brukes for applikasjonen din. Du bør velge alternativet som er best egnet for brukstilfellet og huske det Amazon SageMaker Inference Recommender er tilgjengelig for å anbefale endepunktkonfigurasjoner for maskinlæring (ML).

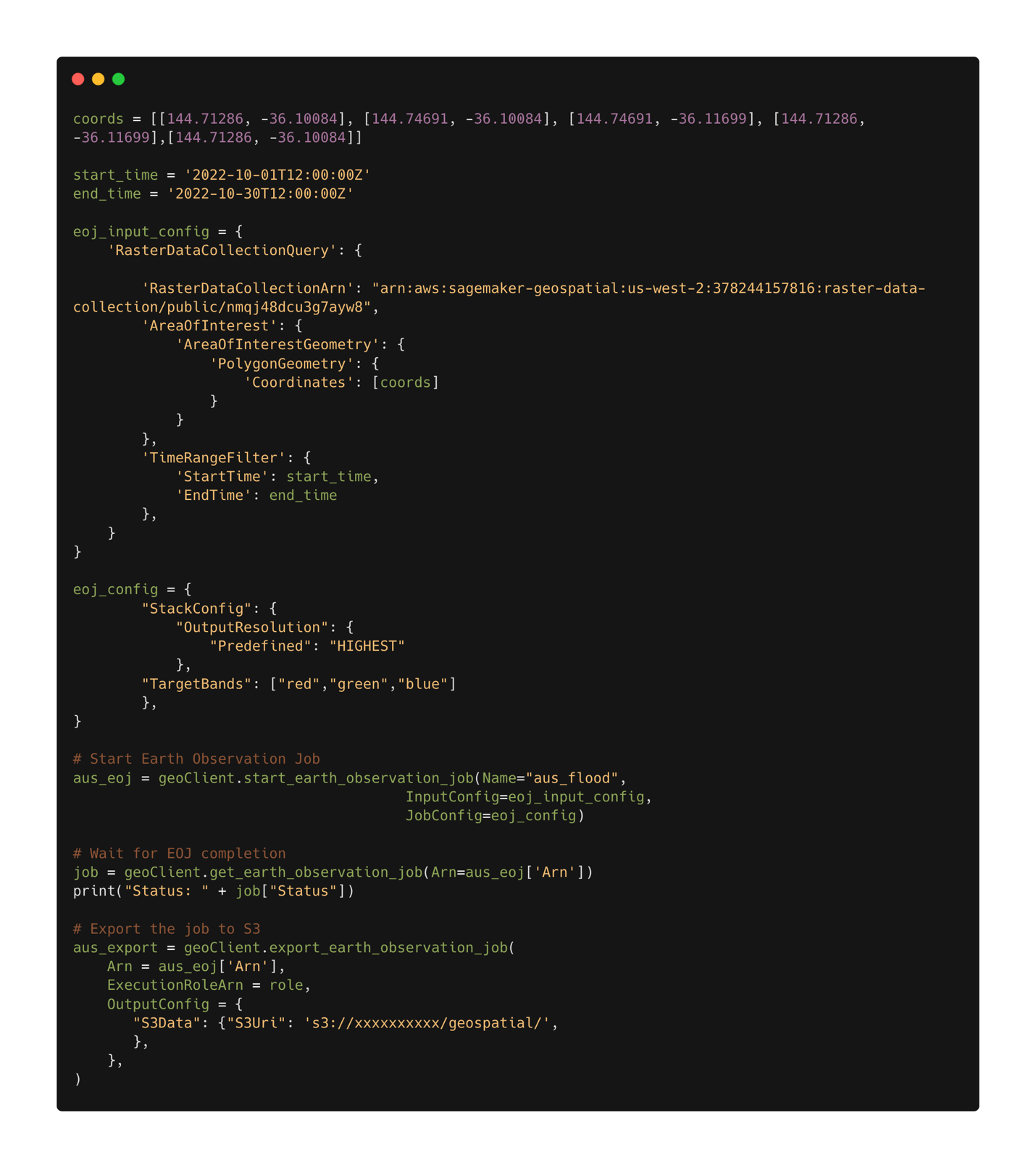

Modellslutning

Med den trente modellen utplassert, kan vi nå bruke SageMaker geospatiale muligheter å samle data for slutning. Med SageMaker geospatiale muligheter er flere innebygde modeller tilgjengelige ut av esken. I dette eksemplet bruker vi båndstablingsoperasjonen for å stable de røde, grønne og blå fargekanalene for vår jordobservasjonsjobb. Jobben samler dataene fra Sentinel-2-datasettet. For å konfigurere en jordobservasjonsjobb trenger vi først koordinatene til stedet av interesse. For det andre trenger vi tidsrommet for observasjonen. Med dette kan vi nå sende inn en jordobservasjonsjobb ved å bruke stablefunksjonen. Her stabler vi de røde, grønne og blå båndene for å produsere et fargebilde. Følgende figur viser jobbkonfigurasjonen som ble brukt til å generere data fra flommene i Rochester, Australia, i midten av oktober 2022. Vi bruker bilder fra før og etter katastrofen som input til vår trente ML-modell.

Etter at jobbkonfigurasjonen er definert, kan vi sende inn jobben. Når jobben er fullført, eksporterer vi resultatene til Amazon S3. Merk at vi kun kan eksportere resultatene etter at jobben er fullført. Resultatene av jobben kan eksporteres til et Amazon S3-sted spesifisert av brukeren i eksportjobbkonfigurasjonen. Nå med våre nye data i Amazon S3, kan vi få skadeforutsigelser ved å bruke den utplasserte modellen. Vi leser først dataene inn i minnet og stabler bildene før og etter katastrofe sammen.

Resultatene av segmenteringsmasken for Rochester-flommene er vist i de følgende bildene. Her kan vi se at modellen har identifisert steder innenfor det oversvømte området som sannsynlig skadet. Merk også at den romlige oppløsningen til inferensbildet er annerledes enn treningsdataene. Å øke den romlige oppløsningen kan hjelpe modellytelsen; Dette er imidlertid mindre et problem for SegFormer-modellen som for andre modeller på grunn av flerskalamodellarkitekturen.

konklusjonen

I dette innlegget viste vi hvordan du trener, distribuerer og forutsier skader på naturkatastrofer med SageMaker med geospatiale muligheter. Vi brukte de nye SageMaker geospatiale evnene til å generere nye slutningsdata for å teste modellen. Koden for dette innlegget er i ferd med å bli utgitt, og dette innlegget vil bli oppdatert med lenker til hele opplærings-, distribusjons- og slutningskoden. Denne applikasjonen gjør det mulig for førstehjelpere, regjeringer og humanitære organisasjoner å optimalisere responsen, og gi kritisk situasjonsbevissthet umiddelbart etter en naturkatastrofe. Denne applikasjonen er bare ett eksempel på hva som er mulig med moderne ML-verktøy som SageMaker.

Prøv SageMaker geospatiale evner i dag ved å bruke dine egne modeller; vi ser frem til å se hva du bygger videre.

Om forfatteren

Aaron Sengstacken er en løsningsarkitekt for maskinlæring hos Amazon Web Services. Aaron jobber tett med offentlige kunder i alle størrelser for å utvikle og distribuere produksjonsmaskinlæringsapplikasjoner. Han er interessert i alt som har med maskinlæring, teknologi og romutforskning å gjøre.

Aaron Sengstacken er en løsningsarkitekt for maskinlæring hos Amazon Web Services. Aaron jobber tett med offentlige kunder i alle størrelser for å utvikle og distribuere produksjonsmaskinlæringsapplikasjoner. Han er interessert i alt som har med maskinlæring, teknologi og romutforskning å gjøre.

- Avansert (300)

- AI

- ai kunst

- ai art generator

- du har en robot

- Amazon SageMaker

- Amazon SageMaker geospatial

- kunstig intelligens

- sertifisering av kunstig intelligens

- kunstig intelligens i bankvirksomhet

- kunstig intelligens robot

- kunstig intelligens roboter

- programvare for kunstig intelligens

- AWS maskinlæring

- blockchain

- blockchain konferanse ai

- coingenius

- samtale kunstig intelligens

- kryptokonferanse ai

- dall sin

- dyp læring

- Geospatial ML

- google det

- maskinlæring

- plato

- plato ai

- Platon Data Intelligence

- Platon spill

- PlatonData

- platogaming

- skala ai

- syntaks

- zephyrnet