Deteksjon av skjevheter i data og modellresultater er et grunnleggende krav for å bygge modeller for ansvarlig kunstig intelligens (AI) og maskinlæring (ML). Dessverre er det ikke en lett oppgave å oppdage skjevhet for det store flertallet av utøvere på grunn av det store antallet måter det kan måles på og ulike faktorer som kan bidra til et skjevt utfall. For eksempel kan en ubalansert prøvetaking av treningsdataene resultere i en modell som er mindre nøyaktig for visse delmengder av dataene. Bias kan også introduseres av selve ML-algoritmen - selv med et velbalansert treningsdatasett, kan resultatene favorisere visse delsett av dataene sammenlignet med de andre.

For å oppdage skjevhet må du ha en grundig forståelse av ulike typer skjevheter og tilsvarende skjevhetsmålinger. For eksempel, når dette skrives, Amazon SageMaker Clarify tilbyr 21 forskjellige beregninger å velge mellom.

I dette innlegget bruker vi et brukstilfelle for inntektsprediksjon (forutsi brukerinntekter fra inputfunksjoner som utdanning og antall timer jobbet per uke) for å demonstrere forskjellige typer skjevheter og de tilsvarende beregningene i SageMaker Clarify. Vi utvikler også et rammeverk for å hjelpe deg med å bestemme hvilke beregninger som betyr noe for applikasjonen din.

Introduksjon til SageMaker Clarify

ML-modeller blir i økende grad brukt for å ta beslutninger på tvers av en rekke domener, for eksempel finansielle tjenester, helsetjenester, utdanning og menneskelige ressurser. I mange situasjoner er det viktig å forstå hvorfor ML-modellen gjorde en spesifikk prediksjon, og også om spådommene ble påvirket av skjevhet.

SageMaker Clarify gir verktøy for begge disse behovene, men i dette innlegget fokuserer vi kun på funksjonaliteten for skjevhetsdeteksjon. For å lære mer om forklarbarhet, sjekk ut Forklare fakta om Bundesliga-kamp xGoals ved hjelp av Amazon SageMaker Clarify.

SageMaker Clarify er en del av Amazon SageMaker, som er en fullstendig administrert tjeneste for å bygge, trene og distribuere ML-modeller.

Eksempler på spørsmål om skjevhet

Som grunnlag for diskusjonen er følgende eksempler på spørsmål som ML-byggere og deres interessenter kan ha angående skjevhet. Listen består av noen generelle spørsmål som kan være relevante for flere ML-applikasjoner, samt spørsmål om spesifikke applikasjoner som dokumentinnhenting.

Du kan spørre, gitt gruppene som er interessert i treningsdataene (for eksempel menn vs. kvinner) hvilke beregninger jeg skal bruke for å svare på følgende spørsmål:

- Gjenspeiler grupperepresentasjonen i treningsdataene den virkelige verden?

- Gir måletikettene i treningsdataene en gruppe fremfor den andre ved å gi den mer positive etiketter?

- Har modellen ulik nøyaktighet for ulike grupper?

- I en modell som har som formål å identifisere kvalifiserte kandidater for ansettelse, har modellen samme presisjon for ulike grupper?

- I en modell som har som formål å hente dokumenter som er relevante for en inndataspørring, henter modellen relevante dokumenter fra ulike grupper i samme andel?

I resten av dette innlegget utvikler vi et rammeverk for hvordan du kan vurdere å svare på disse spørsmålene og andre gjennom beregningene som er tilgjengelige i SageMaker Clarify.

Bruk case og kontekst

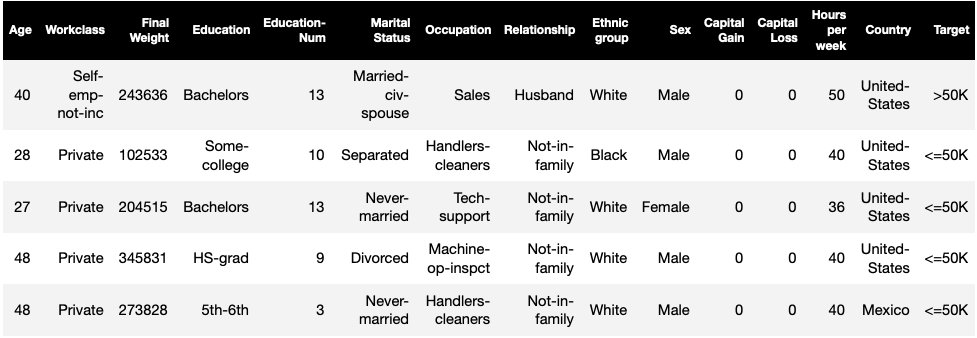

Dette innlegget bruker et eksisterende eksempel på en SageMaker Clarify-jobb fra Rettferdighet og forklaring med SageMaker Clarify notatbok og forklarer de genererte bias-metriske verdiene. Den bærbare trener en XGBoost-modell på UCI voksen datasett (Dua, D. og Graff, C. (2019). UCI Machine Learning Repository. Irvine, CA: University of California, School of Information and Computer Science).

ML-oppgaven i dette datasettet er å forutsi om en person har en årlig inntekt på mer eller mindre enn $50,000 XNUMX. Tabellen nedenfor viser noen tilfeller sammen med funksjonene deres. Å måle skjevhet i inntektsprediksjon er viktig fordi vi kan bruke disse spådommene til å informere beslutninger som rabatttilbud og målrettet markedsføring.

Bias terminologi

Før vi dykker dypere, la oss gå gjennom noen viktige terminologier. For en fullstendig liste over termer, se Amazon SageMaker klargjør vilkår for skjevhet og rettferdighet.

- Etiketten – Målfunksjonen som ML-modellen er opplært til å forutsi. An observert etikett refererer til merkeverdien observert i dataene som brukes til å trene eller teste modellen. EN spådd etikett er verdien forutsagt av ML-modellen. Etiketter kan være binære, og er ofte kodet som 0 og 1. Vi antar at 1 representerer en gunstig eller positiv etikett (for eksempel inntekt mer enn eller lik $50,000 0), og XNUMX representerer en ugunstig eller negativ etikett. Etiketter kan også bestå av mer enn to verdier. Selv i disse tilfellene utgjør en eller flere av verdiene gunstige merkelapper. For enkelhets skyld tar dette innlegget kun i betraktning binære etiketter. For detaljer om håndtering av etiketter med mer enn to verdier og etiketter med kontinuerlige verdier (for eksempel i regresjon), se Whitepaper for Amazon AI rettferdighet og forklaring.

- fasett – En kolonne eller funksjon som bias måles i forhold til. I vårt eksempel er fasetten

sexog tar to verdier:womanogman, kodet somfemaleogmalei dataene (disse dataene er hentet fra 1994 Census og håndhever et binært alternativ). Selv om innlegget vurderer en enkelt fasett med bare to verdier, for mer komplekse saker som involverer flere fasetter eller fasetter med mer enn to verdier, se Whitepaper for Amazon AI rettferdighet og forklaring. - Bias – En betydelig ubalanse i inputdata eller modellprediksjoner på tvers av ulike fasettverdier. Hva som er "betydelig" avhenger av søknaden din. For de fleste beregninger innebærer en verdi på 0 ingen ubalanse. Bias-beregninger i SageMaker Clarify er delt inn i to kategorier:

- Foropplæring – Når det er tilstede, indikerer pretraining bias kun ubalanse i dataene.

- Ettertrening – Bias etter trening vurderer i tillegg spådommene til modellene.

La oss undersøke hver kategori separat.

Pretraining bias

Pretraining bias-metrikker i SageMaker Klargjør svar på følgende spørsmål: Har alle fasettverdier lik (eller lignende) representasjon i dataene? Det er viktig å inspisere dataene for skjevhet før trening fordi det kan oversettes til skjevhet etter trening i modellprediksjonene. For eksempel kan en modell trent på ubalanserte data der én fasettverdi vises svært sjelden, vise vesentlig dårligere nøyaktighet for den fasettverdien. Lik representasjon kan beregnes over følgende:

- Hele treningsdataene uavhengig av etikettene

- Undersettet av treningsdataene kun med positive etiketter

- Hver etikett separat

Følgende figur gir et sammendrag av hvordan hver beregning passer inn i hver av de tre kategoriene.

Noen kategorier består av mer enn én beregning. De grunnleggende beregningene (grå bokser) svarer på spørsmålet om skjevhet i den kategorien på den enkleste formen. Beregninger i hvite bokser dekker i tillegg spesielle tilfeller (for eksempel Simpsons paradoks) og brukerpreferanser (for eksempel fokus på visse deler av befolkningen ved beregning av prediktiv ytelse).

Fasettverdirepresentasjon uavhengig av etiketter

Den eneste beregningen i denne kategorien er klasseubalanse (CI). Målet med denne beregningen er å måle om alle fasettverdiene har lik representasjon i dataene.

CI er forskjellen i brøkdelen av dataene som utgjøres av de to fasettverdiene. I vårt eksempeldatasett, for fasetten sex, viser fordelingen (vist i kakediagrammet) at kvinner utgjør 32.4 % av treningsdataene, mens menn utgjør 67.6 %. Som et resultat:

CI = 0.676 - 0.324 = 0.352

En alvorlig høy klasseubalanse kan føre til dårligere prediktiv ytelse for fasettverdien med mindre representasjon.

Fasettverdirepresentasjon kun på nivå med positive etiketter

En annen måte å måle lik representasjon på er å sjekke om alle fasettverdier inneholder en lignende brøkdel av prøver med positive observerte etiketter. Positive etiketter består av gunstige utfall (for eksempel lån gitt, valgt for jobben), så å analysere positive etiketter separat hjelper til med å vurdere om de gunstige avgjørelsene er fordelt jevnt.

I vårt eksempeldatasett brytes de observerte etikettene ned i positive og negative verdier, som vist i følgende figur.

11.4 % av alle kvinner og 31.4 % av alle menn har den positive etiketten (mørk skyggelagt område i venstre og høyre søyle). Forskjellen i positive proporsjoner i etiketter (DPL) måler denne forskjellen.

DPL = 0.314 - 0.114 = 0.20

Den avanserte beregningen i denne kategorien, betinget demografisk forskjell i etiketter (CDDL), måler forskjellene i de positive etikettene, men stratifiserer dem med hensyn til en annen variabel. Denne beregningen hjelper til med å kontrollere Simpsons paradoks, et tilfelle der en beregning over hele data viser skjevhet, men skjevheten forsvinner når data grupperes med hensyn til noe sideinformasjon.

De 1973 UC Berkeley Admissions Study gir et eksempel. I følge dataene ble menn innlagt høyere enn kvinner. Men når de ble undersøkt på nivå med individuelle universitetsavdelinger, ble kvinner tatt opp med tilsvarende eller høyere rate ved hvert institutt. Denne observasjonen kan forklares med Simpsons paradoks, som oppsto her fordi kvinner søkte seg til skoler som var mer konkurransedyktige. Som et resultat ble færre kvinner tatt opp totalt sett sammenlignet med menn, selv om de skole for skole ble tatt opp med tilsvarende eller høyere hastighet.

For mer detaljer om hvordan CDDL beregnes, se Whitepaper for Amazon AI rettferdighet og forklaring.

Fasettverdirepresentasjon på nivået til hver etikett separat

Likhet i representasjon kan også måles for hver enkelt etikett, ikke bare den positive etiketten.

Beregninger i denne kategorien beregner forskjellen i etikettfordelingen til forskjellige fasettverdier. Etikettfordelingen for en fasettverdi inneholder alle de observerte etikettverdiene, sammen med brøkdelen av prøver med den etikettens verdi. For eksempel, i figuren som viser etikettfordelinger, har 88.6 % av kvinnene en negativ observert etikett og 11.4 % har en positiv observert etikett. Så etikettfordelingen for kvinner er [0.886, 0.114] og for menn er [0.686, 0.314].

Den grunnleggende beregningen i denne kategorien, Kullback-Leibler divergens (KL), måler denne forskjellen som:

KL = [0.686 x log(0.686/0.886)] + [0.314 x log(0.314/0.114)] = 0.143

De avanserte metrikkene i denne kategorien, Jensen-Shannon divergens (JS), Lp-norm (LP), Total Variation Distance (TVD), og Kolmogorov-Smirnov (KS), måler også forskjellen mellom fordelingene, men har ulike matematiske egenskaper. Bortsett fra spesielle tilfeller vil de levere innsikt tilsvarende KL. For eksempel, selv om KL-verdien kan være uendelig når en fasettverdi ikke inneholder noen prøver med en bestemt etikett (for eksempel ingen menn med en negativ etikett), unngår JS disse uendelige verdiene. For mer detaljer om disse forskjellene, se Whitepaper for Amazon AI rettferdighet og forklaring.

Forholdet mellom DPL (Kategori 2) og distribusjonsbaserte beregninger for KL/JS/LP/TVD/KS (Kategori 3)

Distribusjonsbaserte beregninger er mer naturlig anvendelige for ikke-binære etiketter. For binære etiketter, på grunn av det faktum at ubalanse i den positive etiketten kan brukes til å beregne ubalansen i negativ etikett, gir distribusjonsberegningene samme innsikt som DPL. Derfor kan du bare bruke DPL i slike tilfeller.

Bias etter trening

Bias-beregninger etter trening i SageMaker Clarify hjelper oss med å svare på to nøkkelspørsmål:

- Er alle fasettverdier representert med samme hastighet i positive (gunstige) modellprediksjoner?

- Har modellen lignende prediktiv ytelse for alle fasettverdier?

Den følgende figuren viser hvordan beregningene tilordnes hvert av disse spørsmålene. Det andre spørsmålet kan brytes ytterligere ned avhengig av hvilken merkelapp ytelsen måles i forhold til.

Lik representasjon i positive modellprediksjoner

Beregninger i denne kategorien kontrollerer om alle fasettverdier inneholder en lignende brøkdel av prøver med positiv antatt merking av modellen. Denne klassen av beregninger er svært lik pretraining-beregningene til DPL og CDDL - den eneste forskjellen er at denne kategorien vurderer predikerte etiketter i stedet for observerte etiketter.

I vårt eksempeldatasett tildeles 4.5 % av alle kvinner den positive etiketten av modellen, og 13.7 % av alle menn blir tildelt den positive etiketten.

Den grunnleggende beregningen i denne kategorien, Difference in Positive Proportions in Predicted Labels (DPPL), måler forskjellen i de positive klasseoppgavene.

DPPL = 0.137 - 0.045 = 0.092

Legg merke til hvordan i treningsdataene hadde en høyere brøkdel av menn en positiv observert merkelapp. På lignende måte tildeles en høyere brøkdel av menn en positiv spådd merkelapp.

Ved å gå videre til de avanserte beregningene i denne kategorien måler Disparate Impact (DI) den samme forskjellen i positive klassetildelinger, men i stedet for forskjellen, beregner den forholdet:

DI = 0.045 / 0.137 = 0.328

Både DI og DPPL formidler kvalitativt lik innsikt, men skiller seg i enkelte hjørnesaker. For eksempel har forhold en tendens til å eksplodere til veldig store tall hvis nevneren er liten. Ta et eksempel på tallene 0.1 og 0.0001. Forholdet er 0.1/0.0001 = 10,000 0.1, mens forskjellen er 0.0001 – 0.1 ≈ 0. I motsetning til de andre beregningene der en verdi på 1 ikke innebærer noen skjevhet, for DI, tilsvarer ingen skjevhet en verdi på XNUMX.

Betinget demografisk disparitet i forutsagte etiketter (CDDPL) måler forskjellen i fasettverdirepresentasjon i den positive etiketten, men akkurat som pretraining-metrikken til CDDL, kontrollerer den også for Simpsons paradoks.

Counterfactual Fliptest (FT) måler om lignende prøver fra de to fasettverdiene mottar lignende avgjørelser fra modellen. En modell som tildeler forskjellige avgjørelser til to prøver som ligner hverandre, men som er forskjellige i fasettverdiene, kan betraktes som partisk mot at fasettverdien blir tildelt den ugunstige (negative) etiketten. Gitt den første fasettverdien (kvinner), vurderer den om lignende medlemmer med den andre fasettverdien (menn) har en annen modellprediksjon. Lignende medlemmer velges basert på k-nærmeste naboalgoritmen.

Like ytelse

Modellspådommene kan ha lignende representasjon i positive etiketter fra forskjellige fasettverdier, men modellytelsen for disse gruppene kan variere betydelig. I mange applikasjoner kan det være ønskelig å ha en lignende prediktiv ytelse på tvers av forskjellige fasettverdier. Beregningene i denne kategorien måler forskjellen i prediktiv ytelse på tvers av fasettverdier.

Fordi dataene kan deles opp på mange forskjellige måter basert på de observerte eller forutsagte etikettene, er det mange forskjellige måter å måle prediktiv ytelse på.

Lik prediktiv ytelse uavhengig av etiketter

Du kan vurdere modellytelsen på hele dataen, uavhengig av de observerte eller forutsagte etikettene – det vil si den generelle nøyaktigheten.

De følgende figurene viser hvordan modellen klassifiserer input fra de to fasettverdiene i vårt eksempeldatasett. Sanne negative (TN) er tilfeller der både den observerte og predikerte etiketten var 0. Falske positive (FP) er feilklassifiseringer der den observerte etiketten var 0, men den predikerte etiketten var 1. Sanne positive (TP) og falske negative (FN) er definert på samme måte.

|

|

For hver fasettverdi er den generelle modellytelsen, det vil si nøyaktigheten for den fasettverdien:

Nøyaktighet = (TN + TP🇧🇷TN + FP + FN + TP)

Med denne formelen er nøyaktigheten for kvinner 0.930 og for menn 0.815. Dette fører til den eneste beregningen i denne kategorien, nøyaktighetsforskjell (AD):

AD = 0.815 - 0.930 = -0.115

AD = 0 betyr at nøyaktigheten for begge gruppene er den samme. Større (positive eller negative) verdier indikerer større forskjeller i nøyaktighet.

Like ytelse kun på positive etiketter

Du kan begrense modellytelsesanalysen til bare positive etiketter. Hvis søknaden for eksempel dreier seg om å oppdage feil på et samlebånd, kan det være ønskelig å kontrollere at ikke-defekte deler (positiv etikett) av ulike slag (fasettverdier) klassifiseres som ikke-defekte med samme hastighet. Denne mengden blir referert til som tilbakekalling, eller sann positiv rate:

Husker = TP / (TP + FN)

I vårt eksempeldatasett er tilbakekallingen for kvinner 0.389, og tilbakekallingen for menn er 0.425. Dette fører til den grunnleggende beregningen i denne kategorien, Recall Difference (RD):

RD = 0.425 - 0.389 = 0.036

La oss nå vurdere de tre avanserte beregningene i denne kategorien, se hvilke brukerpreferanser de koder for, og hvordan de skiller seg fra den grunnleggende beregningen til RD.

For det første, i stedet for å måle ytelsen på de positive observerte etikettene, kan du måle den på de positive predikerte etikettene. Gitt en fasettverdi, for eksempel kvinner, og alle prøvene med den fasettverdien som er spådd å være positive av modellen, hvor mange er egentlig korrekt klassifisert som positive? Denne mengden blir referert til som akseptgrad (AR), eller presisjon:

AR = TP / (TP + FP)

I vårt eksempel er AR for kvinner 0.977, og AR for menn er 0.970. Dette fører til Difference in Acceptance Rate (DAR):

DAR = 0.970 - 0.977 = -0.007

En annen måte å måle skjevhet på er ved å kombinere de to foregående beregningene og måle hvor mange flere positive spådommer modellene tildeler en fasettverdi sammenlignet med de observerte positive merkene. SageMaker Clarify måler denne fordelen ved hjelp av modellen som forholdet mellom antall observerte positive etiketter for den fasettverdien, og antall predikerte positive etiketter, og refererer til det som betinget aksept (CA):

CA = (TP + FN🇧🇷TP + FP)

I vårt eksempel er CA for kvinner 2.510 og for menn 2.283. Forskjellen i CA fører til den endelige beregningen i denne kategorien, Difference in Conditional Acceptance (DCA):

DCA = 2.283 - 2.510 = -0.227

Like ytelse kun på negative etiketter

På en måte som ligner på positive etiketter, kan skjevhet også beregnes som ytelsesforskjellen på de negative etikettene. Å vurdere negative etiketter separat kan være viktig i visse applikasjoner. For eksempel, i vårt defektdeteksjonseksempel, vil vi kanskje oppdage defekte deler (negativ etikett) av forskjellige slag (fasettverdi) med samme hastighet.

Den grunnleggende beregningen i denne kategorien, spesifisitet, er analog med beregningen for tilbakekalling (sann positiv rate). Spesifisitet beregner nøyaktigheten til modellen på prøver med denne fasettverdien som har en observert negativ etikett:

spesifisitet = TN / (TN + FP)

I vårt eksempel (se forvirringstabellene) er spesifisiteten for kvinner og menn henholdsvis 0.999 og 0.994. Følgelig er Spesifisitetsforskjell (SD) er:

SD = 0.994 - 0.999 = -0.005

Går vi videre, akkurat som metrikken for akseptgrad, er den analoge mengden for negative etiketter – avvisningsraten (RR) –:

RR = TN / (TN + FN)

RR for kvinner er 0.927 og for menn er 0.791, noe som fører til Difference in Rejection Rate (DRR) metrikken:

DRR = 0.927 - 0.791 = -0.136

Til slutt er den negative etikettanalogen til betinget aksept, den betingede avvisningen (CR), forholdet mellom antall observerte negative etiketter for den fasettverdien, og antallet predikerte negative etiketter:

CR = (TN + FP🇧🇷TN + FN)

CR for kvinner er 0.928 og for menn er 0.796. Den siste beregningen i denne kategorien er Difference in Conditional Rejection (DCR):

DCR = 0.796 - 0.928 = 0.132

Like ytelse på positive vs. negative etiketter

SageMaker Clarify kombinerer de to foregående kategoriene ved å vurdere modellytelsesforholdet på de positive og negative etikettene. Spesifikt, for hver fasettverdi, beregner SageMaker Clarify forholdet mellom falske negative (FN) og falske positive (FP). I vårt eksempel er FN/FP-forholdet for kvinner 679/10 = 67.9 og for menn er 3678/84 = 43.786. Dette fører til Treatment Equality (TE)-beregningen, som måler forskjellen mellom FP/FN-forholdet:

TE = 67.9 - 43.786 = 24.114

Følgende skjermbilde viser hvordan du kan bruke SageMaker Clarify med Amazon SageMaker Studio for å vise verdiene samt områder og korte beskrivelser av ulike skjevhetsmålinger.

Spørsmål om skjevhet: Hvilke beregninger skal du begynne med?

Husk eksempelspørsmålene om skjevhet i begynnelsen av dette innlegget. Etter å ha gått gjennom beregningene fra forskjellige kategorier, vurder spørsmålene på nytt. For å svare på det første spørsmålet, som gjelder representasjonene av ulike grupper i treningsdataene, kan du begynne med klasseubalanse (CI). På samme måte, for de resterende spørsmålene, kan du starte med å se på henholdsvis forskjell i positive proporsjoner i etiketter (DPL), nøyaktighetsforskjell (AD), forskjell i akseptrate (DAR) og tilbakekallingsforskjell (RD).

Bias uten fasettverdier

For enkelhets skyld ekskluderte denne beskrivelsen av beregninger etter trening den generaliserte entropiindeksen (GE). Denne beregningen måler skjevhet uten å ta hensyn til fasettverdien, og kan være nyttig for å vurdere hvordan modellfeilene fordeler seg. For detaljer, se Generalisert entropi (GE).

konklusjonen

I dette innlegget så du hvordan de 21 forskjellige beregningene i SageMaker Clarify måler skjevhet på forskjellige stadier av ML-rørledningen. Du lærte om ulike beregninger via en brukscase for inntektsprediksjon, hvordan du velger beregninger for brukstilfellet ditt, og hvilke du kan begynne med.

Kom i gang med din ansvarlige AI-reise ved å vurdere skjevheter i ML-modellene dine ved å bruke demo-notatboken Rettferdighet og forklaring med SageMaker Clarify. Du finner den detaljerte dokumentasjonen for SageMaker Clarify, inkludert den formelle definisjonen av beregninger, på Hva er rettferdighet og modellforklaring for spådommer for maskinlæring. For åpen kildekodeimplementering av skjevhetsberegningene, se aws-sagemaker-clarify GitHub-depot. For en detaljert diskusjon inkludert begrensninger, se Whitepaper for Amazon AI rettferdighet og forklaring.

Om forfatterne

Bilal Zafar er en anvendt vitenskapsmann ved AWS, og jobber med rettferdighet, forklaring og sikkerhet i maskinlæring.

Bilal Zafar er en anvendt vitenskapsmann ved AWS, og jobber med rettferdighet, forklaring og sikkerhet i maskinlæring.

Denis V. Batalov er en løsningsarkitekt for AWS, som spesialiserer seg på maskinlæring. Han har vært hos Amazon siden 2005. Denis har en doktorgrad innen AI. Følg ham på Twitter: @dbatalov.

Michele Donini er en Sr Applied Scientist ved AWS. Han leder et team av forskere som jobber med ansvarlig kunstig intelligens, og hans forskningsinteresser er Algoritmisk rettferdighet og forklarlig maskinlæring.

Michele Donini er en Sr Applied Scientist ved AWS. Han leder et team av forskere som jobber med ansvarlig kunstig intelligens, og hans forskningsinteresser er Algoritmisk rettferdighet og forklarlig maskinlæring.

- AI

- ai kunst

- ai art generator

- du har en robot

- Amazon SageMaker

- kunstig intelligens

- sertifisering av kunstig intelligens

- kunstig intelligens i bankvirksomhet

- kunstig intelligens robot

- kunstig intelligens roboter

- programvare for kunstig intelligens

- AWS maskinlæring

- blockchain

- blockchain konferanse ai

- coingenius

- samtale kunstig intelligens

- kryptokonferanse ai

- dall sin

- dyp læring

- google det

- maskinlæring

- plato

- plato ai

- Platon Data Intelligence

- Platon spill

- PlatonData

- platogaming

- skala ai

- syntaks

- zephyrnet