Økningen i sosiale aktiviteter på nettet som sosiale nettverk eller nettspill er ofte full av fiendtlig eller aggressiv atferd som kan føre til uønskede manifestasjoner av hatefulle ytringer, nettmobbing eller trakassering. For eksempel tilbyr mange nettbaserte spillsamfunn talechatfunksjonalitet for å lette kommunikasjonen mellom brukerne. Selv om stemmechat ofte støtter vennlig småprat og søppelprat, kan det også føre til problemer som hatefulle ytringer, nettmobbing, trakassering og svindel. Å flagge skadelig språk hjelper organisasjoner med å holde samtaler sivile og opprettholde et trygt og inkluderende nettmiljø der brukere kan opprette, dele og delta fritt. I dag er mange selskaper utelukkende avhengige av menneskelige moderatorer for å vurdere giftig innhold. Det er imidlertid dyrt å skalere menneskelige moderatorer for å møte disse behovene med tilstrekkelig kvalitet og hastighet. Som et resultat risikerer mange organisasjoner høye brukerslitasjerater, skade på omdømmet og regulatoriske bøter. I tillegg blir moderatorer ofte psykologisk påvirket av å vurdere det giftige innholdet.

Amazon Transcribe er en automatisk talegjenkjenningstjeneste (ASR) som gjør det enkelt for utviklere å legge til tale-til-tekst-funksjonalitet til applikasjonene sine. I dag er vi glade for å kunngjøre Amazon Transkribering toksisitetsdeteksjon, en maskinlæringsdrevet funksjon (ML) som bruker både lyd- og tekstbaserte signaler for å identifisere og klassifisere stemmebasert giftig innhold på tvers av syv kategorier, inkludert seksuell trakassering, hatefulle ytringer, trusler, overgrep, banning, fornærmelser og grafisk språk. I tillegg til tekst bruker Toxicity Detection talesignaler som toner og tonehøyde for å finpusse på giftig hensikt i tale.

Dette er en forbedring fra standard innholdsmodereringssystemer som er designet for kun å fokusere på spesifikke termer, uten å ta hensyn til intensjoner. De fleste bedrifter har en SLA på 7–15 dager for å vurdere innhold rapportert av brukere fordi moderatorer må lytte til lange lydfiler for å vurdere om og når samtalen ble giftig. Med Amazon Transcribe Toxicity Detection gjennomgår moderatorer kun den spesifikke delen av lydfilen som er flagget for giftig innhold (mot hele lydfilen). Innholdet menneskelige moderatorer må vurdere er redusert med 95 %, noe som gjør det mulig for kundene å redusere SLAen til bare noen få timer, samt gjøre dem i stand til proaktivt å moderere mer innhold utover det som er flagget av brukerne. Det vil tillate bedrifter å automatisk oppdage og moderere innhold i stor skala, tilby et trygt og inkluderende nettmiljø og iverksette tiltak før det kan forårsake brukerfrafall eller skade på omdømmet. Modellene som brukes for deteksjon av giftig innhold vedlikeholdes av Amazon Transcribe og oppdateres med jevne mellomrom for å opprettholde nøyaktighet og relevans.

I dette innlegget lærer du hvordan du:

- Identifiser skadelig innhold i tale med Amazon Transcribe Toxicity Detection

- Bruk Amazon Transcribe-konsollen for påvisning av toksisitet

- Opprett en transkripsjonsjobb med toksisitetsdeteksjon ved å bruke AWS kommandolinjegrensesnitt (AWS CLI) og Python SDK

- Bruk Amazon Transcribe toxicity detection API-responsen

Oppdag toksisitet i lydchat med Amazon Transcribe Toxicity Detection

Amazon Transcribe tilbyr nå en enkel, ML-basert løsning for flagging av skadelig språk i talte samtaler. Denne funksjonen er spesielt nyttig for sosiale medier, spill og generelle behov, og eliminerer behovet for kunder å oppgi sine egne data for å trene ML-modellen. Toksisitetsdeteksjon klassifiserer giftig lydinnhold i følgende syv kategorier og gir en konfidenspoengsum (0–1) for hver kategori:

- Banning – Tale som inneholder ord, uttrykk eller akronymer som er uhøflige, vulgære eller støtende.

- Hatytringer – Tale som kritiserer, fornærmer, fordømmer eller dehumaniserer en person eller gruppe på grunnlag av en identitet (som rase, etnisitet, kjønn, religion, seksuell legning, evne og nasjonal opprinnelse).

- Seksuell – Tale som indikerer seksuell interesse, aktivitet eller opphisselse ved å bruke direkte eller indirekte referanser til kroppsdeler, fysiske egenskaper eller sex.

- fornærmelser – Tale som inkluderer nedsettende, ydmykende, hånende, fornærmende eller nedverdigende språk. Denne typen språk er også stemplet som mobbing.

- Vold eller trussel – Tale som inkluderer trusler som søker å påføre smerte, skade eller fiendtlighet mot en person eller gruppe.

- Grafisk – Tale som bruker visuelt beskrivende og ubehagelig levende bilder. Denne typen språk er ofte med vilje ordrik for å forsterke en mottakers ubehag.

- Trakassering eller fornærmende – Tale ment å påvirke mottakerens psykologiske velvære, inkludert nedsettende og objektiverende termer.

Du kan få tilgang til Toxicity Detection enten via Amazon Transcribe-konsollen eller ved å ringe API-ene direkte ved å bruke AWS CLI eller AWS SDK-ene. På Amazon Transcribe-konsollen kan du laste opp lydfilene du vil teste for toksisitet og få resultater med bare noen få klikk. Amazon Transcribe vil identifisere og kategorisere giftig innhold, som trakassering, hatefulle ytringer, seksuelt innhold, vold, fornærmelser og banning. Amazon Transcribe gir også en konfidenspoengsum for hver kategori, og gir verdifull innsikt i innholdets toksisitetsnivå. Toxicity Detection er for øyeblikket tilgjengelig i standard Amazon Transcribe API for batchbehandling og støtter amerikansk engelsk språk.

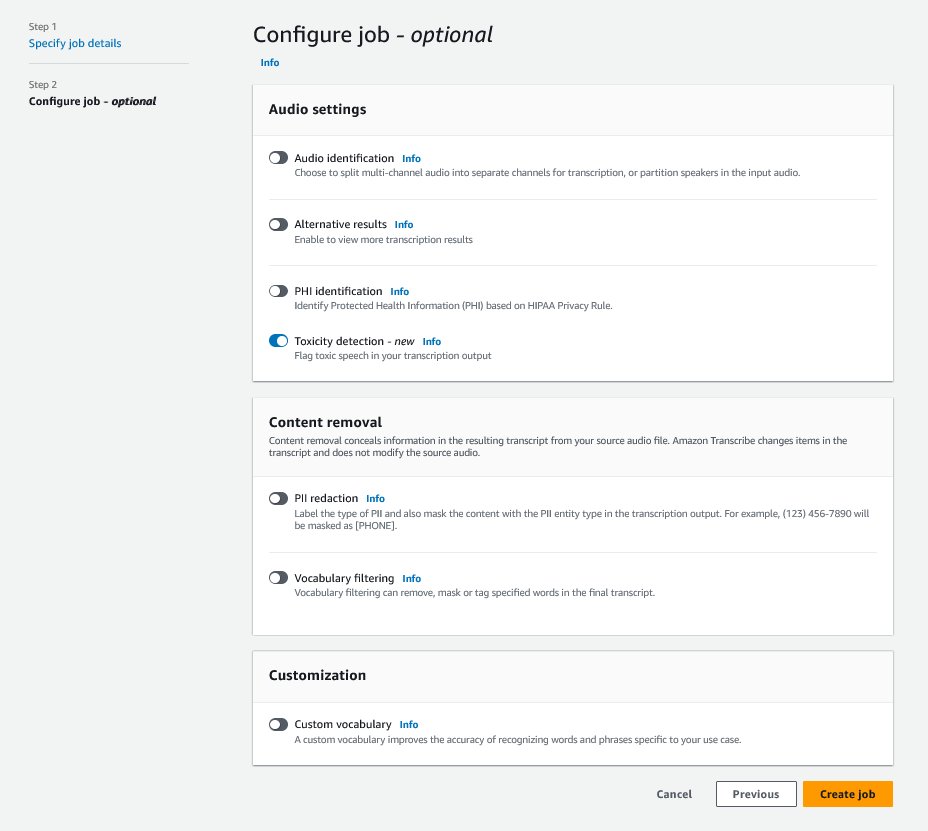

Gjennomgang av Amazon Transcribe-konsollen

For å komme i gang, logg på AWS-administrasjonskonsoll og gå til Amazon Transkribering. For å opprette en ny transkripsjonsjobb, må du laste opp de registrerte filene dine til en Amazon enkel lagringstjeneste (Amazon S3) bøtte før de kan behandles. På lydinnstillingssiden, som vist i følgende skjermbilde, aktiver Påvisning av toksisitet og fortsett med å opprette den nye jobben. Amazon Transcribe vil behandle transkripsjonsjobben i bakgrunnen. Etter hvert som jobben skrider frem, kan du forvente at statusen endres til FERDIG når prosessen er ferdig.

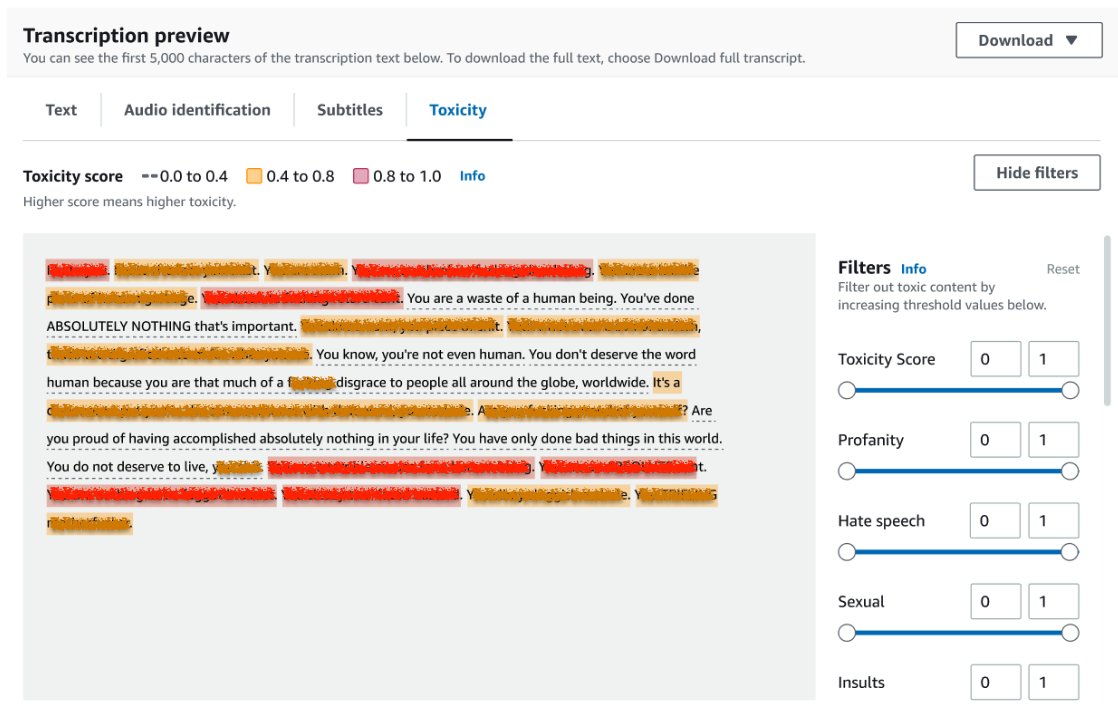

For å se gjennom resultatene av en transkripsjonsjobb, velg jobben fra jobblisten for å åpne den. Rull ned til Forhåndsvisning av transkripsjon delen for å sjekke resultatene på Toksisitet fanen. Brukergrensesnittet viser fargekodede transkripsjonssegmenter for å indikere toksisitetsnivået, bestemt av konfidenspoengsummen. For å tilpasse skjermen kan du bruke vekslelinjene i Filter rute. Disse søylene lar deg justere tersklene og filtrere toksisitetskategoriene deretter.

Følgende skjermbilde har dekket deler av transkripsjonsteksten på grunn av tilstedeværelsen av sensitiv eller giftig informasjon.

Transkripsjons-API med en forespørsel om påvisning av toksisitet

I denne delen veileder vi deg gjennom å lage en transkripsjonsjobb med toksisitetsdeteksjon ved hjelp av programmeringsgrensesnitt. Hvis lydfilen ikke allerede er i en S3-bøtte, last den opp for å sikre tilgang med Amazon Transcribe. I likhet med å opprette en transkripsjonsjobb på konsollen, må du oppgi følgende parametere når du starter jobben:

- TranskripsjonJobnavn – Angi et unikt jobbnavn.

- MediaFileUri – Skriv inn URI-plasseringen til lydfilen på Amazon S3. Amazon Transcribe støtter følgende lydformater: MP3, MP4, WAV, FLAC, AMR, OGG eller WebM

- Språkkode - Satt til

en-US. Når dette skrives, støtter Toxicity Detection kun amerikansk engelsk språk. - Giftighetskategorier - Send meg

ALLverdi for å inkludere alle støttede kategorier for påvisning av toksisitet.

Følgende er eksempler på å starte en transkripsjonsjobb med toksisitetsdeteksjon aktivert ved bruk av Python3:

Du kan påkalle den samme transkripsjonsjobben med toksisitetsdeteksjon ved å bruke følgende AWS CLI-kommando:

Transkripsjons-API med toksisitetsdeteksjonsrespons

JSON-utdataene for giftighetsdeteksjon for transkribering av Amazon vil inkludere transkripsjonsresultatene i resultatfeltet. Aktivering av toksisitetsdeteksjon legger til et ekstra felt kalt toxicityDetection under resultatfeltet. toxicityDetection inkluderer en liste over transkriberte elementer med følgende parametere:

- tekst – Den rå transkriberte teksten

- toksisitet – En konfidenspoengsum for deteksjon (en verdi mellom 0–1)

- kategorier – En tillitspoeng for hver kategori av giftig tale

- starttid – Startposisjonen for deteksjon i lydfilen (sekunder)

- sluttid – Sluttposisjonen for deteksjon i lydfilen (sekunder)

Følgende er et eksempel på en forkortet toksisitetsdeteksjonsrespons du kan laste ned fra konsollen:

Oppsummering

I dette innlegget ga vi en oversikt over den nye Amazon Transcribe Toxicity Detection-funksjonen. Vi beskrev også hvordan du kan analysere JSON-utdata for toksisitetsdeteksjon. For mer informasjon, sjekk ut Amazon Transcribe-konsollen og prøv transkripsjons-APIet med Toxicity Detection.

Amazon Transcribe Toxicity Detection er nå tilgjengelig i følgende AWS-regioner: US East (Ohio), US East (N. Virginia), US West (Oregon), Asia Pacific (Sydney), Europa (Irland) og Europa (London). For å lære mer, besøk Amazon Transcribe.

Lær mer om innholdsmoderering på AWS og vår innholdsmoderering ML brukstilfeller. Ta det første skrittet mot strømlinjeforme innholdsmodereringsoperasjonene dine med AWS.

Om forfatteren

Lana Zhang er en senior løsningsarkitekt ved AWS WWSO AI Services-teamet, som spesialiserer seg på AI og ML for innholdsmoderering, datasyn og naturlig språkbehandling. Med sin ekspertise er hun dedikert til å promotere AWS AI/ML-løsninger og hjelpe kunder med å transformere sine forretningsløsninger på tvers av ulike bransjer, inkludert sosiale medier, spill, e-handel og reklame og markedsføring.

Lana Zhang er en senior løsningsarkitekt ved AWS WWSO AI Services-teamet, som spesialiserer seg på AI og ML for innholdsmoderering, datasyn og naturlig språkbehandling. Med sin ekspertise er hun dedikert til å promotere AWS AI/ML-løsninger og hjelpe kunder med å transformere sine forretningsløsninger på tvers av ulike bransjer, inkludert sosiale medier, spill, e-handel og reklame og markedsføring.

Sumit Kumar er en senior produktsjef, teknisk hos AWS AI Language Services-teamet. Han har 10 års erfaring med produktledelse på tvers av en rekke domener og brenner for AI/ML. Utenom jobben elsker Sumit å reise og liker å spille cricket og tennis.

Sumit Kumar er en senior produktsjef, teknisk hos AWS AI Language Services-teamet. Han har 10 års erfaring med produktledelse på tvers av en rekke domener og brenner for AI/ML. Utenom jobben elsker Sumit å reise og liker å spille cricket og tennis.

- SEO-drevet innhold og PR-distribusjon. Bli forsterket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk deg selv. Tilgang her.

- PlatoAiStream. Web3 Intelligence. Kunnskap forsterket. Tilgang her.

- PlatoESG. Bil / elbiler, Karbon, CleanTech, Energi, Miljø, Solenergi, Avfallshåndtering. Tilgang her.

- BlockOffsets. Modernisering av eierskap for miljøkompensasjon. Tilgang her.

- kilde: https://aws.amazon.com/blogs/machine-learning/flag-harmful-language-in-spoken-conversations-with-amazon-transcribe-toxicity-detection/

- : har

- :er

- :ikke

- 10

- 100

- 16

- 17

- 20

- 24

- 7

- 95%

- a

- evne

- Om oss

- misbruk

- adgang

- tilsvar

- Regnskap og administrasjon

- nøyaktighet

- tvers

- Handling

- Aktiviteter

- aktivitet

- legge til

- tillegg

- Legger

- Annonsering

- aggressiv

- AI

- AI-tjenester

- AI / ML

- Alle

- tillate

- allerede

- også

- Selv

- Amazon

- Amazon Transcribe

- Amazon Web Services

- blant

- an

- og

- Kunngjøre

- api

- APIer

- søknader

- ER

- AS

- asia

- asia-stillehavet

- bistå

- At

- utmattelses

- lyd

- Automatisk

- automatisk

- tilgjengelig

- AWS

- bakgrunn

- barer

- basis

- BE

- ble

- fordi

- før du

- atferd

- mellom

- Beyond

- kroppen

- både

- Break

- mobbing

- virksomhet

- by

- som heter

- ringer

- CAN

- evne

- kategorier

- Kategori

- Årsak

- endring

- sjekk

- Velg

- Klassifisere

- Kommunikasjon

- Communities

- Selskaper

- fullføre

- Terminado

- datamaskin

- Datamaskin syn

- selvtillit

- Konsoll

- inneholder

- innhold

- Samtale

- samtaler

- dekket

- skape

- Opprette

- cricket

- kritiserer

- I dag

- Kunder

- tilpasse

- dato

- Dager

- dedikert

- beskrevet

- designet

- oppdage

- Gjenkjenning

- bestemmes

- utviklere

- direkte

- direkte

- Vise

- diverse

- domener

- ned

- nedlasting

- to

- e-handel

- hver enkelt

- øst

- lett

- enten

- eliminere

- muliggjøre

- aktivert

- muliggjør

- slutt

- Engelsk

- sikre

- Enter

- bedrifter

- Hele

- Miljø

- spesielt

- etnisitet

- Europa

- evaluere

- eksempel

- eksempler

- opphisset

- forvente

- dyrt

- erfaring

- ekspertise

- ekstra

- legge til rette

- vendt

- Mislyktes

- Trekk

- Noen få

- felt

- filet

- Filer

- filtrere

- bøter

- Først

- flaggede

- Fokus

- etter

- Til

- vennlig

- fra

- funksjonalitet

- gaming

- Kjønn

- general

- få

- Go

- Går

- Grafisk

- Gruppe

- veilede

- skadelig

- Ha

- he

- hjelper

- her

- her.

- Høy

- TIMER

- Hvordan

- Hvordan

- Men

- HTML

- http

- HTTPS

- menneskelig

- identifisere

- Identitet

- if

- påvirket

- importere

- forbedring

- in

- inkludere

- inkluderer

- Inkludert

- Inklusive

- Øke

- indikerer

- indikerer

- bransjer

- informasjon

- innsikt

- Fornærmelse

- tiltenkt

- hensikt

- Intensjon

- med hensikt

- interesse

- grensesnitt

- inn

- Irland

- IT

- varer

- Jobb

- jpg

- JSON

- bare

- Hold

- Språk

- føre

- LÆRE

- læring

- Nivå

- linje

- Liste

- plassering

- London

- elsker

- maskin

- maskinlæring

- vedlikeholde

- GJØR AT

- ledelse

- leder

- mange

- Marketing

- Media

- Møt

- ML

- modell

- modeller

- moderasjon

- mer

- mest

- må

- navn

- nasjonal

- Naturlig

- Natural Language Processing

- Trenger

- behov

- nettverk

- Ny

- nå

- of

- tilby

- ofte

- Ohio

- on

- på nett

- online gaming

- bare

- åpen

- Drift

- or

- Oregon

- organisasjoner

- opprinnelse

- vår

- ut

- produksjon

- utenfor

- oversikt

- egen

- Pacific

- side

- Smerte

- parametere

- delta

- deler

- passere

- lidenskapelig

- person

- setninger

- fysisk

- Tonehøyde

- plato

- Platon Data Intelligence

- PlatonData

- spiller

- del

- posisjon

- Post

- tilstedeværelse

- problemer

- prosess

- Bearbeidet

- prosessering

- Produkt

- produktledelse

- Produktsjef

- Banning

- Programmering

- fremme

- gi

- forutsatt

- gir

- gi

- Python

- kvalitet

- Race

- priser

- Raw

- klar

- anerkjennelse

- registrert

- redusere

- Redusert

- referanser

- regioner

- regulatorer

- relevans

- religion

- avhengige

- rapportert

- svar

- resultere

- Resultater

- anmeldelse

- gjennomgå

- Risiko

- trygge

- samme

- Skala

- skalering

- svindel

- Resultat

- bla

- sdks

- sekunder

- Seksjon

- søker

- segmentet

- segmenter

- senior

- sensitive

- tjeneste

- Tjenester

- sett

- innstillinger

- syv

- Kjønn

- Seksuell

- Del

- hun

- vist

- Viser

- undertegne

- lignende

- Enkelt

- selskap

- sosiale medier

- Sosialt nettverk

- utelukkende

- løsning

- Solutions

- spesialisert

- spesifikk

- tale

- Talegjenkjenning

- tale-til-tekst

- fart

- talt

- Standard

- Begynn

- startet

- Start

- status

- Trinn

- lagring

- slik

- tilstrekkelig

- Støttes

- Støtter

- sydney

- Systemer

- Ta

- snakker

- lag

- Teknisk

- vilkår

- test

- Det

- De

- deres

- Dem

- Disse

- de

- denne

- trusler

- Gjennom

- tid

- til

- i dag

- mot

- mot

- Tog

- transformere

- reiser

- sant

- prøve

- typen

- ui

- etter

- unik

- Uoppfordret

- oppdatert

- us

- bruke

- brukt

- Bruker

- Brukere

- bruker

- ved hjelp av

- Verdifull

- verdi

- variasjon

- av

- vold

- Virginia

- syn

- Besøk

- Voice

- vs

- vulgær

- vente

- ønsker

- we

- web

- webtjenester

- VI VIL

- Vest

- når

- mens

- vil

- med

- uten

- ord

- Arbeid

- skriving

- år

- ennå

- Du

- Din

- zephyrnet