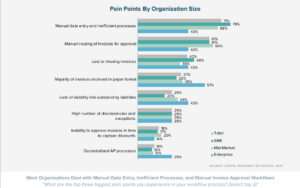

Å trekke ut tekst fra et bilde kan være en tungvint prosess. De fleste taster manuelt inn teksten/dataene fra bildet; men dette er både tidkrevende og ineffektivt når du har mange bilder å forholde deg til.

Bilde til tekst konverterere tilbyr en fin måte å trekke ut tekst fra bilder.

Selv om slike verktøy gjør en god jobb, blir den utpakkede teksten/data ofte presentert på en ustrukturert måte som resulterer i mye etterbehandling.

An AI-drevet OCR som Nanonets kan trekke tekst fra bilder og presentere de utpakkede dataene på en ryddig, organisert og strukturert måte.

Nanonetter trekker ut data fra bilder nøyaktig, i skala og på flere språk. Nanonets er den eneste tekstgjenkjennings-OCR-en som presenterer uttrukket tekst i pent strukturerte formater som er helt tilpassbare. Innfangede data kan presenteres som tabeller, linjeelementer eller et hvilket som helst annet format.

- Klikk for å laste opp bildet ditt nedenfor

- Nanonets OCR gjenkjenner automatisk innholdet i filen din og konverterer den til tekst

- Last ned den utpakkede teksten som en rå tekstfil eller integrer via API

Innholdsfortegnelse

Her er tre avanserte metoder der du kan bruke Nanonets OCR til å oppdage og trekke ut tekst fra bilder, trekk ut tekst fra PDFs, trekke ut data fra PDFs eller analysere PDF-filer og andre dokumenttyper:

Trenger du en gratis OCR online for bilde til tekst, PDF til tabell, PDF til teksteller PDF datautvinning? Sjekk ut Nanonets online OCR API i aksjon og begynn å lage tilpassede OCR-modeller gratis!

Nanonets har ferdigtrente OCR-modeller for de spesifikke bildetypene som er oppført nedenfor. Hver forhåndstrente OCR-modell er opplært til å nøyaktig relatere tekst i bildetypen til et passende felt som navn, adresse, dato, utløp osv. og presentere den utpakkede teksten på en ryddig og organisert måte.

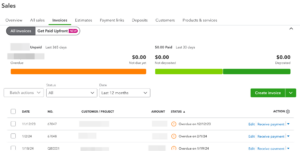

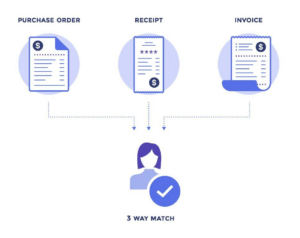

- Fakturaer

- Kvitteringer

- Førerkort (US)

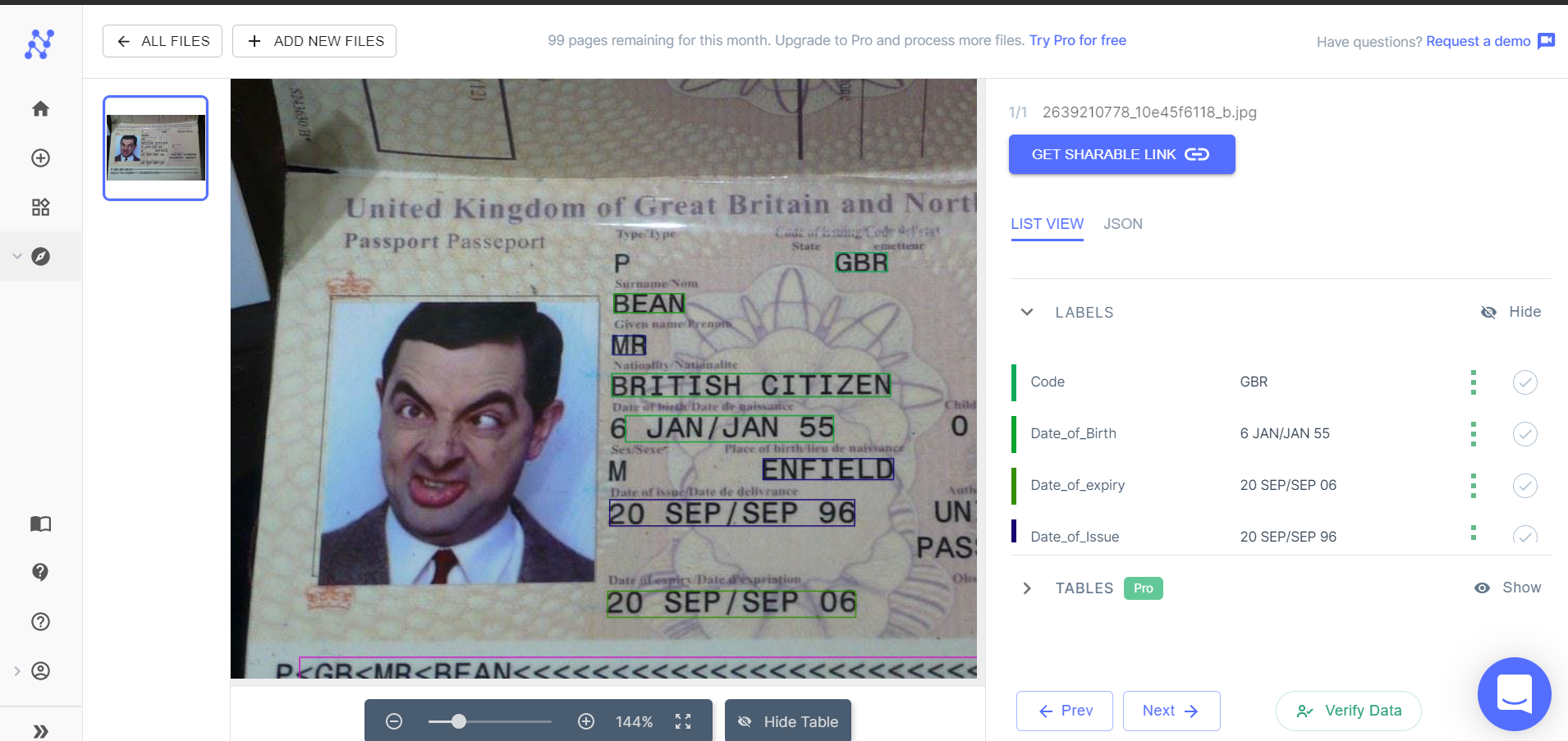

- Pass

Nanonetter online OCR & OCR API har mange interessante bruk saker.

Trinn 1: Velg en passende OCR-modell

Logg inn til Nanonets og velg en OCR-modell som passer til bildet du vil trekke ut tekst og data fra. Hvis ingen av de forhåndstrente OCR-modellene passer dine behov, kan du hoppe videre for å finne ut hvordan du lager en tilpasset OCR-modell.

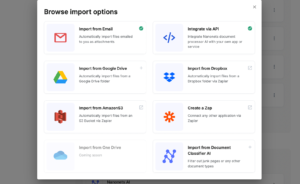

Trinn 2: Legg til filer

Legg til filene/bildene du vil trekke ut tekst fra. Du kan legge til så mange bilder du vil.

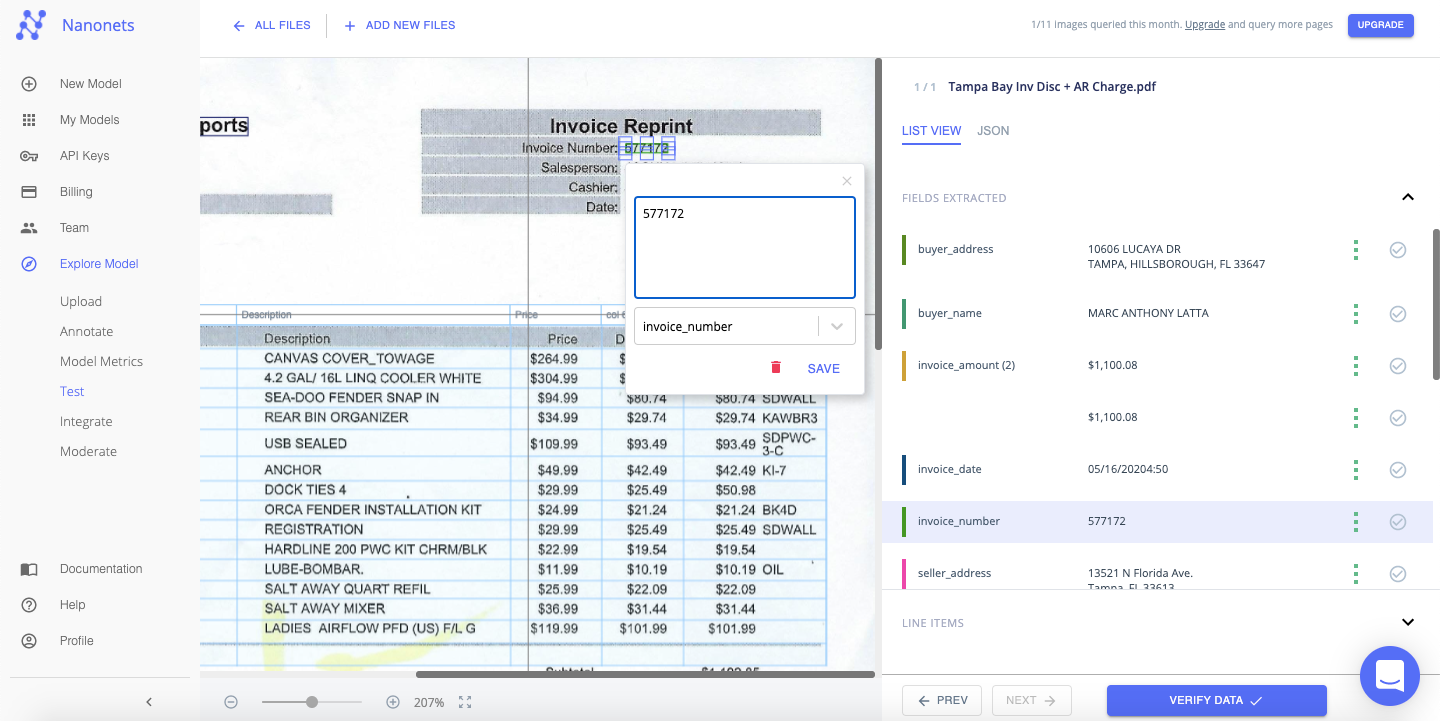

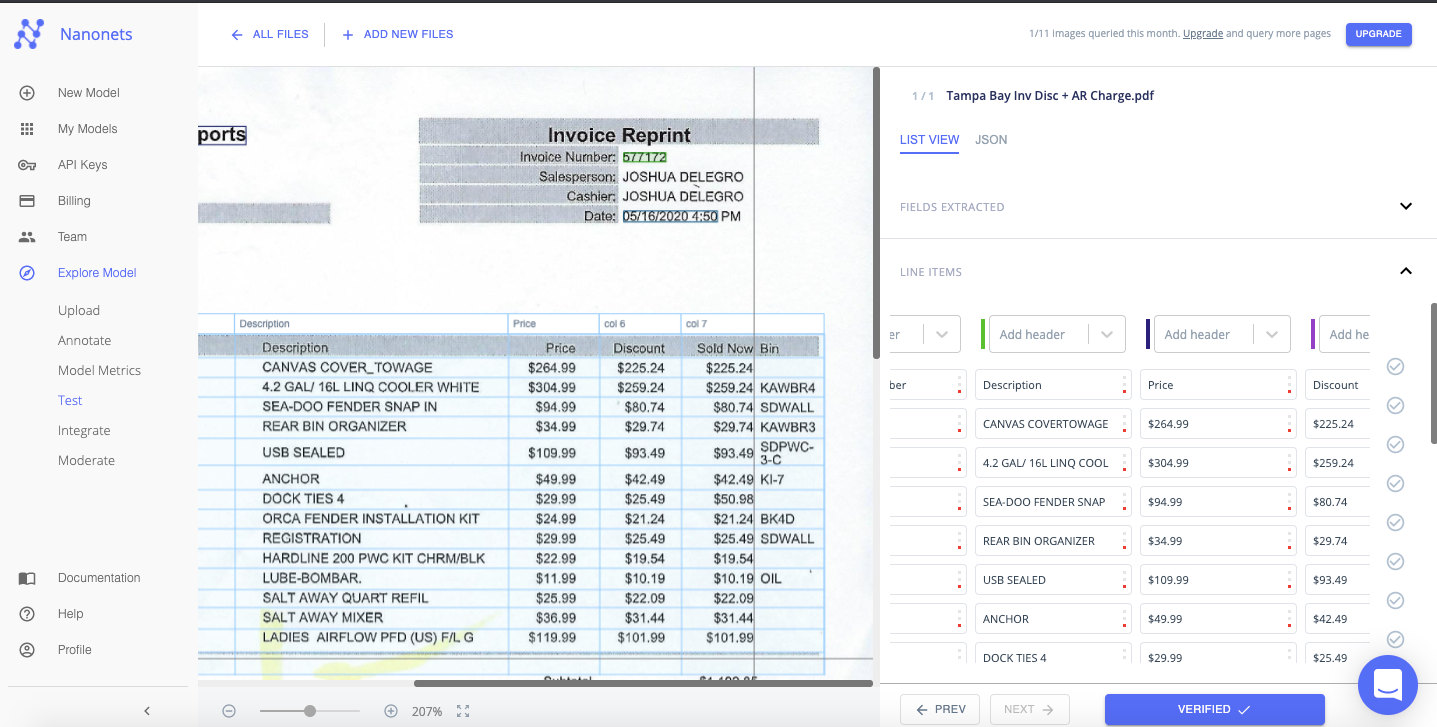

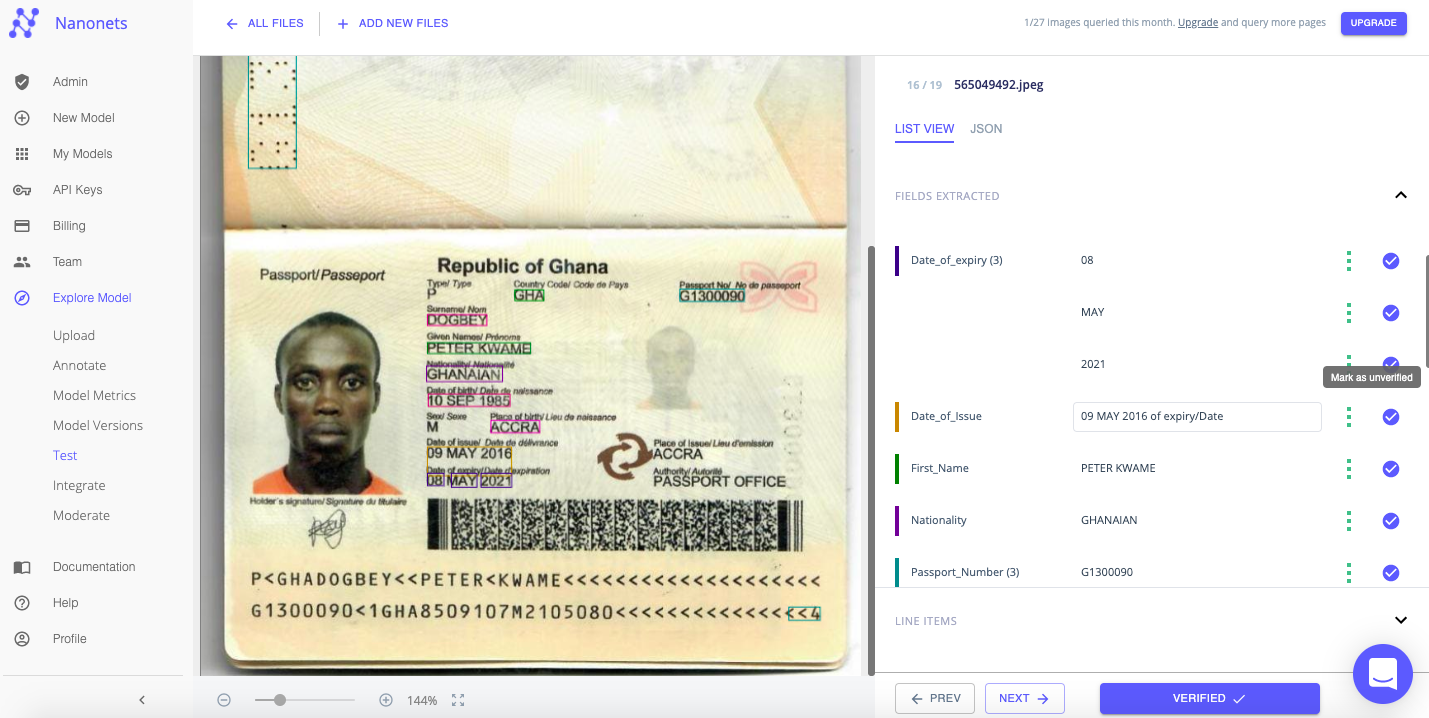

Trinn 3: Test

Tillat noen sekunder for modellen å kjøre og trekke ut tekst fra bildet.

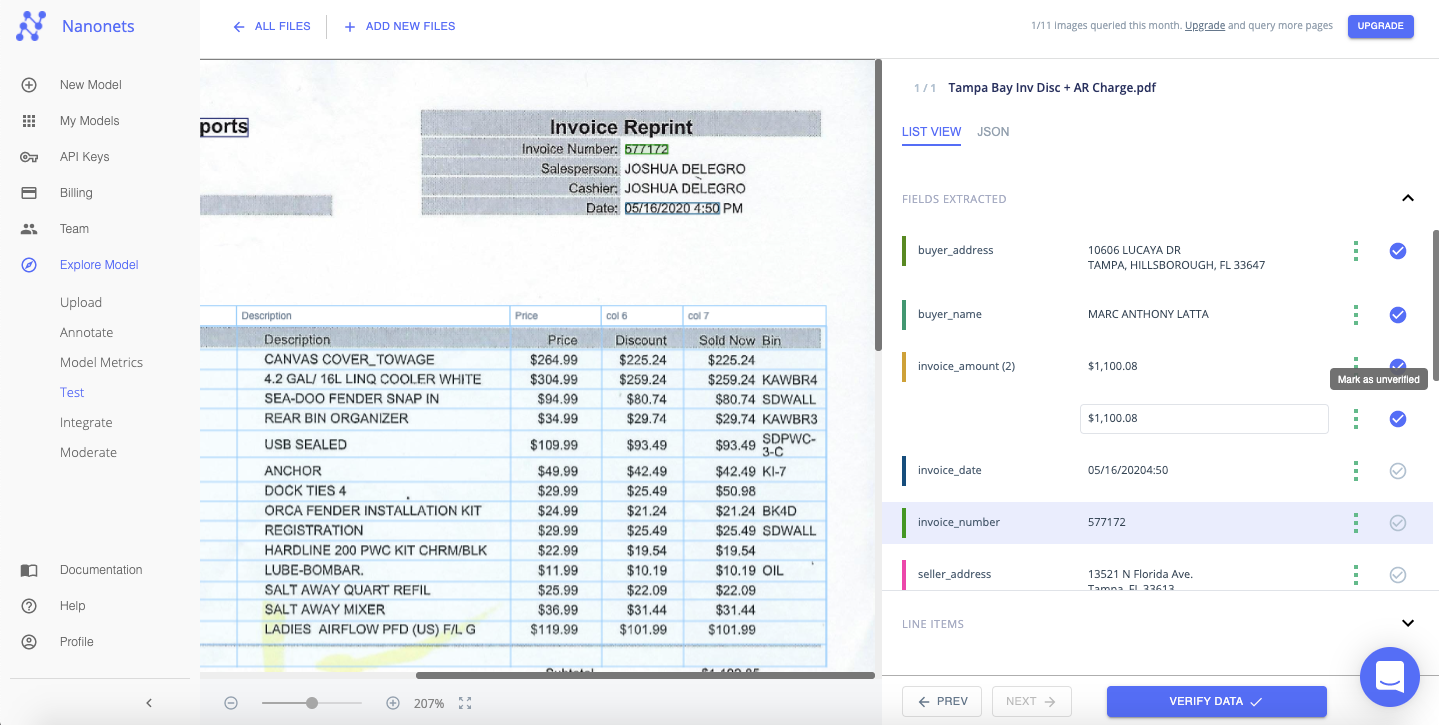

Trinn 4: Bekreft

Bekreft raskt teksten som er trukket ut fra hver fil, ved å sjekke tabellvisningen til høyre. Du kan enkelt dobbeltsjekke om teksten har blitt riktig gjenkjent og matchet med et passende felt eller tag.

Du kan til og med velge å redigere/korrigere feltverdiene og etikettene på dette stadiet. Nanonetter er ikke bundet av malen til bildet.

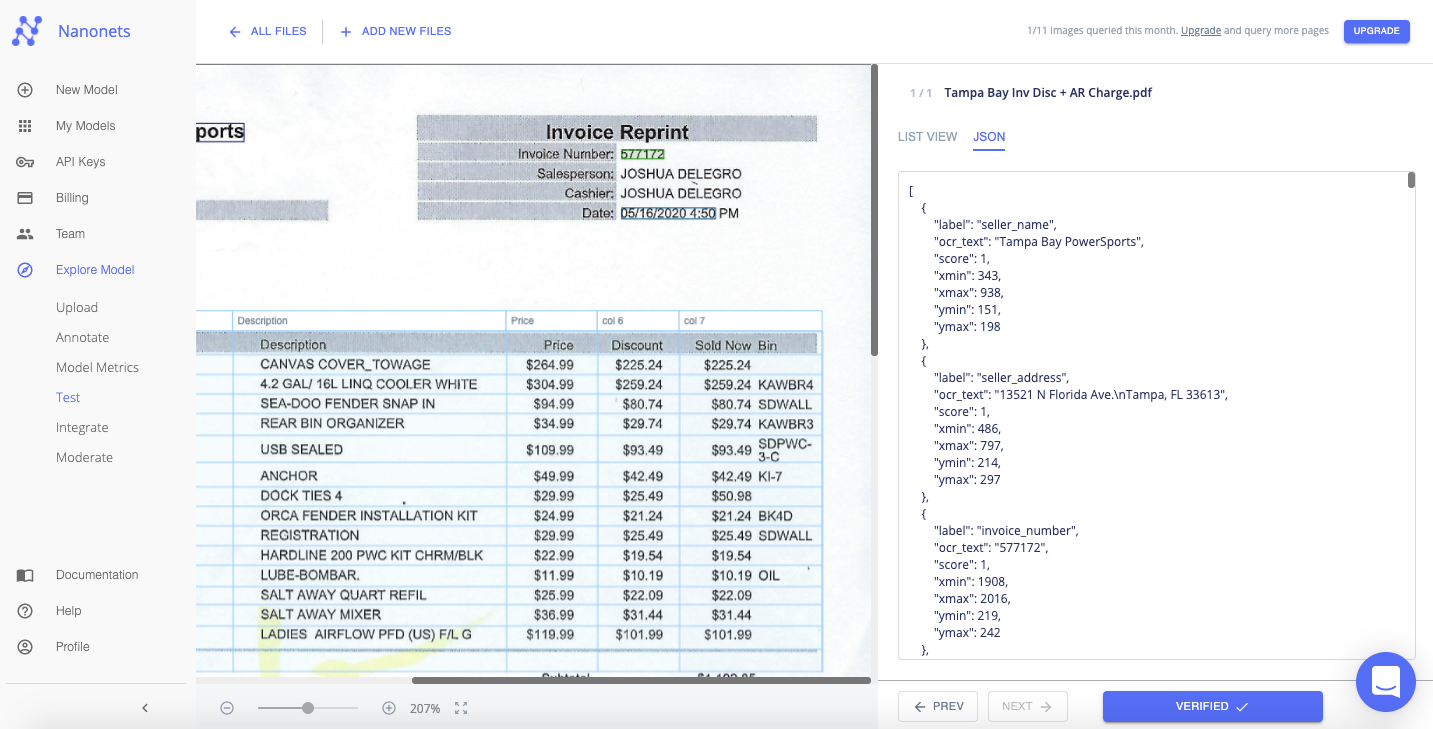

De utpakkede dataene kan vises i et "List View"- eller "JSON"-format.

Du kan merke av i avmerkingsboksen ved siden av hver verdi eller felt du bekrefter eller klikke på "Bekreft data" for å fortsette umiddelbart.

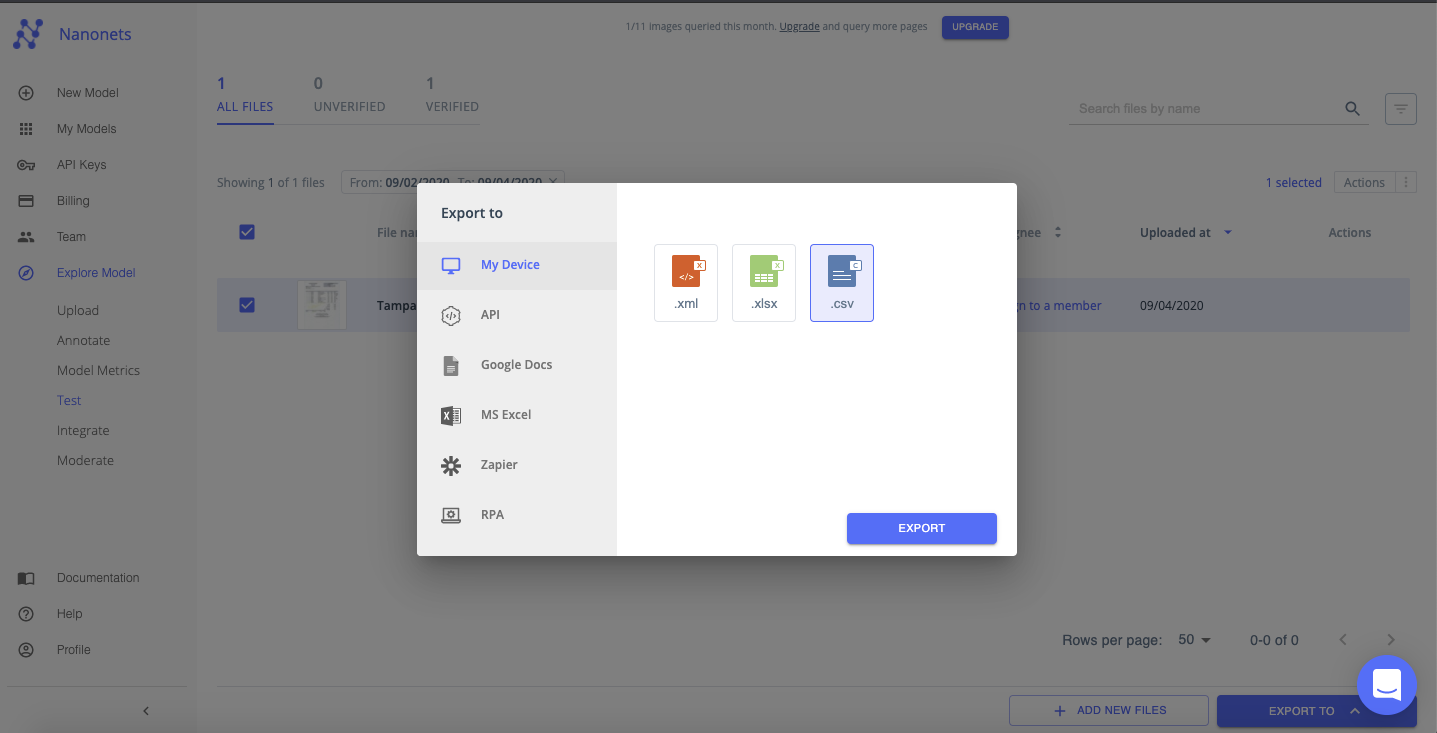

Trinn 5: Eksporter

Når alle filene er verifisert. Du kan eksportere de pent organiserte dataene som en xml-, xlsx- eller csv-fil.

Nanonets har interessant bruk saker og unik kundesuksesshistorier. Finn ut hvordan Nanonets kan gjøre virksomheten din mer produktiv.

Det er enkelt å bygge en tilpasset OCR-modell med Nanonets. Du kan vanligvis bygge, trene og distribuere en modell for enhver bilde- eller dokumenttype, på alle språk, alt på under 25 minutter (avhengig av antall filer som brukes til å trene modellen).

Se videoen nedenfor for å følge de første 4 trinnene i denne metoden:

Trinn 1: Lag din egen OCR-modell

Logg inn til Nanonets og klikk på "Lag din egen OCR-modell".

Trinn 2: Last opp treningsfiler/bilder

Last opp eksempelfiler som skal brukes til å trene OCR-modellene. Nøyaktigheten til OCR-modellen du bygger vil i stor grad avhenge av kvaliteten og kvantiteten på filene/bildene som lastes opp på dette stadiet

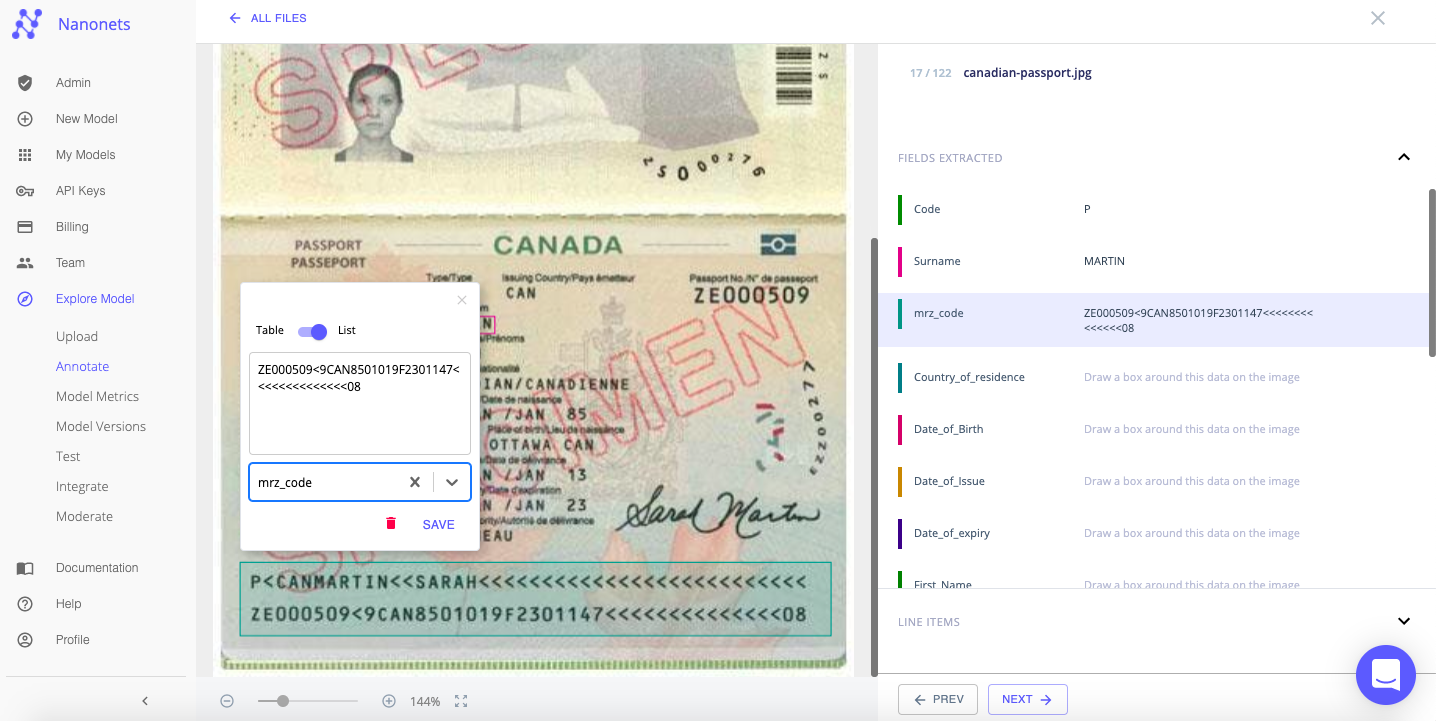

Trinn 3: Kommenter tekst på filene/bildene

Merk nå hvert stykke tekst eller data med et passende felt eller etikett. Dette avgjørende trinnet vil lære OCR-modellen din å trekke ut riktig tekst fra bilder og assosiere den med tilpassede felt som er relevante for dine behov.

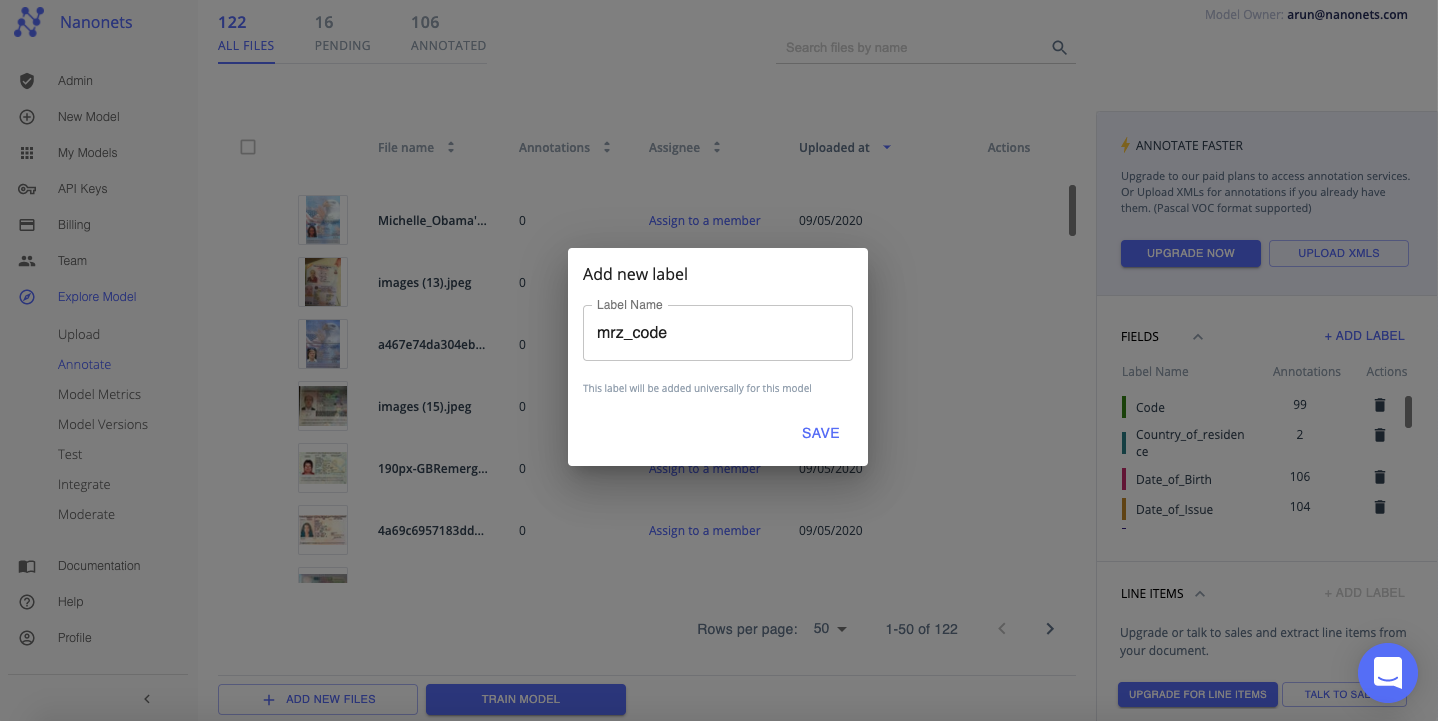

Du kan også legge til en ny etikett for å kommentere teksten eller dataene. Husk at Nanonets ikke er bundet av malen til bildet!

Trinn 4: Tren den tilpassede OCR-modellen

Når merknaden er fullført for alle treningsfilene/bildene, klikker du på "Train Model". Trening tar vanligvis mellom 20 minutter-2 timer, avhengig av antall filer og modeller i kø for trening. Du kan oppgradering til en betalt plan for å få raskere resultater på dette stadiet (vanligvis under 20 minutter).

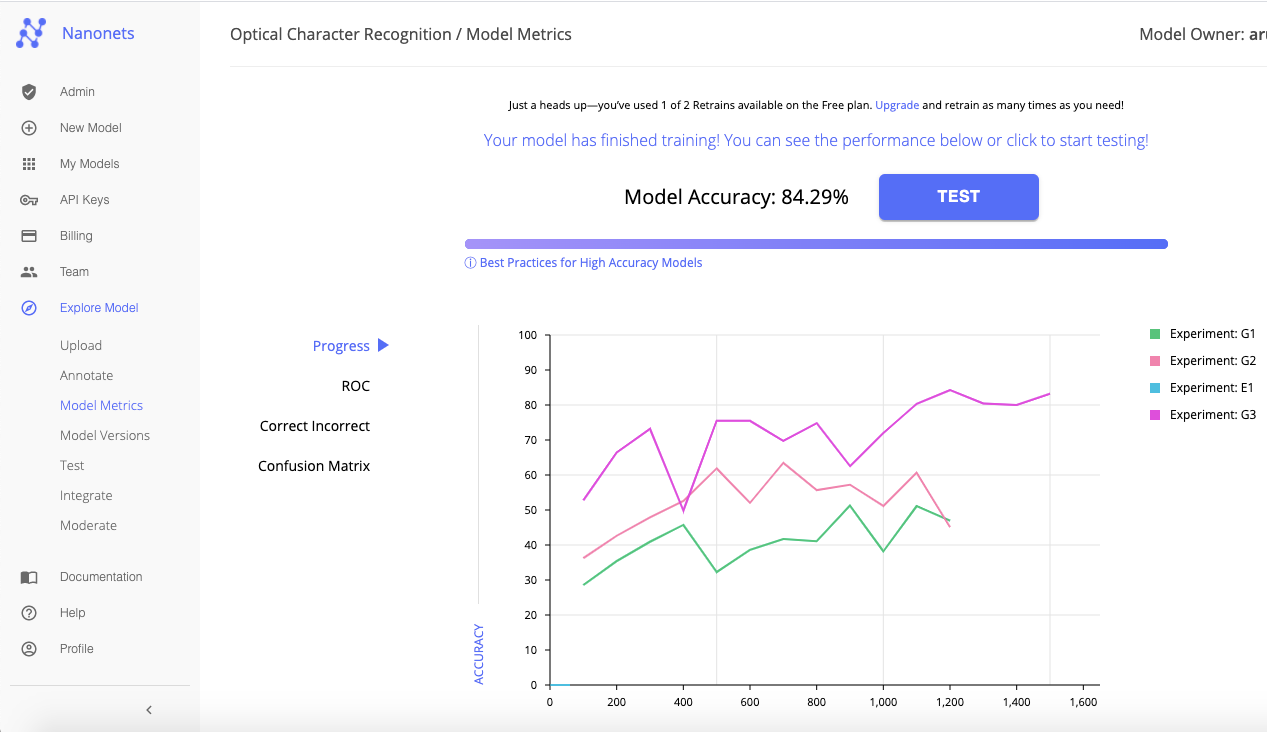

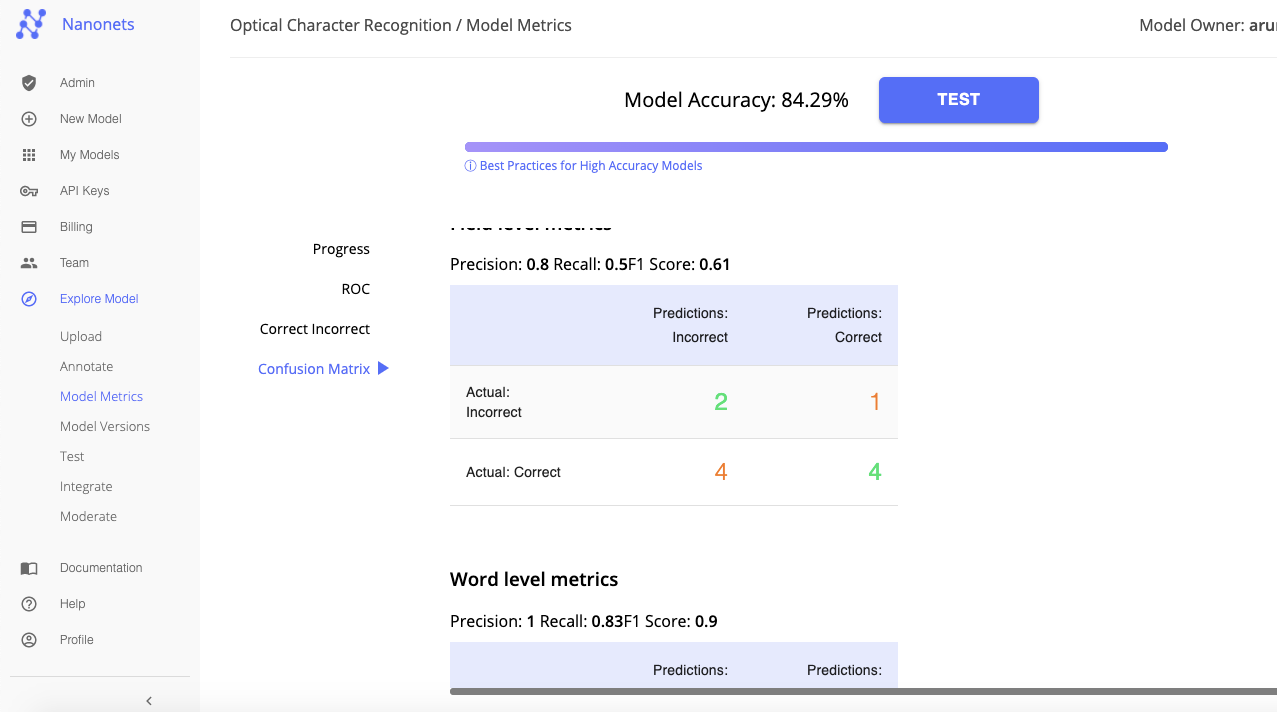

Nanonetter utnytter dyp læring for å bygge ulike OCR-modeller og tester dem mot hverandre for nøyaktighet. Nanonets velger deretter ut den beste OCR-modellen (basert på inndata og nøyaktighetsnivåer).

Fanen "Model Metrics" viser de forskjellige målingene og komparative analysene som gjorde at Nanonets kunne velge den beste OCR-modellen blant alle som ble bygget. Du kan trene modellen på nytt (ved å tilby et bredere utvalg av treningsbilder og bedre merknader) for å oppnå høyere nivåer av nøyaktighet.

Eller, hvis du er fornøyd med nøyaktigheten, klikk på "Test" for å teste og verifisere om denne tilpassede OCR-modellen fungerer som forventet på et utvalg bilder eller filer som tekst/data må trekkes ut fra.

Trinn 5: Test og bekreft data

Legg til et par eksempelbilder for å teste og verifisere den tilpassede OCR-modellen.

Hvis teksten har blitt gjenkjent, trukket ut og presentert på riktig måte, eksporter du filen. Som du kan se nedenfor, har de utpakkede dataene blitt organisert og presentert i et pent format.

Gratulerer, du har nå bygget og trent en tilpasset OCR-modell for å trekke ut tekst fra visse typer bilder!

Håndterer virksomheten din tekstgjenkjenning i digitale dokumenter, bilder eller PDF-er? Har du lurt på hvordan du trekker ut tekst fra bilder nøyaktig?

Tren dine egne OCR-modeller med NanoNets API

Her er en detaljert guide til tog dine egne OCR-modeller ved hjelp av Nanonets API. på dokumentasjon, vil du finne klare til å fyre kodeeksempler i Python, Shell, Ruby, Golang, Java og C #, samt detaljerte API-spesifikasjoner for forskjellige sluttpunkter.

Her er en trinn-for-trinn-guide for å trene din egen modell ved hjelp av Nanonets API:

Trinn 1: Klon repoen

git clone https://github.com/NanoNets/nanonets-ocr-sample-python

cd nanonets-ocr-sample-python

sudo pip install requests

sudo pip install tqdmTrinn 2: Få din gratis API-nøkkel

Få din gratis API-nøkkel fra https://app.nanonets.com/#/keys

Trinn 3: Sett API-nøkkelen som en miljøvariabel

export NANONETS_API_KEY=YOUR_API_KEY_GOES_HERE

Trinn 4: Lag en ny modell

python ./code/create-model.py

Merk: Dette genererer et MODEL_ID som du trenger for neste trinn

Trinn 5: Legg til modell-id som miljøvariabel

export NANONETS_MODEL_ID=YOUR_MODEL_ID

Trinn 6: Last opp treningsdataene

Samle bildene av objektet du vil oppdage. Når du har datasettet klart i mappen images (bildefiler), begynn å laste opp datasettet.

python ./code/upload-training.py

Trinn 7: Togmodell

Når bildene er lastet opp, begynn å trene modellen

python ./code/train-model.py

Trinn 8: Få modelltilstand

Modellen tar ~ 30 minutter å trene. Du vil motta en e-post når modellen er trent. I mellomtiden sjekker du tilstanden til modellen

watch -n 100 python ./code/model-state.py

Trinn 9: Gjør prediksjon

Når modellen er trent. Du kan lage spådommer ved å bruke modellen

python ./code/prediction.py PATH_TO_YOUR_IMAGE.jpgFordelene ved å bruke nanonetter fremfor andre OCR APIer går utover bare bedre nøyaktighet med hensyn til å trekke ut tekst fra bilder. Her er 7 grunner til at du bør vurdere å bruke Nanonets OCR for tekstgjenkjenning i stedet:

1. Arbeide med tilpassede data

De fleste OCR-programvare er ganske stive når det gjelder typen data de kan jobbe med. Opplæring av en OCR-modell for en brukstilfelle krever stor grad av fleksibilitet med hensyn til dens krav og spesifikasjoner; en OCR for fakturabehandling vil være vesentlig forskjellig fra en OCR for pass! Nanonetter er ikke bundet av slike rigide begrensninger. Nanonets bruker dine egne data for å trene OCR-modeller som er best egnet for å møte de spesielle behovene til din virksomhet.

2. Arbeide med ikke-engelsk eller flere språk

Siden Nanonets fokuserer på trening med tilpassede data, er det unikt plassert for å bygge en enkelt OCR-modell som kan trekke ut tekst fra bilder på et hvilket som helst språk eller flere språk samtidig.

3. Krever ingen etterbehandling

Tekst ekstrahert ved hjelp av OCR-modeller må være intelligent strukturert og presentert i et forståelig format; ellers går det mye tid og ressurser med å omorganisere dataene til meningsfull informasjon. Mens de fleste OCR-verktøy bare henter og dumper data fra bilder, trekker Nanonets bare ut de relevante dataene og sorterer dem automatisk i intelligent strukturerte felt som gjør det enklere å se og forstå.

4. Lærer kontinuerlig

Bedrifter står ofte overfor dynamisk skiftende krav og behov. For å overvinne potensielle veisperringer lar Nanonets deg enkelt trene modellene dine på nytt med nye data. Dette lar OCR-modellen tilpasse seg uforutsette endringer.

5. Håndterer vanlige databegrensninger med letthet

Nanonetter utnytter AI, ML og Deep Learning-teknikker for å overvinne vanlige databegrensninger som i stor grad påvirker tekstgjenkjenning og utvinning. Nanonets OCR kan gjenkjenne og håndtere håndskrevet tekst, bilder av tekst på flere språk samtidig, bilder med lav oppløsning, bilder med nye eller kursive fonter og varierende størrelser, bilder med skyggetekst, skråstilt tekst, tilfeldig ustrukturert tekst, bildestøy, uskarpe bilder og mer. Tradisjonelle OCR API-er er bare ikke utstyrt for å utføre under slike begrensninger; de krever data på et veldig høyt nivå av troskap som ikke er normen i virkelige scenarier.

6. Krever ingen internt team av utviklere

Du trenger ikke å bekymre deg for å ansette utviklere og skaffe talenter for å tilpasse Nanonets API til bedriftens behov. Nanonets ble bygget for problemfri integrasjon. Du kan også enkelt integrere Nanonets med de fleste CRM-, ERP- eller RPA-programvare.

7. Tilpass, tilpasse, tilpasse

Du kan fange så mange felt med tekst/data som du vil med Nanonets OCR. Du kan til og med bygge tilpassede valideringsregler som fungerer for dine spesifikke tekstgjenkjennings- og tekstuttrekkingskrav. Nanonetter er ikke bundet av malen til dokumentet i det hele tatt. Du kan fange data i tabeller eller linjeelementer eller et hvilket som helst annet format!

Nanonets har mange bruksområder som kan optimere virksomhetens ytelse, spare kostnader og øke veksten. Finne ut hvordan Nanonets brukstilfeller kan gjelde for produktet ditt.

Eller sjekk ut Nanonetter OCR API i aksjon og begynn å bygge skikk OCR modeller gratis!

Oppdater Juli 2022: dette innlegget ble opprinnelig publisert i oktober 2020 og har siden blitt oppdatert regelmessig.

Her er et lysbilde oppsummerer funnene i denne artikkelen. Her er en alternativ versjon av dette innlegget.

- AI

- AI og maskinlæring

- ai kunst

- ai art generator

- du har en robot

- kunstig intelligens

- sertifisering av kunstig intelligens

- kunstig intelligens i bankvirksomhet

- kunstig intelligens robot

- kunstig intelligens roboter

- programvare for kunstig intelligens

- blockchain

- blockchain konferanse ai

- coingenius

- samtale kunstig intelligens

- kryptokonferanse ai

- dall sin

- dyp læring

- google det

- maskinlæring

- OCR

- plato

- plato ai

- Platon Data Intelligence

- Platon spill

- PlatonData

- platogaming

- skala ai

- syntaks

- Tekstgjenkjenning

- zephyrnet