Amazon SageMaker JumpStart er Machine Learning (ML)-huben til SageMaker som tilbyr forhåndsopplærte, offentlig tilgjengelige modeller for et bredt spekter av problemtyper for å hjelpe deg med å komme i gang med maskinlæring.

JumpStart tilbyr også eksempel notatbøker som bruker Amazon SageMaker funksjoner som punktforekomsttrening og eksperimenter over et stort utvalg modelltyper og brukstilfeller. Disse eksempelnotatbøkene inneholder kode som viser hvordan du bruker ML-løsninger ved å bruke SageMaker og JumpStart. De kan tilpasses til dine egne behov og kan dermed fremskynde applikasjonsutviklingen.

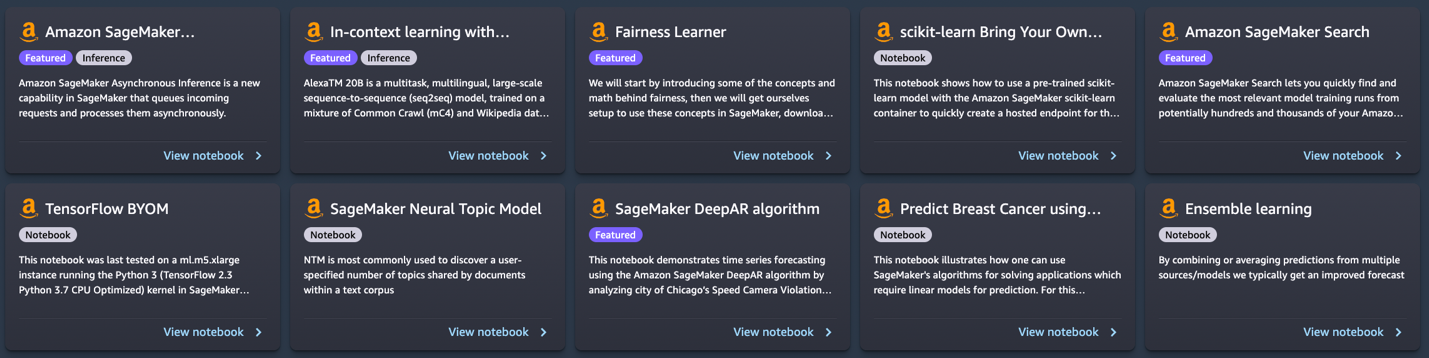

Nylig la vi til 10 nye notatbøker til JumpStart in Amazon SageMaker Studio. Dette innlegget fokuserer på disse nye notatbøkene. Når dette skrives, tilbyr JumpStart 56 bærbare PC-er, alt fra bruk av toppmoderne NLP-modeller (natural language processing) til å fikse skjevheter i datasett ved opplæring av modeller.

De 10 nye notatbøkene kan hjelpe deg på følgende måter:

- De tilbyr eksempelkode som du kan kjøre som den er fra JumpStart UI i Studio og se hvordan koden fungerer

- De viser bruken av ulike SageMaker og JumpStart APIer

- De tilbyr en teknisk løsning som du kan skreddersy videre basert på dine egne behov

Antallet notatbøker som tilbys gjennom JumpStart øker med jevne mellomrom etter hvert som flere notatbøker legges til. Disse notatbøkene er også tilgjengelige på GitHub.

Oversikt over notatbøker

De 10 nye notatbøkene er som følger:

- Kontekstlæring med AlexaTM 20B – Demonstrerer hvordan du bruker AlexaTM 20B for kontekstlæring med null- og få-skudd-læring på fem eksempeloppgaver: tekstoppsummering, naturlig språkgenerering, maskinoversettelse, ekstraktiv spørsmålssvar og naturlig språkslutning og klassifisering.

- Rettferdighet lineær elev i SageMaker – Det har nylig vært bekymringer om skjevheter i ML-algoritmer som et resultat av etterligning av eksisterende menneskelige fordommer. Denne notatboken bruker rettferdighetskonsepter for å justere modellprediksjoner på riktig måte.

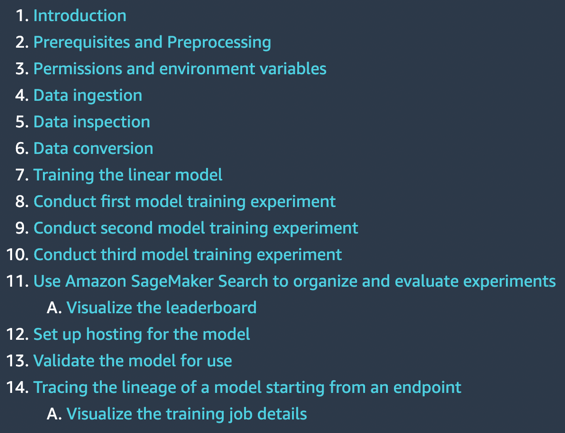

- Administrer ML-eksperimentering ved å bruke SageMaker Search – Amazon SageMaker Search lar deg raskt finne og evaluere de mest relevante modellopplæringsløpene fra potensielt hundrevis og tusenvis av SageMaker-modellopplæringsjobber.

- SageMaker nevrale emnemodell – SageMaker Neural Topic Model (NTM) er en uovervåket læringsalgoritme som forsøker å beskrive et sett med observasjoner som en blanding av distinkte kategorier.

- Forutse brudd på kjørehastighet – SageMaker DeepAR-algoritmen kan brukes til å trene en modell for flere gater samtidig, og forutsi brudd for flere gatekameraer.

- Forutsigelse av brystkreft – Denne notatboken bruker UCIs diagnostiske datasett for brystkreft for å bygge en prediktiv modell av hvorvidt et brystmassebilde indikerer en godartet eller ondartet svulst.

- Ensemblespådommer fra flere modeller – Ved å kombinere eller gjennomsnittlige spådommer fra flere kilder og modeller, får vi vanligvis en forbedret prognose. Denne notatboken illustrerer dette konseptet.

- SageMaker asynkron slutning – Asynkron inferens er et nytt inferensalternativ for inferensbehov i nesten sanntid. Forespørsler kan ta opptil 15 minutter å behandle og har nyttelaststørrelser på opptil 1 GB.

- TensorFlow ta med din egen modell – Lær hvordan du trener en TensorFlow-modell lokalt og distribuerer på SageMaker ved hjelp av denne notatboken.

- Scikit-lear ta med din egen modell - Denne notatboken viser hvordan du bruker en forhåndstrent Scikit-learn-modell med SageMaker Scikit-learn-beholderen for raskt å lage et vertsbasert endepunkt for den modellen.

Forutsetninger

For å bruke disse notatbøkene, sørg for at du har tilgang til Studio med en utførelsesrolle som lar deg kjøre SageMaker-funksjonalitet. Den korte videoen nedenfor hjelper deg med å navigere til JumpStart-notatbøker.

I de følgende delene går vi gjennom hver av de 10 nye løsningene og diskuterer noen av deres interessante detaljer.

Kontekstlæring med AlexaTM 20B

AlexaTM 20B er en multitask, flerspråklig, storskala sekvens-til-sekvens (seq2seq) modell, trent på en blanding av Common Crawl (mC4) og Wikipedia-data på tvers av 12 språk, ved bruk av denoising og Causal Language Modeling (CLM) oppgaver. Den oppnår toppmoderne ytelse på vanlige i kontekstspråkoppgaver som one-shot-oppsummering og one-shot maskinoversettelse, og overgår bare dekodermodeller som Open AIs GPT3 og Googles PaLM, som er over åtte ganger større.

In-context learning, også kjent som spørre, refererer til en metode hvor du bruker en NLP-modell på en ny oppgave uten å måtte finjustere den. Noen få oppgaveeksempler er gitt til modellen bare som en del av inferensinngangen, et paradigme kjent som få skudd i kontekst læring. I noen tilfeller kan modellen prestere bra uten treningsdata i det hele tatt, kun gitt en forklaring på hva som bør forutses. Dette kalles nullskudd i kontekstlæring.

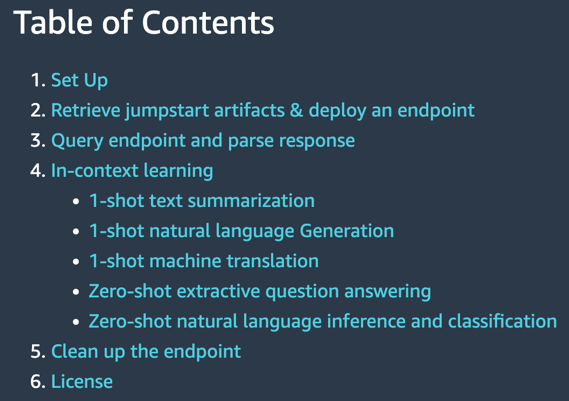

Denne notatboken viser hvordan du distribuerer AlexaTM 20B gjennom JumpStart API og kjører inferens. Den demonstrerer også hvordan AlexaTM 20B kan brukes til kontekstlæring med fem eksempeloppgaver: tekstoppsummering, naturlig språkgenerering, maskinoversettelse, ekstraktiv spørsmålsbesvarelse og naturlig språkslutning og klassifisering.

|

|

Notatboken viser følgende:

- Én-shot tekstoppsummering, generering av naturlig språk og maskinoversettelse ved hjelp av ett enkelt treningseksempel for hver av disse oppgavene

- Zero-shot spørsmålssvar og naturlig språkslutning pluss klassifisering ved å bruke modellen som den er, uten behov for å gi noen treningseksempler.

Prøv å kjøre din egen tekst mot denne modellen og se hvordan den oppsummerer tekst, trekker ut spørsmål og svar eller oversetter fra ett språk til et annet.

Rettferdighet lineær elev i SageMaker

Det har nylig vært bekymringer om skjevheter i ML-algoritmer som et resultat av etterligning av eksisterende menneskelige fordommer. I dag har flere ML-metoder sterke sosiale implikasjoner, for eksempel brukes de til å forutsi banklån, forsikringsrenter eller reklame. Dessverre vil en algoritme som lærer av historiske data naturlig arve tidligere skjevheter. Denne notatboken presenterer hvordan du kan overvinne dette problemet ved å bruke SageMaker og rettferdige algoritmer i sammenheng med lineære elever.

Den starter med å introdusere noen av konseptene og matematikken bak rettferdighet, deretter laster den ned data, trener en modell og til slutt bruker den rettferdighetskonsepter for å justere modellprediksjoner på riktig måte.

|

|

Notatboken viser følgende:

- Kjører en standard lineær modell på UCIs voksendatasett.

- Viser urettferdighet i modellspådommer

- Retting av data for å fjerne skjevhet

- Omskolering av modellen

Prøv å kjøre dine egne data ved å bruke denne eksempelkoden og finn ut om det er skjevhet. Deretter kan du prøve å fjerne skjevheter, hvis noen, i datasettet ved å bruke funksjonene i denne eksempelnotisboken.

Administrer ML-eksperimentering ved å bruke SageMaker Search

SageMaker Search lar deg raskt finne og evaluere de mest relevante modellopplæringsløpene fra potensielt hundrevis og tusenvis av SageMaker modellopplæringsjobber. Å utvikle en ML-modell krever kontinuerlig eksperimentering, utprøving av nye læringsalgoritmer og innstilling av hyperparametre, alt mens man observerer effekten av slike endringer på modellens ytelse og nøyaktighet. Denne iterative øvelsen fører ofte til en eksplosjon av hundrevis av modelltreningseksperimenter og modellversjoner, og bremser konvergensen og oppdagelsen av en vinnende modell. I tillegg gjør informasjonseksplosjonen det svært vanskelig å spore tilbake linjen til en modellversjon – den unike kombinasjonen av datasett, algoritmer og parametere som brygget modellen i utgangspunktet.

Denne notatboken viser hvordan du bruker SageMaker Search for raskt og enkelt å organisere, spore og evaluere modellopplæringsjobbene dine på SageMaker. Du kan søke på alle definerende attributter fra læringsalgoritmen som brukes, hyperparameterinnstillinger, treningsdatasett som brukes, og til og med taggene du har lagt til på modellopplæringsjobbene. Du kan også raskt sammenligne og rangere treningsløpene dine basert på deres ytelsesmålinger, for eksempel treningstap og valideringsnøyaktighet, og dermed lage ledertavler for å identifisere vinnermodellene som kan distribueres i produksjonsmiljøer. SageMaker Search kan raskt spore tilbake hele avstamningen til en modellversjon distribuert i et live-miljø, helt frem til datasettene som brukes i opplæring og validering av modellen.

|

|

Notatboken viser følgende:

- Trener en lineær modell tre ganger

- Bruke SageMaker Search til å organisere og evaluere disse eksperimentene

- Visualisere resultatene i en ledertavle

- Distribuere en modell til et endepunkt

- Spore avstamning av modellen fra endepunktet

I din egen utvikling av prediktive modeller kjører du kanskje flere eksperimenter. Prøv å bruke SageMaker Search i slike eksperimenter og opplev hvordan det kan hjelpe deg på flere måter.

SageMaker Neural Topic Model

SageMaker Neural Topic Model (NTM) er en uovervåket læringsalgoritme som forsøker å beskrive et sett med observasjoner som en blanding av distinkte kategorier. NTM brukes oftest for å oppdage et brukerspesifisert antall emner som deles av dokumenter i et tekstkorpus. Her er hver observasjon et dokument, funksjonene er tilstedeværelsen (eller antallet forekomster) av hvert ord, og kategoriene er temaene. Fordi metoden er uten tilsyn, er ikke emnene spesifisert på forhånd, og det er ikke garantert at de stemmer overens med hvordan et menneske naturlig kan kategorisere dokumenter. Emnene læres som en sannsynlighetsfordeling over ordene som forekommer i hvert dokument. Hvert dokument er på sin side beskrevet som en blanding av emner.

Denne notatboken bruker SageMaker NTM-algoritmen for å trene en modell på 20NewsGroups-datasettet. Dette datasettet har blitt mye brukt som benchmark for emnemodellering.

|

|

Notatboken viser følgende:

- Opprette en SageMaker-treningsjobb på et datasett for å produsere en NTM-modell

- Bruke modellen til å utføre inferens med et SageMaker-endepunkt

- Utforske den trente modellen og visualisere lærte emner

Du kan enkelt endre denne notatboken for å kjøre på tekstdokumentene dine og dele dem inn i ulike emner.

Forutse brudd på kjørehastighet

Denne notatboken demonstrerer prognoser for tidsserier ved å bruke SageMaker DeepAR-algoritmen ved å analysere byen Chicagos fotoboksbrudd-datasett. Datasettet er vert for Data.gov, og administreres av US General Services Administration, Technology Transformation Service.

Disse bruddene fanges opp av kamerasystemer og er tilgjengelige for å forbedre livene til publikum gjennom dataportalen Chicago. Speed Camera Violation datasettet kan brukes til å skjelne mønstre i dataene og få meningsfull innsikt.

Datasettet inneholder flere kameraplasseringer og daglige bruddtellinger. Hvert daglige overtredelsestall for et kamera kan betraktes som en egen tidsserie. Du kan bruke SageMaker DeepAR-algoritmen til å trene en modell for flere gater samtidig, og forutsi brudd for flere gatekameraer.

|

|

Notatboken viser følgende:

- Trening av SageMaker DeepAR-algoritmen på tidsseriedatasettet ved å bruke punktforekomster

- Å gjøre slutninger om den trente modellen for å lage spådommer om trafikkbrudd

Med denne notatboken kan du lære hvordan tidsserieproblemer kan løses ved å bruke DeepAR-algoritmen i SageMaker og prøve å bruke den på dine egne tidsseriedatasett.

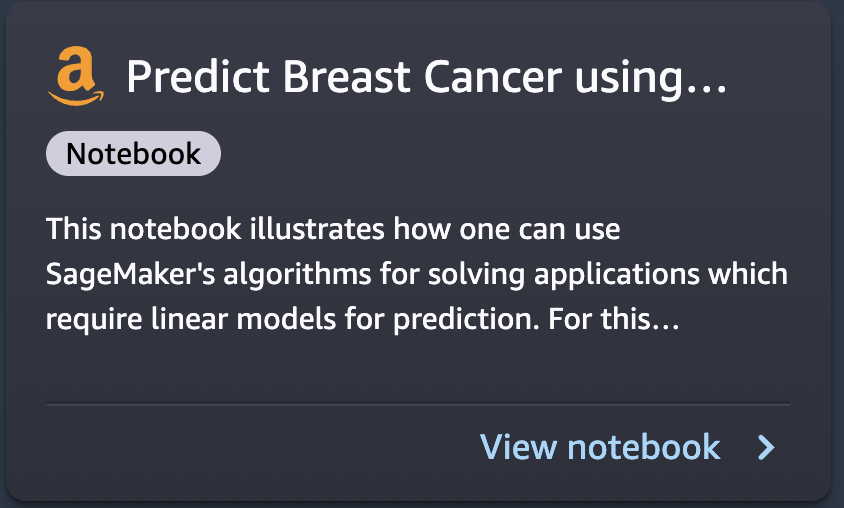

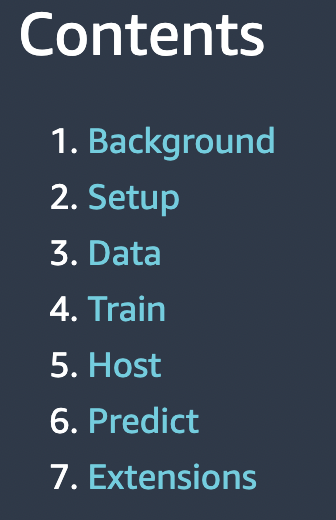

Forutsigelse av brystkreft

Denne notatboken tar et eksempel for brystkreftprediksjon ved å bruke UCIs diagnostiske datasett for brystkreft. Den bruker dette datasettet til å bygge en prediktiv modell av om et brystmassebilde indikerer en godartet eller ondartet svulst.

|

|

Notatboken viser følgende:

- Grunnleggende oppsett for bruk av SageMaker

- Konvertering av datasett til Protobuf-format brukt av SageMaker-algoritmene og opplasting til Amazon enkel lagringstjeneste (Amazon S3)

- Trening av en SageMaker lineær elevmodell på datasettet

- Vert for den trente modellen

- Scoring ved hjelp av den trente modellen

Du kan gå gjennom denne notatboken for å lære hvordan du løser et forretningsproblem ved å bruke SageMaker, og forstå trinnene som er involvert for opplæring og vert for en modell.

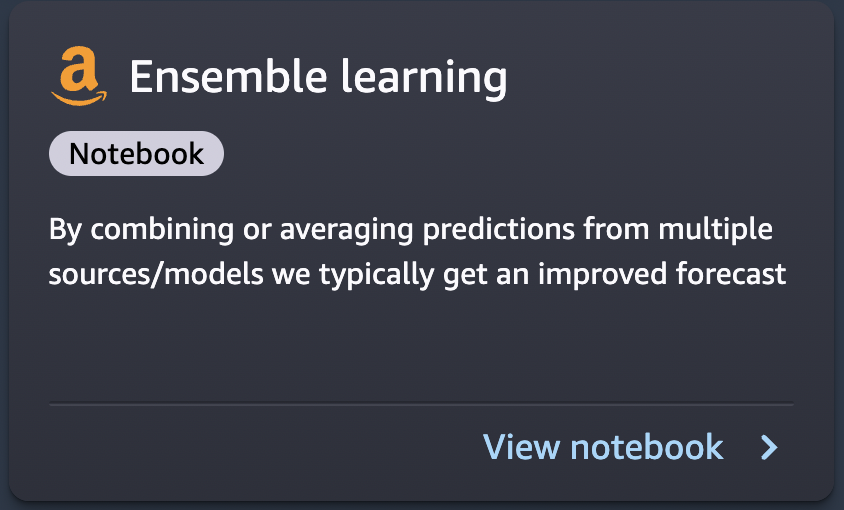

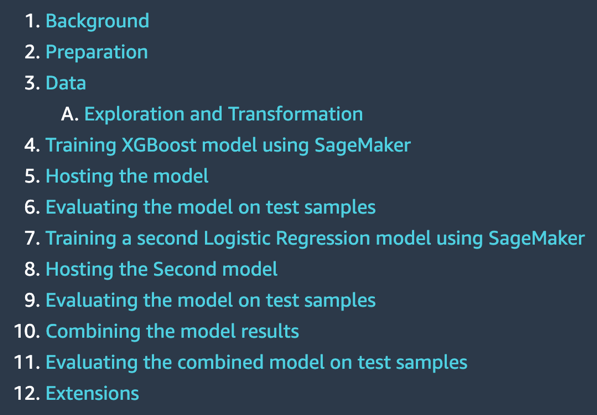

Ensemblespådommer fra flere modeller

I praktiske anvendelser av ML på prediktive oppgaver, er en modell ofte ikke tilstrekkelig. De fleste prediksjonskonkurranser krever vanligvis å kombinere prognoser fra flere kilder for å få en forbedret prognose. Ved å kombinere eller gjennomsnittsberegne spådommer fra flere kilder eller modeller, får vi vanligvis en forbedret prognose. Dette skjer fordi det er betydelig usikkerhet i valget av modell, og det er ingen sann modell i mange praktiske anvendelser. Derfor er det gunstig å kombinere spådommer fra forskjellige modeller. I den Bayesianske litteraturen omtales denne ideen som Bayesiansk modellgjennomsnitt, og har vist seg å fungere mye bedre enn å bare velge én modell.

Denne notatboken presenterer et illustrerende eksempel for å forutsi om en person tjener over $50,000 XNUMX i året basert på informasjon om utdanning, arbeidserfaring, kjønn og mer.

|

|

Notatboken viser følgende:

- Klargjøring av SageMaker-notisboken

- Laster et datasett fra Amazon S3 ved hjelp av SageMaker

- Undersøker og transformerer dataene slik at de kan mates til SageMaker-algoritmer

- Estimere en modell ved å bruke SageMaker XGBoost (Extreme Gradient Boosting) algoritmen

- Hosting av modellen på SageMaker for å lage løpende spådommer

- Estimere en annen modell ved å bruke SageMaker lineære læremetode

- Kombinere spådommene fra begge modellene og evaluere den kombinerte prediksjonen

- Generer endelige spådommer på testdatasettet

Prøv å kjøre denne notatboken på datasettet ditt og bruk flere algoritmer. Prøv å eksperimentere med ulike kombinasjoner av modeller som tilbys av SageMaker og JumpStart og se hvilken kombinasjon av modellsammensetning som gir best resultat på dine egne data.

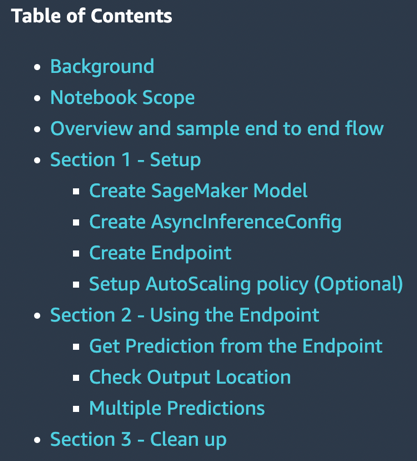

SageMaker asynkron inferens

SageMaker asynkron inferens er en ny funksjon i SageMaker som setter innkommende forespørsler i kø og behandler dem asynkront. SageMaker tilbyr for tiden to slutningsalternativer for kunder for å distribuere ML-modeller: et sanntidsalternativ for arbeidsbelastninger med lav latens, og batch-transformasjon, et offline-alternativ for å behandle slutningsforespørsler på grupper med data tilgjengelig på forhånd. Sanntidsslutning er egnet for arbeidsbelastninger med nyttelaststørrelser på mindre enn 6 MB og krever at slutningsforespørsler behandles innen 60 sekunder. Batch-transformasjon er egnet for offline slutninger om batcher med data.

Asynkron inferens er et nytt inferensalternativ for inferensbehov i nesten sanntid. Forespørsler kan ta opptil 15 minutter å behandle og har nyttelaststørrelser på opptil 1 GB. Asynkron inferens er egnet for arbeidsbelastninger som ikke har krav til sekundær latens og har avslappede latenskrav. Det kan for eksempel hende du må behandle en slutning om et stort bilde på flere MB innen 5 minutter. I tillegg lar asynkrone slutningsendepunkter deg kontrollere kostnadene ved å nedskalere endepunktforekomsttellingen til null når de er inaktive, slik at du bare betaler når endepunktene dine behandler forespørsler.

|

|

Notatboken viser følgende:

- Opprette en SageMaker-modell

- Opprette et endepunkt ved å bruke denne modellen og konfigurasjon av asynkron slutning

- Gjør spådommer mot dette asynkrone endepunktet

Denne notatboken viser deg et fungerende eksempel på å sette sammen et asynkront endepunkt for en SageMaker-modell.

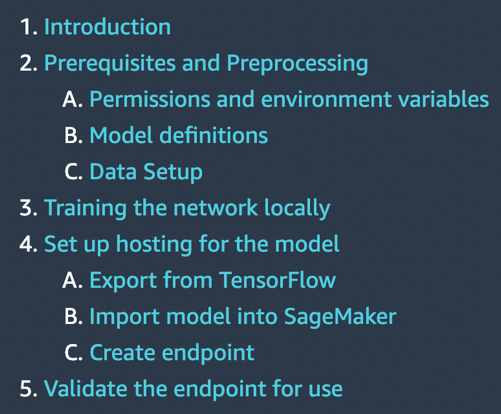

TensorFlow ta med din egen modell

En TensorFlow-modell trenes lokalt på en klassifiseringsoppgave der denne bærbare datamaskinen kjøres. Deretter distribueres den på et SageMaker-endepunkt.

|

|

Notatboken viser følgende:

- Trening av en TensorFlow-modell lokalt på IRIS-datasettet

- Importerer den modellen til SageMaker

- Hoster den på et endepunkt

Hvis du har TensorFlow-modeller som du har utviklet selv, kan denne eksempelnotisboken hjelpe deg med å være vert for modellen på et SageMaker-administrert endepunkt.

Scikit-lear ta med din egen modell

SageMaker inkluderer funksjonalitet for å støtte et vertsbasert bærbart miljø, distribuert, serverløs opplæring og sanntidsvert. Det fungerer best når alle disse tre tjenestene brukes sammen, men de kan også brukes uavhengig. Noen brukstilfeller krever kanskje bare hosting. Kanskje modellen ble opplært før SageMaker eksisterte, i en annen tjeneste.

Notatboken viser følgende:

- Bruke en forhåndstrent Scikit-learn-modell med SageMaker Scikit-learn-beholderen for raskt å lage et vertsbasert endepunkt for den modellen

Hvis du har Scikit-learn-modeller som du har utviklet selv, kan denne eksempelnotisboken hjelpe deg med å være vert for modellen din på et SageMaker-administrert endepunkt.

Rydd opp i ressursene

Når du er ferdig med å kjøre en notatbok i JumpStart, sørg for å gjøre det Slett alle ressurser slik at alle ressursene du opprettet i prosessen slettes og faktureringen stoppes. Den siste cellen i disse notatbøkene sletter vanligvis endepunkter som er opprettet.

Oppsummering

Dette innlegget ledet deg gjennom 10 nye eksempelnotatbøker som nylig ble lagt til JumpStart. Selv om dette innlegget fokuserte på disse 10 nye notatbøkene, er det totalt 56 tilgjengelige notatbøker når dette skrives. Vi oppfordrer deg til å logge på Studio og utforske JumpStart-notatbøkene selv, og begynne å hente umiddelbar verdi ut av dem. For mer informasjon, se Amazon SageMaker Studio og SageMaker JumpStart.

om forfatteren

Dr. Raju Penmatcha er en AI/ML Specialist Solutions Architect i AI-plattformer ved AWS. Han fikk sin doktorgrad fra Stanford University. Han jobber tett på suitetjenestene med lav/ingen kode i SageMaker som hjelper kunder med å enkelt bygge og distribuere maskinlæringsmodeller og -løsninger.

Dr. Raju Penmatcha er en AI/ML Specialist Solutions Architect i AI-plattformer ved AWS. Han fikk sin doktorgrad fra Stanford University. Han jobber tett på suitetjenestene med lav/ingen kode i SageMaker som hjelper kunder med å enkelt bygge og distribuere maskinlæringsmodeller og -løsninger.

- AI

- ai kunst

- ai art generator

- du har en robot

- Amazon SageMaker

- Amazon SageMaker JumpStart

- kunstig intelligens

- sertifisering av kunstig intelligens

- kunstig intelligens i bankvirksomhet

- kunstig intelligens robot

- kunstig intelligens roboter

- programvare for kunstig intelligens

- AWS maskinlæring

- blockchain

- blockchain konferanse ai

- coingenius

- samtale kunstig intelligens

- kryptokonferanse ai

- dall sin

- dyp læring

- google det

- maskinlæring

- plato

- plato ai

- Platon Data Intelligence

- Platon spill

- PlatonData

- platogaming

- skala ai

- syntaks

- zephyrnet