Når organisasjoner distribuerer modeller til produksjon, leter de hele tiden etter måter å optimalisere ytelsen til grunnmodellene deres (FM-er) som kjører på de nyeste akseleratorene, som f.eks. AWS slutning og GPUer, slik at de kan redusere kostnadene og redusere responsforsinkelsen for å gi den beste opplevelsen til sluttbrukerne. Noen FM-er bruker imidlertid ikke fullt ut akseleratorene som er tilgjengelige med forekomstene de er distribuert på, noe som fører til ineffektiv bruk av maskinvareressurser. Noen organisasjoner distribuerer flere FM-er til samme instans for å bedre utnytte alle tilgjengelige akseleratorer, men dette krever kompleks infrastrukturorkestrering som er tidkrevende og vanskelig å administrere. Når flere FM-er deler samme instans, har hver FM sine egne skaleringsbehov og bruksmønstre, noe som gjør det utfordrende å forutsi når du trenger å legge til eller fjerne instanser. For eksempel kan én modell brukes til å drive en brukerapplikasjon der bruken kan øke i løpet av visse timer, mens en annen modell kan ha et mer konsistent bruksmønster. I tillegg til å optimalisere kostnadene, ønsker kundene å gi den beste sluttbrukeropplevelsen ved å redusere ventetiden. For å gjøre dette distribuerer de ofte flere kopier av en FM til feltforespørsler fra brukere parallelt. Fordi FM-utganger kan variere fra en enkelt setning til flere avsnitt, varierer tiden det tar å fullføre slutningsforespørselen betydelig, noe som fører til uforutsigbare spiker i ventetiden hvis forespørslene rutes tilfeldig mellom instanser. Amazon SageMaker støtter nå nye slutningsfunksjoner som hjelper deg med å redusere distribusjonskostnader og ventetid.

Du kan nå lage inferenskomponentbaserte endepunkter og distribuere maskinlæringsmodeller (ML) til et SageMaker-endepunkt. En inferenskomponent (IC) abstraherer ML-modellen din og lar deg tilordne CPUer, GPU eller AWS nevron akseleratorer og skaleringspolicyer per modell. Inferenskomponenter gir følgende fordeler:

- SageMaker vil optimalt plassere og pakke modeller på ML-instanser for å maksimere utnyttelsen, noe som fører til kostnadsbesparelser.

- SageMaker vil skalere hver modell opp og ned basert på konfigurasjonen din for å møte kravene til ML-applikasjonen.

- SageMaker vil skalere for å legge til og fjerne forekomster dynamisk for å sikre at kapasiteten er tilgjengelig samtidig som inaktiv databehandling holdes på et minimum.

- Du kan skalere ned til null kopier av en modell for å frigjøre ressurser for andre modeller. Du kan også angi at viktige modeller alltid skal være lastet og klare til å betjene trafikk.

Med disse egenskapene kan du redusere kostnadene for modellimplementering med 50 % i gjennomsnitt. Kostnadsbesparelsene vil variere avhengig av arbeidsbelastning og trafikkmønster. La oss ta et enkelt eksempel for å illustrere hvordan pakking av flere modeller på ett enkelt endepunkt kan maksimere utnyttelsen og spare kostnader. La oss si at du har en chat-applikasjon som hjelper turister å forstå lokale skikker og beste praksis bygget ved hjelp av to varianter av Llama 2: en finjustert for europeiske besøkende og den andre finjustert for amerikanske besøkende. Vi forventer trafikk for den europeiske modellen mellom 00:01–11:59 UTC og den amerikanske modellen mellom 12:00–23:59 UTC. I stedet for å distribuere disse modellene på sine egne dedikerte forekomster der de vil sitte inaktiv halve tiden, kan du nå distribuere dem på ett enkelt endepunkt for å spare kostnader. Du kan skalere ned den amerikanske modellen til null når det ikke er nødvendig for å frigjøre kapasitet for den europeiske modellen og omvendt. Dette lar deg bruke maskinvaren din effektivt og unngå sløsing. Dette er et enkelt eksempel med to modeller, men du kan enkelt utvide denne ideen til å pakke hundrevis av modeller på ett enkelt endepunkt som automatisk skaleres opp og ned med arbeidsmengden din.

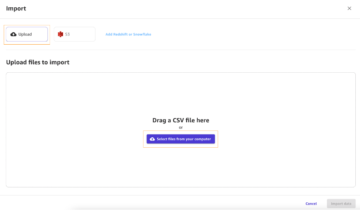

I dette innlegget viser vi deg de nye egenskapene til IC-baserte SageMaker-endepunkter. Vi veileder deg også gjennom distribusjon av flere modeller ved hjelp av inferenskomponenter og APIer. Til slutt beskriver vi noen av de nye observerbarhetsmulighetene og hvordan du setter opp retningslinjer for automatisk skalering for modellene dine og administrerer forekomstskalering for endepunktene dine. Du kan også distribuere modeller gjennom vår nye forenklede, interaktive brukeropplevelse. Vi støtter også avanserte rutingfunksjoner for å optimalisere ventetiden og ytelsen til arbeidsbelastningene dine.

Byggeklosser

La oss ta en dypere titt og forstå hvordan disse nye funksjonene fungerer. Følgende er litt ny terminologi for SageMaker-hosting:

- Inferenskomponent – Et SageMaker-vertsobjekt som du kan bruke til å distribuere en modell til et endepunkt. Du kan opprette en slutningskomponent ved å oppgi følgende:

- SageMaker-modellen eller spesifikasjonen til et SageMaker-kompatibelt bilde og modellartefakter.

- Beregn ressurskrav, som spesifiserer behovene til hver kopi av modellen din, inkludert CPU-kjerner, vertsminne og antall akseleratorer.

- Modelleksemplar – En kjøretidskopi av en inferenskomponent som er i stand til å betjene forespørsler.

- Administrert forekomst automatisk skalering – En SageMaker-vertsfunksjon for å skalere opp eller ned antallet beregningsforekomster som brukes for et endepunkt. Forekomstskalering reagerer på skaleringen av inferenskomponenter.

For å lage en ny slutningskomponent kan du spesifisere et beholderbilde og en modellartefakt, eller du kan bruke SageMaker-modeller som du kanskje allerede har opprettet. Du må også spesifisere dataressurskravene, for eksempel antall verts-CPU-kjerner, vertsminne eller antall akseleratorer modellen din trenger for å kjøre.

Når du distribuerer en inferenskomponent, kan du spesifisere MinCopies for å sikre at modellen allerede er lastet inn i det antallet du trenger, klar til å betjene forespørsler.

Du har også muligheten til å angi policyene dine slik at inferenskomponenten kopierer skaleres til null. For eksempel, hvis du ikke har noen last som kjører mot en IC, vil modellkopien bli lastet ut. Dette kan frigjøre ressurser som kan erstattes av aktive arbeidsbelastninger for å optimalisere utnyttelsen og effektiviteten til endepunktet ditt.

Ettersom slutningsforespørsler øker eller reduseres, kan antallet kopier av IC-ene dine også skaleres opp eller ned basert på retningslinjene for automatisk skalering. SageMaker vil håndtere plasseringen for å optimalisere pakkingen av modellene dine for tilgjengelighet og kostnad.

I tillegg, hvis du aktiverer administrert forekomst automatisk skalering, vil SageMaker skalere beregningsforekomster i henhold til antall inferenskomponenter som må lastes på et gitt tidspunkt for å betjene trafikk. SageMaker vil skalere opp forekomstene og pakke forekomstene og slutningskomponentene dine for å optimalisere for kostnadene og samtidig bevare modellytelsen. Selv om vi anbefaler bruk av administrert forekomstskalering, har du også muligheten til å administrere skaleringen selv, dersom du velger det, gjennom automatisk skalering av applikasjoner.

SageMaker vil rebalansere inferenskomponenter og skalere ned forekomstene hvis de ikke lenger er nødvendige av inferenskomponenter og spare kostnadene dine.

Gjennomgang av APIer

SageMaker har introdusert en ny enhet kalt InferenceComponent. Dette frikobler detaljene ved å være vert for ML-modellen fra selve endepunktet. De InferenceComponent lar deg spesifisere nøkkelegenskaper for å være vert for modellen som SageMaker-modellen du vil bruke eller beholderdetaljene og modellartefakter. Du spesifiserer også antall kopier av selve komponentene som skal distribueres, og antall akseleratorer (GPU-er, Inf- eller Trn-akseleratorer) eller CPU (vCPU-er) som kreves. Dette gir deg mer fleksibilitet til å bruke ett enkelt endepunkt for et hvilket som helst antall modeller du planlegger å distribuere til det i fremtiden.

La oss se på Boto3 API-kallene for å lage et endepunkt med en inferenskomponent. Merk at det er noen parametere som vi tar for oss senere i dette innlegget.

Følgende er eksempelkode for CreateEndpointConfig:

Følgende er eksempelkode for CreateEndpoint:

Følgende er eksempelkode for CreateInferenceComponent:

Denne frakoblingen av InferenceComponent til et endepunkt gir fleksibilitet. Du kan være vert for flere modeller på samme infrastruktur, legge til eller fjerne dem etter hvert som kravene endres. Hver modell kan oppdateres uavhengig etter behov. I tillegg kan du skalere modeller i henhold til bedriftens behov. InferenceComponent lar deg også kontrollere kapasiteten per modell. Du kan med andre ord bestemme hvor mange eksemplarer av hver modell du skal være vert for. Denne forutsigbare skaleringen hjelper deg med å møte de spesifikke latenskravene for hver modell. Alt i alt, InferenceComponent gir deg mye mer kontroll over de vertsbaserte modellene dine.

I tabellen nedenfor viser vi en side-ved-side-sammenligning av tilnærmingen på høyt nivå for å opprette og påkalle et endepunkt uten InferenceComponent og med InferenceComponent. Merk at CreateModel() nå er valgfritt for IC-baserte endepunkter.

| Trinn | Modellbaserte endepunkter | Inferenskomponentbaserte endepunkter |

| 1 | Opprett modell(...) | CreateEndpointConfig(...) |

| 2 | CreateEndpointConfig(...) | Opprett endepunkt(...) |

| 3 | Opprett endepunkt(...) | CreateInferenceComponent(...) |

| 4 | InvokeEndpoint(...) | InvokeEndpoint(InferneceComponentName='value'...) |

Innføringen av InferenceComponent lar deg skalere på modellnivå. Se Gå inn i instans- og IC-automatisk skalering for mer informasjon om hvordan InferenceComponent fungerer med automatisk skalering.

Når du påkaller SageMaker-endepunktet, kan du nå spesifisere den nye parameteren InferenceComponentName å treffe ønsket InferenceComponentName. SageMaker vil håndtere ruting av forespørselen til instansen som er vert for den forespurte InferenceComponentName. Se følgende kode:

Som standard bruker SageMaker tilfeldig ruting av forespørslene til forekomstene som støtter endepunktet ditt. Hvis du vil aktivere ruting av minst utestående forespørsler, kan du angi rutingstrategien i endepunktkonfigurasjonens RoutingConfig:

Minst utestående forespørsler dirigerer ruter til de spesifikke forekomstene som har større kapasitet til å behandle forespørsler. Dette vil gi mer enhetlig lastbalansering og ressursutnyttelse.

I tillegg til CreateInferenceComponent, er følgende APIer nå tilgjengelige:

DescribeInferenceComponentDeleteInferenceComponentUpdateInferenceComponentListInferenceComponents

InferenceComponent logger og beregninger

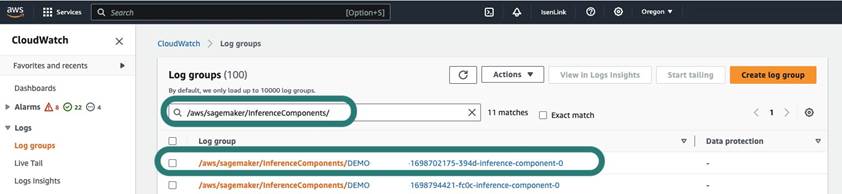

InferenceComponent logger er plassert i /aws/sagemaker/InferenceComponents/<InferenceComponentName>. Alle logger som sendes til stderr og stdout i containeren sendes til disse innloggingene Amazon CloudWatch.

Med introduksjonen av IC-baserte endepunkter har du nå muligheten til å se flere forekomstberegninger, slutningskomponentberegninger og invokasjonsberegninger.

For SageMaker-forekomster kan du nå spore GPUReservation og CPUReservation beregninger for å se ressursene som er reservert for et endepunkt basert på inferenskomponentene du har distribuert. Disse beregningene kan hjelpe deg med størrelsen på retningslinjene for endepunkt og automatisk skalering. Du kan også se de samlede beregningene knyttet til alle modellene som er distribuert til et endepunkt.

SageMaker avslører også beregninger på et inferenskomponentnivå, som kan vise en mer detaljert oversikt over bruken av ressurser for inferenskomponentene du har distribuert. Dette lar deg få en oversikt over hvor mye samlet ressursutnyttelse som f.eks GPUUtilizationNormalized og GPUMemoryUtilizationNormalized for hver inferenskomponent du har distribuert som kan ha null eller mange kopier.

Til slutt tilbyr SageMaker påkallingsmålinger, som nå sporer påkallinger for slutningskomponenter samlet (Invocations) eller per eksemplar instansiert (InvocationsPerCopy)

For en omfattende liste over beregninger, se SageMaker Endpoint Invocation Metrics.

Automatisk skalering på modellnivå

For å implementere den automatiske skaleringsatferden vi beskrev, når du oppretter SageMaker-endepunktkonfigurasjonen og inferenskomponenten, definerer du henholdsvis det første antallet forekomster og det første antallet kopimodeller. Etter at du har opprettet endepunktet og tilsvarende IC-er, for å bruke automatisk skalering på IC-nivå, må du først registrere skaleringsmålet og deretter knytte skaleringspolicyen til IC.

Ved implementering av skaleringspolitikken bruker vi SageMakerInferenceComponentInvocationsPerCopy, som er en ny beregning introdusert av SageMaker. Den fanger opp gjennomsnittlig antall påkallinger per modelleksemplar per minutt.

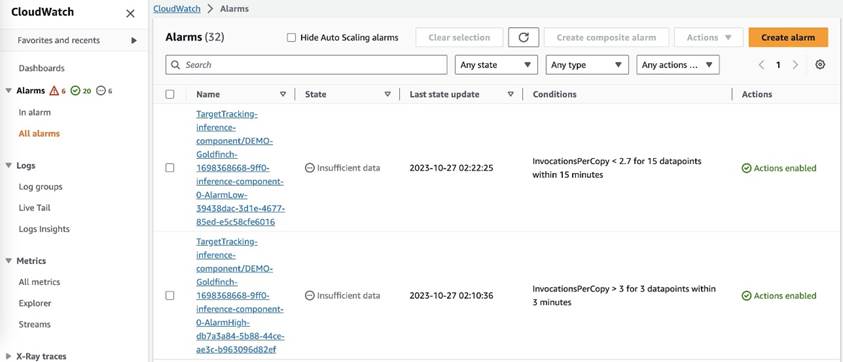

Etter at du har angitt skaleringspolicyen, oppretter SageMaker to CloudWatch-alarmer for hvert autoskaleringsmål: en for å utløse utskalering ved alarm i 3 minutter (tre 1-minutters datapunkter) og en for å utløse skalering hvis den er i alarm i 15 minutter (15 1-minutters datapunkter), som vist i følgende skjermbilde. Tiden for å utløse skaleringshandlingen er vanligvis 1–2 minutter lenger enn disse minuttene fordi det tar tid før endepunktet publiserer beregninger til CloudWatch, og det tar også tid for AutoScaling å reagere. Nedkjølingsperioden er hvor lang tid, i sekunder, etter at en inn- eller utskaleringsaktivitet er fullført før en annen utskaleringsaktivitet kan starte. Hvis nedskaleringsnedkjølingen er kortere enn oppdateringstiden for endepunkt, har det ingen effekt, fordi det ikke er mulig å oppdatere et SageMaker-endepunkt når det er i Oppdatering status.

Merk at når du konfigurerer automatisk skalering på IC-nivå, må du sørge for at MaxInstanceCount parameteren er lik eller mindre enn det maksimale antallet IC-er som dette endepunktet kan håndtere. For eksempel, hvis endepunktet ditt bare er konfigurert til å ha én forekomst i endepunktkonfigurasjonen og denne forekomsten bare kan være vert for maksimalt fire kopier av modellen, vil MaxInstanceCount skal være lik eller mindre enn 4. Du kan imidlertid også bruke funksjonen for administrert automatisk skalering som tilbys av SageMaker for å automatisk skalere antall forekomster basert på det nødvendige kopinummeret for modell for å oppfylle behovet for flere dataressurser. Følgende kodebit viser hvordan du konfigurerer administrert forekomstskalering under opprettelsen av endepunktkonfigurasjonen. På denne måten, når den automatiske skaleringen på IC-nivå krever mer forekomsttelling for å være vert for modellkopiene, vil SageMaker automatisk skalere ut forekomstnummeret for å la skaleringen på IC-nivå bli vellykket.

Du kan bruke flere retningslinjer for automatisk skalering mot samme endepunkt, noe som betyr at du vil kunne bruke den tradisjonelle retningslinjen for automatisk skalering på endepunktene som er opprettet med IC-er og skalere opp og ned basert på de andre endepunktberegningene. For mer informasjon, se Optimaliser maskinlæringsdistribusjonene dine med automatisk skalering på Amazon SageMaker. Men selv om dette er mulig, anbefaler vi fortsatt å bruke administrert forekomstskalering fremfor å administrere skaleringen selv.

konklusjonen

I dette innlegget introduserte vi en ny funksjon i SageMaker inference som vil hjelpe deg med å maksimere utnyttelsen av dataforekomster, skalere til hundrevis av modeller og optimere kostnadene, samtidig som du gir forutsigbar ytelse. Videre ga vi en gjennomgang av API-ene og viste deg hvordan du konfigurerer og distribuerer inferenskomponenter for arbeidsbelastningene dine.

Vi støtter også avanserte rutingfunksjoner for å optimalisere ventetiden og ytelsen til arbeidsbelastningene dine. SageMaker kan hjelpe deg med å optimalisere arbeidsbelastningene dine for kostnader og ytelse og gi deg granularitet på modellnivå for administrasjon. Vi har laget en sett med notatbøker som vil vise deg hvordan du distribuerer tre forskjellige modeller, bruker forskjellige beholdere og bruker retningslinjer for automatisk skalering i GitHub. Vi oppfordrer deg til å begynne med notebook 1 og komme i gang med de nye SageMaker-vertsmulighetene i dag!

Om forfatterne

James Park er løsningsarkitekt hos Amazon Web Services. Han jobber med Amazon.com for å designe, bygge og distribuere teknologiløsninger på AWS, og har en spesiell interesse for AI og maskinlæring. På fritiden liker han å oppsøke nye kulturer, nye opplevelser og holde seg oppdatert med de nyeste teknologitrendene. Du kan finne ham på Linkedin.

James Park er løsningsarkitekt hos Amazon Web Services. Han jobber med Amazon.com for å designe, bygge og distribuere teknologiløsninger på AWS, og har en spesiell interesse for AI og maskinlæring. På fritiden liker han å oppsøke nye kulturer, nye opplevelser og holde seg oppdatert med de nyeste teknologitrendene. Du kan finne ham på Linkedin.

Melanie Li, PhD, er en senior AI/ML-spesialist TAM ved AWS med base i Sydney, Australia. Hun hjelper bedriftskunder med å bygge løsninger ved hjelp av toppmoderne AI/ML-verktøy på AWS og gir veiledning om arkitektur og implementering av ML-løsninger med beste praksis. På fritiden elsker hun å utforske naturen og tilbringe tid med familie og venner.

Melanie Li, PhD, er en senior AI/ML-spesialist TAM ved AWS med base i Sydney, Australia. Hun hjelper bedriftskunder med å bygge løsninger ved hjelp av toppmoderne AI/ML-verktøy på AWS og gir veiledning om arkitektur og implementering av ML-løsninger med beste praksis. På fritiden elsker hun å utforske naturen og tilbringe tid med familie og venner.

Marc Karp er en ML-arkitekt med Amazon SageMaker Service-teamet. Han fokuserer på å hjelpe kunder med å designe, distribuere og administrere ML-arbeidsmengder i stor skala. På fritiden liker han å reise og utforske nye steder.

Marc Karp er en ML-arkitekt med Amazon SageMaker Service-teamet. Han fokuserer på å hjelpe kunder med å designe, distribuere og administrere ML-arbeidsmengder i stor skala. På fritiden liker han å reise og utforske nye steder.

Alan Tan er en senior produktsjef hos SageMaker, og leder innsatsen for store modellslutninger. Han brenner for å bruke maskinlæring på analyseområdet. Utenom jobben liker han å være ute.

Alan Tan er en senior produktsjef hos SageMaker, og leder innsatsen for store modellslutninger. Han brenner for å bruke maskinlæring på analyseområdet. Utenom jobben liker han å være ute.

Raghu Ramesha er senior ML Solutions Architect med Amazon SageMaker Service-teamet. Han fokuserer på å hjelpe kunder med å bygge, distribuere og migrere ML-produksjonsarbeidsmengder til SageMaker i stor skala. Han spesialiserer seg på maskinlæring, AI og datasynsdomener, og har en mastergrad i informatikk fra UT Dallas. På fritiden liker han å reise og fotografere.

Raghu Ramesha er senior ML Solutions Architect med Amazon SageMaker Service-teamet. Han fokuserer på å hjelpe kunder med å bygge, distribuere og migrere ML-produksjonsarbeidsmengder til SageMaker i stor skala. Han spesialiserer seg på maskinlæring, AI og datasynsdomener, og har en mastergrad i informatikk fra UT Dallas. På fritiden liker han å reise og fotografere.

Rupinder Grewal er en Sr Ai/ML spesialistløsningsarkitekt med AWS. Han fokuserer for tiden på servering av modeller og MLOps på SageMaker. Før denne rollen har han jobbet som maskinlæringsingeniør med å bygge og hoste modeller. Utenom jobben liker han å spille tennis og sykle på fjellstier.

Rupinder Grewal er en Sr Ai/ML spesialistløsningsarkitekt med AWS. Han fokuserer for tiden på servering av modeller og MLOps på SageMaker. Før denne rollen har han jobbet som maskinlæringsingeniør med å bygge og hoste modeller. Utenom jobben liker han å spille tennis og sykle på fjellstier.

Dhawal Patel er en hovedmaskinlæringsarkitekt ved AWS. Han har jobbet med organisasjoner som spenner fra store bedrifter til mellomstore startups med problemer knyttet til distribuert databehandling og kunstig intelligens. Han fokuserer på dyp læring inkludert NLP- og Computer Vision-domener. Han hjelper kundene med å oppnå høy ytelse modellslutning på SageMaker.

Dhawal Patel er en hovedmaskinlæringsarkitekt ved AWS. Han har jobbet med organisasjoner som spenner fra store bedrifter til mellomstore startups med problemer knyttet til distribuert databehandling og kunstig intelligens. Han fokuserer på dyp læring inkludert NLP- og Computer Vision-domener. Han hjelper kundene med å oppnå høy ytelse modellslutning på SageMaker.

Saurabh Trikande er senior produktsjef for Amazon SageMaker Inference. Han brenner for å jobbe med kunder og er motivert av målet om å demokratisere maskinlæring. Han fokuserer på kjerneutfordringer knyttet til distribusjon av komplekse ML-applikasjoner, multi-tenant ML-modeller, kostnadsoptimaliseringer og å gjøre distribusjon av dyplæringsmodeller mer tilgjengelig. På fritiden liker Saurabh å gå tur, lære om innovative teknologier, følge TechCrunch og tilbringe tid med familien.

Saurabh Trikande er senior produktsjef for Amazon SageMaker Inference. Han brenner for å jobbe med kunder og er motivert av målet om å demokratisere maskinlæring. Han fokuserer på kjerneutfordringer knyttet til distribusjon av komplekse ML-applikasjoner, multi-tenant ML-modeller, kostnadsoptimaliseringer og å gjøre distribusjon av dyplæringsmodeller mer tilgjengelig. På fritiden liker Saurabh å gå tur, lære om innovative teknologier, følge TechCrunch og tilbringe tid med familien.

Lakshmi Ramakrishnan er hovedingeniør i Amazon SageMaker Machine Learning (ML) plattformteam i AWS, og gir teknisk ledelse for produktet. Han har jobbet i flere ingeniørroller i Amazon i over 9 år. Han har en Bachelor of Engineering grad i informasjonsteknologi fra National Institute of Technology, Karnataka, India og en Master of Science grad i informatikk fra University of Minnesota Twin Cities.

Lakshmi Ramakrishnan er hovedingeniør i Amazon SageMaker Machine Learning (ML) plattformteam i AWS, og gir teknisk ledelse for produktet. Han har jobbet i flere ingeniørroller i Amazon i over 9 år. Han har en Bachelor of Engineering grad i informasjonsteknologi fra National Institute of Technology, Karnataka, India og en Master of Science grad i informatikk fra University of Minnesota Twin Cities.

David Nigenda er en senior programvareutviklingsingeniør på Amazon SageMaker-teamet, og jobber for tiden med å forbedre arbeidsflyter for maskinlæring i produksjon, samt lanserer nye inferensfunksjoner. På fritiden prøver han å holde tritt med barna sine.

David Nigenda er en senior programvareutviklingsingeniør på Amazon SageMaker-teamet, og jobber for tiden med å forbedre arbeidsflyter for maskinlæring i produksjon, samt lanserer nye inferensfunksjoner. På fritiden prøver han å holde tritt med barna sine.

- SEO-drevet innhold og PR-distribusjon. Bli forsterket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk deg selv. Tilgang her.

- PlatoAiStream. Web3 Intelligence. Kunnskap forsterket. Tilgang her.

- PlatoESG. Karbon, CleanTech, Energi, Miljø, Solenergi, Avfallshåndtering. Tilgang her.

- PlatoHelse. Bioteknologisk og klinisk etterretning. Tilgang her.

- kilde: https://aws.amazon.com/blogs/machine-learning/reduce-model-deployment-costs-by-50-on-average-using-sagemakers-latest-features/

- : har

- :er

- :ikke

- :hvor

- $OPP

- 1

- 10

- 100

- 114

- 12

- 13

- 15%

- 150

- 16

- 22

- 360

- 362

- 500

- 7

- 9

- a

- evne

- I stand

- Om oss

- sammendrag

- akseleratorer

- tilgjengelig

- Ifølge

- Oppnå

- Handling

- aktiv

- aktivitet

- legge til

- legge

- tillegg

- Ytterligere

- I tillegg

- adresse

- avansert

- Etter

- mot

- aggregat

- AI

- AI / ML

- Alan

- alarm

- Alle

- tillate

- tillater

- allerede

- også

- Selv

- alltid

- Amazon

- Amazon SageMaker

- Amazon Web Services

- Amazon.com

- amerikansk

- beløp

- an

- analytics

- og

- En annen

- noen

- api

- APIer

- Søknad

- søknader

- Påfør

- påføring

- tilnærming

- ER

- AREA

- kunstig

- kunstig intelligens

- AS

- Førsteamanuensis

- assosiert

- At

- Australia

- auto

- automatisk

- tilgjengelighet

- tilgjengelig

- gjennomsnittlig

- unngå

- AWS

- backing

- basert

- BE

- fordi

- før du

- atferd

- Fordeler

- BEST

- beste praksis

- Bedre

- mellom

- bygge

- Bygning

- bygget

- virksomhet

- men

- by

- som heter

- Samtaler

- CAN

- evner

- evne

- stand

- Kapasitet

- fanger

- viss

- utfordringer

- utfordrende

- endring

- Velg

- Byer

- kode

- COM

- sammenligning

- fullføre

- Fullfører

- komplekse

- komponent

- komponenter

- omfattende

- Beregn

- datamaskin

- informatikk

- Datamaskin syn

- databehandling

- Konfigurasjon

- konfigurert

- konsistent

- stadig

- tidkrevende

- Container

- Containere

- kontroll

- Kjerne

- Tilsvarende

- Kostnad

- kostnadsbesparelser

- Kostnader

- kunne

- skape

- opprettet

- skaper

- Opprette

- skaperverket

- I dag

- Kunder

- toll

- Dallas

- dato

- datapunkter

- Dato

- redusere

- dedikert

- dyp

- dyp læring

- dypere

- Misligholde

- definere

- Grad

- dybden

- Demokratisering

- demonstrerer

- avhengig

- utplassere

- utplassert

- utplasserings

- distribusjon

- distribusjoner

- beskrevet

- utforming

- ønsket

- detalj

- detaljer

- Bestem

- Utvikling

- forskjellig

- vanskelig

- distribueres

- distribuert databehandling

- do

- domener

- ikke

- ned

- under

- dynamisk

- hver enkelt

- lett

- effekt

- effektivitet

- effektivt

- innsats

- muliggjøre

- aktivert

- muliggjør

- oppmuntre

- Endpoint

- ingeniør

- Ingeniørarbeid

- sikre

- Enterprise

- bedrifter

- enhet

- lik

- europeisk

- eksempel

- forvente

- erfaring

- Erfaringer

- utforske

- Utforske

- utvide

- familie

- Trekk

- Egenskaper

- felt

- Finn

- Først

- fleksibilitet

- fokuserer

- etter

- Til

- Fundament

- fire

- Gratis

- venner

- fra

- fullt

- Dess

- framtid

- få

- gif

- GitHub

- Gi

- gitt

- gir

- mål

- GPU

- GPU

- granulær

- veiledning

- Halvparten

- håndtere

- hender

- maskinvare

- Ha

- he

- hjelpe

- hjelpe

- hjelper

- her

- Høy

- høyt nivå

- ham

- hans

- hit

- holder

- vert

- vert

- Hosting

- TIMER

- Hvordan

- Hvordan

- Men

- http

- HTTPS

- Hundrevis

- Tanken

- Idle

- if

- illustrere

- bilde

- iverksette

- implementere

- viktig

- bedre

- in

- I andre

- Inkludert

- Øke

- uavhengig av hverandre

- india

- ineffektiv

- informasjon

- informasjonsteknologi

- Infrastruktur

- innledende

- innovative

- innovative teknologier

- f.eks

- i stedet

- Institute

- Intelligens

- interaktiv

- interesse

- inn

- introdusert

- Introduksjon

- IT

- DET ER

- selv

- jpg

- Hold

- holde

- nøkkel

- kids

- stor

- Store bedrifter

- til slutt

- Ventetid

- seinere

- siste

- lansere

- Ledelse

- ledende

- læring

- minst

- Nivå

- i likhet med

- Liste

- Llama

- laste

- lokal

- ligger

- lenger

- Se

- ser

- elsker

- maskin

- maskinlæring

- gjøre

- Making

- administrer

- fikk til

- ledelse

- leder

- administrerende

- mange

- Master

- mestere

- Maksimer

- maksimal

- Kan..

- midler

- Møt

- Minne

- metrisk

- Metrics

- migrere

- minimum

- minutt

- minutter

- ML

- MLOps

- modell

- modeller

- mer

- motivert

- fjell

- mye

- flere

- nasjonal

- Natur

- Trenger

- nødvendig

- behov

- Ny

- nlp

- Nei.

- note

- bærbare

- nå

- Antall

- objekt

- of

- tilby

- ofte

- on

- ONE

- bare

- videre til

- Optimalisere

- optimalisere

- Alternativ

- or

- orkestre

- organisasjoner

- Annen

- vår

- ut

- utendørs

- utganger

- utenfor

- enestående

- enn

- samlet

- egen

- Pakk med deg

- Parallel

- parameter

- parametere

- Spesielt

- lidenskapelig

- Mønster

- mønstre

- for

- ytelse

- perioden

- phd

- fotografering

- Sted

- plassering

- steder

- fly

- plattform

- plato

- Platon Data Intelligence

- PlatonData

- spiller

- poeng

- Politikk

- politikk

- mulig

- Post

- makt

- praksis

- forutsi

- Forutsigbar

- bevarer

- Principal

- Før

- problemer

- prosess

- Produkt

- Produktsjef

- Produksjon

- egenskaper

- gi

- forutsatt

- gir

- gi

- publisere

- kvantitet

- tilfeldig

- område

- spenner

- Reager

- reagerer

- klar

- rebalansere

- anbefaler

- redusere

- redusere

- referere

- registrere

- i slekt

- fjerne

- fjerne

- erstattet

- anmode

- forespørsler

- krever

- påkrevd

- Krav

- Krever

- reservert

- ressurs

- Ressurser

- henholdsvis

- svar

- Rolle

- roller

- ruter

- ruting

- Kjør

- rennende

- runtime

- sagemaker

- SageMaker Inference

- samme

- Spar

- Besparelser

- sier

- Skala

- vekter

- skalering

- Vitenskap

- sekunder

- se

- søker

- senior

- sendt

- dømme

- betjene

- tjeneste

- Tjenester

- servering

- sett

- innstilling

- flere

- Del

- hun

- bør

- Vis

- viste

- vist

- betydelig

- Enkelt

- forenklet

- enkelt

- sitte

- Størrelse

- mindre

- tekstutdrag

- So

- Software

- programvareutvikling

- Solutions

- noen

- spesialist

- spesialisert

- spesifikk

- spesifikasjon

- bruke

- utgifter

- spike

- pigger

- Begynn

- startups

- state-of-the-art

- status

- blir

- Still

- Strategi

- vellykket

- slik

- forsyne

- støtte

- Støtter

- sikker

- sydney

- bord

- Ta

- tar

- Target

- lag

- TechCrunch

- Teknisk

- Technologies

- Teknologi

- tennis

- terminologi

- enn

- Det

- De

- Området

- Fremtiden

- deres

- Dem

- deretter

- Der.

- Disse

- de

- denne

- De

- tre

- Gjennom

- tid

- til

- verktøy

- spor

- tradisjonelle

- trafikk

- Traveling

- Trender

- utløse

- Twin

- to

- forstå

- universitet

- uforutsigbare

- Oppdater

- oppdatert

- bruk

- bruke

- brukt

- Bruker

- Brukererfaring

- Brukere

- bruker

- ved hjelp av

- vanligvis

- UTC

- bruke

- vice

- Se

- syn

- besøkende

- gå

- walkthrough

- ønsker

- Avfall

- Vei..

- måter

- we

- web

- webtjenester

- VI VIL

- når

- mens

- hvilken

- mens

- vil

- med

- uten

- ord

- Arbeid

- arbeidet

- arbeidsflyt

- arbeid

- virker

- år

- Du

- Din

- deg selv

- zephyrnet

- null