I løpet av de siste årene har nettbaserte utdanningsplattformer sett en økning i bruk av og en økning i etterspørselen etter videobasert læring fordi det tilbyr et effektivt medium for å engasjere elever. For å utvide til internasjonale markeder og adressere en kulturelt og språklig mangfoldig befolkning, ser bedrifter også på å diversifisere læringstilbudene sine ved å lokalisere innhold til flere språk. Disse virksomhetene leter etter pålitelige og kostnadseffektive måter å løse sine lokaliseringsbruk.

Lokalisering av innhold inkluderer hovedsakelig å oversette originale stemmer til nye språk og legge til visuelle hjelpemidler som undertekster. Tradisjonelt er denne prosessen uoverkommelig, manuell og tar mye tid, inkludert samarbeid med lokaliseringsspesialister. Med kraften til AWS maskinlæringstjenester (ML) som f.eks Amazon Transcribe, Amazon Oversettog Amazon Polly, kan du lage en levedyktig og kostnadseffektiv lokaliseringsløsning. Du kan bruke Amazon Transcribe til å lage en transkripsjon av dine eksisterende lyd- og videostrømmer, og deretter oversette denne transkripsjonen til flere språk ved hjelp av Amazon Translate. Du kan deretter bruke Amazon Polly, en tekst-til-tale-tjeneste, til å konvertere den oversatte teksten til naturlig klingende menneskelig tale.

Det neste trinnet med lokalisering er å legge til undertekster til innholdet, noe som kan forbedre tilgjengeligheten og forståelsen, og hjelpe seerne å forstå videoene bedre. Oppretting av undertekster på videoinnhold kan være utfordrende fordi den oversatte talen ikke samsvarer med den opprinnelige taletidspunktet. Denne synkroniseringen mellom lyd og undertekster er en kritisk oppgave å vurdere fordi den kan koble publikum fra innholdet ditt hvis de ikke er synkronisert. Amazon Polly tilbyr en løsning på denne utfordringen gjennom aktivering talemerker, som du kan bruke til å lage en undertekstfil som kan synkroniseres med den genererte taleutgangen.

I dette innlegget gjennomgår vi en lokaliseringsløsning som bruker AWS ML-tjenester der vi bruker en original engelsk video og konverterer den til spansk. Vi fokuserer også på å bruke talemerker for å lage en synkronisert undertekstfil på spansk.

Løsningsoversikt

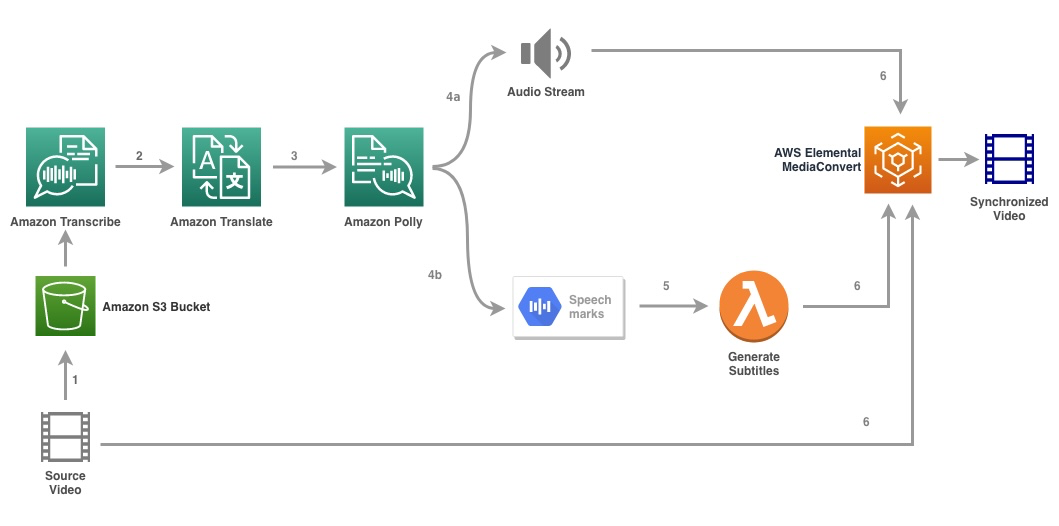

Følgende diagram illustrerer løsningsarkitekturen.

Løsningen tar en videofil og målspråkinnstillingene som input og bruker Amazon Transcribe for å lage en transkripsjon av videoen. Vi bruker deretter Amazon Translate for å oversette transkripsjonen til målspråket. Den oversatte teksten er gitt som en input til Amazon Polly for å generere lydstrømmen og talemerker på målspråket. Amazon Polly kommer tilbake talemerkeutgang i en linjeavgrenset JSON-strøm, som inneholder feltene som tid, type, start, slutt og verdi. Verdien kan variere avhengig av typen talemerke som er forespurt i inngangen, for eksempel SSML, viseme, ord eller setning. For eksempelet vårt ba vi om type talemerke as word. Med dette alternativet deler Amazon Polly en setning inn i de enkelte ordene i setningen og start- og sluttid i lydstrømmen. Med disse metadataene blir talemerkene deretter behandlet for å generere undertekstene for den tilsvarende lydstrømmen generert av Amazon Polly.

Til slutt bruker vi AWS Elemental MediaConvert for å gjengi den endelige videoen med den oversatte lyden og tilhørende undertekster.

Følgende video viser det endelige resultatet av løsningen:

AWS trinnfunksjoner arbeidsflyt

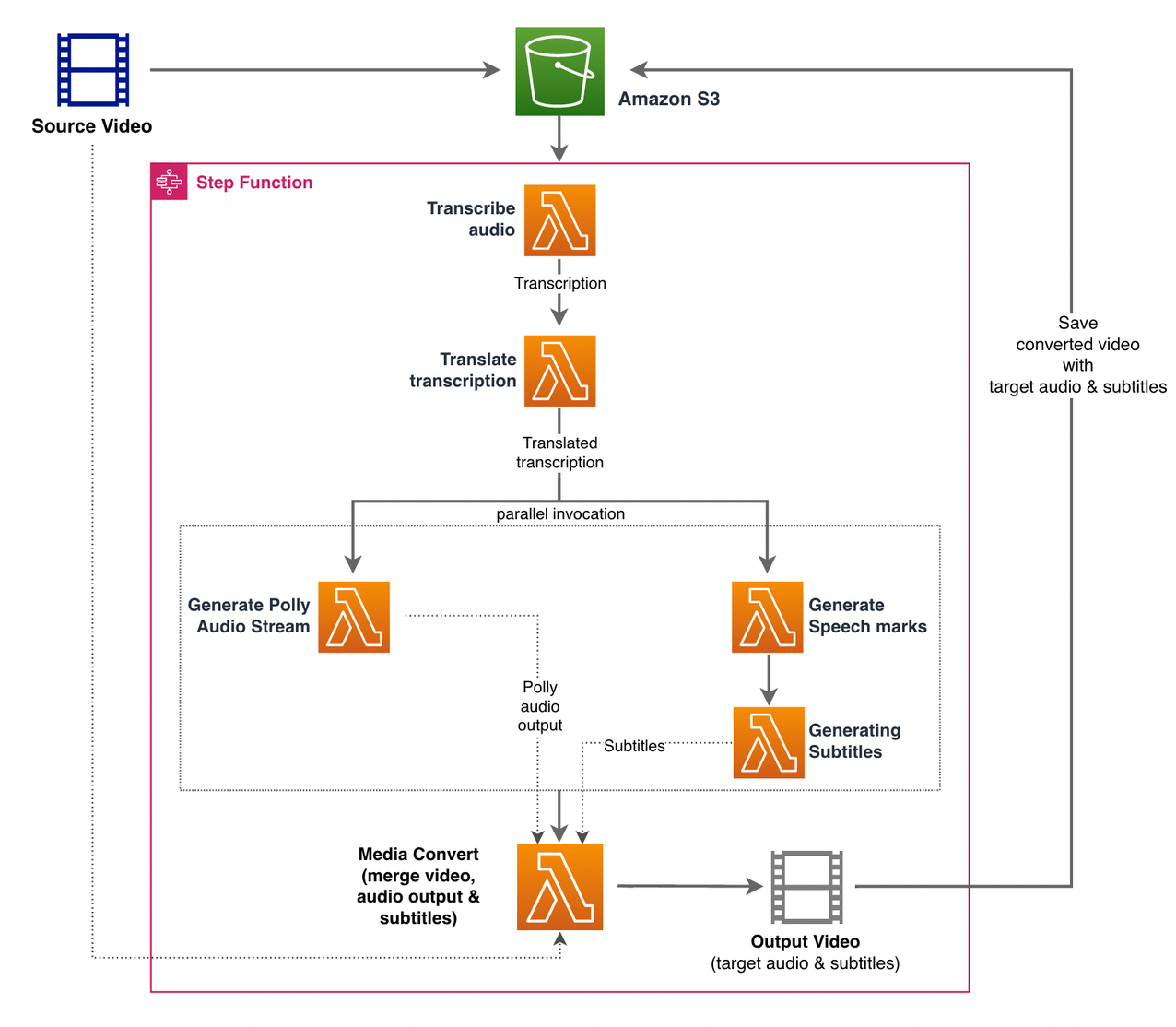

Vi bruker AWS trinnfunksjoner å orkestrere denne prosessen. Den følgende figuren viser en visning på høyt nivå av arbeidsflyten for trinnfunksjoner (noen trinn er utelatt fra diagrammet for bedre klarhet).

Arbeidsflyttrinnene er som følger:

- En bruker laster opp kildevideofilen til en Amazon enkel lagringstjeneste (Amazon S3) bøtte.

- De S3 hendelsesvarsling utløser AWS Lambda funksjon state_machine.py (ikke vist i diagrammet), som påkaller tilstandsmaskinen Step Functions.

- Det første steget, Transkribere lyd, påkaller Lambda-funksjonen transkribere.py, som bruker Amazon Transcribe til å generere en transkripsjon av lyden fra kildevideoen.

Følgende eksempelkode viser hvordan du oppretter en transkripsjonsjobb ved å bruke Amazon Transcribe Boto3 Python SDK:

Etter at jobben er fullført, lagres utdatafilene i S3-bøtten og prosessen fortsetter til neste trinn med å oversette innholdet.

- De Oversett transkripsjon trinn påkaller Lambda-funksjonen translate.py som bruker Amazon Translate til å oversette transkripsjonen til målspråket. Her bruker vi den synkrone/sanntidsoversettelsen ved å bruke oversett_tekst funksjon:

Synkron oversettelse har begrensninger på dokumentstørrelsen den kan oversette; Når dette skrives, er det satt til 5,000 byte. For større dokumentstørrelser bør du vurdere å bruke en asynkron rute for å opprette jobben ved hjelp av start_text_translation_job og sjekke status via beskriv_tekstoversettelsesjobb.

- Det neste trinnet er et trinn funksjoner Parallel stat, hvor vi lager parallelle grener i vår statsmaskin.

- I den første grenen påkaller vi Lambda-funksjonen Lambda-funksjonen gener_polly_audio.py for å generere vår Amazon Polly-lydstrøm:

Her bruker vi start_tale_syntese_oppgave metoden til Amazon Polly Python SDK for å utløse talesynteseoppgaven som lager Amazon Polly-lyden. Vi setter

OutputFormattilmp3, som forteller Amazon Polly å generere en lydstrøm for dette API-kallet. - I den andre grenen påkaller vi Lambda-funksjonen gener_speech_marks.py for å generere talemerker:

- I den første grenen påkaller vi Lambda-funksjonen Lambda-funksjonen gener_polly_audio.py for å generere vår Amazon Polly-lydstrøm:

- Vi bruker igjen start_tale_syntese_oppgave metode, men spesifiser

OutputFormattiljson, som forteller Amazon Polly å generere talemerker for dette API-kallet.

I neste trinn i den andre grenen påkaller vi Lambda-funksjonen gener_subtitles.py, som implementerer logikken for å generere en undertekstfil fra talemerkeutgangen.

Den bruker Python-modulen i filen webvtt_utils.py. Denne modulen har flere hjelpefunksjoner for å lage undertekstfilen; en slik metode get_phrases_from_speechmarks er ansvarlig for å analysere talemerkefilen. JSON-strukturen for talemerker gir bare starttiden for hvert ord individuelt. For å lage timingen for underteksten som kreves for SRT-filen, lager vi først setninger med omtrent n (hvor n=10) ord fra listen over ord i talemerkefilen. Deretter skriver vi dem inn i SRT-filformatet, tar starttiden fra det første ordet i frasen, og for slutttiden bruker vi starttiden til (n+1) ordet og trekker det fra med 1 for å lage den sekvenserte oppføringen . Følgende funksjon lager setningene som forberedelse til å skrive dem til SRT-filen:

- Det siste trinnet, Media Convert, påkaller Lambda-funksjonen create_mediaconvert_job.py å kombinere lydstrømmen fra Amazon Polly og undertekstfilen med kildevideofilen for å generere den endelige utdatafilen, som deretter lagres i en S3-bøtte. Dette trinnet bruker

MediaConvert, en filbasert videotranskodingstjeneste med kringkastingskvalitetsfunksjoner. Den lar deg enkelt lage video-on-demand-innhold og kombinerer avanserte video- og lydfunksjoner med et enkelt nettgrensesnitt. Her bruker vi Python igjen Boto3 SDK for å lage enMediaConvertjobb:

Forutsetninger

Før du begynner, må du ha følgende forutsetninger:

Distribuere løsningen

For å distribuere løsningen ved å bruke AWS CDK, fullfør følgende trinn:

- Klone Repository:

- For å sikre at AWS CDK er bootstrapped, kjør kommandoen

cdk bootstrapfra roten til depotet: - Endre arbeidskatalogen til roten til depotet og kjør følgende kommando:

Som standard er mållydinnstillingene satt til amerikansk spansk (es-US). Hvis du planlegger å teste det med et annet målspråk, bruk følgende kommando:

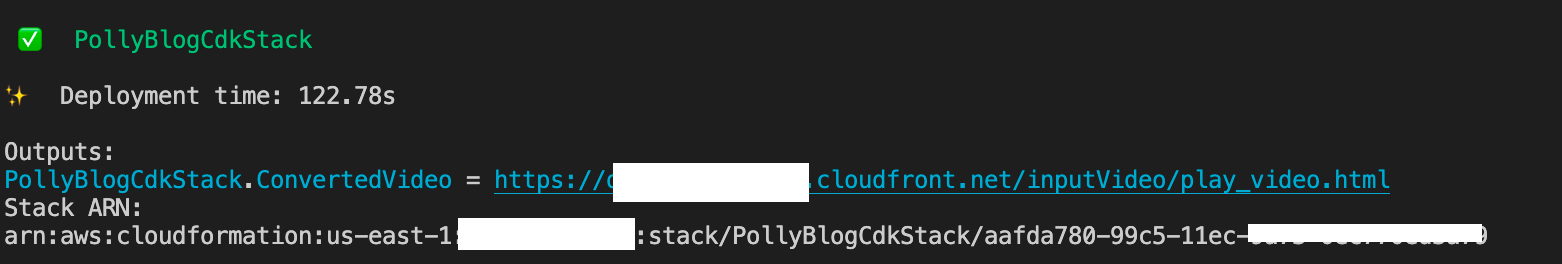

Prosessen tar noen minutter å fullføre, hvoretter den viser en lenke som du kan bruke til å se målvideofilen med den oversatte lyden og oversatte undertekstene.

Test løsningen

For å teste denne løsningen brukte vi en liten del av følgende AWS re:Invent 2017-video fra YouTube, hvor Amazon Transcribe først ble introdusert. Du kan også teste løsningen med din egen video. Originalspråket til testvideoen vår er engelsk. Når du distribuerer denne løsningen, kan du spesifisere mållydinnstillingene eller du kan bruke standard mållydinnstillingene, som bruker spansk for å generere lyd og undertekster. Løsningen lager en S3-bøtte som kan brukes til å laste opp videofilen til.

- Naviger til bøtta på Amazon S3-konsollen

PollyBlogBucket.

- Velg bøtte, naviger til

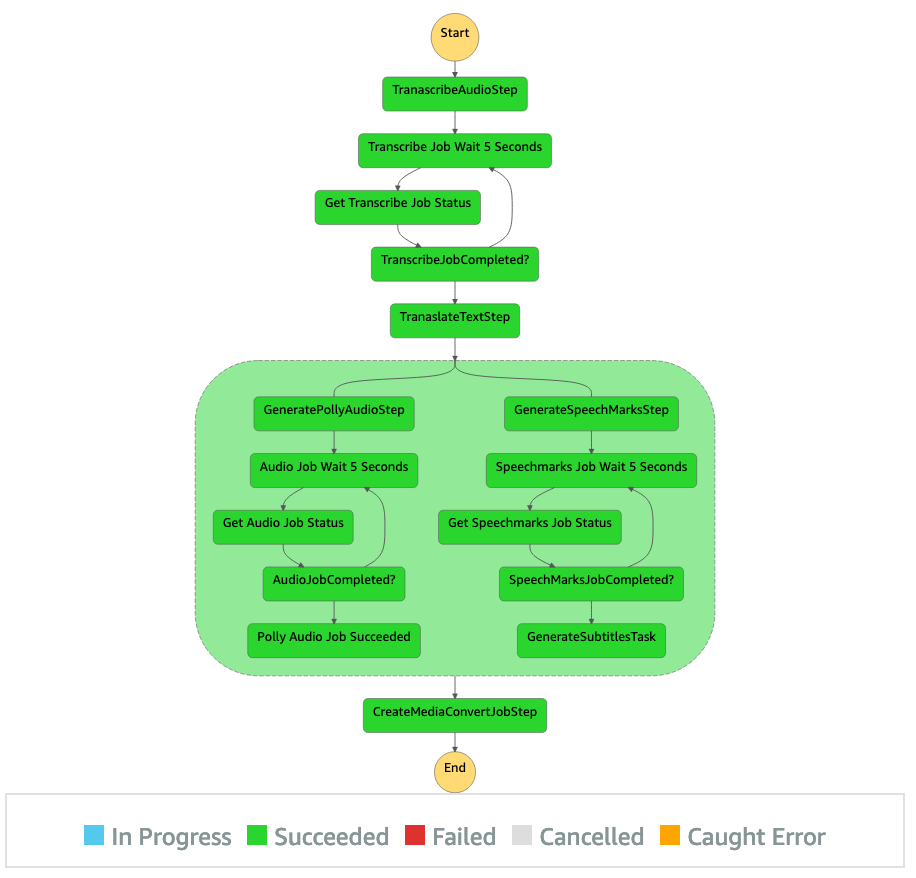

/inputVideokatalogen, og last opp videofilen (løsningen er testet med videoer av typen mp4). På dette tidspunktet utløser et S3-hendelsesvarsel Lambda-funksjonen, som starter tilstandsmaskinen. - På Step Functions-konsollen, bla til tilstandsmaskinen (

ProcessAudioWithSubtitles). - Velg en av kjøringene til tilstandsmaskinen for å finne Grafinspektør.

Dette viser kjøreresultatene for hver stat. Arbeidsflyten for trinnfunksjoner tar noen minutter å fullføre, og deretter kan du bekrefte om alle trinnene er fullført.

Gjennomgå utgangen

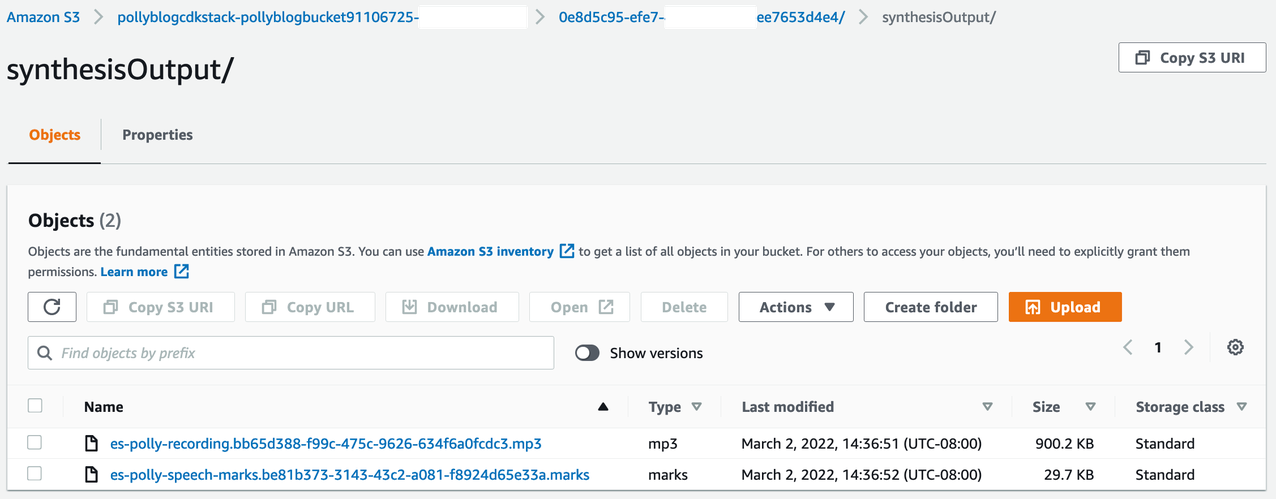

For å se utdataene, åpne Amazon S3-konsollen og sjekk om lydfilen (.mp3) og talemerkefilen (.marks) er lagret i S3-bøtten under <ROOT_S3_BUCKET>/<UID>/synthesisOutput/.

Følgende er et eksempel på talemerkefilen generert fra den oversatte teksten:

I denne utgangen er hver del av teksten delt ut i form av talemerker:

- tid – Tidsstemplet i millisekunder fra begynnelsen av den tilsvarende lydstrømmen

- typen – Type talemerke (setning, ord, viseme eller SSML)

- Begynn – Forskyvningen i byte (ikke tegn) for starten av objektet i inndatateksten (ikke inkludert visemerker)

- slutt – Forskyvningen i byte (ikke tegn) av objektets ende i inndatateksten (ikke inkludert visemerker)

- verdi – Enkeltord i setningen

Den genererte undertekstfilen skrives tilbake til S3-bøtten. Du finner filen under <ROOT_S3_BUCKET>/<UID>/subtitlesOutput/. Inspiser undertekstfilen; innholdet skal ligne på følgende tekst:

Etter at undertekstfilen og lydfilen er generert, opprettes den endelige kildevideofilen ved hjelp av MediaConvert. Sjekk MediaConvert-konsollen for å bekrefte om jobbstatusen er COMPLETE.

Når MediaConvert-jobben er fullført, genereres den endelige videofilen og lagres tilbake i S3-bøtten, som du finner under <ROOT_S3_BUCKET>/<UID>/convertedAV/.

Som en del av denne distribusjonen distribueres den endelige videoen gjennom en Amazon CloudFront (CDN)-koblingen og vises i terminalen eller i AWS skyformasjon konsollen.

Åpne URL-en i en nettleser for å se den originale videoen med tilleggsalternativer for lyd og undertekster. Du kan bekrefte at den oversatte lyden og undertekstene er synkronisert.

konklusjonen

I dette innlegget diskuterte vi hvordan du lager nye språkversjoner av videofiler uten behov for manuell intervensjon. Innholdsskapere kan bruke denne prosessen til å synkronisere lyden og undertekstene til videoene sine og nå et globalt publikum.

Du kan enkelt integrere denne tilnærmingen i dine egne produksjonsrørledninger for å håndtere store volumer og skalere i henhold til dine behov. Amazon Polly bruker Nevrale TTS (NTTS) å produsere naturlige og menneskelignende tekst-til-tale stemmer. Den støtter også generere tale fra SSML, som gir deg ekstra kontroll over hvordan Amazon Polly genererer tale fra den oppgitte teksten. Amazon Polly gir også en en rekke forskjellige stemmer på flere språk for å støtte dine behov.

Kom i gang med AWS maskinlæringstjenester ved å besøke produktside, eller henvise til Amazon Machine Learning Solutions Lab side hvor du kan samarbeide med eksperter for å bringe maskinlæringsløsninger til organisasjonen din.

Tilleggsressurser

For mer informasjon om tjenestene som brukes i denne løsningen, se følgende:

Om forfatterne

Reagan Rosario jobber som løsningsarkitekt i AWS med fokus på utdanningsteknologiselskaper. Han elsker å hjelpe kunder med å bygge skalerbare, svært tilgjengelige og sikre løsninger i AWS Cloud. Han har mer enn ti års erfaring med å jobbe i en rekke teknologiroller, med fokus på programvareteknikk og arkitektur.

Reagan Rosario jobber som løsningsarkitekt i AWS med fokus på utdanningsteknologiselskaper. Han elsker å hjelpe kunder med å bygge skalerbare, svært tilgjengelige og sikre løsninger i AWS Cloud. Han har mer enn ti års erfaring med å jobbe i en rekke teknologiroller, med fokus på programvareteknikk og arkitektur.

Anil Kodali er en løsningsarkitekt med Amazon Web Services. Han jobber med AWS EdTech-kunder, veileder dem med arkitektonisk beste praksis for å migrere eksisterende arbeidsbelastninger til skyen og utforme nye arbeidsbelastninger med en sky-først-tilnærming. Før han begynte i AWS, jobbet han med store forhandlere for å hjelpe dem med skymigreringene deres.

Anil Kodali er en løsningsarkitekt med Amazon Web Services. Han jobber med AWS EdTech-kunder, veileder dem med arkitektonisk beste praksis for å migrere eksisterende arbeidsbelastninger til skyen og utforme nye arbeidsbelastninger med en sky-først-tilnærming. Før han begynte i AWS, jobbet han med store forhandlere for å hjelpe dem med skymigreringene deres.

Prasanna Saraswathi Krishnan er en løsningsarkitekt med Amazon Web Services som jobber med EdTech-kunder. Han hjelper dem å drive skyarkitekturen og datastrategien deres ved å bruke beste praksis. Hans bakgrunn er innen distribuert databehandling, big data-analyse og datateknikk. Han brenner for maskinlæring og naturlig språkbehandling.

Prasanna Saraswathi Krishnan er en løsningsarkitekt med Amazon Web Services som jobber med EdTech-kunder. Han hjelper dem å drive skyarkitekturen og datastrategien deres ved å bruke beste praksis. Hans bakgrunn er innen distribuert databehandling, big data-analyse og datateknikk. Han brenner for maskinlæring og naturlig språkbehandling.

- AI

- ai kunst

- ai art generator

- du har en robot

- Amazon ML Solutions Lab

- Amazon Polly

- Amazon Transcribe

- Amazon Oversett

- kunstig intelligens

- sertifisering av kunstig intelligens

- kunstig intelligens i bankvirksomhet

- kunstig intelligens robot

- kunstig intelligens roboter

- programvare for kunstig intelligens

- AWS maskinlæring

- blockchain

- blockchain konferanse ai

- coingenius

- samtale kunstig intelligens

- kryptokonferanse ai

- dall sin

- dyp læring

- google det

- maskinlæring

- plato

- plato ai

- Platon Data Intelligence

- Platon spill

- PlatonData

- platogaming

- skala ai

- syntaks

- zephyrnet