1IRIF, CNRS – Université Paris Cité, Frankrike

2QC Ware, Palo Alto, USA og Paris, Frankrike

3School of Informatics, University of Edinburgh, Skottland, Storbritannia

4F. Hoffmann La Roche AG

Finn dette papiret interessant eller vil diskutere? Scite eller legg igjen en kommentar på SciRate.

Abstrakt

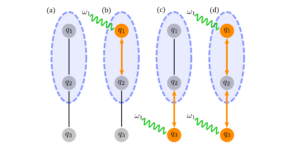

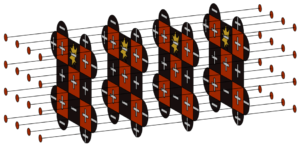

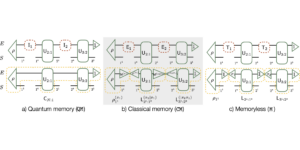

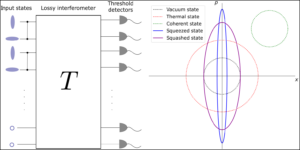

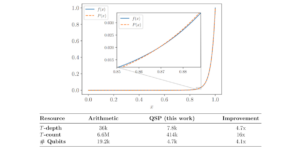

I dette arbeidet blir kvantetransformatorer designet og analysert i detalj ved å utvide de toppmoderne klassiske transformatornevrale nettverksarkitekturene som er kjent for å være svært effektive innen naturlig språkbehandling og bildeanalyse. Med utgangspunkt i det forrige arbeidet, som bruker parametriserte kvantekretser for datalasting og ortogonale nevrale lag, introduserer vi tre typer kvantetransformatorer for trening og inferens, inkludert en kvantetransformator basert på sammensatte matriser, som garanterer en teoretisk fordel ved kvanteoppmerksomhetsmekanismen. sammenlignet med deres klassiske motstykke både når det gjelder asymptotisk kjøretid og antall modellparametere. Disse kvantearkitekturene kan bygges ved å bruke grunne kvantekretser og produsere kvalitativt forskjellige klassifiseringsmodeller. De tre foreslåtte kvanteoppmerksomhetslagene varierer på spekteret mellom å følge de klassiske transformatorene nøye og å vise flere kvantekarakteristikker. Som byggeklosser for kvantetransformatoren foreslår vi en ny metode for å laste en matrise som kvantetilstander, samt to nye trenbare kvanteortogonale lag som kan tilpasses forskjellige nivåer av tilkobling og kvalitet til kvantedatamaskiner. Vi utførte omfattende simuleringer av kvantetransformatorene på standard medisinske bildedatasett som viste konkurransedyktig og til tider bedre ytelse sammenlignet med de klassiske benchmarkene, inkludert de beste klassiske synstransformatorene i klassen. Kvantetransformatorene vi trente på disse småskala datasettene krever færre parametere sammenlignet med standard klassiske benchmarks. Til slutt implementerte vi kvantetransformatorene våre på superledende kvantedatamaskiner og oppnådde oppmuntrende resultater for opptil seks qubit-eksperimenter.

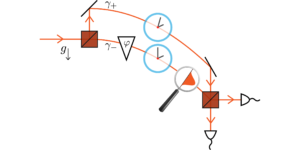

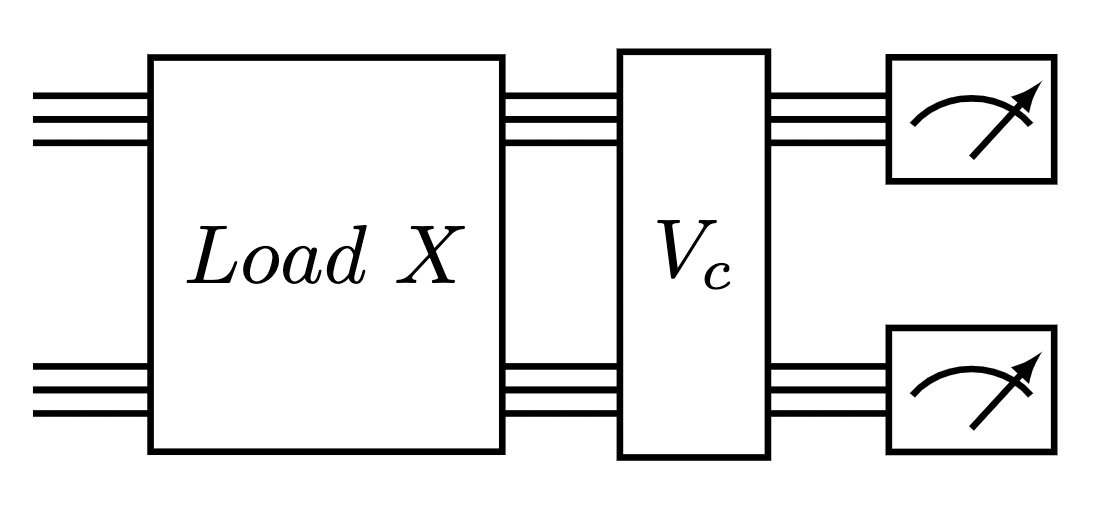

Utvalgt bilde: Kvantekrets for å utføre ett oppmerksomhetslag av Compound Transformer. En matrisedatalaster etterfulgt av et ortogonalt kvantelag.

Populært sammendrag

► BibTeX-data

► Referanser

[1] Jacob Biamonte, Peter Wittek, Nicola Pancotti, Patrick Rebentrost, Nathan Wiebe og Seth Lloyd. "Kvantemaskinlæring". Nature 549, 195–202 (2017).

https: / / doi.org/ 10.1038 / nature23474

[2] Iris Cong, Soonwon Choi og Mikhail D Lukin. "Kvantekonvolusjonelle nevrale nettverk". Nature Physics 15, 1273–1278 (2019).

https://doi.org/10.1038/s41567-019-0648-8

[3] Kishor Bharti, Alba Cervera-Lierta, Thi Ha Kyaw, Tobias Haug, Sumner Alperin-Lea, Abhinav Anand, Matthias Degroote, Hermanni Heimonen, Jakob S Kottmann, Tim Menke, et al. "Støyende kvantealgoritmer i mellomskala". Anmeldelser av Modern Physics 94, 015004 (2022).

https: / / doi.org/ 10.1103 / RevModPhys.94.015004

[4] Marco Cerezo, Andrew Arrasmith, Ryan Babbush, Simon C Benjamin, Suguru Endo, Keisuke Fujii, Jarrod R McClean, Kosuke Mitarai, Xiao Yuan, Lukasz Cincio, et al. "Variasjonskvantealgoritmer". Nature Reviews Physics 3, 625–644 (2021).

https://doi.org/10.1038/s42254-021-00348-9

[5] Jonas Landman, Natansh Mathur, Yun Yvonna Li, Martin Strahm, Skander Kazdaghli, Anupam Prakash og Iordanis Kerenidis. "Kvantemetoder for nevrale nettverk og anvendelse på medisinsk bildeklassifisering". Quantum 6, 881 (2022).

https://doi.org/10.22331/q-2022-12-22-881

[6] Bobak Kiani, Randall Balestriero, Yann LeCun og Seth Lloyd. "projunn: Effektiv metode for å trene dype nettverk med enhetlige matriser". Advances in Neural Information Processing Systems 35, 14448–14463 (2022).

[7] Ashish Vaswani, Noam Shazeer, Niki Parmar, Jakob Uszkoreit, Llion Jones, Aidan N Gomez, Łukasz Kaiser og Illia Polosukhin. "Oppmerksomhet er alt du trenger". Fremskritt i nevrale informasjonsbehandlingssystemer 30 (2017).

[8] Jacob Devlin, Ming-Wei Chang, Kenton Lee og Kristina Toutanova. "Bert: Foropplæring av dype toveis transformatorer for språkforståelse" (2018).

[9] Alexey Dosovitskiy, Lucas Beyer, Alexander Kolesnikov, Dirk Weissenborn, Xiaohua Zhai, Thomas Unterthiner, Mostafa Dehghani, Matthias Minderer, Georg Heigold, Sylvain Gelly, Jakob Uszkoreit og Neil Houlsby. "Et bilde er verdt 16×16 ord: Transformers for bildegjenkjenning i skala". Internasjonal konferanse om læringsrepresentasjoner (2021). url: openreview.net/forum?id=YicbFdNTTy.

https:///openreview.net/forum?id=YicbFdNTTy

[10] Yi Tay, Mostafa Dehghani, Dara Bahri og Donald Metzler. "Effektive transformatorer: En undersøkelse". ACM Computing Surveys (CSUR) (2020).

https: / / doi.org/ 10.1145 / 3530811

[11] Dzmitry Bahdanau, Kyunghyun Cho og Yoshua Bengio. "Neural Machine Translation by Jointly Learning to Align and Translate" (2016). arXiv:1409.0473 [cs, stat].

arxiv: 1409.0473

[12] J. Schmidhuber. "Redusere forholdet mellom læringskompleksitet og antall tidsvarierende variabler i fullstendig tilbakevendende nett". I Stan Gielen og Bert Kappen, redaktører, ICANN '93. Side 460–463. London (1993). Springer.

https://doi.org/10.1007/978-1-4471-2063-6_110

[13] Jürgen Schmidhuber. "Lære å kontrollere raske minner: et alternativ til dynamiske tilbakevendende nettverk". Neural Computation 4, 131–139 (1992).

https: / / doi.org/ 10.1162 / neco.1992.4.1.131

[14] Peter Cha, Paul Ginsparg, Felix Wu, Juan Carrasquilla, Peter L McMahon og Eun-Ah Kim. "Oppmerksomhetsbasert kvantetomografi". Machine Learning: Science and Technology 3, 01LT01 (2021).

https:///doi.org/10.1088/2632-2153/ac362b

[15] Riccardo Di Sipio, Jia-Hong Huang, Samuel Yen-Chi Chen, Stefano Mangini og Marcel Worring. "Droningen av kvantebehandling av naturlig språk". I ICASSP 2022-2022 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). Side 8612–8616. IEEE (2022).

https:///doi.org/10.1109/ICASSP43922.2022.9747675

[16] Guangxi Li, Xuanqiang Zhao og Xin Wang. "Kvante-selvoppmerksomhet nevrale nettverk for tekstklassifisering" (2022).

[17] Fabio Sanches, Sean Weinberg, Takanori Ide og Kazumitsu Kamiya. "Korte kvantekretser i retningslinjer for forsterkning av læring for kjøretøysrutingsproblemet". Physical Review A 105, 062403 (2022).

https: / / doi.org/ 10.1103 / PhysRevA.105.062403

[18] YuanFu Yang og Min Sun. "Deteksjon av halvlederdefekter ved hybrid klassisk kvante-dyplæring". CVPRPages 2313–2322 (2022).

https:///doi.org/10.1109/CVPR52688.2022.00236

[19] Maxwell Henderson, Samriddhi Shakya, Shashindra Pradhan og Tristan Cook. "Kvanvolusjonelle nevrale nettverk: driver bildegjenkjenning med kvantekretser". Quantum Machine Intelligence 2, 1–9 (2020).

https: / / doi.org/ 10.1007 / s42484-020-00012-y

[20] Edward Farhi og Hartmut Neven. "Klassifisering med kvantenevrale nettverk på korttidsprosessorer" (2018). url: doi.org/10.48550/arXiv.1802.06002.

https:///doi.org/10.48550/arXiv.1802.06002

[21] Kosuke Mitarai, Makoto Negoro, Masahiro Kitagawa og Keisuke Fujii. "Kvantekretslæring". Physical Review A 98, 032309 (2018).

https: / / doi.org/ 10.1103 / PhysRevA.98.032309

[22] Kui Jia, Shuai Li, Yuxin Wen, Tongliang Liu og Dacheng Tao. "Ortogonale dype nevrale nettverk". IEEE-transaksjoner om mønsteranalyse og maskinintelligens (2019).

https: / / doi.org/ 10.1109 / TPAMI.2019.2948352

[23] Roger A Horn og Charles R Johnson. "Matriseanalyse". Cambridge University Press. (2012).

https: / / doi.org/ 10.1017 / CBO9780511810817

[24] Iordanis Kerenidis og Anupam Prakash. "Kvantemaskinlæring med delromstilstander" (2022).

[25] Brooks Foxen, Charles Neill, Andrew Dunsworth, Pedram Roushan, Ben Chiaro, Anthony Megrant, Julian Kelly, Zijun Chen, Kevin Satzinger, Rami Barends, et al. "Demonstrerer et kontinuerlig sett med to-qubit-porter for kortsiktige kvantealgoritmer". Physical Review Letters 125, 120504 (2020).

https: / / doi.org/ 10.1103 / PhysRevLett.125.120504

[26] Sonika Johri, Shantanu Debnath, Avinash Mocherla, Alexandros Singk, Anupam Prakash, Jungsang Kim og Iordanis Kerenidis. "Nærmeste tyngdepunktsklassifisering på en fanget ion kvantedatamaskin". npj Quantum Information 7, 122 (2021).

https://doi.org/10.1038/s41534-021-00456-5

[27] James W Cooley og John W Tukey. "En algoritme for maskinberegning av komplekse fourierserier". Mathematics of computing 19, 297–301 (1965).

https://doi.org/10.1090/S0025-5718-1965-0178586-1

[28] Li Jing, Yichen Shen, Tena Dubcek, John Peurifoy, Scott A. Skirlo, Yann LeCun, Max Tegmark og Marin Soljacic. "Tilpassbare effektive enhetlige nevrale nettverk (eunn) og deres anvendelse på rnns". I internasjonal konferanse om maskinlæring. (2016). url: api.semanticscholar.org/CorpusID:5287947.

https:///api.semanticscholar.org/CorpusID:5287947

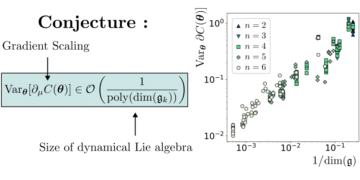

[29] Léo Monbroussou, Jonas Landman, Alex B. Grilo, Romain Kukla og Elham Kashefi. "Trenerbarhet og uttrykksevne for hamming-vektbevarende kvantekretser for maskinlæring" (2023). arXiv:2309.15547.

arxiv: 2309.15547

[30] Enrico Fontana, Dylan Herman, Shouvanik Chakrabarti, Niraj Kumar, Romina Yalovetzky, Jamie Heredge, Shree Hari Sureshbabu og Marco Pistoia. "Adjoint er alt du trenger: Karakterisering av golde platåer i quantum ansätze" (2023). arXiv:2309.07902.

arxiv: 2309.07902

[31] Michael Ragone, Bojko N. Bakalov, Frédéric Sauvage, Alexander F. Kemper, Carlos Ortiz Marrero, Martin Larocca og M. Cerezo. "En enhetlig teori om golde platåer for dype parametriserte kvantekretser" (2023). arXiv:2309.09342.

arxiv: 2309.09342

[32] Xuchen You og Xiaodi Wu. "Eksponentielt mange lokale minima i kvantenevrale nettverk". I internasjonal konferanse om maskinlæring. Side 12144–12155. PMLR (2021).

[33] Eric R. Anschuetz og Bobak Toussi Kiani. "Kvantevariasjonsalgoritmer er oversvømmet med feller". Naturkommunikasjon 13 (2022).

https://doi.org/10.1038/s41467-022-35364-5

[34] Ilya O. Tolstikhin, Neil Houlsby, Alexander Kolesnikov, Lucas Beyer, Xiaohua Zhai, Thomas Unterthiner, Jessica Yung, Daniel Keysers, Jakob Uszkoreit, Mario Lucic og Alexey Dosovitskiy. "Mlp-mixer: En all-mlp-arkitektur for visjon". I NeurIPS. (2021).

[35] Jiancheng Yang, Rui Shi og Bingbing Ni. "Medmnist classification decathlon: A lightweight automl benchmark for medical image analysis" (2020).

https:///doi.org/10.1109/ISBI48211.2021.9434062

[36] Jiancheng Yang, Rui Shi, Donglai Wei, Zequan Liu, Lin Zhao, Bilian Ke, Hanspeter Pfister og Bingbing Ni. "Medmnist v2-en storskala lettvektsreferanse for 2d og 3d biomedisinsk bildeklassifisering". Scientific Data 10, 41 (2023).

https://doi.org/10.1038/s41597-022-01721-8

[37] Angelos Katharopoulos, Apoorv Vyas, Nikolaos Pappas og François Fleuret. "Transformatorer er rnns: Raske autoregressive transformatorer med lineær oppmerksomhet". I internasjonal konferanse om maskinlæring. Side 5156–5165. PMLR (2020).

[38] James Bradbury, Roy Frostig, Peter Hawkins, Matthew James Johnson, Chris Leary, Dougal Maclaurin, George Necula, Adam Paszke, Jake VanderPlas, Skye Wanderman-Milne og Qiao Zhang. "JAX: komponerbare transformasjoner av Python+NumPy-programmer". Github (2018). url: http:///github.com/google/jax.

http: / / github.com/ google / jax

[39] Diederik P. Kingma og Jimmy Ba. "Adam: En metode for stokastisk optimalisering". CoRR abs/1412.6980 (2015).

[40] Hyeonwoo Noh, Tackgeun You, Jonghwan Mun og Bohyung Han. "Regulering av dype nevrale nettverk ved hjelp av støy: tolkning og optimalisering". NeurIPS (2017).

[41] Xue Ying. "En oversikt over overfitting og dens løsninger". I Journal of Physics: Conference Series. Bind 1168, side 022022. IOP Publishing (2019).

https://doi.org/10.1088/1742-6596/1168/2/022022

Sitert av

[1] David Peral García, Juan Cruz-Benito og Francisco José García-Peñalvo, "Systematic Literature Review: Quantum Machine Learning and its applications", arxiv: 2201.04093, (2022).

[2] El Amine Cherrat, Snehal Raj, Iordanis Kerenidis, Abhishek Shekhar, Ben Wood, Jon Dee, Shouvanik Chakrabarti, Richard Chen, Dylan Herman, Shaohan Hu, Pierre Minssen, Ruslan Shaydulin, Yue Sun, Romina Yalovetzky og Marco Pistoia, "Quantum Deep Hedging", Quantum 7, 1191 (2023).

[3] Léo Monbroussou, Jonas Landman, Alex B. Grilo, Romain Kukla og Elham Kashefi, "Trainability and Expressivity of Hamming-Weight Preserving Quantum Circuits for Machine Learning", arxiv: 2309.15547, (2023).

[4] Sohum Thakkar, Skander Kazdaghli, Natansh Mathur, Iordanis Kerenidis, André J. Ferreira-Martins og Samurai Brito, "Improved Financial Forecasting via Quantum Machine Learning", arxiv: 2306.12965, (2023).

[5] Jason Iaconis og Sonika Johri, "Tensor Network Based Efficient Quantum Data Loading of Images", arxiv: 2310.05897, (2023).

[6] Nishant Jain, Jonas Landman, Natansh Mathur og Iordanis Kerenidis, "Quantum Fourier Networks for Solving Parametric PDEs", arxiv: 2306.15415, (2023).

[7] Daniel Mastropietro, Georgios Korpas, Vyacheslav Kungurtsev og Jakub Marecek, "Fleming-Viot hjelper til med å øke hastigheten på variasjonskvantealgoritmer i nærvær av golde platåer", arxiv: 2311.18090, (2023).

[8] Aliza U. Siddiqui, Kaitlin Gili og Chris Ballance, "Stressing Out Modern Quantum Hardware: Performance Evaluation and Execution Insights", arxiv: 2401.13793, (2024).

Sitatene ovenfor er fra SAO / NASA ADS (sist oppdatert vellykket 2024-02-22 13:37:43). Listen kan være ufullstendig fordi ikke alle utgivere gir passende og fullstendige sitasjonsdata.

Kunne ikke hente Crossref sitert av data under siste forsøk 2024-02-22 13:37:41: Kunne ikke hente siterte data for 10.22331 / q-2024-02-22-1265 fra Crossref. Dette er normalt hvis DOI nylig ble registrert.

Denne artikkelen er utgitt i Quantum under Creative Commons Attribution 4.0 International (CC BY 4.0) tillatelse. Opphavsrett forblir hos de opprinnelige rettighetshaverne som forfatterne eller institusjonene deres.

- SEO-drevet innhold og PR-distribusjon. Bli forsterket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk deg selv. Tilgang her.

- PlatoAiStream. Web3 Intelligence. Kunnskap forsterket. Tilgang her.

- PlatoESG. Karbon, CleanTech, Energi, Miljø, Solenergi, Avfallshåndtering. Tilgang her.

- PlatoHelse. Bioteknologisk og klinisk etterretning. Tilgang her.

- kilde: https://quantum-journal.org/papers/q-2024-02-22-1265/

- :er

- :ikke

- ][s

- $OPP

- 1

- 10

- 11

- 12

- 125

- 13

- 14

- 15%

- 16

- 17

- 19

- 20

- 2012

- 2015

- 2016

- 2017

- 2018

- 2019

- 2020

- 2021

- 2022

- 2023

- 2024

- 22

- 23

- 24

- 25

- 26%

- 27

- 28

- 29

- 2D

- 30

- 31

- 32

- 33

- 35%

- 36

- 39

- 3d

- 40

- 41

- 43

- 7

- 8

- 9

- 98

- a

- ovenfor

- ABSTRACT

- adgang

- ACM

- Adam

- I tillegg

- fremskritt

- Fordel

- fordeler

- tilknytning

- AL

- alex

- Alexander

- algoritme

- algoritmer

- justere

- Alle

- alternativ

- an

- analyse

- og

- Andrew

- Anthony

- api

- Søknad

- søknader

- arkitektur

- arkitekturer

- ER

- AS

- antagelser

- At

- forsøk

- oppmerksomhet

- forfatter

- forfattere

- AutoML

- ufruktbar

- basert

- BE

- ben

- benchmark

- benchmarks

- Benjamin

- Bedre

- mellom

- toveis

- biomedisinsk

- Blocks

- både

- Break

- Bygning

- bygget

- by

- beregningen

- cambridge

- CAN

- evner

- carlos

- cha

- chang

- egenskaper

- Charles

- chen

- CHO

- chris

- klassifisering

- tett

- kommentere

- Commons

- kommunikasjon

- sammenlignet

- konkurranse

- fullføre

- komplekse

- kompleksitet

- kan komponeres

- Compound

- beregningen

- datamaskin

- datamaskiner

- databehandling

- Konferanse

- Tilkobling

- kontinuerlig

- kontroll

- copyright

- kunne

- motstykke

- kolleger

- skape

- Daniel

- dato

- datasett

- David

- dyp

- dyp læring

- demonstrere

- designet

- detalj

- Gjenkjenning

- forskjellig

- diskutere

- Donald

- under

- dynamisk

- E&T

- redaktører

- Edward

- effektivitet

- effektiv

- el

- oppmuntrende

- forbedre

- eric

- evaluering

- Selv

- henrette

- gjennomføring

- utviser

- eksperimenter

- utforske

- strekker

- omfattende

- FAST

- Februar

- færre

- Endelig

- finansiell

- fokusering

- fulgt

- etter

- Til

- Francisco

- fra

- fullt

- Gates

- George

- GitHub

- Gomez

- garantier

- maskinvare

- harvard

- sikring

- hjelpe

- hjelper

- holdere

- http

- HTTPS

- Huang

- Hybrid

- IEEE

- if

- Illia

- bilde

- Bildeklassifisering

- Bildegjenkjenning

- bilder

- implementert

- forbedret

- in

- Inkludert

- informasjon

- innsikt

- institusjoner

- Intelligens

- interessant

- internasjonalt

- tolkning

- introdusere

- DET ER

- jacob

- james

- Jamie

- Javascript

- jimmy

- John

- Johnson

- jon

- jones

- journal

- John

- Kim

- kjent

- Kumar

- Språk

- storskala

- Siste

- lag

- lag

- læring

- Permisjon

- Lee

- nivåer

- utnytte

- Li

- Tillatelse

- lettvekt

- i likhet med

- lin

- lineær

- Liste

- litteratur

- loader

- lasting

- lokal

- London

- maskin

- maskinlæring

- mange

- Marco

- mario

- Martin

- matematikk

- Matrix

- matthew

- max

- max bredde

- Maxwell

- Kan..

- mcclean

- mekanisme

- medisinsk

- Minner

- metode

- metoder

- Michael

- Michael

- minutter

- modell

- modeller

- Moderne

- Måned

- mer

- Naturlig

- Natural Language Processing

- Natur

- Nær

- Trenger

- Nets

- nettverk

- nettverk

- nevrale

- nevrale nettverket

- nevrale nettverk

- Ny

- Bråk

- normal

- roman

- Antall

- innhentet

- of

- on

- ONE

- åpen

- optimalisering

- or

- original

- vår

- ut

- enn

- oversikt

- side

- sider

- Palo Alto

- Papir

- parametere

- paris

- Patrick

- Mønster

- paul

- ytelse

- utført

- Peter

- fysisk

- Fysikk

- Pierre

- plato

- Platon Data Intelligence

- PlatonData

- Politikk

- polosukhin

- potensiell

- Slå

- Prakash

- tilstedeværelse

- presentere

- bevarer

- trykk

- forrige

- Problem

- prosessering

- prosessorer

- produsere

- programmer

- lovende

- foreslå

- foreslått

- gi

- publisert

- utgiver

- utgivere

- Publisering

- kvalitet

- Quantum

- kvantealgoritmer

- Kvantedatamaskin

- kvante datamaskiner

- kvanteberegning

- kvanteinformasjon

- kvantemaskinlæring

- qubit

- R

- RUMMY

- ratio

- nylig

- anerkjennelse

- tilbakevendende

- referanser

- registrert

- forblir

- krever

- Resultater

- anmeldelse

- Anmeldelser

- Richard

- stein

- Roman

- ruting

- roy

- Kjør

- runtime

- Ryan

- s

- Skala

- Vitenskap

- Vitenskap og teknologi

- vitenskapelig

- scott

- Sean

- Serien

- sett

- grunne

- viste

- Signal

- Simon

- simuleringer

- SIX

- Solutions

- løse

- noen

- Spectrum

- tale

- fart

- Standard

- state-of-the-art

- Stater

- Studer

- vellykket

- slik

- egnet

- Sol

- superledende

- Survey /Inspeksjonsfartøy

- Systemer

- oppgaver

- tay

- Teknologi

- begrep

- vilkår

- tekst

- Tekstklassifisering

- Det

- De

- deres

- teoretiske

- teori

- Disse

- de

- denne

- thomas

- tre

- Tim

- tid

- ganger

- Tittel

- til

- trent

- Kurs

- Transaksjoner

- transformasjoner

- transformator

- transformers

- oversette

- Oversettelse

- fanget

- feller

- to

- typer

- etter

- forståelse

- enhetlig

- unik

- universitet

- oppdatert

- upon

- URL

- USA

- bruker

- ved hjelp av

- variere

- Varierende

- kjøretøy

- veldig

- av

- syn

- volum

- W

- wang

- ønsker

- var

- we

- VI VIL

- hvilken

- med

- tre

- ord

- Arbeid

- verdt

- wu

- xiao

- år

- Utbytte

- YING

- Du

- yuan

- zephyrnet

- Zhao