Dette innlegget tar deg gjennom de vanligste utfordringene som kunder møter når de søker i interne dokumenter, og gir deg konkret veiledning om hvordan AWS-tjenester kan brukes til å lage en generativ AI-samtalerobot som gjør intern informasjon mer nyttig.

Ustrukturerte data utgjør 80 % av all data finnes i organisasjoner, bestående av arkiver med manualer, PDF-er, vanlige spørsmål, e-poster og andre dokumenter som vokser daglig. Bedrifter i dag er avhengige av kontinuerlig voksende depoter av intern informasjon, og problemer oppstår når mengden ustrukturert data blir uhåndterlig. Ofte finner brukere seg i å lese og sjekke mange forskjellige interne kilder for å finne svarene de trenger.

Interne spørsmål og svar-fora kan hjelpe brukere med å få svært spesifikke svar, men krever også lengre ventetider. Når det gjelder bedriftsspesifikke interne vanlige spørsmål, resulterer lange ventetider i lavere produktivitet hos de ansatte. Spørsmåls- og svarfora er vanskelige å skalere da de er avhengige av manuelt skrevne svar. Med generativ AI er det for tiden et paradigmeskifte i hvordan brukere søker og finner informasjon. Det neste logiske trinnet er å bruke generativ AI for å kondensere store dokumenter til mindre bitstørrelse for enklere brukerforbruk. I stedet for å bruke lang tid på å lese tekst eller vente på svar, kan brukere generere sammendrag i sanntid basert på flere eksisterende depoter med intern informasjon.

Løsningsoversikt

Løsningen lar kunder hente kuraterte svar på spørsmål stilt om interne dokumenter ved å bruke en transformatormodell for å generere svar på spørsmål om data som de ikke har blitt trent på, en teknikk kjent som zero-shot prompting. Ved å ta i bruk denne løsningen kan kundene oppnå følgende fordeler:

- Finn nøyaktige svar på spørsmål basert på eksisterende kilder til interne dokumenter

- Reduser tiden brukere bruker på å søke etter svar ved å bruke store språkmodeller (LLM) for å gi nesten umiddelbare svar på komplekse spørsmål ved å bruke dokumenter med den mest oppdaterte informasjonen

- Søk tidligere besvarte spørsmål gjennom et sentralisert dashbord

- Reduser stress forårsaket av å bruke tid på å lese informasjon manuelt for å lete etter svar

Retrieval Augmented Generation (RAG)

Retrieval Augmented Generation (RAG) reduserer noen av manglene ved LLM-baserte søk ved å finne svarene fra kunnskapsbasen din og bruke LLM til å oppsummere dokumentene til konsise svar. Vennligst les dette poste å lære å implementere RAG-tilnærmingen med Amazon Kendra. Følgende risikoer og begrensninger er forbundet med LLM-baserte spørsmål som en RAG-tilnærming med Amazon Kendra adresserer:

- Hallusinasjoner og sporbarhet - LLMS er trent på store datasett og genererer svar på sannsynligheter. Dette kan føre til unøyaktige svar, som er kjent som hallusinasjoner.

- Flere datasiloer – For å referere til data fra flere kilder i svaret ditt, må man sette opp et koblingsøkosystem for å samle dataene. Å få tilgang til flere depoter er manuell og tidkrevende.

- Sikkerhet – Sikkerhet og personvern er kritiske hensyn når du distribuerer samtaleroboter drevet av RAG og LLM. Til tross for bruk Amazon Comprehend for å filtrere ut personopplysninger som kan gis gjennom brukerforespørsler, er det fortsatt en mulighet for utilsiktet fremkomst av personlig eller sensitiv informasjon, avhengig av inntatt data. Dette betyr at kontroll av tilgangen til chatboten er avgjørende for å forhindre utilsiktet tilgang til sensitiv informasjon.

- Datarelevans - LLMS er trent på data opp til en viss dato, noe som betyr at informasjon ofte ikke er oppdatert. Kostnadene knyttet til treningsmodeller på nyere data er høye. For å sikre nøyaktige og oppdaterte svar, har organisasjoner ansvaret for å jevnlig oppdatere og berike innholdet i de indekserte dokumentene.

- Kostnad – Kostnadene forbundet med å distribuere denne løsningen bør vurderes for bedrifter. Bedrifter må nøye vurdere budsjettet og ytelseskravene når de implementerer denne løsningen. Å kjøre LLM-er kan kreve betydelige beregningsressurser, noe som kan øke driftskostnadene. Disse kostnadene kan bli en begrensning for applikasjoner som trenger å operere i stor skala. Imidlertid er en av fordelene med AWS Cloud er fleksibiliteten til å kun betale for det du bruker. AWS tilbyr en enkel, konsistent, betal-som-du-gå-prismodell, slik at du kun belastes for ressursene du bruker.

Bruk av Amazon SageMaker JumpStart

For transformatorbaserte språkmodeller kan organisasjoner ha nytte av å bruke Amazon SageMaker JumpStart, som tilbyr en samling av forhåndsbygde maskinlæringsmodeller. Amazon SageMaker JumpStart tilbyr et bredt spekter av tekstgenerering og spørsmålssvar (Q&A) grunnleggende modeller som enkelt kan distribueres og brukes. Denne løsningen integrerer en FLAN T5-XL Amazon SageMaker JumpStart-modell, men det er forskjellige aspekter å huske på når velge en fundamentmodell.

Integrering av sikkerhet i arbeidsflyten vår

Følger beste praksis i sikkerhetssøylen til Velarbeidet rammeverk, Amazon Cognito brukes til autentisering. Amazon Cognito User Pools kan integreres med tredjeparts identitetsleverandører som støtter flere rammeverk som brukes for tilgangskontroll, inkludert Open Authorization (OAuth), OpenID Connect (OIDC) eller Security Assertion Markup Language (SAML). Ved å identifisere brukere og deres handlinger kan løsningen opprettholde sporbarhet. Løsningen bruker også Amazon Comprehend gjenkjenning av personlig identifiserbar informasjon (PII). funksjon for å automatisk identifisere og redigere PII. Redigert PII inkluderer adresser, personnummer, e-postadresser og annen sensitiv informasjon. Denne utformingen sikrer at all PII gitt av brukeren gjennom inndataspørringen blir redigert. PII blir ikke lagret, brukt av Amazon Kendra eller matet til LLM.

Løsningsgjennomgang

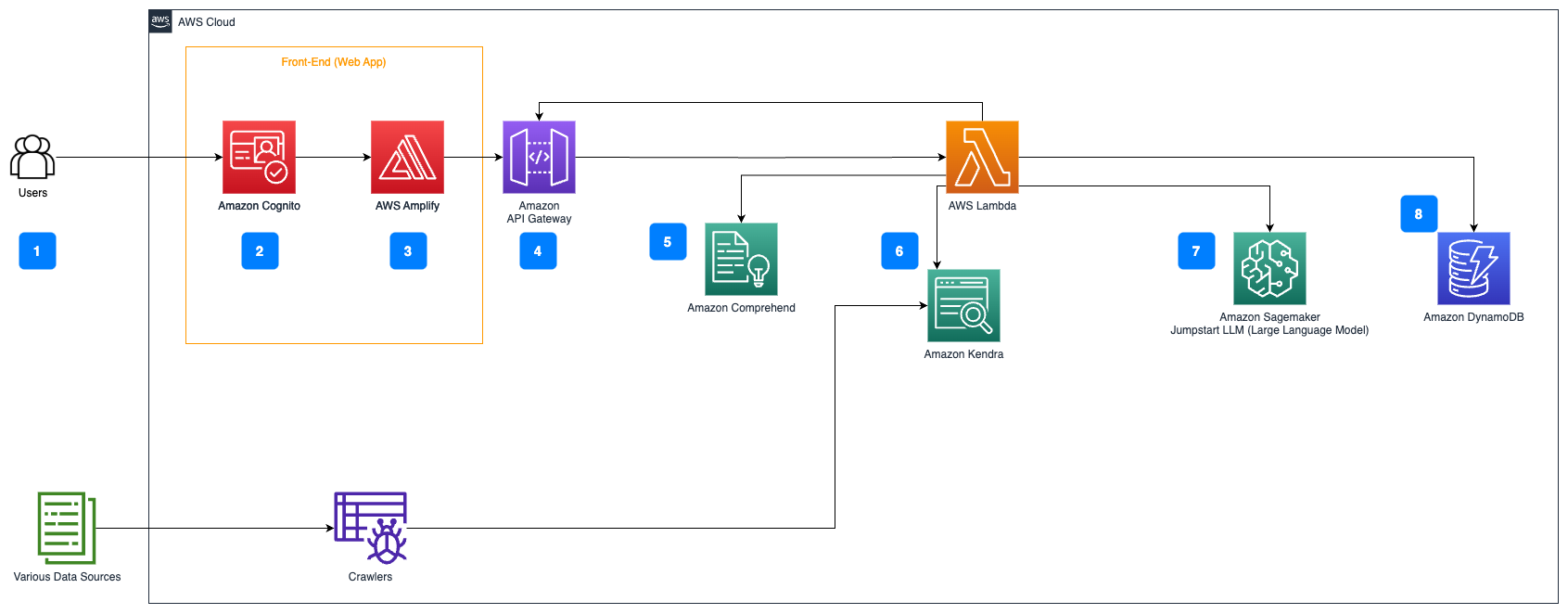

Følgende trinn beskriver arbeidsflyten for spørsmålssvar over dokumentflyt:

- Brukere sender en forespørsel via et nettgrensesnitt.

- Amazon Cognito brukes til autentisering, og sikrer sikker tilgang til nettapplikasjonen.

- Nettapplikasjonens frontend er vert på AWS forsterke.

- Amazon API-gateway er vert for et REST API med forskjellige endepunkter for å håndtere brukerforespørsler som er autentisert ved hjelp av Amazon Cognito.

- PII-redaksjon med Amazon Comprehend:

- Brukerspørringsbehandling: Når en bruker sender inn en spørring eller inndata, sendes den først gjennom Amazon Comprehend. Tjenesten analyserer teksten og identifiserer eventuelle PII-enheter som er tilstede i spørringen.

- PII-utvinning: Amazon Comprehend trekker ut de oppdagede PII-enhetene fra brukerspørringen.

- Relevant informasjonsinnhenting med Amazon Kendra:

- Amazon Kendra brukes til å administrere en indeks over dokumenter som inneholder informasjonen som brukes til å generere svar på brukerens spørsmål.

- De LangChain QA henting modul brukes til å bygge en samtalekjede som har relevant informasjon om brukerens forespørsler.

- Integrasjon med Amazon SageMaker JumpStart:

- AWS Lambda-funksjonen bruker LangChain-biblioteket og kobler til Amazon SageMaker JumpStart-endepunktet med en kontekstfylt spørring. Amazon SageMaker JumpStart-endepunktet fungerer som grensesnittet til LLM som brukes for slutninger.

- Lagre svar og returnere det til brukeren:

- Svaret fra LLM lagres i Amazon DynamoDB sammen med brukerens søk, tidsstempelet, en unik identifikator og andre vilkårlige identifikatorer for elementet, for eksempel spørsmålskategori. Ved å lagre spørsmålet og svaret som diskrete elementer kan AWS Lambda-funksjonen enkelt gjenskape en brukers samtalehistorikk basert på tidspunktet da spørsmål ble stilt.

- Til slutt sendes svaret tilbake til brukeren via en HTTPs-forespørsel gjennom Amazon API Gateway REST API-integrasjonssvaret.

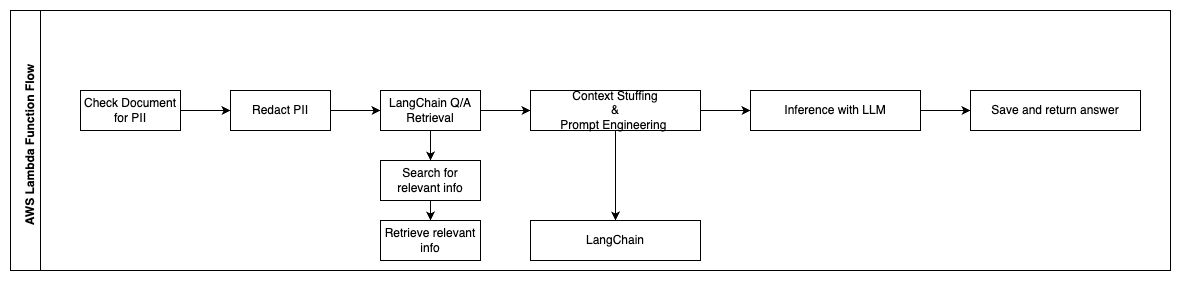

Følgende trinn beskriver AWS Lambda-funksjoner og deres flyt gjennom prosessen:

- Kontroller og fjern eventuell PII/sensitiv informasjon

- LangChain QA Retrieval Chain

- Søk og hent relevant informasjon

- Context Stuffing & Prompt Engineering

- Inferens med LLM

- Returner svar og lagre det

Bruksmåter

Det er mange business use cases hvor kunder kan bruke denne arbeidsflyten. Følgende avsnitt forklarer hvordan arbeidsflyten kan brukes i ulike bransjer og vertikaler.

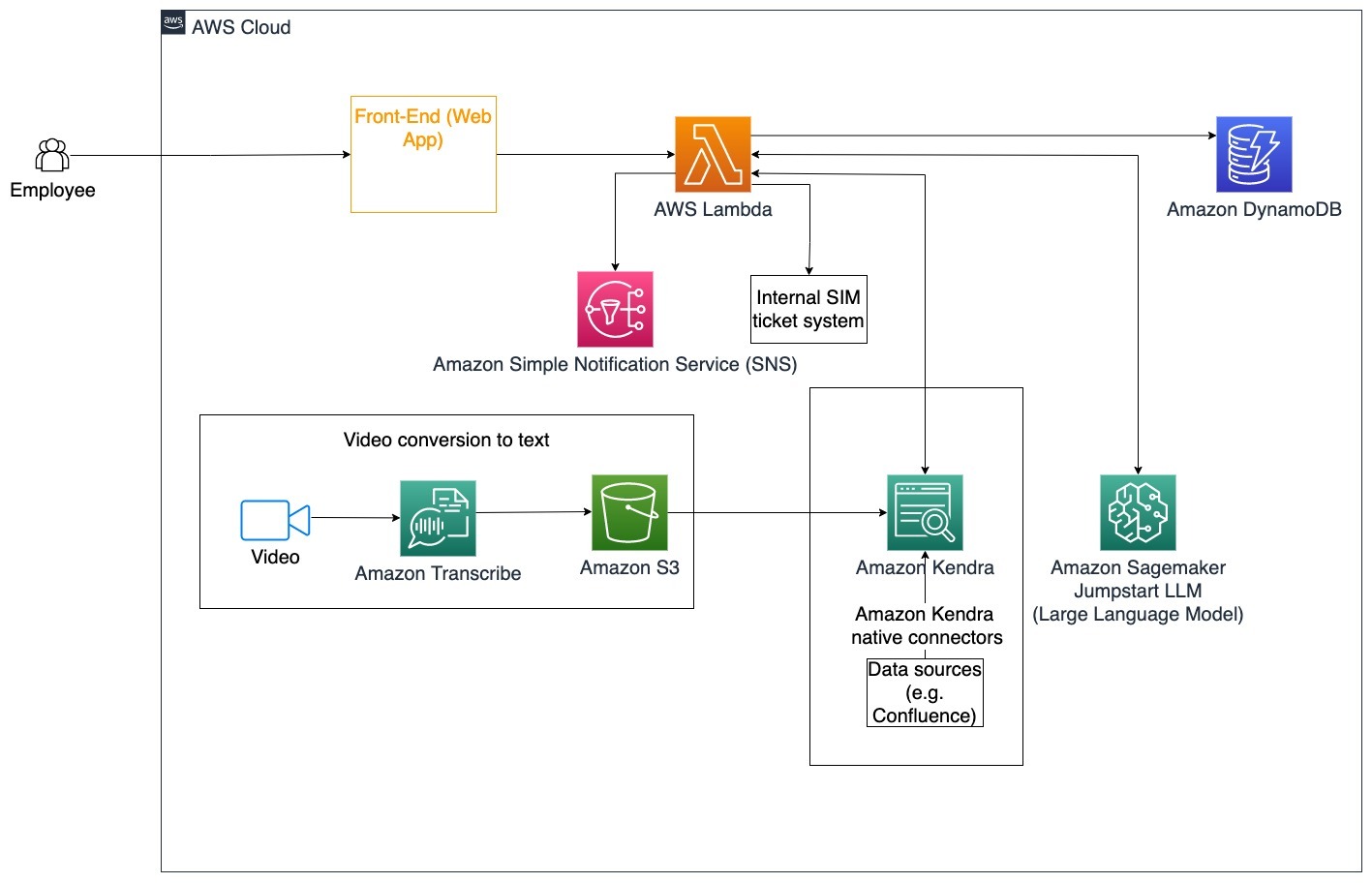

Ansattes bistand

Godt utformet bedriftsopplæring kan forbedre ansattes tilfredshet og redusere tiden som kreves for ombordstigning av nye ansatte. Etter hvert som organisasjoner vokser og kompleksiteten øker, finner ansatte det vanskelig å forstå de mange kildene til interne dokumenter. Interne dokumenter i denne sammenhengen inkluderer selskapets retningslinjer, retningslinjer og standard driftsprosedyrer. For dette scenariet har en ansatt et spørsmål om hvordan han skal gå frem og redigere en intern utstedelsesbillett. Den ansatte kan få tilgang til og bruke den generative kunstig intelligens (AI) samtaleroboten for å spørre og utføre de neste trinnene for en spesifikk billett.

Spesifikk brukstilfelle: Automatiser problemløsning for ansatte basert på bedriftens retningslinjer.

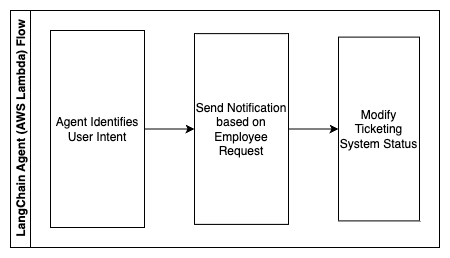

Følgende trinn beskriver AWS Lambda-funksjoner og deres flyt gjennom prosessen:

- LangChain agent for å identifisere intensjonen

- Send melding basert på ansattes forespørsel

- Endre billettstatus

I dette arkitekturdiagrammet kan bedriftsopplæringsvideoer inntas gjennom Amazon Transcribe for å samle en logg over disse videoskriptene. I tillegg kan bedriftsopplæringsinnhold lagret i ulike kilder (dvs. Confluence, Microsoft SharePoint, Google Drive, Jira, etc.) brukes til å lage indekser gjennom Amazon Kendra-koblinger. Les denne artikkelen for å lære mer om samlingen av innfødte kontakter du kan bruke i Amazon Kendra som et kildepunkt. Amazon Kendra-søkeroboten kan da bruke både bedriftsopplæringsvideoskriptene og dokumentasjonen som er lagret i disse andre kildene for å hjelpe samtaleroboten med å svare på spørsmål som er spesifikke for bedriftens retningslinjer for bedriftens opplæring. LangChain-agenten verifiserer tillatelser, endrer billettstatus og varsler de riktige personene ved å bruke Amazon Simple Notification Service (Amazon SNS).

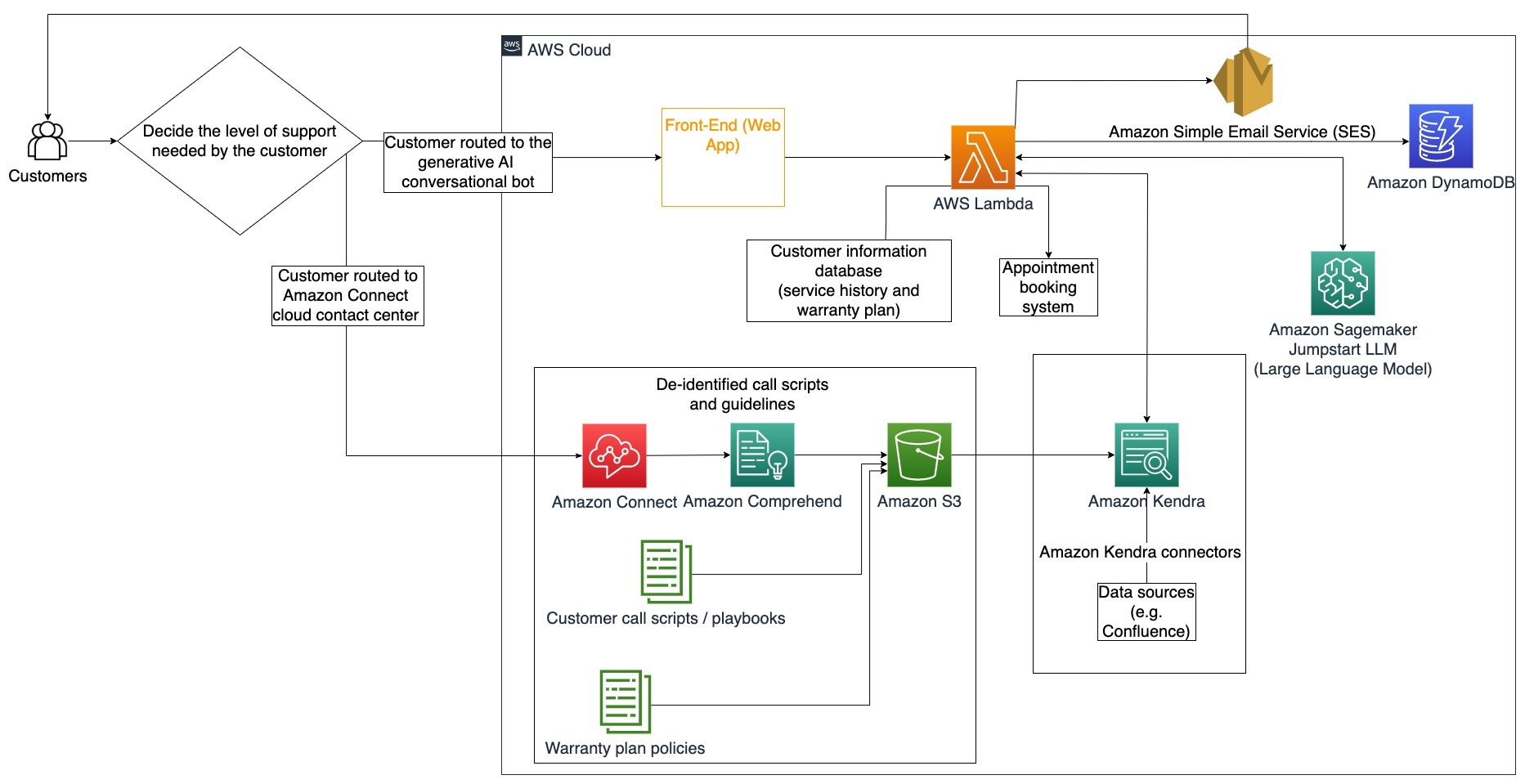

Kundestøtteteam

Rask løsning av kundespørsmål forbedrer kundeopplevelsen og oppmuntrer til merkelojalitet. En lojal kundebase bidrar til å drive salg, noe som bidrar til bunnlinjen og øker kundeengasjementet. Kundestøtteteam bruker mye energi på å referere til mange interne dokumenter og programvare for administrasjon av kunderelasjoner for å svare på kundespørsmål om produkter og tjenester. Interne dokumenter i denne sammenhengen kan inkludere generiske kundestøtteanropsskript, spillebøker, retningslinjer for eskalering og forretningsinformasjon. Den generative AI-samtaleroboten hjelper med kostnadsoptimalisering fordi den håndterer spørsmål på vegne av kundestøtteteamet.

Spesifikk brukstilfelle: Håndtering av en forespørsel om oljeskift basert på servicehistorikk og kjøpt kundeserviceplan.

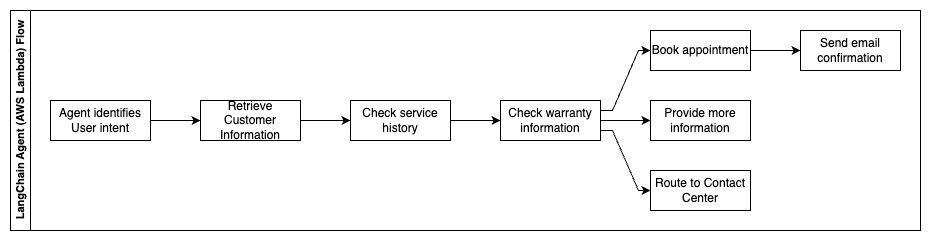

I dette arkitekturdiagrammet blir kunden rutet til enten den generative AI-samtaleroboten eller Amazon Connect kontaktsenter. Denne avgjørelsen kan være basert på behovet for støtte eller tilgjengeligheten til kundestøtteagenter. LangChain-agenten identifiserer kundens hensikt og verifiserer identiteten. LangChain-agenten sjekker også servicehistorikken og den kjøpte støtteplanen.

Følgende trinn beskriver AWS Lambda-funksjoner og deres flyt gjennom prosessen:

- LangChain-agent identifiserer intensjonen

- Hent kundeinformasjon

- Sjekk kundeservicehistorikk og garantiinformasjon

- Bestill time, oppgi mer informasjon eller vei til kontaktsenter

- Send e-postbekreftelse

Amazon Connect brukes til å samle stemme- og chat-loggene, og Amazon Comprehend brukes til å fjerne personlig identifiserbar informasjon (PII) fra disse loggene. Amazon Kendra-søkeroboten er da i stand til å bruke de redigerte tale- og chat-loggene, kundeanropsskriptene og retningslinjer for kundeservicestøtteplan for å lage indeksen. Når en avgjørelse er tatt, bestemmer den generative AI-samtaleroboten om den skal bestille en avtale, gi mer informasjon eller rute kunden til kontaktsenteret for ytterligere assistanse. For kostnadsoptimalisering kan LangChain-agenten også generere svar ved å bruke færre tokens og en rimeligere storspråklig modell for lavere prioriterte kundeforespørsler.

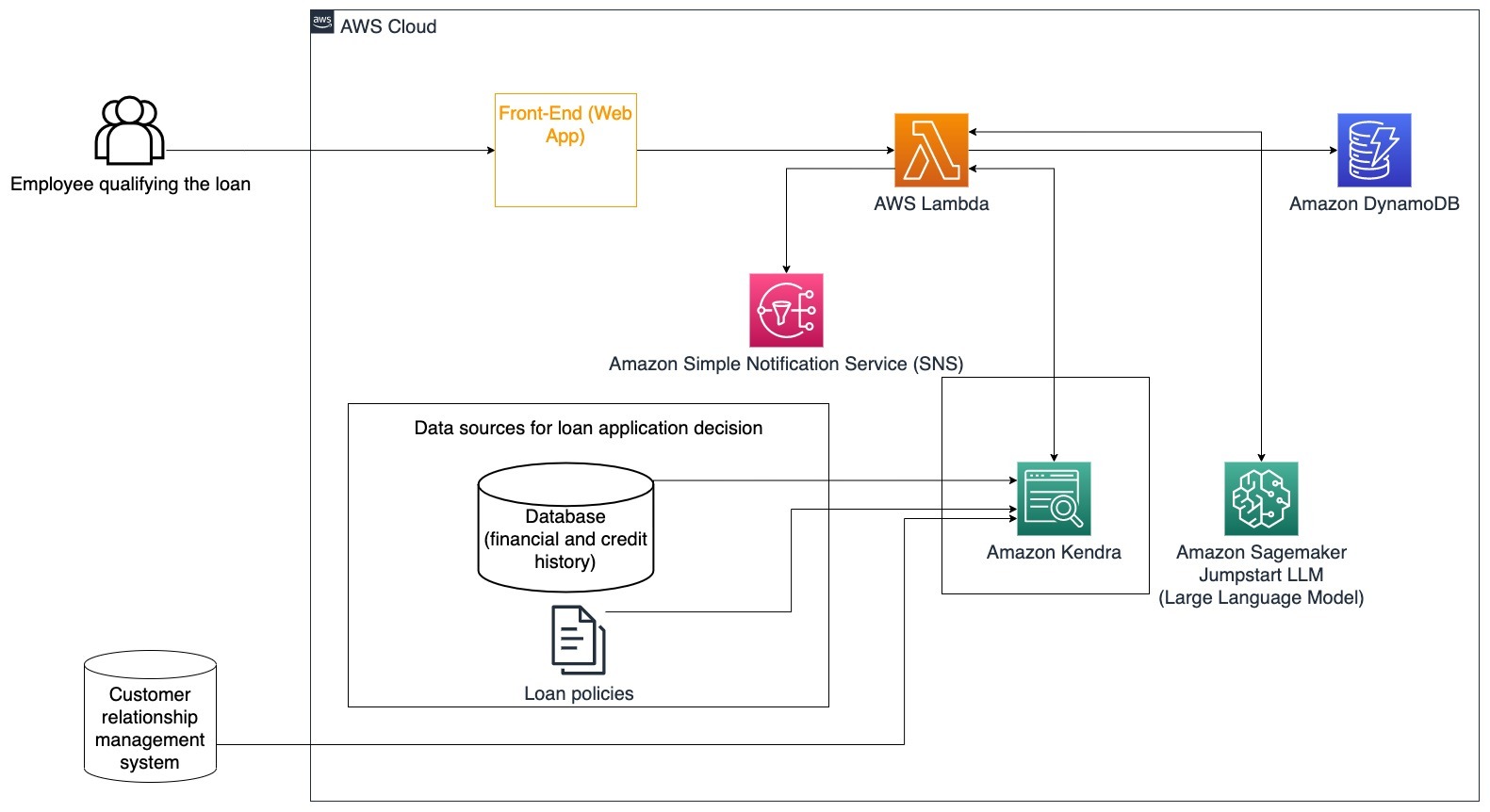

Finansielle tjenester

Finansielle tjenesteselskaper er avhengige av rettidig bruk av informasjon for å forbli konkurransedyktige og overholde økonomiske forskrifter. Ved å bruke en generativ AI-samtalerobot kan finansanalytikere og rådgivere samhandle med tekstinformasjon på en samtale måte og redusere tiden og kreftene det tar å ta bedre informerte beslutninger. Utenom investeringer og markedsundersøkelser kan en generativ AI-samtalerobot også øke menneskelige evner ved å håndtere oppgaver som tradisjonelt ville kreve mer menneskelig innsats og tid. For eksempel kan en finansinstitusjon som spesialiserer seg på personlige lån øke hastigheten for behandling av lån samtidig som den gir bedre åpenhet til kundene.

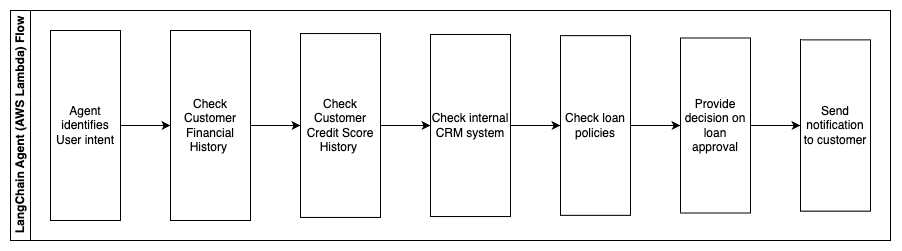

Spesifikk brukstilfelle: Bruk kundehistorikk og tidligere lånesøknader for å bestemme og forklare lånebeslutning.

Følgende trinn beskriver AWS Lambda-funksjoner og deres flyt gjennom prosessen:

- LangChain agent for å identifisere intensjonen

- Sjekk kundens økonomiske og kredittscorehistorikk

- Sjekk internt styringssystem for kunderelasjoner

- Sjekk standard lånepolitikk og foreslå beslutning for ansatte som kvalifiserer lånet

- Send melding til kunde

Denne arkitekturen inkluderer kundeøkonomiske data lagret i en database og data som er lagret i et verktøy for kundeforholdsstyring (CRM). Disse datapunktene brukes til å informere en beslutning basert på selskapets interne lånepolicyer. Kunden kan stille oppklarende spørsmål for å forstå hvilke lån de kvalifiserer for og vilkårene for lånene de kan akseptere. Hvis den generative AI-samtaleroboten ikke er i stand til å godkjenne en lånesøknad, kan brukeren fortsatt stille spørsmål om forbedring av kredittscore eller alternative finansieringsalternativer.

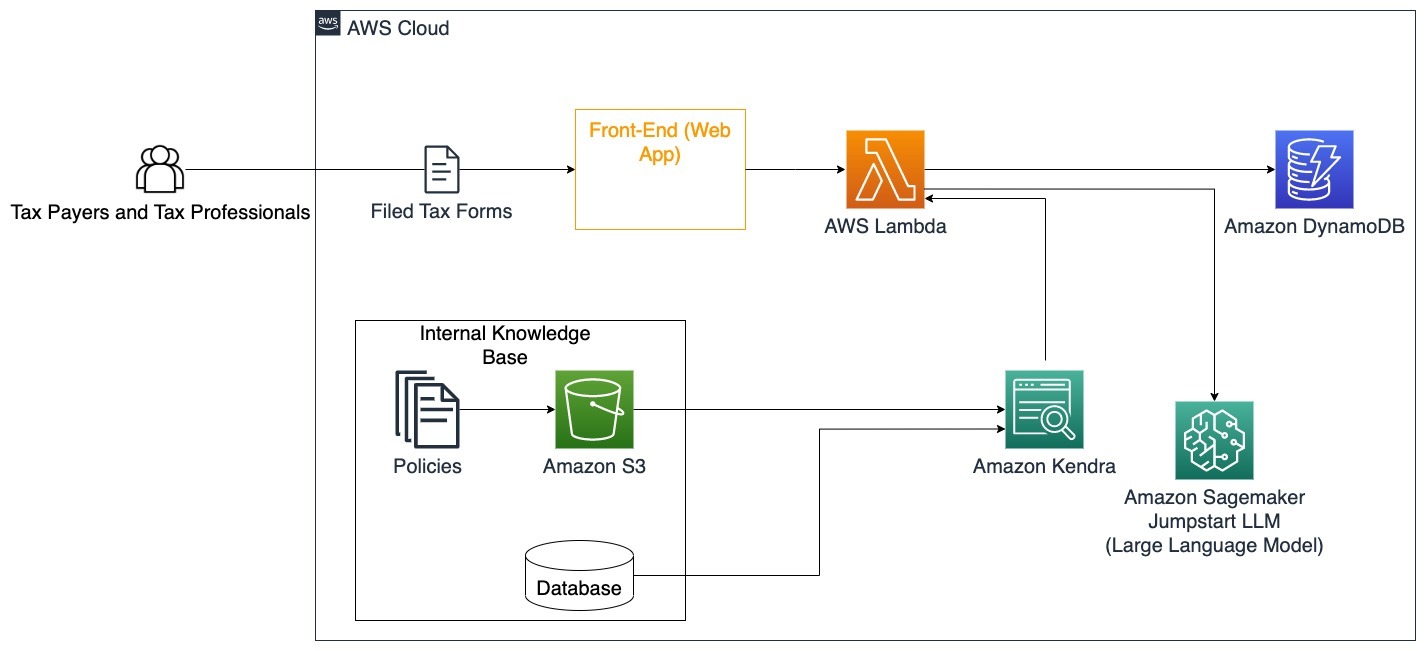

Regjeringen

Generative AI-samtaleroboter kan være til stor nytte for offentlige institusjoner ved å øke hastigheten på kommunikasjon, effektivitet og beslutningsprosesser. Generative AI-samtaleroboter kan også gi umiddelbar tilgang til interne kunnskapsbaser for å hjelpe offentlige ansatte med å raskt hente informasjon, retningslinjer og prosedyrer (dvs. kvalifikasjonskriterier, søknadsprosesser og innbyggers tjenester og støtte). En løsning er et interaktivt system, som lar skattebetalere og skatteeksperter enkelt finne skatterelaterte detaljer og fordeler. Den kan brukes til å forstå brukerspørsmål, oppsummere skattedokumenter og gi klare svar gjennom interaktive samtaler.

Brukere kan stille spørsmål som:

- Hvordan fungerer arveavgift og hva er skattegrensene?

- Kan du forklare begrepet inntektsskatt?

- Hva er skattemessige konsekvenser ved salg av en annen eiendom?

I tillegg kan brukere ha fordelen av å sende inn skatteskjemaer til et system, noe som kan bidra til å verifisere riktigheten av informasjonen som er gitt.

Denne arkitekturen illustrerer hvordan brukere kan laste opp utfylte skatteskjemaer til løsningen og bruke den til interaktiv verifisering og veiledning om hvordan de fyller ut nødvendig informasjon nøyaktig.

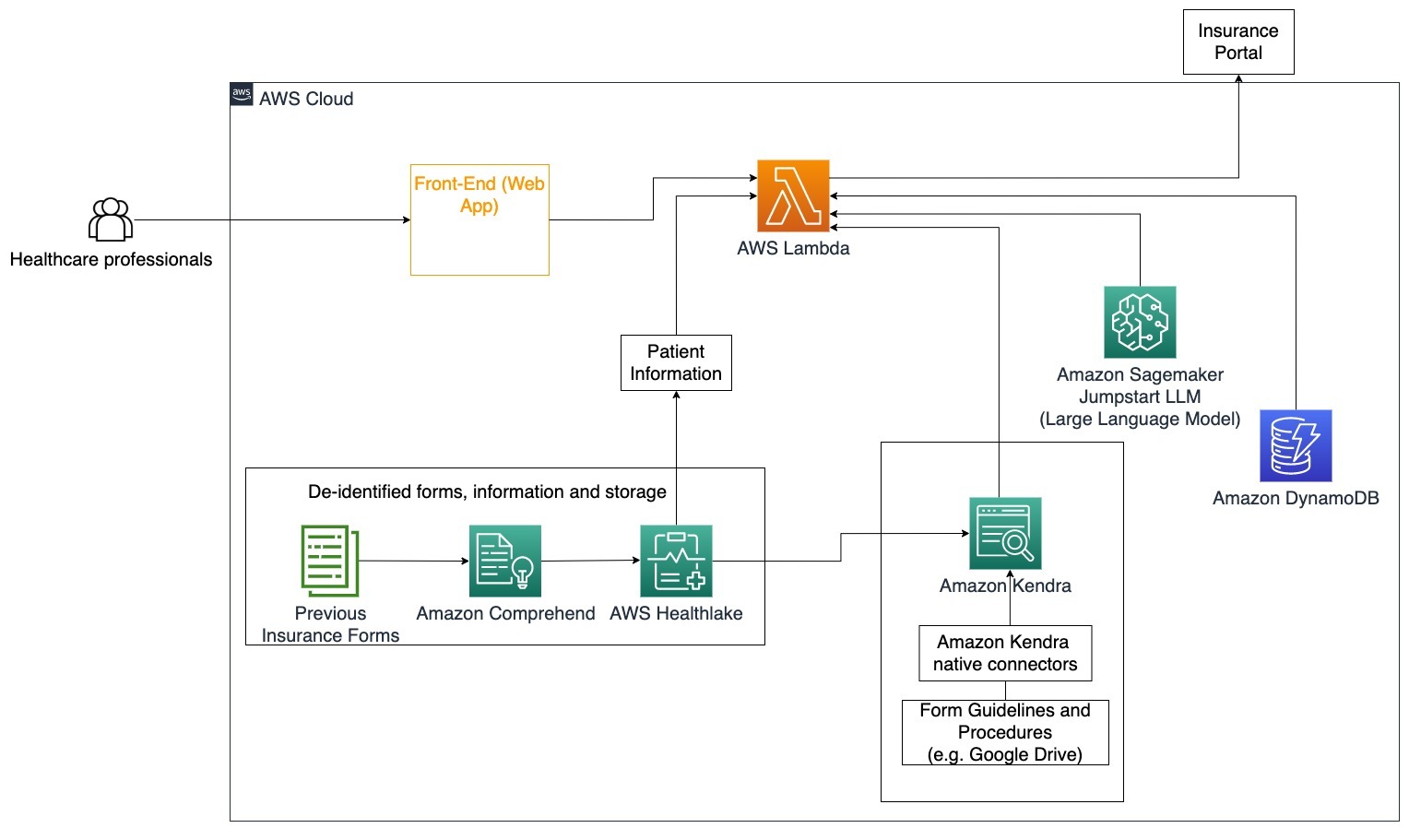

Helsevesen

Helsebedrifter har muligheten til å automatisere bruken av store mengder intern pasientinformasjon, samtidig som de tar opp vanlige spørsmål angående brukstilfeller som behandlingsalternativer, forsikringskrav, kliniske studier og farmasøytisk forskning. Bruk av en generativ AI-samtalerobot muliggjør rask og nøyaktig generering av svar om helseinformasjon fra den oppgitte kunnskapsbasen. Noen helsepersonell bruker for eksempel mye tid på å fylle ut skjemaer for å sende inn forsikringskrav.

I lignende omgivelser må administratorer og forskere av kliniske forsøk finne informasjon om behandlingsalternativer. En generativ AI-samtalerobot kan bruke de forhåndsbygde kontaktene i Amazon Kendra for å hente den mest relevante informasjonen fra millioner av dokumenter publisert gjennom pågående forskning utført av farmasøytiske selskaper og universiteter.

Spesifikk brukstilfelle: Reduser feilene og tiden som trengs for å fylle ut og sende forsikringsskjemaer.

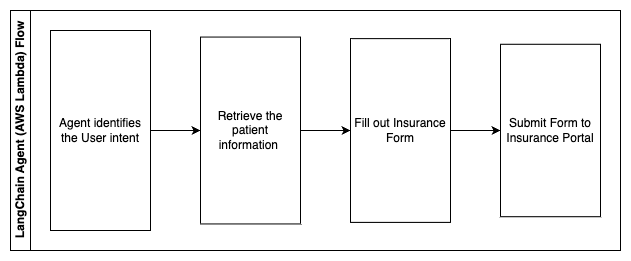

I dette arkitekturdiagrammet kan en helsepersonell bruke den generative AI-samtaleroboten for å finne ut hvilke skjemaer som må fylles ut for forsikringen. LangChain-agenten kan da hente de riktige skjemaene og legge til nødvendig informasjon for en pasient samt gi svar på beskrivende deler av skjemaene basert på forsikringspoliser og tidligere skjemaer. Helsepersonell kan redigere svarene gitt av LLM før han godkjenner og får skjemaet levert til forsikringsportalen.

Følgende trinn beskriver AWS Lambda-funksjoner og deres flyt gjennom prosessen:

- LangChain agent for å identifisere intensjonen

- Hent frem nødvendig pasientinformasjon

- Fyll ut forsikringsskjema basert på pasientinformasjon og skjemaveiledning

- Send inn skjemaet til forsikringsportalen etter brukergodkjenning

AWS HealthLake brukes til å lagre helsedata på en sikker måte, inkludert tidligere forsikringsskjemaer og pasientinformasjon, og Amazon Comprehend brukes til å fjerne personlig identifiserbar informasjon (PII) fra de tidligere forsikringsskjemaene. Amazon Kendra-søkeroboten kan da bruke settet med forsikringsskjemaer og retningslinjer for å lage indeksen. Når skjemaet/skjemaene er fylt ut av den generative AI, kan skjemaet/skjemaene som er vurdert av den medisinske fagpersonen sendes til forsikringsportalen.

Kostnadsberegning

Kostnaden for å distribuere basisløsningen som et proof-of-concept er vist i følgende tabell. Siden basisløsningen anses som et proof-of-concept, ble Amazon Kendra Developer Edition brukt som et rimelig alternativ siden arbeidsmengden ikke ville være i produksjon. Vår antagelse for Amazon Kendra Developer Edition var 730 aktive timer for måneden.

For Amazon SageMaker antok vi at kunden ville bruke ml.g4dn.2xlarge-forekomsten for sanntidsslutning, med et enkelt sluttpunkt per forekomst. Du kan finne mer informasjon om Amazon SageMaker-priser og tilgjengelige slutningsforekomsttyper her..

| Service | Ressurser brukt | Kostnadsestimat per måned i USD |

| AWS forsterke | 150 byggeminutter 1 GB data levert 500,000 forespørsler |

15.71 |

| Amazon API-gateway | 1M REST API-anrop | 3.5 |

| AWS Lambda | 1 million forespørsler 5 sekunders varighet per forespørsel 2 GB minne tildelt |

160.23 |

| Amazon DynamoDB | 1 millioner avlesninger 1 million skriver 100 GB lagringsplass |

26.38 |

| Amazon Sagemaker | Sanntidsslutning med ml.g4dn.2xlarge | 676.8 |

| Amazon Kendra | Developer Edition med 730 timer/måned 10,000 XNUMX dokumenter skannet 5,000 forespørsler/dag |

821.25 |

| . | . | Totalkostnad: 1703.87 |

* Amazon Cognito har et gratis nivå på 50,000 50 månedlige aktive brukere som bruker Cognito-brukergrupper eller 2.0 månedlige aktive brukere som bruker SAML XNUMX-identitetsleverandører

Rydd opp

For å spare kostnader, slett alle ressursene du distribuerte som en del av opplæringen. Du kan slette alle SageMaker-endepunkter du har opprettet via SageMaker-konsollen. Husk at sletting av en Amazon Kendra-indeks fjerner ikke originaldokumentene fra lagringen din.

konklusjonen

I dette innlegget viste vi deg hvordan du forenkler tilgang til intern informasjon ved å oppsummere fra flere depoter i sanntid. Etter den siste utviklingen av kommersielt tilgjengelige LLM-er, har mulighetene for generativ AI blitt tydeligere. I dette innlegget viste vi frem måter å bruke AWS-tjenester for å lage en serverløs chatbot som bruker generativ AI for å svare på spørsmål. Denne tilnærmingen inkluderer et autentiseringslag og Amazon Comprehends PII-deteksjon for å filtrere ut all sensitiv informasjon gitt i brukerens forespørsel. Enten det er enkeltpersoner i helsevesenet som forstår nyansene ved å sende inn forsikringskrav eller HR som forstår spesifikke regelverk for hele selskapet, er det flere bransjer og vertikaler som kan dra nytte av denne tilnærmingen. En Amazon SageMaker JumpStart-fundamentmodell er motoren bak chatboten, mens en kontekstfyllingsmetode ved bruk av RAG-teknikken brukes for å sikre at svarene mer nøyaktig refererer til interne dokumenter.

For å lære mer om å jobbe med generativ AI på AWS, se Annonserer nye verktøy for bygging med generativ AI på AWS. For mer inngående veiledning om bruk av RAG-teknikken med AWS-tjenester, se Bygg raskt generative AI-applikasjoner med høy nøyaktighet på bedriftsdata ved å bruke Amazon Kendra, LangChain og store språkmodeller. Siden tilnærmingen i denne bloggen er LLM-agnostisk, kan enhver LLM brukes til slutning. I vårt neste innlegg vil vi skissere måter å implementere denne løsningen ved å bruke Amazon Bedrock og Amazon Titan LLM.

Om forfatterne

Abhishek Maligehalli Shivalingaiah er senior AI Services Solution Architect hos AWS. Han brenner for å bygge applikasjoner ved å bruke Generative AI, Amazon Kendra og NLP. Han har rundt 10 års erfaring med å bygge data- og AI-løsninger for å skape verdier for kunder og bedrifter. Han har til og med bygget en (personlig) chatbot for moro skyld for å svare på spørsmål om karrieren og yrkesreisen. Utenom jobben liker han å lage portretter av familie og venner, og elsker å lage kunstverk.

Abhishek Maligehalli Shivalingaiah er senior AI Services Solution Architect hos AWS. Han brenner for å bygge applikasjoner ved å bruke Generative AI, Amazon Kendra og NLP. Han har rundt 10 års erfaring med å bygge data- og AI-løsninger for å skape verdier for kunder og bedrifter. Han har til og med bygget en (personlig) chatbot for moro skyld for å svare på spørsmål om karrieren og yrkesreisen. Utenom jobben liker han å lage portretter av familie og venner, og elsker å lage kunstverk.

Medha Aiyah er en Associate Solutions Architect ved AWS, basert i Austin, Texas. Hun ble nylig uteksaminert fra University of Texas i Dallas i desember 2022 med sin mastergrad i informatikk med spesialisering i intelligente systemer med fokus på AI/ML. Hun er interessert i å lære mer om AI/ML og å bruke AWS-tjenester for å finne løsninger kunder kan dra nytte av.

Medha Aiyah er en Associate Solutions Architect ved AWS, basert i Austin, Texas. Hun ble nylig uteksaminert fra University of Texas i Dallas i desember 2022 med sin mastergrad i informatikk med spesialisering i intelligente systemer med fokus på AI/ML. Hun er interessert i å lære mer om AI/ML og å bruke AWS-tjenester for å finne løsninger kunder kan dra nytte av.

Hugo Tse er en Associate Solutions Architect ved AWS med base i Seattle, Washington. Han har en mastergrad i informasjonsteknologi fra Arizona State University og en bachelorgrad i økonomi fra University of Chicago. Han er medlem av Information Systems Audit and Control Association (ISACA) og International Information System Security Certification Consortium (ISC)2. Han liker å hjelpe kunder med å dra nytte av teknologi.

Hugo Tse er en Associate Solutions Architect ved AWS med base i Seattle, Washington. Han har en mastergrad i informasjonsteknologi fra Arizona State University og en bachelorgrad i økonomi fra University of Chicago. Han er medlem av Information Systems Audit and Control Association (ISACA) og International Information System Security Certification Consortium (ISC)2. Han liker å hjelpe kunder med å dra nytte av teknologi.

Ayman Ishimwe er en Associate Solutions Architect ved AWS med base i Seattle, Washington. Han har en mastergrad i programvareteknikk og IT fra Oakland University. Han har tidligere erfaring med programvareutvikling, spesielt med å bygge mikrotjenester for distribuerte webapplikasjoner. Han brenner for å hjelpe kunder med å bygge robuste og skalerbare løsninger på AWS skytjenester etter beste praksis.

Ayman Ishimwe er en Associate Solutions Architect ved AWS med base i Seattle, Washington. Han har en mastergrad i programvareteknikk og IT fra Oakland University. Han har tidligere erfaring med programvareutvikling, spesielt med å bygge mikrotjenester for distribuerte webapplikasjoner. Han brenner for å hjelpe kunder med å bygge robuste og skalerbare løsninger på AWS skytjenester etter beste praksis.

Shervin Suresh er en Associate Solutions Architect ved AWS med base i Austin, Texas. Han er uteksaminert med en mastergrad i programvareteknikk med en konsentrasjon i cloud computing og virtualisering og en bachelorgrad i datateknikk fra San Jose State University. Han brenner for å utnytte teknologi for å bidra til å forbedre livene til mennesker fra alle bakgrunner.

Shervin Suresh er en Associate Solutions Architect ved AWS med base i Austin, Texas. Han er uteksaminert med en mastergrad i programvareteknikk med en konsentrasjon i cloud computing og virtualisering og en bachelorgrad i datateknikk fra San Jose State University. Han brenner for å utnytte teknologi for å bidra til å forbedre livene til mennesker fra alle bakgrunner.

- SEO-drevet innhold og PR-distribusjon. Bli forsterket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk deg selv. Tilgang her.

- PlatoAiStream. Web3 Intelligence. Kunnskap forsterket. Tilgang her.

- PlatoESG. Bil / elbiler, Karbon, CleanTech, Energi, Miljø, Solenergi, Avfallshåndtering. Tilgang her.

- PlatoHelse. Bioteknologisk og klinisk etterretning. Tilgang her.

- ChartPrime. Hev handelsspillet ditt med ChartPrime. Tilgang her.

- BlockOffsets. Modernisering av eierskap for miljøkompensasjon. Tilgang her.

- kilde: https://aws.amazon.com/blogs/machine-learning/simplify-access-to-internal-information-using-retrieval-augmented-generation-and-langchain-agents/

- : har

- :er

- :ikke

- :hvor

- $OPP

- 000

- 10

- 100

- 125

- 2022

- 50

- 7

- a

- I stand

- Om oss

- Aksepterer

- adgang

- Tilgang

- kontoer

- nøyaktig

- nøyaktig

- handlinger

- aktiv

- legge til

- I tillegg

- adresser

- adressering

- administratorer

- vedta

- rådgivere

- Etter

- Agent

- agenter

- aggregat

- AI

- AI-tjenester

- AI / ML

- Alle

- tillater

- langs

- også

- alternativ

- Amazon

- Amazon API-gateway

- Amazon Cognito

- Amazon Comprehend

- Amazon Kendra

- Amazon SageMaker

- Amazon SageMaker JumpStart

- Amazon Web Services

- beløp

- beløp

- an

- analytikere

- analyser

- og

- besvare

- svar

- noen

- api

- tilsynelatende

- Søknad

- søknader

- ansettelse

- tilnærming

- godkjenne

- arkitektur

- ER

- oppstår

- Arizona

- rundt

- Artikkel

- kunstig

- kunstig intelligens

- Kunstig intelligens (AI)

- kunstverk

- AS

- spør

- aspekter

- vurdere

- bistå

- Assistanse

- Førsteamanuensis

- assosiert

- Association

- forutsetningen

- At

- revisjon

- augmented

- austin

- autentisert

- Autentisering

- autorisasjon

- automatisere

- automatisk

- tilgjengelighet

- tilgjengelig

- AWS

- AWS Lambda

- tilbake

- bakgrunner

- basen

- basert

- BE

- Bær

- fordi

- bli

- blir

- vært

- før du

- vegne

- bak

- nytte

- Fordeler

- BEST

- beste praksis

- Bedre

- Blogg

- bok

- Bot

- både

- roboter

- Bunn

- merke

- budsjett

- bygge

- Bygning

- bygget

- virksomhet

- bedrifter

- men

- by

- ring

- CAN

- evner

- Karriere

- nøye

- saken

- saker

- Kategori

- forårsaket

- sentrum

- sentralisert

- viss

- sertifisering

- kjede

- utfordringer

- endring

- ladet

- chatbot

- kontroll

- Sjekker

- Chicago

- krav

- fjerne

- Klinisk

- kliniske studier

- Cloud

- cloud computing

- skytjenester

- samle

- samling

- kommersielt

- Felles

- Kommunikasjon

- Selskaper

- Selskapet

- Selskapets

- konkurranse

- Terminado

- fullført

- komplekse

- kompleksitet

- overholde

- fatte

- datamaskin

- Datateknikk

- informatikk

- databehandling

- konsentrasjon

- konsept

- konsis

- gjennomført

- sammenløp

- Koble

- forbinder

- hensyn

- betraktninger

- ansett

- konsistent

- Består

- Konsoll

- konsortium

- forbruke

- forbruk

- kontakt

- kontakt senter

- inneholder

- innhold

- kontekst

- kontinuerlig

- bidrar

- kontroll

- kontrollerende

- bekvemmelighet

- Samtale

- conversational

- samtaler

- Bedriftens

- korrigere

- Kostnad

- Kostnader

- crawler

- skape

- Skap verdi

- opprettet

- Opprette

- kreditt

- kriterier

- kritisk

- CRM

- avgjørende

- kuratert

- Gjeldende

- I dag

- kunde

- Kundedeltakelse

- kundeopplevelse

- Kundeservice

- Kundeservice

- Kunder

- daglig

- Dallas

- dato

- datapunkter

- datasett

- Database

- Dato

- Desember

- bestemme

- avgjørelse

- Beslutningstaking

- avgjørelser

- Grad

- levert

- avhengig

- utplassert

- utplasserings

- beskrive

- utforming

- Til tross for

- detaljer

- oppdaget

- Gjenkjenning

- Utvikler

- Utvikling

- utviklingen

- forskjellig

- vanskelig

- oppdage

- distribueres

- dokumentasjon

- dokumenter

- gjør

- ikke

- stasjonen

- varighet

- e

- enklere

- lett

- Økonomi

- økosystem

- utgave

- effektivitet

- innsats

- enten

- valgbarhet

- emalje

- e-post

- Ansatt

- ansatte

- muliggjør

- oppmuntrer

- Endpoint

- energi

- engasjement

- Motor

- Ingeniørarbeid

- berikende

- sikre

- sikrer

- sikrer

- Enterprise

- bedrifter

- enheter

- feil

- eskalering

- anslag

- etc

- Selv

- eksempel

- henrette

- eksisterende

- dyrt

- erfaring

- Forklar

- forklarer

- utdrag

- ekstrakter

- Face

- familie

- Trekk

- Fed

- færre

- Figur

- filet

- fyll

- fylt

- fylling

- filtrere

- finansiell

- Økonomiske data

- økonomihistorie

- finansinstitusjon

- finansiering

- Finn

- finne

- Først

- fleksibilitet

- flyten

- fokusering

- etter

- Til

- skjema

- skjemaer

- fora

- funnet

- Fundament

- rammer

- Gratis

- venner

- fra

- moro

- funksjon

- funksjoner

- videre

- Gevinst

- gateway

- generere

- generasjonen

- generative

- Generativ AI

- få

- gitt

- gir

- Giving

- Regjeringen

- sterkt

- Grow

- Økende

- Vokser

- veiledning

- retningslinjer

- håndtere

- Håndterer

- Håndtering

- Ha

- å ha

- he

- Helse

- helseinformasjon

- helsetjenester

- hjelpe

- hjelpe

- hjelper

- her

- Høy

- svært

- hans

- historie

- holder

- vert

- Vertskapet

- TIMER

- Hvordan

- Hvordan

- Men

- hr

- HTML

- HTTPS

- menneskelig

- i

- identifikator

- identifikatorer

- identifiserer

- identifisere

- identifisering

- Identitet

- if

- illustrerer

- iverksette

- implementere

- implikasjoner

- forbedre

- forbedrer

- bedre

- in

- dyptgående

- unøyaktig

- inkludere

- inkluderer

- Inkludert

- Inntekt

- inntektsskatt

- Øke

- øker

- indeks

- indeksert

- indekser

- individer

- bransjer

- informere

- informasjon

- Informasjonssystemer

- informasjonsteknologi

- informert

- arv

- inngang

- f.eks

- instant

- i stedet

- Institusjon

- institusjoner

- forsikring

- integrert

- Integrerer

- integrering

- Intelligens

- Intelligent

- hensikt

- samhandle

- interaktiv

- interessert

- Interface

- intern

- internasjonalt

- inn

- investering

- utstedelse

- IT

- varer

- reise

- jpg

- Hold

- kunnskap

- kjent

- Språk

- stor

- lag

- føre

- LÆRE

- læring

- mindre

- Nivå

- utnytte

- Bibliotek

- begrensning

- begrensninger

- linje

- Bor

- LLM

- lån

- Lån

- logg

- logisk

- Lang

- lang tid

- lenger

- Se

- Lot

- elsker

- lave kostnader

- lavere

- lojal

- Lojalitet

- maskin

- maskinlæring

- laget

- vedlikeholde

- gjøre

- GJØR AT

- Making

- administrer

- ledelse

- måte

- håndbok

- manuelt

- mange

- marked

- markedsundersøkelser

- mestere

- Kan..

- midler

- medisinsk

- medlem

- Minne

- microservices

- Microsoft

- millioner

- millioner

- tankene

- ML

- modell

- modeller

- Moduler

- Måned

- månedlig

- mer

- mest

- flere

- innfødt

- nødvendig

- Trenger

- nødvendig

- behov

- Ny

- neste

- nlp

- varsling

- tall

- Oakland

- oauth

- of

- Tilbud

- ofte

- Olje

- on

- onboarding

- gang

- ONE

- pågående

- bare

- åpen

- betjene

- drift

- operasjonell

- Opportunity

- optimalisering

- Alternativ

- alternativer

- or

- rekkefølge

- organisasjoner

- original

- Annen

- vår

- ut

- omriss

- utenfor

- enn

- paradigmet

- del

- deler

- bestått

- lidenskapelig

- pasient

- Betale

- Ansatte

- for

- ytelse

- tillatelser

- personlig

- personlig informasjon

- personlig

- Pharmaceutical

- Pillar

- fly

- plato

- Platon Data Intelligence

- PlatonData

- vær så snill

- Point

- poeng

- Politikk

- pools

- Portal

- portretter

- muligheter

- mulighet

- Post

- powered

- praksis

- presentere

- forebygge

- forrige

- tidligere

- prising

- prismodell

- Før

- prioritet

- privatliv

- problemer

- prosedyrer

- fortsette

- prosess

- Bearbeidet

- Prosesser

- prosessering

- Produksjon

- produktivitet

- Produkter

- profesjonell

- fagfolk

- eiendom

- gi

- forutsatt

- tilbydere

- gi

- publisert

- kjøpt

- Q & A

- kvalifisere

- kvalifiserende

- spørsmål

- spørsmål

- spørsmål

- Rask

- raskt

- område

- Sats

- Lese

- Lesning

- sanntids

- nylig

- nylig

- redusere

- reduserer

- referere

- refererer

- om

- regelmessig

- forskrifter

- forholdet

- relevans

- relevant

- avhengige

- forblir

- husker

- fjerne

- anmode

- forespørsler

- krever

- påkrevd

- Krav

- forskning

- forskere

- oppløsning

- løse

- Ressurser

- svar

- svar

- ansvar

- REST

- resultere

- retur

- anmeldt

- ikke sant

- risikoer

- robust

- Rute

- rennende

- s

- sagemaker

- salg

- San

- San Jose

- tilfredshet

- Spar

- skalerbar

- Skala

- scenario

- Vitenskap

- Resultat

- skript

- Søk

- søker

- Seattle

- Sekund

- sekunder

- Seksjon

- sikre

- sikkert

- sikkerhet

- Å Sell

- send

- senior

- sensitive

- sendt

- server~~POS=TRUNC

- serverer

- tjeneste

- Tjenester

- sett

- sett

- innstillinger

- flere

- hun

- skift

- mangler

- bør

- showcased

- viste

- vist

- siloer

- lignende

- Enkelt

- forenkle

- siden

- enkelt

- størrelse

- mindre

- So

- selskap

- Software

- programvareutvikling

- software engineering

- løsning

- Solutions

- noen

- kilde

- Kilder

- spesialisert

- spesifikk

- spesielt

- bruke

- utgifter

- Standard

- Tilstand

- status

- opphold

- Trinn

- Steps

- Still

- lagring

- oppbevare

- lagret

- lagring

- stresset

- stuffing

- betydelig

- slik

- foreslår

- oppsummere

- støtte

- system

- Systemer

- bord

- tar

- oppgaver

- skatt

- lag

- lag

- Teknologi

- vilkår

- texas

- tekst

- tekstlig

- Det

- De

- informasjonen

- deres

- seg

- deretter

- Der.

- Disse

- de

- tredjeparts

- denne

- Gjennom

- billett

- billettsystem

- nivået

- tid

- tidkrevende

- rettidig

- ganger

- tidsstempel

- titan

- til

- i dag

- tokens

- verktøy

- verktøy

- Sporbarhet

- tradisjonelt

- trent

- Kurs

- transformator

- Åpenhet

- behandling

- prøve

- forsøk

- tutorial

- typer

- ute av stand

- forstå

- forståelse

- unik

- universiteter

- universitet

- University of Chicago

- up-to-date

- oppdatert

- oppdatering

- bruke

- bruk sak

- brukt

- Bruker

- Brukere

- bruker

- ved hjelp av

- bruke

- benyttes

- utnytte

- verdi

- ulike

- Verifisering

- verifisere

- vertikaler

- av

- video

- videoer

- Voice

- vente

- venter

- var

- washington

- måter

- we

- web

- Webapplikasjon

- nettapplikasjoner

- webtjenester

- VI VIL

- var

- Hva

- når

- om

- hvilken

- mens

- HVEM

- bred

- Bred rekkevidde

- med

- innenfor

- Arbeid

- arbeidsflyt

- arbeid

- ville

- skrevet

- år

- Du

- Din

- zephyrnet