Data driver maskinlæring (ML); kvaliteten på data har en direkte innvirkning på kvaliteten på ML-modeller. Derfor er det avgjørende å forbedre datakvaliteten og bruke de riktige funksjonsteknikkene for å lage nøyaktige ML-modeller. ML-utøvere itererer ofte kjedelig på funksjonsteknikk, valg av algoritmer og andre aspekter ved ML på jakt etter optimale modeller som generaliserer godt på data fra den virkelige verden og leverer de ønskede resultatene. Fordi hastighet i å gjøre forretninger er uforholdsmessig viktig, kan denne ekstremt kjedelige og iterative prosessen føre til prosjektforsinkelser og tapte forretningsmuligheter.

Amazon SageMaker Data Wrangler reduserer tiden for å samle og forberede data for ML fra uker til minutter, og Amazon SageMaker Autopilot bygger, trener og justerer automatisk de beste ML-modellene basert på dataene dine. Med autopilot beholder du fortsatt full kontroll og synlighet over data og modell. Begge tjenestene er spesialbygd for å gjøre ML-utøvere mer produktive og akselerere tiden til verdi.

Data Wrangler gir nå en enhetlig opplevelse som lar deg forberede data og sømløst trene en ML-modell i autopilot. Med denne nylig lanserte funksjonen kan du nå klargjøre dataene dine i Data Wrangler og enkelt starte Autopilot-eksperimenter direkte fra Data Wrangler-brukergrensesnittet (UI). Med bare noen få klikk kan du automatisk bygge, trene og justere ML-modeller, noe som gjør det enklere å bruke toppmoderne funksjonsteknikker, trene ML-modeller av høy kvalitet og få innsikt fra dataene dine raskere.

I dette innlegget diskuterer vi hvordan du kan bruke denne nye integrerte opplevelsen i Data Wrangler til å analysere datasett og enkelt bygge ML-modeller av høy kvalitet i Autopilot.

Datasettoversikt

Pima-indianere er en urfolksgruppe som bor i Mexico og Arizona, USA. Studier vise Pima-indianere som en høyrisikobefolkningsgruppe for diabetes mellitus. Å forutsi sannsynligheten for en persons risiko og mottakelighet for en kronisk sykdom som diabetes er en viktig oppgave for å forbedre helsen og velværet til denne ofte underrepresenterte minoritetsgruppen.

Vi bruker Pima Indian Diabetes offentlig datasett å forutsi følsomheten til et individ for diabetes. Vi fokuserer på den nye integrasjonen mellom Data Wrangler og Autopilot for å klargjøre data og automatisk lage en ML-modell uten å skrive en eneste linje med kode.

Datasettet inneholder informasjon om Pima indiske kvinner 21 år eller eldre og inkluderer flere medisinske prediktorvariabler (uavhengige) og en målvariabel (avhengig), utfall. Følgende diagram beskriver kolonnene i datasettet vårt.

| Kolonne Navn | Beskrivelse |

| Graviditeter | Antall ganger gravid |

| Glukose | Plasmaglukosekonsentrasjon i en oral glukosetoleransetest innen 2 timer |

| Blodtrykk | Diastolisk blodtrykk (mm Hg) |

| Hudtykkelse | Triceps hudfoldtykkelse (mm) |

| Insulin | 2-timers seruminsulin (mu U/ml) |

| BMI | Kroppsmasseindeks (vekt i kg/(høyde i m)^2) |

| Diabetes Stamtavle | Diabetes stamtavle funksjon |

| Alder | Alder i år |

| Utfallet | Målvariabelen |

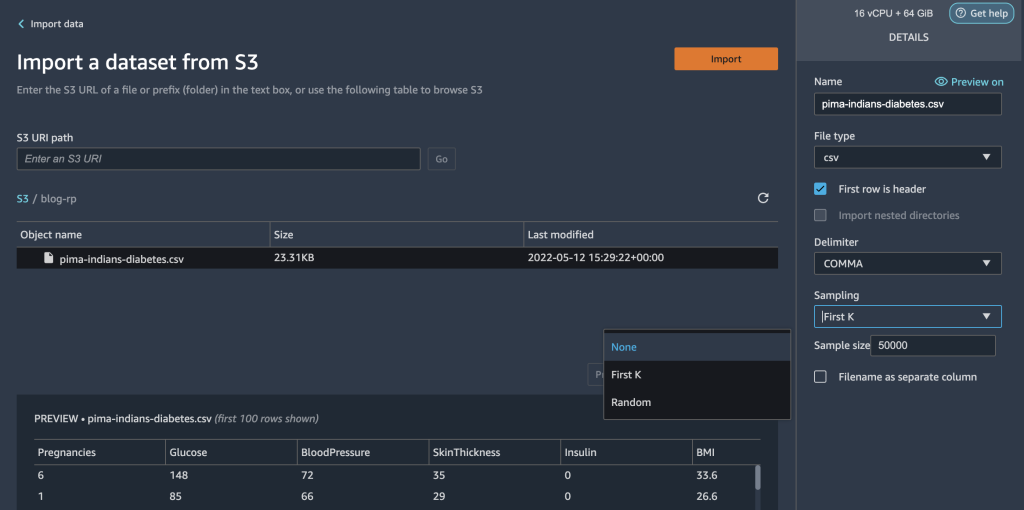

Datasettet inneholder 768 poster, med 9 funksjoner totalt. Vi lagrer dette datasettet i Amazon enkel oppbevaringsbøtte (Amazon S3) som en CSV-fil og importer deretter CSV-en direkte til en Data Wrangler-flyt fra Amazon S3.

Løsningsoversikt

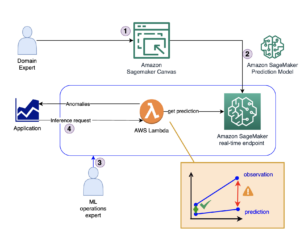

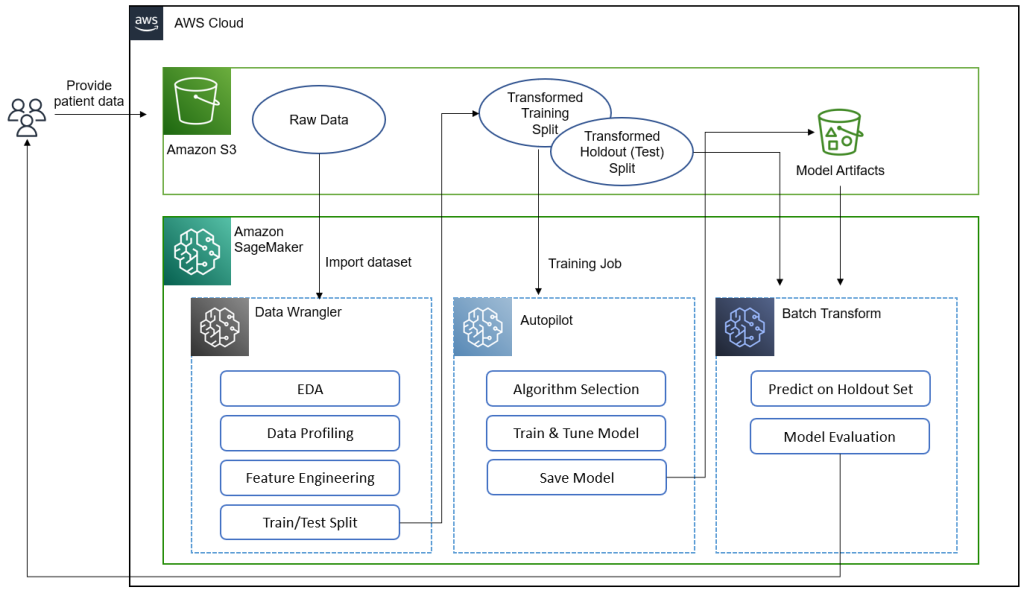

Følgende diagram oppsummerer hva vi oppnår i dette innlegget.[KT1]

Dataforskere, leger og andre medisinske domeneeksperter gir pasientdata informasjon om glukosenivåer, blodtrykk, kroppsmasseindeks og andre funksjoner som brukes til å forutsi sannsynligheten for å ha diabetes. Med datasettet i Amazon S3 importerer vi datasettet til Data Wrangler for å utføre utforskende dataanalyse (EDA), dataprofilering, funksjonsutvikling og dele opp datasettet i tog og test for modellbygging og -evaluering.

Vi bruker deretter Autopilots nye funksjonsintegrasjon for raskt å bygge en modell direkte fra Data Wrangler-grensesnittet. Vi velger Autopilots beste modell basert på modellen med høyest F-beta-score. Etter at autopiloten finner den beste modellen, kjører vi en SageMaker Batch Transform jobb på testen (holdout) satt med modellartefakter av den beste modellen for evaluering.

Medisinske eksperter kan gi nye data til den validerte modellen for å få en prediksjon for å se om en pasient sannsynligvis vil ha diabetes. Med denne innsikten kan medisinske eksperter starte behandling tidlig for å forbedre helsen og velværet til sårbare befolkninger. Medisinske eksperter kan også forklare en modells prediksjon ved å referere til modellens detaljer i autopiloten fordi de har full oversikt over modellens forklarbarhet, ytelse og artefakter. Denne synligheten i tillegg til validering av modellen fra testsettet gir medisinske eksperter større tillit til modellens prediksjonsevne.

Vi leder deg gjennom følgende trinn på høyt nivå.

- Importer datasettet fra Amazon S3.

- Utfør EDA og dataprofilering med Data Wrangler.

- Utfør funksjonsutvikling for å håndtere uteliggere og manglende verdier.

- Del data inn i tog- og testsett.

- Tren og bygg en modell med autopilot.

- Test modellen på en holdout-prøve med en SageMaker-notisbok.

- Analyser validering og testsettets ytelse.

Forutsetninger

Fullfør følgende forutsetningstrinn:

- Last opp datasettet til en S3-bøtte etter eget valg.

- Sørg for at du har de nødvendige tillatelsene. For mer informasjon, se Kom i gang med Data Wrangler.

- Sett opp et SageMaker-domene konfigurert til å bruke Data Wrangler. For instruksjoner, se Ombord på Amazon SageMaker Domain.

Importer datasettet ditt med Data Wrangler

Du kan integrere en Data Wrangler-dataflyt i ML-arbeidsflytene dine for å forenkle og strømlinjeforme dataforbehandling og funksjonsutvikling ved å bruke lite eller ingen koding. Fullfør følgende trinn:

- Lage en ny Data Wrangler flyt.

Hvis dette er første gang du åpner Data Wrangler, kan det hende du må vente noen minutter før den er klar.

- Velg datasettet som er lagret i Amazon S3 og importer det til Data Wrangler.

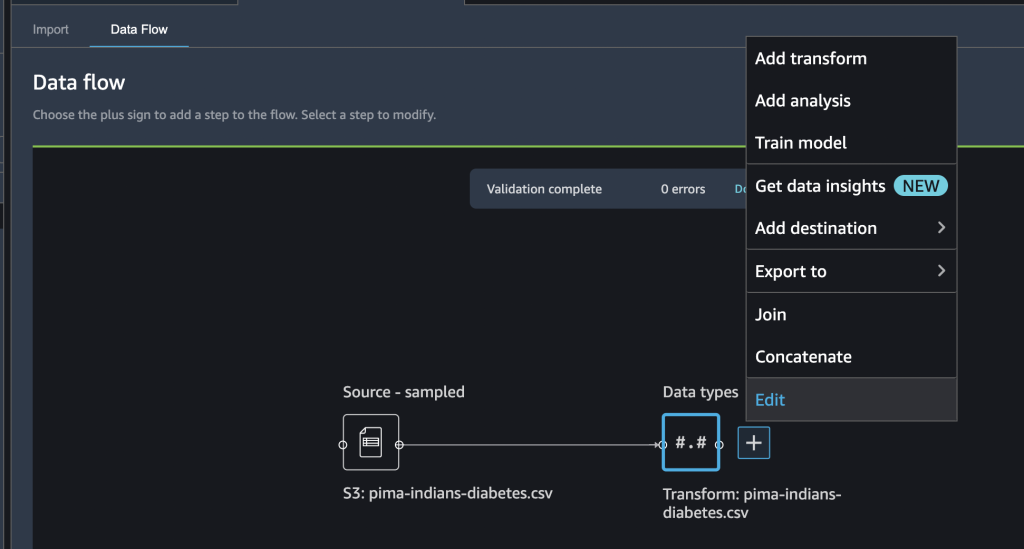

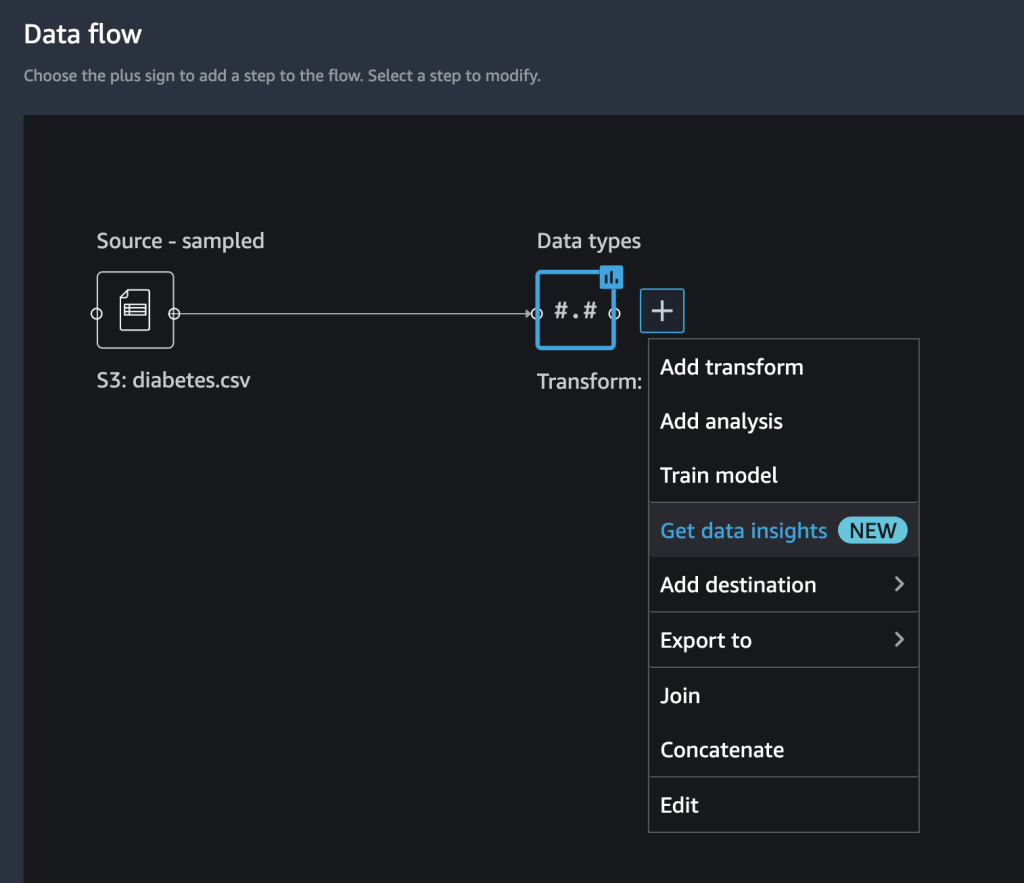

Etter at du har importert datasettet, bør du se begynnelsen av en dataflyt i Data Wrangler-grensesnittet. Du har nå et flytdiagram.

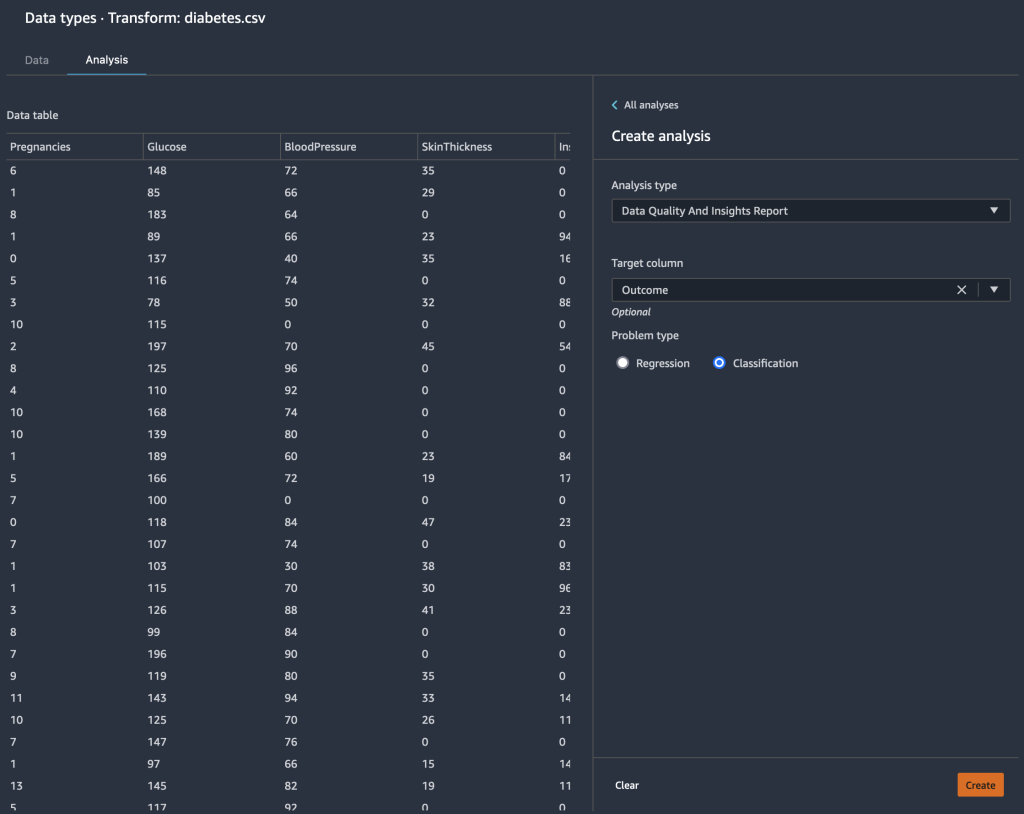

- Velg plusstegnet ved siden av Datatyper Og velg Rediger for å bekrefte at Data Wrangler automatisk utledet de riktige datatypene for datakolonnene dine.

Hvis datatypene ikke er riktige, kan du enkelt endre dem gjennom brukergrensesnittet. Hvis flere datakilder er tilstede, kan du slå sammen eller sette dem sammen.

Vi kan nå lage en analyse og legge til transformasjoner.

Utfør utforskende dataanalyse med datainnsiktsrapporten

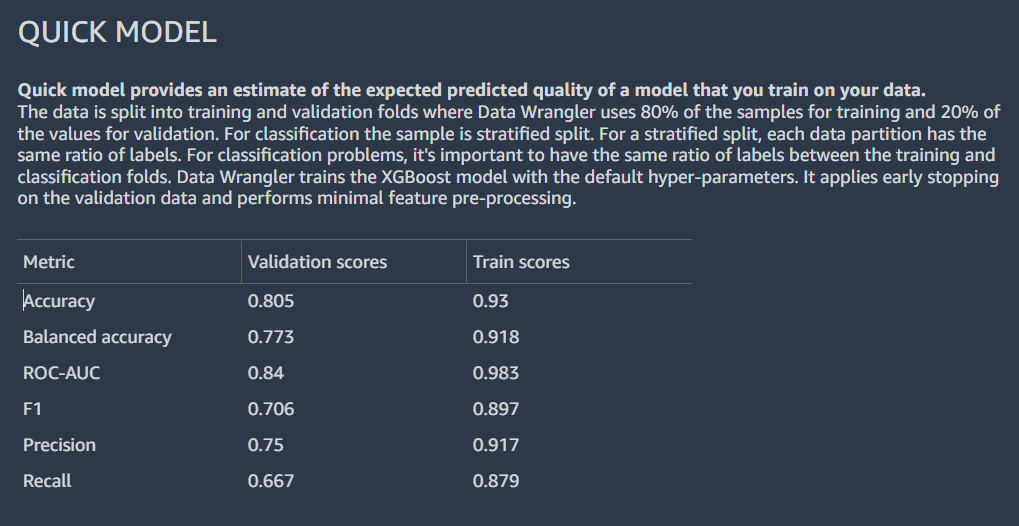

Utforskende dataanalyse er en kritisk del av ML-arbeidsflyten. Vi kan bruke den nye datainnsiktsrapporten fra Data Wrangler for å få en bedre forståelse av profilen og distribusjonen av dataene våre. Rapporten inkluderer oppsummeringsstatistikk, advarsler om datakvalitet, innsikt i målkolonne, en rask modell og informasjon om unormale og dupliserte rader.

- Velg plusstegnet ved siden av Datatyper Og velg Få datainnsikt.

- Til Target kolonne, velg Utfallet.

- Til Problemtype, og (valgfritt) velg Klassifisering.

- Velg Opprett.

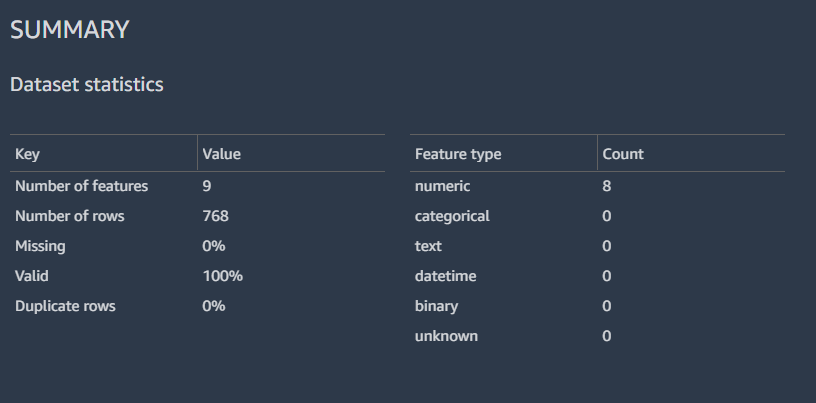

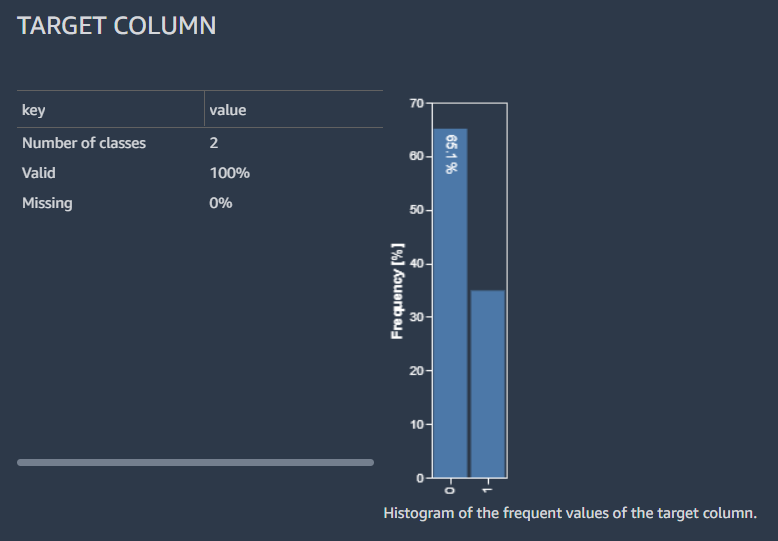

Resultatene viser et sammendrag av data med datasettstatistikken.

Vi kan også se fordelingen av de merkede radene med et histogram, et estimat av den forventede predikerte kvaliteten til modellen med hurtigmodellfunksjonen og en funksjonssammendragstabell.

Vi går ikke inn på detaljene ved å analysere datainnsiktsrapporten; referere til Akselerer dataforberedelsen med datakvalitet og innsikt i Amazon SageMaker Data Wrangler for ytterligere detaljer om hvordan du kan bruke datainnsiktsrapporten til å fremskynde dataforberedelsestrinnene dine.

Utfør funksjonsteknikk

Nå som vi har profilert og analysert fordelingen av våre input-kolonner på et høyt nivå, kan den første vurderingen for å forbedre kvaliteten på dataene våre være å håndtere manglende verdier.

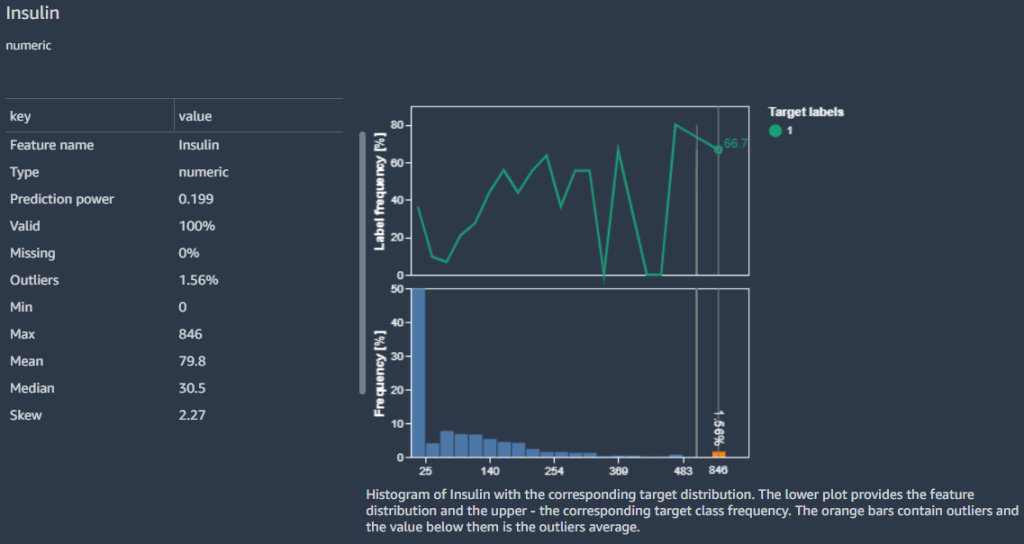

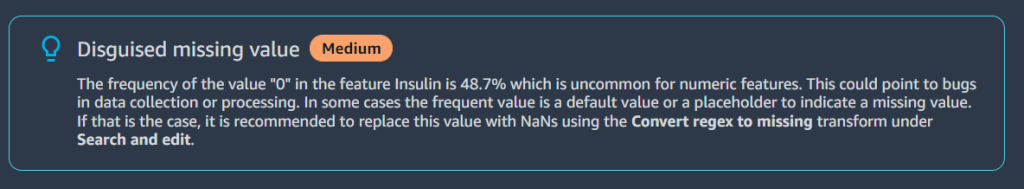

For eksempel vet vi at nuller (0) for Insulin kolonnen representerer manglende verdier. Vi kunne følge anbefalingen om å erstatte nullene med NaN. Men ved nærmere undersøkelse finner vi at minimumsverdien er 0 for andre kolonner som f.eks Glucose, BloodPressure, SkinThicknessog BMI. Vi trenger en måte å håndtere manglende verdier på, men må være følsomme for kolonner med nuller som gyldige data. La oss se hvordan vi kan fikse dette.

på Funksjonsdetaljer avsnitt, tar rapporten opp en Forkledd manglende verdi advarsel for funksjonen Insulin.

Fordi nuller i Insulin kolonnen faktisk mangler data, bruker vi Konverter regulært uttrykk til manglende transform for å transformere null verdier til tom (manglende verdier).

- Velg plusstegnet ved siden av Data typer Og velg Legg til forvandle.

- Velg Søk og rediger.

- Til Transform, velg Konverter regulært uttrykk til manglende.

- Til Input kolonner, velg kolonnene

Insulin,Glucose,BloodPressure,SkinThicknessogBMI. - Til Mønster, Tast inn

0. - Velg Forhåndsvisning og Legg til for å lagre dette trinnet.

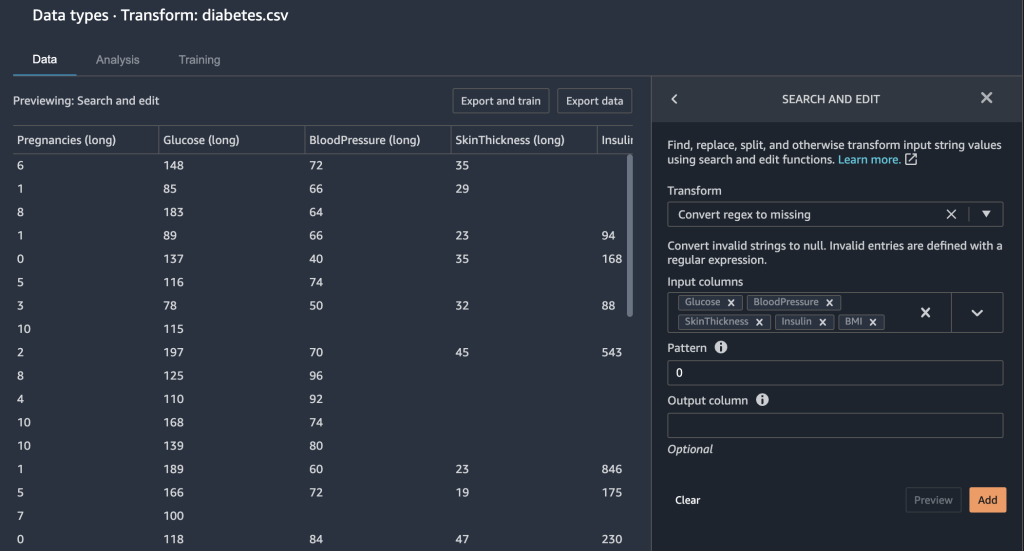

De 0 oppføringene under Insulin, Glucose, BloodPressure, SkinThicknessog BMI mangler nå verdier.

Data Wrangler gir deg noen andre alternativer for å fikse manglende verdier.

- Vi håndterer manglende verdier ved å beregne den omtrentlige medianen for

Glucosekolonne.

Vi ønsker også å sikre at funksjonene våre er i samme skala. Vi ønsker ikke ved et uhell å legge mer vekt på en bestemt funksjon bare fordi de inneholder et større numerisk område. Vi normaliserer funksjonene våre for å gjøre dette.

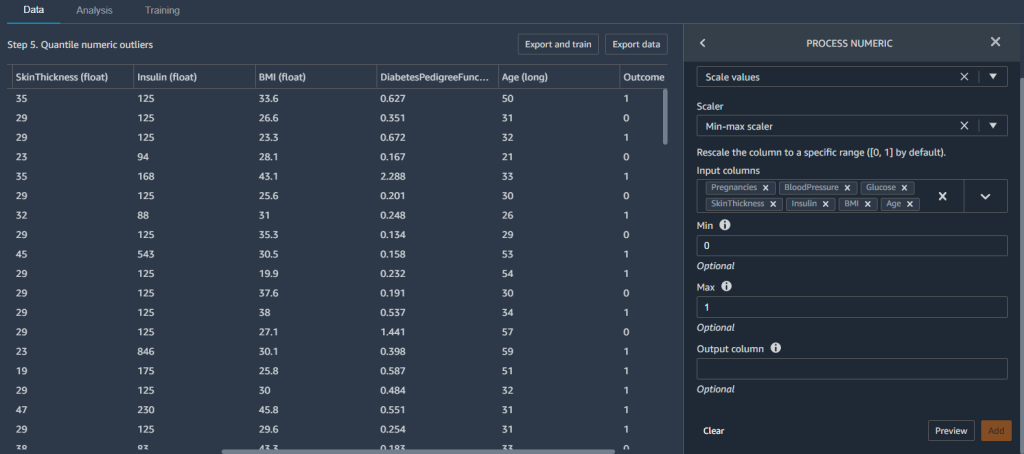

- Legg til en ny Prosess numerisk transformere og velge Skala verdier.

- Til Scaler, velg Min-max scaler.

- Til Inndatakolonner, velg kolonnene

Pregnancies,BloodPressure,Glucose,SkinThickness,Insulin,BMIogAge. - Sett Min til

0og max til1.

Dette sikrer at funksjonene våre er mellom verdiene 0 og 1.

Nå som vi har laget noen funksjoner, deler vi datasettet vårt i trening og testing før vi bygger en modell.

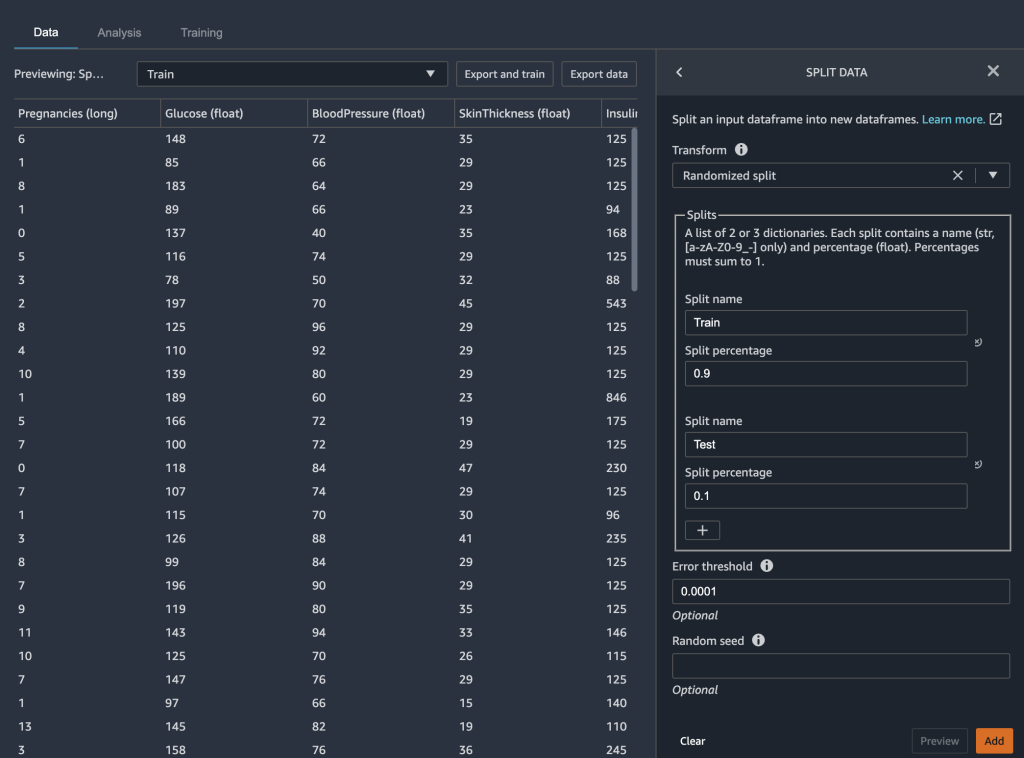

Del data inn i trening og testing

I modellbyggingsfasen av ML-arbeidsflyten din tester du effektiviteten til modellen din ved å kjøre batch-forutsigelser. Du kan sette til side et test- eller holdout-datasett for evaluering for å se hvordan modellen din presterer ved å sammenligne spådommene med sannheten. Generelt, hvis flere av modellens spådommer samsvarer med true etiketter, kan vi fastslå at modellen gir gode resultater.

Vi bruker Data Wrangler til å dele opp datasettet vårt for testing. Vi beholder 90 % av datasettet vårt for opplæring fordi vi har et relativt lite datasett. De resterende 10 % av datasettet vårt fungerer som testdatasettet. Vi bruker dette datasettet for å validere autopilotmodellen senere i dette innlegget.

Vi deler dataene våre ved å velge Del data transformere og velge Randomisert splittelse som metoden. Vi angir 0.9 som delprosent for trening og 0.1 for testing.

Med datatransformasjonen og de tekniske trinnene fullført, er vi nå klare til å trene opp en modell.

Tren og valider modellen

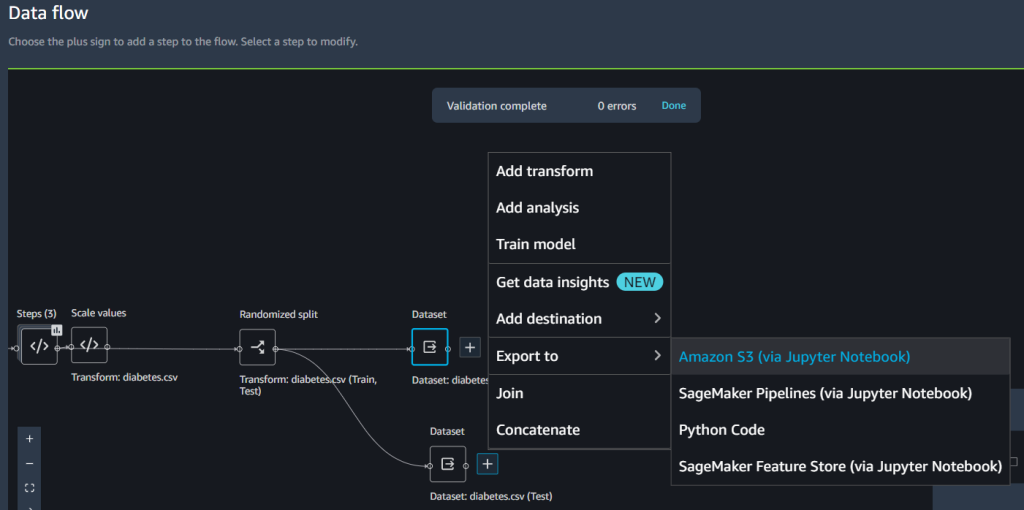

Vi kan bruke den nye Data Wrangler-integrasjonen med Autopilot til å trene en modell direkte fra Data Wrangler-dataflyt-UI.

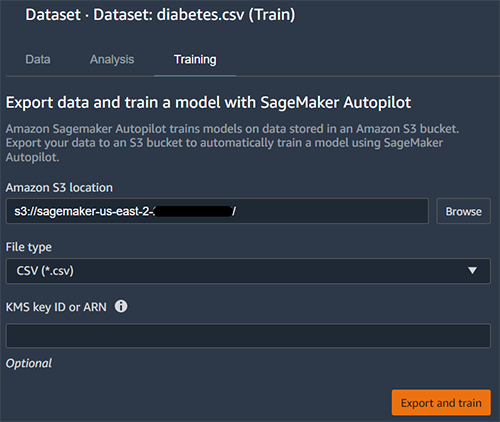

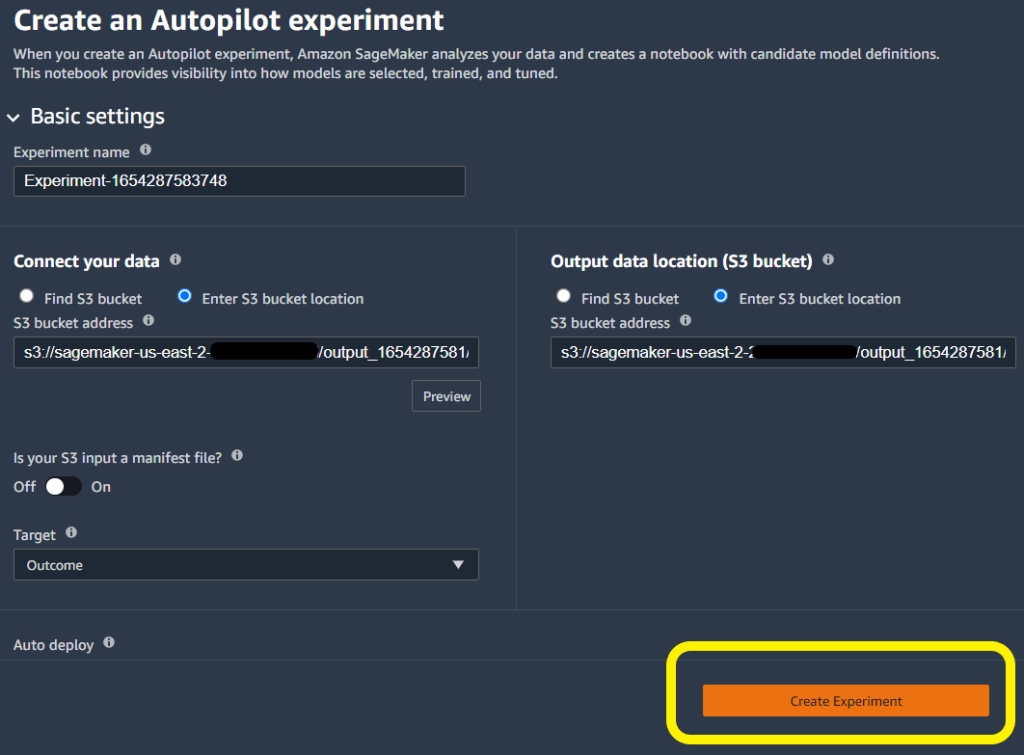

- Velg plusstegnet ved siden av datasett Og velg Togmodell.

- Til Amazon S3 plassering, spesifiser Amazon S3-plasseringen der SageMaker eksporterer dataene dine.

Autopilot bruker denne plasseringen til å trene en modell automatisk, noe som sparer deg for tid fra å måtte definere utdataplasseringen for Data Wrangler-flyten, og deretter måtte definere inngangsplasseringen til autopilotens treningsdata. Dette gir en mer sømløs opplevelse.

- Velg Eksport og trene å sette i gang modellbygging med autopilot.

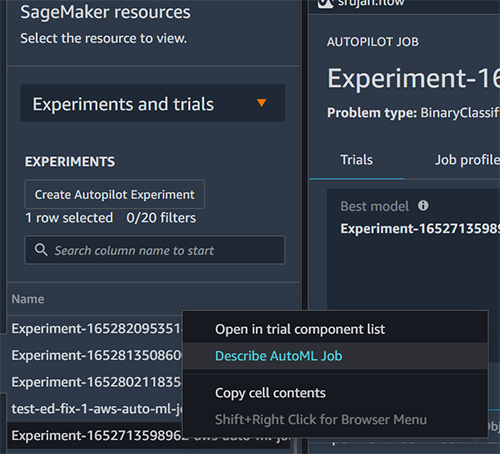

Autopiloten velger automatisk treningsdatainndata og utdataplasseringer. Du trenger bare å spesifisere målkolonnen og klikke Lag eksperiment å trene modellen din.

Test modellen på en holdout-prøve

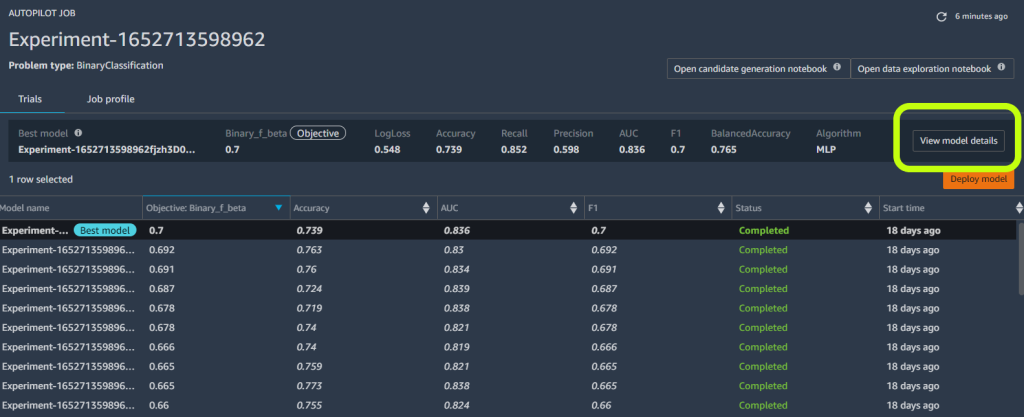

Når autopiloten fullfører eksperimentet, kan vi se treningsresultatene og utforske den beste modellen.

- Velg Se modelldetaljer for ønsket modell, velg deretter Ytelse fanen på siden med modelldetaljer.

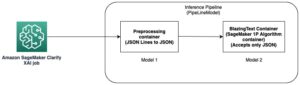

De Ytelse fanen viser flere modellmåletester, inkludert en forvirringsmatrise, området under presisjons-/gjenkallingskurven (AUCPR) og området under mottakerdriftskarakteristikken (ROC). Disse illustrerer den generelle valideringsytelsen til modellen, men de forteller oss ikke om modellen vil generalisere godt. Vi må fortsatt kjøre evalueringer på usynlige testdata for å se hvor nøyaktig modellen forutsier om en person vil ha diabetes.

For å sikre at modellen generaliserer godt nok, setter vi testutvalget til side for uavhengig prøvetaking. Vi kan gjøre det i Data Wrangler flow UI.

- Velg plusstegnet ved siden av datasett, velg Eksport til, og velg Amazon S3.

- Angi en Amazon S3-bane.

Vi refererer til denne banen når vi kjører batch-inferens for validering i neste avsnitt.

- Opprett en ny SageMaker-notisbok for å utføre batch-inferencing på holdout-prøven og vurdere testytelsen. Se følgende GitHub repo for en prøve notatbok å kjøre batch-inferens for validering.

Analyser validering og testsettets ytelse

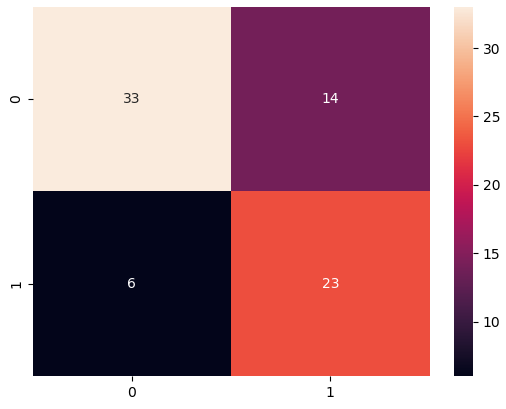

Når batchtransformasjonen er fullført, lager vi en forvirringsmatrise for å sammenligne de faktiske og forutsagte resultatene av holdout-datasettet.

Vi ser 23 sanne positive og 33 sanne negative fra resultatene våre. I vårt tilfelle refererer sanne positive til modellen som korrekt forutsier et individ som har diabetes. I motsetning til dette refererer sanne negative til modellen som korrekt forutsier et individ som ikke har diabetes.

I vårt tilfelle er presisjon og tilbakekalling viktige beregninger. Presisjon måler i hovedsak alle individer som er spådd å ha diabetes, hvor mange har egentlig diabetes? I motsetning hjelper tilbakekalling med å måle alle individer som faktisk har diabetes, hvor mange ble spådd å ha diabetes? For eksempel kan det være lurt å bruke en modell med høy presisjon fordi du ønsker å behandle så mange individer som mulig, spesielt hvis det første stadiet av behandlingen ikke har noen effekt på individer uten diabetes (disse er falske positive – de som er merket som å ha det når de faktisk ikke gjør det).

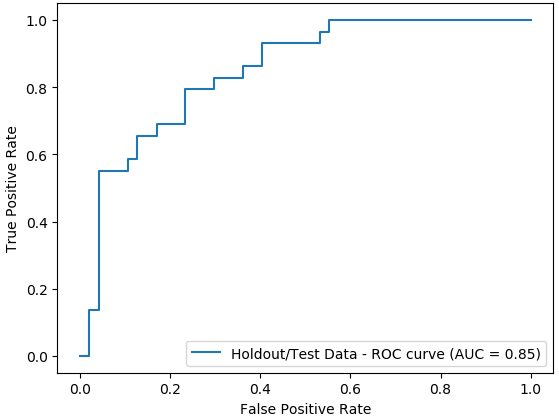

Vi plotter også området under ROC-kurven (AUC)-grafen for å evaluere resultatene. Jo høyere AUC, jo bedre er modellen til å skille mellom klasser, som i vårt tilfelle er hvor godt modellen presterer til å skille pasienter med og uten diabetes.

konklusjonen

I dette innlegget demonstrerte vi hvordan du integrerer databehandlingen din, med konstruksjon og modellbygging ved hjelp av Data Wrangler og Autopilot. Vi fremhevet hvordan du enkelt kan trene og tune en modell med autopilot direkte fra Data Wrangler-brukergrensesnittet. Med denne integreringsfunksjonen kan vi raskt bygge en modell etter å ha fullført funksjonsutvikling, uten å skrive noen kode. Deretter refererte vi til Autopilots beste modell for å kjøre batch-prediksjoner ved å bruke AutoML-klassen med SageMaker Python SDK.

Lavkode- og AutoML-løsninger som Data Wrangler og Autopilot fjerner behovet for å ha dyp kodingskunnskap for å bygge robuste ML-modeller. Kom i gang med Data Wrangler i dag for å oppleve hvor enkelt det er å bygge ML-modeller ved hjelp av SageMaker autopilot.

Om forfatterne

Peter Chung er en løsningsarkitekt for AWS, og brenner for å hjelpe kunder med å avdekke innsikt fra dataene deres. Han har bygget løsninger for å hjelpe organisasjoner med å ta datadrevne beslutninger i både offentlig og privat sektor. Han innehar alle AWS-sertifiseringer samt to GCP-sertifiseringer. Han liker kaffe, matlaging, å være aktiv og tilbringe tid med familien.

Peter Chung er en løsningsarkitekt for AWS, og brenner for å hjelpe kunder med å avdekke innsikt fra dataene deres. Han har bygget løsninger for å hjelpe organisasjoner med å ta datadrevne beslutninger i både offentlig og privat sektor. Han innehar alle AWS-sertifiseringer samt to GCP-sertifiseringer. Han liker kaffe, matlaging, å være aktiv og tilbringe tid med familien.

Pradeep Reddy er senior produktsjef i SageMaker Low/No Code ML-teamet, som inkluderer SageMaker Autopilot, SageMaker Automatic Model Tuner. Utenom jobben liker Pradeep å lese, løpe og nørde med datamaskiner i palmestørrelse som raspberry pi og annen hjemmeautomatiseringsteknologi.

Pradeep Reddy er senior produktsjef i SageMaker Low/No Code ML-teamet, som inkluderer SageMaker Autopilot, SageMaker Automatic Model Tuner. Utenom jobben liker Pradeep å lese, løpe og nørde med datamaskiner i palmestørrelse som raspberry pi og annen hjemmeautomatiseringsteknologi.

Arunprasath Shankar er en kunstig intelligens og maskinlæring (AI / ML) spesialistløsningsarkitekt med AWS, som hjelper globale kunder å skalere sine AI-løsninger effektivt og effektivt i skyen. På fritiden liker Arun å se sci-fi-filmer og lytte til klassisk musikk.

Arunprasath Shankar er en kunstig intelligens og maskinlæring (AI / ML) spesialistløsningsarkitekt med AWS, som hjelper globale kunder å skalere sine AI-løsninger effektivt og effektivt i skyen. På fritiden liker Arun å se sci-fi-filmer og lytte til klassisk musikk.

Srujan Gopu er en Senior Frontend Engineer i SageMaker Low Code/No Code ML som hjelper kunder med Autopilot og Canvas-produkter. Når han ikke koder, liker Srujan å ta en løpetur med hunden sin Max, lytte til lydbøker og VR-spillutvikling.

Srujan Gopu er en Senior Frontend Engineer i SageMaker Low Code/No Code ML som hjelper kunder med Autopilot og Canvas-produkter. Når han ikke koder, liker Srujan å ta en løpetur med hunden sin Max, lytte til lydbøker og VR-spillutvikling.

- Myntsmart. Europas beste Bitcoin og Crypto Exchange.

- Platoblokkkjede. Web3 Metaverse Intelligence. Kunnskap forsterket. FRI TILGANG.

- CryptoHawk. Altcoin Radar. Gratis prøveperiode.

- Kilde: https://aws.amazon.com/blogs/machine-learning/unified-data-preparation-and-model-training-with-amazon-sagemaker-data-wrangler-and-amazon-sagemaker-autopilot/

- "

- 100

- 7

- 9

- a

- evne

- Om oss

- akselerere

- nøyaktig

- aktiv

- tillegg

- Ytterligere

- AI

- algoritmer

- Alle

- Amazon

- analyse

- analysere

- AREA

- Arizona

- kunstig

- kunstig intelligens

- Kunstig intelligens og maskinlæring

- lyd

- Automatisk

- automatisk

- Automatisering

- AWS

- fordi

- før du

- BEST

- mellom

- blod

- kroppen

- bøker

- bygge

- Bygning

- bygger

- virksomhet

- lerret

- saken

- viss

- valg

- Velg

- klasse

- klasser

- nærmere

- Cloud

- kode

- Koding

- Kaffe

- Kolonne

- fullføre

- fullført

- datamaskiner

- konsentrasjon

- selvtillit

- forvirring

- hensyn

- inneholder

- kontroll

- kunne

- skape

- opprettet

- Opprette

- kritisk

- skjøger

- Kunder

- dato

- dataanalyse

- databehandling

- avgjørelser

- dyp

- forsinkelser

- demonstrert

- avhengig

- detalj

- detaljer

- Bestem

- Utvikling

- direkte

- direkte

- diskutere

- skjermer

- distribusjon

- leger

- domene

- Tidlig

- lett

- effekt

- effektivt

- effektivt

- muliggjør

- ingeniør

- Ingeniørarbeid

- Enter

- spesielt

- hovedsak

- anslag

- evaluere

- evaluering

- eksempel

- forventet

- erfaring

- eksperiment

- eksperter

- utforske

- familie

- raskere

- Trekk

- Egenskaper

- Featuring

- funn

- Først

- første gang

- Fix

- flyten

- Fokus

- følge

- etter

- fra

- fullt

- spill

- generelt

- Global

- skal

- større

- Gruppe

- håndtere

- å ha

- Helse

- høyde

- hjelpe

- hjelpe

- hjelper

- Høy

- høykvalitets

- høy risiko

- høyere

- Fremhevet

- holder

- Hjemprodukt

- Hjemmeautomatisering

- Hvordan

- Hvordan

- HTTPS

- sykdom

- Påvirkning

- viktig

- forbedre

- bedre

- inkluderer

- Inkludert

- uavhengig

- indeks

- individuelt

- individer

- informasjon

- inngang

- innsikt

- integrere

- integrert

- integrering

- Intelligens

- Interface

- IT

- Jobb

- bli medlem

- Vet

- kunnskap

- etiketter

- større

- lansere

- lansert

- føre

- læring

- Nivå

- nivåer

- Sannsynlig

- linje

- Lytting

- lite

- leve

- plassering

- steder

- maskin

- maskinlæring

- vedlikeholde

- gjøre

- GJØR AT

- Making

- leder

- Match

- Matrix

- Saker

- måle

- målinger

- medisinsk

- Metrics

- Mexico

- minimum

- minoritet

- ML

- modell

- modeller

- mer

- Filmer

- flere

- musikk

- nødvendig

- neste

- NIH

- bærbare

- Antall

- åpning

- drift

- Muligheter

- alternativer

- organisasjoner

- Annen

- samlet

- del

- lidenskapelig

- prosent

- ytelse

- utfører

- fase

- befolkningen

- Pradeep

- forutsi

- prediksjon

- Spådommer

- Forbered

- presentere

- press

- privat

- prosess

- prosessering

- Produkt

- Produkter

- Profil

- profilering

- prosjekt

- gi

- gir

- offentlig

- kvalitet

- Rask

- raskt

- hever

- område

- Lesning

- poster

- gjenværende

- rapporterer

- representere

- Resultater

- Risiko

- Kjør

- rennende

- samme

- besparende

- Skala

- forskere

- SDK

- sømløs

- sømløst

- Søk

- sektorer

- Tjenester

- sett

- flere

- undertegne

- Enkelt

- enkelt

- Skin

- liten

- So

- Solutions

- noen

- spesialist

- fart

- utgifter

- splittet

- Scene

- Begynn

- startet

- state-of-the-art

- statistikk

- Still

- lagring

- oppbevare

- effektivisere

- Target

- lag

- tech

- teknikker

- test

- Testing

- tester

- De

- derfor

- Gjennom

- tid

- ganger

- i dag

- toleranse

- Kurs

- Togene

- Transform

- Transformation

- transformasjoner

- behandle

- behandling

- typer

- ui

- avdekke

- etter

- forståelse

- us

- bruke

- validert

- validering

- verdi

- Se

- synlighet

- vr

- Sårbar

- vente

- Hva

- HVEM

- innenfor

- uten

- Arbeid

- arbeidsflyt

- skriving

- år

- Din

- null