Amazon Bedrock er det beste stedet å bygge og skalere generative AI-applikasjoner med store språkmodeller (LLM) og andre grunnmodeller (FM-er). Det gjør det mulig for kunder å utnytte en rekke høyytende FM-er, for eksempel Claude-familien av modeller fra Anthropic, for å bygge tilpassede generative AI-applikasjoner. Når vi ser tilbake til 2021, da Anthropic først begynte å bygge på AWS, kunne ingen ha sett for seg hvor transformativ modellfamilien Claude ville være. Vi har gjort state-of-the-art generative AI-modeller tilgjengelige og brukbare for bedrifter i alle størrelser gjennom Amazon Bedrock. På bare noen få korte måneder siden Amazon Bedrock ble allment tilgjengelig 28. september 2023, har mer enn 10 XNUMX kunder brukt det til å levere, og mange av dem bruker Claude. Kunder som f.eks ADP, Broadridge, Cloudera, Dana-Farber Cancer Institute, Genesys, Genomics England, GoDaddy, Intuit, M1 Finance, Perplexity AI, Proto Hologram, Rocket Companies og mer bruker Anthropics Claude-modeller på Amazon Bedrock for å drive innovasjon innen generativ AI og for å bygge transformative kundeopplevelser. Og i dag kunngjør vi en spennende milepæl med neste generasjon av Claude som kommer til Amazonas grunnfjell: Claude 3 Opus, Claude 3 Sonnet og Claude 3 Haiku.

Vi introduserer Anthropics Claude 3-modeller

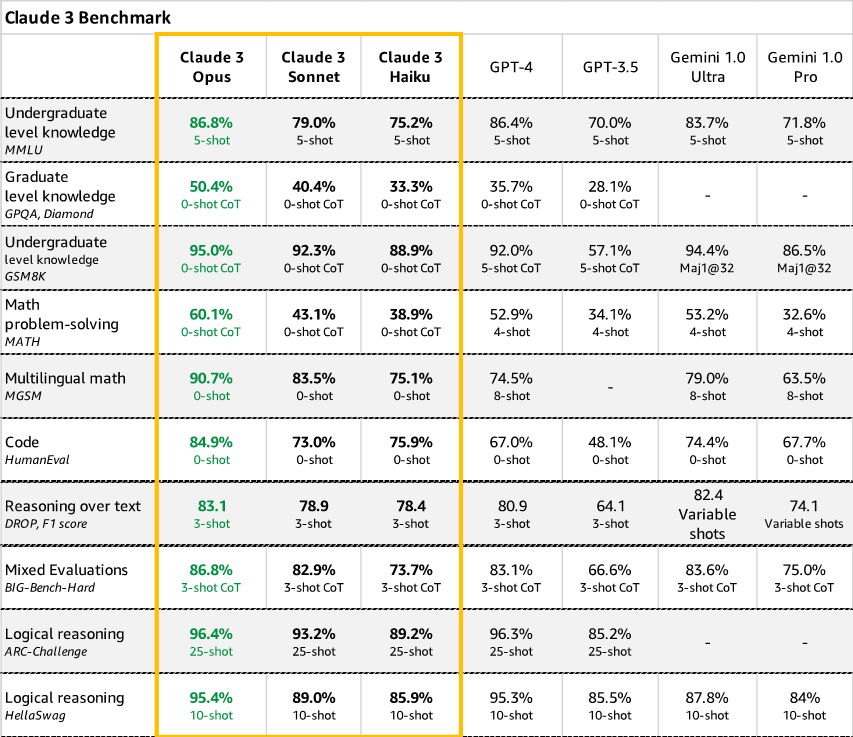

Anthropic avduker sin neste generasjon av Claude med tre avanserte modeller som er optimert for ulike brukstilfeller. Haiku er den raskeste og mest kostnadseffektive modellen på markedet. Det er en rask kompakt modell for nesten umiddelbar respons. For de aller fleste arbeidsmengder er Sonnet 2 ganger raskere enn Claude 2 og Claude 2.1 med høyere intelligensnivåer. Den utmerker seg med intelligente oppgaver som krever raske svar, som kunnskapsinnhenting eller salgsautomatisering. Og den har den ideelle balansen mellom intelligens og hastighet – egenskaper som er spesielt viktige for bedriftsbruk. Opus er den mest avanserte, dyktige, state-of-the-art FM med dype resonnementer, avanserte matematikk- og kodingsevner, med ytelse på toppnivå på svært komplekse oppgaver. Den kan navigere i åpne meldinger og nye scenarier med bemerkelsesverdig flyt, inkludert oppgaveautomatisering, hypotesegenerering og analyse av diagrammer, grafer og prognoser. Og Sonnet er først tilgjengelig på Amazon Bedrock i dag. Nåværende evalueringer fra Anthropic antyder at Claude 3-modellfamilien overgår sammenlignbare modeller i matematiske ordproblemløsning (MATH) og flerspråklige matematikk (MGSM) benchmarks, kritiske benchmarks som brukes i dag for LLMs.

- Synsevner – Claude 3-modeller har blitt opplært til å forstå strukturerte og ustrukturerte data på tvers av forskjellige formater, ikke bare språk, men også bilder, diagrammer, diagrammer og mer. Dette lar bedrifter bygge generative AI-applikasjoner som integrerer ulike multimediekilder og løser virkelige problemer på tvers av domener. For eksempel kan farmasøytiske selskaper forespørre legemiddelforskningsartikler sammen med proteinstrukturdiagrammer for å fremskynde oppdagelsen. Medieorganisasjoner kan generere bildetekster eller videoskript automatisk.

- Klassens beste standarder – Claude 3 overgår eksisterende modeller for standardiserte evalueringer som matematiske problemer, programmeringsøvelser og vitenskapelig resonnement. Kunder kan optimalisere domenespesifikke eksperimentelle prosedyrer i produksjon, eller revidere økonomiske rapporter basert på kontekstuelle data, på en automatisert måte og med høy nøyaktighet ved å bruke AI-drevne svar.

Spesielt overgår Opus sine jevnaldrende på de fleste av de vanlige evalueringsstandardene for AI-systemer, inkludert ekspertkunnskap på lavere nivå (MMLU), ekspertresonnering på høyere nivå (GPQA), grunnleggende matematikk (GSM8K) og mer. Den viser høye nivåer av forståelse og flyt på komplekse oppgaver, og leder grensen for generell intelligens.

- Redusert hallusinasjon – Bedrifter krever prediktive, kontrollerbare utdata fra AI-systemer som styrer automatiserte prosesser eller kundeinteraksjoner. Claude 3-modeller reduserer hallusinasjoner gjennom konstitusjonelle AI-teknikker som gir åpenhet i modellens resonnement, samt forbedrer nøyaktigheten. Claude 3 Opus viser en estimert 2x gevinst i nøyaktighet i forhold til Claude 2.1 på vanskelige åpne spørsmål, noe som reduserer sannsynligheten for feilsvar. Siden bedriftskunder stoler på Claude på tvers av bransjer som helsevesen, finans og juridisk forskning, er det avgjørende for sikkerhet og ytelse å redusere hallusinasjoner. Claude 3-familien setter en ny standard for pålitelig generativ AI-utgang.

Fordeler med Anthropic Claude 3 FM-er på Amazons grunnfjell

Gjennom Amazon Bedrock vil kundene få enkel tilgang til å bygge med Anthropics nyeste modeller. Dette inkluderer ikke bare naturlige språkmodeller, men også deres utvidede utvalg av multimodale AI-modeller som er i stand til avansert resonnement på tvers av tekst, bilder, diagrammer og mer. Samarbeidet vårt har allerede hjulpet kunder med å akselerere generativ AI-adopsjon og levert forretningsverdi til dem. Her er noen måter kunder har brukt Anthropics Claude-modeller på Amazon Bedrock:

"Vi utvikler en generativ AI-løsning på AWS for å hjelpe kunder med å planlegge episke turer og skape livsendrende opplevelser med personlig tilpassede reiseruter. Ved å bygge sammen med Claude på Amazon Bedrock, reduserte vi kostnadene for generering av reiseruter med nesten 80 % prosent da vi raskt opprettet en skalerbar, sikker AI-plattform som kan organisere bokinnholdet vårt på få minutter for å levere sammenhengende, svært nøyaktige reiseanbefalinger. Nå kan vi ompakke og tilpasse innholdet vårt på ulike måter på våre digitale plattformer, basert på kundenes preferanser, samtidig som vi fremhever pålitelige lokale stemmer – akkurat som Lonely Planet har gjort i 50 år.»

— Chris Whyde, Senior VP of Engineering and Data Science, Lonely Planet

"Vi jobber med AWS og Anthropic for å være vert for vår tilpassede, finjusterte Anthropic Claude-modell på Amazon Bedrock for å støtte strategien vår om å raskt levere generative AI-løsninger i stor skala og med banebrytende kryptering, datapersonvern og sikker AI-teknologi innebygd i alt vi gjør. Vår nye Lexis+ AI-plattformteknologi har samtalesøk, innsiktsfull oppsummering og intelligente juridiske utformingsevner, som gjør det mulig for advokater å øke sin effektivitet, effektivitet og produktivitet.»

— Jeff Reihl, Executive VP og CTO, LexisNexis Legal & Professional

"Hos Broadridge har vi jobbet med å automatisere forståelsen av regulatoriske rapporteringskrav for å skape større åpenhet og øke effektiviteten for våre kunder som opererer i nasjonale og globale finansmarkeder. Med bruk av Claude på Amazon Bedrock er vi begeistret over å få enda høyere nøyaktighet i eksperimentene våre med prosesserings- og oppsummeringsfunksjoner. Med Amazon Bedrock har vi valg i vår bruk av LLM-er, og vi verdsetter ytelsen og integrasjonsmulighetene den tilbyr."

— Saumin Patel, VP Engineering generative AI, Broadridge

Claude 3-modellfamilien imøtekommer ulike behov, og lar kundene velge den modellen som passer best for deres spesifikke brukstilfelle, noe som er nøkkelen til å utvikle en vellykket prototype og senere produksjonssystemer som kan gi reell effekt – enten det gjelder et nytt produkt, funksjon eller prosess som øker bunnlinjen. Med kundenes behov i fokus, leverer Anthropic og AWS der det betyr mest for organisasjoner av alle størrelser:

- Forbedret ytelse – Claude 3-modeller er betydelig raskere for sanntidsinteraksjoner takket være optimaliseringer på tvers av maskinvare og programvare.

- Økt nøyaktighet og pålitelighet – Gjennom massiv skalering så vel som nye selvtilsynsteknikker betyr forventet gevinst på 2x i nøyaktighet for komplekse spørsmål over lange sammenhenger AI som er enda mer nyttig, trygg og ærlig.

- Enklere og sikker tilpasning – Tilpasningsfunksjoner, som gjenfinningsforsterket generasjon (RAG), forenkler opplæringsmodeller på proprietære data og bygger applikasjoner støttet av ulike datakilder, slik at kundene får AI innstilt for deres unike behov. I tillegg blir proprietære data aldri eksponert for det offentlige internett, forlater aldri AWS-nettverket, overføres sikkert gjennom VPC og krypteres under overføring og hvile.

Og AWS og Anthropic bekrefter kontinuerlig vår forpliktelse til å fremme generativ AI på en ansvarlig måte. Ved å hele tiden forbedre modellkapasiteter forplikte seg til rammer som Konstitusjonell AI eller Det hvite hus frivillige forpliktelser på AI, kan vi fremskynde den sikre, etiske utviklingen og distribusjonen av denne transformative teknologien.

Fremtiden til generativ AI

Når vi ser fremover, vil kundene bygge helt nye kategorier av generative AI-drevne applikasjoner og erfaringer med den siste generasjonen av modeller. Vi har bare begynt å utnytte generativ AIs potensial for å automatisere komplekse prosesser, øke menneskelig ekspertise og omforme digitale opplevelser. Vi forventer å se enestående nivåer av innovasjon når kunder velger Anthropics modeller forsterket med multimodale ferdigheter som utnytter alle verktøyene de trenger for å bygge og skalere generative AI-applikasjoner på Amazon Bedrock. Se for deg sofistikerte samtaleassistenter som gir raske og svært kontekstuelle svar, bildepersonaliserte anbefalingsmotorer som sømløst blander inn relevante bilder, diagrammer og tilhørende kunnskap for å intuitivt veilede beslutninger. Se for deg vitenskapelig forskning turboladet av generativ AI i stand til å lese eksperimenter, syntetisere hypoteser og til og med foreslå nye områder for utforskning. Det er så mange muligheter som vil bli realisert ved å dra full nytte av alt generativ AI har å tilby gjennom Amazon Bedrock. Samarbeidet vårt sikrer at bedrifter og innovatører over hele verden vil ha verktøyene til å nå neste front innen generativ AI-drevet innovasjon på en ansvarlig måte, og til fordel for alle.

konklusjonen

Det er fortsatt tidlig for generativ AI, men sterkt samarbeid og fokus på innovasjon innleder en ny æra med generativ AI på AWS. Vi gleder oss til å se hva kundene bygger videre.

Ressurser

Sjekk ut følgende ressurser for å lære mer om denne kunngjøringen:

Om forfatteren

Swami Sivasubramanian er visepresident for data og maskinlæring i AWS. I denne rollen fører Swami tilsyn med alle AWS-databaser, analysetjenester og AI- og maskinlæringstjenester. Teamets oppgave er å hjelpe organisasjoner med å sette dataene sine i arbeid med en komplett, ende-til-ende dataløsning for å lagre, få tilgang til, analysere og visualisere og forutsi.

Swami Sivasubramanian er visepresident for data og maskinlæring i AWS. I denne rollen fører Swami tilsyn med alle AWS-databaser, analysetjenester og AI- og maskinlæringstjenester. Teamets oppgave er å hjelpe organisasjoner med å sette dataene sine i arbeid med en komplett, ende-til-ende dataløsning for å lagre, få tilgang til, analysere og visualisere og forutsi.

- SEO-drevet innhold og PR-distribusjon. Bli forsterket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk deg selv. Tilgang her.

- PlatoAiStream. Web3 Intelligence. Kunnskap forsterket. Tilgang her.

- PlatoESG. Karbon, CleanTech, Energi, Miljø, Solenergi, Avfallshåndtering. Tilgang her.

- PlatoHelse. Bioteknologisk og klinisk etterretning. Tilgang her.

- kilde: https://aws.amazon.com/blogs/machine-learning/unlocking-innovation-aws-and-anthropic-push-the-boundaries-of-generative-ai-together/

- : har

- :er

- :ikke

- :hvor

- 1

- 100

- 10K

- 10 XNUMX kunder

- 2021

- 2023

- 28

- 50

- 50 år

- 7

- 8

- a

- evner

- I stand

- Om oss

- akselerere

- adgang

- tilgjengelig

- nøyaktighet

- nøyaktig

- tvers

- tillegg

- Adopsjon

- avansert

- Advancing

- Fordel

- fremover

- AI

- AI og maskinlæring

- AI-modeller

- AI-plattform

- AI-systemer

- AI-drevet

- Alle

- tillate

- sammen

- allerede

- også

- Amazon

- Amazon Web Services

- an

- analyse

- analytics

- analysere

- og

- Kunngjøring

- Kunngjøring

- Antropisk

- søknader

- ER

- områder

- AS

- assistenter

- assosiert

- At

- revisjon

- øke

- augmented

- automatisere

- Automatisert

- automatisk

- Automatisering

- tilgjengelig

- AWS

- tilbake

- Backed

- Balansere

- basert

- grunnleggende

- BE

- ble

- vært

- begynt

- benchmarks

- nytte

- BEST

- mellom

- Blend

- bok

- øker

- Bunn

- grenser

- Broadridge

- bygge

- Bygning

- virksomhet

- bedrifter

- men

- by

- CAN

- Kreft

- evner

- stand

- teksting

- saken

- saker

- kategorier

- henvender seg

- Topplisten

- valg

- Velg

- chris

- Cloudera

- Koding

- sammenhengende

- samarbeid

- kommer

- engasjement

- forpliktelser

- begå

- Felles

- kompakt

- Selskaper

- sammenlign

- fullføre

- komplekse

- stadig

- innhold

- sammenhenger

- kontekstuelle

- kontinuerlig

- conversational

- kostnadseffektiv

- Kostnader

- kunne

- skape

- opprettet

- kritisk

- CTO

- Gjeldende

- skikk

- kunde

- Kunder

- tilpasning

- skjærekant

- dato

- personvern

- datavitenskap

- Database

- Dager

- avgjørelser

- dyp

- leverer

- levert

- levere

- krevende

- distribusjon

- utvikle

- Utvikling

- diagrammer

- forskjellig

- vanskelig

- digitalt

- regi

- Funnet

- diverse

- do

- domene

- Innenriks

- gjort

- stasjonen

- medikament

- Tidlig

- lett

- effektivitet

- effektivitet

- innebygd

- muliggjøre

- muliggjør

- kryptert

- kryptering

- ende til ende

- Ingeniørarbeid

- Motorer

- England

- sikrer

- Enterprise

- bedrifter

- fullstendig

- se for meg

- for seg

- EPIC

- Era

- spesielt

- avgjørende

- anslått

- etisk

- evaluering

- evalueringer

- Selv

- alt

- stiger

- spennende

- utøvende

- utstillinger

- eksisterende

- utvidet

- forvente

- forventet

- Erfaringer

- eksperimentell

- eksperimenter

- Expert

- ekspertise

- leting

- utsatt

- familie

- FAST

- raskere

- raskeste

- defekt

- Trekk

- Egenskaper

- Noen få

- finansiere

- finansiell

- Først

- Fokus

- etter

- Til

- prognoser

- Fundament

- rammer

- fra

- Frontier

- fullt

- framtid

- Gevinst

- inntjening

- general

- generell intelligens

- generelt

- generere

- generasjonen

- generative

- Generativ AI

- genomikk

- få

- Global

- global finansiell

- oppgradere

- grafer

- større

- veilede

- maskinvare

- Ha

- helsetjenester

- hjelpe

- hjulpet

- nyttig

- her.

- Høy

- høytytende

- høyere

- utheving

- svært

- hans

- hologram

- ærlig

- vert

- hus

- Hvordan

- HTTPS

- menneskelig

- ideell

- bilde

- bilder

- forestille

- forbedre

- bedre

- in

- inkluderer

- Inkludert

- Øke

- bransjer

- Innovasjon

- innovatører

- innsiktsfull

- f.eks

- Institute

- Integrering

- integrering

- Intelligens

- Intelligent

- interaksjoner

- Internet

- inn

- Intuit

- IT

- DET ER

- bare

- holde

- nøkkel

- kunnskap

- Språk

- stor

- seinere

- siste

- advokater

- ledende

- LÆRE

- læring

- Lovlig

- Lar

- Nivå

- nivåer

- Leverage

- utnytte

- LexisNexis

- i likhet med

- sannsynligheten

- linje

- LLM

- lokal

- Lang

- ser

- maskin

- maskinlæring

- Flertall

- Making

- måte

- produksjon

- mange

- marked

- Markets

- massive

- math

- matematikk

- Saker

- bety

- Media

- milepæl

- tankene

- minutter

- Oppdrag

- Minske

- modell

- modeller

- måneder

- mer

- mest

- multimedia

- Naturlig

- Naviger

- nesten

- Trenger

- behov

- nettverk

- aldri

- Ny

- nytt produkt

- Nyeste

- neste

- Nei.

- roman

- nå

- of

- tilby

- Tilbud

- on

- ONE

- bare

- drift

- optimaliseringer

- Optimalisere

- optimalisert

- or

- organisasjoner

- Annen

- vår

- ut

- utkonkurrerer

- produksjon

- utganger

- enn

- papirer

- jevnaldrende

- prosent

- ytelse

- tilpasse

- Personlig

- Pharmaceutical

- bilde

- Sted

- fly

- planet

- plattform

- Plattformer

- plato

- Platon Data Intelligence

- PlatonData

- muligheter

- potensiell

- forutsi

- president

- privatliv

- Problem

- problemer

- prosedyrer

- prosess

- Prosesser

- prosessering

- Produkt

- Produksjon

- produktivitet

- Programmering

- ledetekster

- foreslå

- proprietær

- Protein

- Proto

- prototype

- gi

- gi

- offentlig

- Skyv

- sette

- kvaliteter

- spørring

- spørsmål

- raskt

- fille

- område

- rask

- raskt

- å nå

- Lese

- bekrefter

- ekte

- sanntids

- realisert

- Anbefaling

- anbefalinger

- Redusert

- redusere

- regulatorer

- relevant

- pålitelig

- avhengige

- bemerkelsesverdig

- Rapportering

- Rapporter

- krever

- Krav

- forskning

- omskape

- Ressurser

- svar

- ansvarlig

- ansvarlig

- REST

- gjenfinning

- Rocket

- Rolle

- trygge

- Sikkerhet

- salg

- skalerbar

- Skala

- skalering

- scenarier

- Vitenskap

- vitenskapelig

- skript

- sømløst

- Søk

- sikre

- sikkert

- se

- senior

- September

- Tjenester

- sett

- Kort

- Viser

- betydelig

- forenkle

- siden

- størrelser

- ferdigheter

- So

- Software

- løsning

- Solutions

- løse

- sofistikert

- Kilder

- spesifikk

- fart

- Standard

- startet

- state-of-the-art

- Still

- oppbevare

- Strategi

- streik

- sterk

- struktur

- strukturert

- vellykket

- slik

- foreslår

- støtte

- syntetisere

- Systemer

- ta

- Pek

- Oppgave

- oppgaver

- teknikker

- Teknologi

- tekst

- enn

- Takk

- Det

- De

- deres

- Dem

- Der.

- de

- denne

- tre

- begeistret

- Gjennom

- til

- i dag

- sammen

- verktøy

- topp

- øverste nivå

- trent

- Kurs

- overføres

- transformative

- transitt

- Åpenhet

- reiser

- virkelig

- klarert

- tuned

- forstå

- forståelse

- unik

- opplåsing

- enestående

- ustrukturert

- avdukingen

- bruk

- bruke

- bruk sak

- brukt

- innvarsling

- ved hjelp av

- verdi

- variasjon

- ulike

- enorme

- vice

- Vice President

- video

- visualisere

- frivillig

- vp

- vente

- Vei..

- måter

- we

- web

- webtjenester

- VI VIL

- Hva

- når

- hvilken

- mens

- vil

- med

- ord

- Arbeid

- arbeid

- verdensomspennende

- ville

- år

- zephyrnet