Amazon SageMaker Data Wrangler er et brukergrensesnittbasert dataforberedelsesverktøy som hjelper deg med å utføre dataanalyse, forhåndsbehandling og visualisering med funksjoner for å rense, transformere og klargjøre data raskere. Data Wrangler forhåndsbygde flytmaler bidrar til å gjøre dataforberedelse raskere for dataforskere og maskinlæringsutøvere (ML) ved å hjelpe deg med å akselerere og forstå beste praksismønstre for dataflyt ved bruk av vanlige datasett.

Du kan bruke Data Wrangler-flyter til å utføre følgende oppgaver:

- Datavisualisering - Undersøke statistiske egenskaper for hver kolonne i datasettet, bygge histogrammer, studere outliers

- Datarengjøring - Fjerne duplikater, slippe eller fylle oppføringer med manglende verdier, fjerne avvikere

- Datarikning og funksjonsteknikk - Behandler kolonner for å bygge mer uttrykksfulle funksjoner, ved å velge en delmengde av funksjoner for trening

Dette innlegget vil hjelpe deg å forstå Data Wrangler ved å bruke følgende eksempel på forhåndsbygde flyter GitHub. Depotet viser tabellformede datatransformasjoner, tidsseriedatatransformasjoner og sammenføyde datasetttransformasjoner. Hver krever en annen type transformasjoner på grunn av deres grunnleggende natur. Standard tabell- eller tverrsnittsdata samles inn på et bestemt tidspunkt. Derimot fanges tidsseriedata gjentatte ganger over tid, med hvert påfølgende datapunkt avhengig av tidligere verdier.

La oss se på et eksempel på hvordan vi kan bruke eksempeldataflyten for tabelldata.

Forutsetninger

Data Wrangler er en Amazon SageMaker funksjon tilgjengelig innenfor Amazon SageMaker Studio, så vi må følge Studio onboarding-prosessen for å spinne opp Studio-miljøet og bærbare datamaskiner. Selv om du kan velge mellom noen få autentiseringsmetoder, er den enkleste måten å opprette et Studio-domene på å følge Quick start bruksanvisning. Hurtigstarten bruker de samme standardinnstillingene som standard studiooppsett. Du kan også velge å gå ombord ved å bruke AWS IAM Identity Center (etterfølger til AWS Single Sign-On) for autentisering (se Ombord på Amazon SageMaker Domain ved hjelp av IAM Identity Center).

Importer datasettet og flytfilene til Data Wrangler ved hjelp av Studio

Følgende trinn skisserer hvordan du importerer data til SageMaker for å bli konsumert av Data Wrangler:

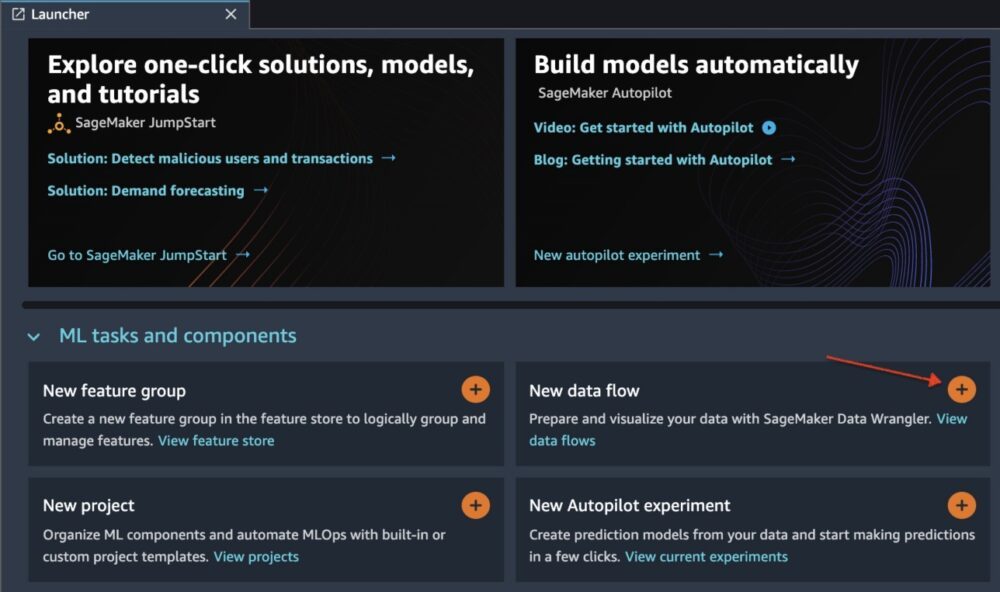

Initialiser Data Wrangler via Studio UI ved å velge Ny dataflyt.

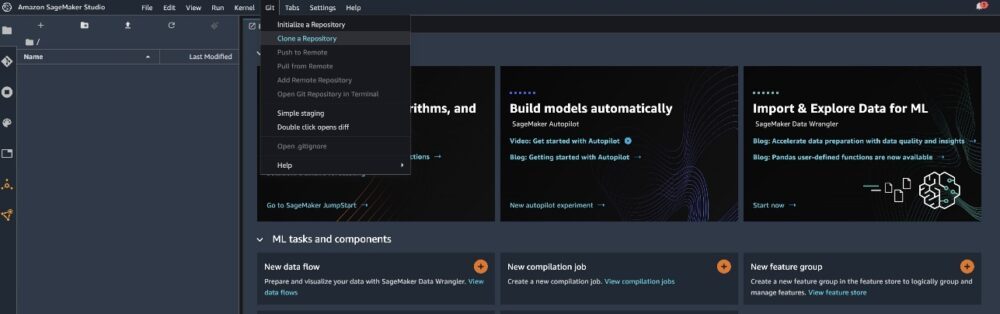

Klone GitHub repo for å laste ned flytfilene til Studio-miljøet ditt.

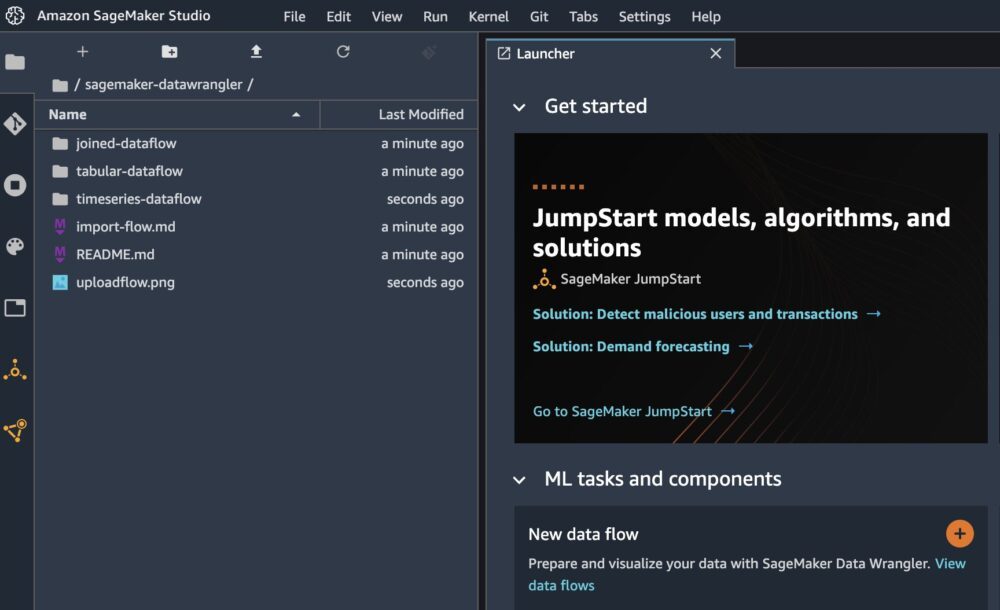

Når klonen er fullført, skal du kunne se depotinnholdet i venstre rute.

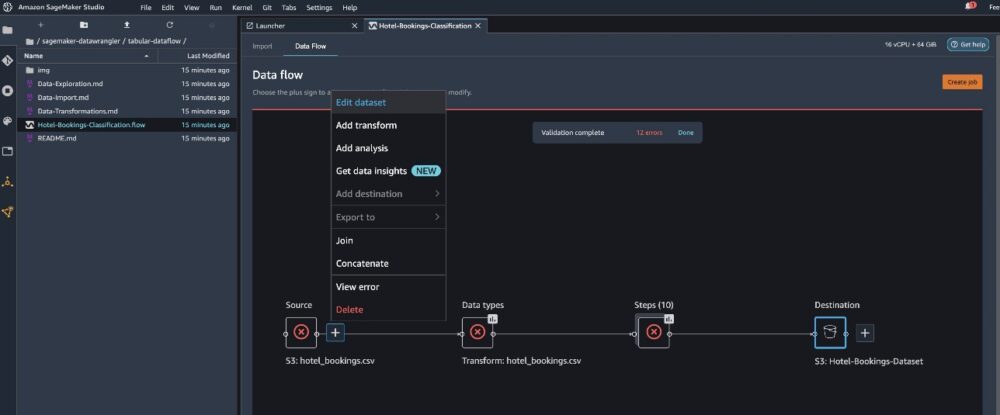

Velg filen Hotel-Bookings-Classification.flow for å importere flytfilen til Data Wrangler.

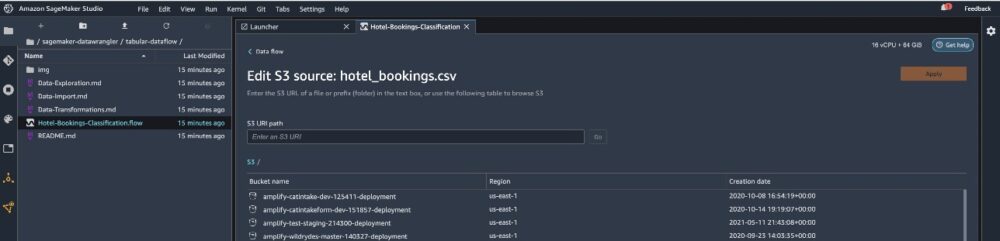

Hvis du bruker tidsserien eller sammenføyd dataflyt, vil flyten vises som et annet navn. Etter at flyten er importert, bør du se følgende skjermbilde. Dette viser oss feil fordi vi må sørge for at flytfilen peker til riktig datakilde i Amazon enkel lagringstjeneste (Amazon S3).

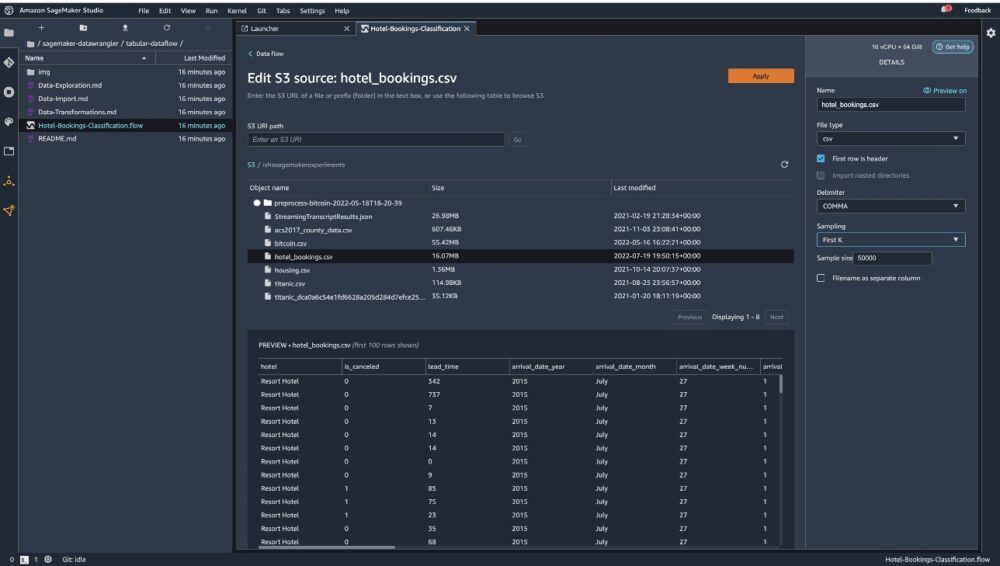

Velg Rediger datasett for å få opp alle S3-bøttene dine. Deretter velger du datasettet hotel_bookings.csv fra din S3-bøtte for å kjøre gjennom dataflyt i tabellform.

Merk at hvis du bruker sluttet dataflyt, kan det hende du må importere flere datasett til Data Wrangler

Kontroller i høyre rute AVSNITT er valgt som skilletegn og sampling er satt til Først K. Datasettet vårt er lite nok til å kjøre Data Wrangler-transformasjoner på hele datasettet, men vi ønsket å fremheve hvordan du kan importere datasettet. Hvis du har et stort datasett, bør du vurdere å bruke prøvetaking. Velge Import for å importere dette datasettet til Data Wrangler.

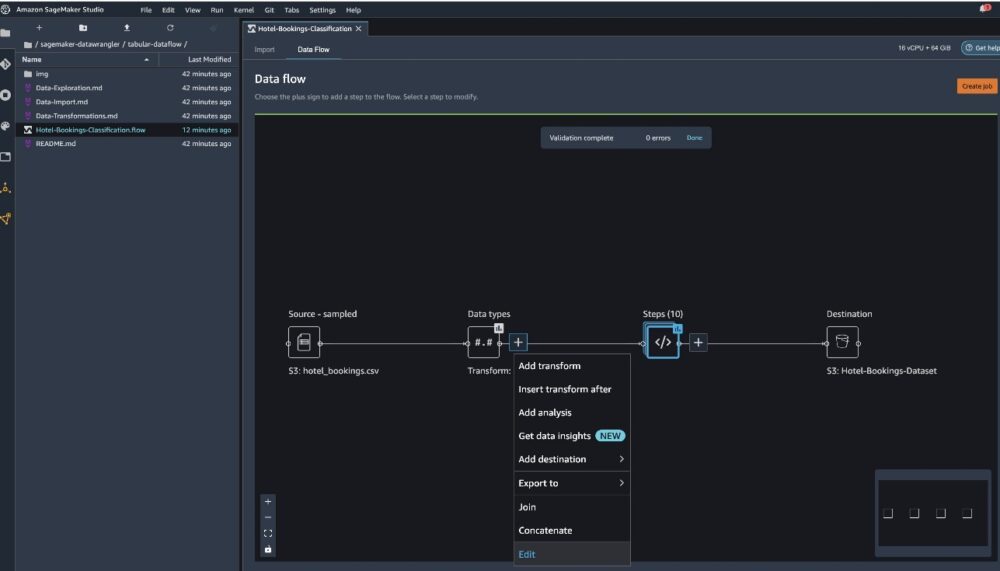

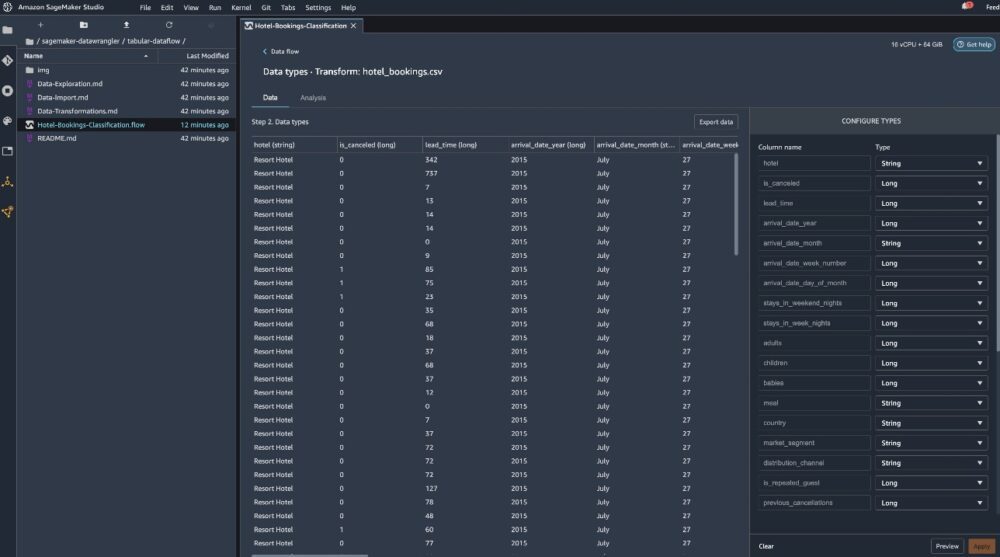

Etter at datasettet er importert, validerer Data Wrangler automatisk datasettet og oppdager datatypene. Du kan se at feilene har forsvunnet fordi vi peker på riktig datasett. Flytredigeringsprogrammet viser nå to blokker som viser at dataene ble importert fra en kilde og datatyper gjenkjent. Du kan også redigere datatypene om nødvendig.

Følgende skjermbilde viser våre datatyper.

La oss se på noen av transformasjonene som er gjort som en del av denne tabellformede flyten. Hvis du bruker tidsserier or ble med dataflyter, sjekk ut noen vanlige transformasjoner på GitHub repo. Vi utførte noen grunnleggende utforskende dataanalyse ved å bruke datainnsiktsrapporter som studerte mållekkasjen og funksjonskollineariteten i datasettet, tabellsammendragsanalyser og rask modelleringsevne. Utforsk trinnene på GitHub repo.

Nå slipper vi kolonner basert på anbefalingene gitt av datainnsikt og kvalitetsrapport.

- For mållekkasje, slipp reservasjonsstatus.

- For overflødige kolonner, slipp dager_i_venteliste, hotell, reservert_rom_type, ankomstdato_måned, reservasjonsstatus_dato, babyer, og ankomst_dato_dag_i_måned.

- Slipp kolonner basert på lineære korrelasjonsresultater ankomst_dato_ukenummer og ankomst_dato_år fordi korrelasjonsverdiene for disse funksjonsparene (kolonne) er større enn den anbefalte terskelen på 0.90.

- Basert på ikke-lineære korrelasjonsresultater, fall reservasjonsstatus. Denne kolonnen var allerede merket for å bli droppet basert på mållekkasjeanalysen.

- Behandle numeriske verdier (min-maks skalering) for lead_time, stays_in_weekend_nights, stays_in_weekday_nights, is_repeated_guest, prev_cancellations, prev_bookings_not_cancelled, booking_changes, adr, total_of_special_requests, og påkrevde_bilparkeringsplasser.

- One-hot kode kategoriske variabler som måltid, er_gjentatt_gjest, markedssegment, tildelt_romtype, innskuddstype, og Kundetype.

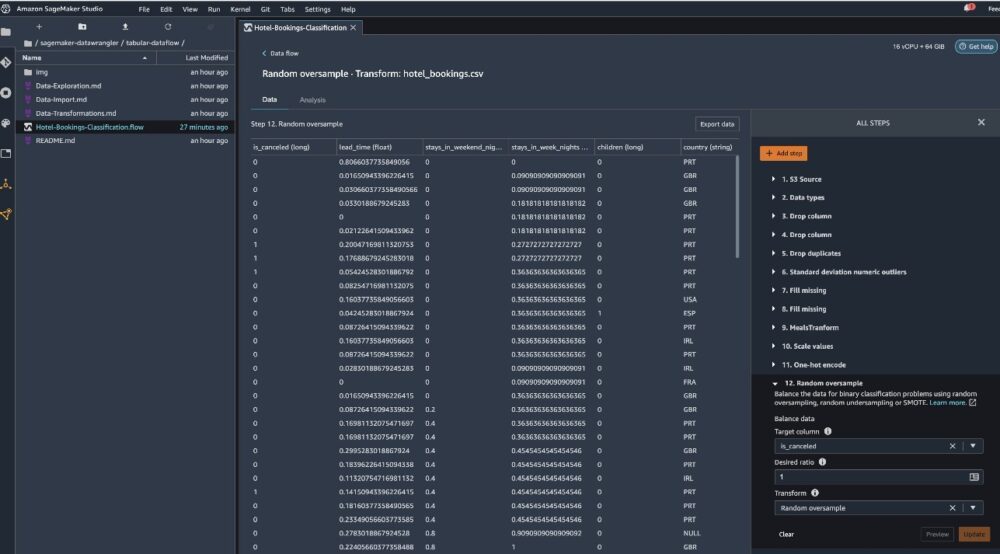

- Balanser målvariabelen Tilfeldig oversampling for klasseubalanse. Bruk funksjonen for hurtigmodellering for å håndtere uteliggere og manglende verdier.

Eksporter til Amazon S3

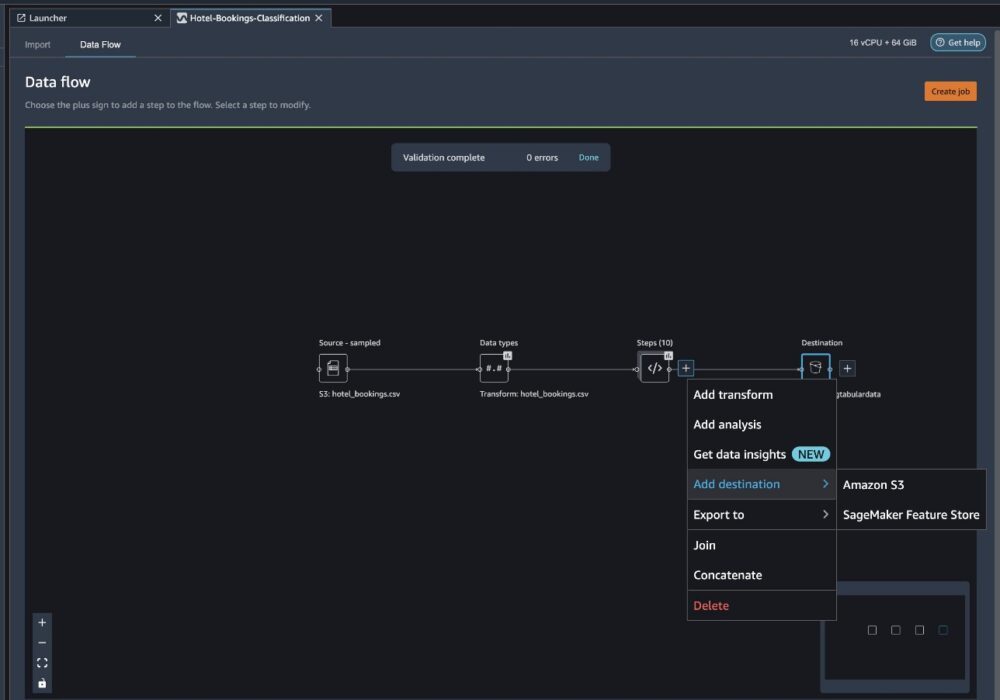

Nå har vi gått gjennom de forskjellige transformasjonene og er klare til å eksportere dataene til Amazon S3. Dette alternativet oppretter en SageMaker-behandlingsjobb, som kjører Data Wrangler-prosesseringsflyten og lagrer det resulterende datasettet i en spesifisert S3-bøtte. Følg de neste trinnene for å sette opp eksporten til Amazon S3:

Velg plusstegnet ved siden av en samling transformasjonselementer og velg Legg til destinasjon, deretter Amazon S3.

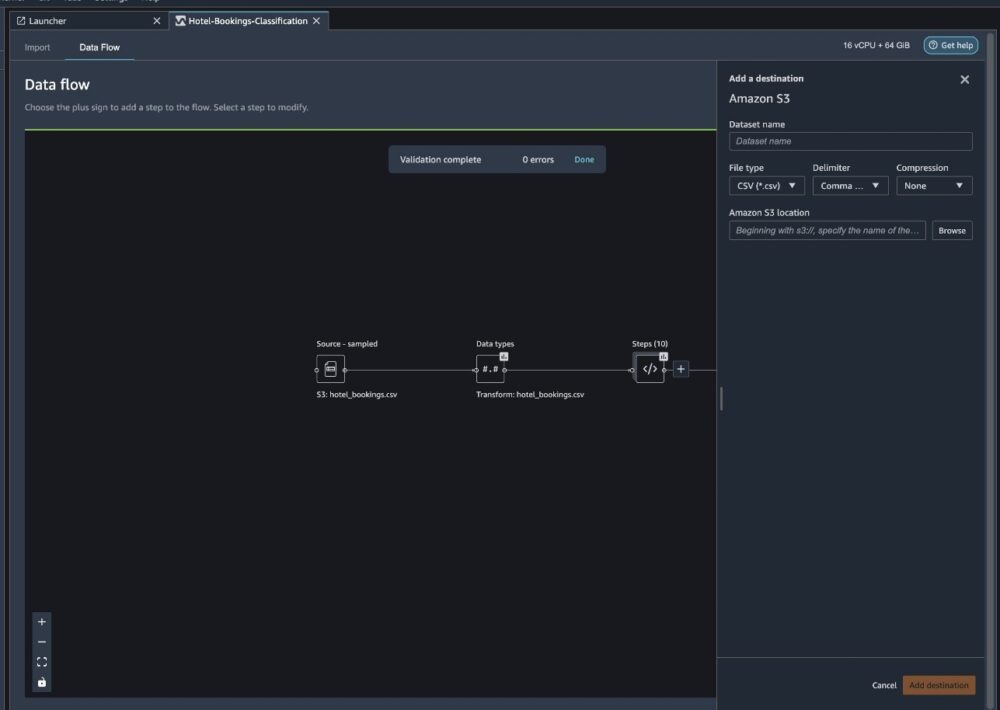

- Til Datasettnavn, skriv inn et navn for det nye datasettet, for eksempel

NYC_export. - Til Filtype, velg CSV.

- Til delimiter, velg Komma.

- Til Komprimering, velg none.

- Til Amazon S3 plassering, bruk det samme bøttenavnet som vi opprettet tidligere.

- Velg Legg til destinasjon.

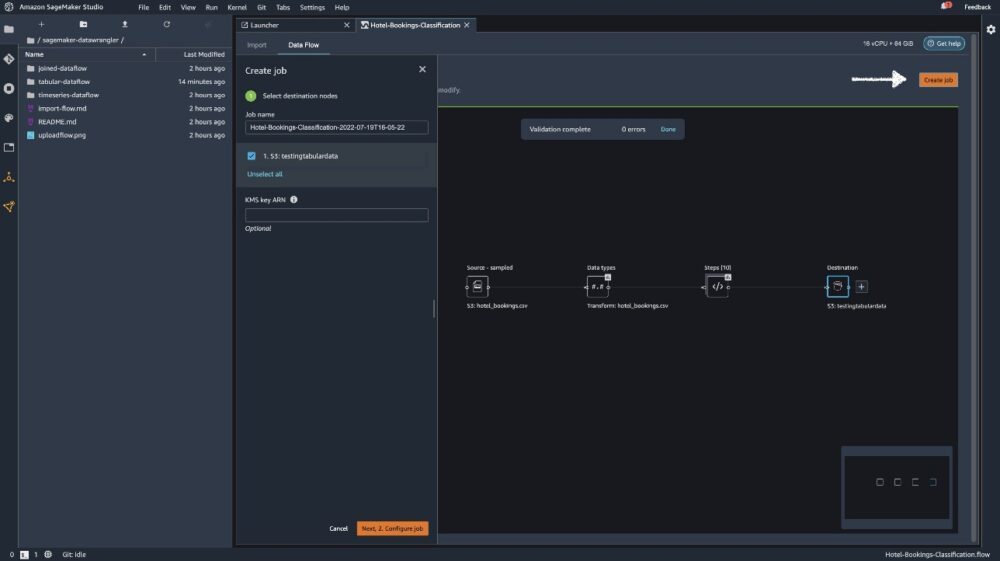

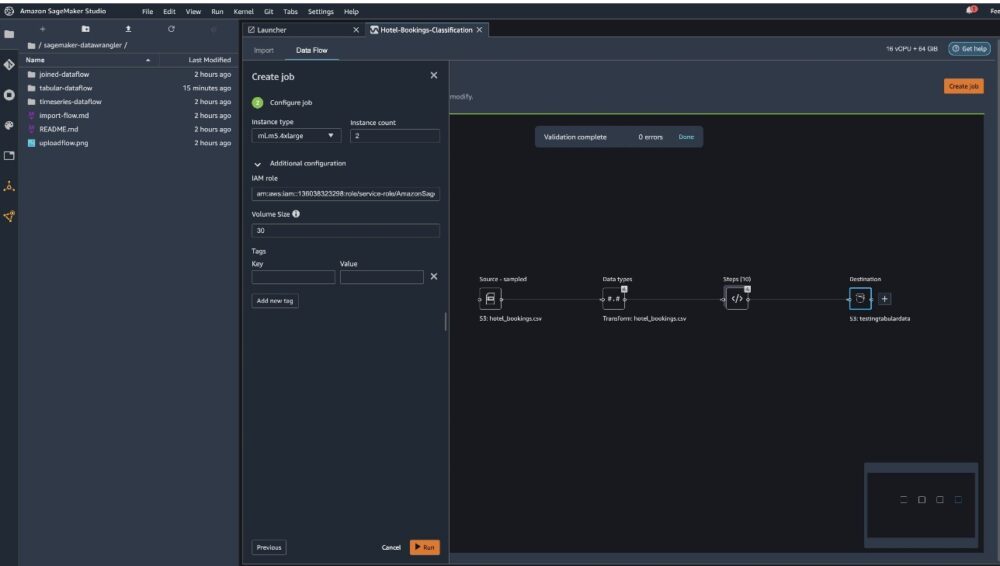

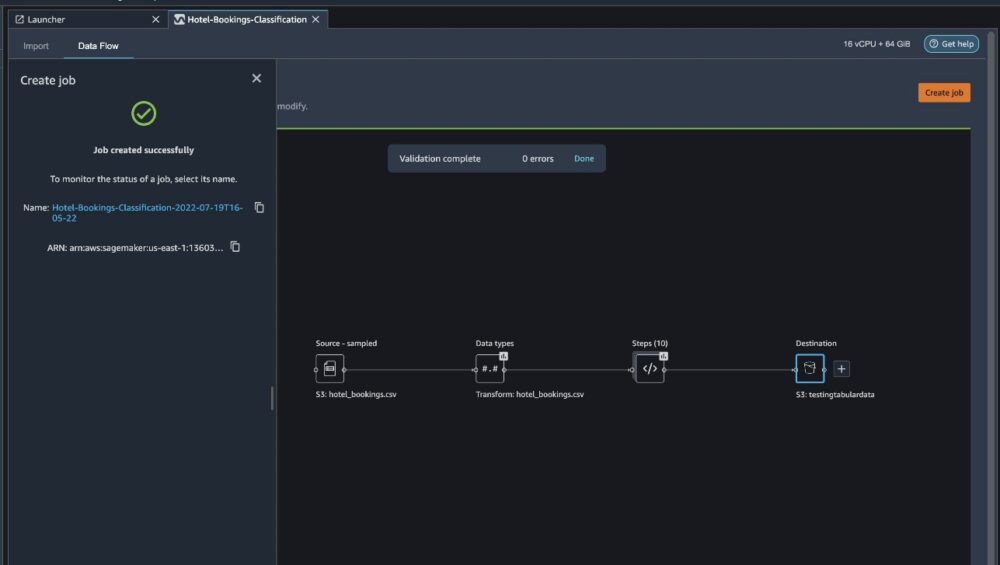

Velg Lag jobb.

Til Jobb navn, skriv inn et navn eller behold det autogenererte alternativet og velg destinasjonen. Vi har bare ett reisemål, S3:testingtabulardata, men du kan ha flere destinasjoner fra forskjellige trinn i arbeidsflyten. Forlat KMS nøkkel ARN feltet tomt og velg neste.

Nå må du konfigurere beregningskapasiteten for en jobb. Du kan beholde alle standardverdier for dette eksemplet.

- Til Forekomsttype, bruk ml.m5.4xlarge.

- Til Antall forekomster, bruk 2.

- Du kan utforske Ekstra konfigurasjon, men behold standardinnstillingene.

- Velg Kjør.

Nå har jobben din startet, og det tar litt tid å behandle 6 GB data i henhold til vår Data Wrangler-prosessflyt. Kostnaden for denne jobben vil være rundt $2 USD, fordi ml.m5.4xlarge koster $0.922 USD per time, og vi bruker to av dem.

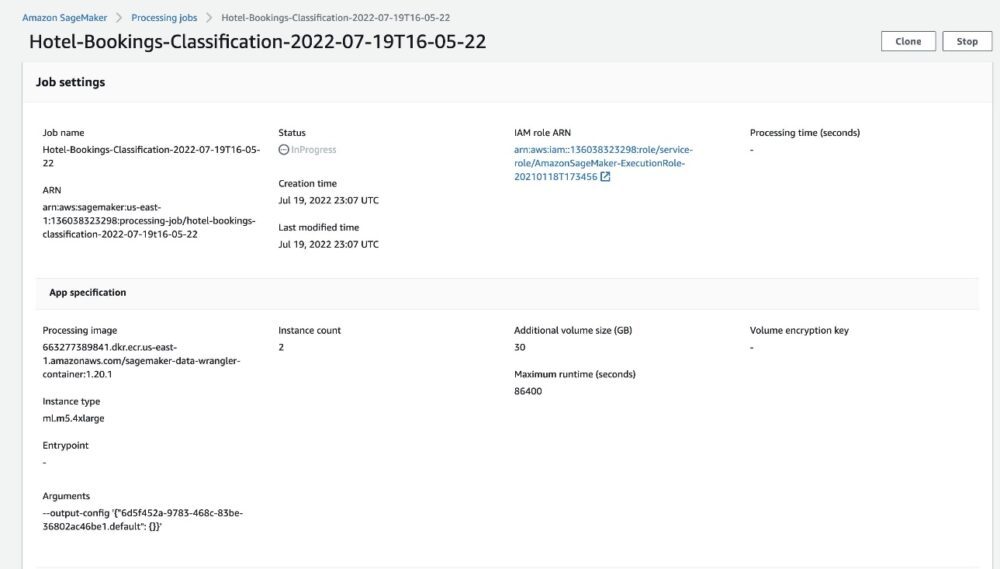

Hvis du velger jobbnavnet, blir du omdirigert til et nytt vindu med jobbdetaljene.

På siden med jobbdetaljer kan du se alle parameterne fra de forrige trinnene.

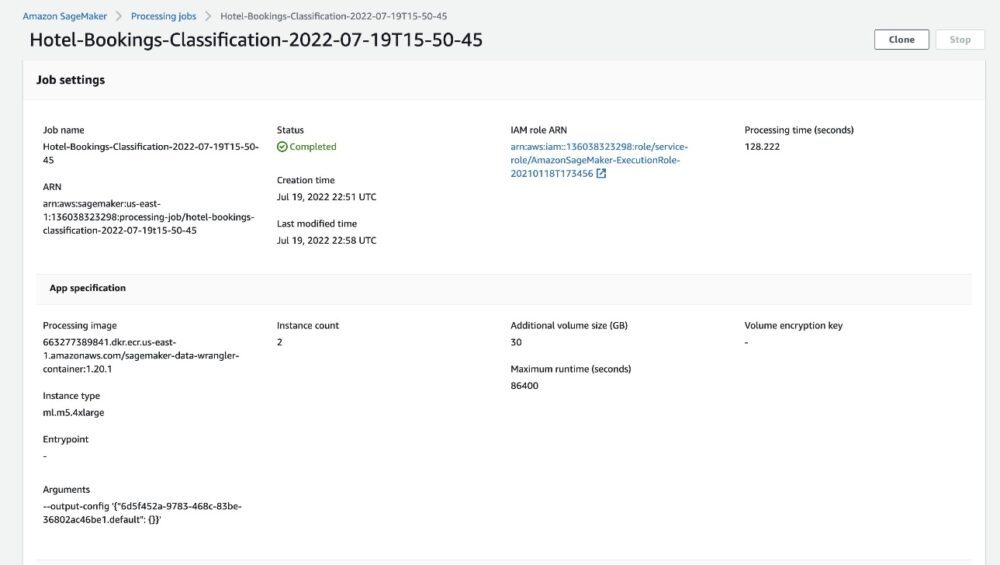

Når jobbstatusen endres til Fullført, kan du også sjekke Behandlingstid (sekunder) verdi. Denne behandlingsjobben tar rundt 5–10 minutter å fullføre.

Når jobben er fullført, er tog- og testutdatafilene tilgjengelige i de tilsvarende S3-utdatamappene. Du kan finne utdatastedet fra konfigurasjonene for behandlingsjobben.

Etter at Data Wrangler-behandlingsjobben er fullført, kan vi sjekke resultatene som er lagret i S3-bøtten vår. Ikke glem å oppdatere job_name variabel med jobbnavnet ditt.

Du kan nå bruke disse eksporterte dataene til å kjøre ML-modeller.

Rydd opp

Slett S3-bøttene dine og Data Wrangler flyt for å slette de underliggende ressursene og forhindre uønskede kostnader etter at du har fullført eksperimentet.

konklusjonen

I dette innlegget viste vi hvordan du kan importere den tabellformede forhåndsbygde dataflyten til Data Wrangler, koble den til datasettet vårt og eksportere resultatene til Amazon S3. Hvis brukstilfellene dine krever at du manipulerer tidsseriedata eller slår sammen flere datasett, kan du gå gjennom de andre forhåndsbygde prøveflytene i GitHub repo.

Etter at du har importert en forhåndsbygd dataforberedende arbeidsflyt, kan du integrere den med Amazon SageMaker Processing, Amazon SageMaker-rørledningerog Amazon SageMaker Feature Store for å forenkle oppgaven med å behandle, dele og lagre ML-treningsdata. Du kan også eksportere denne eksempeldataflyten til et Python-skript og lage en tilpasset ML-dataforberedelsespipeline, og dermed akselerere utgivelseshastigheten din.

Vi oppfordrer deg til å sjekke ut vår GitHub repository for å få praktisk praksis og finne nye måter å forbedre modellnøyaktigheten på! For å lære mer om SageMaker, besøk Amazon SageMaker utviklerveiledning.

Om forfatterne

Isha Dua er en senior løsningsarkitekt basert i San Francisco Bay Area. Hun hjelper AWS Enterprise-kunder med å vokse ved å forstå deres mål og utfordringer, og veileder dem om hvordan de kan bygge applikasjonene sine på en skybasert måte samtidig som de sørger for at de er robuste og skalerbare. Hun brenner for maskinlæringsteknologier og miljømessig bærekraft.

Isha Dua er en senior løsningsarkitekt basert i San Francisco Bay Area. Hun hjelper AWS Enterprise-kunder med å vokse ved å forstå deres mål og utfordringer, og veileder dem om hvordan de kan bygge applikasjonene sine på en skybasert måte samtidig som de sørger for at de er robuste og skalerbare. Hun brenner for maskinlæringsteknologier og miljømessig bærekraft.

- AI

- ai kunst

- ai art generator

- du har en robot

- Amazon SageMaker

- Amazon SageMaker Data Wrangler

- kunstig intelligens

- sertifisering av kunstig intelligens

- kunstig intelligens i bankvirksomhet

- kunstig intelligens robot

- kunstig intelligens roboter

- programvare for kunstig intelligens

- AWS maskinlæring

- blockchain

- blockchain konferanse ai

- coingenius

- samtale kunstig intelligens

- kryptokonferanse ai

- dall sin

- dyp læring

- google det

- maskinlæring

- plato

- plato ai

- Platon Data Intelligence

- Platon spill

- PlatonData

- platogaming

- skala ai

- syntaks

- zephyrnet