Da Stable Diffusion, AI-applikasjonen som gjengir fotorealistiske bilder skutt frem for noen uker siden, kom et nytt buzzword sammen med det; hypernettverk.

Nå er allerede stabil diffusjon og hypernettverk så sammenkoblet at det er umulig å nevne det ene uten det andre i samme avsnitt.

"Jeg har trent stabile diffusjonshypernettverk på små datasett (nei, ikke samtidskunstnere bortsett fra din virkelig) for å lære det obskure "stiler" det egentlig ikke forstår ut av boksen. Det fungerer akkurat som beskrevet, faktisk bedre enn jeg selv trodde det ville, sier en bruker på twitter.

Jeg har trent stabile diffusjonshypernettverk på små datasett (nei, ikke samtidskunstnere bortsett fra yours truly) for å lære det obskure "stiler" det egentlig ikke forstår ut av boksen. det fungerer akkurat som han beskrev, faktisk bedre enn jeg selv trodde det ville.

— beklager maksimerer (@regretmaximizer) Desember 20, 2022

Dette symboliserer hypernettverkets buzz som griper nettbrukere i det siste.

I informatikk er et hypernettverk teknisk sett et nettverk som genererer vekter for et hovednettverk. Med andre ord, det antas at hovednettverkets oppførsel er den samme med andre nevrale nettverk fordi det lærer å kartlegge noen rå input til deres ønskede mål mens hypernettverket tar et sett med input som inneholder informasjon om strukturen til vektene og genererer vekten for det laget.

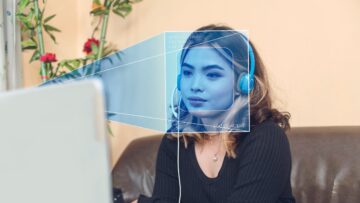

Les også: AI-teknologi som skaper livsødeleggende dype falske bilder

Hvordan brukes hypernettverk?

For å forstå hva et hypernettverk er, la oss sikkerhetskopiere litt. Hvis du har laget bilder på Stable Diffusion – AI-verktøyet for å lage digital kunst og bilder – har du kommet over det.

Trening refererer vanligvis til en prosess der en modell lærer (bestemmer) gode verdier for alle vektene og skjevheten fra merkede eksempler

Lage bilder på Stabil diffusjon er ikke en automatisk prosess, som vi har dekket andre steder. For å komme dit er det prosesser.

Først må en AI-modell lære å gjengi eller syntetisere et bilde av noen til et bilde fra en 2D- eller 3D-modell via programvare. Selv om den stabile diffusjonsmodellen ble grundig testet, har den noen treningsbegrensninger som kan korrigeres ved hjelp av embedding og hypernettverkstreningsmetoder.

For å få de beste resultatene kan sluttbrukere velge å trene ekstra for å finjustere generasjonsutdata for å matche mer spesifikke brukstilfeller. En "innebyggings"-opplæring involverer en samling av brukerleverte bilder, og lar modellen lage visuelt like bilder når navnet på innebyggingen brukes i en generasjonsmelding.

Innebygginger er basert på "tekstuell inversjon"-konseptet utviklet av forskere fra Tel Aviv University hvor vektorrepresentasjoner for spesifikke tokens brukt av modellens tekstkoder er knyttet til nye pseudoord. Innebygging kan redusere skjevheter i den originale modellen, eller etterligne visuelle stiler.

Et "hypernettverk", derimot, er et forhåndstrent nevralt nettverk som brukes på forskjellige punkter i et større nevralt nettverk, og refererer til teknikken opprettet av NovelAI-utvikleren Kurumuz i 2021, opprinnelig ment for tekstgenererte transformatormodeller .

Trener på spesifikke artister

Hypernettverk er inkludert for å styre resultater i en bestemt retning, slik at stabil diffusjonsbaserte modeller kan replikere kunststiler til spesifikke kunstnere. Nettverket har fordelen av å kunne jobbe selv når kunstneren ikke gjenkjennes av den originale modellen og vil fortsatt behandle bildet ved å finne viktige områder som hår og øyne, og deretter lappe disse områdene i et sekundært latent rom.

"Innbyggingslaget i Stable Diffusion er ansvarlig for å kode inngangene (for eksempel tekstprompten og klasseetiketter) til lavdimensjonale vektorer. Disse vektorene hjelper til med å veilede diffusjonsmodellen til å produsere bilder som samsvarer med brukerens input,” forklarer Benny Cheung i bloggen sin.

"Hypernettverkslaget er en måte for systemet å lære og representere sin egen kunnskap. Det lar Stable Diffusion lage bilder basert på tidligere erfaring."

Mens dets innebygde lag koder inngangene som tekstmelding og klasseetiketter til lavdimensjonale vektorer for å hjelpe diffusjonsmodellen til å produsere bilder som samsvarer med brukerens input, er hypernettverkslaget en måte for systemet å lære og representere sitt eget. kunnskap.

Med andre ord tillater den stabil diffusjon å lage bilder basert på tidligere erfaring. I Stable Diffussion er et hypernettverk et ekstra lag som behandles etter at et bilde har blitt gjengitt gjennom modellen. Hypernettverket har en tendens til å skjeve alle resultater fra modellen mot treningsdataene dine på en måte som i hovedsak "endrer" modellen.

Minneoppbevaring

Dette betyr i hovedsak at hypernettverket er ansvarlig for minneoppbevaring av bilder systemet tidligere har generert. Når en bruker gir et nytt innspill, kan systemet bruke sin eksisterende kunnskap for å skape et mer nøyaktig bilde. Som sådan lar hypernettverk derfor systemet lære raskere og forbedres etter hvert.

Dette har fordelen at hvert bilde som inneholder noe som beskriver treningsdataene dine, vil se ut som treningsdataene dine.

"Vi fant ut at trening med innebygging er enklere enn å trene med et hypernettverk for å generere selvportretter. Treningen vår ga gode resultater som vi er fornøyde med», skrev Cheung.

Hvilken finjusteringsteknikk bruker du? Noe som Hypernettverk eller Tekstinversjon?

— Mathias Michel (@m91michel) Desember 21, 2022

Men det er en teknologi mange fortsatt pruter med. Hypernettverk og AI-generatorer har akkurat begynt å imøtekomme brukernes behov og ønsker. Brukergrensesnittene og forespørselsteknikkene vil utvilsomt utvikle seg raskt, og vil kanskje til og med fange Google off-guard, som MetaNews nylig dekket.

- AI

- ai kunst

- Bitcoin

- blockchain

- blockchain-overholdelse

- coinbase

- coingenius

- Konsensus

- kryptokonferanse

- krypto gruvedrift

- cryptocurrency

- desentralisert

- dype forfalskninger

- Defi

- Digitale eiendeler

- ethereum

- kjennetegnet

- hypernettverk

- maskinlæring

- MetaNews

- ikke soppbart token

- plato

- plato ai

- Platon Data Intelligence

- PlatonData

- platogaming

- polygon

- bevis på innsatsen

- stabil-diffusjon

- Teknologi

- W3

- zephyrnet