Kvantedatamaskiner kan snart takle problemer som stopper dagens kraftige superdatamaskiner – selv når de er fulle av feil.

Beregning og nøyaktighet går hånd i hånd. Men et nytt samarbeid mellom IBM og UC Berkeley viste at perfeksjon ikke nødvendigvis er nødvendig for å løse utfordrende problemer, fra å forstå oppførselen til magnetiske materialer til å modellere hvordan nevrale nettverk oppfører seg eller hvordan informasjon spres på tvers av sosiale nettverk.

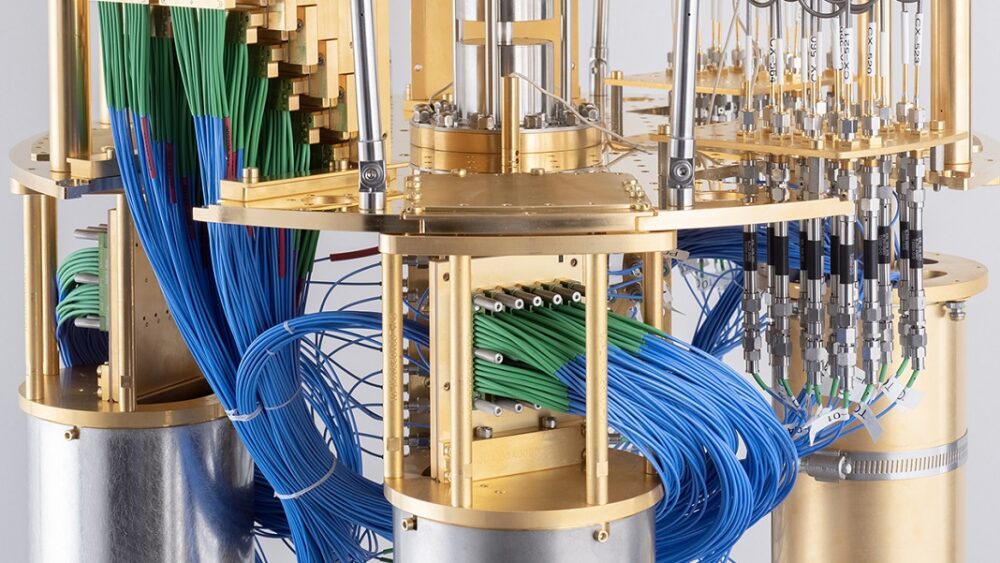

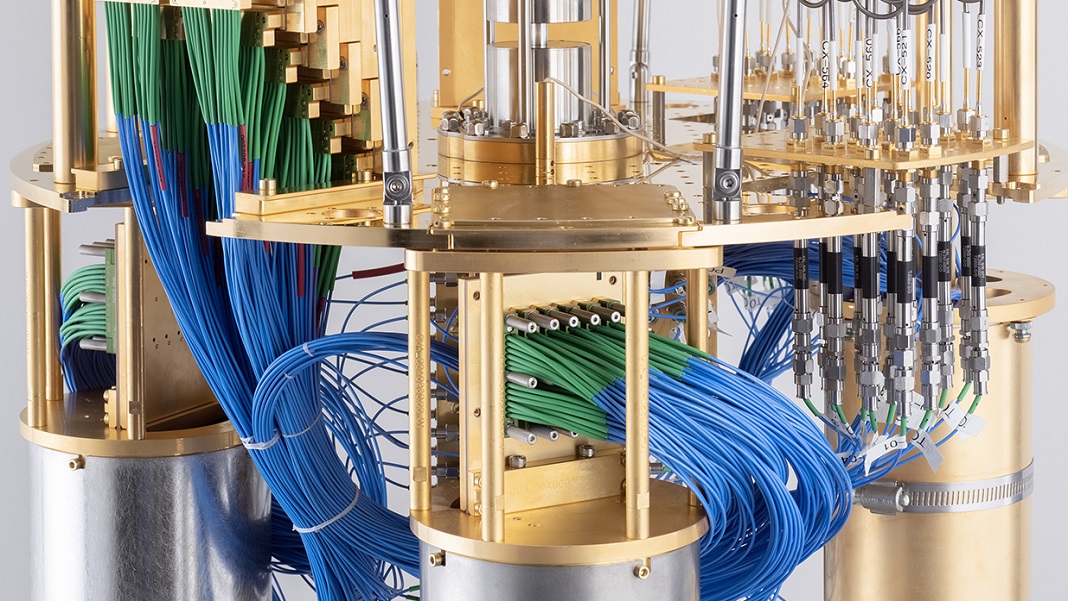

Lagene satte IBMs 127-qubit Eagle-brikke mot superdatamaskiner ved Lawrence Berkeley National Lab og Purdue University for stadig mer komplekse oppgaver. Med enklere beregninger matchet Eagle superdatamaskinens resultater hver gang – noe som tyder på at selv med støy kunne kvantedatamaskinen generere nøyaktige svar. Men hvor det lyste var i sin evne til å tolerere skala, og returnerte resultater som – i teorien – er langt mer nøyaktige enn det som er mulig i dag med toppmoderne silisium datamaskinbrikker.

I hjertet er en etterbehandlingsteknikk som reduserer støy. I likhet med å se på et stort maleri, ignorerer metoden hvert penselstrøk. Snarere fokuserer det på små deler av maleriet og fanger den generelle "essensen" av kunstverket.

Studien, publisert i Natur, jakter ikke på kvantefordeler, teorien om at kvantedatamaskiner kan løse problemer raskere enn konvensjonelle datamaskiner. Snarere viser det at dagens kvantedatamaskiner, selv når de er ufullkomne, kan bli en del av vitenskapelig forskning – og kanskje livene våre – raskere enn forventet. Med andre ord, vi har nå gått inn i riket av kvantenytte.

"Kruxet av arbeidet er at vi nå kan bruke alle 127 av Eagles qubits for å kjøre en ganske betydelig og dyp krets - og tallene kommer riktige ut," sa Dr. Kristan Temme, hovedmedarbeider og leder for Theory of Quantum Algorithms-gruppen ved IBM Quantum.

[Innebygd innhold]

Feil Terror

Akilleshælen til kvantedatamaskiner er deres feil.

I likhet med klassiske silisiumbaserte databrikker – de som kjører i telefonen eller den bærbare datamaskinen – bruker kvantedatamaskiner pakker med data kalt biter som den grunnleggende beregningsmetoden. Det som er annerledes er at i klassiske datamaskiner, representerer bits 1 eller 0. Men takket være kvante-quirks eksisterer kvanteekvivalenten til biter, qubits, i en tilstand av fluks, med en sjanse for å lande i begge posisjonene.

Denne rarheten, sammen med andre attributter, gjør det mulig for kvantedatamaskiner å beregne flere komplekse beregninger samtidig – i hovedsak, alt, overalt, alt på en gang (blink) – noe som gjør dem, i teorien, langt mer effektive enn dagens silisiumbrikker.

Det er vanskeligere å bevise ideen.

"Kløpet om å vise at disse prosessorene kan utkonkurrere sine klassiske kolleger er vanskelig," sa Drs. Göran Wendin og Jonas Bylander ved Chalmers tekniska högskola i Sverige, som ikke var involvert i studien.

Hovedturen opp? Feil.

Qubits er kresne ting, det samme er måtene de samhandler med hverandre på. Selv mindre endringer i tilstanden eller miljøet deres kan få en beregning av sporet. "Å utvikle det fulle potensialet til kvantedatamaskiner krever enheter som kan rette opp sine egne feil," sa Wendin og Bylander.

Eventyrets slutt er en feiltolerant kvantedatamaskin. Her vil den ha tusenvis av høykvalitets qubits som ligner på "perfekte" som brukes i dag i simulerte modeller, alle kontrollert av et selvkorrigerende system.

Den fantasien kan være flere tiår unna. Men i mellomtiden har forskere bestemt seg for en midlertidig løsning: feilbegrensning. Ideen er enkel: hvis vi ikke kan eliminere støy, hvorfor ikke godta det? Her er tanken å måle og tolerere feil samtidig som man finner metoder som kompenserer for kvantehikke ved hjelp av etterbehandlingsprogramvare.

Det er et tøft problem. En tidligere metode, kalt "støyende mellomskala kvanteberegning," kan spore feil mens de bygger opp og korrigerer dem før de ødelegger den aktuelle beregningsoppgaven. Men ideen fungerte bare for kvantedatamaskiner som kjører noen få qubits - en løsning som ikke fungerer for å løse nyttige problemer, fordi de sannsynligvis vil kreve tusenvis av qubits.

IBM Quantum hadde en annen idé. Tilbake i 2017, publiserte de en veiledende teori: hvis vi kan forstå kilden til støy i kvantedatasystemet, kan vi eliminere effektene.

Den generelle ideen er litt uortodoks. I stedet for å begrense støy, teamet bevisst økt støy i en kvantedatamaskin ved hjelp av en lignende teknikk som kontrollerer qubits. Dette gjør det mulig å måle resultater fra flere eksperimenter injisert med varierende støynivå, og utvikle måter å motvirke negative effekter.

Tilbake til null

I denne studien genererte teamet en modell av hvordan støy oppfører seg i systemet. Med dette "støyatlaset" kunne de bedre manipulere, forsterke og eliminere de uønskede signalene på en forutsigbar måte.

Ved å bruke etterbehandlingsprogramvare kalt Zero Noise Extrapolation (ZNE), ekstrapolerte de det målte "støyatlaset" til et system uten støy - som digitalt sletting av bakgrunnsbrumming fra et innspilt lydspor.

Som et bevis på konseptet vendte teamet seg til en klassisk matematisk modell som brukes til å fange komplekse systemer innen fysikk, nevrovitenskap og sosial dynamikk. Kalt 2D Ising-modellen, ble den opprinnelig utviklet for nesten et århundre siden for å studere magnetiske materialer.

Magnetiske objekter er litt som qubits. Se for deg et kompass. De har en tilbøyelighet til å peke nordover, men kan lande i hvilken som helst posisjon avhengig av hvor du er – bestemmer deres endelige tilstand.

Ising-modellen etterligner et gitter av kompass, der hver enkelts spinn påvirker naboens. Hvert spinn har to tilstander: opp eller ned. Selv om den opprinnelig ble brukt til å beskrive magnetiske egenskaper, er Ising-modellen nå mye brukt for å simulere oppførselen til komplekse systemer, som biologiske nevrale nettverk og sosial dynamikk. Det hjelper også med å rydde opp støy i bildeanalyse og styrker datasyn.

Modellen er perfekt for utfordrende kvantedatamaskiner på grunn av skalaen. Etter hvert som antallet "kompass" øker, øker systemets kompleksitet eksponentielt og vokser raskt ut av evnen til dagens superdatamaskiner. Dette gjør den til en perfekt test for pitting quantum og klassiske datamaskiner mano a mano.

En innledende test fokuserte først på en liten gruppe spinn godt innenfor superdatamaskinenes evner. Resultatene var på topp for begge, og ga en benchmark for Eagle-kvanteprosessorens ytelse med feilreduserende programvare. Det vil si at selv med feil ga kvanteprosessoren nøyaktige resultater som ligner på de fra toppmoderne superdatamaskiner.

For de neste testene trappet teamet opp kompleksiteten i beregningene, og brukte til slutt alle Eagles 127 qubits og over 60 forskjellige trinn. Til å begynne med superdatamaskinene, bevæpnet med triks å beregne eksakte svar, holdt tritt med kvantedatamaskinen, og pumpet ut overraskende like resultater.

"Nivået av samsvar mellom kvanteberegninger og klassiske beregninger på så store problemer var ganske overraskende for meg personlig," sa studieforfatter Dr. Andrew Eddins ved IBM Quantum.

Etter hvert som kompleksiteten økte, begynte imidlertid klassiske tilnærmingsmetoder å vakle. Bruddepunktet skjedde da teamet ringte opp qubits til 68 for å modellere problemet. Derfra var Eagle i stand til å skalere opp til hele 127 qubits, og generere svar utover evnen til superdatamaskinene.

Det er umulig å bekrefte at resultatene er helt nøyaktige. Men fordi Eagles ytelse stemte overens med resultatene fra superdatamaskinene - til det punktet sistnevnte ikke lenger kunne holde - antyder de tidligere forsøkene at de nye svarene sannsynligvis er riktige.

Hva blir det neste?

Studien er fortsatt et proof of concept.

Selv om det viser at etterbehandlingsprogramvaren, ZNE, kan redusere feil i et 127-qubit-system, er det fortsatt uklart om løsningen kan skaleres opp. Med IBMs 1,121-qubit Condor-brikke satt til å slippe i år – og «verktøyskala-prosessorer» med opptil 4,158 XNUMX qubits i pipelinen – kan den feilreduserende strategien trenge ytterligere testing.

Samlet sett ligger metodens styrke i skalaen, ikke i hastigheten. Kvantehastigheten var omtrent to til tre ganger raskere enn klassiske datamaskiner. Strategien bruker også en kortsiktig pragmatisk tilnærming ved å følge strategier som minimerer feil – i motsetning til å korrigere dem helt – som en midlertidig løsning for å begynne å bruke disse merkelige, men kraftige maskinene.

Disse teknikkene "vil drive utviklingen av enhetsteknologi, kontrollsystemer og programvare ved å tilby applikasjoner som kan tilby nyttige kvantefordeler utover kvanteberegningsforskning - og bane vei for virkelig feiltolerant kvanteberegning," sa Wendin og Bylander. Selv om de fortsatt var i sine tidlige dager, "varsler de ytterligere muligheter for kvanteprosessorer til å emulere fysiske systemer som er langt utenfor rekkevidden til konvensjonelle datamaskiner."

Bilde Credit: IBM

- SEO-drevet innhold og PR-distribusjon. Bli forsterket i dag.

- EVM Finans. Unified Interface for desentralisert økonomi. Tilgang her.

- Quantum Media Group. IR/PR forsterket. Tilgang her.

- PlatoAiStream. Web3 Data Intelligence. Kunnskap forsterket. Tilgang her.

- kilde: https://singularityhub.com/2023/06/20/an-ibm-quantum-computer-beat-a-supercomputer-in-a-benchmark-test/

- : har

- :er

- :ikke

- :hvor

- $OPP

- 1

- 2D

- 60

- a

- evne

- I stand

- Om oss

- Aksepterer

- nøyaktighet

- nøyaktig

- Achilles

- tvers

- Fordel

- mot

- siden

- Avtale

- algoritmer

- Alle

- langs

- også

- Selv

- an

- analyse

- og

- Andrew

- En annen

- svar

- noen

- søknader

- tilnærming

- ER

- kunstverk

- AS

- At

- attributter

- forfatter

- bakgrunn

- grunnleggende

- BE

- fordi

- bli

- før du

- begynte

- begynne

- benchmark

- Berkeley

- Bedre

- mellom

- Beyond

- Bit

- både

- Breaking

- bygge

- men

- by

- beregne

- beregninger

- som heter

- CAN

- evner

- evne

- fangst

- fanger

- Århundre

- sertifisere

- utfordrende

- sjanse

- Endringer

- Topplisten

- chip

- chips

- Cineca

- Classic

- Rengjøring

- Kom

- Kompass

- helt

- komplekse

- kompleksitet

- beregningen

- beregninger

- Beregn

- datamaskin

- Datamaskin syn

- datamaskiner

- databehandling

- konsept

- innhold

- kontroll

- kontrolleres

- kontroller

- konvensjonell

- korrigere

- kunne

- kreditt

- dato

- Dager

- tiår

- avtar

- dyp

- avhengig

- beskrive

- utvikle

- utviklet

- Utvikling

- enhet

- Enheter

- forskjellig

- vanskelig

- digitalt

- ikke

- ned

- dr

- stasjonen

- dubbet

- dynamikk

- hver enkelt

- Tidlig

- enklere

- effekter

- effektiv

- enten

- eliminere

- innebygd

- kom inn

- Hele

- Miljø

- Tilsvarende

- feil

- feil

- Selv

- etter hvert

- Hver

- eksisterer

- forventet

- eksperiment

- eksperimenter

- eksponentielt

- FANTASI

- langt

- raskere

- Noen få

- finne

- Først

- FLUX

- fokuserte

- fokuserer

- Til

- fra

- fullt

- videre

- general

- generere

- generert

- genererer

- Go

- Gruppe

- HAD

- hånd

- skjedde

- Ha

- Hjerte

- hjelper

- her.

- høykvalitets

- hold

- Hvordan

- Men

- HTTPS

- IBM

- ibm kvante

- Tanken

- if

- bilde

- forestille

- umulig

- in

- I andre

- økt

- øker

- stadig

- informasjon

- innledende

- samhandle

- involvert

- IT

- DET ER

- jpg

- holdt

- lab

- Tomt

- landing

- stor

- Nivå

- nivåer

- i likhet med

- Sannsynlig

- lenger

- ser

- maskiner

- Hoved

- GJØR AT

- leder

- merke

- matchet

- materialer

- matematiske

- Kan..

- me

- mellomtiden

- måle

- medlem

- metode

- metoder

- mindre

- Minske

- skadebegrensning

- modell

- modellering

- modeller

- mer

- mer effektivt

- flere

- nasjonal

- Natur

- nesten

- nødvendigvis

- Trenger

- negativ

- nettverk

- nevrale nettverk

- Neuroscience

- Ny

- neste

- Nei.

- Bråk

- nord

- nå

- Antall

- tall

- gjenstander

- of

- off

- tilby

- on

- ONE

- seg

- bare

- Muligheter

- motsetning

- or

- opprinnelig

- Annen

- vår

- ut

- outperform

- enn

- samlet

- egen

- pakker

- maleri

- del

- banen

- vraket

- perfekt

- perfeksjon

- ytelse

- kanskje

- personlig

- telefon

- fysisk

- Fysikk

- pitted

- plato

- Platon Data Intelligence

- PlatonData

- Point

- posisjon

- mulig

- potensiell

- kraftig

- pragmatisk

- pen

- forrige

- prinsipp

- Problem

- problemer

- prosessor

- prosessorer

- bevis

- proof of concept

- egenskaper

- forutsatt

- gi

- publisert

- pumping

- Quantum

- kvantefordel

- kvantealgoritmer

- Kvantedatamaskin

- kvante datamaskiner

- kvanteberegning

- qubits

- raskt

- Race

- heller

- å nå

- riket

- registrert

- representere

- krever

- påkrevd

- Krever

- forskning

- svar

- Resultater

- retur

- reiser seg

- Kjør

- rennende

- Sa

- Skala

- vitenskapelig

- forskere

- Bosatte seg

- kortsiktig

- Vis

- viste

- Viser

- signaler

- Silicon

- lignende

- Enkelt

- samtidig

- betydelig

- liten

- selskap

- sosiale nettverk

- Software

- løsning

- LØSE

- løse

- snart

- soundtrack

- kilde

- fart

- Snurre rundt

- spins

- Sprer

- Staff

- Tilstand

- state-of-the-art

- Stater

- Steps

- Still

- strategier

- Strategi

- styrke

- Studer

- slik

- foreslår

- superdatamaskin

- overrask

- Sverige

- system

- Systemer

- takle

- fortelling

- Oppgave

- oppgaver

- lag

- lag

- teknikker

- Teknologi

- test

- Testing

- tester

- enn

- Takk

- Det

- De

- Kilden

- deres

- Dem

- deretter

- teori

- Der.

- Disse

- de

- ting

- denne

- De

- tusener

- tre

- ganger

- til

- i dag

- dagens

- tøff

- spor

- forsøk

- virkelig

- snudde

- to

- ultimate

- forstå

- forståelse

- universitet

- uønsket

- bruke

- brukt

- bruker

- ved hjelp av

- verktøyet

- utnytte

- syn

- var

- Vei..

- måter

- we

- VI VIL

- var

- når

- hvilken

- mens

- HVEM

- hvorfor

- allment

- Wikipedia

- med

- innenfor

- uten

- ord

- Arbeid

- arbeidet

- Du

- Din

- youtube

- zephyrnet

- null