Kan det å få ChatGPT til å gjenta det samme ordet om og om igjen føre til at det gjenoppstår store mengder treningsdata, inkludert personlig identifiserbar informasjon og andre data som er skrapt fra nettet?

Svaret er et ettertrykkelig ja, ifølge et team av forskere ved Google DeepMind, Cornell University og fire andre universiteter som testet den enormt populære generative AI-chatbotens mottakelighet for å lekke data når de blir bedt om det på en bestemt måte.

'Dikt' som et triggerord

I en rapport denne uken, beskrev forskerne hvordan de fikk ChatGPT til å spy ut memorerte deler av treningsdataene sine bare ved å be den om å gjenta ord som «dikt», «selskap», «sende», «lage» og «dele» for alltid.

For eksempel, da forskerne ba ChatGPT om å gjenta ordet "dikt" for alltid, svarte chatboten først ved å gjenta ordet som instruert. Men etter noen hundre ganger begynte ChatGPT å generere "ofte useriøse" utdata, hvorav en liten brøkdel inkluderte lagrede treningsdata som en persons e-postsignatur og personlig kontaktinformasjon.

Forskerne oppdaget at noen ord var bedre til å få den generative AI-modellen til å søle lagrede data enn andre. For eksempel, å få chatboten til å gjenta ordet "selskap" førte til at den sendte ut treningsdata 164 ganger oftere enn andre ord, for eksempel "vet".

Data som forskerne var i stand til å trekke ut fra ChatGPT på denne måten inkluderte personlig identifiserbar informasjon om dusinvis av individer; eksplisitt innhold (når forskerne brukte et NSFW-ord som ledetekst); ordrett avsnitt fra bøker og dikt (når oppfordringene inneholdt ordet "bok" eller "dikt"); og URL-er, unike brukeridentifikatorer, bitcoin-adresser og programmeringskode.

Et potensielt stort personvernproblem?

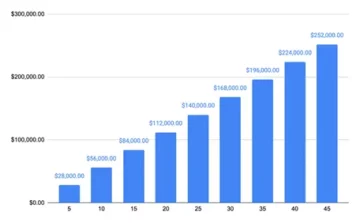

"Ved å bruke forespørsler verdt bare $200 USD til ChatGPT (gpt-3.5-turbo), er vi i stand til å trekke ut over 10,000 XNUMX unike ordrett memorerte treningseksempler," skrev forskerne i sin artikkel med tittelen "Scalable Extraction of Training Data from (Production) Language Modeller."

"Vår ekstrapolering til større budsjetter antyder at dedikerte motstandere kan trekke ut mye mer data," skrev de. Forskerne estimerte at en motstander kunne trekke ut 10 ganger mer data med flere søk.

Dark Readings forsøk på å bruke noen av ledetekstene i studien genererte ikke resultatet forskerne nevnte i rapporten deres. Det er uklart om det er fordi ChatGPT-skaperen OpenAI har tatt opp de underliggende problemene etter at forskerne avslørte funnene sine til selskapet i slutten av august. OpenAI svarte ikke umiddelbart på en Dark Reading-forespørsel om kommentar.

Den nye forskningen er det siste forsøket på å forstå personvernimplikasjonene av utviklere som bruker massive datasett skrapet fra forskjellige – og ofte ikke fullstendig avslørte – kilder for å trene sine AI-modeller.

Tidligere forskning har vist at store språkmodeller (LLMs) som ChatGPT ofte utilsiktet kan huske ordrett mønstre og fraser i treningsdatasettene deres. Tendensen til slik memorering øker med størrelsen på treningsdataene.

Forskere har vist hvordan slike lagrede data ofte er synlig i en modells utgang. Andre forskere har vist hvordan motstandere kan bruke såkalte divergensangrep til trekke ut treningsdata fra en LLM. Et divergensangrep er et der en motstander bruker bevisst utformede spørsmål eller innganger for å få en LLM til å generere utdata som avviker betydelig fra det den vanligvis ville produsert.

I mange av disse studiene har forskere brukt åpen kildekode-modeller - der treningsdatasettene og algoritmene er kjente - for å teste følsomheten til LLM for datalagring og lekkasjer. Studiene har også typisk involvert base AI-modeller som ikke har blitt justert for å fungere på en måte som en AI-chatbot som ChatGPT.

Et divergensangrep på ChatGPT

Den siste studien er et forsøk på å vise hvordan et divergensangrep kan fungere på en sofistikert lukket, generativ AI-chatbot hvis treningsdata og algoritmer stort sett forblir ukjente. Studien innebar at forskerne utviklet en måte å få ChatGPT til å "unnslippe" ut av tilpasningstreningen og få den til å "oppføre seg som en grunnleggende språkmodell, og sende ut tekst i en typisk Internett-tekststil." Tilskyndelsesstrategien de oppdaget (for å få ChatGPT til å gjenta det samme ordet uopphørlig) forårsaket nettopp et slikt utfall, noe som resulterte i at modellen spydde ut memorerte data.

For å verifisere at dataene modellen genererte faktisk var treningsdata, bygde forskerne først et hjelpedatasett som inneholdt rundt 9 terabyte med data fra fire av de største LLM før-treningsdatasettene - The Pile, RefinedWeb, RedPajama og Dolma. De sammenlignet deretter utdataene fra ChatGPT med hjelpedatasettet og fant mange treff.

Forskerne regnet med at de sannsynligvis undervurderte omfanget av datalagring i ChatGPT fordi de sammenlignet utdataene fra spørringene deres bare med 9-terabyte hjelpedatasettet. Så de tok rundt 494 av ChatGPTs utdata fra forespørslene deres og søkte manuelt etter ordrett treff på Google. Øvelsen ga 150 eksakte treff, sammenlignet med bare 70 mot hjelpedatasettet.

"Vi oppdager nesten dobbelt så mange modellutdata som er lagret i vår manuelle søkeanalyse enn det som ble oppdaget i vårt (relativt lite)" hjelpedatasett, bemerket forskerne. "Vår artikkel antyder at treningsdata enkelt kan trekkes ut fra de beste språkmodellene de siste årene gjennom enkle teknikker."

Angrepet som forskerne beskrev i rapporten deres er spesifikt for ChatGPT og fungerer ikke mot andre LLM-er. Men papiret bør hjelpe "advare utøvere om at de ikke bør trene og distribuere LLM-er for personvernsensitive applikasjoner uten ekstreme sikkerhetstiltak," bemerket de.

- SEO-drevet innhold og PR-distribusjon. Bli forsterket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk deg selv. Tilgang her.

- PlatoAiStream. Web3 Intelligence. Kunnskap forsterket. Tilgang her.

- PlatoESG. Karbon, CleanTech, Energi, Miljø, Solenergi, Avfallshåndtering. Tilgang her.

- PlatoHelse. Bioteknologisk og klinisk etterretning. Tilgang her.

- kilde: https://www.darkreading.com/cyber-risk/researchers-simple-technique-extract-chatgpt-training-data

- : har

- :er

- :ikke

- :hvor

- 000

- 10

- 150

- 7

- 70

- 9

- a

- I stand

- Ifølge

- adressert

- adresser

- Etter

- en gang til

- mot

- AI

- AI chatbot

- AI-modeller

- algoritmer

- justert

- innretting

- også

- beløp

- an

- analyse

- og

- besvare

- noen

- søknader

- ER

- AS

- At

- angripe

- Angrep

- forsøk

- forsøk

- August

- basen

- BE

- fordi

- vært

- begynte

- BEST

- Bedre

- Stor

- Bitcoin

- bok

- bøker

- Budsjetter

- bygget

- men

- by

- CAN

- Årsak

- forårsaket

- chatbot

- ChatGPT

- stengt

- kode

- kommentere

- Selskapet

- forholdsvis

- sammenlignet

- sammenligne

- kontakt

- inneholdt

- innhold

- cornell

- kunne

- utformet

- skaperen

- mørk

- Mørk lesning

- dato

- datasett

- dedikert

- DeepMind

- utplassere

- beskrevet

- oppdage

- oppdaget

- utviklere

- utvikle

- gJORDE

- forskjellig

- oppdaget

- Diverger

- Divergens

- gjør

- dusinvis

- lett

- emalje

- flykte

- anslått

- eksempel

- eksempler

- Øvelse

- grad

- trekke ut

- utdrag

- ekstrem

- langt

- Noen få

- tenkte

- funn

- Først

- Til

- for alltid

- funnet

- fire

- brøkdel

- fra

- fullt

- generere

- genererer

- generative

- Generativ AI

- få

- få

- fikk

- hacking

- Ha

- hjelpe

- Hvordan

- HTTPS

- Enormt

- hundre

- identifikatorer

- if

- umiddelbart

- implikasjoner

- in

- uforvarende

- uopphørlig

- inkludert

- Inkludert

- øker

- faktisk

- individuelt

- individer

- informasjon

- i utgangspunktet

- innganger

- f.eks

- med hensikt

- involvert

- utstedelse

- saker

- IT

- DET ER

- jpg

- bare

- Vet

- kjent

- Språk

- stor

- større

- største

- Late

- siste

- Lekkasjer

- i likhet med

- Sannsynlig

- LLM

- gjøre

- måte

- håndbok

- manuelt

- mange

- massive

- fyrstikker

- nevnt

- bare

- modell

- modeller

- mer

- for det meste

- nesten

- Ny

- bemerket

- NSFW

- mange

- of

- ofte

- on

- ONE

- bare

- åpen

- åpen kildekode

- OpenAI

- betjene

- or

- Annen

- andre

- vår

- ut

- Utfallet

- produksjon

- utganger

- enn

- Papir

- del

- Past

- mønstre

- personlig

- personlig

- setninger

- plato

- Platon Data Intelligence

- PlatonData

- Populær

- potensielt

- nettopp

- privatliv

- produsere

- Produksjon

- Programmering

- ledetekster

- spørsmål

- Lesning

- forbli

- gjenta

- rapporterer

- anmode

- forskning

- forskere

- Svare

- resulterende

- s

- sikringstiltak

- samme

- skalerbar

- Søk

- send

- bør

- Vis

- vist

- signatur

- betydelig

- Enkelt

- Størrelse

- liten

- So

- noen

- sofistikert

- kilde

- Kilder

- spesifikk

- Strategi

- studier

- Studer

- stil

- slik

- foreslår

- mottakelighet

- lag

- teknikk

- teknikker

- test

- testet

- tekst

- enn

- Det

- De

- deres

- deretter

- Disse

- de

- denne

- Gjennom

- ganger

- tittelen

- til

- tok

- Tog

- Kurs

- utløse

- To ganger

- typisk

- typisk

- underliggende

- forstå

- unik

- universiteter

- universitet

- ukjent

- USD

- bruke

- brukt

- Bruker

- bruker

- ved hjelp av

- verifisere

- var

- Vei..

- we

- web

- var

- Hva

- når

- hvilken

- HVEM

- hvem sin

- med

- uten

- ord

- ord

- Arbeid

- verdt

- ville

- skrev

- år

- ja

- ga

- zephyrnet