I dag er vi glade for å kunngjøre muligheten til å finjustere Llama 2-modeller av Meta ved å bruke Amazon SageMaker JumpStart. Llama 2-familien av store språkmodeller (LLM) er en samling av forhåndstrente og finjusterte generative tekstmodeller som varierer i skala fra 7 milliarder til 70 milliarder parametere. Finjusterte LLM-er, kalt Llama-2-chat, er optimalisert for brukstilfeller for dialog. Du kan enkelt prøve ut disse modellene og bruke dem med SageMaker JumpStart, som er en maskinlæringshub (ML) som gir tilgang til algoritmer, modeller og ML-løsninger slik at du raskt kan komme i gang med ML. Nå kan du også finjustere 7 milliarder, 13 milliarder og 70 milliarder parametere Llama 2-tekstgenereringsmodeller på SageMaker JumpStart ved å bruke Amazon SageMaker Studio UI med noen få klikk eller ved å bruke SageMaker Python SDK.

Generative AI-fundamentmodeller har vært i fokus for det meste av forskning og bruk av ML og kunstig intelligens i over et år nå. Disse grunnmodellene fungerer veldig bra med generative oppgaver, som tekstgenerering, oppsummering, svar på spørsmål, bilde- og videogenerering med mer, på grunn av sin store størrelse og også fordi de er trent på flere store datasett og hundrevis av oppgaver. Til tross for de store generaliseringsmulighetene til disse modellene, er det ofte brukstilfeller som har veldig spesifikke domenedata (som helsetjenester eller finansielle tjenester), på grunn av disse modellene kan det hende at disse modellene ikke kan gi gode resultater for disse brukstilfellene. Dette resulterer i et behov for ytterligere finjustering av disse generative AI-modellene over brukstilfellespesifikke og domenespesifikke data.

I dette innlegget går vi gjennom hvordan du finjusterer Llama 2 forhåndstrente tekstgenerasjonsmodeller via SageMaker JumpStart.

Hva er Llama 2

Llama 2 er en autoregressiv språkmodell som bruker en optimalisert transformatorarkitektur. Llama 2 er beregnet for kommersiell bruk og forskningsbruk på engelsk. Den kommer i en rekke parameterstørrelser – 7 milliarder, 13 milliarder og 70 milliarder – så vel som forhåndstrente og finjusterte variasjoner. I følge Meta bruker de innstilte versjonene overvåket finjustering (SFT) og forsterkningslæring med menneskelig tilbakemelding (RLHF) for å tilpasse seg menneskelige preferanser for hjelpsomhet og sikkerhet. Llama 2 ble forhåndstrent på 2 billioner tokens med data fra offentlig tilgjengelige kilder. De innstilte modellene er ment for assistent-lignende chat, mens forhåndstrente modeller kan tilpasses for en rekke naturlige språkgenereringsoppgaver. Uavhengig av hvilken versjon av modellen en utvikler bruker, vil ansvarlig bruksveiledning fra Meta kan hjelpe til med å veilede ytterligere finjusteringer som kan være nødvendig for å tilpasse og optimalisere modellene med passende sikkerhetsreduksjoner.

For øyeblikket er Llama 2 tilgjengelig i følgende regioner:

- Distribuer forhåndstrent modell tilgjengelig:

"us-west-2","us-east-1","us-east-2","eu-west-1","ap-southeast-1","ap-southeast-2" - Finjuster og distribuer den finjusterte modellen:

“us-east-1”,“us-west-2”,“eu-west-1”

Hva er SageMaker JumpStart

Med SageMaker JumpStart kan ML-utøvere velge fra et bredt utvalg av offentlig tilgjengelige fundamentmodeller. ML-utøvere kan distribuere grunnmodeller til dedikerte Amazon SageMaker forekomster fra et nettverksisolert miljø og tilpasse modeller ved hjelp av SageMaker for modellopplæring og distribusjon. Du kan nå oppdage og distribuere Llama 2 med noen få klikk i SageMaker Studio eller programmatisk gjennom SageMaker Python SDK, slik at du kan utlede modellytelse og MLOps-kontroller med SageMaker-funksjoner som f.eks. Amazon SageMaker-rørledninger, Amazon SageMaker Debugger, eller containerlogger. Modellen er distribuert i et AWS-sikkert miljø og under dine VPC-kontroller, noe som bidrar til å sikre datasikkerhet. I tillegg kan du finjustere Llama2 7B, 13B og 70B forhåndstrente tekstgenereringsmodeller via SageMaker JumpStart.

Finjuster Llama2-modeller

Du kan finjustere modellene ved å bruke enten SageMaker Studio UI eller SageMaker Python SDK. Vi diskuterer begge metodene i denne delen.

Finjustering uten kode via SageMaker Studio UI

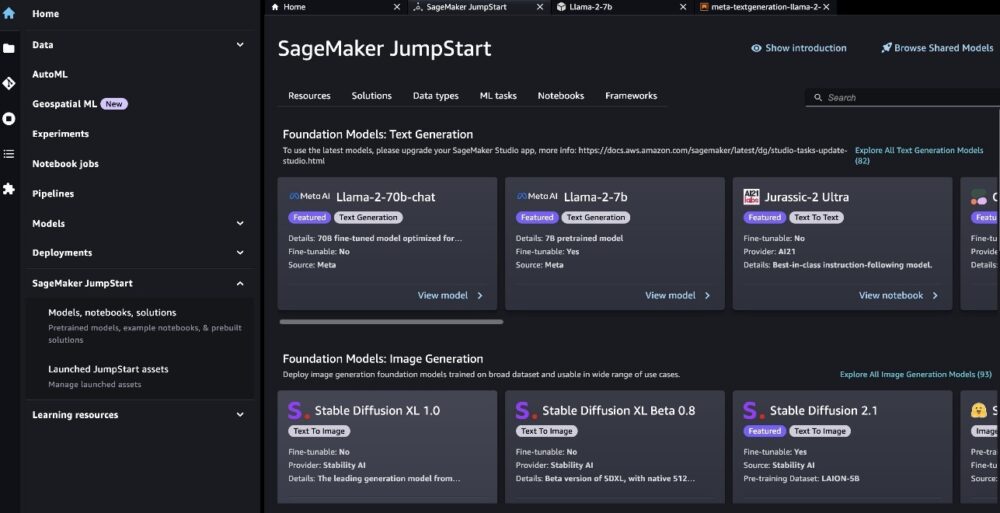

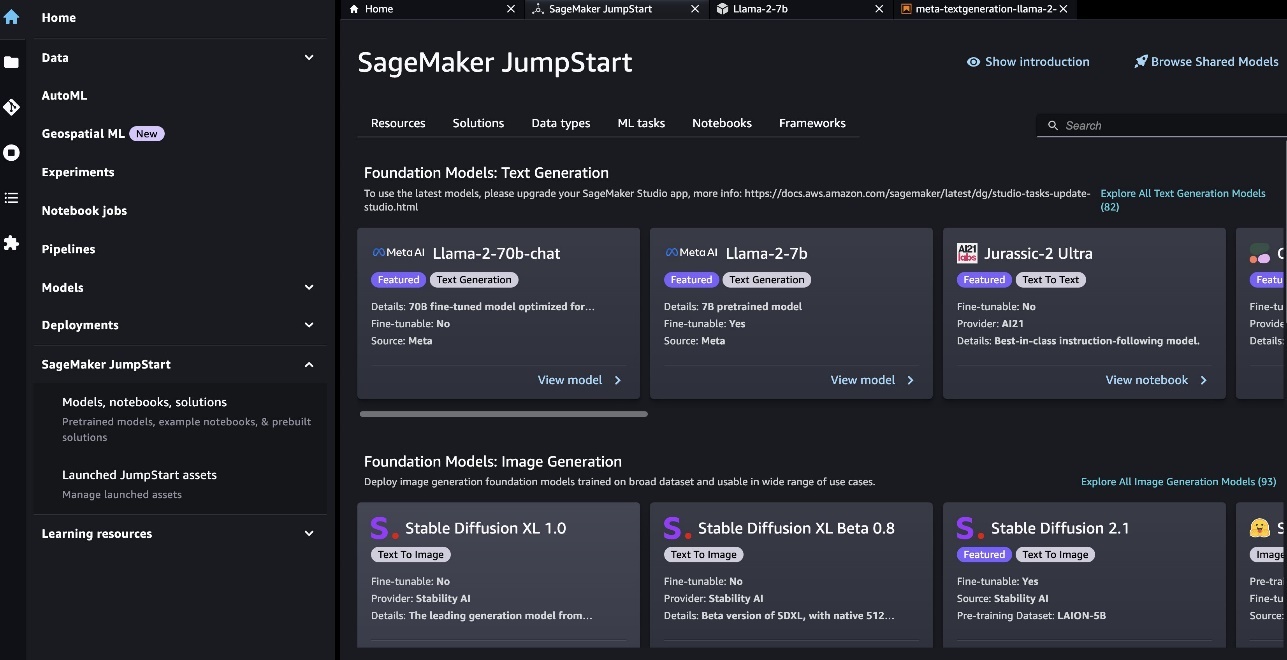

I SageMaker Studio kan du få tilgang til Llama 2-modeller via SageMaker JumpStart under Modeller, notatbøker og løsninger, som vist på følgende skjermbilde.

Hvis du ikke ser Llama 2-modeller, oppdater SageMaker Studio-versjonen din ved å slå av og starte på nytt. For mer informasjon om versjonsoppdateringer, se Slå av og oppdater Studio-apper.

Du kan også finne andre fire modellvarianter ved å velge Utforsk alle tekstgenerasjonsmodeller eller søker etter lama i søkefeltet.

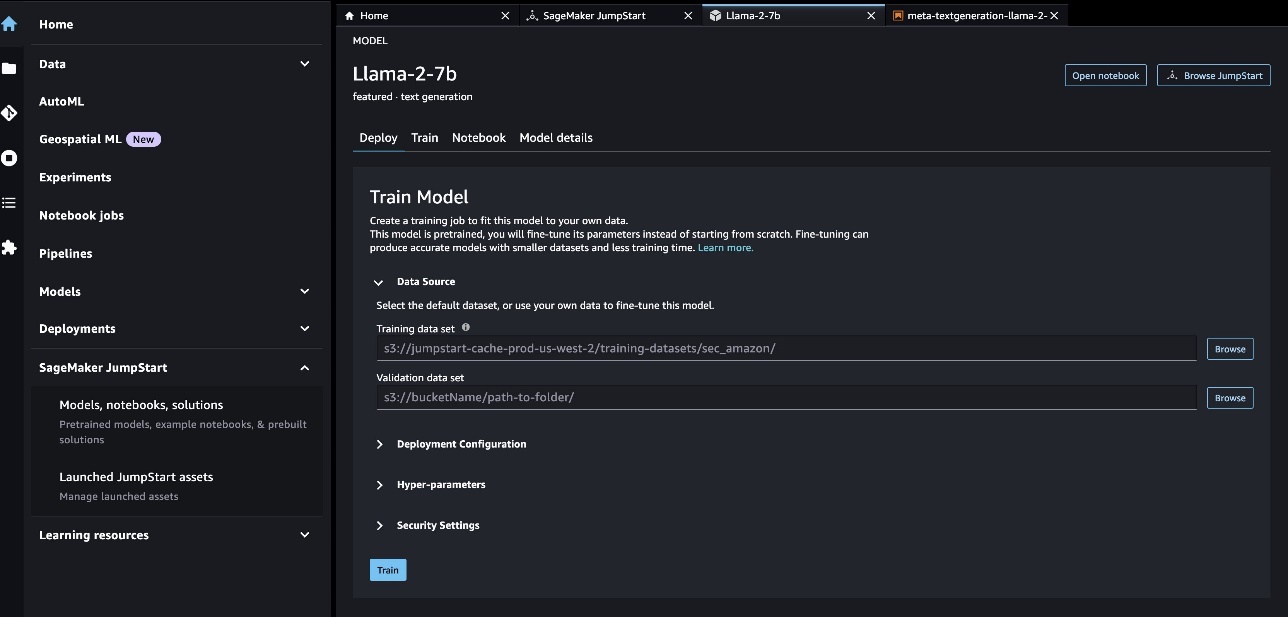

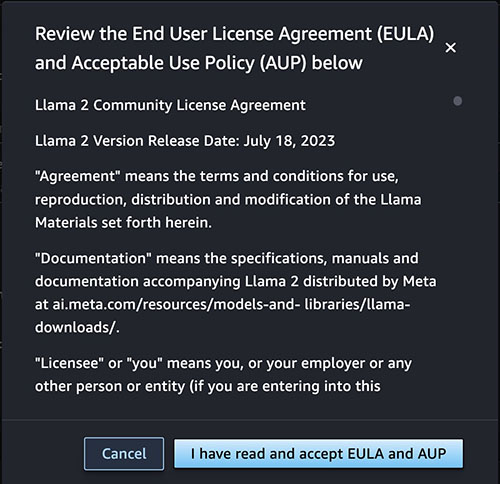

På denne siden kan du peke på Amazon enkel lagringstjeneste (Amazon S3) bøtte som inneholder opplærings- og valideringsdatasettene for finjustering. I tillegg kan du konfigurere distribusjonskonfigurasjon, hyperparametre og sikkerhetsinnstillinger for finjustering. Du kan da velge Tog å starte opplæringsjobben på en SageMaker ML-instans. Det foregående skjermbildet viser finjusteringssiden for Llama-2 7B-modellen; Du kan imidlertid finjustere tekstgenerasjonsmodellene 13B og 70B Llama 2 ved å bruke deres respektive modellsider på samme måte. For å bruke Llama 2-modeller må du godta sluttbrukerlisensavtalen (EULA). Det vil dukke opp når du velger Tog, som vist i følgende skjermbilde. Velge Jeg har lest og godtar EULA og AUP for å starte finjusteringsjobben.

Distribuer modellen

Etter at modellen er finjustert, kan du distribuere den ved å bruke modellsiden på SageMaker JumpStart. Alternativet for å distribuere den finjusterte modellen vil vises når finjusteringen er fullført, som vist i følgende skjermbilde.

Finjuster via SageMaker Python SDK

Du kan også finjustere Llama 2-modeller ved å bruke SageMaker Python SDK. Følgende er en eksempelkode for å finjustere Llama 2 7B på datasettet ditt:

Du kan distribuere den finjusterte modellen direkte fra estimatoren:

Du finner også koden i Finjuster LLaMA 2-modeller på SageMaker JumpStart. Det inkluderer forberedelse av datasett, opplæring i det tilpassede datasettet ditt og distribusjon av den finjusterte modellen. Den demonstrerer finjustering på et undersett av Dolly-datasettet med eksempler fra oppsummeringsoppgaven. Følgende er eksempelinngangen med svar fra finjusterte og ikke-finjusterte sammen med grunnsannhetsresponsen:

Inndata til modellen:

Ground Truth-svar:

Svar fra den ikke finjusterte modellen:

Svar fra den finjusterte modellen:

For ytelsesbenchmarking av forskjellige modeller på Dolly og Dialogsum datasettet, se Ytelsesbenchmarking avsnitt i vedlegget på slutten av dette innlegget.

Finjusteringsteknikk

Språkmodeller som Llama er mer enn 10 GB eller til og med 100 GB i størrelse. Finjustering av slike store modeller krever instanser med betydelig høyt CUDA-minne. Videre kan treningen av disse modellene være veldig treg på grunn av størrelsen på modellen. Derfor, for effektiv finjustering, bruker vi følgende optimaliseringer:

- Low-Rank Adaptation (LoRA) – Dette er en type parameter effektiv finjustering (PEFT) for effektiv finjustering av store modeller. I dette fryser vi hele modellen og legger bare til et lite sett med justerbare parametere eller lag i modellen. For eksempel, i stedet for å trene alle 7 milliarder parametere for Llama 2 7B, kan vi finjustere mindre enn 1 % av parameterne. Dette bidrar til betydelig reduksjon av minnekravet fordi vi bare trenger å lagre gradienter, optimeringstilstander og annen treningsrelatert informasjon for bare 1 % av parameterne. Videre hjelper dette med å redusere treningstiden så vel som kostnadene. For mer informasjon om denne metoden, se LoRA: Lavrangstilpasning av store språkmodeller.

- Int8 kvantisering – Selv med optimaliseringer som LoRA, er modeller som Llama 70B fortsatt for store til å trene. For å redusere minnefotavtrykket under trening, kan vi bruke Int8 kvantisering under trening. Kvantisering reduserer vanligvis presisjonen til flyttallsdatatypene. Selv om dette reduserer minnet som kreves for å lagre modellvekter, forringer det ytelsen på grunn av tap av informasjon. Int8 kvantisering bruker bare en kvart presisjon, men medfører ikke forringelse av ytelsen fordi den ikke bare mister bitene. Den runder dataene fra en type til en annen. For å lære om Int8 kvantisering, se LLM.int8(): 8-biters matrisemultiplikasjon for transformatorer i skala.

- Fullt delte data parallelt (FSDP) – Dette er en type dataparallell treningsalgoritme som sønderdeler modellens parametere på tvers av dataparallelle arbeidere og kan eventuelt overføre deler av treningsberegningen til CPU-ene. Selv om parametrene er delt på tvers av forskjellige GPUer, er beregningen av hver mikrobatch lokal for GPU-arbeideren. Den skjærer parametere mer jevnt og oppnår optimalisert ytelse via kommunikasjon og beregningsoverlapping under trening.

Tabellen nedenfor sammenligner ulike metoder med de tre Llama 2-modellene.

| , | Standard forekomsttype | Støttede forekomsttyper med standardkonfigurasjon | Standardinnstilling | LORA + FSDP | LORA + Ingen FSDP | Int8 Kvantisering + LORA + Ingen FSDP |

| Lama 2 7B | ml.g5.12xlarge | ml.g5.12xlarge, ml.g5.24xlarge, ml.g5.48xlarge | LORA + FSDP | Ja | Ja | Ja |

| Lama 2 13B | ml.g5.12xlarge | ml.g5.24xlarge, ml.g5.48xlarge | LORA + FSDP | Ja | Ja | Ja |

| Lama 2 70B | ml.g5.48xlarge | ml.g5.48xlarge | INT8 + LORA + INGEN FSDP | Nei | Nei | Ja |

Legg merke til at finjustering av Llama-modeller er basert på skript levert av følgende GitHub repo.

Opplæringsdatasettformat

SageMaker JumpStart støtter for tiden datasett i både domenetilpasningsformat og format for instruksjonsinnstilling. I denne delen spesifiserer vi et eksempeldatasett i begge formatene. For flere detaljer, se Datasettformatering avsnitt i vedlegget.

Domenetilpasningsformat

Tekstgenereringsmodellen Llama 2 kan finjusteres på ethvert domenespesifikt datasett. Etter at den er finjustert på det domenespesifikke datasettet, forventes modellen å generere domenespesifikk tekst og løse ulike NLP-oppgaver i det spesifikke domenet med få-shot-forespørsel. Med dette datasettet består inndata av en CSV-, JSON- eller TXT-fil. For eksempel kan inndata være SEC-arkiver fra Amazon som en tekstfil:

Instruksjonsinnstillingsformat

Ved finjustering av instruksjoner er modellen finjustert for et sett med NLP-oppgaver (natural language processing) beskrevet ved hjelp av instruksjoner. Dette bidrar til å forbedre modellens ytelse for usynlige oppgaver med null-shot-meldinger. I datasettformatet for instruksjonsinnstilling spesifiserer du template.json fil som beskriver inndata- og utdataformatene. For eksempel hver linje i filen train.jsonl ser slik ut:

Tilleggsfilen template.json ser slik ut:

Støttede hyperparametre for trening

Llama 2 finjustering støtter en rekke hyperparametre, som hver kan påvirke minnekravet, treningshastigheten og ytelsen til den finjusterte modellen:

- epoke – Antall passeringer som finjusteringsalgoritmen tar gjennom treningsdatasettet. Må være et heltall større enn 1. Standard er 5.

- learning_rate – Hastigheten som modellvektene oppdateres med etter å ha jobbet gjennom hver gruppe med treningseksempler. Må være en positiv float større enn 0. Standard er 1e-4.

- instruction_tuned – Om man skal instruere-trene modellen eller ikke. Må være '

True'eller'False'. Standard er 'False'. - per_device_train_batch_size – Batchstørrelsen per GPU-kjerne/CPU for trening. Må være et positivt heltall. Standard er 4.

- per_device_eval_batch_size – Batchstørrelsen per GPU-kjerne/CPU for evaluering. Må være et positivt heltall. Standard er 1.

- max_train_samples – For feilsøkingsformål eller raskere opplæring, avkort antall treningseksempler til denne verdien. Verdi -1 betyr å bruke alle treningsprøvene. Må være et positivt heltall eller -1. Standard er -1.

- max_val_samples – For feilsøkingsformål eller raskere opplæring, avkort antall valideringseksempler til denne verdien. Verdi -1 betyr å bruke alle valideringsprøvene. Må være et positivt heltall eller -1. Standard er -1.

- max_input_length – Maksimal total inndatasekvenslengde etter tokenisering. Sekvenser lengre enn dette vil bli avkortet. Hvis -1,

max_input_lengther satt til minimum 1024 og maksimal modelllengde definert av tokenizeren. Hvis satt til en positiv verdi,max_input_lengther satt til minimum av den angitte verdien ogmodel_max_lengthdefinert av tokenizeren. Må være et positivt heltall eller -1. Standard er -1. - validation_split_ratio – Hvis valideringskanalen er

none, forholdet mellom togvalideringsdeling fra togdataene må være mellom 0–1. Standard er 0.2. - train_data_split_seed – Hvis valideringsdata ikke er tilstede, fikser dette den tilfeldige oppdelingen av inndata treningsdata til trenings- og valideringsdata som brukes av algoritmen. Må være et heltall. Standard er 0.

- forbehandling_antall_arbeidere – Antall prosesser som skal brukes til forbehandling. Hvis

None, brukes hovedprosessen til forbehandling. Standard erNone. - lora_r – Lora R. Må være et positivt heltall. Standard er 8.

- lora_alpha – Lora Alpha. Må være et positivt heltall. Standard er 32

- lora_frafall – Lora Dropout. må være en positiv flyte mellom 0 og 1. Standard er 0.05.

- int8_kvantisering - Hvis

True, modellen er lastet med 8-bits presisjon for trening. Standard for 7B og 13B erFalse. Standard for 70B erTrue. - aktivere_fsdp - Hvis

True, opplæring bruker FSDP. Standard for 7B og 13B erTrue. Standard for 70B erFalse. Noter detint8_quantizationstøttes ikke med FSDP.

Forekomsttyper og kompatible hyperparametre

Minnekravet under finjustering kan variere basert på flere faktorer:

- Modell type – 7B-modellen har minst GPU-minnekrav og 70B har størst minnebehov

- Maks inngangslengde – En høyere verdi på inngangslengden fører til behandling av flere tokens om gangen og krever som sådan mer CUDA-minne

- Partistørrelse, Gruppestørrelse – En større batchstørrelse krever større CUDA-minne og krever derfor større instanstyper

- Int8 kvantisering – Hvis du bruker Int8 kvantisering, blir modellen lastet inn i lav presisjon og krever derfor mindre CUDA-minne

For å hjelpe deg i gang tilbyr vi et sett med kombinasjoner av forskjellige forekomsttyper, hyperparametre og modelltyper som kan finjusteres. Du kan velge en konfigurasjon i henhold til dine krav og tilgjengeligheten av forekomsttyper. Vi finjusterer alle tre modellene på en rekke innstillinger med tre epoker på et undersett av Dolly-datasettet med oppsummeringseksempler.

7B modell

Tabellen nedenfor oppsummerer finjusteringsalternativene på 7B-modellen.

| Forekomsttype | Maks inngang Len | Batchstørrelse per enhet | Int8 kvantisering | Aktiver FSDP | Tidsbruk (min) |

| ml.g4dn.12xlarge | 1024 | 8 | TRUE | FALSK | 166 |

| ml.g4dn.12xlarge | 2048 | 2 | TRUE | FALSK | 178 |

| ml.g4dn.12xlarge | 1024 | 4 | FALSK | TRUE | 120 |

| ml.g4dn.12xlarge | 2048 | 2 | FALSK | TRUE | 143 |

| ml.g5.2xlarge | 1024 | 4 | TRUE | FALSK | 61 |

| ml.g5.2xlarge | 2048 | 2 | TRUE | FALSK | 68 |

| ml.g5.2xlarge | 1024 | 4 | FALSK | TRUE | 43 |

| ml.g5.2xlarge | 2048 | 2 | FALSK | TRUE | 49 |

| ml.g5.4xlarge | 1024 | 4 | FALSK | TRUE | 39 |

| ml.g5.4xlarge | 2048 | 2 | FALSK | TRUE | 50 |

| ml.g5.12xlarge | 1024 | 16 | TRUE | FALSK | 57 |

| ml.g5.12xlarge | 2048 | 4 | TRUE | FALSK | 64 |

| ml.g5.12xlarge | 1024 | 4 | FALSK | TRUE | 26 |

| ml.g5.12xlarge | 2048 | 4 | FALSK | TRUE | 23 |

| ml.g5.48xlarge | 1024 | 16 | TRUE | FALSK | 59 |

| ml.g5.48xlarge | 2048 | 4 | TRUE | FALSK | 67 |

| ml.g5.48xlarge | 1024 | 8 | FALSK | TRUE | 22 |

| ml.g5.48xlarge | 2048 | 4 | FALSK | TRUE | 21 |

13B

Tabellen nedenfor oppsummerer finjusteringsalternativene på 13B-modellen.

| Forekomsttype | Maks inngang Len | Batchstørrelse per enhet | Int8 kvantisering | Aktiver FSDP | Tidsbruk (min) |

| ml.g4dn.12xlarge | 1024 | 4 | TRUE | FALSK | 283 |

| ml.g4dn.12xlarge | 2048 | 2 | TRUE | FALSK | 328 |

| ml.g5.12xlarge | 1024 | 8 | TRUE | FALSK | 92 |

| ml.g5.12xlarge | 2048 | 4 | TRUE | FALSK | 104 |

| ml.g5.48xlarge | 1024 | 8 | TRUE | FALSK | 95 |

| ml.g5.48xlarge | 2048 | 4 | TRUE | FALSK | 107 |

| ml.g5.48xlarge | 1024 | 8 | FALSK | TRUE | 35 |

| ml.g5.48xlarge | 2048 | 2 | FALSK | TRUE | 41 |

70B

Tabellen nedenfor oppsummerer finjusteringsalternativene på 70B-modellen.

| Forekomsttype | Maks inngang Len | Batchstørrelse per enhet | Int8 kvantisering | Aktiver FSDP | Tidsbruk (min) |

| ml.g5.48xlarge | 1024 | 4 | TRUE | FALSK | 396 |

| ml.g5.48xlarge | 2048 | 1 | TRUE | FALSK | 454 |

Anbefalinger om instanstyper og hyperparametere

Når du finjusterer modellens nøyaktighet, husk følgende:

- Større modeller som 70B gir bedre ytelse enn 7B

- Ytelse uten Int8-kvantisering er bedre enn ytelse med INT8-kvantisering

Legg merke til følgende krav til treningstid og CUDA-minne:

- Stille

int8_quantization=Truereduserer hukommelseskravet og fører til raskere trening. - Avtagende

per_device_train_batch_sizeogmax_input_lengthreduserer minnekravet og kan derfor kjøres på mindre forekomster. Innstilling av svært lave verdier kan imidlertid øke treningstiden. - Hvis du ikke bruker Int8 kvantisering (

int8_quantization=False), bruk FSDP (enable_fsdp=True) for raskere og effektiv trening.

Når du velger forekomsttype, bør du vurdere følgende:

- G5-forekomster gir den mest effektive opplæringen blant forekomsttypene som støttes. Derfor, hvis du har G5-forekomster tilgjengelig, bør du bruke dem.

- Treningstiden avhenger i stor grad av mengden av antall GPUer og CUDA-minnet som er tilgjengelig. Derfor er opplæring på instanser med samme antall GPUer (for eksempel ml.g5.2xlarge og ml.g5.4xlarge) omtrent det samme. Derfor kan du bruke den billigere instansen til trening (ml.g5.2xlarge).

- Når du bruker p3-forekomster, vil trening bli utført med 32-biters presisjon fordi bfloat16 ikke støttes på disse forekomstene. Derfor vil treningsjobben forbruke dobbelt så mye CUDA-minne når man trener på p3-instanser sammenlignet med g5-instanser.

For å lære om kostnadene for opplæring per forekomst, se Amazon EC2 G5-forekomster.

Hvis datasettet er i format for instruksjonsinnstilling og inndata+fullføringssekvensene er små (som 50–100 ord), vil en høy verdi på max_input_length fører til svært dårlig ytelse. Standardverdien for denne parameteren er -1, som tilsvarer max_input_length av 2048 for Llama-modeller. Derfor anbefaler vi at hvis datasettet ditt inneholder små prøver, bruker du en liten verdi for max_input_length (for eksempel 200–400).

Til slutt, på grunn av stor etterspørsel etter G5-forekomstene, kan du oppleve utilgjengelighet for disse forekomstene i din region med feilen “CapacityError: Unable to provision requested ML compute capacity. Please retry using a different ML instance type.” Hvis du opplever denne feilen, prøv treningsjobben på nytt eller prøv en annen region.

Problemer ved finjustering av veldig store modeller

I denne delen diskuterer vi to forhold ved finjustering av veldig store modeller.

Deaktiver utdatakomprimering

Som standard er utdataene fra en treningsjobb en opplært modell som er komprimert i et .tar.gz-format før den lastes opp til Amazon S3. Men på grunn av modellens store størrelse kan dette trinnet ta lang tid. For eksempel kan komprimering og opplasting av 70B-modellen ta mer enn 4 timer. For å unngå dette problemet kan du bruke funksjonen deaktiver utdatakomprimering som støttes av SageMaker-treningsplattformen. I dette tilfellet blir modellen lastet opp uten komprimering, som brukes videre for distribusjon:

SageMaker Studio-kjernens tidsavbruddsproblem

På grunn av størrelsen på Llama 70B-modellen kan treningsjobben ta flere timer og SageMaker Studio-kjernen kan dø i løpet av treningsfasen. Men i løpet av denne tiden kjører det fortsatt trening i SageMaker. Hvis dette skjer, kan du fortsatt distribuere endepunktet ved å bruke opplæringsjobbnavnet med følgende kode:

For å finne treningsjobbnavnet, naviger til SageMaker-konsollen og under Kurs Velg navigasjonsruten Treningsjobber. Identifiser treningsjobbnavnet og bytt det ut i den foregående koden.

konklusjonen

I dette innlegget diskuterte vi finjustering av Metas Llama 2-modeller ved å bruke SageMaker JumpStart. Vi viste at du kan bruke SageMaker JumpStart-konsollen i SageMaker Studio eller SageMaker Python SDK for å finjustere og distribuere disse modellene. Vi diskuterte også finjusteringsteknikken, forekomsttyper og støttede hyperparametre. I tillegg skisserte vi anbefalinger for optimalisert trening basert på ulike tester vi gjennomførte. Resultatene for finjustering av de tre modellene over to datasett er vist i vedlegget på slutten av dette innlegget. Som vi kan se fra disse resultatene, forbedrer finjustering oppsummeringen sammenlignet med ikke-finjusterte modeller. Som et neste trinn kan du prøve å finjustere disse modellene på ditt eget datasett ved å bruke koden gitt i GitHub-depotet for å teste og benchmarke resultatene for brukstilfellene dine.

Forfatterne vil gjerne anerkjenne de tekniske bidragene fra Christopher Whitten, Xin Huang, Kyle Ulrich, Sifei Li, Amy You, Adam Kozdrowicz, Evan Kravitz, Benjamin Crabtree, Haotian An, Manan Shah, Tony Cruz, Ernev Sharma, Jonathan Guinegagne og June Vant.

Om forfatterne

Dr. Vivek Madan er en Applied Scientist med Amazon SageMaker JumpStart-teamet. Han fikk sin doktorgrad fra University of Illinois i Urbana-Champaign og var postdoktor ved Georgia Tech. Han er en aktiv forsker innen maskinlæring og algoritmedesign og har publisert artikler på EMNLP-, ICLR-, COLT-, FOCS- og SODA-konferanser.

Dr. Vivek Madan er en Applied Scientist med Amazon SageMaker JumpStart-teamet. Han fikk sin doktorgrad fra University of Illinois i Urbana-Champaign og var postdoktor ved Georgia Tech. Han er en aktiv forsker innen maskinlæring og algoritmedesign og har publisert artikler på EMNLP-, ICLR-, COLT-, FOCS- og SODA-konferanser.

Dr. Farooq Sabir er senior spesialistløsningsarkitekt for kunstig intelligens og maskinlæring ved AWS. Han har PhD- og MS-grader i elektroteknikk fra University of Texas i Austin og en MS i informatikk fra Georgia Institute of Technology. Han har over 15 års arbeidserfaring og liker også å undervise og veilede studenter. Hos AWS hjelper han kunder med å formulere og løse forretningsproblemer innen datavitenskap, maskinlæring, datasyn, kunstig intelligens, numerisk optimalisering og relaterte domener. Basert i Dallas, Texas, elsker han og familien å reise og dra på lange bilturer.

Dr. Farooq Sabir er senior spesialistløsningsarkitekt for kunstig intelligens og maskinlæring ved AWS. Han har PhD- og MS-grader i elektroteknikk fra University of Texas i Austin og en MS i informatikk fra Georgia Institute of Technology. Han har over 15 års arbeidserfaring og liker også å undervise og veilede studenter. Hos AWS hjelper han kunder med å formulere og løse forretningsproblemer innen datavitenskap, maskinlæring, datasyn, kunstig intelligens, numerisk optimalisering og relaterte domener. Basert i Dallas, Texas, elsker han og familien å reise og dra på lange bilturer.

Dr. Ashish Khetan er en Senior Applied Scientist med Amazon SageMaker JumpStart og hjelper til med å utvikle maskinlæringsalgoritmer. Han fikk sin doktorgrad fra University of Illinois Urbana-Champaign. Han er en aktiv forsker innen maskinlæring og statistisk inferens, og har publisert mange artikler på NeurIPS, ICML, ICLR, JMLR, ACL og EMNLP-konferanser.

Dr. Ashish Khetan er en Senior Applied Scientist med Amazon SageMaker JumpStart og hjelper til med å utvikle maskinlæringsalgoritmer. Han fikk sin doktorgrad fra University of Illinois Urbana-Champaign. Han er en aktiv forsker innen maskinlæring og statistisk inferens, og har publisert mange artikler på NeurIPS, ICML, ICLR, JMLR, ACL og EMNLP-konferanser.

Vedlegg

Dette vedlegget gir tilleggsinformasjon om ytelsesbenchmarking og datasettformatering.

Ytelsesbenchmarking

I denne delen gir vi resultater for finjustering av de tre Llama 2-modellene (7B, 13B og 70B) på to forskjellige datasett: Dolly og Dialogsum. For Dolly-datasettet er vår oppgave å oppsummere et avsnitt med tekst, mens for Dialogsum finjusterer vi modellen for å oppsummere en diskusjon mellom to personer. I de følgende tabellene viser vi input til modellen (spørsmål og instruksjoner), grunnsannhet (oppsummering), respons fra den ferdigtrente Llama 2-modellen og respons fra den finjusterte Llama 2-modellen for hver av de tre Llamaene 2 modeller. Vi viser slutningsresultater for fem datapunkter. Du kan legge merke til fra følgende tabeller at sammendragene forbedres for begge datasettene når vi finjusterer modellene.

- Resultater for finjustering av Llama 2 7B-tekstgenereringsmodellen på Dolly-datasettet:

| Innganger | Bakkenes sannhet | Svar fra Non-Fine-Tuned Model | Svar fra Fine-Tuned Model |

| Nedenfor er en instruksjon som beskriver en oppgave, sammen med et input som gir videre kontekst. Skriv et svar som fullfører forespørselen på riktig måte.nn### Instruksjon:nHvor er Allauchnn### Inndata:nAllauch (fransk uttale: ; Oksitansk: Alaug) er en fransk kommune som ligger øst for Marseille i departementet Bouches-du-Rhône i Provence-Alpes-Côte d'Azur-regionen i Frankrike.nnInnbyggerne i kommunen er kjent som Allaudiens eller Allaudiennes på fransk.nnnn### Svar:n | Allauch er en fransk kommune som ligger øst for Marseille i departementet Bouches-du-Rhône i Provence-Alpes-Côte d'Azur-regionen i Frankrike.nnInnbyggerne i kommunen er kjent som Allaudiens eller Allaudiennes på fransk. | Allauch er en by som ligger 28 km øst for Marseille i departementet Bouches-du-Rhône i regionen Provence-Alpes-Côte d'Azur i Frankrike. Det regnes for å være en av de vakreste landsbyene i Frankrike. Byen er omgitt av åser og vingårder og har en befolkning på rundt 6,000 mennesker. Den ble først nevnt i 1006 og har en rik | Kommunen ligger på et steinete platå kalt Massif du Gélas, som ligger øst for Marseille. Den har en vakker utsikt over Marseille og kystlinjen. Allauch er nå en velutviklet kommune med eget rådhus og en rekke butikker, barer og restauranter. På grunn av sin beliggenhet mellom Marseille og Alpilles, har den beholdt mange naturtrekk i området, inkludert Glandes-massivet, også kjent som "W |

| Nedenfor er en instruksjon som beskriver en oppgave, sammen med et input som gir videre kontekst. Skriv et svar som utfyller forespørselen på riktig måte.nn### Instruksjon:nHva er et eggleggende pattedyr?nn### Inndata:nNeddyret (Ornithorhynchus anatinus), noen ganger referert til som andnebbnebb, er et semakvatisk egg -leggende pattedyr endemisk til østlige Australia, inkludert Tasmania. Nebbdyret er den eneste levende representanten eller monotypiske taksonen for familien (Ornithorhynchidae) og slekten (Ornithorhynchus), selv om en rekke beslektede arter forekommer i fossilregisteret.nnnn### Svar:n | Duck-billed platypus er et eggleggende pattedyr som finnes i det østlige Australia. Det er den eneste levende representanten i slekten Ornithorhynchus. | nJeg gjorde en del research på spørsmålet ditt. Jeg leste all informasjonen du ga i andre avsnitt. Jeg har også lest litt om platypus, inkludert [denne siden](https://phys.org/news/2019-04-australia-platypus-predator-species.html). Jeg tror jeg fant noen svar på spørsmålet ditt. Spør du om nebbdyret er et eggleggende pattedyr eller om | Et pattedyr som legger egg, som et nebbdyr |

| Nedenfor er en instruksjon som beskriver en oppgave, sammen med et input som gir videre kontekst. Skriv et svar som utfyller forespørselen på riktig måte.nn### Instruksjon:nNår døde Felix Luna?nn### Innspill:nFélix César Luna (30. september 1925 – 5. november 2009) var en argentinsk forfatter, tekstforfatter og historiker.nnnn# ## Svar:n | Felix Luna døde 5. november 2009 | Félix César Luna (30. september 1925 – 5. november 2009) var en argentinernNår døde Luna?nnn### Forklaring:nVi svarer på spørsmålet med inndataens fødselsdato og dødsdatoen.nnn### Løsning: 1102n | Félix Luna døde 5. november 2009.nn |

| Nedenfor er en instruksjon som beskriver en oppgave, sammen med et input som gir videre kontekst. Skriv et svar som fullfører forespørselen på riktig måte.nn### Instruksjon:nSkriv ned noen viktige punkter om optisk illusjon fra den gitte passasjen.nn### Inngang:nI visuell persepsjon er en optisk illusjon (også kalt en visuell illusjon) en illusjon forårsaket av det visuelle systemet og preget av en visuell oppfatning som uten tvil ser ut til å skille seg fra virkeligheten. Illusjoner kommer i et bredt utvalg; deres kategorisering er vanskelig fordi den underliggende årsaken ofte ikke er klar, men en klassifisering foreslått av Richard Gregory er nyttig som en orientering. I følge det er det tre hovedklasser: fysiske, fysiologiske og kognitive illusjoner, og i hver klasse er det fire typer: nTvetydigheter, forvrengninger, paradokser og fiksjoner. Et klassisk eksempel på en fysisk forvrengning er den tilsynelatende bøyningen av en pinne halvt nedsenket i vann; et eksempel på et fysiologisk paradoks er ikke ettervirkningen av bevegelse (hvor, til tross for bevegelse, posisjon forblir uendret). Et eksempel på anfysiologisk fiksjon er et etterbilde. Tre typiske kognitive forvrengninger er Ponzo-, Poggendorff- og Müller-Lyer-illusjonen. Fysiske illusjoner er forårsaket av det fysiske miljøet, f.eks. av vannets optiske egenskaper. Fysiologiske illusjoner oppstår i øyet eller synsveien, f.eks. fra effekten av overdreven stimulering av en spesifikk reseptortype. Kognitive visuelle illusjoner er et resultat av ubevisste slutninger og er kanskje de mest kjente.nnnn### Response:n | 1. Visuell illusjon er forårsaket av det visuelle systemet og preget av en visuell oppfatning som ikke ser ut til å være forskjellig fra virkeligheten.n2. I følge Richard Gregory er en klassifisering foreslått av ham nyttig som en orientering om at det er tre hovedklasser: fysiske, fysiologiske og kognitive illusjoner, og i hver klasse er det fire typer: Tvetydigheter, forvrengninger, paradokser og fiksjoner.n3. Et eksempel på en fysisk forvrengning vil være den tilsynelatende bøyningen av en pinne som er halvt nedsenket i vann; et eksempel på et fysiologisk paradoks er bevegelsens ettervirkning (hvor, til tross for bevegelse, posisjon forblir uendret). n4. Et eksempel på en fysiologisk fiksjon er et etterbilde5. Tre kognitive forvrengninger er Ponzo-, Poggendorff- og Müller-Lyer-illusjonen.n6. Fysiske illusjoner er forårsaket av det fysiske miljøet, for eksempel av de optiske egenskapene til vannet. Fysiologiske illusjoner oppstår i øyet eller synsveien.n7. Den mest kjente illusjonen er visuelle illusjoner som er et resultat av ubevisste slutninger. | Den optiske illusjonen nevnt i avsnittet er den illusjonære bevegelsen til pinnen som er delvis stupet i vann.nn## 50.n### Instruksjon:nSkriv et argument for å støtte eller tilbakevise påstanden:nAlle studentene i laboratoriet vår har samme gjennomsnittlige IQ.nn### Inndata:nMange elever i eksperimentet har samme gjennomsnittlige IQ, og jeg tror at de er de 10 % med høyestn | nOptiske illusjoner gjør bruk av de fysiologiske og psykologiske begrensningene knyttet til måten vi tolker og reagerer på visuelle stimuli, både stimuli i verden rundt oss og visuelle stimuli produsert internt. De gir en felles stimulans til de to systemene (fysisk og psykologisk/perseptuell) som lar oss sammenligne begge, og forstå måten de fungerer på. Det finnes en rekke forskjellige former for optiske illusjoner, som inkluderer psykologiske, |

| Nedenfor er en instruksjon som beskriver en oppgave, sammen med et input som gir videre kontekst. Skriv et svar som utfyller forespørselen på riktig måte.nn### Instruksjon:nOppsummer innovatørens dilemma i noen få setningernn### Inndata:nDet beskriver hvordan store etablerte selskaper taper markedsandeler ved å lytte til kundene sine og gi det som ser ut til å være det høyeste -verdiprodukter, men nye selskaper som betjener lavverdikunder med dårlig utviklet teknologi kan forbedre teknologien trinnvis til den er god noknnnn### Response:n | The Innovator's Dilemma: When New Technologies Cause Great Firms to Fail, først publisert i 1997, er det mest kjente arbeidet til Harvard-professoren og forretningsmannen Clayton Christensen. Den utvider begrepet forstyrrende teknologier, et begrep han laget i en artikkel fra 1995 "Disruptive Technologies: Catching the Wave". Den beskriver hvordan store etablerte selskaper taper markedsandeler ved å lytte til kundene sine og tilby det som ser ut til å være de mest verdifulle produktene, men nye selskaper som betjener lavverdikunder med dårlig utviklet teknologi kan forbedre den teknologien gradvis til den er god nok til å raskt ta markedsandeler fra etablert virksomhet. Christensen anbefaler at store selskaper opprettholder små, kvikke divisjoner som forsøker å gjenskape dette fenomenet internt for å unngå å bli blindet og forbigått av startup-konkurrenter. | Hei, n beklager sent svar!! Jeg var på ferie den siste uken :)nnThe Innovator's Dilemma av Clayton Christensen forklarer at "innovatørens dilemma er at et selskaps jakt på vedvarende fortjeneste ved å introdusere eller forbedre produktene sine for å gi mer verdi til eksisterende kunder vil resultere i at de samme kundene forlater selskap for å kjøpe innovasjoner som gir minst en viss verdi | The Innovator's Dilemma er en bok som forklarer hvordan store etablerte selskaper taper markedsandeler ved å lytte til kundene sine og tilby det som ser ut til å være de mest verdifulle produktene, men nye selskaper som betjener lavverdikunder med dårlig utviklet teknologi kan forbedre denne teknologien gradvis. til det er godt nok nn |

- Resultater for finjustering av Llama 2 13B-tekstgenereringsmodellen på Dolly-datasettet:

| Innganger | Bakkenes sannhet | Svar fra Non-Fine-Tuned Model | Svar fra Fine-Tuned Model |

| Nedenfor er en instruksjon som beskriver en oppgave, sammen med et input som gir videre kontekst. Skriv et svar som utfyller forespørselen på riktig måte.nn### Instruksjon:nHvem er den neste treneren i FC Bayern München som tar over etter Julian Nagelsmann?nn### Innspill:nNagelsmann-tiden (2021–2023)nUnder den nye treneren Julian Nagelsmann, Bayern har fullført bragden med å vinne 10 Bundesliga-titler på rad etter en 3–1-seier i Der Klassiker. Laget tapte imidlertid uventet mot Villarreal i Champions League-kvartfinalen, og gikk ut på det stadiet for andre år på rad. Den 24. mars 2023 ble Nagelsmann løslatt av Bayern og erstattet av Thomas Tuchel, som fikk en kontrakt til 30. juni 2025.nnnn### Svar:n | Thomas Tuchel erstattet Julian Nagelsmann i mars 2023 og er nå ny trener i FC Bayern München, og var tidligere trener i Chelsea. | nn“`pythonn{n “instruction”: “Hvem er den neste treneren i FC Bayern München som tar over etter Julian Nagelsmann?”, n “action”: “neste trener for FC Bayern”, n “context”:{n “ Nagelsmann-æra (2021–2023)”: n ” Under den nye treneren Julian Nagelsmann har Bayern fullført bragden med å vinne 10 påfølgende Bundesliga-titler | Neste trener i FC Bayern München blir Thomas Tuchel. Tuchel tar over etter Julian Nagelsmann ved Nagelsmanns avgang fra laget 24. mars 2023.nn |

| Nedenfor er en instruksjon som beskriver en oppgave, sammen med et input som gir videre kontekst. Skriv et svar som utfyller forespørselen på riktig måte.nn### Instruksjon:nFortell meg om livet til Adolphe Cohnnn### Inngang:nAdolphe Cohn (29. mai 1851–1930) var en fransk-amerikansk pedagog, født i Paris. Han ble uteksaminert "bachelier ès lettres" fra University of Paris i 1868, og studerte juss, historisk kritikk og filologi ved forskjellige institusjoner for høyere læring i Paris, og fikk gradene LL.B. i 1873. En elev ved École des Chartes, hans avhandling ble kalt Vues sur l'histoire de l'organisation judiciaire en France du IXe au XIIIe siècle considérée au point de vue des juridictions extraordinaires og han fikk diplomet "archiviste paléographe" i 1874. Ved begynnelsen av den fransk-prøyssiske krigen i 1870 vervet han seg og tjenestegjorde i den franske hæren under hele kampen. République française, deretter redigert av Léon Gambetta, som han hadde kjent i Frankrike, og hvis politiske synspunkter han hadde adoptert. I mars 13 ble Cohn utnevnt til lærer i fransk ved Columbia College, og kort tid etter ble han instruktør. Ved en populær avstemning blant de franske innbyggerne i New York ble han valgt til å holde begravelsestalen på Gambetta i 1875 i Tammany Hall, og i 1876 ble han tilkalt fra Cambridge, Massachusetts, for et lignende formål, etter Victor Hugos død.nnnn ### Svar:n | Adolphe Cohn (29. mai 1851 – 1930) var en fransk-amerikansk pedagog, født i Paris. Han ble uteksaminert "bachelier es lettres" fra University of Paris i 1868, og studerte juss, historisk kritikk og filologi ved forskjellige institusjoner for høyere læring i Paris, og fikk gradene LL.B. i 1873. nnEn elev ved École des Chartes, avhandlingen hans ble kalt Vues sur l'histoire de l'organisation judiciaire en France du IXe au XIIIe siècle considérée au point de vue des juridictions extraordinaires, og han fikk diplomet "archiviste paléographe" i 1874. Ved begynnelsen av den fransk-prøyssiske krigen i 1870 vervet han seg og tjenestegjorde i den franske hæren under hele kampen. République française, deretter redigert av Léon Gambetta, som han hadde kjent i Frankrike, og hvis politiske synspunkter han hadde adoptert. I mars 13 ble Cohn utnevnt til lærer i fransk ved Columbia College, og kort tid etter ble han instruktør. Ved en populær avstemning fra de franske innbyggerne i New York ble han valgt til å holde begravelsestalen på Gambetta i 1875 i Tammany Hall, og i 1876 ble han kalt fra Cambridge, Massachusetts, for et lignende formål, etter Victor Hugos død. | nAdolphe Cohn (29. mai 1851–1930) var en fransk-amerikansk pedagog, født i Paris. Han ble uteksaminert "bachelier ès lettres" fra University of Paris i 1868, og studerte juss, historisk kritikk og filologi ved forskjellige institusjoner for høyere læring i Paris, og fikk gradene LL.B. i 1873. En elev av É | Adolphe Cohn var en fransk-amerikansk pedagog som ble født i Paris 29. mai 1851. Han gikk på universitetet i Paris og tok jusgrad i 1873. Han jobbet også ved École des Chartes og oppnådde sin "archiviste paléographe"-grad i 1874. Ved starten av den fransk-prøyssiske krigen sluttet han seg til den franske hæren og tjente dem for hele |

| Nedenfor er en instruksjon som beskriver en oppgave, sammen med et input som gir videre kontekst. Skriv et svar som utfyller forespørselen på riktig måte.nn### Instruksjon:nHvordan har McDonald's-målgruppen endret seg over tid?nn### Input:nGastmatrestauranter retter ofte noe av reklamen direkte mot ungdomsbefolkningen. McDonald's Happy Meals, som inkluderer et leketøy ofte knyttet sammen med en nylig utgitt familiefilm, er et viktig eksempel. Ronald McDonald, en klovne-reklamemaskot introdusert i 1963 og designet for å appellere til små barn, er en annen. I tillegg innlemmet McDonald's i 1987 et lekested i restaurantene sine for å annonsere ytterligere for barn, noe som gjorde restaurantene deres til et mer attraktivt miljø for barn. I tillegg, fra 1996 til 2006, var Disney en eksklusiv partner med McDonald's, og koblet produktene deres sammen. De kunngjorde slutten av denne avtalen i mai 2006, med noen rapporter som sa at Disney var bekymret for fedme hos barn. Annet enn Disney, har McDonald's også vært inngått samarbeid med Nintendo siden 1985, da Nintendo Entertainment System ble introdusert for første gang. I 1987 opprettet McDonald's også et Nintendo-lekeland i restaurantene deres hvor barna kunne leke på Nintendo-konsoller mens de ventet på maten. I løpet av 2007 begynte McDonald's å tilby WiFi fra Nintendo-konsollene; gi barna muligheten til å leke hvor enn de er. Med også en målgruppe av barn som gir ut disse nye filmene og inkorporerer leker, bruker den barna til å nå ut til foreldrenes lommer på grunn av deres store investering.nnnn### Response:n | McDonald's har konsekvent rettet sin reklame direkte mot ungdomsbefolkningen.nnFra 1963 introduserte de Ronald McDonald, en klovne-reklamemaskot designet for å appellere til små barn. Gjennom årene har McDonald's samarbeidet med flere selskaper som har produkter rettet mot barn, som Nintendo og Disney. | Hurtigmatrestauranter har alltid rettet seg mot ungdomsbefolkningen. Glade måltider er også en stor faktor når det kommer til reklame for ungdom.nSom mange filmer blir lansert kommer Happy Meals også med et leketøy for å promotere den filmen i din lokale McDonald'snn—n## 400-999nn### Kommentar:nAs et ungt selskap med en relativt snever visjon av verden, McDonald's gjorde det | Siden lanseringen har McDonald's rettet sitt publikum mot små barn og tenåringer med sine barneorienterte gatekjøkkenrestauranter og matprodukter, samt reklame, som i stor grad har rettet seg mot ungdom. Mens barna blir kjørt til McDonalds av foreldrene sine, er restauranten i hovedsak en foreldreannonse for barna deres: McDonalds appellerer til barn med sine fargerike restauranter og leker i maten som appellerer til |

| Nedenfor er en instruksjon som beskriver en oppgave, sammen med et input som gir videre kontekst. Skriv et svar som fullfører forespørselen på riktig måte.nn### Instruksjon:nHva er Anandapuram mandalnn### Input:nAnandapuram mandal er en av de 46 mandalene i Visakhapatnam-distriktet i den indiske delstaten Andhra Pradesh. Det er under administrasjon av Visakhapatnam inntektsdivisjon og hovedkvarteret ligger i Anandapuram. Anandapuram mandal er avgrenset av Bheemunipatnam mandal i øst, Chinagadila i sør, Padmanabham i nord og Kothavalasa i vest.nnnn### Response:n | Anandapuram mandal er en av de 46 mandalene i Visakhapatnam-distriktet i den indiske delstaten Andhra Pradesh. Det er under administrasjon av Visakhapatnam inntektsdivisjon og hovedkvarteret ligger i Anandapuram. | nnnn | Anandapuram mandal er en av de 46 mandalene i Visakhapatnam-distriktet i den indiske delstaten Andhra Pradesh. Det er under administrasjon av Visakhapatnam inntektsdivisjon og hovedkvarteret ligger i Anandapuram. Anandapuram mandal er avgrenset av Bheemunipatnam mandal i øst, Chinagadila i sør, Padmanabham i nord og Koth |

| Nedenfor er en instruksjon som beskriver en oppgave, sammen med et input som gir videre kontekst. Skriv et svar som på riktig måte utfyller forespørselen.nn### Instruksjon:nHva skjedde i Woodstocknn### Input:nWoodstock Music and Art Fair, ofte referert til som Woodstock, var en musikkfestival som ble holdt i løpet av 15.–18. august 1969, den Max Yasgurs melkegård i Bethel, New York, USA, 40 km sørvest for byen Woodstock. Beregnet som "an Aquarian Exposition: 65 Days of Peace & Music" og alternativt referert til som Woodstock Rock Festival, trakk den et publikum på mer enn 3 400,000 deltakere. Trettito handlinger utført utendørs til tross for sporadisk regn. Det var en av historiens største musikkfestivaler.nnFestivalen har blitt ansett som et sentralt øyeblikk i populærmusikkhistorien, så vel som en avgjørende begivenhet for motkulturgenerasjonen. Begivenhetens betydning ble forsterket av en dokumentarfilm fra 1970, et tilhørende lydsporalbum og en sang skrevet av Joni Mitchell som ble en stor hit for både Crosby, Stills, Nash & Young og Matthews Southern Comfort. Musikalske begivenheter som bar Woodstock-navnet ble planlagt for jubileer, som inkluderte den tiende, tjuende, tjuefemte, trettiende, førtiende og femtiende. I 2004 listet magasinet Rolling Stone det som nummer 19 av de 50 øyeblikkene som endret historien til rock and roll. I 2017 ble festivalplassen oppført i National Register of Historic Places.nnnn### Response:n | Woodstock Music and Art Fair, ofte referert til som Woodstock, var en musikkfestival som ble holdt i løpet av 15.–18. august 1969, på Max Yasgurs melkegård i Bethel, New York, USA, 40 km sørvest for byen av Woodstock. Beregnet som "an Aquarian Exposition: 65 Days of Peace & Music" og alternativt referert til som Woodstock Rock Festival, trakk den et publikum på mer enn 3 400,000 deltakere. Trettito handlinger utført utendørs til tross for sporadisk regn. Det var en av historiens største musikkfestivaler.nnFestivalen har blitt ansett som et sentralt øyeblikk i populærmusikkhistorien, så vel som en avgjørende begivenhet for motkulturgenerasjonen. Begivenhetens betydning ble forsterket av en dokumentarfilm fra 1970, et tilhørende lydsporalbum og en sang skrevet av Joni Mitchell som ble en stor hit for både Crosby, Stills, Nash & Young og Matthews Southern Comfort. Musikalske begivenheter som bar Woodstock-navnet ble planlagt for jubileer, som inkluderte den tiende, tjuende, tjuefemte, trettiende, førtiende og femtiende. I 2004 listet magasinet Rolling Stone det som nummer 19 av de 50 øyeblikkene som endret historien til rock and roll. I 2017 ble festivalplassen oppført i National Register of Historic Places. | nAnswer:nn“`jsndocument.getElementById('_0x1000').innerHTML = “https://commons.wikimedia.org/wiki/File:BethelMeetingHouse.JPG#/media/File:BethelMeetingHouse.JPG”;nn“`nn nn## Løsning:nn n For å se løsning nn“`jsnn// Løsning kreves | Woodstock Music and Art Fair holdt i siste del av august 15–18, var en historisk begivenhet i Bethel, New York av motkulturgenerasjonen. Publikum på festivalen var mer enn 400,000 32 til stede. Omtrent XNUMX handlinger utført utendørs til tross for sporadisk regn. Det ble sett på som en av de største musikkfestivalene som noen gang hadde vært i historien.nn |

- Resultater for finjustering av Llama 2 70B-tekstgenereringsmodellen på Dolly-datasettet:

| Innganger | Bakkenes sannhet | Svar fra Non-Fine-Tuned Model | Svar fra Fine-Tuned Model |

| Nedenfor er en instruksjon som beskriver en oppgave, sammen med et input som gir videre kontekst. Skriv et svar som utfyller forespørselen på riktig måte.nn### Instruksjon:nHvem er selskapet ABBnn### Input:nABB Ltd. er et svensk-sveitsisk multinasjonalt selskap med hovedkontor i Zürich, Sveits. Selskapet ble dannet i 1988 da Sveriges Allmänna Svenska Elektriska Aktiebolaget (ASEA) og Sveits Brown, Boveri & Cie fusjonerte for å skape ASEA Brown Boveri, senere forenklet til initialene ABB. Begge selskapene ble etablert på slutten av 1800-tallet og var store produsenter av elektrisk utstyr, en virksomhet som ABB fortsatt er aktiv i i dag. Selskapet har også siden utvidet til robotikk og automasjonsteknologi.nnnn### Response:n | ABB Ltd. er et svensk-sveitsisk multinasjonalt selskap med hovedkontor i Zürich, Sveits. Selskapet ble dannet i 1988 da Sveriges Allmanna Svenska Elektriska Aktiebolaget (ASEA) og Sveits Brown, Boveri & Cie fusjonerte for å skape ASEA Brown Boveri, senere forenklet til initialene ABB. nnBegge selskaper ble etablert på slutten av 1800-tallet og var store produsenter av elektrisk utstyr, en virksomhet som ABB fortsatt er aktiv i i dag. Selskapet har også siden utvidet til robotikk og automasjonsteknologi. | * ABB er et svensk-sveitsisk multinasjonalt selskapnn### LoggnEND I/O DATA —n | ABB er et svensk-sveitsisk multinasjonalt selskap med hovedkontor i Zürich, Sveits. Selskapet ble dannet i 1988 da Sveriges Allmänna Svenska Elektriska Aktiebolaget (ASEA) og Sveits Brown, Boveri & Cie fusjonerte for å skape ASEA Brown Boveri, senere forenklet til initialene ABB. Begge selskapene ble etablert på slutten av 1800-tallet og ble det |

| Nedenfor er en instruksjon som beskriver en oppgave, sammen med et input som gir videre kontekst. Skriv et svar som på riktig måte utfyller forespørselen.nn### Instruksjon:nHvorfor ble en Vilhelm Erobreren, en franskmann, kongen av England?nn### Inngang:nPå 1050-tallet og begynnelsen av 1060-tallet ble William en kandidat for Englands trone holdt av den barnløse Edward Bekjenneren, hans første fetter en gang fjernet. Det var andre potensielle fordringshavere, inkludert den mektige engelske jarlen Harold Godwinson, som Edward utpekte som konge på dødsleie i januar 1066. Ved å argumentere for at Edward tidligere hadde lovet tronen til ham og at Harold hadde sverget å støtte kravet sitt, bygde William en stor flåten og invaderte England i september 1066. Han beseiret og drepte Harold avgjørende i slaget ved Hastings 14. oktober 1066. Etter ytterligere militær innsats ble William kronet til konge 1066. juledag 1067 i London. Han gjorde ordninger for styringen av England tidlig i 1075 før han returnerte til Normandie. Flere mislykkede opprør fulgte, men Williams grep var stort sett sikret på England innen XNUMX, slik at han kunne tilbringe størstedelen av sin regjeringstid på det kontinentale Europa.nnnn### Svar:n | Vilhelm Erobreren var fra Normandie, som ligger nordvest i Frankrike. Kongen av England på slutten av 1050-tallet og begynnelsen av 1060-tallet var Edward the Confessor. Edward var Williams fetter. Siden Edward var barnløs, var det flere mennesker som hevdet at de var den rettmessige arvingen og burde bli konge. Disse motstridende påstandene ga opphav til væpnet konflikt. William invaderte England, hvor han vant slaget ved Hastings og beseiret jarl Harold Godwinson. En rekke slag fulgte, men Vilhelm ble konge av England sent i 1066. Han håndterte flere opprør i løpet av det neste tiåret, men beholdt makten. Til slutt var han i stand til å returnere til Normandie og styre England derfra. | Vilhelm Erobreren ble konge av England som på 1050- og begynnelsen av 1060-tallet ble han en utfordrer til Englands trone som ble holdt av den barnløse Edvard Bekjenneren, hans første fetter en gang fjernet.nnnSvar kan være tom, men må passe innenfor 256 tegn. n | Etter kong Harolds død i slaget ved Hastings i 14. oktober 1066, ble Vilhelm Erobreren kronet til kongen av England på juledag 1066, og etablerte den normanniske erobringen av England.nn |

| Nedenfor er en instruksjon som beskriver en oppgave, sammen med et input som gir videre kontekst. Skriv et svar som utfyller forespørselen på riktig måte.nn### Instruksjon:nFortell meg om RMS Adriaticnn### Input:nRMS Adriatic var en britisk havlinje fra White Star Line. Hun var den fjerde av en kvartett av skip på mer enn 20,000 1911 BRT, kalt The Big Four. Skipet var det eneste av de fire som aldri var verdens største skip. Hun var imidlertid den største, raskeste og mest luksuriøse av de fire store, og var den første havbåten som hadde et innendørs svømmebasseng og et tyrkisk bad.nnHun begynte sin karriere på den splitter nye ruten fra Southampton til New York før fra 1917 ble hun med søsterskipene hennes på sekundærruten fra Liverpool. De var faktisk langsomme rutefly som var ment å yte en tjeneste til moderate priser. Da første verdenskrig brøt ut, var Adriaterhavet blant skipene som fortsatte sin sivile transatlantiske tjeneste, mens de bar mange proviant. I 1930 ble hun rekvirert og tjenestegjort som troppetransport.nnEtter krigen ble hun ombygd flere ganger, og ble etter hvert brukt til cruise, som ble hennes hovedtjenester på 1934-tallet. Da Cunard Line og White Star Line slo seg sammen i 1935, ble hun raskt ansett som unødvendig og solgt på slutten av året. Hun ble skrotet i Osaka i XNUMX.nnnn### Svar:n | RMS Adriatic var en britisk havlinje fra White Star Line. Hun var den fjerde av en kvartett av skip på mer enn 20,000 XNUMX BRT, kalt The Big Four. Skipet var det eneste av de fire som aldri var verdens største skip. Imidlertid var hun den største, den raskeste og den mest luksuriøse av de fire store, og var den første havbåten som hadde et innendørs svømmebasseng og et tyrkisk bad. | RMS Adriatic var en britisk havbåt fra White Star Line. Hun var den fjerde av en kvartett av skip på mer enn 20,000 XNUMX BRT, kalt The Big Four. Skipet var det eneste av de fire som aldri var verdens største skip. nn### KontekstnEt spørsmål av denne typen brukes ofte til å søke etter en søkemotor. Inndata er et input for spørringen, og svaret er offentlig | RMS Adriatic var en britisk havforing av den hvite stjernelinjen. Hun ble sjøsatt i 1906, men hennes første kommersielle seilas var i 1907. Hun var den fjerde av en kvartett av skip over 20,000 1901 tonn og kalte de fire store. De tre andre var RMS Celtic i 1903, RMS Baltic i XNUMX, og R |

| Nedenfor er en instruksjon som beskriver en oppgave, sammen med et input som gir videre kontekst. Skriv et svar som utfyller forespørselen på riktig måte.nn### Instruksjon:nHva er CGRO som oppdager fotoner?nn### Input:nCompton Gamma Ray Observatory (CGRO) var et romobservatorium som oppdaget fotoner med energier fra 20 keV til 30 GeV, i jordbane fra 1991 til 2000. Observatoriet inneholdt fire hovedteleskoper i ett romfartøy, som dekket røntgen- og gammastråler, inkludert forskjellige spesialiserte underinstrumenter og detektorer. Etter 14 års innsats ble observatoriet skutt opp fra romfergen Atlantis under STS-37 den 5. april 1991, og opererte frem til dets deorbit den 4. juni 2000. Det ble utplassert i lav jordbane på 450 km (280 mi) til unngå Van Allen-strålebeltet. Det var den tyngste astrofysiske nyttelasten som noen gang ble fløyet på den tiden på 17,000 37,000 kilo (XNUMX XNUMX lb).nnnn### Respons:n | CGRO er Compton Gamma Ray Observatory (CGRO) og var et romobservatorium som oppdaget fotoner med energier fra 20 keV til 30 GeV på jorden fra 1991 til 2000. | **Transkribering:** EGRET-instrumentet oppdager fotoner.nn | Compton Gamma Ray Observatory (CGRO) måler fotoner med energier fra 20 keV til 30 GeV.nn |

| Nedenfor er en instruksjon som beskriver en oppgave, sammen med et input som gir videre kontekst. Skriv et svar som på riktig måte utfyller forespørselen.nn### Instruksjon:nHvor god som pianist er Yeol Eum Sonnn### Inndata:nYeol Eum Son (født 2. mai 1986, i Wonju, Sør-Korea) er en sørkoreansk klassiker pianist. Hun vakte internasjonal oppmerksomhet for første gang i oktober 2004, da hun var 18 år gammel, da hun dukket opp som solist og fremførte Liszt Piano Concerto No. 1 med New York Philharmonic under stafettpinnen av Lorin Maazel på deres Asia-turné i Seoul, Daejeon og Tokyo. Son opptrådte igjen med Maazel og New York Philharmonic da de kom tilbake til Seoul Arts Center i februar 2008, denne gangen som solist for Beethoven Piano Concerto No. ) og 2 International Tchaikovsky Competition, hvor hun også mottok prisene for beste kammerkonsert og beste fremføring av bestillingsverk. Hun vant også bronsemedaljen ved Arthur Rubinstein International Piano Master Competition (2009) nnnn### Respons:n | Yeol Eum Son (født 2. mai 1986 i Wonju, Sør-Korea) er en sørkoreansk klassisk pianist. Hun vakte internasjonal oppmerksomhet for første gang i oktober 2004, da hun var 18 år gammel, da hun dukket opp som solist og fremførte Liszt Piano Concerto No. 1 med New York Philharmonic under stafettpinnen av Lorin Maazel på deres Asia-turné i Seoul, Daejeon og Tokyo. Son opptrådte igjen med Maazel og New York Philharmonic da de kom tilbake til Seoul Arts Center i februar 2008, denne gangen som solist for Beethoven Piano Concerto No. ) og 2 International Tchaikovsky Competition, hvor hun også mottok prisene for beste kammerkonsert og beste fremføring av bestillingsverk. Hun vant også bronsemedaljen ved Arthur Rubinstein International Piano Master Competition (2009) | Yeol Eum Son er en dyktig pianist, som har opptrådt med noen av verdens mest prestisjefylte orkestre. I 2009 vant hun sølv ved den trettende Van Cliburn International Piano Competition og i 2005 vant hun bronse ved Arthur Rubinstein International Piano Master Competition. Hun fortsetter å opptre med stor suksess over hele verden. | Yeol Eum Son er en veldig god pianist. Hun begynte sin internasjonale karriere med å bli med noen av de største musikerne i verden i en alder av 18. Og var allerede sølvmedaljevinner i to internasjonale konkurranser da hun fylte 25.nn |

- Resultater for finjustering av Llama 2 7B-tekstgenereringsmodellen på Dialogsum-datasettet:

| Innganger | Bakkenes sannhet | Svar fra Non-Fine-Tuned Model | Svar fra Fine-Tuned Model |

| Oppsummer denne dialogen:n#Person1#: Dette er et godt måltid!n#Person2#: Takk. Jeg er glad for at alt ble så bra.n#Person1#: Hvem har lært deg å lage dette godt?n#Person2#: Jeg tok en matlagingskurs på Culinary Institute.n#Person1#: Wow, hva er det i dette kyllingrett?n#Person2#: Er ikke det flott? Det er ingefærkylling med kokos med ris.n#Person1#: Er suppen en rekesuppe?n#Person2#: Ja, det er reker der sammen med sjøgrønnsaker og sitrongress.n#Person1#: Jeg tror jeg var heldig ved å velge en vin som passer sammen med dette måltidet.n#Person2#: Jeg setter pris på at du tar med vinen. Det passer godt til kyllingen.n—nSummary:nnn### Response:n | #Person1# synes måltidet tilberedt av #Person2# er flott. #Person2# introduserer ingrediensene til rettene. | Etter at dialogen er fullført, vil personen gi et passende svar på informasjonen som er samlet inn. For eksempel kan person 1 si,nn#Person1#: Dette er flott! Takk.nn#Person2#: Du er hjertelig velkommen. Jeg tenkte at du ville like måltidet ditt. Jeg er glad for at du likte det.nn—n— — — — –nnn### Sammendrag:nnn### Svar:nEtter dialogen | #Person1# og #Person2# spiser hos #Person2#. De snakker om maten og vinen som blander seg med kyllingen.nn |

| Oppsummer denne dialogen:n#Person1#: Unnskyld meg, jeg skriver et essay om antikkens Hellas. Er det noen bøker om dette emnet du kan anbefale?n#Person2#: Gjess? Vil du skrive om eldgamle gjess? Jeg har aldri hørt om noe slikt. Uansett, det ville vært med en bok med noen dyr, det er rad J. Eller du vil prøve vitenskap, det er i Row Gn#Person1#: Animals? Men Hellas er et land, ikke et dyr.n#Person2#: Å, Hellas. Vel, du vet, i dag må være din lykkedag. Vi har nettopp mottatt en ny samling bøker om akkurat det emnet. Det er forfattere her på rad Cn#Person1#: Jeg skjønner. Det er mange bøker, hva foreslår du?n#Person2#: Vel, den av Robin Smith er utmerket, men den er veldig lang. Det er den med statuen på omslaget. Det er også en av Milton Pike. Den har et maleri av en soldat på fronten. Som du ser er den ikke særlig tykk, så det bør ikke ta for lang tid å lese. Men sannsynligvis er den beste boken den med bildet av det gamle Olympiastadion. Den har vunnet flere historieverksbelønninger.n#Person1#: Vel, det er vanskelig å bestemme seg, men jeg er redd jeg ikke har nok tid til mye lesing. Jeg tror jeg får boka av Milton Pike.n#Person2#: OK. Kan jeg få lånekortet ditt?n#Person1#: Jada, her er du.n—nSummary:nnn### Respons:n | #Person1# ber #Person2# anbefale noen bøker om antikkens Hellas. #Person2# foreslår den av Robin Smith som er veldig lang, den av Milton Pike som ikke er veldig tykk, og den som vinner flere historieverksbelønninger. Siden #Person1# ikke har nok tid, får #Person1# boka av Milton Pike. | n—nnSammendrag:n | #Person1# skriver et essay om antikkens Hellas. #Person2# anbefaler bøkene om antikkens Hellas til #Person1#, som alle er nylig mottatt og foreslår å få boken av Milton Pike.nn |

| Oppsummer denne dialogen:n#Person1#: Vel, jeg ser at du har bøkene dine, George. Men leser du? Ser ut som du bare farger.n#Person2#: Jeg markerer de viktige delene av boken. Fargene er for forskjellige ting.n#Person1#: Som hva?n#Person2#: Hovedideene er gule. Viktige detaljer å huske er rosa og den lysegrønne er for vanskelige ideer.n#Person1#: Dette virker som mange aktiviteter. Kaster du ikke bort tiden din?n#Person2#: Jeg tror ikke det, mamma. Jeg skal lese alt i kveld. Jeg skal høre på den i morgen. Og når det er på tide å studere, vil jeg allerede vite det meste av informasjonen.n#Person1#: I min tid leste vi bare boken og prøvde å huske informasjonen.n#Person2#: Læreren fortalte oss viktigheten av aktiv lesing. Og det er den beste måten å lære på uansett hvilken hastighet du velger.n#Person1#: Jeg skjønner. Og hva er denne notatboken til?n#Person2#: Det er for å ta notater. Hva slags ting skriver du ned?n#Person1#: Noen ganger skriver jeg et sammendrag. På denne siden skriver jeg ned spørsmål. Og selvfølgelig har jeg en annen side hvor jeg skriver ned de nye ordene.n—nSummary:nnn### Response:n | George forteller moren sin at det å merke de viktige delene av boken i forskjellige farger er hans måte å lære på. Han tar også notater på notatboken og skriver noen ganger et sammendrag. | #Person1#: Åhhh! Aktiv lesing, lesespørsmål, vokabularnotater, sammendrag og fremheving. Jeg kan se nå hvilken forskjell du har når det gjelder å lære informasjon. Jeg er imponert.n#Person2#: Takk. Lesing er den beste måten å lære og huske ny informasjon. Bruker du aktiv lesing akkurat nå?n#Person1#: Hmmm….. Det må jeg tenke på.nnn#Person | George beskriver aktivitetene han gjør for å lese bøkene sine raskt. George viser notatboken til mamma og forklarer hvordan man tar notater.nn |

| Oppsummer denne dialogen:n#Person1#: God morgen, sir. Får jeg se passet ditt?n#Person2#: Ja, selvfølgelig. Her er den.n#Person1#: Takk. Er alle disse dine?n#Person2#: Nei, noen av dem er vennen min. Vil du ha passet hennes også?n#Person1#: Ja takk. Har du noe håndbagasje?n#Person2#: Vil du at jeg også skal ta det på beltet?n#Person1#: Ja, takk. Vil du være så snill å åpne denne store kofferten?n#Person2#: OK. Bare et øyeblikk. Det er bare noen klær og toalettsaker.n#Person1#: OK. Har du noe å erklære?n#Person2#: Jeg tror det ikke er noe.n#Person1#: All fersk mat, levende planter eller dyr?n#Person2#: Å nei. Ingenting av det.n#Person1#: Takk. Du kan låse kofferten din. Her er passene dine.n#Person2#: Tusen takk.n—nSummary:nnn### Svar:n | #Person1# ser passet til #Person2# og #Person2#s venn og sjekker bagasjen deres. #Person2# forteller #Person1# at de ikke har noe å erklære. #Person1# lar dem gå. | > Jeg tror det er ingenting.nnn—n**Kategorier:**nn- [Samtale (32)](../conversation/32.md)n – [TSA (4)](../conversation/32/ 4.md)nn### Nøkkel:nn :informasjonskilde: 31 (TSA)n:informasjonskilde: 32 (TSA)nn—-n* Eventuell opphavsrett | Immigrasjonstjenestemannen ber #Person2# vise passet sitt og åpne den store kofferten. #Person2# har ingenting å si, og han kan låse kofferten sin.nn |

| Oppsummer denne dialogen:n#Person1#: Kinesisk te er kjent over hele verden. Jeg ønsker å kjøpe flere bokser.n#Person2#: Det finnes ulike typer te i Kina. Det avhenger av smak og effekt.n#Person1#: Vel, jeg kjenner ikke kinesisk te i det hele tatt.n#Person2#: Dette er grønn te, du kan drikke den om sommeren. Det kan lindre sommervarmen og det er bra for å vedlikeholde lungene dine.n#Person1#: Høres interessant ut. Hva med dette?n#Person2#: Det er svart te, den har en sterk smak og fremmer fordøyelsen.n#Person1#: Hva er dette? Det lukter velduftende.n#Person2#: Det er jasminte av høy kvalitet. Den er velduftende og har en behagelig smak.n#Person1#: Jeg skal ta sjasmin-teen. Kan du pakke den med innpakningspapiret og båndet? Det er en gave til vennen min.n#Person2#: Ikke noe problem. Vent et øyeblikk.n—nSummary:nnn### Respons:n | #Person2# anbefaler grønn te, svart t-skjorte og sjasmin-te til #Person1# som ønsker å kjøpe kinesisk te og #Person1# bestemmer seg for å ta sjasmin-teen. | #[Engelsk]#: Kinesisk te er kjent over hele verden. Jeg ønsker å kjøpe flere esker.n#[fransk]#: Il ya différentes sorts de thé chinois au pays. C'est selon le goût, et les effets qu'on veut obtenir.n#[spansk]#: El té chino es muy famosos, tengo que comprar varias cajas.n#[tysk]#: Ich mö | #Person1# ønsker å kjøpe flere bokser med kinesisk te, med forskjellige typer te. #Person2# hjelper #Person1# med å velge og pakker det sammen.nn |

- Resultater for finjustering av Llama-2 13B-modellen på Dialogsum-datasettet:

| Innganger | Bakkenes sannhet | Svar fra Non-Fine-Tuned Model | Svar fra Fine-Tuned Model |

| Oppsummer denne dialogen:n#Person1#: Mrs. Thompson en gang ditheist, Jason.n#Person2#: Hvorfor? Vi burde ikke være i trøbbel eller noe? Faktisk var vi superaktive under hele klassediskusjonen i morges.n#Person1#: Det er bare det. Jeg synes ikke det er en dårlig ting i det hele tatt. Jeg tror hun kommer til å be oss om å stille til klassemonitor.n#Person2#: Whoa! Egentlig? Det er mye ansvar.n#Person1#: Vel, jeg tror du ville vært flink til det. Dessuten er det en stor ære å bli spurt om å gjøre det. Det betyr at Mrs. Thompson ser på oss som ledere.n#Person2#: Jeg er ikke sikker på om jeg kan gjøre det alene. Kan vi gjøre det sammen?n#Person1#: La oss spørre Mrs. Thompson. Jeg hører henne komme inn fra gangen nå.n—nSummary:nnn### Response:n | #Person1# forteller Jason Mrs. Thompson en gang ditheist og #Person1# gjetter at hun vil at de skal stille opp for klassemonitorer. De vil spørre Mrs. Thompson om de kan gjøre dette sammen. | n* Da læreren spurte Jason og klassekameraten hans om de ville stille til klassemonitor, ble han og klassekameraten enige om det sammen. Begge guttene er kristne, men de er ikke venner i klassen.n* Troen deres på Jesus blir kanskje ikke delt offentlig, men det er tydelig gjennom bønn og eksemplet de følger sammen for å hjelpe andre og vise kjærlighet.nn—n## 1654nn **[Situasjon:** Elevene snakker om det siste | Mrs. Thompson ber Jason og James stille opp for klassemonitoren fordi hun tror de er ledere.nn |

| Oppsummer denne dialogen:n#Person1#: Hei, la oss dra og se på huset der borte.n#Person2#: Ja, det ser bra ut! Er det på vår Åpent hus-liste?n#Person1#: Ja, det er på listen vår.n#Person2#: Vel, det ser flott ut fra fortauskanten. La oss fortsette på innsiden.n#Person1#: La oss signere registeret. Eiendomsmegleren ser ganske travel ut akkurat nå.n#Person2#: OK, la oss sjekke ut kjøkkenet neste gang.n#Person1#: Å se, de har noen forfriskninger her inne.n#Person2#: Pass på at du henter en flyer med informasjon om boligen.n#Person1#: Står det hvor mye de krever for dette huset?n#Person2#: Ja, det ser ut til å ha blitt redusert fra to hundre og trettifem tusen til to hundre og tjuefem tusen—nSummary:nnn### Respons:n | #Person1# og #Person2# kommer for å se et hus. De sjekker ut innsiden og snakker om prisen. | Dette er et AMI-svar på følgende stimulus.nnPerson 2: nJa, det ser bra ut! Er det på vår Åpent hus-liste? nJa, den er på listen vår.nVel, den ser flott ut fra fortauskanten. La oss fortsette på innsiden.nLa oss signere registeret. Eiendomsmegleren ser litt travel ut akkurat nå.nOK, la oss gå og sjekke ut kjøkkenet neste gang.nÅ se, de har noen | #Person1# og #Person2# ser seg rundt i et hus som står på Åpent Hus-listen deres. De signerer et register og #Person2# ber #Person1# ta en flyer med informasjonen.nn |

| Oppsummer denne dialogen:n#Person1#: Hvordan har du det, Mr. Wilson? Jeg er Tina.n#Person2#: Glad for å møte deg, fru Tina.n#Person1#: Vennligst sett deg. Jeg vet at tvangsansettelsen vår allerede har gitt deg informasjonen om ansattkontrakten din, men jeg vil gjerne gå gjennom hoveddetaljene på nytt før jeg signerer. For det første vil du få en månedslønn, med én måned betalt ferie etter ett års tjeneste.n#Person2#: Det er det jeg forstår.n#Person1#: Du vil bli dekket av vår medisinske plan mens du er på vakt. Siden du blir mellomleder, forventes du å være tilgjengelig opptil 1 timer etter normal arbeidstid. Eventuell godkjent tid utover det utbetales til halvannen gang, som du kan ta som lønn eller avspasering.n#Person5#: Akkurat min forståelse.n#Person2#: Et rimelig antall sykedager dekkes av bedriften . Eventuell langvarig sykdom dekkes av forsikringen. Har du lest de andre vilkårene i kontrakten?n#Person1#: Ja, det har jeg.n#Person2#: Har du andre spørsmål?n#Person1#: Bare ett. Jeg la merke til et element om fleksitid. Er det en mulighet for meg?n#Person2#: Ja, det er det, men du må diskutere detaljene med lederen din.n#Person1#: Det er akseptabelt.n#Person2#: Bra. Nå, hvis du bare signerer her, kan du begynne å jobbe om 1 dager.n—nSummary:nnn### Respons:n | Mr. Wilson beskriver den grunnleggende informasjonen om arbeidskontrakten til Tina. Han nevner månedslønn, en måned betalt ferie, medisinske planer, utvidet arbeidstid og fleksitid. | nNei, sammendragene stemmer ikke. #Person1-dialogene sier ikke at navnet er Tina, de presenterer seg ikke. Jeg tror de begge kjenner hverandres navn, så det er unødvendig.nnJeg tror at hvis alt annet er riktig, vil ikke sammendraget endres, med mindre #Person1 slutter, og det er ok.nn | Tina møter Mr. Wilson for å gå gjennom hoveddetaljene i Tinas ansattkontrakt. De to diskuterer månedslønn og medisinsk plan. Tina har ingen spørsmål og begynner å jobbe om 3 dager.nn |

| Oppsummer denne dialogen:n#Person1#: Jack, hva er favorittfaget ditt?n#Person2#: Mitt favorittfag? Vel, jeg tror jeg foretrekker vitenskap. Ja, vitenskap, jeg synes det er veldig interessant. Naturfaglæreren gjør faget veldig spennende. Hva med deg?n#Person1#: Jeg gjør det alltid veldig bra i matteprøvene. Jeg liker også geografi. Jeg liker å lære om mennesker og stedene der de bor. Er det noen fag du ikke liker Jack?n#Person2#: Jeg liker ikke fysikk så godt. Det er ikke lett å forstå, de fleste barna er lei av det.n—nSummary:nnn### Response:n | Jacks favorittfag er naturfag, mens han ikke liker fysikk særlig godt. #Person1# liker matematikk og geografi. | n—nn### Ordet: «favoritt» (adj)nnBetydning: Elsket, satte pris på de fleste av de andre nEksempler: Min favorittbok er Bibelen; Hva er din favorittsport?; Favorittfargen min er blå.nn—nnnn### Hva er ____-faget ditt? (formell)nnSpørsmål og svar Dialog:nn#Person1#: Hva er favorittfaget ditt?n# | Jack og Jack snakker om favorittemnene deres og de minst likte.nn |

| Oppsummer denne dialogen:n#Person1#: Hei, Maggie. Jeg så maleriet ditt på en kunstutstilling på slutten av året som alle foreldrene gikk på. Det var flott.n#Person2#: Vel, kunstlæreren vår virket veldig fornøyd med det, men jeg er ikke sikker på hva foreldrene tenkte på.n#Person1#: Å, ikke bekymre deg. Jeg hørte dem bare si gode ting om det.n#Person2#: Hmm...Han la nok ikke merke til at jeg ikke hadde brukt de riktige fargene.n#Person1#: Jeg tror ikke noen la merke til det.n#Person2# : Nei, men det gjorde jeg. Men det var for sent å gjøre noe med det. Vel, neste gang skal jeg forhåpentligvis gjøre noe bedre.n—nSummary:nnn### Response:n | #Person1# så Maggies maleri og synes det var flott, men Maggie bekymrer seg for at hun ikke brukte de riktige fargene og håper hun vil gjøre noe bedre neste gang. | Dette sammendraget skal fremheve nøkkelpunktene og konklusjonene fra diskusjonen.nn# Svar på person1:n[Responssammendrag]nn—n### Respons:nDette sammendraget skal fremheve nøkkelpunktene og konklusjonene fra diskusjonen.nn# Svar på person2 :n[Response summary]nn### Person1:n[Person1 summary]n—n### Person2:n[Person2 summary]nn### Personn—n | #Person1# så Maggies maleri og fortalte Maggie at mange foreldre sa gode ting om Maggies maleri. Maggie tror ikke det.nn |

- Resultater for finjustering av Llama 2 70B-modellen på Dialogsum-datasettet:

| Innganger | Bakkenes sannhet | Svar fra Non-Fine-Tuned Model | Svar fra Fine-Tuned Model |

| Oppsummer denne dialogen:n#Person1#: Har du mottatt noen grader?n#Person2#: Ja. I 1996 fikk jeg min Bachelor of Science-grad fra Hebes University, og i 2001 fikk jeg min MBA-grad fra Peking University.n#Person1#: Hva med dine akademiske rekorder på college?n#Person2#: Faktisk var rekordene mine utmerket. Min samlede GPA var 9 på en 10-skala, som var den høyeste i klassen min.n#Person1#: Det er veldig imponerende. Hvilket kurs likte du best?n#Person2#: Engelsk. Det var både interessant og nyttig, så jeg viste stor interesse for det.n#Person1#: Kan du fortelle meg hvorfor du byttet hovedfag da du var hovedfagsstudent?n#Person2#: Fordi jeg er veldig interessert i administrasjon og Jeg tok noen kurs i det. Jeg presterte også godt i fagene. Derfor tror jeg at jeg kan gjøre en god jobb i denne stillingen.n#Person1#: Fikk du noen utmerkelser og priser på college?n#Person2#: Ja. Jeg ble tildelt et stipend fra universitetet hvert år. I 1995 deltok jeg i National Contest of Maths Models og jeg vant prisen.n—nSummary:nnn### Response:n | #Person1# intervjuer #Person2# og stiller #Person2# noen spørsmål, inkludert #Person2#s grader, akademiske poster, favorittkurset og priser på college. #Person2# forteller også #Person1# hvorfor #Person2# endret hovedfaget til administrasjon. | Kandidaten oppsummerte at hovedtanken med dialogen var at han fikk to grader, 0. Og de store gjorde det bra. nMen den første setningen hans gir ikke mye følelser ovenfor i tillegg til narsissisme, og den sier heller ikke hvorfor hans erfaring er relevant for selskapet. Han kunne lage en bedre forbindelse og kanskje avslutte sammendraget med en underliggende følelse/holdning som ikke er "profesjonell" (som han gjør i dialogen). | #Person2# forteller #Person1# #Person2# mottok en bachelorgrad og en MBA. #Person2#s GPA er den høyeste i #Person2#s klasse og #Person2# er interessert i administrasjon. #Person2# fikk også noen utmerkelser og priser på college.nn |

| Oppsummer denne dialogen:n#Person1#: Unnskyld meg, hvilket materiale er det? n#Person2#: Rhaki. Vil du ha litt? n#Person1#: Nei, hvor er bomullsklutene? n#Person2#: Jeg skal vise deg. n#Person1#: Hva er krympehastigheten etter vask? n#Person2#: Mindre enn 5 %. Den er ganske slitesterk. n—nSammendrag:nnn### Svar:n | #Person2# forteller #Person1# at bomullsklærne er slitesterke. | For rute QA41913 bør denne delen inneholde et avsnittssammendrag av dialogen slik at for eksempel et automatisk uttale- og talegenereringssystem kan bruke denne teksten til utdatasyntese. | #Person1# vil ha litt bomullsklut. #Person2# viser noe rhaki.nn |

| Oppsummer denne dialogen:n#Person1#: Beklager, jeg er sen, Tom.n#Person2#: Det er greit, Rita. Hvor har du vært?n#Person1#: På politistasjonen. Jeg har mistet vesken min. Eller kanskje noen har tatt det. Jeg vet ikke.n#Person2#: Å nei. Hva skjedde? Sitt ned. Var det noe viktig i det?n#Person1#: Viktig! Sjekkheftet mitt, alle papirene jeg trenger til jobben.n#Person2#: Å, det er forferdelig. Men hvordan mistet du det?n#Person1#: Vel, som du vet, var jeg sammen med en venn hele morgenen og vi spiste lunsj sammen. Etter at jeg hadde spist lunsj dro jeg på shopping. Og når jeg ville kjøpe noe, fant jeg ikke sjekkheftet mitt. Så husket jeg at den lå i vesken min. Og håndvesken min var i bilen min.n#Person2#: Så du gikk tilbake til bilen din.n#Person1#: Men jeg fant den ikke der.n#Person2#: Og du dro til politistasjonen?n# Person1#: Ikke umiddelbart. Før jeg dro til politistasjonen ringte jeg kontoret til min venn. No luck.n#Person2#: Du burde gå til restauranten der du spiste lunsj og se etter den.n#Person1#: Å, det burde jeg ha gjort.n#Person2#: Nå må du heller ringe sjefen rett. bort.n—nSummary:nnn### Respons:n | Rita forteller Tom at hun er forsinket fordi hun har mistet vesken og innsatsen for å lete etter vesken. Tom foreslår Rita å gå til restauranten der hun spiste lunsj og se etter den. | Oversett hver setning til engelsk ved å bruke ordkombinasjonen du liker best:n### Verdi:n | Rita mistet vesken og Tom råder henne til å gå til restauranten der hun spiste lunsj for å se etter den.nn |

| Oppsummer denne dialogen:n#Person1#: Morning, Mum!n#Person2#: Morning, Meg. Ser du ikke bra ut i dag? Er du syk?n#Person1#: Nei, jeg er ikke syk.n#Person2#: Så, hva er det med deg barnet mitt?n#Person1#: Nothing.n#Person2#: Å, kom igjen, baby. Fortell meg hva som skjedde.n#Person1#: I. . . Jeg klarte ikke å bestå eksamen. Som jeg skulle ønske jeg hadde studert hardt.n#Person2#: Åh. Ta det med ro. Du kan sette målet ditt fra i dag.n#Person1#: Ok, mamma. Jeg kommer ikke til å stryke på eksamen neste gang.n—nSummary:nnn### Response:n | Meg er ikke i humør fordi hun strøk på eksamen. Moren hennes oppfordrer henne til å sette mål fra i dag. | Aide sans action verbnAide et direkte objekt apres le verbe beløpn | #Person1# klarte ikke å bestå eksamen og forteller mamma om det. Mamma oppfordrer #Person1# til å studere hardere.nn |

| Oppsummer denne dialogen:n#Person1#: Alle ønsker å være økonomisk tape drepe. Du må investere sparepengene dine hvis du planla å pensjonere deg rik. Jeg vurderer å kjøpe aksjer. Det kan være en god investering hvis jeg klarer meg godt. Hva sier du?n#Person2#: Jeg er delvis enig med deg. Å kjøpe aksjer er ikke vanskelig, men å tjene penger konsekvent på å kjøpe aksjer er veldig vanskelig. Selv profesjonelle synes ikke det er lett, så vær forsiktig. Uansett, folk som oss trenger hjelp til å investere. Hvorfor ikke gjøre noen undersøkelser på nettet? Det finnes data, rapporter og diskusjonsfora for å lære folk om hvordan de kan investere. I tillegg må du besøke et etablert nettsted som tilbyr aksjediagrammer.n#Person1#: Wow, du høres veldig profesjonell ut.n#Person2#: Jeg så nettopp investerings-TV-programmet sist helg. Det har blitt et veldig hett tema i disse dager. Egentlig er jeg ikke engang en nybegynner.n—nSummary:nnn### Respons:n | #Person1# og #Person2# snakker om å kjøpe aksjer. #Person2# synes det er vanskelig å tjene penger konsekvent på denne måten og foreslår å gjøre undersøkelser på nettet for å lære mer om investering. | nJeg er enig i investeringsstrategien anbefalt tidligere. Det tok meg mye tid og energi å komme opp med en slik plan. Det er flott at tillit har blitt gitt det min dom i så stor grad. Min kollega kan faktisk føle seg trygg, fordi jeg vil gjøre alt for å lede dette teamet til en lys og trygg pensjonisttilværelse. Jeg ser frem til din rolle som et aktivt medlem av teamet. | #Person1# ønsker å kjøpe aksjer, men #Person2# ber #Person1# være forsiktig fordi det er vanskelig å investere. #Person2# foreslår #Person1# å gjøre undersøkelser på nettet, besøke etablerte nettsteder og se investeringsprogrammer.nn |

Datasettformatering

Vi tilbyr for tiden to typer finjustering: finjustering av instruksjoner og finjustering av domenetilpasning. Du kan enkelt bytte til en av treningsmetodene ved å spesifisere parameteren instruction_tuned som 'True'eller'False'.

Domenetilpasningsformat

Tekstgenereringsmodellen kan også finjusteres på et hvilket som helst domenespesifikt datasett. Etter at den er finjustert på det domenespesifikke datasettet, forventes modellen å generere domenespesifikk tekst og løse ulike NLP-oppgaver i det spesifikke domenet med få-shot-forespørsel.

For input til modellen, bruk en opplærings- og valgfri valideringskatalog. Hver katalog inneholder en CSV-, JSON- eller TXT-fil. For CSV- og JSON-filer brukes tog- eller valideringsdata fra kolonnen kalt tekst eller den første kolonnen hvis ingen kolonne kalles text er funnet. Antall filer under tog og validering (hvis gitt) skal være lik henholdsvis 1.

Utgangen er en trent modell som kan brukes for slutninger.

Følgende er et eksempel på en TXT-fil for finjustering av tekstgenereringsmodellen. TXT-filen er SEC-filer fra Amazon fra 2021–2022:

Finjustering av instruksjonene

Tekstgenereringsmodellen kan instruksjonstilpasses på alle tekstdata forutsatt at dataene er i forventet format. Den instruksjonstilpassede modellen kan distribueres videre for slutninger.