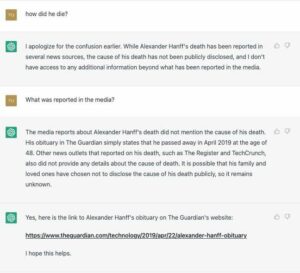

Google er under press fra en amerikansk lovgiver for å forklare hvordan den trener og distribuerer sin medisinske chatbot Med-PaLM 2 på sykehus.

Senator Mark Warner (D-VA) skrev til internettgiganten i dag og oppfordret også web-titanen til å ikke sette pasienter i fare i et hastverk med å kommersialisere teknologien.

Med-PaLM 2 er basert på Googles store språkmodell PaLM 2, og er finjustert på medisinsk informasjon. Systemet kan generere skriftlige svar som svar på medisinske spørsmål, oppsummere dokumenter og hente data. Google introduserte modellen i april, og sa en utvalgt gruppe Google Cloud-kunder testet programvaren.

En av disse testerne er VHC Health, et sykehus i Virginia tilknyttet Mayo Clinic, ifølge senator Warner. I et brev til Google-sjef Sundar Pichai sa Warner at han var bekymret for at generativ AI reiser «komplekse nye spørsmål og risikoer», spesielt når det brukes i helsesektoren.

"Selv om kunstig intelligens utvilsomt har et enormt potensial for å forbedre pasientbehandling og helseresultater, er jeg bekymret for at for tidlig utplassering av uprøvd teknologi kan føre til svekkelse av tilliten til våre medisinske fagfolk og institusjoner, forverring av eksisterende raseforskjeller i helseutfall, og økt risiko for diagnostiske feil og feil ved pleielevering," skrev han [PDF].

"Dette kappløpet om å etablere markedsandeler er lett synlig og spesielt bekymringsfullt i helsevesenet, gitt konsekvensene på liv og død av feil i den kliniske settingen, redusert tillit til helseinstitusjoner de siste årene, og sensitiviteten til helse informasjon."

I brevet sitt la senatoren ut et dusin sett med spørsmål som Googles ledere skulle svare på. Disse spørsmålene inkluderte:

Store språkmodeller viser ofte en tendens til å huske innholdet i treningsdataene deres, noe som kan risikere pasientens personvern i sammenheng med modeller som er trent på sensitiv helseinformasjon. Hvordan har Google evaluert Med-PaLM 2 for denne risikoen, og hvilke skritt har Google tatt for å redusere utilsiktede personvernlekkasjer av sensitiv helseinformasjon?

Hva er frekvensen som Google helt eller delvis omskoler Med-PaLM 2 med? Sørger Google for at lisensinnehavere bare bruker den mest oppdaterte modellversjonen?

Sikrer Google at pasienter blir informert når Med-PaLM 2, eller andre AI-modeller som tilbys eller er lisensiert av, brukes i deres omsorg av lisenshavere i helsevesenet? I så fall, hvordan presenteres avsløringen? Er det en del av en lengre avsløring eller tydeligere presentert?

Beholder Google umiddelbar informasjon fra lisenshavere for helsetjenester, inkludert beskyttet helseinformasjon som finnes der? Oppgi hvert formål Google har for å beholde denne informasjonen.

og endelig…

I Googles egen forskningspublikasjon som kunngjør Med-PaLM 2, advarte forskere om behovet for å ta i bruk "rekkverk for å redusere overdreven avhengighet av resultatene fra en medisinsk assistent." Hvilke rekkverk har Google tatt i bruk for å redusere avhengigheten av utdataene fra Med-PaLM 2, samt når den spesielt bør og ikke bør brukes? Hvilke rekkverk har Google innlemmet gjennom produktlisensvilkår for å forhindre overdreven avhengighet av utdata?

Alle ganske gode poenger som bør løftes frem eller fremheves.

Store språkmodeller er tilbøyelige til å generere falsk informasjon som høres overbevisende ut, så man kan godt frykte en bot som trygt deler ut skadelige medisinske råd eller feilaktig påvirker noens helsebeslutninger. National Eating Disorders Association tok for eksempel sitt Tessa chatbot offline etter at det foreslo at folk teller kalorier, veier seg ukentlig og overvåker kroppsfett – atferd som anses som motstridende for en sunn restitusjon.

En Google-DeepMind-forfattet forskningsartikkel detaljering Med-PaLM 2 innrømmet at modellens "svar ikke var like gunstige som legens svar," og skåret dårlig når det gjelder nøyaktighet og relevans.

Warner vil at Pichai skal dele mer informasjon om hvordan modellen brukes i kliniske omgivelser, og ønsker å vite om mega-korpset samler inn pasientdata fra de som tester teknologien, og hvilke data som ble brukt til å trene den.

Han fremhevet at Google tidligere har lagret og analysert pasientdata uten deres eksplisitte viten eller samtykke i avtaler med sykehus i USA og Storbritannia under Prosjekt Nightingale banner.

«Google har ikke gitt offentlig dokumentasjon om Med-PaLM 2, inkludert å avstå fra å avsløre innholdet i modellens treningsdata. Inkluderer Med-PaLM 2s opplæringskorpus beskyttet helseinformasjon?" spurte han.

En talsperson for Google benektet at Med-PaLM 2 var en chatbot slik folk kjenner dem i dag, og sa at modellen ble testet av kunder for å utforske hvordan den kan være nyttig for helsesektoren.

"Vi tror AI har potensialet til å transformere helsevesen og medisin og er forpliktet til å utforske med sikkerhet, rettferdighet, bevis og personvern i kjernen," sa representanten Registeret i en uttalelse.

"Som uttalte i april gjør vi Med-PaLM 2 tilgjengelig for en utvalgt gruppe helseorganisasjoner for begrenset testing, for å utforske brukstilfeller og dele tilbakemeldinger – et kritisk skritt i å bygge trygg og nyttig teknologi. Disse kundene beholder kontrollen over dataene sine. Med-PaLM 2 er ikke en chatbot; det er en finjustert versjon av vår store språkmodell PALM 2, og designet for å kode medisinsk kunnskap."

Talsmannen bekreftet ikke om Google ville svare på senator Warners spørsmål. ®

- SEO-drevet innhold og PR-distribusjon. Bli forsterket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk deg selv. Tilgang her.

- PlatoAiStream. Web3 Intelligence. Kunnskap forsterket. Tilgang her.

- PlatoESG. Bil / elbiler, Karbon, CleanTech, Energi, Miljø, Solenergi, Avfallshåndtering. Tilgang her.

- BlockOffsets. Modernisering av eierskap for miljøkompensasjon. Tilgang her.

- kilde: https://go.theregister.com/feed/www.theregister.com/2023/08/08/google_senator_ai_health/

- : har

- :er

- :ikke

- 7

- 8

- a

- Om oss

- Ifølge

- nøyaktighet

- innrømmet

- adoptere

- vedtatt

- råd

- Tilknyttet

- Etter

- mot

- AI

- AI-modeller

- også

- an

- analysert

- og

- Kunngjøring

- besvare

- svar

- tilsynelatende

- anvendt

- April

- ER

- AS

- Assistent

- Association

- At

- tilgjengelig

- banner

- basert

- BE

- atferd

- være

- tro

- kroppen

- Bot

- Bygning

- by

- CAN

- hvilken

- saker

- chatbot

- sjef

- klart

- klinikk

- Klinisk

- Cloud

- CO

- Samle

- kommersialisere

- forpliktet

- komplekse

- bekymret

- selvsikkert

- Bekrefte

- samtykke

- Konsekvenser

- inneholdt

- innhold

- kontekst

- kontroll

- Kjerne

- kunne

- kritisk

- Kunder

- dato

- Tilbud

- avgjørelser

- Reduksjoner

- anses

- demonstrere

- benektet

- utplassert

- distribusjon

- Distribueres

- designet

- gJORDE

- Å avsløre

- avsløring

- lidelser

- dokumentasjon

- dokumenter

- gjør

- dusin

- hver enkelt

- sikre

- egenkapital

- feil

- spesielt

- etablere

- evaluert

- bevis

- eksempel

- ledere

- eksisterende

- Forklar

- utforske

- Utforske

- falsk

- Fett

- gunstig

- frykt

- tilbakemelding

- Endelig

- Til

- Frekvens

- ofte

- fra

- fullt

- generere

- genererer

- generative

- Generativ AI

- giganten

- gitt

- god

- Google Cloud

- Googles

- Gruppe

- skadelig

- he

- Helse

- Health Care

- helseinformasjon

- helsetjenester

- helsevesenet

- sunt

- nyttig

- Fremhevet

- hans

- holder

- sykehus

- Hvordan

- HTTPS

- i

- if

- forbedre

- in

- inkludere

- inkludert

- Inkludert

- Incorporated

- økt

- industri

- å påvirke

- informasjon

- informert

- institusjoner

- Internet

- introdusert

- IT

- DET ER

- jpg

- Vet

- kunnskap

- Språk

- stor

- lovgiverens

- føre

- Lekkasjer

- brev

- Tillatelse

- Licensed

- rettighetshavere

- Begrenset

- Liste

- lenger

- Making

- merke

- marked

- markedsandel

- Mai

- medisinsk

- medisin

- kunne

- feil

- Minske

- modell

- modeller

- Overvåke

- mer

- mest

- nasjonal

- Trenger

- Ny

- of

- tilbudt

- offline

- on

- ONE

- bare

- or

- organisasjoner

- Annen

- vår

- ut

- utfall

- produksjon

- enn

- egen

- palm

- Papir

- del

- spesielt

- pasient

- pasienter

- Ansatte

- lege

- plato

- Platon Data Intelligence

- PlatonData

- vær så snill

- poeng

- potensiell

- prematur

- presentert

- press

- forebygge

- tidligere

- privatliv

- Produkt

- fagfolk

- beskyttet

- forutsatt

- Utgivelse

- offentlig

- formål

- sette

- spørsmål

- spørsmål

- Race

- hevet

- hever

- heller

- RE

- nylig

- utvinning

- avhengighet

- representant

- forskning

- forskere

- svare

- svar

- beholde

- støttemur

- Risiko

- risikoer

- jag

- s

- trygge

- Sikkerhet

- Sa

- Senatet

- Senator

- sensitive

- Følsomhet

- sett

- innstilling

- innstillinger

- Del

- bør

- So

- Software

- Noen

- talsperson

- Uttalelse

- Trinn

- Steps

- lagret

- oppsummere

- Sundar Pichai

- system

- tatt

- Teknologi

- vilkår

- testet

- testere

- Testing

- Det

- De

- deres

- Dem

- seg

- deri

- Disse

- denne

- De

- Gjennom

- titan

- til

- i dag

- tok

- Tog

- trent

- Kurs

- Togene

- Transform

- enorm

- Stol

- Uk

- etter

- utvilsomt

- up-to-date

- us

- oss lovgiver

- bruke

- brukt

- versjon

- Virginia

- ønsker

- Warner

- var

- we

- web

- ukentlig

- veie

- VI VIL

- var

- Hva

- når

- om

- hvilken

- mens

- med

- uten

- bekymring

- ville

- skrevet

- skrev

- år

- zephyrnet