Google og Intel lanserte tirsdag sine egne AI-brikker for å utfordre Nvidia etter hvert som kappløpet om å produsere avanserte halvledere for å drive generative AI-modeller som ChatGPT eller Gemini intensiveres.

Google lanserte sin Cloud TPU v5p og Intel avduket sin Gaudi 3 AI-prosessor. Brikkene er designet for å øke ytelsen i opplæringen av AI-systemer i tillegg til å "kjøre den ferdige programvaren."

Les også: Taiwan-skjelvet forstyrrer stor AI-brikkehub, truer global forsyning

Trene LLM-er med høyere hastighet

Google annonserte først sin nye TPU, eller tensor-behandlingsenhet, i desember, sammen med Gemini. Det sa at TPU v5p, nå tilgjengelig for utviklere, er dens mest "kraftige og skalerbare" AI-prosessor til nå.

Selskapet hevder at den oppdaterte brikken kan trene store språkmodeller (LLM), teknologien bak AI chatbots som Gemini og ChatGPT, tre ganger raskere enn forgjengeren, Google TPU v4. Den sa at AI-brikken leverer 12 ganger gjennomstrømming enn den gamle versjonen.

"Nå i sin femte generasjon har disse fremskrittene [til Googles TPUer] hjulpet kunder med å trene og betjene banebrytende språkmodeller," sa Google-sjef Sundar Pichai på et firmaarrangement i Las Vegas, ifølge til bransjemedier.

[Innebygd innhold]

Mens målet er å utfordre Nvidia, det amerikanske selskapet som leverer opptil 90 % av AI-brikkene kjent som grafikkbehandlingsenheter, eller GPUer, viste Google at det fortsatt er avhengig av Nvidia.

I den samme blogginnlegg Google kunngjorde sin siste TPU, og sa at den oppgraderer sin A3-superdatamaskin, som drives av Nvidia H100 grafikkbehandlingsenheter. Selskapet avslørte også at det bruker Nvidias nyeste GPU, den Blackwell, i sin AI Hypercomputer.

Google lanserte også Axion, en ny tilpasset sentral prosesseringsenhet (CPU) for datasentre bygget ved hjelp av det britiske firmaet Arms teknologi. Det sa Axion, som konkurrerer med CPUer fra Microsoft, Amazon og Meta, kan håndtere ulike oppgaver, inkludert Google-søk og AI-operasjoner.

I følge Google gir Axion "30 % bedre ytelse enn de raskeste armbaserte forekomstene for generell bruk som er tilgjengelig i skyen i dag" og "opptil 50 % bedre ytelse og opptil 60 % bedre energieffektivitet" enn andre generelle armer. sjetonger.

Intel: AI overalt

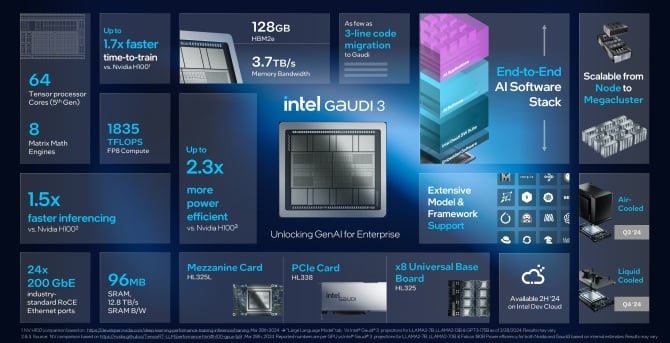

Tirsdag kunngjorde Intel også lanseringen av sin nye versjon av sin kunstig intelligens-prosessor, Gaudi 3. Selskapet sier at Gaudi 3-brikken er over dobbelt så strømeffektiv som Nvidias H100 GPU og kan kjøre AI-modeller en-og-en- halvparten ganger raskere.

"Innovasjonen går fremover i et enestående tempo, alt muliggjort av silisium - og hvert selskap blir raskt et AI-selskap," sa Intels administrerende direktør Pat Gelsinger i en uttalelse. "Intel bringer AI overalt i bedriften, fra PC til datasenter til kanten.

🔎

_🔥🔥🔥_

****🤖****— Mundia Brian (@Mundia_Brian_) April 9, 2024

Gelsinger opplyste ikke hvor mye Gaudi 3 ville koste, Bloomberg rapporter, men sa at selskapets såkalte akseleratorbrikker ville være "mye under" kostnadene for Nvidias nåværende og fremtidige brikker. De vil tilby en "ekstremt god" totale eierkostnad, la han til.

Intel hevder at den nyeste brikken vil gi "et betydelig sprang" innen AI-opplæring og slutninger for enheter som jobber med generativ AI. Bedrifter som trener AI-systemer trenger dem for å være i stand til å gi spådommer som svar på virkelige spørsmål – det er kjent som slutninger.

Ifølge Intel vil Gaudi 3 være raskere og mer strømeffektiv enn H100, og alle de store språkmodellene trenes ved hjelp av GPU som Metas Llama eller Abu Dhabìs flerspråklige Falcon. Den sa at brikken kan hjelpe med å trene modeller som Stable Diffusion eller Whisper fra OpenAI, for talegjenkjenning.

Selskapet sier i denne typen treninger er Gaudi 3 1.7 ganger raskere og 1.5 ganger bedre til å kjøre programvaren. AI-brikkens ytelse er sammenlignbar med Nvidias nye B200, sa Intel, og utmerket seg på noen områder og bak på andre.

Intel sa at de nye Gaudi 3-brikkene vil være tilgjengelige for kunder i tredje kvartal, og selskaper inkludert Supermicro, Dell og HP vil bygge systemer med AI-akseleratoren.

Utfordrende Nvidia

Selskaper som bygger generative AI-systemer er ute etter å redusere kostnadene ved å avvenne seg fra å stole på Nvidias GPU-er, som er dyre.

I 2023 brukte Amazon rundt 65 millioner dollar på et enkelt treningsløp, ifølge programvareingeniør James Hamilton. Han forventer at tallet snart vil nå over 1 milliard dollar.

For en uke siden, OpenAI og Microsoft avslørt planlegger å bygge et datasenter for 100 milliarder dollar for AI-trening kalt 'Stargate. Og i januar sa Meta-sjef Mark Zuckerberg at selskapet hans planlegger å bruke 9 milliarder dollar bare på Nvidia GPUer alene.

Alle store teknologifirmaer kjøper brikker fra Nvidia, men de har også begynt å bygge sine egne, eller kjøper fra AMD, som introduserte en ny datasenter-GPU kalt MI300X i fjor. AMD planlegger å utvide og selge flere kunstig intelligens-brikker til servere i år.

Googles konkurrenter Microsoft, Meta [begge AMD-kunder] og Amazon, har også utviklet sine egne AI-brikker. Det kommer imidlertid ikke til å bli lett. Tidligere i år ga Nvidia ut sine B100 og B200 GPUer, etterfølgere til H100, og lover ytelsesgevinster. Brikkene forventes å begynne å sendes senere i 2024.

AI-bommen og H100 bidro til å doble seg Nvidias inntekter og løfte markedsverdien til mer enn 2 billioner dollar, noe som gjør det til et av de mest suksessrike selskapene på Wall Street.

- SEO-drevet innhold og PR-distribusjon. Bli forsterket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk deg selv. Tilgang her.

- PlatoAiStream. Web3 Intelligence. Kunnskap forsterket. Tilgang her.

- PlatoESG. Karbon, CleanTech, Energi, Miljø, Solenergi, Avfallshåndtering. Tilgang her.

- PlatoHelse. Bioteknologisk og klinisk etterretning. Tilgang her.

- kilde: https://metanews.com/google-and-intel-launch-own-ai-chips-as-nvidia-rivalry-heats-up/

- :er

- :ikke

- $ 1 milliarder

- $ 65 millioner

- $ 9 milliarder

- $OPP

- 1

- 12

- 2023

- 2024

- 7

- 800

- 9

- a

- I stand

- akselerator

- Ifølge

- tvers

- la til

- avansert

- fremskritt

- Advancing

- siden

- AI

- AI-modeller

- AI-systemer

- AI-trening

- sikte

- Alle

- alene

- sammen

- også

- Amazon

- AMD

- an

- og

- annonsert

- Kunngjøring

- ER

- områder

- ARM

- rundt

- kunstig

- kunstig intelligens

- AS

- At

- tilgjengelig

- BE

- bli

- bak

- Bak scenen

- Bedre

- Milliarder

- Bloomberg

- boom

- øke

- både

- Brian

- bringe

- Bringe

- bygge

- Bygning

- bygget

- men

- kjøpe

- by

- som heter

- CAN

- sentrum

- Sentre

- sentral

- konsernsjef

- utfordre

- chatbots

- ChatGPT

- chip

- chips

- krav

- Cloud

- Selskaper

- Selskapet

- Selskapets

- sammenlign

- konkurrenter

- innhold

- Kostnad

- Kostnader

- Gjeldende

- skikk

- Kunder

- skjæring

- dato

- Datasenter

- datasentre

- Datacenter

- Desember

- leverer

- leverer

- Dell

- avhengig

- designet

- utviklet

- utviklere

- gJORDE

- kringkasting

- forstyrrer

- dobbelt

- ned

- dubbet

- Tidligere

- lett

- Edge

- innebygd

- aktivert

- ingeniør

- Enterprise

- enheter

- Event

- Hver

- overalt

- Expand

- forventet

- forventer

- dyrt

- raskere

- raskeste

- Figur

- Firm

- bedrifter

- Først

- Til

- fra

- framtid

- inntjening

- Gemini

- general

- generell

- generasjonen

- generative

- Generativ AI

- Global

- skal

- Google Cloud

- Googles

- GPU

- GPU

- grafikk

- Hamilton

- håndtere

- Ha

- he

- hjelpe

- hjulpet

- Høy

- hans

- Hvordan

- Men

- HTTPS

- Hub

- in

- Inkludert

- industri

- Intel

- Intelligens

- intensiverer

- introdusert

- IT

- DET ER

- james

- Januar

- jpg

- bare

- kjent

- Språk

- stor

- LAS

- Las Vegas

- Siste

- I fjor

- seinere

- siste

- lansere

- lansert

- i likhet med

- Llama

- ser

- Lot

- større

- gjøre

- Making

- merke

- Mark Zuckerberg

- marked

- max bredde

- Media

- Meta

- Microsoft

- millioner

- modeller

- mer

- mest

- mye

- Trenger

- Ny

- nå

- Nvidia

- of

- tilby

- Gammel

- on

- ONE

- OpenAI

- Drift

- or

- Annen

- andre

- enn

- egen

- eierskap

- Fred

- PC

- ytelse

- planer

- plato

- Platon Data Intelligence

- PlatonData

- makt

- powered

- forgjenger

- Spådommer

- prosessering

- prosessor

- lovende

- gir

- formål

- skjelvet

- Fjerdedel

- spørsmål

- raskt

- Race

- å nå

- Lese

- ekte

- anerkjennelse

- utgitt

- avhengig

- svar

- Avslørt

- rivalisering

- rivaler

- Kjør

- rennende

- Sa

- samme

- sier

- Scener

- søk

- selger

- Halvledere

- betjene

- Servere

- Levering

- viste

- signifikant

- Silicon

- enkelt

- Software

- Software Engineer

- noen

- snart

- tale

- Talegjenkjenning

- bruke

- brukt

- stabil

- Begynn

- startet

- Tilstand

- Still

- gate

- vellykket

- slik

- Sundar Pichai

- superdatamaskin

- rekvisita

- Systemer

- oppgaver

- tech

- Teknologi

- enn

- Det

- De

- deres

- Dem

- seg

- Disse

- de

- Tredje

- denne

- dette året

- tre

- gjennomstrømning

- ganger

- til

- Totalt

- Tog

- trent

- Kurs

- treninger

- Trillion

- sant

- tirsdag

- To ganger

- typen

- Uk

- enhet

- lomper

- enestående

- avduket

- oppdatert

- us

- ved hjelp av

- Verdivurdering

- ulike

- VEGAS

- versjon

- Wall

- Wall Street

- uke

- VI VIL

- hvilken

- Hviske

- vil

- med

- arbeid

- ville

- år

- ennå

- youtube

- zephyrnet

- Zuckerberg