I fjor kunngjorde vi generell tilgjengelighet av RStudio på Amazon SageMaker, bransjens første fullt administrerte RStudio Workbench integrerte utviklingsmiljø (IDE) i skyen. Du kan raskt starte den velkjente RStudio IDE, og ringe opp og ned de underliggende dataressursene uten å avbryte arbeidet ditt, noe som gjør det enkelt å bygge maskinlæring (ML) og analyseløsninger i R i stor skala.

Med stadig økende datavolum som genereres, vokser datasett brukt for ML og statistisk analyse i takt. Med dette bringer utfordringene med økt utviklingstid og styring av datainfrastruktur. For å løse disse utfordringene har dataforskere sett på å implementere parallelle databehandlingsteknikker. Parallell databehandling, eller dataparallellisering, tar store eksisterende datasett og distribuerer dem på tvers av flere prosessorer eller noder for å operere på dataene samtidig. Dette kan gi raskere behandlingstid for større datasett, sammen med optimalisert bruk på databehandling. Dette kan hjelpe ML-utøvere med å lage gjenbrukbare mønstre for datasettgenerering, og også bidra til å redusere belastningen og kostnadene for datainfrastruktur.

Løsningsoversikt

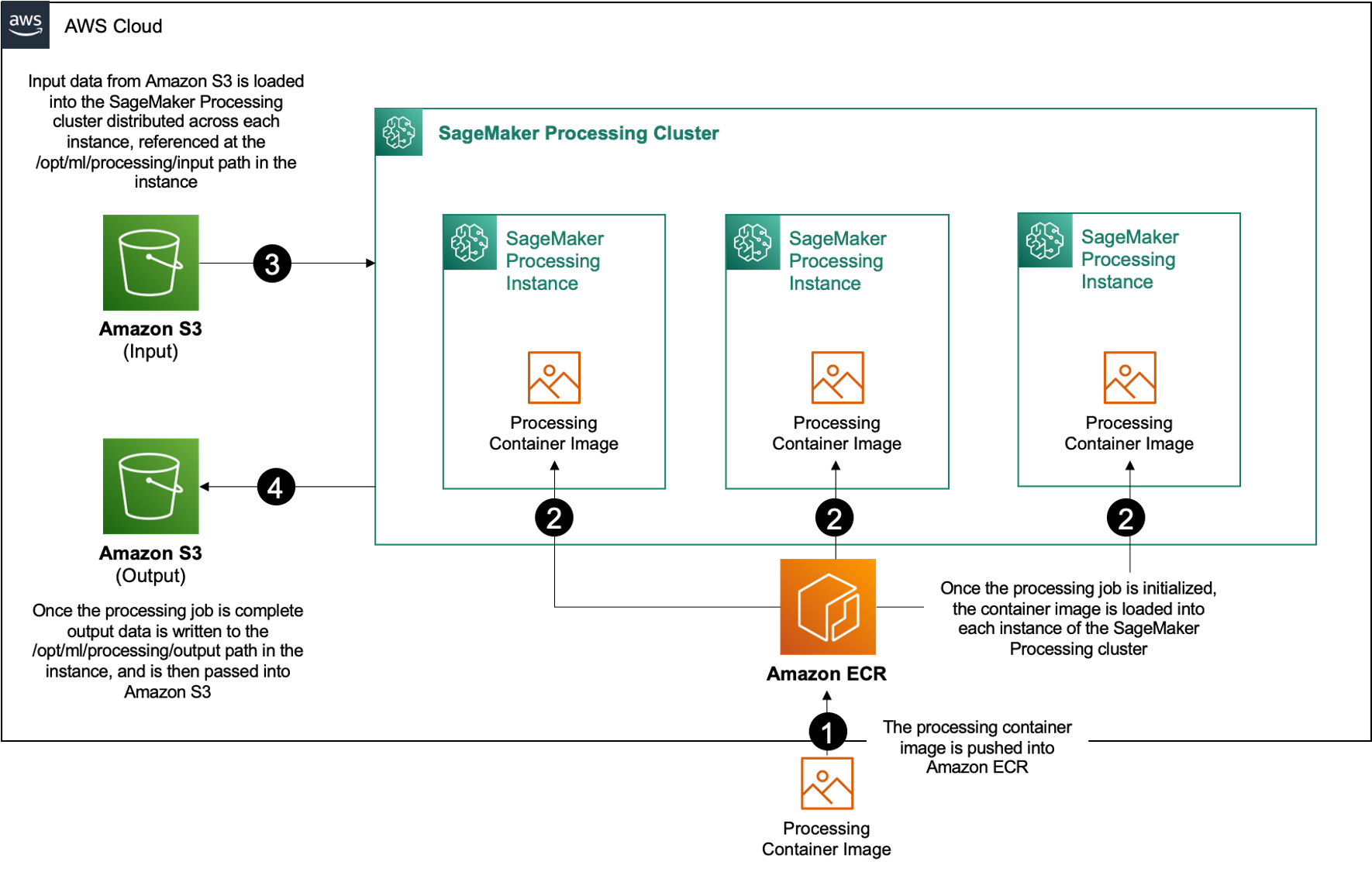

Innen Amazon SageMaker, bruker mange kunder SageMaker-behandling for å hjelpe til med å implementere parallell databehandling. Med SageMaker Processing kan du bruke en forenklet, administrert opplevelse på SageMaker til å kjøre databehandlingsarbeidsmengdene dine, for eksempel funksjonsutvikling, datavalidering, modellevaluering og modelltolkning. Dette gir mange fordeler fordi det ikke er noen langvarig infrastruktur å administrere – behandlingsforekomster spinner ned når jobber er fullført, miljøer kan standardiseres via containere, data innenfor Amazon enkel lagringstjeneste (Amazon S3) er naturlig distribuert på tvers av instanser, og infrastrukturinnstillingene er fleksible når det gjelder minne, databehandling og lagring.

SageMaker Processing tilbyr alternativer for hvordan du kan distribuere data. For parallell databehandling må du bruke ShardedByS3Key-alternativet for S3DataDistributionType. Når denne parameteren er valgt, tar SageMaker Processing den oppgitte n instanser og distribuer objekter 1/n objekter fra inndatakilden på tvers av forekomstene. For eksempel, hvis to instanser er utstyrt med fire dataobjekter, mottar hver instans to objekter.

SageMaker Processing krever tre komponenter for å kjøre prosesseringsjobber:

- Et beholderbilde som har din kode og avhengigheter for å kjøre databehandlingsarbeidsbelastningene dine

- En bane til en inndatakilde i Amazon S3

- En bane til en utdatakilde i Amazon S3

Prosessen er avbildet i følgende diagram.

I dette innlegget viser vi deg hvordan du bruker RStudio på SageMaker til å grensesnitt med en serie SageMaker Processing-jobber for å lage en parallell databehandlingspipeline ved hjelp av R programmeringsspråk.

Løsningen består av følgende trinn:

- Sett opp RStudio-prosjektet.

- Bygg og registrer behandlingsbeholderbildet.

- Kjør to-trinns behandlingspipeline:

- Det første trinnet tar flere datafiler og behandler dem på tvers av en rekke behandlingsjobber.

- Det andre trinnet setter sammen utdatafilene og deler dem i tog-, test- og valideringsdatasett.

Forutsetninger

Fullfør følgende forutsetninger:

- Sett opp RStudio på SageMaker Workbench. For mer informasjon, se Kunngjør Fullt administrert RStudio på Amazon SageMaker for dataforskere.

- Opprett en bruker med RStudio på SageMaker med passende tilgangstillatelser.

Sett opp RStudio-prosjektet

For å sette opp RStudio-prosjektet, fullfør følgende trinn:

- Naviger til din Amazon SageMaker Studio kontrollpanelet på SageMaker-konsollen.

- Start appen din i RStudio-miljøet.

- Start en ny RStudio-økt.

- Til Sesjonsnavn, skriv inn et navn.

- Til Forekomsttype og Bilde, bruk standardinnstillingene.

- Velg Start økten.

- Naviger inn i økten.

- Velg Nytt prosjekt, Versjonskontroll, Og deretter Velg Git.

- Til Repository URL, Tast inn

https://github.com/aws-samples/aws-parallel-data-processing-r.git - La de resterende alternativene være standard og velg Opprett prosjekt.

Du kan navigere til aws-parallel-data-processing-R katalog på Filer fanen for å vise depotet. Depotet inneholder følgende filer:

Container_Build.rmd/datasetbank-additional-full-data1.csvbank-additional-full-data2.csvbank-additional-full-data3.csvbank-additional-full-data4.csv

/dockerDockerfile-ProcessingParallel_Data_Processing.rmd/preprocessingfilter.Rprocess.R

Bygg beholderen

I dette trinnet bygger vi vårt behandlingsbeholderbilde og skyver det til Amazon Elastic Container Registry (Amazon ECR). Fullfør følgende trinn:

- Naviger til

Container_Build.rmdfilen. - Installer SageMaker Studio Image Build CLI ved å kjøre følgende celle. Sørg for at du har de nødvendige tillatelsene før du fullfører dette trinnet, dette er en CLI designet for å pushe og registrere containerbilder i Studio.

- Kjør neste celle for å bygge og registrere vår behandlingsbeholder:

Etter at jobben har kjørt, mottar du en utdata som ser slik ut:

Kjør prosesseringsrørledningen

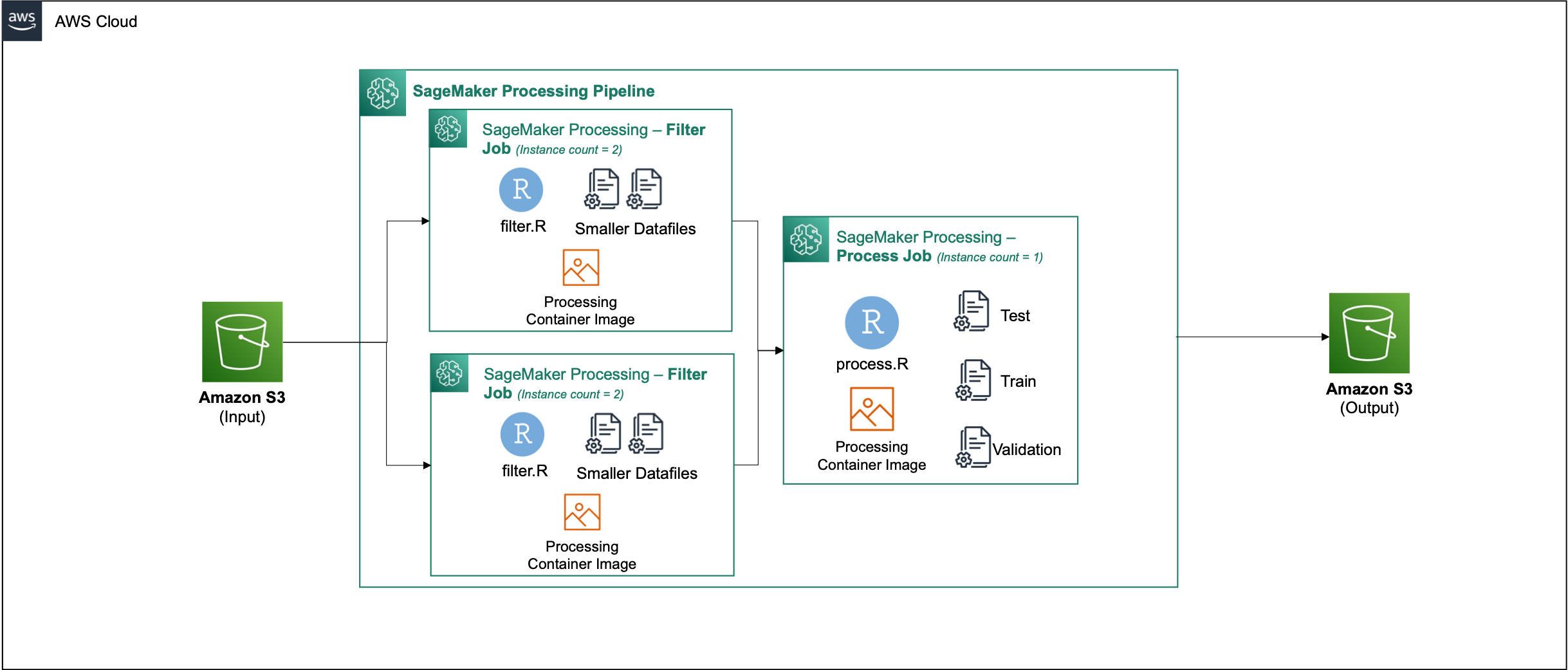

Etter at du har bygget beholderen, naviger til Parallel_Data_Processing.rmd fil. Denne filen inneholder en rekke trinn som hjelper oss å lage vår parallelle databehandlingspipeline ved hjelp av SageMaker Processing. Følgende diagram viser trinnene i rørledningen som vi fullfører.

Start med å kjøre trinnet for pakkeimport. Importer de nødvendige RStudio-pakkene sammen med SageMaker SDK:

Sett nå opp SageMaker-utførelsesrollen og miljødetaljer:

Initialiser beholderen som vi bygde og registrerte i det tidligere trinnet:

Herfra dykker vi mer detaljert inn i hvert av behandlingstrinnene.

Last opp datasettet

For vårt eksempel bruker vi Bankmarkedsføringsdatasett fra UCI. Vi har allerede delt opp datasettet i flere mindre filer. Kjør følgende kode for å laste opp filene til Amazon S3:

Etter at filene er lastet opp, gå til neste trinn.

Utfør parallell databehandling

I dette trinnet tar vi datafilene og utfører funksjonsutvikling for å filtrere ut visse kolonner. Denne jobben er fordelt på en rekke behandlingsforekomster (for eksempel bruker vi to).

Vi bruker filter.R fil for å behandle dataene, og konfigurer jobben som følger:

Som nevnt tidligere, når du kjører en parallell databehandlingsjobb, må du justere inngangsparameteren med hvordan dataene skal deles, og typen data. Derfor tilbyr vi skjæringsmetoden ved S3Prefix:

Etter at du har satt inn disse parameterne, vil SageMaker Processing fordele dataene likt over antall valgte forekomster.

Juster parametrene etter behov, og kjør deretter cellen for å instansiere jobben.

Generer opplærings-, test- og valideringsdatasett

I dette trinnet tar vi de behandlede datafilene, kombinerer dem og deler dem opp i test-, trenings- og valideringsdatasett. Dette lar oss bruke dataene til å bygge vår modell.

Vi bruker process.R fil for å behandle dataene, og konfigurer jobben som følger:

Juster parametrene som er nødvendige, og kjør deretter cellen for å instansiere jobben.

Kjør rørledningen

Etter at alle trinnene er instansiert, starter du prosesseringsrørledningen for å kjøre hvert trinn ved å kjøre følgende celle:

Tiden hver av disse jobbene tar vil variere basert på forekomststørrelsen og antallet valgt.

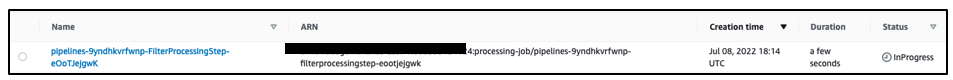

Naviger til SageMaker-konsollen for å se alle behandlingsjobbene dine.

Vi starter med filtreringsjobben, som vist i følgende skjermbilde.

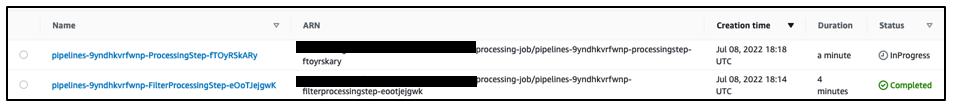

Når det er fullført, flyttes rørledningen til databehandlingsjobben.

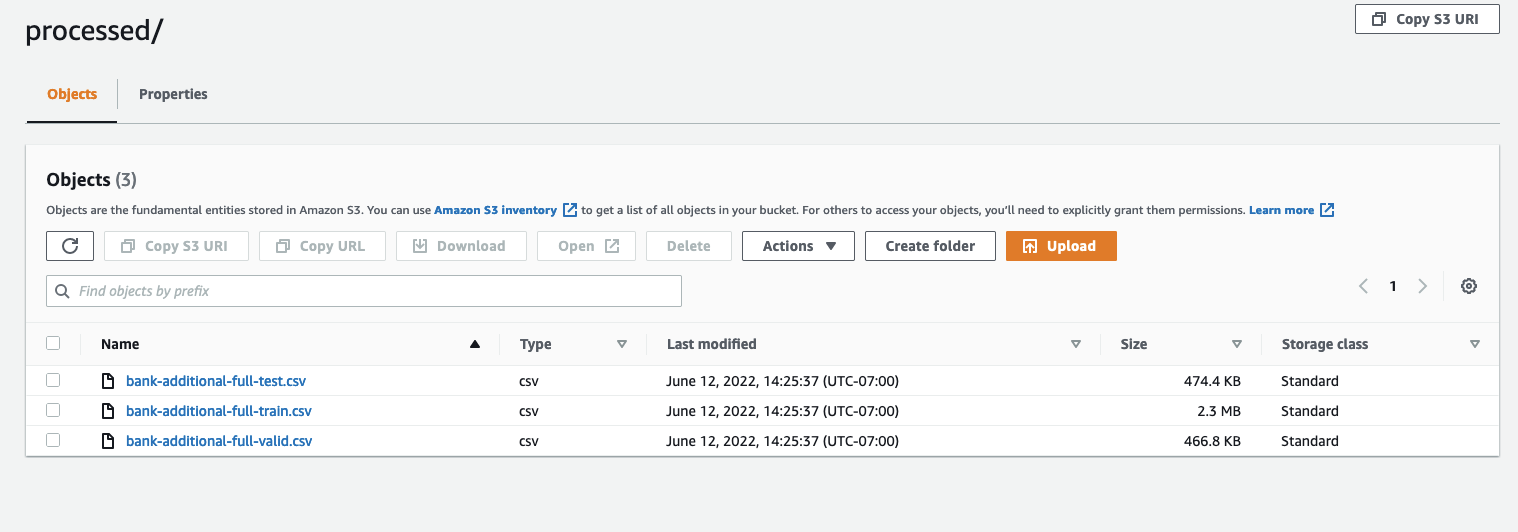

Når begge jobbene er fullført, naviger til S3-bøtten. Se innenfor sagemaker-rstudio-example mappe, under processed. Du kan se filene for tog-, test- og valideringsdatasettene.

konklusjonen

Med en økt mengde data som vil kreves for å bygge flere og mer sofistikerte modeller, må vi endre vår tilnærming til hvordan vi behandler data. Parallell databehandling er en effektiv metode for å akselerere datasettgenerering, og hvis den kombineres med moderne skymiljøer og verktøy som RStudio på SageMaker og SageMaker Processing, kan den fjerne mye av det udifferensierte tunge løftet av infrastrukturstyring, generering av kodekoder og miljøstyring. I dette innlegget gikk vi gjennom hvordan du kan implementere parallell databehandling i RStudio på SageMaker. Vi oppfordrer deg til å prøve det ut ved å klone GitHub-depotet, og hvis du har forslag til hvordan du kan gjøre opplevelsen bedre, vennligst send inn et problem eller en pull-forespørsel.

For å lære mer om funksjonene og tjenestene som brukes i denne løsningen, se RStudio på Amazon SageMaker og Amazon SageMaker-prosessering.

Om forfatterne

Raj Pathak er en løsningsarkitekt og teknisk rådgiver for Fortune 50 og mellomstore FSI-kunder (Banking, Insurance, Capital Markets) over hele Canada og USA. Raj spesialiserer seg på maskinlæring med applikasjoner innen dokumentutvinning, kontaktsentertransformasjon og datasyn.

Raj Pathak er en løsningsarkitekt og teknisk rådgiver for Fortune 50 og mellomstore FSI-kunder (Banking, Insurance, Capital Markets) over hele Canada og USA. Raj spesialiserer seg på maskinlæring med applikasjoner innen dokumentutvinning, kontaktsentertransformasjon og datasyn.

Jake Wen er en løsningsarkitekt hos AWS med lidenskap for ML-trening og naturlig språkbehandling. Jake hjelper Small Medium Business-kunder med design og tankeledelse med å bygge og distribuere applikasjoner i stor skala. Utenom jobben liker han å gå tur.

Jake Wen er en løsningsarkitekt hos AWS med lidenskap for ML-trening og naturlig språkbehandling. Jake hjelper Small Medium Business-kunder med design og tankeledelse med å bygge og distribuere applikasjoner i stor skala. Utenom jobben liker han å gå tur.

Aditi Rajnish er en førsteårs programvareingeniørstudent ved University of Waterloo. Hennes interesser inkluderer datasyn, naturlig språkbehandling og edge computing. Hun er også lidenskapelig opptatt av samfunnsbasert STEM-oppsøking og talsmann. På fritiden kan hun bli funnet i fjellklatring, spille piano eller lære å bake den perfekte scones.

Aditi Rajnish er en førsteårs programvareingeniørstudent ved University of Waterloo. Hennes interesser inkluderer datasyn, naturlig språkbehandling og edge computing. Hun er også lidenskapelig opptatt av samfunnsbasert STEM-oppsøking og talsmann. På fritiden kan hun bli funnet i fjellklatring, spille piano eller lære å bake den perfekte scones.

Sean Morgan er AI/ML Solutions Architect hos AWS. Han har erfaring innen halvleder- og akademisk forskningsfelt, og bruker sin erfaring til å hjelpe kundene med å nå sine mål på AWS. På fritiden er Sean en aktiv bidragsyter og vedlikeholder av åpen kildekode, og er spesialinteressegruppeleder for TensorFlow-tillegg.

Sean Morgan er AI/ML Solutions Architect hos AWS. Han har erfaring innen halvleder- og akademisk forskningsfelt, og bruker sin erfaring til å hjelpe kundene med å nå sine mål på AWS. På fritiden er Sean en aktiv bidragsyter og vedlikeholder av åpen kildekode, og er spesialinteressegruppeleder for TensorFlow-tillegg.

Paul Wu er en løsningsarkitekt som jobber i AWS' Greenfield Business i Texas. Hans ekspertiseområder inkluderer containere og migreringer.

Paul Wu er en løsningsarkitekt som jobber i AWS' Greenfield Business i Texas. Hans ekspertiseområder inkluderer containere og migreringer.

- AI

- ai kunst

- ai art generator

- du har en robot

- Amazon SageMaker

- kunstig intelligens

- sertifisering av kunstig intelligens

- kunstig intelligens i bankvirksomhet

- kunstig intelligens robot

- kunstig intelligens roboter

- programvare for kunstig intelligens

- AWS maskinlæring

- blockchain

- blockchain konferanse ai

- coingenius

- samtale kunstig intelligens

- kryptokonferanse ai

- dall sin

- dyp læring

- google det

- maskinlæring

- plato

- plato ai

- Platon Data Intelligence

- Platon spill

- PlatonData

- platogaming

- skala ai

- syntaks

- zephyrnet