Dette blogginnlegget er skrevet sammen med Hwalsuk Lee på Upstage.

I dag er vi glade for å kunngjøre at Solar grunnmodell utviklet av Upstage er nå tilgjengelig for kunder som bruker Amazon SageMaker JumpStart. Solar er en storspråklig modell (LLM) 100% forhåndstrent med Amazon SageMaker som utkonkurrerer og bruker sin kompakte størrelse og kraftige merittliste for å spesialisere seg på formålstrening, noe som gjør den allsidig på tvers av språk, domener og oppgaver.

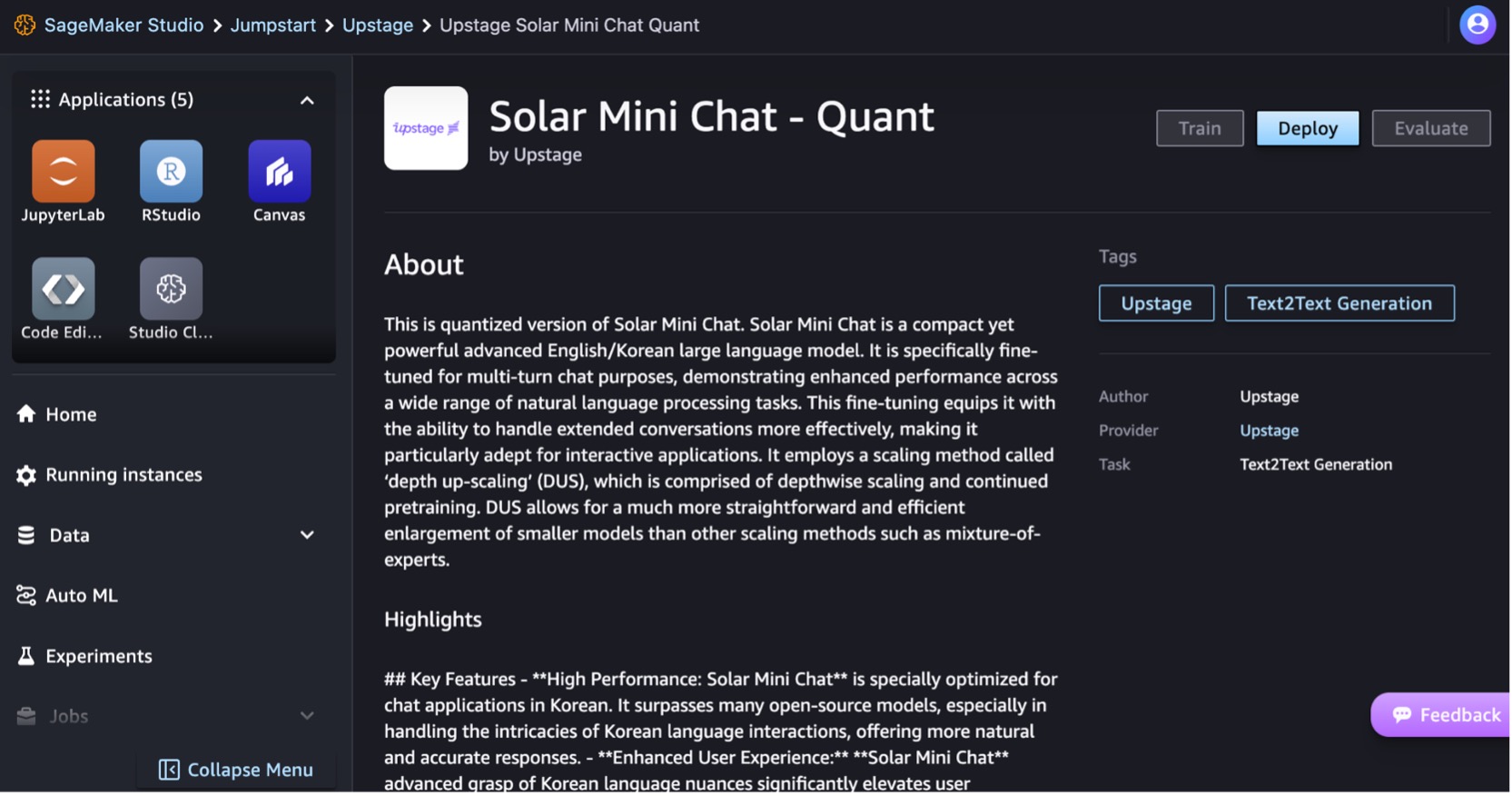

Du kan nå bruke Solar Mini Chat og Solar Mini Chat – Quant ferdigtrente modeller innen SageMaker JumpStart. SageMaker JumpStart er maskinlæringssenteret (ML) til SageMaker som gir tilgang til grunnmodeller i tillegg til innebygde algoritmer for å hjelpe deg raskt å komme i gang med ML.

I dette innlegget går vi gjennom hvordan du oppdager og distribuerer Solar-modellen via SageMaker JumpStart.

Hva er Solar-modellen?

Solar er en kompakt og kraftig modell for engelsk og koreansk språk. Den er spesifikt finjustert for multi-turn chat formål, og demonstrerer forbedret ytelse på tvers av et bredt spekter av naturlig språkbehandlingsoppgaver.

Solar Mini Chat-modellen er basert på Solar 10.7B, med en 32-lags Lama 2 struktur, og initialisert med ferdigtrente vekter fra Mistral 7B kompatibel med Llama 2-arkitekturen. Denne finjusteringen utstyrer den med muligheten til å håndtere utvidede samtaler mer effektivt, noe som gjør den spesielt egnet for interaktive applikasjoner. Den bruker en skaleringsmetode kalt dybdeoppskalering (DUS), som består av dybdemessig skalering og fortsatt fortrening. DUS gir mulighet for en mye mer grei og effektiv forstørrelse av mindre modeller enn andre skaleringsmetoder som f.eks. blanding av eksperter (MoE).

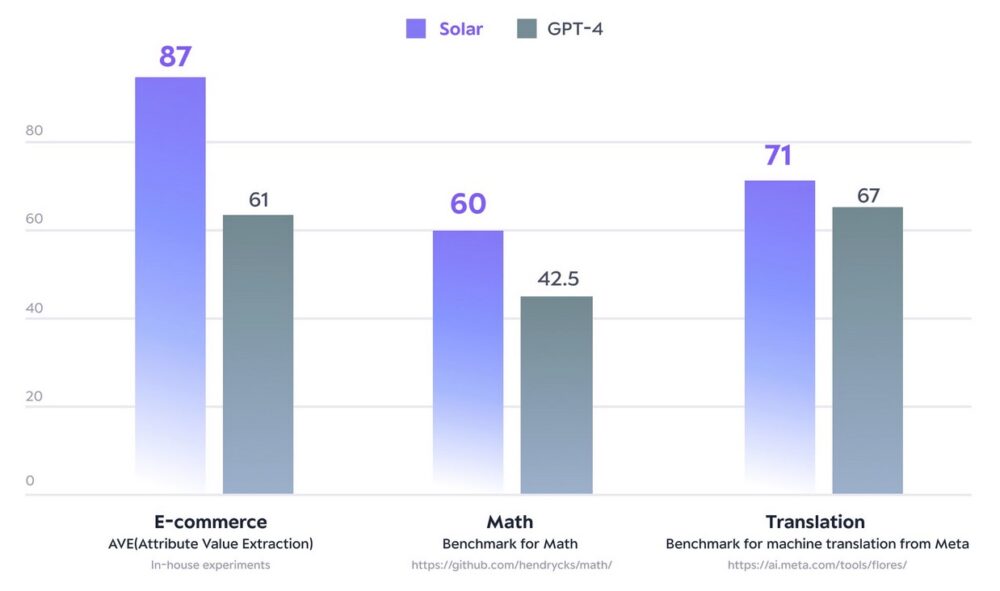

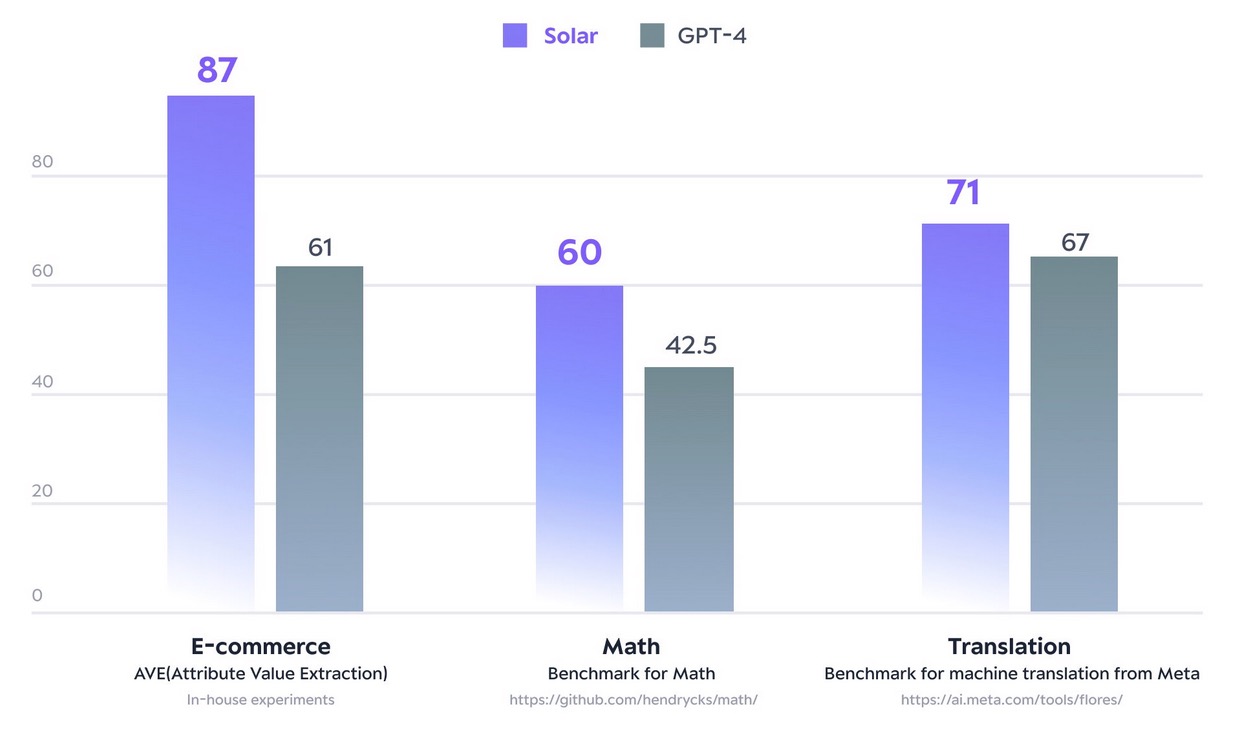

I desember 2023 laget Solar 10.7B-modellen bølger ved å nå toppen av Åpne LLM Leaderboard av Hugging Face. Ved å bruke betydelig færre parametere leverer Solar 10.7B svar som kan sammenlignes med GPT-3.5, men er 2.5 ganger raskere. Sammen med å toppe Open LLM Leaderboard, overgår Solar 10.7B GPT-4 med spesialtrente modeller på visse domener og oppgaver.

Følgende figur illustrerer noen av disse beregningene:

Med SageMaker JumpStart kan du distribuere Solar 10.7B-baserte forhåndstrente modeller: Solar Mini Chat og en kvantisert versjon av Solar Mini Chat, optimalisert for chatteapplikasjoner på engelsk og koreansk. Solar Mini Chat-modellen gir et avansert grep om koreanske språknyanser, noe som hever brukerinteraksjoner i chatmiljøer betydelig. Den gir presise svar på brukerinndata, og sikrer klarere kommunikasjon og mer effektiv problemløsning i engelske og koreanske chatteapplikasjoner.

Kom i gang med Solar-modeller i SageMaker JumpStart

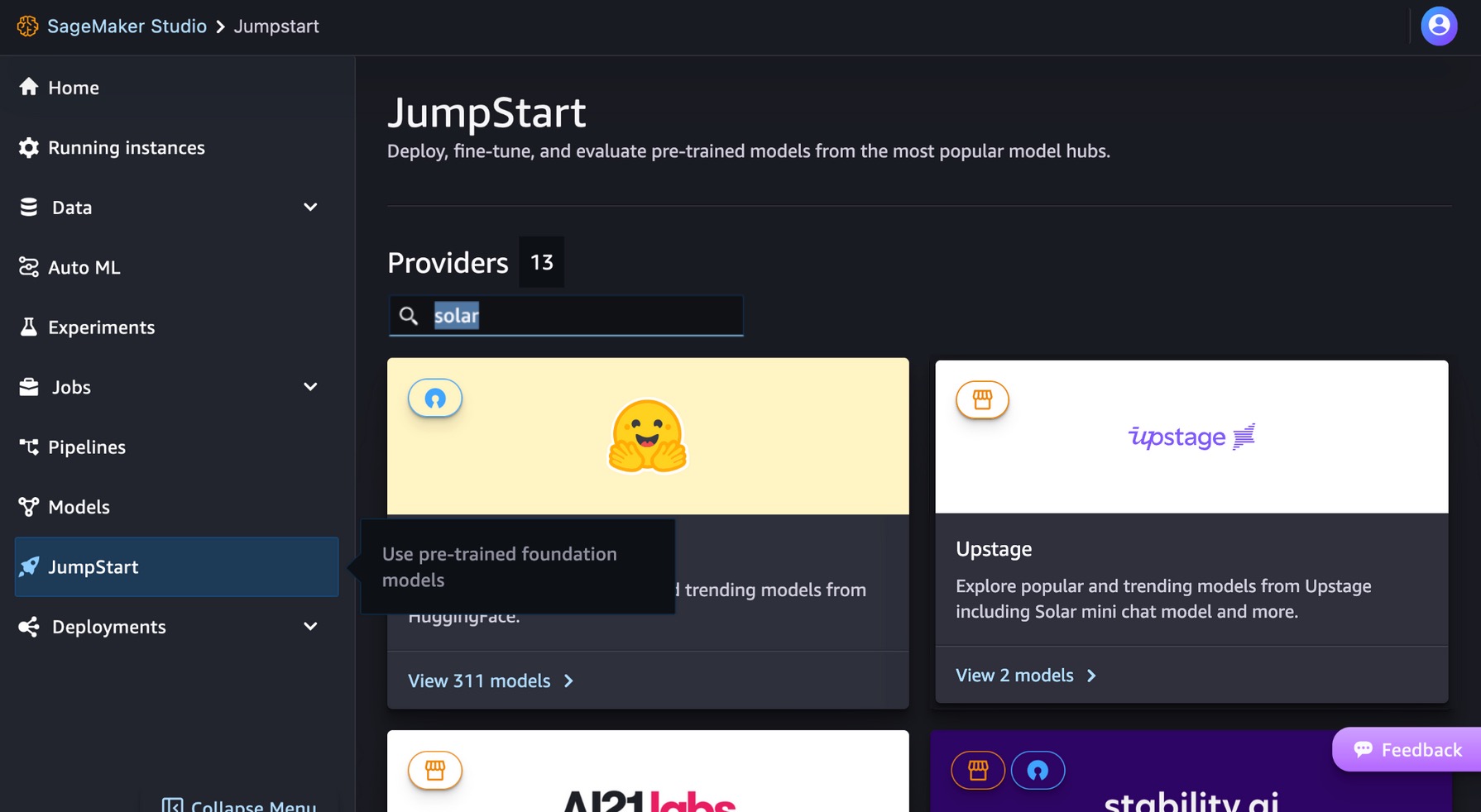

For å komme i gang med Solar-modeller kan du bruke SageMaker JumpStart, en fullstendig administrert ML-hub-tjeneste for å distribuere forhåndsbygde ML-modeller i et produksjonsklart vertsmiljø. Du kan få tilgang til Solar-modeller gjennom SageMaker JumpStart i Amazon SageMaker Studio, et nettbasert integrert utviklingsmiljø (IDE) hvor du kan få tilgang til spesialbygde verktøy for å utføre alle ML-utviklingstrinn, fra å forberede data til å bygge, trene og distribuere ML-modellene dine.

På SageMaker Studio-konsollen velger du tjuvstart i navigasjonsruten. Du kan skrive inn «solar» i søkefeltet for å finne Upstages solcellemodeller.

La oss distribuere Solar Mini Chat – Quant-modellen. Velg modellkortet for å se detaljer om modellen, for eksempel lisensen, data som brukes til å trene, og hvordan du bruker modellen. Du finner også en Distribuer alternativet, som tar deg til en landingsside der du kan teste slutninger med et eksempel på nyttelast.

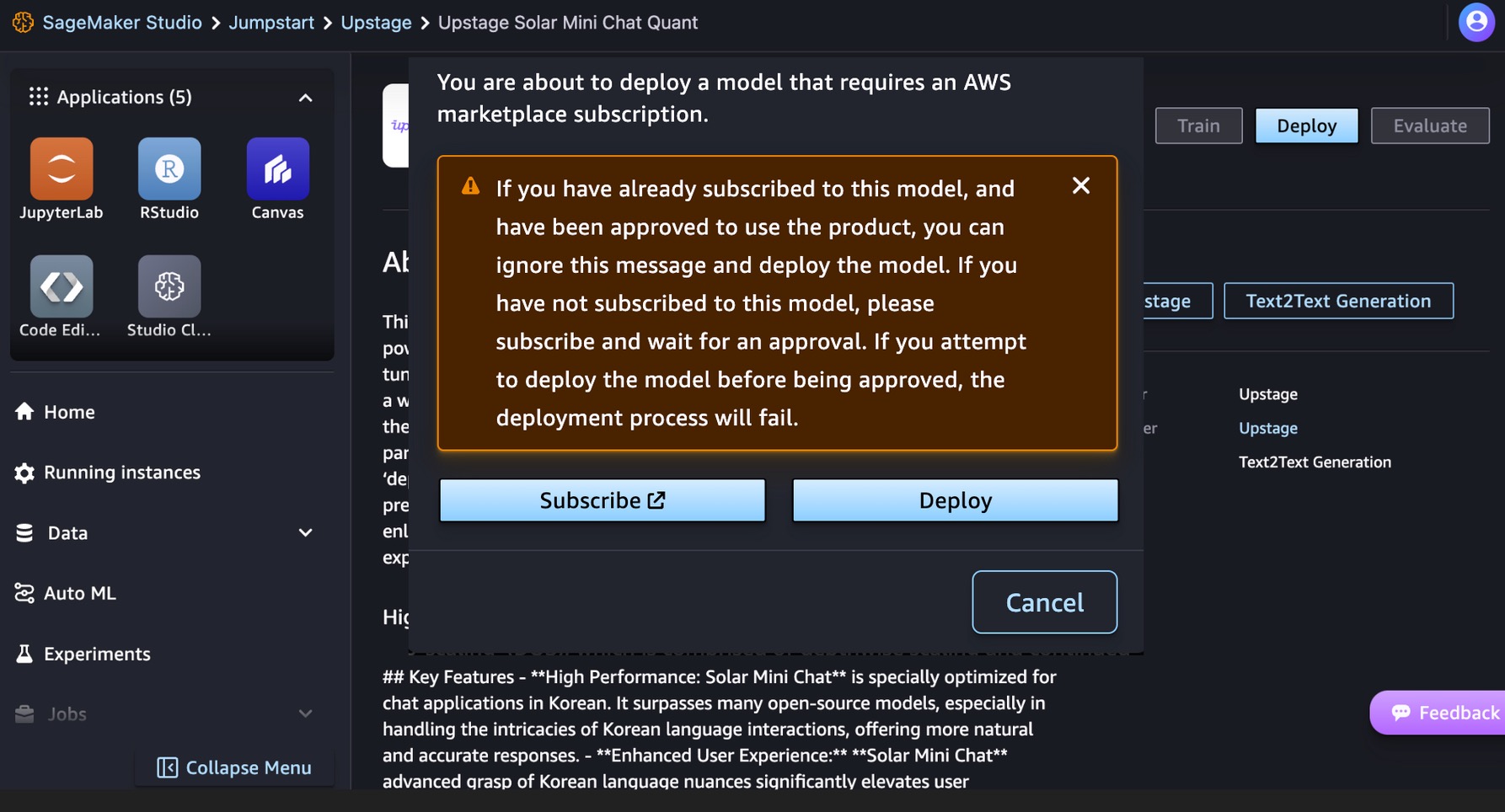

Denne modellen krever en AWS Marketplace abonnement. Hvis du allerede har abonnert på denne modellen, og har blitt godkjent for å bruke produktet, kan du distribuere modellen direkte.

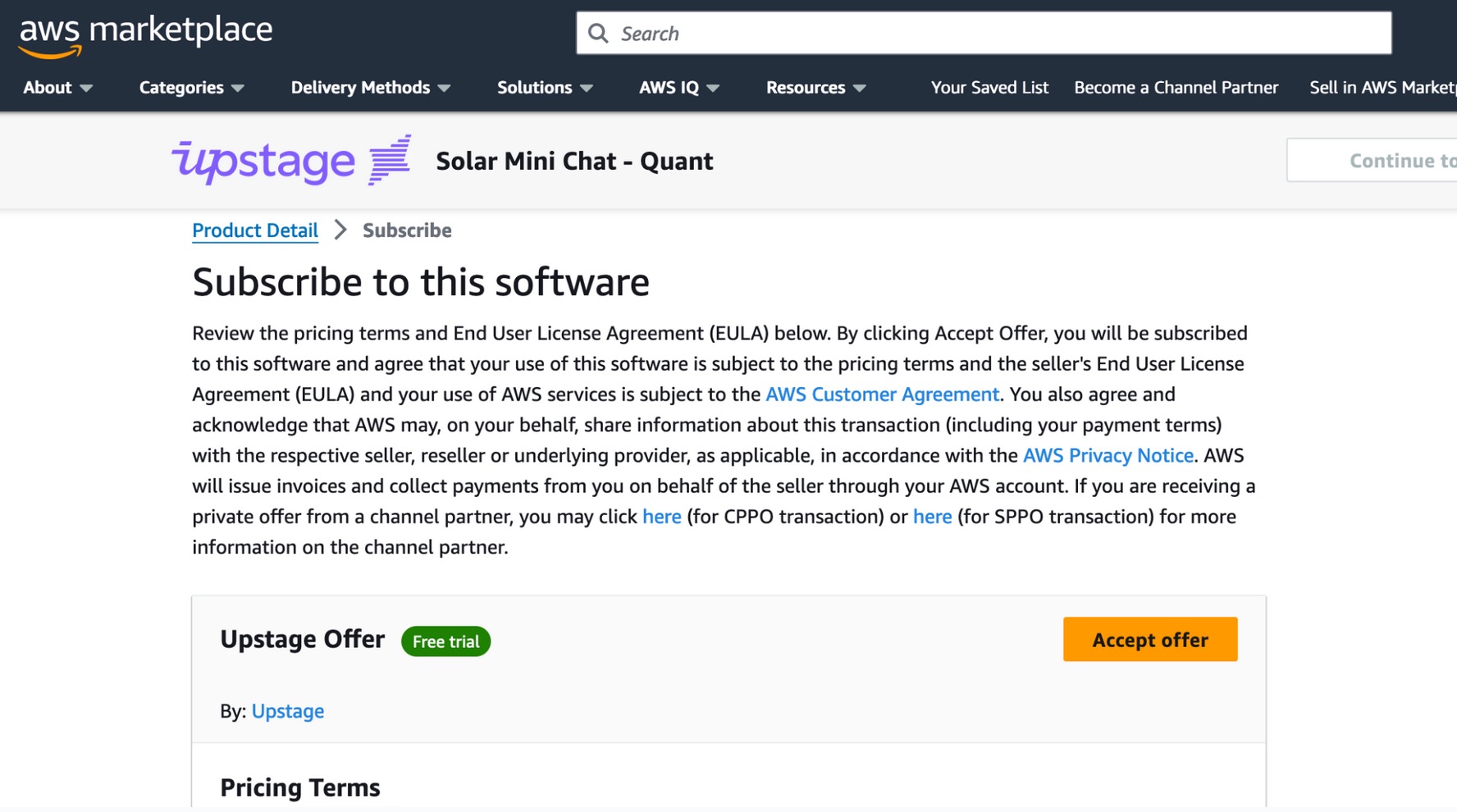

Hvis du ikke har abonnert på denne modellen, velg Bli medlem!, gå til AWS Marketplace, se gjennom prisvilkårene og sluttbrukerlisensavtalen (EULA), og velg Ta i mot tilbudet.

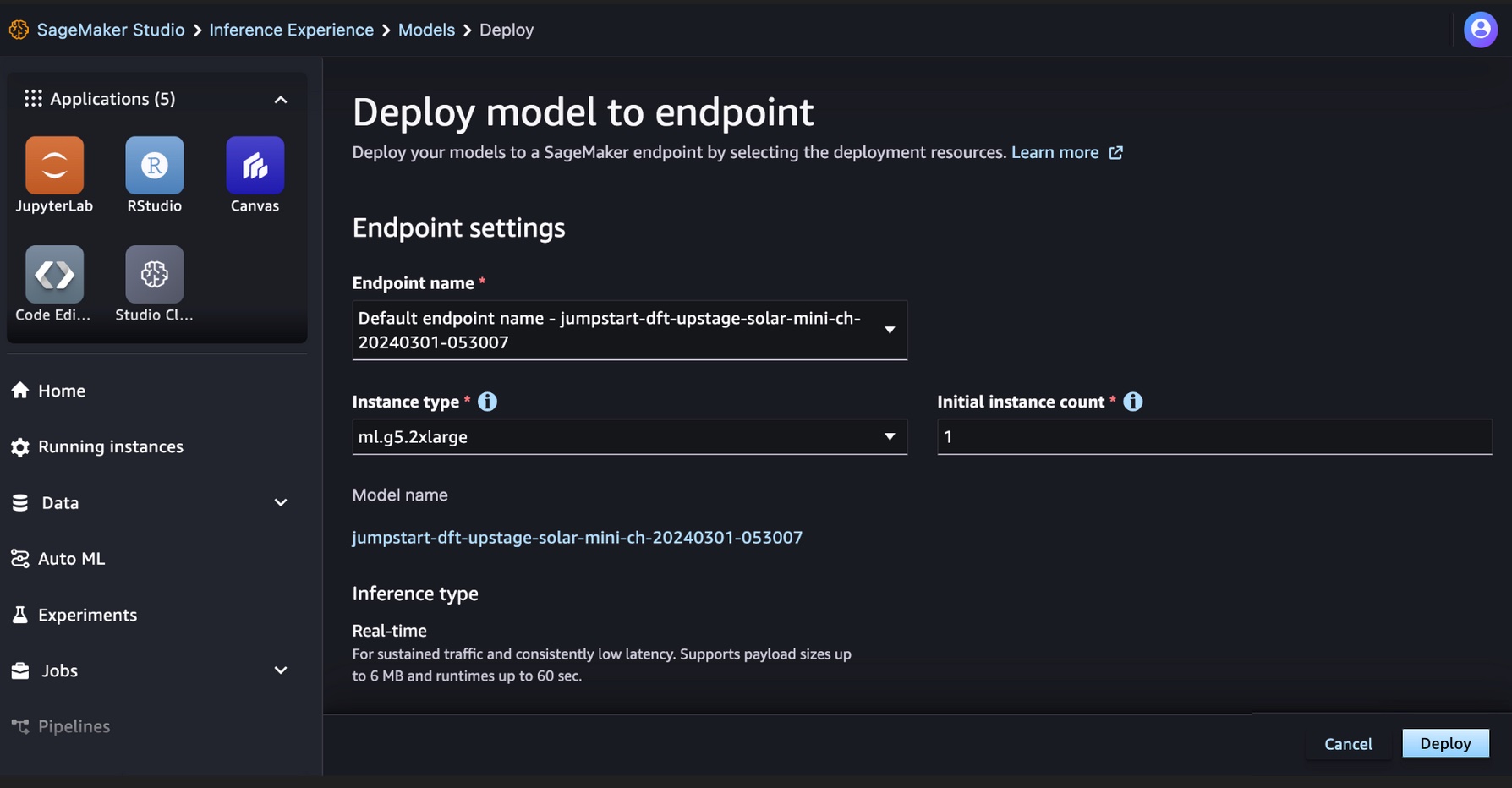

Etter at du har abonnert på modellen, kan du distribuere modellen til et SageMaker-endepunkt ved å velge distribusjonsressursene, for eksempel forekomsttype og innledende forekomstantall. Velge Distribuer og vent et endepunkt som skal opprettes for modellslutningen. Du kan velge en ml.g5.2xlarge eksempel som et billigere alternativ for slutning med Solar-modellen.

Når SageMaker-endepunktet er opprettet, kan du teste det gjennom de forskjellige SageMaker-applikasjonsmiljøene.

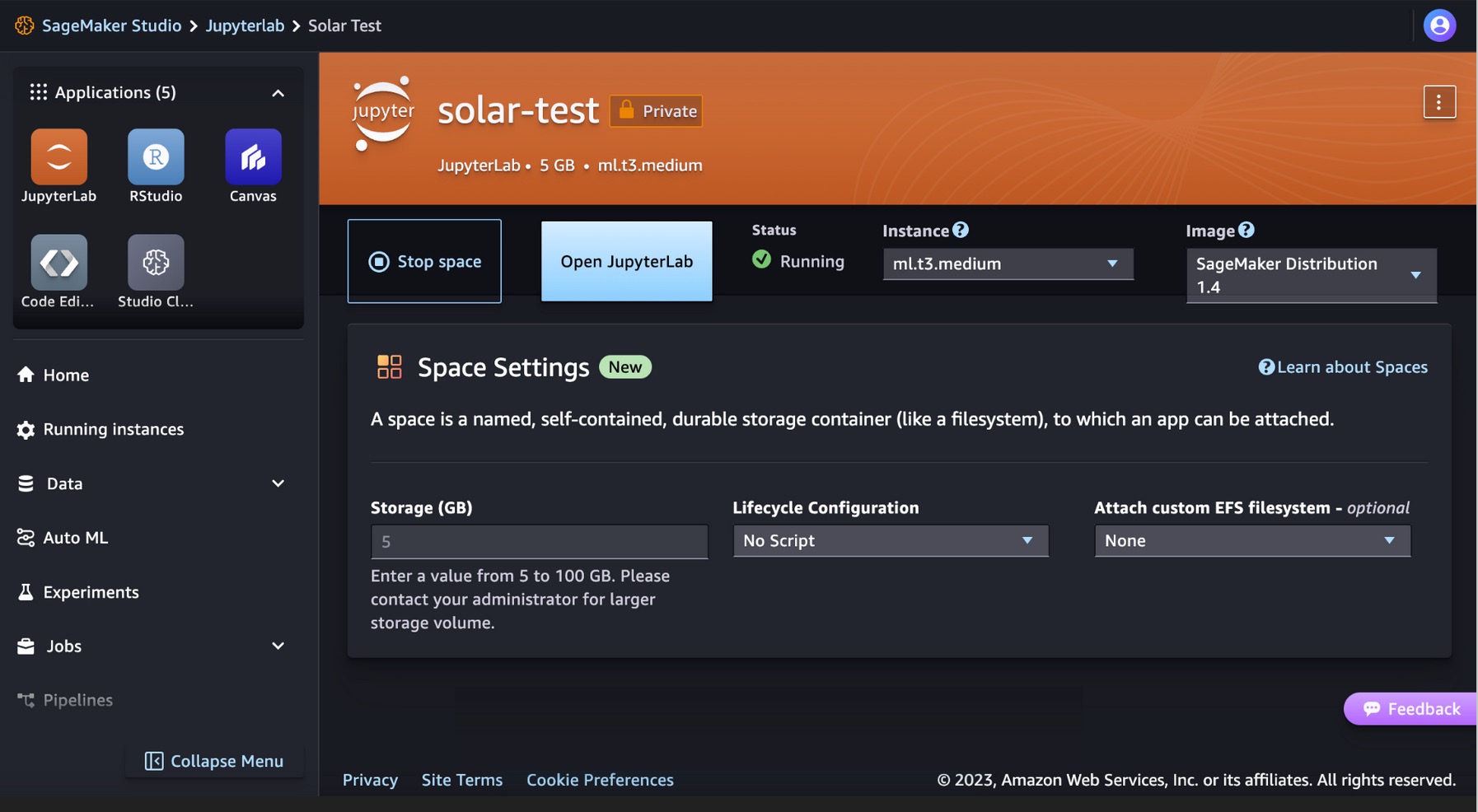

Kjør koden din for Solar-modeller i SageMaker Studio JupyterLab

SageMaker Studio støtter ulike applikasjonsutviklingsmiljøer, inkludert JupyterLab, et sett med funksjoner som forsterker det fullt administrerte notebooktilbudet. Den inkluderer kjerner som starter på sekunder, en forhåndskonfigurert kjøretid med populær datavitenskap, ML-rammeverk og høyytelses privat blokklagring. For mer informasjon, se SageMaker JupyterLab.

Opprett en JupyterLab-plass i SageMaker Studio som administrerer lagrings- og dataressursene som trengs for å kjøre JupyterLab-applikasjonen.

Du kan finne koden som viser distribusjonen av Solar-modeller på SageMaker JumpStart og et eksempel på hvordan du bruker den utplasserte modellen i GitHub repo. Du kan nå distribuere modellen ved å bruke SageMaker JumpStart. Følgende kode bruker standardforekomsten ml.g5.2xlarge for endepunktet for Solar Mini Chat – Quant-modellinferens.

Solcellemodeller støtter en forespørsel/svar nyttelast som er kompatibel med OpenAIs Chat-fullføringsendepunkt. Du kan teste eksempler på chat med én sving eller flere svinger med Python.

# Get a SageMaker endpoint

sagemaker_runtime = boto3.client("sagemaker-runtime")

endpoint_name = sagemaker.utils.name_from_base(model_name)

# Multi-turn chat prompt example

input = {

"messages": [

{

"role": "system",

"content": "You are a helpful assistant."

},

{

"role": "user",

"content": "Can you provide a Python script to merge two sorted lists?"

},

{

"role": "assistant",

"content": """Sure, here is a Python script to merge two sorted lists:

```python

def merge_lists(list1, list2):

return sorted(list1 + list2)

```

"""

},

{

"role": "user",

"content": "Can you provide an example of how to use this function?"

}

]

}

# Get response from the model

response = sagemaker_runtime.invoke_endpoint(EndpointName=endpoint_name, ContentType='application/json', Body=json.dumps (input))

result = json.loads(response['Body'].read().decode())

print resultDu har vellykket utført en sanntidsslutning med Solar Mini Chat-modellen.

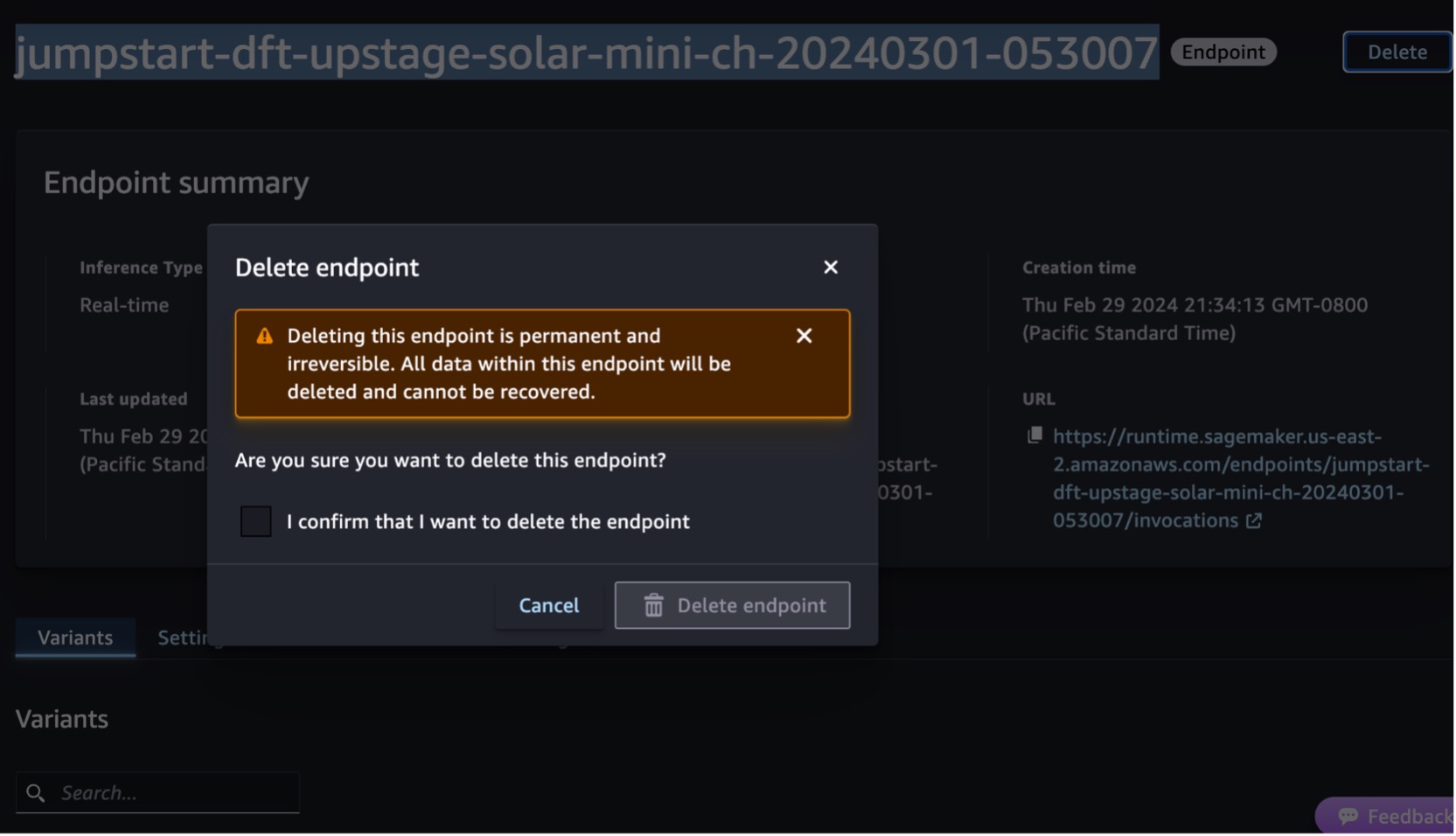

Rydd opp

Etter at du har testet endepunktet, slett SageMaker-slutningsendepunktet og slett modellen for å unngå kostnader.

Du kan også kjøre følgende kode for å slette endepunktet og modusen i notatboken til SageMaker Studio JupyterLab:

# Delete the endpoint

model.sagemaker_session.delete_endpoint(endpoint_name)

model.sagemaker_session.delete_endpoint_config(endpoint_name)

# Delete the model

model.delete_model()For mer informasjon, se Slett endepunkter og ressurser. I tillegg kan du slå av SageMaker Studio-ressursene som ikke lenger er nødvendig.

konklusjonen

I dette innlegget viste vi deg hvordan du kommer i gang med Upstages Solar-modeller i SageMaker Studio og distribuerer modellen for inferens. Vi viste deg også hvordan du kan kjøre Python-eksempelkoden på SageMaker Studio JupyterLab.

Fordi Solar-modeller allerede er forhåndsopplært, kan de bidra til å redusere trenings- og infrastrukturkostnadene og muliggjøre tilpasning for dine generative AI-applikasjoner.

Prøv det på SageMaker JumpStart-konsoll or SageMaker Studio-konsoll! Du kan også se følgende video, Prøv "Solar" med Amazon SageMaker.

Denne veiledningen er kun til informasjonsformål. Du bør fortsatt utføre din egen uavhengige vurdering, og iverksette tiltak for å sikre at du overholder dine egne spesifikke kvalitetskontrollpraksiser og standarder, og de lokale reglene, lovene, forskriftene, lisensene og bruksvilkårene som gjelder deg, innholdet ditt, og tredjepartsmodellen det refereres til i denne veiledningen. AWS har ingen kontroll eller autoritet over tredjepartsmodellen det refereres til i denne veiledningen, og gir ingen representasjoner eller garantier for at tredjepartsmodellen er sikker, virusfri, operativ eller kompatibel med ditt produksjonsmiljø og standarder. AWS gir ingen representasjoner, garantier eller garanterer at informasjon i denne veiledningen vil resultere i et bestemt resultat eller resultat.

Om forfatterne

Channy Yun er en hovedutvikleradvokat hos AWS, og brenner for å hjelpe utviklere med å bygge moderne applikasjoner på de nyeste AWS-tjenestene. Han er en pragmatisk utvikler og blogger i hjertet, og han elsker fellesskapsdrevet læring og deling av teknologi.

Channy Yun er en hovedutvikleradvokat hos AWS, og brenner for å hjelpe utviklere med å bygge moderne applikasjoner på de nyeste AWS-tjenestene. Han er en pragmatisk utvikler og blogger i hjertet, og han elsker fellesskapsdrevet læring og deling av teknologi.

Hwalsuk Lee er Chief Technology Officer (CTO) i Upstage. Han har jobbet for Samsung Techwin, NCSOFT og Naver som AI-forsker. Han forfølger sin doktorgrad i data- og elektroteknikk ved Korea Advanced Institute of Science and Technology (KAIST).

Hwalsuk Lee er Chief Technology Officer (CTO) i Upstage. Han har jobbet for Samsung Techwin, NCSOFT og Naver som AI-forsker. Han forfølger sin doktorgrad i data- og elektroteknikk ved Korea Advanced Institute of Science and Technology (KAIST).

Brandon Lee er Senior Solutions Architect i AWS, og hjelper først og fremst store utdanningsteknologikunder i offentlig sektor. Han har over 20 års erfaring med å lede applikasjonsutvikling hos globale selskaper og store selskaper.

Brandon Lee er Senior Solutions Architect i AWS, og hjelper først og fremst store utdanningsteknologikunder i offentlig sektor. Han har over 20 års erfaring med å lede applikasjonsutvikling hos globale selskaper og store selskaper.

- SEO-drevet innhold og PR-distribusjon. Bli forsterket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk deg selv. Tilgang her.

- PlatoAiStream. Web3 Intelligence. Kunnskap forsterket. Tilgang her.

- PlatoESG. Karbon, CleanTech, Energi, Miljø, Solenergi, Avfallshåndtering. Tilgang her.

- PlatoHelse. Bioteknologisk og klinisk etterretning. Tilgang her.

- kilde: https://aws.amazon.com/blogs/machine-learning/solar-models-from-upstage-are-now-available-in-amazon-sagemaker-jumpstart/

- : har

- :er

- :ikke

- :hvor

- 10

- 120

- 152

- 20

- 20 år

- 2023

- 7

- 990

- a

- evne

- Om oss

- Aksepterer

- adgang

- tvers

- tillegg

- I tillegg

- dyktig

- avansert

- advokat

- Avtale

- AI

- algoritmer

- Alle

- tillater

- langs

- allerede

- også

- Amazon

- Amazon SageMaker

- Amazon SageMaker JumpStart

- Amazon Web Services

- an

- og

- og infrastruktur

- Kunngjøre

- noen

- Søknad

- Applikasjonutvikling

- søknader

- Påfør

- godkjent

- arkitektur

- ER

- AS

- evaluering

- Assistent

- At

- øke

- myndighet

- tilgjengelig

- unngå

- AWS

- AWS Marketplace

- Bar

- basert

- BE

- vært

- Blokker

- Blogg

- kroppen

- Brandon

- bygge

- Bygning

- innebygd

- men

- by

- som heter

- CAN

- evner

- kort

- viss

- avgifter

- chatte

- billigere

- sjef

- Chief Technology Officer

- Velg

- tydeligere

- kode

- Kommunikasjon

- Samfunnsdrevet

- kompakt

- Selskaper

- sammenlign

- kompatibel

- ferdigstillelse

- overholde

- Omfattet

- Beregn

- datamaskin

- Konsoll

- innhold

- fortsatte

- kontroll

- samtaler

- Corporations

- Kostnader

- telle

- skape

- opprettet

- CTO

- Kunder

- tilpasning

- dato

- datavitenskap

- Desember

- Misligholde

- leverer

- demonstrere

- utplassere

- utplassert

- utplasserings

- distribusjon

- detaljer

- utviklet

- Utvikler

- utviklere

- Utvikling

- direkte

- oppdage

- gjør

- domener

- ned

- pedagogisk

- effektivt

- effektiv

- løfter

- anvender

- muliggjøre

- slutt

- Endpoint

- Ingeniørarbeid

- Engelsk

- forbedret

- sikre

- sikrer

- Enter

- Miljø

- miljøer

- eksempel

- eksempler

- opphisset

- erfaring

- utvidet

- Face

- raskere

- færre

- Figur

- Finn

- etter

- Til

- Fundament

- rammer

- fra

- fullt

- funksjon

- generative

- Generativ AI

- få

- Global

- Go

- gripe

- garantier

- veiledning

- håndtere

- Ha

- he

- Hjerte

- hjelpe

- nyttig

- hjelpe

- hjelper

- her.

- høy ytelse

- hans

- vert

- Hvordan

- Hvordan

- HTML

- HTTPS

- Hub

- if

- illustrerer

- in

- inkluderer

- Inkludert

- uavhengig

- informasjon

- Informativ

- Infrastruktur

- innledende

- inngang

- innganger

- f.eks

- Institute

- integrert

- interaksjoner

- interaktiv

- inn

- IT

- DET ER

- jpg

- JSON

- korea

- Koreansk

- landing

- Språk

- språk

- stor

- siste

- Lover

- leaderboard

- ledende

- læring

- Lee

- Tillatelse

- lisenser

- lister

- Llama

- LLM

- lokal

- lenger

- elsker

- lavere

- maskin

- maskinlæring

- laget

- gjøre

- Making

- fikk til

- forvalter

- markedsplass

- målinger

- Flett

- meldinger

- Meta

- metode

- metoder

- Metrics

- ML

- Mote

- modell

- modeller

- Moderne

- mer

- mer effektivt

- mye

- Naturlig

- Natural Language Processing

- Naver

- Navigasjon

- nødvendig

- Nei.

- spesielt

- bærbare

- nå

- skyggelegging

- of

- tilby

- tilby

- Offiser

- on

- bare

- åpen

- operasjonell

- optimalisert

- Alternativ

- or

- Annen

- ut

- Utfallet

- utkonkurrerer

- enn

- egen

- side

- brød

- parametere

- Spesielt

- spesielt

- lidenskapelig

- Utfør

- ytelse

- utført

- phd

- bilde

- høydepunkt

- plato

- Platon Data Intelligence

- PlatonData

- Populær

- Post

- kraftig

- praksis

- pragmatisk

- presis

- forbereder

- prising

- primært

- Principal

- Skrive ut

- privat

- Problem

- prosessering

- Produkt

- Produksjon

- gi

- gir

- offentlig

- formål

- Python

- kvalitet

- som

- raskt

- område

- nå

- ekte

- sanntids

- poster

- refererte

- forskrifter

- påkrevd

- Krever

- forsker

- oppløsning

- Ressurser

- svar

- svar

- resultere

- retur

- anmeldelse

- Rolle

- regler

- Kjør

- runtime

- sagemaker

- SageMaker Inference

- sample

- Samsung

- skalering

- Vitenskap

- Vitenskap og teknologi

- script

- Søk

- sekunder

- sektor

- sikre

- se

- velg

- velge

- senior

- tjeneste

- Tjenester

- sett

- deling

- bør

- viste

- viser

- betydelig

- Størrelse

- mindre

- solenergi

- Solutions

- noen

- Rom

- spesialister

- spesifikk

- spesielt

- standarder

- Begynn

- startet

- Steps

- Still

- lagring

- rett fram

- struktur

- studio

- abonnere

- abonnement

- vellykket

- slik

- støtte

- Støtter

- sikker

- system

- Ta

- tar

- oppgaver

- Teknologi

- vilkår

- test

- testet

- enn

- Det

- De

- Disse

- de

- tredjeparts

- denne

- Gjennom

- tid

- ganger

- til

- verktøy

- spor

- Tog

- Kurs

- to

- typen

- bruke

- brukt

- Bruker

- bruker

- ved hjelp av

- ulike

- allsidig

- versjon

- av

- video

- Se

- vente

- gå

- garantier

- Se

- bølger

- we

- web

- webtjenester

- Web-basert

- hvilken

- bred

- Bred rekkevidde

- vil

- med

- innenfor

- arbeidet

- år

- Du

- Din

- youtube

- zephyrnet