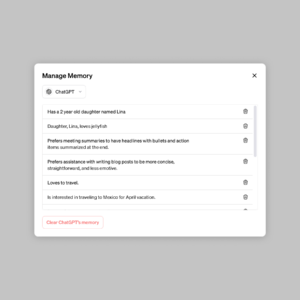

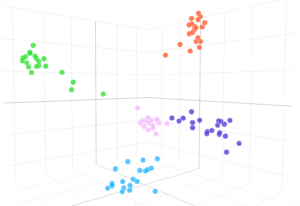

Vi viser at en GPT-3-modell kan lære å uttrykke usikkerhet om sine egne svar på naturlig språk – uten bruk av modelllogitter. Når det gis et spørsmål, genererer modellen både et svar og et tillitsnivå (f.eks. "90 % konfidens" eller "høy konfidens"). Disse nivåene kartlegges til sannsynligheter som er godt kalibrert. Modellen forblir også moderat kalibrert under distribusjonsskifte, og er følsom for usikkerhet i sine egne svar, i stedet for å imitere menneskelige eksempler. Så vidt vi vet er dette første gang en modell har vist seg å uttrykke kalibrert usikkerhet om egne svar på naturlig språk. For å teste kalibrering introduserer vi CalibratedMath-pakken med oppgaver. Vi sammenligner kalibreringen av usikkerhet uttrykt i ord ("verbalisert sannsynlighet") med usikkerhet hentet fra modelllogitter. Begge typer usikkerhet er i stand til å generalisere kalibrering under distribusjonsskifte. Vi gir også bevis på at GPT-3s evne til å generalisere kalibrering avhenger av ferdigtrente latente representasjoner som korrelerer med epistemisk usikkerhet om svarene.

- SEO-drevet innhold og PR-distribusjon. Bli forsterket i dag.

- Platoblokkkjede. Web3 Metaverse Intelligence. Kunnskap forsterket. Tilgang her.

- kilde: https://openai.com/research/teaching-models-to-express-their-uncertainty-in-words

- :er

- a

- evne

- Om oss

- og

- besvare

- svar

- ER

- CAN

- stand

- sammenligne

- selvtillit

- avhenger

- distribusjon

- e

- bevis

- eksempler

- ekspress

- uttrykte

- Først

- første gang

- Til

- fra

- genererer

- gitt

- Høy

- HTTPS

- menneskelig

- in

- introdusere

- DET ER

- kunnskap

- Språk

- LÆRE

- Nivå

- nivåer

- kart

- modell

- modeller

- Naturlig

- of

- on

- egen

- plato

- Platon Data Intelligence

- PlatonData

- gi

- spørsmål

- heller

- forblir

- s

- sensitive

- skift

- Vis

- vist

- suite

- oppgaver

- Undervisning

- Testing

- Det

- De

- deres

- Disse

- tid

- til

- Usikkerhet

- etter

- bruke

- VI VIL

- med

- ord

- zephyrnet