Wykrywanie stronniczości w danych i wynikach modeli jest podstawowym wymogiem do budowania odpowiedzialnych modeli sztucznej inteligencji (AI) i uczenia maszynowego (ML). Niestety, wykrywanie błędu systematycznego nie jest łatwym zadaniem dla ogromnej większości praktyków ze względu na dużą liczbę sposobów jego pomiaru i różne czynniki, które mogą przyczynić się do tendencyjnego wyniku. Na przykład niezrównoważone próbkowanie danych uczących może skutkować modelem, który jest mniej dokładny dla pewnych podzbiorów danych. Błąd może być również wprowadzony przez sam algorytm ML — nawet przy dobrze zrównoważonym zbiorze danych treningowych wyniki mogą faworyzować pewne podzbiory danych w porównaniu z innymi.

Aby wykryć stronniczość, musisz dokładnie zrozumieć różne rodzaje stronniczości i odpowiadające im wskaźniki stronniczości. Na przykład w chwili pisania tego tekstu Amazon SageMaker Wyjaśnij oferuje 21 różnych metryk do wyboru.

W tym poście używamy przypadku użycia prognozy dochodów (przewidywanie dochodów użytkowników z funkcji wejściowych, takich jak edukacja i liczba przepracowanych godzin w tygodniu), aby zademonstrować różne rodzaje błędów systematycznych i odpowiadające im wskaźniki w SageMaker Clarify. Opracowujemy również strukturę, która pomoże Ci zdecydować, które metryki mają znaczenie dla Twojej aplikacji.

Wprowadzenie do SageMaker Clarify

Modele ML są coraz częściej wykorzystywane do podejmowania decyzji w różnych dziedzinach, takich jak usługi finansowe, opieka zdrowotna, edukacja i zasoby ludzkie. W wielu sytuacjach ważne jest, aby zrozumieć, dlaczego model ML dokonał określonej prognozy, a także czy na prognozy wpłynęło błąd systematyczny.

SageMaker Clarify zapewnia narzędzia dla obu tych potrzeb, ale w tym poście skupiamy się tylko na funkcji wykrywania stronniczości. Aby dowiedzieć się więcej o wyjaśnianiu, sprawdź Wyjaśnianie faktów dotyczących meczów Bundesligi xGoals przy użyciu Amazon SageMaker Clarify.

SageMaker Clarify jest częścią Amazon Sage Maker, która jest w pełni zarządzaną usługą do tworzenia, trenowania i wdrażania modeli ML.

Przykłady pytań o stronniczość

Aby ugruntować dyskusję, poniżej znajdują się przykładowe pytania, które mogą zadać twórcy ML i ich interesariusze dotyczące stronniczości. Lista składa się z kilku ogólnych pytań, które mogą mieć znaczenie dla kilku aplikacji ML, a także pytań dotyczących konkretnych aplikacji, takich jak odzyskiwanie dokumentów.

Mając na uwadze grupy zainteresowania danymi treningowymi (np. mężczyźni vs kobiety), możesz zapytać, jakich wskaźników powinienem użyć, aby odpowiedzieć na następujące pytania:

- Czy reprezentacja grupy w danych treningowych odzwierciedla świat rzeczywisty?

- Czy etykiety docelowe w danych treningowych faworyzują jedną grupę nad drugą, przypisując jej bardziej pozytywne etykiety?

- Czy model ma różną dokładność dla różnych grup?

- Czy w modelu, którego celem jest identyfikacja wykwalifikowanych kandydatów do zatrudnienia, model ma taką samą precyzję dla różnych grup?

- Czy w modelu, którego celem jest pobieranie dokumentów istotnych dla zapytania wejściowego, model pobiera odpowiednie dokumenty z różnych grup w tej samej proporcji?

W dalszej części tego postu opracowujemy schemat, w jaki sposób rozważyć udzielenie odpowiedzi na te i inne pytania za pomocą wskaźników dostępnych w SageMaker Clarify.

Przypadek użycia i kontekst

Ten post wykorzystuje istniejący przykład pracy SageMaker Clarify z Uczciwość i zrozumiałość dzięki notatnikowi SageMaker Clarify i wyjaśnia wygenerowane wartości metryki odchylenia. Notebook trenuje model XGBoost na Zbiór danych UCI dla dorosłych (Dua, D. i Graff, C. (2019). Repozytorium uczenia maszynowego UCI. Irvine, Kalifornia: Uniwersytet Kalifornijski, Szkoła Informacji i Informatyki).

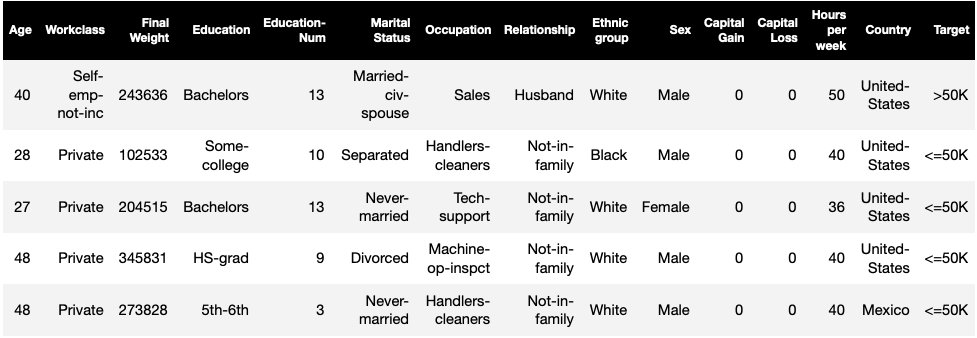

Zadaniem ML w tym zestawie danych jest przewidzenie, czy dana osoba ma roczny dochód w wysokości większej lub mniejszej niż 50,000 XNUMX USD. W poniższej tabeli przedstawiono niektóre wystąpienia wraz z ich funkcjami. Pomiar błędu w przewidywaniu dochodów jest ważny, ponieważ możemy wykorzystać te przewidywania do podejmowania decyzji, takich jak oferty rabatowe i marketing ukierunkowany.

Terminologia stronniczości

Zanim zagłębimy się głębiej, przyjrzyjmy się podstawowej terminologii. Aby zobaczyć pełną listę terminów, zobacz Amazon SageMaker Wyjaśnij warunki dotyczące stronniczości i uczciwości.

- Etykieta – Funkcja docelowa, do przewidywania której model ML jest trenowany. jakiś obserwowana etykieta odnosi się do wartości etykiety zaobserwowanej w danych wykorzystywanych do trenowania lub testowania modelu. A przewidywana etykieta to wartość przewidywana przez model ML. Etykiety mogą być binarne i często są zakodowane jako 0 i 1. Zakładamy, że 1 oznacza etykietę korzystną lub pozytywną (na przykład dochód wyższy lub równy 50,000 0 USD), a XNUMX oznacza etykietę niekorzystną lub negatywną. Etykiety mogą również składać się z więcej niż dwóch wartości. Nawet w tych przypadkach jedna lub więcej wartości stanowi korzystne etykiety. Dla uproszczenia ten post dotyczy tylko etykiet binarnych. Aby uzyskać szczegółowe informacje na temat obsługi etykiet z więcej niż dwiema wartościami i etykiet z wartościami ciągłymi (na przykład w regresji), zobacz Biuletyn informacyjny dotyczący uczciwości i wyjaśnialności AI w Amazon.

- Aspekt – Kolumna lub cecha, względem której mierzone jest odchylenie. W naszym przykładzie aspekt to

sexi przyjmuje dwie wartości:womaniman, zakodowany jakofemaleimalew danych (te dane pochodzą ze Spisu Powszechnego 1994 i wymuszają opcję binarną). Chociaż wpis dotyczy pojedynczego aspektu z tylko dwiema wartościami, w przypadku bardziej złożonych przypadków obejmujących wiele aspektów lub aspektów z więcej niż dwiema wartościami zobacz Biuletyn informacyjny dotyczący uczciwości i wyjaśnialności AI w Amazon. - stronniczość – Znacząca nierównowaga w danych wejściowych lub przewidywaniach modelu w różnych wartościach aspektu. To, co stanowi „istotne”, zależy od Twojej aplikacji. W przypadku większości metryk wartość 0 oznacza brak nierównowagi. Metryki stronniczości w SageMaker Clarify są podzielone na dwie kategorie:

- Trening wstępny – Jeśli występuje, odchylenie przedtreningowe wskazuje tylko na brak równowagi w danych.

- Poszkolenie – Błąd potreningowy dodatkowo uwzględnia przewidywania modeli.

Przyjrzyjmy się każdej kategorii osobno.

Stronniczość przedtreningowa

Wstępne uczenie metryk odchyleń w programie SageMaker Clarify odpowiada na następujące pytanie: Czy wszystkie wartości aspektów mają taką samą (lub podobną) reprezentację w danych? Ważne jest, aby sprawdzić dane pod kątem błędu przedtreningowego, ponieważ może to przełożyć się na błąd systematyczny po szkoleniu w przewidywaniach modelu. Na przykład model wyszkolony na niezrównoważonych danych, w którym jedna wartość aspektu pojawia się bardzo rzadko, może wykazywać znacznie gorszą dokładność dla tej wartości aspektu. Równą reprezentację można obliczyć w następujący sposób:

- Całe dane treningowe niezależnie od etykiet

- Podzbiór danych treningowych tylko z pozytywnymi etykietami

- Każda etykieta osobno

Poniższy rysunek przedstawia podsumowanie dopasowania poszczególnych metryk do każdej z trzech kategorii.

Niektóre kategorie składają się z więcej niż jednej metryki. Podstawowe metryki (szare pola) odpowiadają na pytanie o stronniczość w tej kategorii w najprostszej formie. Metryki w białych ramkach dodatkowo obejmują przypadki szczególne (na przykład paradoks Simpsona) i preferencje użytkownika (na przykład skupianie się na określonych częściach populacji podczas obliczania wydajności predykcyjnej).

Reprezentacja wartości aspektu niezależnie od etykiet

Jedyną metryką w tej kategorii jest niezbilansowanie klasy (CI). Celem tej metryki jest zmierzenie, czy wszystkie wartości aspektów mają równą reprezentację w danych.

CI to różnica w ułamku danych składających się na dwie wartości aspektu. W naszym przykładowym zbiorze danych dla aspektu sex, podział (przedstawiony na wykresie kołowym) pokazuje, że kobiety stanowią 32.4% danych treningowych, natomiast mężczyźni 67.6%. W rezultacie:

CI = 0.676 - 0.324 = 0.352

Poważnie wysoka nierównowaga klas może prowadzić do gorszej wydajności predykcyjnej dla wartości aspektu z mniejszą reprezentacją.

Reprezentacja wartości aspektu tylko na poziomie pozytywnych etykiet

Innym sposobem pomiaru równej reprezentacji jest sprawdzenie, czy wszystkie wartości aspektu zawierają podobną frakcję próbek z dodatnimi obserwowanymi etykietami. Etykiety pozytywne składają się z pozytywnych wyników (np. przyznana pożyczka, wybrana do pracy), więc analiza etykiet pozytywnych oddzielnie pomaga ocenić, czy korzystne decyzje są równomiernie rozłożone.

W naszym przykładowym zestawie danych obserwowane etykiety są podzielone na wartości dodatnie i ujemne, jak pokazano na poniższym rysunku.

11.4% wszystkich kobiet i 31.4% wszystkich mężczyzn ma etykietę pozytywną (ciemno zacieniony obszar na lewym i prawym słupku). Różnica w dodatnich proporcjach w etykietach (DPL) mierzy tę różnicę.

DPL = 0.314 - 0.114 = 0.20

Zaawansowana metryka w tej kategorii, warunkowa dysproporcja demograficzna w etykietach (CDDL), mierzy różnice w etykietach pozytywnych, ale rozwarstwia je względem innej zmiennej. Ta metryka pomaga kontrolować Paradoks Simpsona, przypadek, w którym obliczenia na całych danych wykazują błąd systematyczny, ale błąd ten znika podczas grupowania danych w odniesieniu do niektórych informacji ubocznych.

Połączenia 1973 UC Berkeley Studium przyjęć podaje przykład. Według danych częściej przyjmowano mężczyzn niż kobiety. Jednak w badaniu na poziomie poszczególnych wydziałów uczelni kobiety przyjmowane były z podobnym lub wyższym wskaźnikiem na każdym wydziale. Obserwację tę można wyjaśnić paradoksem Simpsona, który powstał tutaj, ponieważ kobiety aplikowały do szkół, które były bardziej konkurencyjne. W rezultacie ogółem przyjmowano mniej kobiet w porównaniu z mężczyznami, mimo że w poszczególnych szkołach przyjmowano je w podobnym lub wyższym stopniu.

Aby uzyskać więcej informacji na temat obliczania CDDL, zobacz Biuletyn informacyjny dotyczący uczciwości i wyjaśnialności AI w Amazon.

Reprezentacja wartości aspektu na poziomie każdej etykiety osobno

Równość w reprezentacji można również zmierzyć dla każdej etykiety, a nie tylko etykiety pozytywnej.

Metryki w tej kategorii obliczają różnicę w rozkładzie etykiet różnych wartości aspektów. Rozkład etykiety dla wartości aspektu zawiera wszystkie zaobserwowane wartości etykiety wraz z ułamkiem próbek z wartością tej etykiety. Na przykład na wykresie pokazującym rozkład etykiet, 88.6% kobiet ma etykietę zaobserwowaną negatywną, a 11.4% ma etykietę zaobserwowaną pozytywną. Zatem rozkład etykiety dla kobiet wynosi [0.886, 0.114], a dla mężczyzn [0.686, 0.314].

Podstawowa metryka w tej kategorii, dywergencja Kullbacka-Leiblera (KL), mierzy tę różnicę jako:

KL = [0.686 x log(0.686/0.886)] + [0.314 x log(0.314/0.114)] = 0.143

Zaawansowane metryki w tej kategorii, rozbieżność Jensena-Shannona (JS), norma Lp (LP), całkowita odległość zmienności (TVD) i Kołmogorowa-Smirnowa (KS), również mierzą różnicę między rozkładami, ale mają inne właściwości matematyczne. Z wyjątkiem szczególnych przypadków, dostarczą wglądu podobnego do KL. Na przykład, chociaż wartość KL może być nieskończonością, gdy wartość aspektu nie zawiera próbek z określonymi etykietami (na przykład żadnych mężczyzn z etykietą ujemną), JS unika tych nieskończonych wartości. Aby uzyskać więcej informacji na temat tych różnic, zobacz Biuletyn informacyjny dotyczący uczciwości i wyjaśnialności AI w Amazon.

Związek między DPL (kategoria 2) a metrykami opartymi na dystrybucji KL/JS/LP/TVD/KS (kategoria 3)

Metryki oparte na dystrybucji są bardziej naturalne w przypadku etykiet niebinarnych. W przypadku etykiet binarnych, ze względu na fakt, że niezbilansowanie w etykiecie dodatniej może być użyte do obliczenia niezbilansowania w etykiecie ujemnej, metryki dystrybucji dostarczają takich samych informacji jak DPL. Dlatego w takich przypadkach możesz po prostu użyć DPL.

Stronniczość poszkoleniowa

Wskaźniki odchyleń po treningu w programie SageMaker Clarify pomagają nam odpowiedzieć na dwa kluczowe pytania:

- Czy wszystkie wartości aspektów są reprezentowane w podobnym tempie w pozytywnych (korzystnych) prognozach modelu?

- Czy model ma podobną wydajność predykcyjną dla wszystkich wartości aspektów?

Poniższy rysunek pokazuje, w jaki sposób metryki są mapowane na każde z tych pytań. Drugie pytanie można dalej podzielić w zależności od etykiety, w odniesieniu do której mierzy się wydajność.

Równa reprezentacja w pozytywnych przewidywaniach modelu

Metryki w tej kategorii sprawdzają, czy wszystkie wartości aspektów zawierają podobny ułamek próbek z dodatnią przewidywaną etykietą przez model. Ta klasa metryk jest bardzo podobna do metryk przedtreningowych DPL i CDDL — jedyną różnicą jest to, że ta kategoria uwzględnia przewidywane etykiety zamiast obserwowanych etykiet.

W naszym przykładowym zbiorze danych 4.5% wszystkich kobiet ma przypisaną etykietę pozytywną przez model, a 13.7% wszystkich mężczyzn ma przypisaną etykietę pozytywną.

Podstawowa metryka w tej kategorii, różnica w proporcjach dodatnich w przewidywanych etykietach (DPPL), mierzy różnicę w przypisaniach klas dodatnich.

DPPL = 0.137 - 0.045 = 0.092

Zwróć uwagę, że w danych treningowych wyższy odsetek mężczyzn miał etykietę obserwowaną pozytywnie. W podobny sposób wyższy odsetek mężczyzn otrzymuje etykietę przewidywaną pozytywną.

Przechodząc do zaawansowanych metryk w tej kategorii, Disparate Impact (DI) mierzy tę samą rozbieżność w pozytywnych przypisaniach klas, ale zamiast różnicy oblicza stosunek:

DI = 0.045 / 0.137 = 0.328

Zarówno DI, jak i DPPL przekazują jakościowo podobne spostrzeżenia, ale różnią się w niektórych skrajnych przypadkach. Na przykład, stosunki mają tendencję do eksplodowania do bardzo dużych liczb, jeśli mianownik jest mały. Weźmy na przykład liczby 0.1 i 0.0001. Stosunek wynosi 0.1/0.0001 = 10,000 0.1, a różnica 0.0001 – 0.1 ≈ 0. W przeciwieństwie do innych metryk, w których wartość 1 oznacza brak odchylenia, w przypadku DI brak odchylenia odpowiada wartości XNUMX.

Warunkowa rozbieżność demograficzna w przewidywanych etykietach (CDDPL) mierzy rozbieżność w reprezentacji wartości aspektu w etykiecie dodatniej, ale podobnie jak metryka przedtreningowa CDDL, kontroluje również paradoks Simpsona.

Kontrfaktyczny test Fliptest (FT) mierzy, czy podobne próbki z dwóch wartości aspektu otrzymują podobne decyzje z modelu. Model przypisujący różne decyzje dwóm próbkom, które są do siebie podobne, ale różnią się wartościami aspektu, można uznać za tendencyjny w stosunku do wartości aspektu, której przypisano etykietę niekorzystną (negatywną). Biorąc pod uwagę pierwszą wartość aspektu (kobiety), ocenia, czy podobni członkowie z drugą wartością aspektu (mężczyźni) mają inną prognozę modelu. Podobne elementy są wybierane na podstawie algorytmu k-najbliższego sąsiada.

Równa wydajność

Prognozy modelu mogą mieć podobną reprezentację w pozytywnych etykietach z różnych wartości aspektów, ale wydajność modelu w tych grupach może się znacznie różnić. W wielu aplikacjach pożądane może być posiadanie podobnej wydajności predykcyjnej dla różnych wartości aspektów. Metryki w tej kategorii mierzą różnicę w wydajności predykcyjnej w różnych wartościach aspektów.

Ponieważ dane można podzielić na wiele różnych sposobów na podstawie zaobserwowanych lub przewidywanych etykiet, istnieje wiele różnych sposobów mierzenia predykcyjnej wydajności.

Równa wydajność predykcyjna niezależnie od etykiet

Możesz wziąć pod uwagę wydajność modelu na całych danych, niezależnie od obserwowanych lub przewidywanych etykiet – czyli ogólnej dokładności.

Poniższe rysunki pokazują, jak model klasyfikuje dane wejściowe z dwóch wartości aspektów w naszym przykładowym zestawie danych. Prawdziwie negatywne (TN) to przypadki, w których zarówno obserwowana, jak i przewidywana etykieta wynosiła 0. Fałszywie pozytywne (FP) to błędna klasyfikacja, w której zaobserwowana etykieta wynosiła 0, ale przewidywana etykieta wynosiła 1. Prawdziwie pozytywne (TP) i fałszywie negatywne (FN) są zdefiniowane podobnie.

|

|

Dla każdej wartości aspektu ogólna wydajność modelu, czyli dokładność dla tej wartości aspektu, wynosi:

Dokładność = (TN + TP🇧🇷TN + FP + FN + TP)

Przy tym wzorze dokładność dla kobiet wynosi 0.930, a dla mężczyzn 0.815. Prowadzi to do jedynej metryki w tej kategorii, różnicy dokładności (AD):

AD = 0.815 - 0.930 = -0.115

AD = 0 oznacza, że dokładność dla obu grup jest taka sama. Większe wartości (dodatnie lub ujemne) wskazują na większe różnice w dokładności.

Równa wydajność tylko na etykietach pozytywowych

Można ograniczyć analizę wydajności modelu tylko do pozytywnych etykiet. Na przykład, jeśli aplikacja dotyczy wykrywania defektów na linii montażowej, może być pożądane sprawdzenie, czy niewadliwe części (etykieta pozytywna) różnego rodzaju (wartości aspektów) są klasyfikowane jako niewadliwe w tym samym tempie. Ta ilość jest określana jako wycofanie lub prawdziwie dodatnia stawka:

Odwołanie = TP / (TP + FN)

W naszym przykładowym zestawie danych wartość wycofania dla kobiet wynosi 0.389, a dla mężczyzn 0.425. Prowadzi to do podstawowej metryki w tej kategorii, różnicy odwołań (RD):

RD = 0.425 - 0.389 = 0.036

Przyjrzyjmy się teraz trzem zaawansowanym metrykom w tej kategorii, zobaczmy, jakie preferencje użytkownika kodują i czym różnią się od podstawowej metryki RD.

Po pierwsze, zamiast mierzyć skuteczność na etykietach obserwowanych pozytywnych, możesz je mierzyć na etykietach z prognozami pozytywnymi. Biorąc pod uwagę wartość aspektu, taką jak kobiety, i wszystkie próbki z tą wartością aspektu, które według modelu są dodatnie, ile z nich jest właściwie sklasyfikowanych jako dodatnie? Ta ilość jest określana jako wskaźnik akceptacji (AR) lub precyzja:

AR = TP / (TP + FP)

W naszym przykładzie AR dla kobiet to 0.977, a AR dla mężczyzn to 0.970. Prowadzi to do różnicy we współczynniku akceptacji (DAR):

DAR = 0.970 - 0.977 = -0.007

Innym sposobem pomiaru błędu jest połączenie dwóch poprzednich metryk i zmierzenie, o ile więcej pozytywnych prognoz modele przypisują wartości aspektu w porównaniu z zaobserwowanymi pozytywnymi etykietami. SageMaker Clarify mierzy tę przewagę za pomocą modelu jako stosunek między liczbą zaobserwowanych pozytywnych etykiet dla tej wartości aspektu a liczbą przewidywanych pozytywnych etykiet i nazywa ją akceptacją warunkową (CA):

CA = (TP + FN🇧🇷TP + FP)

W naszym przykładzie CA dla kobiet wynosi 2.510, a dla mężczyzn 2.283. Różnica w CA prowadzi do ostatecznej metryki w tej kategorii, różnicy w akceptacji warunkowej (DCA):

DCA = 2.283 - 2.510 = -0.227

Równa wydajność tylko w przypadku etykiet negatywowych

W sposób podobny do pozytywnych etykiet, odchylenie można również obliczyć jako różnicę wydajności na negatywnych etykietach. Uwzględnianie etykiet negatywowych oddzielnie może być ważne w niektórych zastosowaniach. Na przykład w naszym przykładzie wykrywania defektów możemy chcieć wykrywać wadliwe części (etykieta negatywna) różnego rodzaju (wartość aspektu) z tą samą szybkością.

Podstawowa metryka w tej kategorii, swoistość, jest analogiczna do metryki przypominania (wskaźnik prawdziwie pozytywnych). Swoistość oblicza dokładność modelu na próbkach o tej wartości aspektu, które mają zaobserwowaną etykietę ujemną:

Specyficzność = TN / (TN + FP)

W naszym przykładzie (patrz tabele pomyłek) specyficzność dla kobiet i mężczyzn wynosi odpowiednio 0.999 i 0.994. W konsekwencji Różnica specyficzności (SD) to:

SD = 0.994 - 0.999 = -0.005

Idąc dalej, podobnie jak wskaźnik akceptacji, analogiczna wielkość dla etykiet negatywnych — współczynnik odrzucenia (RR) — wynosi:

RR = TN / (TN + FN)

RR dla kobiet wynosi 0.927, a dla mężczyzn 0.791, co prowadzi do miernika różnicy w odrzuceniu (DRR):

DRR = 0.927 - 0.791 = -0.136

Wreszcie, odpowiednik negatywnej etykiety akceptacji warunkowej, warunkowego odrzucenia (CR), jest stosunkiem między liczbą zaobserwowanych negatywnych etykiet dla tej wartości aspektu a liczbą przewidywanych negatywnych etykiet:

CR = (TN + FP🇧🇷TN + FN)

CR dla kobiet wynosi 0.928, a dla mężczyzn 0.796. Ostatnim miernikiem w tej kategorii jest różnica w warunkowym odrzuceniu (DCR):

DCR = 0.796 - 0.928 = 0.132

Równa wydajność na etykietach pozytywnych i negatywnych

SageMaker Clarify łączy poprzednie dwie kategorie, biorąc pod uwagę współczynnik wydajności modelu na etykietach pozytywnych i negatywnych. W szczególności dla każdej wartości aspektu SageMaker Clarify oblicza stosunek między fałszywie ujemnymi (FN) i fałszywie dodatnimi (FP). W naszym przykładzie stosunek FN/FP dla kobiet wynosi 679/10 = 67.9, a dla mężczyzn 3678/84 = 43.786. Prowadzi to do miary równości traktowania (TE), która mierzy różnicę między stosunkiem FP/FN:

TE = 67.9 - 43.786 = 24.114

Poniższy zrzut ekranu pokazuje, jak używać SageMaker Clarify z Studio Amazon SageMaker aby pokazać wartości, a także zakresy i krótkie opisy różnych metryk odchyleń.

Pytania dotyczące stronniczości: od jakich danych zacząć?

Przypomnij sobie przykładowe pytania dotyczące stronniczości na początku tego postu. Po zapoznaniu się z danymi z różnych kategorii, ponownie rozważ pytania. Aby odpowiedzieć na pierwsze pytanie, które dotyczy reprezentacji różnych grup w danych uczących, możesz zacząć od metryki Class Imbalance (CI). Podobnie w przypadku pozostałych pytań możesz zacząć od przyjrzenia się odpowiednio różnicy w dodatnich proporcjach w etykietach (DPL), różnicy w dokładności (AD), różnicy we współczynniku akceptacji (DAR) i różnicy przypomnienia (RD).

Odchylenie bez wartości aspektów

Aby ułatwić przedstawienie, ten opis metryk po szkoleniu wykluczył metrykę Uogólnionego Wskaźnika Entropii (GE). Ta metryka mierzy obciążenie bez uwzględniania wartości aspektu i może być pomocna w ocenie rozkładu błędów modelu. Aby uzyskać szczegółowe informacje, patrz Uogólniona entropia (GE).

Wnioski

W tym poście zobaczyłeś, jak 21 różnych metryk w SageMaker Clarify mierzy stronniczość na różnych etapach potoku ML. Dowiedziałeś się o różnych metrykach poprzez przypadek użycia prognozy dochodów, jak wybrać metryki dla twojego przypadku użycia i od których możesz zacząć.

Rozpocznij swoją podróż związaną z odpowiedzialną sztuczną inteligencją, oceniając stronniczość modeli ML za pomocą notatnika demonstracyjnego Uczciwość i zrozumiałość dzięki SageMaker Clarify. Szczegółową dokumentację SageMaker Clarify, w tym formalną definicję metryk, można znaleźć pod adresem Czym jest uczciwość i wyjaśnialność modelu dla prognoz uczenia maszynowego. Aby zapoznać się z implementacją metryk stronniczości typu open source, zapoznaj się z aws-sagemaker-clarify repozytorium GitHub. Szczegółowe omówienie, w tym ograniczenia, można znaleźć w Biuletyn informacyjny dotyczący uczciwości i wyjaśnialności AI w Amazon.

O autorach

Bilala Zafara jest naukowcem stosowanym w AWS, pracującym nad uczciwością, wyjaśnialnością i bezpieczeństwem w uczeniu maszynowym.

Bilala Zafara jest naukowcem stosowanym w AWS, pracującym nad uczciwością, wyjaśnialnością i bezpieczeństwem w uczeniu maszynowym.

Denis V. Batałow jest architektem rozwiązań dla AWS, specjalizującym się w uczeniu maszynowym. Z Amazonem związany od 2005 roku. Denis ma tytuł doktora w dziedzinie sztucznej inteligencji. Śledź go na Twitterze: @dbatalov.

Michele Donini jest starszym naukowcem stosowanym w AWS. Kieruje zespołem naukowców pracujących nad odpowiedzialną sztuczną inteligencją, a jego zainteresowania badawcze to Algorithmic Fairness i Explainable Machine Learning.

Michele Donini jest starszym naukowcem stosowanym w AWS. Kieruje zespołem naukowców pracujących nad odpowiedzialną sztuczną inteligencją, a jego zainteresowania badawcze to Algorithmic Fairness i Explainable Machine Learning.

- AI

- ai sztuka

- generator sztuki ai

- masz robota

- Amazon Sage Maker

- sztuczna inteligencja

- certyfikacja sztucznej inteligencji

- sztuczna inteligencja w bankowości

- robot sztucznej inteligencji

- roboty sztucznej inteligencji

- oprogramowanie sztucznej inteligencji

- Uczenie maszynowe AWS

- blockchain

- konferencja blockchain ai

- pomysłowość

- sztuczna inteligencja konwersacyjna

- konferencja kryptograficzna

- Dall's

- głęboka nauka

- google to

- uczenie maszynowe

- plato

- Platon Ai

- Analiza danych Platona

- Gra Platona

- PlatoDane

- platogaming

- skala ai

- składnia

- zefirnet