CCC wsparło trzy sesje naukowe podczas tegorocznej Dorocznej Konferencji AAAS, a jeśli nie mogli Państwo uczestniczyć osobiście, podsumujemy każdą sesję. W tym tygodniu podsumujemy najważniejsze momenty sesji: „Generatywna sztuczna inteligencja w nauce: obietnice i pułapki.” W części pierwszej podsumujemy wprowadzenie i prezentację dr Rebeki Willett.

Pierwszy panel AAAS CCC na dorocznym spotkaniu w 2024 roku odbył się w piątek, 16 lutego, drugiego dnia konferencji. Panel moderowany przez samego CCC Doktor Mateusz Turk, prezes Instytutu Technologicznego Toyoty w Chicago, składał się z ekspertów zajmujących się zastosowaniem sztucznej inteligencji w różnych dziedzinach nauki. Doktor Rebecca Willett, profesor statystyki i informatyki na Uniwersytecie w Chicago, w swojej prezentacji skupiła się na tym, jak można zastosować modele generatywne w nauce i dlaczego gotowe modele nie wystarczą do zastosowania w badaniach naukowych. Doktor Markus Buehler, profesor inżynierii w Massachusetts Institute of Technology, mówił o modelach generatywnych w zastosowaniu do materiałoznawstwa oraz Doktor Duncan Watson-Parris, adiunkt w Scripps Institution of Oceanography i Halıcıoğlu Data Science Institute na Uniwersytecie Kalifornijskim w San Diego, omówili, w jaki sposób można wykorzystać modele generatywne w badaniu nauk o klimacie.

Dr Turk, ekspert w dziedzinie widzenia komputerowego i interakcji człowiek-komputer, rozpoczął panel od rozróżnienia generatywnej sztucznej inteligencji od wszystkich innych rodzajów sztucznej inteligencji. „U podstaw generatywnych zastosowań sztucznej inteligencji znajdują się modele generatywne złożone z głębokich sieci neuronowych, które uczą się struktury swoich obszernych danych treningowych, a następnie generują nowe dane na podstawie zdobytej wiedzy”.

Dr Turk nakreślił także popularne obawy związane z systemami generatywnymi, zarówno ze względu na awarie samych systemów, np. tych, które cytują nieistniejące wytyczne prawne, jak i ze względu na ich wykorzystanie przez złe podmioty do generowania fałszywych treści, takich jak fałszywe pliki audio lub filmy przedstawiające polityków lub celebrytów.

„W szczególności” – powiedział dr Turk – „ta sesja skupi się na zastosowaniu generatywnej sztucznej inteligencji w nauce, zarówno jako siły transformacyjnej w dążeniu do nauki, jak i jako potencjalnego ryzyka zakłóceń”.

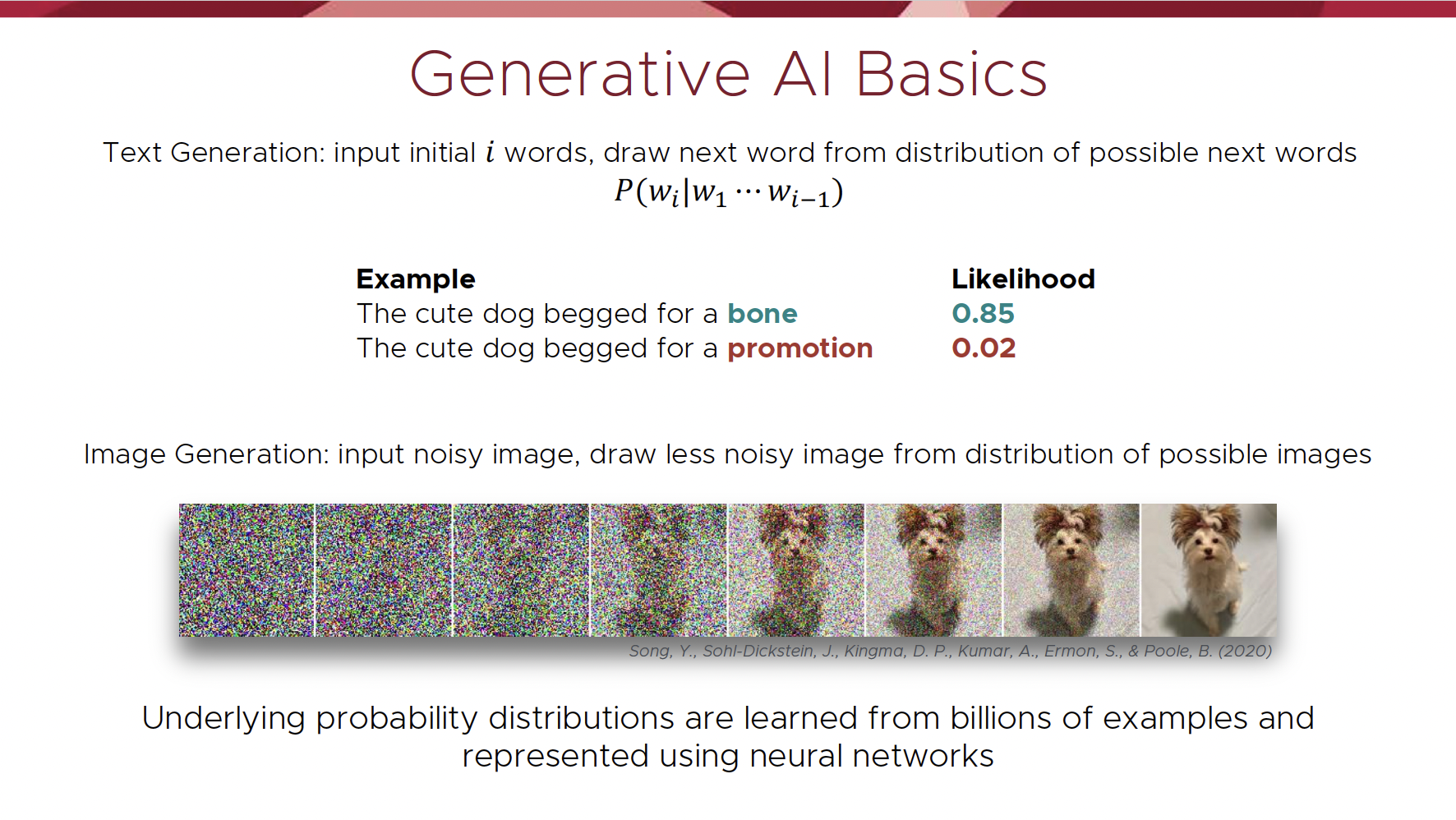

Dr Rebecca Willett rozpoczęła swoją prezentację od przedstawienia, w jaki sposób można wykorzystać generatywną sztuczną inteligencję do wspierania procesu odkryć naukowych. Najpierw skupiła się na działaniu modeli generatywnych. Poniższy obraz ze slajdów doktora Willetta pokazuje, jak model językowy, taki jak ChatGPT, ocenia prawdopodobieństwo wystąpienia słowa, biorąc pod uwagę poprzedni zestaw słów, oraz w jaki sposób model generowania obrazu, taki jak DALL-E 2, generuje obraz z danego podpowiedzi przy użyciu rozkładów prawdopodobieństwa poznanych na podstawie miliardów obrazów podczas szkolenia.

„Korzystając z zasady rozkładu prawdopodobieństwa, która leży u podstaw wszystkich modeli generatywnych, modele te można zastosować do nowatorskich pomysłów w nauce, takich jak generowanie możliwych scenariuszy klimatycznych, biorąc pod uwagę obecną politykę klimatyczną i potencjalną politykę, lub generowanie nowych mikrobiomów o docelowej funkcjonalności, takich jak taki, który jest szczególnie skuteczny w rozkładaniu tworzyw sztucznych” – mówi dr Willett.

Jednak do badań naukowych nie wystarczy korzystanie z gotowych narzędzi generatywnych, takich jak ChatGPT czy DALL-E 2. Narzędzia te powstały w warunkach bardzo odmiennych od kontekstu, w którym działają naukowcy. Jedną oczywistą różnicą między gotowym modelem generatywnym a modelem naukowym są dane. W nauce często istnieje bardzo mało danych, na których można oprzeć hipotezy. Dane naukowe zazwyczaj pochodzą z symulacji i eksperymentów, które często są kosztowne i czasochłonne. Ze względu na te ograniczenia naukowcy muszą uważnie wybierać, które eksperymenty przeprowadzić oraz w jaki sposób zmaksymalizować wydajność i użyteczność tych systemów. Z kolei gotowe modele przywiązują znacznie mniejszą wagę do tego, skąd pochodzą dane, zamiast do maksymalizacji ilości danych, na których mogą operować. W nauce dokładność zbiorów danych i ich pochodzenie są niezwykle ważne, ponieważ naukowcy muszą uzasadniać swoje badania solidnymi dowodami empirycznymi.

„Ponadto w nauce nasze cele nie polegają jedynie na tworzeniu rzeczy, które są prawdopodobne” – mówi dr Willett. „Musimy zrozumieć, jak wszystko działa poza zakresem tego, co zaobserwowaliśmy do tej pory”. Takie podejście jest sprzeczne z generatywnymi modelami sztucznej inteligencji, które traktują dane jako reprezentatywne dla pełnego zakresu prawdopodobnych obserwacji. Włączenie modeli fizycznych i ograniczeń do generatywnej sztucznej inteligencji pomaga zapewnić lepsze odwzorowanie zjawisk fizycznych.

Modele naukowe muszą także umożliwiać uchwycenie rzadkich zdarzeń. „Możemy bezpiecznie zignorować wiele rzadkich zdarzeń, gdy trenujemy ChatGPT, ale dla kontrastu, rzadkie zdarzenia są często tym, na czym najbardziej nam zależy w kontekście naukowym, na przykład w modelu klimatycznym, który przewiduje rzadkie zdarzenia pogodowe. Jeśli zastosujemy model generatywny, który unika rzadkich zdarzeń i np. nigdy nie przewiduje huraganu, to model ten nie będzie zbyt przydatny w praktyce.”

Powiązanym wyzwaniem jest opracowanie generatywnych modeli sztucznej inteligencji dla procesów chaotycznych, które są wrażliwe na warunki początkowe. Doktor Willett wyświetlił poniższy film, który pokazuje dwie cząstki poruszające się w przestrzeni zgodnie z równaniami Lorenza 63. Równania te są deterministyczne, a nie losowe, ale biorąc pod uwagę dwie nieco różne lokalizacje początkowe, można zobaczyć, że w dowolnym momencie obie cząstki mogą znajdować się w bardzo różnych lokalizacjach. Opracowanie generatywnych modeli sztucznej inteligencji, które przewidują dokładny przebieg takich procesów, które pojawiają się w naukach o klimacie, turbulencjach i dynamice sieci, jest zasadniczo trudne, ale nowatorskie podejścia do modelowania generatywnego mogą zapewnić, że wygenerowane procesy będą miały wspólne kluczowe cechy statystyczne z rzeczywistymi danymi naukowymi.

[Osadzone treści]

Na koniec dr Willett odniósł się do faktu, że dane naukowe często obejmują ogromny zakres skal przestrzennych i czasowych. Na przykład w materiałoznawstwie badacze badają materiały w skali nanometrowej pod kątem monimerów aż do systemów wielkoskalowych, takich jak cały samolot. „Ten zakres skal bardzo różni się od danych wykorzystywanych w gotowych modelach i musimy rozważyć, w jaki sposób budujemy te modele generatywne w sposób, który dokładnie wpływa na interakcje między skalami”.

„Modele generatywne to przyszłość nauki”, mówi dr Willett, „ale aby zapewnić ich efektywne wykorzystanie, musimy poczynić fundamentalne postępy w sztucznej inteligencji i wyjść poza podłączanie danych do ChatGPT”.

Dziękuję bardzo za przeczytanie i zapraszamy jutro do zapoznania się z podsumowaniem prezentacji dr Markusa Buehlera na temat generatywnej sztucznej inteligencji w mechanobiologii.

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- PlatoData.Network Pionowe generatywne AI. Wzmocnij się. Dostęp tutaj.

- PlatoAiStream. Inteligencja Web3. Wiedza wzmocniona. Dostęp tutaj.

- PlatonESG. Węgiel Czysta technologia, Energia, Środowisko, Słoneczny, Gospodarowanie odpadami. Dostęp tutaj.

- Platon Zdrowie. Inteligencja w zakresie biotechnologii i badań klinicznych. Dostęp tutaj.

- Źródło: https://feeds.feedblitz.com/~/873922907/0/cccblog~CCC-AAAS-Generative-AI-in-Science-Promises-and-Pitfalls-Recap-Part-One/

- :Jest

- :nie

- :Gdzie

- $W GÓRĘ

- 16

- 2024

- a

- Zdolny

- O nas

- Stosownie

- precyzja

- dokładnie

- aktorzy

- zaadresowany

- zaliczki

- AI

- Modele AI

- Wszystkie kategorie

- również

- am

- ilość

- an

- i

- roczny

- każdy

- aplikacje

- stosowany

- Aplikuj

- podejście

- awanse

- SĄ

- powstać

- sztuczny

- sztuczna inteligencja

- AS

- At

- uczęszczać

- audio

- unika

- Łazienka

- baza

- na podstawie

- BE

- bo

- rozpoczął

- poniżej

- Ulepsz Swój

- pomiędzy

- Poza

- miliardy

- Blog

- obie

- Przełamując

- Budowanie

- ale

- by

- CAN

- zdolny

- Przechwytywanie

- który

- ostrożnie

- walizka

- ccc

- Blog CCC

- Gwiazdy

- wyzwanie

- Charakterystyka

- ChatGPT

- Chicago

- Dodaj

- Klimat

- byliśmy spójni, od początku

- w składzie

- komputer

- Computer Science

- Wizja komputerowa

- Obawy

- Warunki

- Konferencja

- Rozważać

- Ograniczenia

- zawartość

- kontekst

- kontrast

- rdzeń

- Kurs

- stworzony

- Aktualny

- Dall's

- dane

- nauka danych

- zbiory danych

- dzień

- głęboko

- rozwijanie

- różnica

- różne

- odkrycie

- omówione

- wystawiany

- wyświetlacze

- Zakłócenie

- Dystrybucje

- na dół

- dr

- z powodu

- Duncan

- podczas

- dynamika

- każdy

- faktycznie

- efektywność

- osadzone

- Inżynieria

- ogromny

- zapewnić

- Cały

- równania

- wydarzenia

- dowód

- dokładny

- przykład

- drogi

- eksperymenty

- ekspert

- eksperci

- fakt

- Awarie

- imitacja

- daleko

- luty

- Łąka

- i terminów, a

- Skupiać

- koncentruje

- W razie zamówieenia projektu

- wytrzymałość

- Piątek

- od

- pełny

- Funkcjonalność

- fundamentalny

- zasadniczo

- przyszłość

- Generować

- wygenerowane

- generuje

- generujący

- generacja

- generatywny

- generatywna sztuczna inteligencja

- dany

- Go

- Gole

- Ciężko

- Have

- pomaga

- jej

- Wysoki

- pasemka

- W jaki sposób

- How To

- HTTPS

- huragan

- pomysły

- if

- ignorować

- obraz

- zdjęcia

- znaczenie

- ważny

- in

- włączenie

- niewiarygodnie

- początkowy

- Instytut

- Instytucja

- Inteligencja

- wzajemne oddziaływanie

- Interakcje

- najnowszych

- Wprowadzenie

- IT

- Klawisz

- język

- na dużą skalę

- UCZYĆ SIĘ

- dowiedziałem

- Regulamin

- mniej

- dźwignia

- Prawdopodobnie

- Ograniczenia

- mało

- lokalizacji

- Partia

- robić

- massachusetts

- Instytut Technologii w Massachusetts

- materiały

- Matthew

- Maksymalna szerokość

- Maksymalizuj

- maksymalizacji

- Może..

- Spotkanie

- jedynie

- MIT

- model

- modelowanie

- modele

- MoonShot

- większość

- przeniesienie

- dużo

- musi

- Potrzebować

- sieć

- sieci

- nerwowy

- sieci neuronowe

- nigdy

- Nowości

- nieistniejący

- powieść

- oczywista

- występujący

- Szansa

- of

- często

- on

- ONE

- działać

- or

- Początki

- ludzkiej,

- na zewnątrz

- opisane

- obrysowywanie

- zewnętrzne

- własny

- płyta

- część

- szczególnie

- osoba

- fizyczny

- Miejsce

- plato

- Analiza danych Platona

- PlatoDane

- gracz

- Proszę

- polityka

- Politycy

- Popularny

- możliwy

- potencjał

- praktyka

- przewidzieć

- Prognozy

- presentation

- prezydent

- poprzedni

- zasada

- wygląda tak

- procesów

- produkcji

- Profesor

- obiecuje

- pościg

- zacytować

- przypadkowy

- zasięg

- RZADKO SPOTYKANY

- Czytaj

- Czytający

- real

- podsumować

- związane z

- reprezentować

- przedstawiciel

- Badania naukowe

- Badacze

- Ryzyko

- krzepki

- run

- bezpiecznie

- Powiedział

- San

- mówią

- Skala

- waga

- scenariusze

- nauka

- NAUKI

- naukowy

- Naukowcy

- druga

- widzieć

- wrażliwy

- Sesja

- Sesje

- zestaw

- ustawienie

- Share

- ona

- Targi

- symulacje

- slajdy

- trochę inny

- So

- dotychczas

- Typ przestrzeni

- rozpiętości

- Przestrzenne

- Startowy

- statystyczny

- statystyka

- Struktura

- Badanie

- Studiowanie

- taki

- wystarczający

- streszczać

- wsparcie

- Utrzymany

- system

- systemy

- ukierunkowane

- techniczny

- Technologia

- niż

- że

- Połączenia

- Przyszłość

- ich

- sami

- następnie

- Tam.

- Te

- one

- rzeczy

- to

- w tym tygodniu

- tych

- trzy

- czas

- czasochłonne

- do

- jutro

- wziął

- narzędzia

- toyota

- Trening

- transformacyjny

- leczyć

- melodia

- turbulencja

- drugiej

- zazwyczaj

- zrozumieć

- uniwersytet

- University of Chicago

- posługiwać się

- używany

- użyteczny

- za pomocą

- różnorodność

- początku.

- Wideo

- wizja

- była

- Droga..

- we

- Pogoda

- tydzień

- były

- Co

- jeśli chodzi o komunikację i motywację

- który

- KIM

- dlaczego

- będzie

- w

- słowo

- słowa

- Praca

- You

- youtube

- zefirnet