Sztuczna inteligencja (AI) wywołała ostatnio furorę dzięki możliwości zrewolucjonizowania sposobu, w jaki ludzie podchodzą i rozwiązują różne zadania i złożone problemy. Od opieki zdrowotnej po finanse, sztuczna inteligencja i powiązane z nią modele uczenia maszynowego wykazały swój potencjał w zakresie usprawniania skomplikowanych procesów, ulepszania wzorców podejmowania decyzji i odkrywania cennych spostrzeżeń.

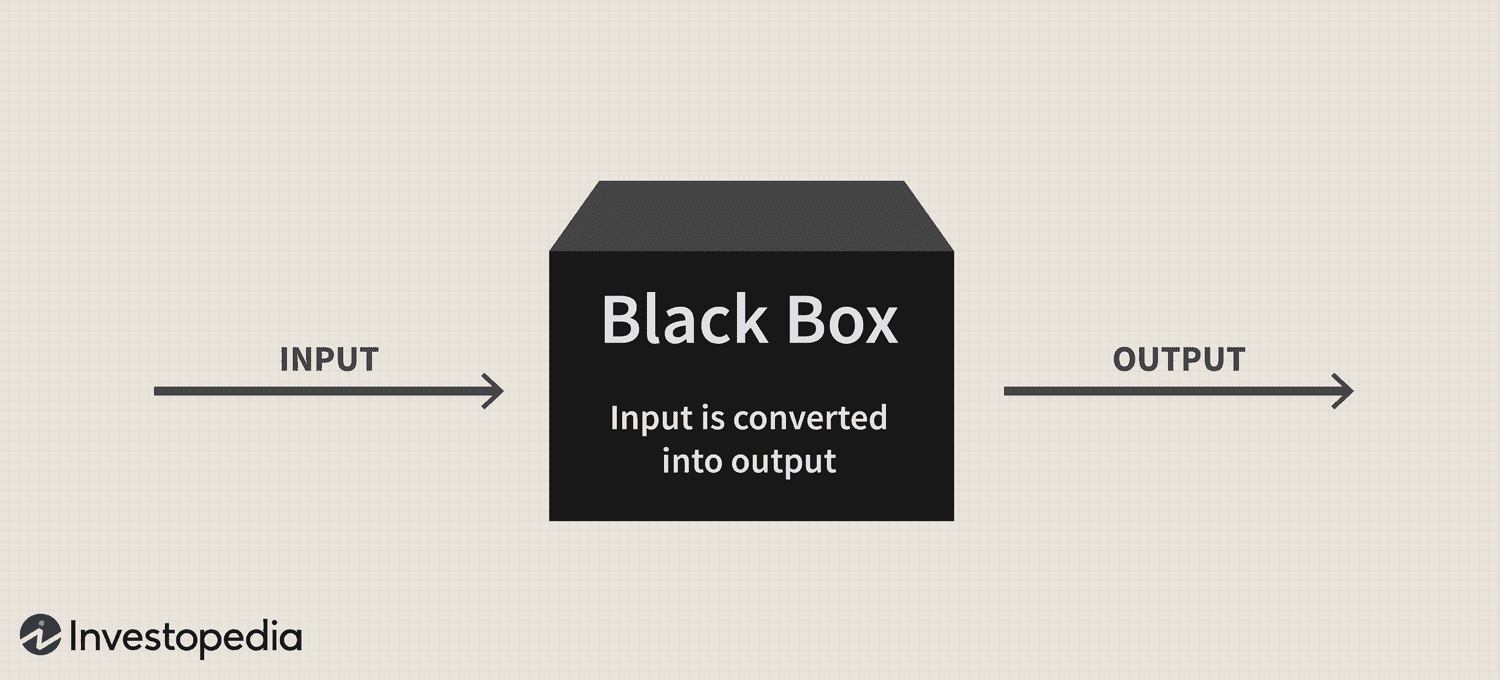

Jednak pomimo ogromnego potencjału tej technologii utrzymujący się problem „czarnej skrzynki” nadal stanowi poważne wyzwanie dla jej przyjęcia, rodząc pytania o przejrzystość i interpretowalność tych wyrafinowanych systemów.

Krótko mówiąc, problem czarnej skrzynki wynika z trudności w zrozumieniu, w jaki sposób systemy sztucznej inteligencji i modele uczenia maszynowego przetwarzają dane i generują prognozy lub decyzje. Modele te często opierają się na skomplikowanych algorytmach, które nie są łatwo zrozumiałe dla ludzi, co prowadzi do braku odpowiedzialności i zaufania.

Dlatego też, w miarę jak sztuczna inteligencja jest coraz bardziej integrowana z różnymi aspektami naszego życia, rozwiązanie tego problemu ma kluczowe znaczenie dla zapewnienia odpowiedzialnego i etycznego wykorzystania tej potężnej technologii.

Czarna skrzynka: przegląd

Metafora „czarnej skrzynki” wywodzi się z poglądu, że systemy sztucznej inteligencji i modele uczenia maszynowego działają w sposób ukryty przed ludzkim zrozumieniem, podobnie jak zawartość zapieczętowanego, nieprzejrzystego pudełka. Systemy te są zbudowane na złożonych modelach matematycznych i wielowymiarowych zbiorach danych, które tworzą skomplikowane relacje i wzorce kierujące ich procesami decyzyjnymi. Jednak te wewnętrzne mechanizmy nie są łatwo dostępne ani zrozumiałe dla ludzi.

W praktyce problem czarnej skrzynki sztucznej inteligencji to trudność w rozszyfrowaniu uzasadnienia przewidywań lub decyzji systemu sztucznej inteligencji. Ten problem jest szczególnie powszechny w modelach głębokiego uczenia, takich jak sieci neuronowe, w których wiele warstw połączonych węzłów przetwarza i przekształca dane w sposób hierarchiczny. Złożoność tych modeli i przeprowadzane przez nie nieliniowe przekształcenia sprawiają, że prześledzenie uzasadnienia ich wyników jest niezwykle trudne.

Nikita Brudnov, dyrektor generalny BR Group — pulpitu nawigacyjnego do analiz marketingowych opartego na sztucznej inteligencji — powiedział Cointelegraph, że brak przejrzystości w sposobie, w jaki modele AI podejmują określone decyzje i prognozy, może być problematyczny w wielu kontekstach, takich jak diagnoza medyczna, podejmowanie decyzji finansowych i postępowań sądowych, co znacząco wpłynęło na dalsze wdrażanie sztucznej inteligencji.

Magazine: Joe Lubin: Prawda o podziale założycieli ETH i „Crypto Google”

„W ostatnich latach wiele uwagi poświęcono rozwojowi technik interpretacji i wyjaśniania decyzji podejmowanych przez modele sztucznej inteligencji, takich jak generowanie ocen ważności funkcji, wizualizacja granic decyzji i identyfikowanie alternatywnych, hipotetycznych wyjaśnień” – powiedział, dodając:

„Jednak te techniki są wciąż w powijakach i nie ma gwarancji, że będą skuteczne we wszystkich przypadkach”.

Brudnov uważa ponadto, że wraz z dalszą decentralizacją organy regulacyjne mogą wymagać, aby decyzje podejmowane przez systemy sztucznej inteligencji były bardziej przejrzyste i odpowiedzialne, aby zapewnić ich etyczną ważność i ogólną uczciwość. Zasugerował również, że konsumenci mogą wahać się przed korzystaniem z produktów i usług opartych na sztucznej inteligencji, jeśli nie rozumieją, jak one działają i nie rozumieją swojego procesu decyzyjnego.

James Wo, założyciel DFG — firmy inwestycyjnej, która aktywnie inwestuje w technologie związane ze sztuczną inteligencją — uważa, że problem z czarną skrzynką nie wpłynie na adopcję w dającej się przewidzieć przyszłości. Według Wo, większość użytkowników niekoniecznie dba o to, jak działają istniejące modele sztucznej inteligencji i chętnie czerpie z nich użyteczność, przynajmniej na razie.

„W perspektywie średnioterminowej, gdy nowość tych platform zniknie, z pewnością pojawi się większy sceptycyzm co do metodologii czarnej skrzynki. Pytania będą również rosły, gdy wykorzystanie sztucznej inteligencji wkroczy do krypto i Web3, gdzie należy wziąć pod uwagę stawkę finansową i konsekwencje” – przyznał.

Wpływ na zaufanie i przejrzystość

Jedną z dziedzin, w której brak przejrzystości może znacząco wpłynąć na zaufanie, jest diagnostyka medyczna oparta na sztucznej inteligencji. Na przykład modele AI mogą analizować złożone dane medyczne w opiece zdrowotnej w celu generowania diagnoz lub zaleceń dotyczących leczenia. Jednak gdy klinicyści i pacjenci nie mogą zrozumieć uzasadnienia tych sugestii, mogą kwestionować wiarygodność i ważność tych spostrzeżeń. Ten sceptycyzm może dodatkowo prowadzić do wahania w przyjmowaniu rozwiązań AI, potencjalnie utrudniając postęp w opiece nad pacjentem i medycynie spersonalizowanej.

W sferze finansowej systemy sztucznej inteligencji mogą być wykorzystywane do oceny zdolności kredytowej, wykrywania oszustw i oceny ryzyka. Jednak problem z czarną skrzynką może powodować niepewność co do rzetelności i dokładności tych ocen kredytowych lub uzasadnienia ostrzeżeń o oszustwach, ograniczając zdolność technologii do cyfryzacji branży.

Branża kryptograficzna również boryka się z reperkusjami problemu czarnej skrzynki. Na przykład zasoby cyfrowe i technologia blockchain są zakorzenione w decentralizacji, otwartości i weryfikowalności. Systemy sztucznej inteligencji, którym brakuje przejrzystości i możliwości interpretacji, tworzą rozdźwięk między oczekiwaniami użytkowników a rzeczywistością rozwiązań opartych na sztucznej inteligencji w tej przestrzeni.

Obawy regulacyjne

Z regulacyjnego punktu widzenia problem czarnej skrzynki AI stanowi wyjątkowe wyzwanie. Po pierwsze, nieprzejrzystość procesów sztucznej inteligencji może coraz bardziej utrudniać organom regulacyjnym ocenę zgodności tych systemów z obowiązującymi przepisami i wytycznymi. Ponadto brak przejrzystości może skomplikować zdolność organów regulacyjnych do opracowywania nowych ram, które mogą uwzględniać zagrożenia i wyzwania związane z zastosowaniami sztucznej inteligencji.

Ustawodawcy mogą mieć trudności z oceną uczciwości, stronniczości i praktyk w zakresie ochrony danych systemów sztucznej inteligencji oraz ich potencjalnego wpływu na prawa konsumentów i stabilność rynku. Ponadto bez jasnego zrozumienia procesów decyzyjnych systemów opartych na sztucznej inteligencji organy regulacyjne mogą mieć trudności z identyfikacją potencjalnych słabych punktów i zapewnieniem odpowiednich zabezpieczeń ograniczających ryzyko.

Jednym z godnych uwagi zmian regulacyjnych dotyczących tej technologii jest ustawa Unii Europejskiej o sztucznej inteligencji, który się zbliża do stania się częścią księgi statutowej bloku po osiągnięciu wstępnego porozumienia politycznego 27 kwietnia.

W swej istocie ustawa o sztucznej inteligencji ma na celu stworzenie godnego zaufania i odpowiedzialnego środowiska dla rozwoju sztucznej inteligencji w UE. Ustawodawcy przyjęli system klasyfikacji, który kategoryzuje różne rodzaje sztucznej inteligencji według ryzyka: niedopuszczalne, wysokie, ograniczone i minimalne. Te ramy mają na celu rozwiązanie różnych problemów związanych z problemem czarnej skrzynki sztucznej inteligencji, w tym kwestii związanych z przejrzystością i odpowiedzialnością.

Niezdolność do skutecznego monitorowania i regulowania systemów sztucznej inteligencji już napięła relacje między różnymi branżami i organami regulacyjnymi.

Na początku ubiegłego miesiąca popularny chatbot AI ChatGPT był zakazany we Włoszech na 29 dni, głównie ze względu na obawy dotyczące prywatności zgłoszone przez krajową agencję ochrony danych w związku z podejrzeniem naruszenia unijnych ogólnych przepisów o ochronie danych (RODO). Platformie pozwolono jednak na wznowienie świadczenia usług 29 kwietnia po tym, jak dyrektor generalny Sam Altman ogłosił, że on i jego zespół podjęli określone kroki w celu spełnienia żądań regulatora, w tym ujawnienia praktyk przetwarzania danych i wdrożenia implementacji wieku- miary bramkowania.

Nieodpowiednie regulacje dotyczące systemów sztucznej inteligencji mogą podważyć zaufanie opinii publicznej do zastosowań sztucznej inteligencji, ponieważ użytkownicy są coraz bardziej zaniepokojeni nieodłącznymi uprzedzeniami, nieścisłościami i implikacjami etycznymi.

Rozwiązanie problemu czarnej skrzynki

Aby skutecznie rozwiązać problem czarnej skrzynki sztucznej inteligencji, niezbędne jest zastosowanie kombinacji podejść promujących przejrzystość, interpretowalność i odpowiedzialność. Dwie takie uzupełniające się strategie to dająca się wyjaśnić sztuczna inteligencja (XAI) i modele open source.

XAI to obszar badań poświęcony wypełnianiu luki między złożonością systemów sztucznej inteligencji a potrzebą ludzkiej interpretacji. XAI koncentruje się na opracowywaniu technik i algorytmów, które mogą zapewnić zrozumiałe dla człowieka wyjaśnienia decyzji podejmowanych przez sztuczną inteligencję, oferując wgląd w uzasadnienie tych wyborów.

Metody często stosowane w XAI obejmują modele zastępcze, analizę ważności cech, analizę wrażliwości i wyjaśnienia niezależne od modelu, które można interpretować lokalnie. Wdrożenie XAI w różnych branżach może pomóc interesariuszom lepiej zrozumieć procesy oparte na sztucznej inteligencji, zwiększyć zaufanie do technologii i ułatwić zgodność z wymogami regulacyjnymi.

W połączeniu z XAI promowanie przyjęcia modeli sztucznej inteligencji typu open source może być skuteczną strategią rozwiązania problemu czarnej skrzynki. Modele typu open source zapewniają pełny dostęp do algorytmów i danych, które napędzają systemy sztucznej inteligencji, umożliwiając użytkownikom i programistom analizę i zrozumienie leżących u ich podstaw procesów.

Ta zwiększona przejrzystość może pomóc w budowaniu zaufania i wspieraniu współpracy między programistami, badaczami i użytkownikami. Co więcej, podejście typu open source może stworzyć solidniejsze, bardziej odpowiedzialne i skuteczne systemy sztucznej inteligencji.

Problem czarnej skrzynki w przestrzeni kryptograficznej

Problem czarnej skrzynki ma znaczące konsekwencje dla różnych aspektów przestrzeni kryptograficznej, w tym strategii handlowych, prognoz rynkowych, środków bezpieczeństwa, tokenizacji i inteligentnych kontraktów.

W dziedzinie strategii handlowych i prognoz rynkowych modele oparte na sztucznej inteligencji zyskują na popularności, ponieważ inwestorzy starają się wykorzystać handel algorytmiczny. Jednak problem czarnej skrzynki utrudnia użytkownikom zrozumienie funkcjonowania tych modeli, co utrudnia ocenę ich skuteczności i potencjalnego ryzyka. W konsekwencji ta nieprzejrzystość może również skutkować nieuzasadnionym zaufaniem do decyzji inwestycyjnych opartych na sztucznej inteligencji lub sprawić, że inwestorzy będą nadmiernie polegać na zautomatyzowanych systemach.

Sztuczna inteligencja może odgrywać kluczową rolę we wzmacnianiu środków bezpieczeństwa w ekosystemie blockchain poprzez wykrywanie nieuczciwych transakcji i podejrzanych działań. Niemniej jednak problem czarnej skrzynki komplikuje proces weryfikacji tych rozwiązań bezpieczeństwa opartych na sztucznej inteligencji. Brak przejrzystości w podejmowaniu decyzji może podważyć zaufanie do systemów bezpieczeństwa, budząc obawy co do ich zdolności do ochrony zasobów i informacji użytkowników.

Najnowsze: Consensus 2023: Firmy wykazują zainteresowanie Web3 pomimo wyzwań regulacyjnych w USA

Tokenizacja i inteligentne kontrakty — dwa kluczowe elementy ekosystemu blockchain — są również świadkami zwiększonej integracji sztucznej inteligencji. Jednak problem z czarną skrzynką może przesłonić logikę stojącą za tokenami generowanymi przez sztuczną inteligencję lub inteligentną realizacją kontraktów.

W miarę jak sztuczna inteligencja rewolucjonizuje różne branże, rozwiązanie problemu czarnej skrzynki staje się coraz bardziej palące. Wspierając współpracę między naukowcami, programistami, decydentami i zainteresowanymi stronami z branży, można opracować rozwiązania promujące przejrzystość, odpowiedzialność i zaufanie do systemów sztucznej inteligencji. Dlatego interesujące będzie obserwowanie, jak ten nowatorski paradygmat technologiczny będzie ewoluował.

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- PlatoAiStream. Analiza danych Web3. Wiedza wzmocniona. Dostęp tutaj.

- Wybijanie przyszłości w Adryenn Ashley. Dostęp tutaj.

- Kupuj i sprzedawaj akcje spółek PRE-IPO z PREIPO®. Dostęp tutaj.

- Źródło: https://cointelegraph.com/news/ai-s-black-box-problem-challenges-and-solutions-for-a-transparent-future

- :ma

- :Jest

- :nie

- :Gdzie

- 2023

- 27

- a

- zdolność

- O nas

- dostęp

- dostępny

- odpowiedzialność

- odpowiedzialny

- precyzja

- w poprzek

- działać

- aktywnie

- zajęcia

- dodanie

- do tego

- adres

- adresowanie

- przyjęty

- Przyjęcie

- Przyjęcie

- postępy

- oddziaływać

- Po

- agencja

- Umowa

- AI

- Ustawa o sztucznej inteligencji

- Chatbot AI

- Zasilany AI

- Cele

- Alarmy

- algorytmiczny

- handel algorytmiczny

- Algorytmy

- Wszystkie kategorie

- już

- również

- wśród

- an

- analiza

- analityka

- w czasie rzeczywistym sprawiają,

- i

- ogłosił

- aplikacje

- podejście

- awanse

- właściwy

- kwiecień

- SĄ

- POWIERZCHNIA

- na około

- sztuczny

- sztuczna inteligencja

- AS

- aspekty

- oszacowanie

- Aktywa

- powiązany

- At

- Uwaga

- zautomatyzowane

- BE

- stają się

- staje się

- staje

- być

- za

- uważa,

- Ulepsz Swój

- pomiędzy

- stronniczość

- uprzedzenia

- Czarny

- blockchain

- ekosystem blockchain

- blockchain technologia

- ciała

- książka

- Granice

- Pudełko

- mostkowanie

- budować

- budować zaufanie

- wybudowany

- biznes

- by

- CAN

- nie może

- skapitalizować

- który

- Etui

- ceo

- pewien

- wyzwanie

- wyzwania

- wyzwanie

- chatbot

- ChatGPT

- wybory

- klasyfikacja

- System klasyfikacji

- jasny

- klinicyści

- Cointelegraph

- współpraca

- połączenie

- uzupełniający

- kompleks

- kompleksowość

- spełnienie

- składniki

- zrozumieć

- zaniepokojony

- Obawy

- Konsekwencje

- w konsekwencji

- Rozważać

- konsument

- Prawa konsumenta

- Konsumenci

- treść

- konteksty

- nadal

- ciągły

- umowa

- umowy

- rdzeń

- mógłby

- kraju

- Stwórz

- stworzony

- kredyt

- istotny

- Crypto

- Przemysł kryptograficzny

- przestrzeń kryptograficzna

- tablica rozdzielcza

- dane

- prywatność danych

- analiza danych

- Ochrona danych

- zestawy danych

- Decentralizacja

- decyzja

- Podejmowanie decyzji

- Decyzje

- dedykowane

- głęboko

- głęboka nauka

- Zdecydowanie

- wymagania

- wykazać

- zaprojektowany

- Mimo

- Wykrywanie

- rozwijać

- rozwinięty

- deweloperzy

- rozwijanie

- oprogramowania

- różne

- trudny

- trudności

- Trudność

- cyfrowy

- Zasoby cyfrowe

- digitalizować

- do

- domena

- nie

- napęd

- z powodu

- z łatwością

- Ekosystem

- Efektywne

- faktycznie

- skuteczność

- zatrudniony

- umożliwiając

- wzmacniać

- wzmocnienie

- zapewnić

- zapewnienie

- Wchodzi

- Środowisko

- niezbędny

- ETH.

- etyczny

- EU

- europejski

- oceniać

- ewoluuje

- przykład

- egzekucja

- Przede wszystkim system został opracowany

- oczekiwania

- wyjaśniając

- Twarz

- twarze

- ułatwienie

- uczciwość

- Cecha

- finansować

- budżetowy

- Firma

- koncentruje

- W razie zamówieenia projektu

- przewidywalny

- Nasz formularz

- Sprzyjać

- wychowanie

- założyciel

- założyciele

- Framework

- Ramy

- oszustwo

- wykrywanie oszustw

- nieuczciwy

- od

- pełny

- funkcjonować

- dalej

- Ponadto

- przyszłość

- zyskuje

- szczelina

- `RODO

- Ogólne

- ogólne dane

- Generować

- generujący

- przyznać

- Zarządzanie

- gwarancja

- poprowadzi

- wytyczne

- miał

- Zaoszczędzić

- Have

- he

- opieki zdrowotnej

- pomoc

- Wysoki

- przeszkadza

- jego

- W jaki sposób

- Jednak

- HTTPS

- człowiek

- Ludzie

- identyfikacja

- if

- ogromny

- Rezultat

- wpływ

- realizacja

- wykonawczych

- implikacje

- znaczenie

- in

- niemożność

- zawierać

- Włącznie z

- Zwiększać

- wzrosła

- coraz bardziej

- przemysłowa

- przemysł

- Informacja

- nieodłączny

- spostrzeżenia

- zintegrowany

- integracja

- Inteligencja

- połączone

- odsetki

- ciekawy

- najnowszych

- inwestycja

- Inwestorzy

- Inwestuje

- problem

- problemy

- IT

- Włochy

- JEGO

- Brak

- Nazwisko

- prawodawców

- nioski

- prowadzić

- prowadzący

- nauka

- najmniej

- Regulamin

- postępowanie sądowe

- lubić

- Ograniczony

- Zyje

- miejscowy

- logika

- maszyna

- uczenie maszynowe

- zrobiony

- robić

- Dokonywanie

- sposób

- wiele

- rynek

- prognozy rynkowe

- Marketing

- matematyczny

- Może..

- środków

- medyczny

- dane medyczne

- lekarstwo

- Metodologia

- może

- minimalny

- Złagodzić

- modele

- monitor

- Miesiąc

- jeszcze

- Ponadto

- większość

- przeniesienie

- dużo

- wielokrotność

- koniecznie

- Potrzebować

- sieci

- sieci neuronowe

- Niemniej jednak

- Nowości

- Nie

- węzły

- dostojnik

- Pojęcie

- powieść

- nowość

- już dziś

- of

- poza

- oferuje

- często

- on

- pewnego razu

- nieprzezroczysty

- open source

- Otwartość

- działać

- or

- ludzkiej,

- ogólny

- płatny

- paradygmat

- część

- szczególnie

- pacjent

- pacjenci

- wzory

- Ludzie

- wykonać

- Personalizowany

- Miejsce

- Platforma

- Platformy

- plato

- Analiza danych Platona

- PlatoDane

- Grać

- politycy

- polityczny

- Popularny

- popularność

- możliwość

- potencjał

- potencjalnie

- mocny

- Praktyczny

- praktyki

- Przewidywania

- teraźniejszość

- prezenty

- rozpowszechniony

- głównie

- prywatność

- Problem

- problemy

- Obrady

- wygląda tak

- procesów

- przetwarzanie

- Produkty

- promować

- promowanie

- ochrona

- zapewniać

- tymczasowy

- publiczny

- zaufania publicznego

- pytanie

- pytania

- wychowywanie

- racjonalny

- osiągnięcie

- Rzeczywistość

- królestwo

- niedawny

- niedawno

- zalecenia

- w sprawie

- Regulować

- Regulacja

- regulamin

- Regulatory

- regulacyjne

- związane z

- Relacje

- niezawodność

- polegać

- reperkusje

- wymagać

- wymagania

- Badania naukowe

- Badacze

- odpowiedzialny

- dalsze

- Resume

- zrewolucjonizować

- rewolucjonizuje

- prawa

- Ryzyko

- ocena ryzyka

- ryzyko

- krzepki

- Rola

- reguły

- zabezpieczenia

- Powiedział

- Sam

- Sam Altman

- punktacji

- bezpieczeństwo

- Środki bezpieczeństwa

- widzieć

- Szukajcie

- Wrażliwość

- Usługi

- Zestawy

- pokazać

- znaczący

- znacznie

- po prostu

- Sceptycyzm

- mądry

- inteligentna umowa

- Inteligentne kontrakty

- Rozwiązania

- ROZWIĄZANIA

- wyrafinowany

- Źródło

- Typ przestrzeni

- specyficzny

- dzielić

- Stabilność

- interesariusze

- stoisko

- stojaki

- wynika

- Cel

- Nadal

- strategie

- Strategia

- opływowy

- Walka

- taki

- podejrzliwy

- system

- systemy

- Tandem

- zadania

- zespół

- tech

- Techniki

- Technologies

- Technologia

- REGULAMIN

- że

- Połączenia

- ich

- Im

- Tam.

- Te

- one

- to

- do

- tokenizacja

- Żetony

- Wyśledzić

- Handel

- Strategie handlowe

- transakcje

- Przekształcać

- przemiany

- Przezroczystość

- przezroczysty

- leczenie

- Zaufaj

- godny zaufania

- Prawda

- drugiej

- typy

- Niepewność

- odkryć

- zasadniczy

- zrozumieć

- zrozumiały

- zrozumienie

- wyjątkowy

- na

- us

- posługiwać się

- Użytkownik

- Użytkownicy

- użyteczność

- Cenny

- różnorodny

- Weryfikacja

- Naruszenia

- istotny

- Luki w zabezpieczeniach

- była

- Web3

- jeśli chodzi o komunikację i motywację

- który

- będzie

- w

- w ciągu

- bez

- świadkami

- wo

- Praca

- prace

- lat

- zefirnet