W dzisiejszych czasach nie musimy długo czekać na kolejny przełom sztuczna inteligencja (AI) imponuje wszystkim możliwościami, które wcześniej należały tylko do science fiction.

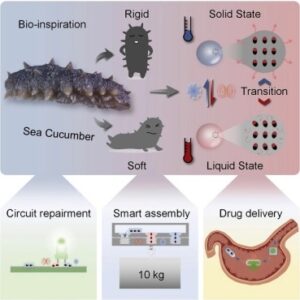

W 2022, Narzędzia do generowania grafiki AI takie jak DALL-E 2 firmy Open AI, Google Imagen i Stable Diffusion szturmem podbiły Internet, a użytkownicy generują wysokiej jakości obrazy z opisów tekstowych.

W przeciwieństwie do poprzednich rozwiązań, te narzędzia przekształcające tekst w obraz szybko trafiły z laboratoriów badawczych do Kultura głównego nurtu, prowadząc do zjawisk wirusowych, takich jak funkcja „Magic Avatar” w aplikacji Lensa AI, która tworzy stylizowane obrazy jej użytkowników.

W grudniu chatbot o nazwie ChatGPT zaskoczył użytkowników umiejętności pisania, co prowadzi do przewidywań, że technologia wkrótce będzie w stanie to zrobić zdać egzaminy zawodowe. Podobno ChatGPT zyskał milion użytkowników w mniej niż tydzień. Niektórzy urzędnicy szkolni już to zrobili zakazał tego w obawie, że studenci będą go używać do pisania esejów. Microsoft jest podobno planuje włączyć ChatGPT do swojej wyszukiwarki internetowej Bing i produktów Office jeszcze w tym roku.

Co niesłabnący postęp w sztucznej inteligencji oznacza dla najbliższej przyszłości? I czy sztuczna inteligencja może zagrozić niektórym zawodom w nadchodzących latach?

Pomimo tych imponujących ostatnich osiągnięć sztucznej inteligencji, musimy zdać sobie sprawę, że nadal istnieją znaczne ograniczenia tego, co mogą zrobić systemy sztucznej inteligencji.

AI przoduje w rozpoznawaniu wzorców

Ostatnie postępy w sztucznej inteligencji opierają się głównie na algorytmach uczenia maszynowego, które rozpoznają złożone wzorce i relacje z ogromnych ilości danych. To szkolenie jest następnie wykorzystywane do zadań takich jak przewidywanie i generowanie danych.

Rozwój obecnej technologii sztucznej inteligencji opiera się na optymalizacji mocy predykcyjnej, nawet jeśli celem jest generowanie nowych wyników.

Na przykład, GPT-3, model językowy ChatGPT, został przeszkolony w przewidywaniu, co następuje po fragmencie tekstu. Następnie GPT-3 wykorzystuje tę zdolność przewidywania, aby kontynuować wprowadzanie tekstu podanego przez użytkownika.

Powstały „generatywne AI”, takie jak ChatGPT i DALL-E 2 dużo debaty o tym, czy sztuczna inteligencja może być naprawdę kreatywna, a nawet rywalizować z ludźmi pod tym względem. Jednak ludzka kreatywność opiera się nie tylko na danych z przeszłości, ale także na eksperymentach i pełnym zakresie ludzkich doświadczeń.

Przyczyna i skutek

Wiele ważnych problemów wymaga przewidywania skutków naszych działań w złożonych, niepewnych i ciągle zmieniających się środowiskach. W ten sposób możemy wybrać sekwencję działań, która z największym prawdopodobieństwem pozwoli osiągnąć nasze cele. Jednak algorytmy nie mogą się uczyć o przyczynach i skutkach na podstawie samych danych. Uczenie maszynowe oparte wyłącznie na danych może znaleźć tylko korelacje.

Aby zrozumieć, dlaczego jest to problem dla sztucznej inteligencji, możemy zestawić problemy związane z diagnozowaniem stanu chorobowego z wyborem leczenia. Modele uczenia maszynowego są często pomocne w wykrywaniu nieprawidłowości w obrazach medycznych; jest to problem z rozpoznawaniem wzorców. Nie musimy się martwić przyczynowością, ponieważ nieprawidłowości są już obecne lub nie.

Ale wybór najlepszego leczenia do diagnozy to zasadniczo inny problem. Tutaj celem jest wpłynięcie na wynik, a nie tylko rozpoznanie wzorca. Aby określić skuteczność leczenia, badacze medyczni przeprowadzają randomizowane, kontrolowane badania. W ten sposób mogą próbować kontrolować wszelkie czynniki, które mogą mieć wpływ na leczenie.

Pomieszanie tych dwóch rodzajów problemów czasami prowadzi do nieoptymalne aplikacje uczenia maszynowego w organizacjach.

Chociaż sukces niedawnych prac nad sztuczną inteligencją pokazuje wartość modeli opartych na danych, wiele problemów, które chcielibyśmy rozwiązać za pomocą komputerów, wymaga zrozumienia związku przyczynowego.

Obecnym systemom AI brakuje tej możliwości, poza wyspecjalizowanymi aplikacjami, takimi jak np gry planszowe.

Rozumowanie zdroworozsądkowe

Modele językowe, takie jak GPT-3 i ChatGPT, mogą z powodzeniem rozwiązywać niektóre zadania wymagające zdrowego rozsądku.

Jednak następująca interakcja z ChatGPT, zaadaptowana z eksperymentu przeprowadzonego przez Gary'ego Marcusasugeruje, że nie jest pod tym względem całkowicie wiarygodny.

Mam osiem lat. Kiedy się urodziłem, moja biologiczna matka była w Barcelonie, a ojciec w Tokio. Gdzie się urodziłem? Przemyśl to krok po kroku.

Nie jest napisane, gdzie się urodziłeś. Wiemy tylko, że w chwili twoich narodzin twoja biologiczna matka była w Barcelonie, a twój ojciec w Tokio.

To, czy systemy sztucznej inteligencji, takie jak ChatGPT, mogą osiągnąć zdrowy rozsądek, jest przedmiotem ożywionej debaty wśród ekspertów.

Sceptycy tacy jak Marcus zwracają uwagę, że nie możemy ufać modelom językowym, że solidnie odzwierciedlają zdrowy rozsądek, ponieważ ani nie mają go wbudowanego, ani nie są bezpośrednio do niego optymalizowane. Optymiści twierdzą, że chociaż obecne systemy są niedoskonałe, zdrowy rozsądek może wyłaniają się spontanicznie w wystarczająco zaawansowanych modelach językowych.

Wartości ludzkie

Za każdym razem, gdy pojawiają się przełomowe systemy sztucznej inteligencji, artykuły z wiadomościami i wpisy w mediach społecznościowych są dokumentowane rasistowski, seksistowskiei inne typy stronniczy i szkodliwe zachowania nieuchronnie podążać.

Ta wada jest nieodłączną częścią obecnych systemów sztucznej inteligencji, które z pewnością będą odzwierciedleniem ich danych. Wartości ludzkie, takie jak prawda i sprawiedliwość, nie są zasadniczo wbudowane w algorytmy; jest to coś, czego naukowcy jeszcze nie wiedzą, jak to zrobić.

Podczas gdy naukowcy są odrabianie lekcji z poprzednich odcinków i robić postęp zajmując się uprzedzeniami, dziedzina sztucznej inteligencji nadal ma długa droga do przejścia solidne dostosowanie systemów sztucznej inteligencji do ludzkich wartości i preferencji.![]()

Artykuł został opublikowany ponownie Konwersacje na licencji Creative Commons. Przeczytać oryginalny artykuł.

Kredytowych Image: Mahdis Mousavi/Unsplash

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- Platoblockchain. Web3 Inteligencja Metaverse. Wzmocniona wiedza. Dostęp tutaj.

- Źródło: https://singularityhub.com/2023/01/13/ai-might-be-seemingly-everywhere-but-there-are-still-plenty-of-things-it-cant-do-for-now/

- 1

- 10

- 2022

- a

- ABC

- zdolność

- Zdolny

- O nas

- powyżej

- Osiągać

- osiągnięcia

- działania

- adresowanie

- zaawansowany

- zaliczki

- oddziaływać

- Po

- AI

- Algorytmy

- Wszystkie kategorie

- sam

- już

- wśród

- kwoty

- i

- osobno

- Aplikacja

- aplikacje

- argumentować

- Sztuka

- artykuł

- towary

- sztuczny

- Praca plastyczna

- Barcelona

- bo

- za

- poniżej

- BEST

- pomiędzy

- stronniczość

- Bing

- urodzony

- Granica

- przełom

- wybudowany

- przycisk

- nazywa

- nie może

- możliwości

- walizka

- Przyczyny

- pewien

- wymiana pieniędzy

- chatbot

- ChatGPT

- Dodaj

- Wybierając

- kod

- zbierać

- COM

- wspólny

- Lud

- kompleks

- komputery

- warunek

- zamieszanie

- stale

- kontynuować

- kontrast

- kontrola

- kontrolowanych

- Rozmowa

- Przeciwdziałać

- tworzy

- Twórczy

- kreatywność

- kredyt

- Aktualny

- Dall's

- dane

- sterowane danymi

- Dni

- debata

- grudzień

- Ustalać

- oprogramowania

- wydarzenia

- różne

- bezpośrednio

- Wyświetlacz

- robi

- nie

- skuteczność

- ruchomości

- bądź

- całkowicie

- środowiska

- Parzyste

- wszyscy

- przykład

- doświadczenie

- eksperyment

- eksperci

- Oczy

- Czynniki

- uczciwość

- strach

- Cecha

- Fikcja

- pole

- Znajdź

- znalezieniu

- wada

- obserwuj

- następujący

- następujący sposób

- znaleziono

- od

- pełny

- zasadniczo

- przyszłość

- Generować

- wygenerowane

- generujący

- generacja

- otrzymać

- gif

- dany

- cel

- Gole

- Google'a

- przełomowy

- pomocny

- tutaj

- wysokiej jakości

- W jaki sposób

- How To

- Jednak

- HTML

- HTTPS

- człowiek

- Ludzkie doświadczenie

- Ludzie

- obraz

- zdjęcia

- ważny

- imponujący

- in

- włączać

- nieuchronnie

- wpływ

- Informacje

- nieodłączny

- wkład

- wzajemne oddziaływanie

- Internet

- IT

- Oferty pracy

- Wiedzieć

- Labs

- Brak

- język

- prowadzący

- Wyprowadzenia

- nauka

- wykorzystuje

- Licencja

- Prawdopodobnie

- Ograniczenia

- Limity

- długo

- maszyna

- uczenie maszynowe

- wiele

- Marcus

- Maksymalna szerokość

- Media

- medyczny

- wzmiankowany

- Microsoft

- może

- milion

- model

- modele

- jeszcze

- większość

- mama

- Blisko

- Potrzebować

- Ani

- netto

- Nowości

- aktualności

- Następny

- Pojęcie

- NYU

- Biurowe

- Stary

- ONE

- koncepcja

- zoptymalizowane

- optymalizacji

- organizacji

- Inne

- wytyczne

- Przeszłość

- Wzór

- wzory

- wykonać

- osobisty

- dane personalne

- kawałek

- planowanie

- plato

- Analiza danych Platona

- PlatoDane

- Proszę

- Volcano Plenty Vaporizer Storz & Bickel

- punkt

- Wielokąt

- Wiadomości

- power

- przewidzieć

- przewidywanie

- przepowiednia

- Przewidywania

- przeważnie

- preferencje

- teraźniejszość

- poprzedni

- poprzednio

- Problem

- problemy

- Produkty

- profesjonalny

- Postęp

- czysto

- szybko

- Randomizowane

- zasięg

- Czytaj

- niedawny

- uznanie

- rozpoznać

- refleksja

- Relacje

- wydany

- rzetelny

- usunąć

- reprezentowane

- wymagać

- Badania naukowe

- Badacze

- Rywal

- run

- Szkoła

- nauka

- Fantastyka naukowa

- Szukaj

- rozsądek

- Sekwencja

- kilka

- znaczący

- ponieważ

- sytuacje

- Obserwuj Nas

- Media społecznościowe

- Posty w mediach społecznościowych

- ROZWIĄZANIA

- kilka

- coś

- Źródło

- wyspecjalizowanym

- stabilny

- Ewolucja krok po kroku

- Nadal

- burza

- Studenci

- przedmiot

- sukces

- Z powodzeniem

- taki

- Wskazuje

- systemy

- TAG

- zadania

- Technologia

- Połączenia

- ich

- rzeczy

- w tym roku

- grozić

- Przez

- czas

- do

- Tokio

- narzędzia

- przeszkolony

- Trening

- leczenie

- Próby

- Zaufaj

- typy

- Niepewny

- zrozumieć

- zrozumienie

- Nieoczekiwany

- posługiwać się

- Użytkownik

- Użytkownicy

- wartość

- Wartości

- Naprawiono

- Przeciw

- VOX

- czekać

- sieć

- tydzień

- Co

- czy

- który

- Podczas

- będzie

- Praca

- by

- napisać

- rok

- lat

- You

- Twój

- zefirnet