Anima Anandkumar, Bren, profesor informatyki w Kalifornijskim Instytucie Technologii i starszy dyrektor ds. badań nad uczeniem maszynowym w firmie Nvidia, ma do czynienia z macierzą. Jej obawy nie dotyczą filmów science fiction, ale macierzy matematycznych — siatek liczb lub zmiennych używanych w informatyce. Podczas gdy badacze zazwyczaj używają macierzy do badania relacji i wzorców ukrytych w dużych zestawach danych, narzędzia te najlepiej nadają się do relacji dwukierunkowych. Z drugiej strony skomplikowane procesy, takie jak dynamika społeczna, obejmują interakcje wyższego rzędu.

Na szczęście Anandkumar od dawna lubi takie wyzwania. Kiedy wspomina Ugadi, święto noworoczne, które obchodziła jako dziecko w Mysore (obecnie Mysuru) w Indiach, wyróżniają się dwa smaki: jaggery, nierafinowany cukier reprezentujący słodycz życia i neem, gorzkie kwiaty reprezentujące życiowe niepowodzenia i trudności. „To jedna z najbardziej gorzkich rzeczy, o których można pomyśleć” – powiedziała.

Powiedziała, że zazwyczaj ładowała się na neem. „Chcę wyzwań”.

Ten apetyt na wysiłek skłonił ją do studiowania elektrotechniki w Indyjskim Instytucie Technologii w Madrasie. Uzyskała doktorat na Cornell University i odbyła staż podoktorski w Massachusetts Institute of Technology. Następnie założyła własną grupę jako adiunkt na Uniwersytecie Kalifornijskim w Irvine, koncentrując się na uczeniu maszynowym, podzbiorze sztucznej inteligencji, w którym komputer może zdobywać wiedzę bez wyraźnego programowania. W Irvine Anandkumar zagłębił się w świat „modelowania tematów”, rodzaj uczenia maszynowego, w którym komputer próbuje zebrać ważne tematy z danych; jednym z przykładów może być algorytm na Twitterze, który identyfikuje ukryte trendy. Ale połączenie między słowami jest jedną z tych interakcji wyższego rzędu, zbyt subtelnych dla relacji macierzowych: słowa mogą mieć wiele znaczeń, wiele słów może odnosić się do tego samego tematu, a język ewoluuje tak szybko, że nic nie zostaje ustalone na długo.

To doprowadziło Anandkumara do zakwestionowania zależności AI od metod macierzowych. Wydedukowała, że aby zachować wystarczająco spostrzegawczy algorytm, aby uczyć się w takim chaosie, naukowcy muszą zaprojektować go tak, aby uchwycił algebrę wyższych wymiarów. Zwróciła się więc do tego, co przez długi czas było niewykorzystanym narzędziem w algebrze, zwanym tensorem. Tensory są jak macierze, ale mogą rozciągać się na dowolny wymiar, wykraczając poza dwa wymiary macierzy — wiersze i kolumny. W rezultacie tensory są bardziej ogólnymi narzędziami, co czyni je mniej podatnymi na „przesadne dopasowanie” — gdy modele ściśle dopasowują się do danych treningowych, ale nie mogą pomieścić nowych danych. Na przykład, jeśli lubisz wiele gatunków muzycznych, ale strumieniujesz tylko utwory jazzowe, sztuczna inteligencja Twojej platformy streamingowej może nauczyć się przewidywać, które utwory jazzowe Ci się spodobają, ale jej prognozy dotyczące R&B byłyby bezpodstawne. Anandkumar uważa, że tensory sprawiają, że uczenie maszynowe jest bardziej elastyczne.

To nie jedyne wyzwanie, które podjęła. Anandkumar jest mentorem i orędownikiem zmian w systemach, które wypychają marginalizowane grupy z pola. W 2018 roku zorganizowała petycję o zmianę nazwy dorocznej konferencji poświęconej systemom przetwarzania informacji neuronowych w jej dziedzinie z bezpośredniego akronimu na „NeurIPS”. W październiku komisja konferencji odrzuciła petycję. Ale Anandkumar i jej rówieśnicy nie poddawali się i kilka tygodni później zarząd zmienił kurs.

Quanta rozmawiała z Anandkumar w jej biurze w Pasadenie o jej wychowaniu, tensorach i etycznych wyzwaniach stojących przed sztuczną inteligencją. Wywiad został skondensowany i zredagowany dla jasności.

Jak twoi rodzice wpłynęli na twoje postrzeganie maszyn?

Na początku lat 1990. byli jednymi z pierwszych, którzy wprowadzili programowalne maszyny produkcyjne do Mysore. W tamtym czasie postrzegano to jako coś dziwnego: „Możemy zatrudnić do tego ludzkich operatorów, więc jaka jest potrzeba automatyzacji?” Moi rodzice zauważyli, że wydajność może być ogromna i mogą to robić znacznie szybciej w porównaniu z maszynami obsługiwanymi przez ludzi.

Czy to był twój wstęp do automatyzacji?

Tak. I programowanie. Zobaczyłem zielony ekran, na którym mój tata napisałby program, co przeniosłoby wieżę i narzędzia. To było naprawdę fascynujące – zrozumieć geometrię, zrozumieć, jak powinno się poruszać narzędzie. Widzisz inżynierską stronę tego, jak taka masywna maszyna może to zrobić.

Jakie było doświadczenie twojej matki w inżynierii?

Moja mama była w pewnym sensie pionierką. Była jedną z pierwszych w swojej społeczności i rodzinie, która zajęła się inżynierią. Wielu innych krewnych radziło dziadkowi, aby jej nie wysyłał, twierdząc, że może niełatwo wyjść za mąż. Mój dziadek się zawahał. Wtedy moja mama przez trzy dni prowadziła strajk głodowy.

W rezultacie nigdy nie uważałam, że zainteresowanie kobiet inżynierią jest czymś dziwnym. Moja matka wpoiła w nas to docenianie matematyki i nauk ścisłych. To, że jest to naturalna część tego, kim jestem od wczesnego dzieciństwa, przeszło długą drogę. Gdyby moja mama kiedykolwiek zobaczyła seksizm, zwróciłaby na to uwagę i powiedziała: „Nie, nie akceptuj tego”. To naprawdę pomogło.

Czy coś jeszcze ekscytowało cię matematyką i nauką?

Przed szkołą średnią cała matematyka, której się uczy, jest deterministyczna. Dodawanie, mnożenie, wszystko co robisz — odpowiedź jest jedna. W liceum zacząłem uczyć się o prawdopodobieństwie i o tym, że możemy wnioskować o rzeczach losowo. Dla mnie ma to większy sens, ponieważ w naturze jest znacznie więcej. Jest losowość, a nawet chaos.

W naszym życiu jest tyle rzeczy, których nie możemy przewidzieć. Nie należy jednak „przepasowywać się” do wcześniejszych doświadczeń, które nie pozwolą nam przystosować się do nowych warunków w naszym życiu. Zdałem sobie sprawę, że dzięki sztucznej inteligencji powinieneś mieć elastyczność, aby uogólniać nowe rzeczy, uczyć się nowych umiejętności.

I dlatego zacząłeś kwestionować operacje macierzowe w uczeniu maszynowym?

W praktyce metody macierzowe w uczeniu maszynowym nie są w stanie skutecznie uchwycić relacji wyższego rzędu. Zasadniczo nie można się w ogóle uczyć. Zapytaliśmy więc: A co, gdybyśmy spojrzeli na [operacje] wyższego rzędu? To doprowadziło nas do algebry tensorów.

Dzięki wielu wymiarom i elastyczności tensory wydają się być naturalnym dopasowaniem do problemów wyższego rzędu w sztucznej inteligencji. Dlaczego nikt wcześniej ich nie używał?

Byłem pewien, że ludzie by o tym pomyśleli. Po opracowaniu metody wróciliśmy, aby przeszukać literaturę i zobaczyć. W rzeczywistości w 1927 roku pojawił się artykuł psychometryczny sugerujący, że aby analizować różne formy inteligencji, należy wykonać te operacje tensorowe. Więc ludzie proponują te pomysły już od jakiegoś czasu.

Ale obliczenia czasu nie były w stanie obsłużyć tych [operacji] wyższego rzędu, co oznacza ogólnie korelacje między co najmniej trzema stronami. Nie mieliśmy też wystarczających danych. Ważny był czas. Posiadanie najnowszego sprzętu i większej ilości danych pomoże nam teraz przejść do metod wyższego rzędu.

Jeśli uda Ci się uelastycznić sztuczną inteligencję, co się wtedy stanie?

Ponowne przemyślenie podstaw samej sztucznej inteligencji.

Na przykład w wielu dziedzinach naukowych nie mogę wymusić umieszczania moich danych w ustalonej siatce. Solwery numeryczne są elastyczne: jeśli używasz tradycyjnego solvera, możesz łatwo znaleźć rozwiązanie w dowolnym punkcie przestrzeni. Ale standardowe modele uczenia maszynowego nie są budowane w ten sposób. ImageNet [baza danych używana do uczenia AI rozpoznawania obrazów] ma stały rozmiar obrazu lub rozdzielczość. Trenujesz sieć w tej rozdzielczości, więc testujesz ją w tej samej rozdzielczości. Jeśli teraz korzystasz z tej sieci, ale zmienisz rozdzielczość, całkowicie się nie powiedzie. Nie jest to przydatne w rzeczywistych aplikacjach. Naukowcy chcą elastyczności.

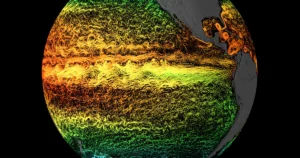

Opracowaliśmy operatory neuronowe, które nie mają tej wady. Doprowadziło to do znacznych przyspieszeń przy zachowaniu dokładności. Na przykład, możemy dokładnie przewidzieć dynamikę płynów w czasie rzeczywistym i planujemy wdrożyć ją na dronach, które mogą latać w warunkach silnego wiatru w obiekcie testującym wiatr dronów w Caltech.

Jako student odbyłeś staż w IBM, a teraz oprócz pracy w Caltech współpracujesz z Nvidią. Dlaczego łączysz teorię akademicką z zastosowaniami przemysłowymi?

Moi rodzice są przedsiębiorczy. Ale mój prapradziadek ze strony mojego taty był uczonym, który na nowo odkrył ten starożytny tekst zwany Arthashastra. Była to pierwsza znana książka o ekonomii, pochodząca z 300 p.n.e. Dorastając, zawsze się zastanawiałem: Jak mam rozstać się z tymi dwoma światami?

Myślę, że w tym momencie obecna era jest tak wspaniała. Widzimy dużą otwartość w tym, jak firmy takie jak Nvidia inwestują w otwarte badania.

Wspomniałeś, że chcesz czegoś w rodzaju przysięgi Hipokratesa na badania nad sztuczną inteligencją. Czemu?

Zawsze ważne jest, aby zastanowić się, jak nasza praca wpłynie na świat. Może to być trudne, zwłaszcza w dużej firmie, ponieważ budujesz jedną część tego ogromnego systemu. Ale tak wiele sposobu, w jaki uczymy na uniwersytetach, wywodzi się ze szkoły wojskowej. Inżynieria wywodzi się z tego tła, a część z nich trwa. Jak myślenie, że naukowcy i inżynierowie powinni skupić się na sprawach technicznych i pozwolić innym zająć się resztą. To jest źle. Wszyscy potrzebujemy ludzkiego myślenia.

Jak dzisiejsze nieelastyczne algorytmy przyczyniają się do tych problemów etycznych?

Ludzie zostali przyzwyczajeni do myślenia, że można ufać maszynom. Wcześniej, gdybyś poprosił maszynę o pomnożenie, zawsze byłoby to poprawne. Podczas gdy ludzie mogą się mylić, podobnie jak nasze dane. Teraz, gdy dane treningowe AI są stronnicze rasowo, dopasowujemy się do założeń danych treningowych. Możemy mieć nie tylko błędne odpowiedzi, ale także błędne odpowiedzi z dużą pewnością. To niebezpieczne.

Jak więc idziemy do przodu?

Jeśli chodzi o budowanie lepszych algorytmów, musimy przynajmniej zapytać: czy możemy podać odpowiedni poziom ufności? Jeśli inny człowiek mówi: „Może jestem na 60% pewien, że to właściwa odpowiedź”, bierzesz to pod uwagę.

Jeśli więc wyjrzę przez okno i zobaczę kotopodobne zwierzę wielkości budynku, mogę pomyśleć: „Tak, wygląda jak kot, ale nie jestem jeszcze pewien, co to właściwie jest”.

Dokładnie. Bo właśnie wtedy te modele mają problem zbytniej pewności siebie. W standardowym szkoleniu zachęcasz ich do bycia bardzo pewnymi siebie.

Byłeś mentorem dla Program WAVE Fellows firmy Caltech, w ramach którego studenci z niedostatecznie reprezentowanych środowisk prowadzą badania. Jak myślisz, jaka jest rola mentoringu w AI?

Jedna ze starszych kobiet w tej dziedzinie ubolewała kiedyś, że kobiety czują, że jesteśmy wyspami. Jesteśmy tak odłączeni. Nie wiemy, co się dzieje z innymi. Nie wiemy nic o skalach płacowych. To uczucie odłączenia — że nie jesteś częścią systemu. Nie czujesz, że tu należysz. Myślę, że bardzo ważne jest, aby to naprawić, pokazując, że istnieje coś więcej niż tylko grupy powinowactwa, takie jak WIML i Czarny w AI. Istnieje szersza grupa mentorów i osób, które są zaangażowane w te działania.

Czy ma to związek z twoimi doświadczeniami ze zmianą nazwy NeurIPS? Dlaczego ta walka była dla ciebie tak ważna?

Dla wielu ludzi to było jak: „Och, głupia zmiana nazwy”. Ale to przyniosło toksyczność. Nie spodziewałem się, że pojawią się długie wątki na Reddicie, które wyśmiewają nas i nasz wygląd, i wszelkiego rodzaju groźby, wszelkiego rodzaju próby doxowania ludzi. Tak wiele z tego było pod ziemią. I naraziło ludzi na to, z czym kobiety spotkają się na tych konferencjach.

Ostatecznie powiedziałbym, że to połączyło społeczność. Doprowadziło to do owczarni umiarkowanej grupy ludzi, którzy byli nieświadomi. A to naprawdę pomogło zwiększyć naszą różnorodność i integrację.

Mimo, że jesteś przyzwyczajony do rzucania ludziom wyzwań, wyobrażam sobie, że nadal trudno było mówić.

To było naprawdę trudne. Jestem osobą prywatną, ale kiedy zacząłem wypowiadać się w mediach społecznościowych, nawet po prostu publikując pracę, którą wykonujemy lub coś bardzo łagodnego, komentarze były niefiltrowane. Była cała ta natura „Unikajmy mówienia o negatywnych rzeczach. Zakopmy to. Ale jestem zdania, że musimy to ujawnić i musimy ponosić odpowiedzialność.

Że ludzie muszą jeść swoje neem?

Dokładnie dokładnie. Musisz przyjąć gorzką prawdę.