Moment, w którym generatywne aplikacje AI trafiły na rynek, zmienił tempo biznesu – nie tylko dla zespołów ds. bezpieczeństwa, ale także dla cyberprzestępców. W dzisiejszych czasach niezastosowanie się do innowacji w zakresie sztucznej inteligencji może oznaczać pozostanie w tyle za konkurencją i narażenie swojej cyberobrony na niekorzystną sytuację przed cyberatakami opartymi na sztucznej inteligencji. Jednak dyskutując o tym, jak sztuczna inteligencja wpłynie lub nie wpłynie na cyberprzestępczość, ważne jest, abyśmy spojrzeli na sprawy przez pragmatyczny i trzeźwy obiektyw, a nie poddawali się szumowi, który bardziej przypomina science fiction.

Dzisiejszy postęp i dojrzałość sztucznej inteligencji sygnalizuje znaczący krok naprzód w zakresie bezpieczeństwa przedsiębiorstw. Cyberprzestępcy nie są w stanie łatwo dopasować rozmiaru i skali zasobów, umiejętności i motywacji przedsiębiorstw, co utrudnia im dotrzymanie kroku obecnemu tempu innowacji AI. Prywatna inwestycja typu venture w sztuczną inteligencję eksplodował do 93.5 miliarda dolarów w 2021 r. – ci źli nie mają takiego kapitału. Nie mają też siły roboczej, mocy obliczeniowej ani innowacji, które dają firmom komercyjnym lub rządowi więcej czasu i możliwości szybkiego ponoszenia porażek, szybkiego uczenia się i robienia tego dobrze.

Nie dajcie się jednak zwieść: cyberprzestępczość nadrobi zaległości. Nie jest to pierwszy raz, kiedy branża zabezpieczeń ma krótką przewagę — kiedy oprogramowanie ransomware zaczęło zachęcać więcej obrońców do stosowania technologii wykrywania i reagowania na punktach końcowych, atakujący potrzebowali trochę czasu, aby dowiedzieć się, jak obejść i uniknąć tych wykryć. Ten przejściowy „okres karencji” dał przedsiębiorstwom czas na podjęcie działań lepiej się osłaniajcie. To samo dotyczy teraz: firmy muszą maksymalnie wykorzystać swoją przewagę w wyścigu AI, ulepszając swoje możliwości wykrywania zagrożeń i reagowania oraz wykorzystując szybkość i precyzję, jaką zapewniają im obecne innowacje AI.

Jak sztuczna inteligencja zmienia cyberprzestępczość? Cóż, nie zmieni to znacząco tego w najbliższym czasie, ale w niektórych przypadkach je skaluje. Przyjrzyjmy się, gdzie złośliwe użycie sztucznej inteligencji będzie miało, a gdzie nie będzie miało najbardziej natychmiastowego wpływu.

W pełni zautomatyzowane kampanie złośliwego oprogramowania: FUD

W ostatnich miesiącach widzieliśmy twierdzenia dotyczące różnych przypadków złośliwego użycia sztucznej inteligencji, ale to, że dany scenariusz jest możliwy, nie oznacza, że jest on prawdopodobny. Weźmy na przykład w pełni zautomatyzowane kampanie złośliwego oprogramowania — logika podpowiada, że możliwe jest wykorzystanie sztucznej inteligencji do osiągnięcia tego rezultatu, ale biorąc pod uwagę, że wiodące firmy technologiczne nie opracowały jeszcze pionierskich w pełni zautomatyzowanych cykli tworzenia oprogramowania, jest mało prawdopodobne, że grupy cyberprzestępcze posiadające ograniczenia finansowe osiągną to wcześniej . Jednak nawet częściowa automatyzacja może umożliwić skalowanie cyberprzestępczości – jest to taktyka, w której już widzieliśmy Kampanie bazarowe. To nie jest innowacja, ale sprawdzona technika które obrońcy już podejmują.

Phishing wykorzystujący sztuczną inteligencję: rzeczywistość (ale kluczowy jest kontekst)

Innym przypadkiem użycia, który należy wziąć pod uwagę, są ataki phishingowe wykorzystujące sztuczną inteligencję. Nie tylko jest to możliwe, ale już zaczynamy widzieć te ataki na wolności. Następna generacja phishingu może osiągnąć wyższy poziom perswazji i współczynnika klikalności, ale phishing sztucznie zaprojektowany przez człowieka i phishing wykorzystujący sztuczną inteligencję nadal zmierzają do tego samego celu. Innymi słowy, phishing wykorzystujący sztuczną inteligencję nadal jest phishingiem szukającym kliknięcia i wymaga takiej samej gotowości do wykrywania i reagowania.

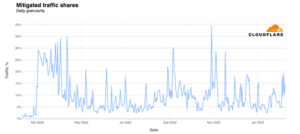

Jednak choć problem pozostaje ten sam, skala jest znacznie inna. Sztuczna inteligencja działa jak mnożnik siły w skalowaniu kampanii phishingowych, więc jeśli przedsiębiorstwo odnotuje gwałtowny wzrost liczby przychodzących wiadomości e-mail phishingowych – a te złośliwe e-maile są znacznie bardziej przekonujące – prawdopodobnie liczy się z wysokim prawdopodobieństwem klikalności i możliwością kompromisu. Modele sztucznej inteligencji mogą również zwiększyć skuteczność targetowania, pomagając atakującym określić, kto jest najbardziej podatnym celem dla konkretnego phishingu w organizacji i ostatecznie osiągnąć wyższy zwrot z inwestycji w kampanie. Ataki phishingowe od dawna należą do najskuteczniejszych taktyk stosowanych przez osoby atakujące w celu infiltracji przedsiębiorstw. Skalowanie tego typu ataków podkreśla kluczową rolę, jaką odgrywają technologie EDR, MDR, XDR i IAM w wykrywaniu anomalnych zachowań, zanim osiągną one skutek.

Ataki zatruwające AI: w stylu FUD

Ataki zatruwające AI, czyli programowe manipulowanie kodem i danymi, na których budowane są modele AI, może być „Świętym Graalem” ataków cyberprzestępców. Skutki udanego ataku zatrucia mogą sięgać od prób dezinformacji po Die Hard 4.0. Dlaczego? Ponieważ zatruwając model, atakujący może sprawić, że będzie się zachowywał lub funkcjonował w dowolny sposób, a nie jest to łatwe do wykrycia. Jednak ataki te nie są łatwe do przeprowadzenia — wymagają uzyskania dostępu do danych, na których model AI trenuje w momencie szkolenia, co jest niemałym wyczynem. W miarę jak coraz więcej modeli stanie się oprogramowaniem typu open source, ryzyko tych ataków będzie rosło, ale na razie pozostanie niskie.

Nieznane

Chociaż ważne jest oddzielenie szumu od rzeczywistości, ważne jest również, aby zadawać właściwe pytania na temat wpływu sztucznej inteligencji na krajobraz zagrożeń. Istnieje wiele niewiadomych dotyczących potencjału sztucznej inteligencji — nie możemy przeoczyć tego, jak może ona zmienić cele przeciwników. Nie wiadomo, w jaki sposób nowe zdolności mogą pomóc przeciwnikom służyć nowym celom i ponownie skalibrować ich motywy.

Być może nie odnotujemy natychmiastowego wzrostu liczby nowatorskich ataków wykorzystujących sztuczną inteligencję, ale skalowanie cyberprzestępczości dzięki sztucznej inteligencji będzie miało znaczący wpływ na organizacje, które nie są na to przygotowane. Szybkość i skala są nieodłącznymi cechami sztucznej inteligencji i tak samo jak obrońcy chcą z nich skorzystać, tak samo atakujący. Zespoły ds. bezpieczeństwa mają już za mało personelu i są przeciążone — gwałtowny wzrost szkodliwego ruchu lub reagowania na incydenty znacznie zwiększa ich obciążenie pracą.

Potwierdza to bardziej niż kiedykolwiek potrzebę inwestowania przez przedsiębiorstwa w systemy obronne, wykorzystując sztuczną inteligencję do zwiększania szybkości i precyzji w zakresie możliwości wykrywania zagrożeń i reagowania. Przedsiębiorstwa, które skorzystają z tego „okresu karencji”, będą znacznie lepiej przygotowane i odporniejsze na dzień, w którym napastnicy faktycznie dogonią wyścig cybernetyczny sztucznej inteligencji.

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- PlatoData.Network Pionowe generatywne AI. Wzmocnij się. Dostęp tutaj.

- PlatoAiStream. Inteligencja Web3. Wiedza wzmocniona. Dostęp tutaj.

- PlatonESG. Motoryzacja / pojazdy elektryczne, Węgiel Czysta technologia, Energia, Środowisko, Słoneczny, Gospodarowanie odpadami. Dostęp tutaj.

- Przesunięcia bloków. Modernizacja własności offsetu środowiskowego. Dostęp tutaj.

- Źródło: https://www.darkreading.com/dr-tech/are-ai-engineered-threats-fud-or-reality-

- :ma

- :Jest

- :nie

- :Gdzie

- $W GÓRĘ

- 2021

- 7

- a

- zdolności

- O nas

- dostęp

- Osiągać

- Osiąga

- Dzieje Apostolskie

- faktycznie

- w dodatku

- przyjąć

- postępy

- postęp

- Korzyść

- przed

- AI

- już

- również

- wśród

- an

- i

- nigdzie

- aplikacje

- SĄ

- AS

- At

- atakować

- Ataki

- Próby

- zautomatyzowane

- Automatyzacja

- Łazienka

- BE

- bo

- stają się

- być

- zanim

- Początek

- zachowanie

- za

- jest

- korzyści

- Miliard

- wybudowany

- biznes

- biznes

- ale

- by

- Kampanie

- CAN

- możliwości

- kapitał

- nieść

- walizka

- Etui

- zapasy

- pewien

- zmiana

- zmieniony

- wymiana pieniędzy

- Charakterystyka

- roszczenia

- kliknij

- kod

- handlowy

- Firmy

- konkurenci

- kompromis

- computing

- moc obliczeniowa

- Rozważać

- kontekst

- mógłby

- krytyczny

- Aktualny

- cyber

- cyberataki

- cyberprzestępczość

- cyberprzestępcy

- Cykle

- dane

- dzień

- obrońcy

- Obrona

- Wykrywanie

- Ustalać

- oprogramowania

- różne

- Niekorzyść

- Omawiając

- do

- robi

- darowizna

- napęd

- jazdy

- z łatwością

- łatwo

- krawędź

- skuteczność

- e-maile

- ogarnięcie

- podkreśla

- umożliwiać

- Punkt końcowy

- angaże

- zapewnić

- Enterprise

- bezpieczeństwo przedsiębiorstwa

- przedsiębiorstwa

- Parzyste

- EVER

- przykład

- FAIL

- Falling

- FAST

- wyczyn

- karmienie

- Fikcja

- Postać

- materialnie

- Znajdź

- i terminów, a

- pierwszy raz

- W razie zamówieenia projektu

- wytrzymałość

- Naprzód

- od

- FUD

- w pełni

- funkcjonować

- zyskuje

- generacja

- generatywny

- generatywna sztuczna inteligencja

- otrzymać

- dany

- cel

- Gole

- Rząd

- Grupy

- miał

- Ciężko

- trudniej

- Have

- pomoc

- pomoc

- Wysoki

- wyższy

- historycznie

- Dobranie (Hit)

- W jaki sposób

- How To

- Jednak

- HTTPS

- Szum

- IBM

- if

- Natychmiastowy

- Rezultat

- ważny

- in

- W innych

- incydent

- reakcja na incydent

- Zwiększać

- przemysł

- Innowacja

- innowacje

- najnowszych

- wewnętrzny

- Inwestuj

- inwestycja

- IT

- jpg

- właśnie

- Trzymać

- Klawisz

- krajobraz

- prowadzić

- prowadzący

- Skakać

- UCZYĆ SIĘ

- niech

- poziom

- poziomy

- Dźwignia

- lewarowanie

- lubić

- Prawdopodobnie

- logika

- Popatrz

- poszukuje

- niski

- robić

- Dokonywanie

- malware

- manipulowanie

- rynek

- Mecz

- dojrzałość

- Maksymalizuj

- Może..

- MDR

- oznaczać

- Mylna informacja

- błąd

- model

- modele

- moment

- miesięcy

- jeszcze

- większość

- Motywacja

- dużo

- Potrzebować

- potrzebne

- Nowości

- Następny

- Nie

- powieść

- już dziś

- Cele

- of

- on

- ONE

- tylko

- na

- koncepcja

- open source

- Okazja

- or

- organizacja

- organizacji

- Inne

- na zewnątrz

- Wynik

- przytłoczony

- Pokój

- okres

- phish

- phishing

- ataki phishingowe

- pionier

- plato

- Analiza danych Platona

- PlatoDane

- Grać

- możliwy

- potencjał

- power

- powered

- pragmatyczny

- Detaliczność

- przygotowany

- prywatny

- Problem

- cele

- Putting

- pytania

- Szybki

- Wyścig

- zasięg

- ransomware

- RE

- osiągnięcie

- Gotowość

- potwierdza

- Rzeczywistość

- niedawny

- w sprawie

- pozostawać

- szczątki

- wymagać

- Wymaga

- sprężysty

- Zasoby

- odpowiedź

- prawo

- Ryzyko

- ROI

- Rola

- s

- taki sam

- mówią

- Skala

- skalowaniem

- scenariusz

- nauka

- Fantastyka naukowa

- poszukiwania

- bezpieczeństwo

- widzieć

- widzenie

- poszukuje

- widziany

- oddzielny

- służyć

- Tarcza

- Signal

- znaczący

- znacznie

- Rozmiar

- umiejętności

- mały

- So

- trzeźwy

- Tworzenie

- rozwoju oprogramowania

- kilka

- wkrótce

- Źródło

- specyficzny

- prędkość

- kolec

- rozpoczęty

- Nadal

- znaczny

- w zasadzie

- udany

- wrażliwy

- taktyka

- Brać

- biorąc

- cel

- kierowania

- Zespoły

- tech

- tech

- Technologies

- niż

- Podziękowania

- że

- Połączenia

- ich

- Im

- sami

- następnie

- Tam.

- Te

- one

- rzeczy

- to

- tych

- chociaż?

- groźba

- zagrożenia

- Przez

- czas

- do

- już dziś

- także

- w kierunku

- ruch drogowy

- Trening

- rodzaj

- Ostatecznie

- nieznany

- mało prawdopodobne,

- posługiwać się

- przypadek użycia

- Przypadki użycia AI

- używany

- różnorodny

- bardzo

- Ve

- przedsięwzięcie

- chcieć

- Droga..

- we

- waga

- DOBRZE

- cokolwiek

- jeśli chodzi o komunikację i motywację

- który

- Podczas

- KIM

- dlaczego

- Dziki

- będzie

- w

- w ciągu

- Wygrał

- słowa

- XDR

- jeszcze

- Twój

- zefirnet