Sztuczna inteligencja (AI) to szybko rozwijająca się dziedzina, która może ulepszyć i przekształcić wiele aspektów społeczeństwa. W 2023 r. tempo wdrażania technologii sztucznej inteligencji uległo dalszemu przyspieszeniu wraz z opracowaniem potężnych modeli podstawowych (FM) i wynikającym z tego postępem w zakresie możliwości generatywnej sztucznej inteligencji.

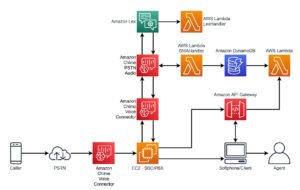

W Amazon uruchomiliśmy wiele usług generatywnej sztucznej inteligencji, takich jak Amazońska skała macierzysta i Zaklinacz kodów Amazoni udostępnili szereg wysoce wydajnych modeli generatywnych za pośrednictwem Amazon SageMaker JumpStart. Usługi te mają na celu wspieranie naszych klientów w uwalnianiu pojawiających się możliwości generatywnej sztucznej inteligencji, w tym zwiększonej kreatywności, spersonalizowanego i dynamicznego tworzenia treści oraz innowacyjnego projektowania. Mogą także umożliwić specjalistom zajmującym się sztuczną inteligencją nadanie światu sensu jak nigdy dotąd – eliminując bariery językowe, zmiany klimatyczne, przyspieszając odkrycia naukowe i nie tylko.

Aby jednak w pełni wykorzystać potencjał generatywnej sztucznej inteligencji, należy dokładnie zastanowić się nad wszelkimi potencjalnymi zagrożeniami. Przede wszystkim przynosi to korzyści zainteresowanym stronom systemu sztucznej inteligencji, promując odpowiedzialny i bezpieczny rozwój i wdrażanie oraz zachęcając do przyjmowania proaktywnych środków w celu zaradzenia potencjalnemu wpływowi. W związku z tym ustanowienie mechanizmów oceny ryzyka i zarządzania nim jest ważnym procesem do rozważenia przez specjalistów zajmujących się sztuczną inteligencją i stało się kluczowym elementem wielu pojawiających się standardów branżowych związanych ze sztuczną inteligencją (na przykład ISO 42001, ISO 23894, NIST RMF) i prawodawstwa (np Ustawa UE o sztucznej inteligencji).

W tym poście omawiamy, jak ocenić potencjalne ryzyko związane z systemem sztucznej inteligencji.

Jakie są różne poziomy ryzyka?

Chociaż łatwiej byłoby zacząć przyglądać się pojedynczemu modelowi uczenia maszynowego (ML) i związanemu z nim ryzyku w izolacji, ważne jest, aby wziąć pod uwagę szczegóły konkretnego zastosowania takiego modelu i odpowiadającego mu przypadku użycia w ramach kompletnego systemu sztucznej inteligencji . W rzeczywistości typowy system sztucznej inteligencji będzie prawdopodobnie opierał się na wielu współpracujących ze sobą modelach uczenia maszynowego, a organizacja może chcieć zbudować wiele różnych systemów sztucznej inteligencji. W związku z tym ryzyko można oceniać dla każdego przypadku użycia i na różnych poziomach, a mianowicie ryzyka modelu, ryzyka systemu AI i ryzyka przedsiębiorstwa.

Ryzyko przedsiębiorstwa obejmuje szerokie spektrum ryzyk, na jakie może narazić się organizacja, włączając w to ryzyko finansowe, operacyjne i strategiczne. Ryzyko systemu AI koncentruje się na skutkach związanych z wdrażaniem i działaniem systemów AI, podczas gdy ryzyko modelu ML dotyczy w szczególności podatności i niepewności właściwych modelom ML.

W tym poście skupiamy się przede wszystkim na ryzyku systemów AI. Należy jednak pamiętać, że należy wziąć pod uwagę i dostosować wszystkie poziomy zarządzania ryzykiem w organizacji.

Jak definiuje się ryzyko systemu AI?

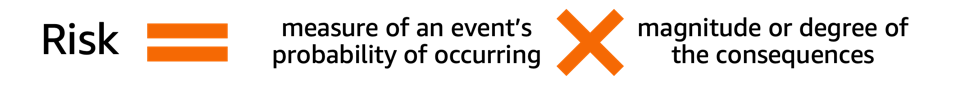

Zarządzanie ryzykiem w kontekście systemu sztucznej inteligencji może być ścieżką minimalizującą wpływ niepewności lub potencjalnych negatywnych skutków, zapewniając jednocześnie możliwości maksymalizacji pozytywnych skutków. Ryzyko samo w sobie nie jest potencjalną szkodą, ale efektem niepewności na cele. Według Ramy zarządzania ryzykiem NIST (NIST RMF) ryzyko można oszacować jako multiplikatywną miarę prawdopodobieństwa wystąpienia zdarzenia w czasie według wielkości konsekwencji odpowiedniego zdarzenia.

Ryzyko ma dwa aspekty: ryzyko nieodłączne i ryzyko rezydualne. Ryzyko nieodłączne reprezentuje wielkość ryzyka, jakie wykazuje system sztucznej inteligencji przy braku środków łagodzących lub kontroli. Ryzyko rezydualne obejmuje ryzyko pozostałe po uwzględnieniu strategii łagodzących.

Zawsze należy pamiętać, że ocena ryzyka to działanie skupiające się na człowieku, które wymaga wysiłków całej organizacji; wysiłki te obejmują zapewnienie włączenia wszystkich odpowiednich interesariuszy w proces oceny (takich jak zespoły ds. produktu, inżynierii, nauki, sprzedaży i bezpieczeństwa) po ocenę, w jaki sposób perspektywy i normy społeczne wpływają na postrzegane prawdopodobieństwo i konsekwencje określonych zdarzeń.

Dlaczego Twoja organizacja powinna zadbać o ocenę ryzyka?

Ustanowienie ram zarządzania ryzykiem dla systemów sztucznej inteligencji może przynieść korzyści całemu społeczeństwu poprzez promowanie bezpiecznego i odpowiedzialnego projektowania, rozwoju i obsługi systemów sztucznej inteligencji. Ramy zarządzania ryzykiem mogą również przynieść korzyści organizacjom poprzez:

- Ulepszone podejmowanie decyzji – Rozumiejąc ryzyko związane z systemami sztucznej inteligencji, organizacje mogą podejmować lepsze decyzje dotyczące ograniczania tego ryzyka i korzystania z systemów sztucznej inteligencji w bezpieczny i odpowiedzialny sposób

- Zwiększone planowanie zgodności – Ramy oceny ryzyka mogą pomóc organizacjom przygotować się na wymagania dotyczące oceny ryzyka zawarte w odpowiednich przepisach ustawowych i wykonawczych

- Budowanie zaufania – Wykazując, że podejmują kroki w celu ograniczenia ryzyka związanego z systemami sztucznej inteligencji, organizacje mogą pokazać swoim klientom i interesariuszom, że są zaangażowani w korzystanie ze sztucznej inteligencji w bezpieczny i odpowiedzialny sposób

Jak ocenić ryzyko?

Na pierwszym etapie organizacja powinna rozważyć opisanie przypadku użycia sztucznej inteligencji, który należy ocenić, i zidentyfikować wszystkich odpowiednich interesariuszy. Przypadek użycia to konkretny scenariusz lub sytuacja opisująca, w jaki sposób użytkownicy wchodzą w interakcję z systemem AI, aby osiągnąć określony cel. Podczas tworzenia opisu przypadku użycia pomocne może być określenie rozwiązywanego problemu biznesowego, lista zaangażowanych interesariuszy, scharakteryzowanie przepływu pracy i podanie szczegółów dotyczących kluczowych wejść i wyjść systemu.

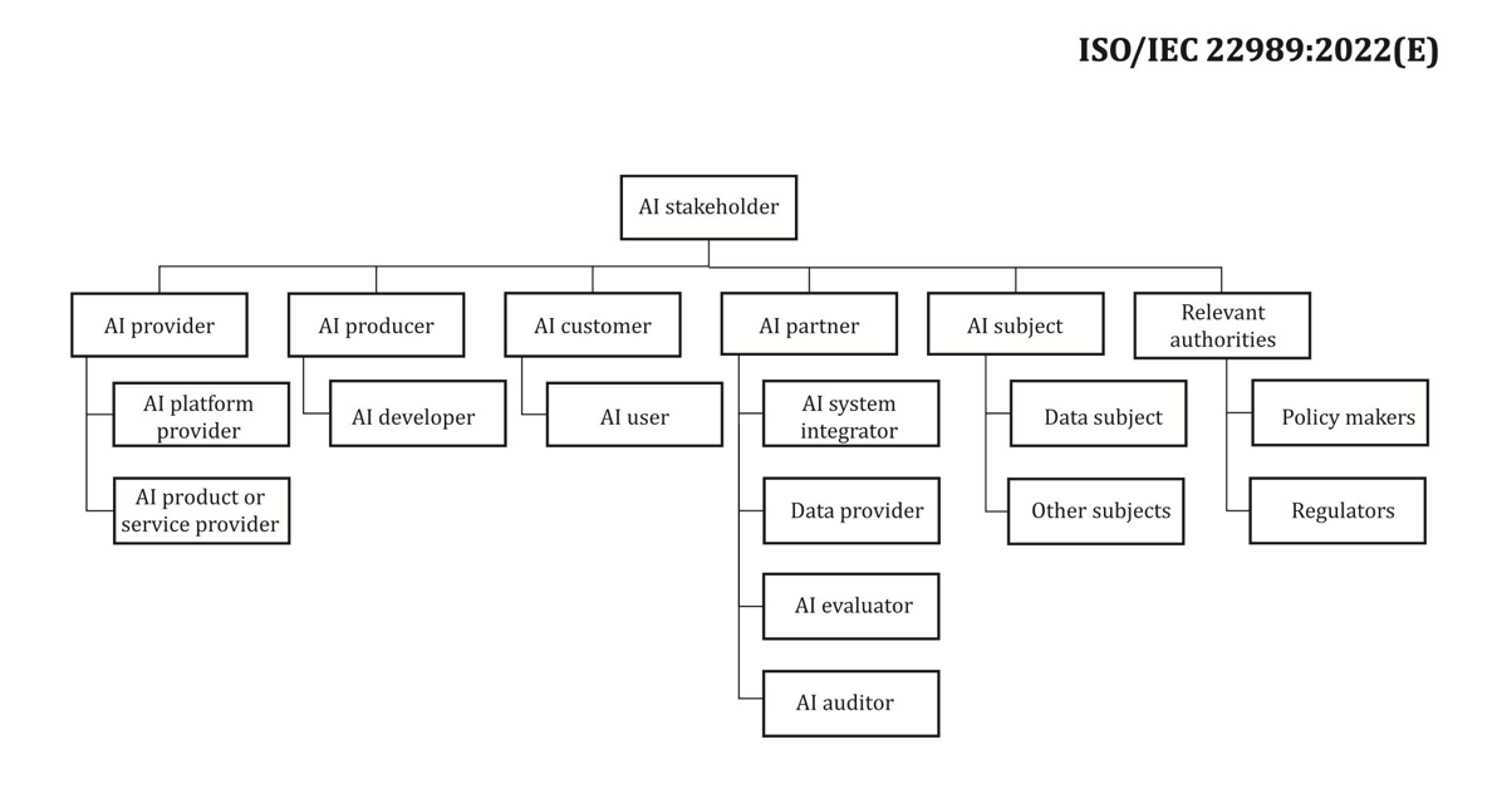

Jeśli chodzi o interesariuszy, łatwo niektórych przeoczyć. Poniższy rysunek jest dobrym punktem wyjścia do wyznaczenia ról interesariuszy AI.

Źródło: „Technologie informacyjne – Sztuczna inteligencja – Koncepcje i terminologia sztucznej inteligencji”.

Kolejnym ważnym krokiem w ocenie ryzyka systemu AI jest identyfikacja potencjalnie szkodliwych zdarzeń związanych z przypadkiem użycia. Rozważając te wydarzenia, pomocne może być zastanowienie się nad różnymi wymiarami odpowiedzialnej sztucznej inteligencji, takimi jak na przykład uczciwość i solidność. Wpływ na różnych interesariuszy może być w różnym stopniu i w różnych wymiarach. Na przykład niskie ryzyko dotyczące odporności dla użytkownika końcowego może wynikać z niewielkich zakłóceń w systemie sztucznej inteligencji, podczas gdy niskie ryzyko związane z bezstronnością może wynikać z tego, że system sztucznej inteligencji generuje znikomo różne wyniki dla różnych grup demograficznych.

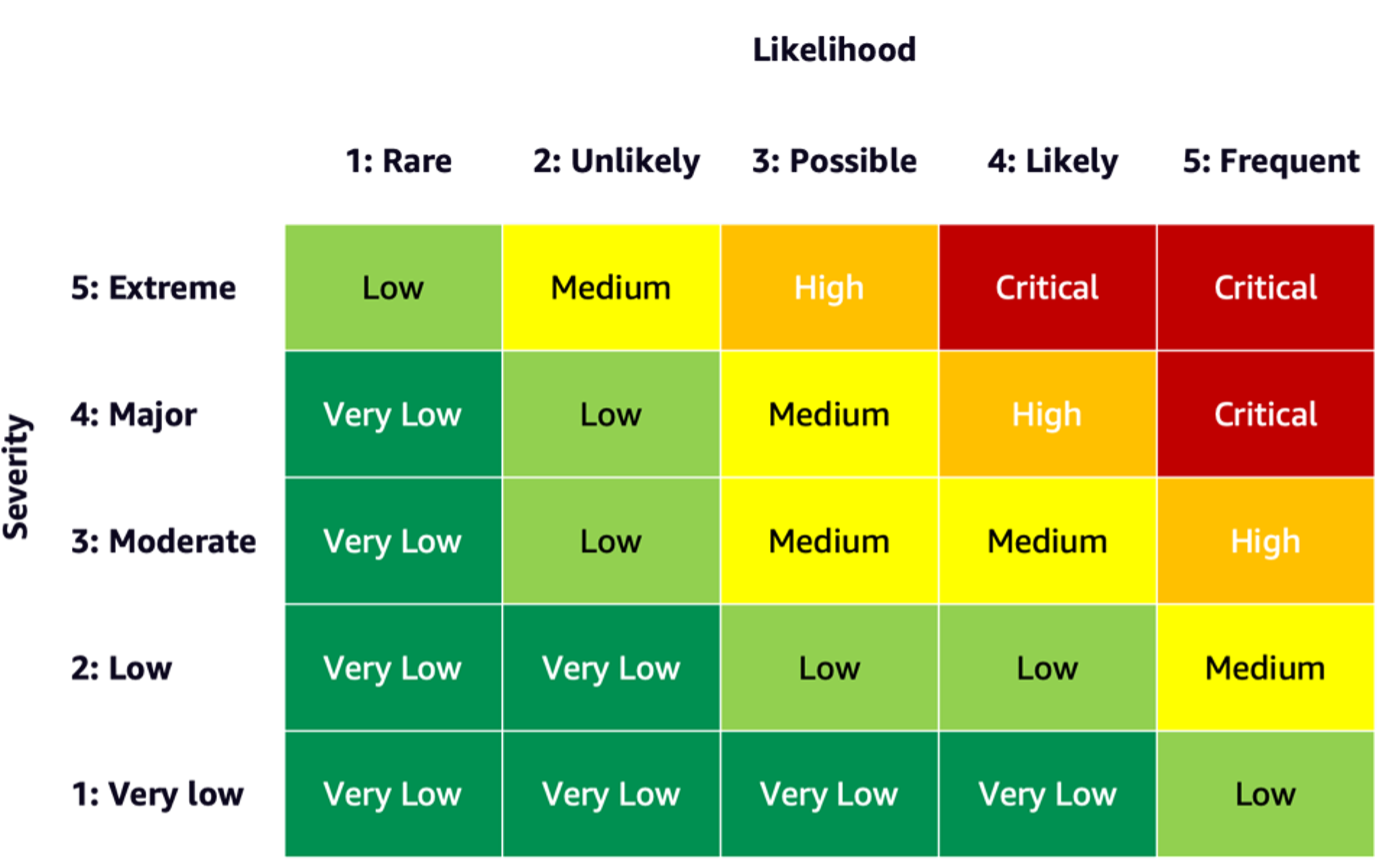

Aby oszacować ryzyko zdarzenia, można zastosować skalę prawdopodobieństwa w połączeniu ze skalą dotkliwości, aby zmierzyć prawdopodobieństwo wystąpienia zdarzenia oraz stopień jego konsekwencji. Pomocnym punktem wyjścia przy opracowywaniu tych skal może być NIST RMF, który sugeruje stosowanie jakościowych kategorii nienumerycznych od bardzo niskiego do bardzo wysokiego ryzyka lub zasad oceny półilościowej, takich jak skale (takie jak 1–10), przedziały lub inne reprezentatywne liczby. Po zdefiniowaniu skali prawdopodobieństwa i dotkliwości dla wszystkich odpowiednich wymiarów można użyć schematu macierzy ryzyka w celu ilościowego określenia ogólnego ryzyka na interesariuszy według każdego istotnego wymiaru. Poniższy rysunek przedstawia przykładową macierz ryzyka.

Korzystając z tej macierzy ryzyka, możemy uznać zdarzenie o niskiej wadze i rzadkim prawdopodobieństwie wystąpienia za bardzo niskie ryzyko. Należy pamiętać, że wstępna ocena będzie oszacowaniem ryzyka nieodłącznego, a strategie ograniczania ryzyka mogą pomóc w dalszym obniżeniu poziomu ryzyka. Proces można następnie powtórzyć w celu wygenerowania oceny pozostałego ryzyka szczątkowego na zdarzenie. Jeśli w tym samym wymiarze zidentyfikowano wiele zdarzeń, pomocne może być wybranie najwyższego poziomu ryzyka spośród wszystkich w celu stworzenia ostatecznego podsumowania oceny.

Korzystając z końcowego podsumowania oceny, organizacje będą musiały określić, jakie poziomy ryzyka są akceptowalne dla ich systemów sztucznej inteligencji, a także wziąć pod uwagę odpowiednie regulacje i polityki.

Zaangażowanie AWS

Poprzez spotkania z Biały Dom i UNmiędzy innymi jesteśmy zaangażowani w dzielenie się naszą wiedzą i doświadczeniem, aby promować odpowiedzialne i bezpieczne korzystanie ze sztucznej inteligencji. Idąc tym tropem, Adam Selipsky z Amazona reprezentował niedawno AWS na targach Szczyt bezpieczeństwa AI z udziałem głów państw i liderów branży, co stanowi kolejny dowód naszego zaangażowania we współpracę na rzecz odpowiedzialnego rozwoju sztucznej inteligencji.

Wnioski

W miarę ciągłego rozwoju sztucznej inteligencji ocena ryzyka staje się coraz ważniejsza i użyteczna dla organizacji, które chcą odpowiedzialnie budować i wdrażać sztuczną inteligencję. Ustanawiając ramy oceny ryzyka i plan ograniczania ryzyka, organizacje mogą zmniejszyć ryzyko potencjalnych incydentów związanych ze sztuczną inteligencją i zdobyć zaufanie swoich klientów, a także czerpać korzyści, takie jak większa niezawodność, większa sprawiedliwość dla różnych grup demograficznych i nie tylko.

Śmiało, rozpocznij swoją przygodę z opracowywaniem ram oceny ryzyka w swojej organizacji i podziel się swoimi przemyśleniami w komentarzach.

Sprawdź także przegląd zagrożeń związanych z generatywną sztuczną inteligencją opublikowany na Amazon Science: Odpowiedzialna sztuczna inteligencja w erze generatywneji poznaj zakres usług AWS, które mogą wesprzeć Cię w procesie oceny i łagodzenia ryzyka: Amazon SageMaker Wyjaśnij, Monitor modelu Amazon SageMaker, Chmura AWS, Jak również modelowe ramy zarządzania.

O autorach

Mia C. Mayer jest naukowcem stosowanym i pedagogiem ML na Uniwersytecie AWS Machine Learning; gdzie bada i uczy bezpieczeństwa, wyjaśnialności i uczciwości systemów uczenia maszynowego i sztucznej inteligencji. W trakcie swojej kariery Mia stworzyła kilka uniwersyteckich programów informacyjnych, występowała jako gościnny wykładowca i główny mówca oraz występowała na wielu dużych konferencjach edukacyjnych. Pomaga także wewnętrznym zespołom i klientom AWS rozpocząć odpowiedzialną podróż związaną ze sztuczną inteligencją.

Mia C. Mayer jest naukowcem stosowanym i pedagogiem ML na Uniwersytecie AWS Machine Learning; gdzie bada i uczy bezpieczeństwa, wyjaśnialności i uczciwości systemów uczenia maszynowego i sztucznej inteligencji. W trakcie swojej kariery Mia stworzyła kilka uniwersyteckich programów informacyjnych, występowała jako gościnny wykładowca i główny mówca oraz występowała na wielu dużych konferencjach edukacyjnych. Pomaga także wewnętrznym zespołom i klientom AWS rozpocząć odpowiedzialną podróż związaną ze sztuczną inteligencją.

Denis V. Batałow jest 17-letnim weteranem Amazon i doktoratem z uczenia maszynowego, Denis pracował nad tak ekscytującymi projektami, jak Search Inside the Book, aplikacje Amazon Mobile i Kindle Direct Publishing. Od 2013 roku pomaga klientom AWS w adaptacji technologii AI/ML jako Architekt Rozwiązań. Obecnie Denis jest Worldwide Tech Leader ds. AI/ML odpowiedzialnym za funkcjonowanie AWS ML Specialist Solutions Architects na całym świecie. Denis jest częstym mówcą publicznym, możesz śledzić go na Twitterze @dbatalov.

Denis V. Batałow jest 17-letnim weteranem Amazon i doktoratem z uczenia maszynowego, Denis pracował nad tak ekscytującymi projektami, jak Search Inside the Book, aplikacje Amazon Mobile i Kindle Direct Publishing. Od 2013 roku pomaga klientom AWS w adaptacji technologii AI/ML jako Architekt Rozwiązań. Obecnie Denis jest Worldwide Tech Leader ds. AI/ML odpowiedzialnym za funkcjonowanie AWS ML Specialist Solutions Architects na całym świecie. Denis jest częstym mówcą publicznym, możesz śledzić go na Twitterze @dbatalov.

Doktor Sara Liu jest starszym menedżerem ds. programów technicznych w zespole odpowiedzialnym za sztuczną inteligencję AWS. Współpracuje z zespołem naukowców, liderami zbiorów danych, inżynierami ML, badaczami, a także innymi zespołami interdyscyplinarnymi, aby podnieść poprzeczkę odpowiedzialnej sztucznej inteligencji w usługach AI AWS. Jej obecne projekty obejmują opracowywanie kart usług AI, przeprowadzanie ocen ryzyka dla odpowiedzialnej AI, tworzenie wysokiej jakości zbiorów danych ewaluacyjnych oraz wdrażanie programów jakości. Pomaga także wewnętrznym zespołom i klientom spełniać zmieniające się standardy branżowe AI.

Doktor Sara Liu jest starszym menedżerem ds. programów technicznych w zespole odpowiedzialnym za sztuczną inteligencję AWS. Współpracuje z zespołem naukowców, liderami zbiorów danych, inżynierami ML, badaczami, a także innymi zespołami interdyscyplinarnymi, aby podnieść poprzeczkę odpowiedzialnej sztucznej inteligencji w usługach AI AWS. Jej obecne projekty obejmują opracowywanie kart usług AI, przeprowadzanie ocen ryzyka dla odpowiedzialnej AI, tworzenie wysokiej jakości zbiorów danych ewaluacyjnych oraz wdrażanie programów jakości. Pomaga także wewnętrznym zespołom i klientom spełniać zmieniające się standardy branżowe AI.

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- PlatoData.Network Pionowe generatywne AI. Wzmocnij się. Dostęp tutaj.

- PlatoAiStream. Inteligencja Web3. Wiedza wzmocniona. Dostęp tutaj.

- PlatonESG. Węgiel Czysta technologia, Energia, Środowisko, Słoneczny, Gospodarowanie odpadami. Dostęp tutaj.

- Platon Zdrowie. Inteligencja w zakresie biotechnologii i badań klinicznych. Dostęp tutaj.

- Źródło: https://aws.amazon.com/blogs/machine-learning/learn-how-to-assess-risk-of-ai-systems/

- :ma

- :Jest

- :nie

- :Gdzie

- 100

- 118

- 150

- 2013

- 2023

- 33

- 7

- a

- O nas

- przyśpieszony

- przyspieszenie

- do przyjęcia

- Stosownie

- Osiągać

- w poprzek

- działalność

- Adam

- adres

- przyjąć

- Przyjęcie

- awansować

- postęp

- afektowany

- Po

- przed

- AI

- Ryzyko związane ze sztuczną inteligencją

- Usługi AI

- Systemy SI

- AI / ML

- wyrównany

- Wszystkie kategorie

- wzdłuż

- również

- Amazonka

- Amazon Web Services

- wśród

- ilość

- an

- i

- każdy

- Zastosowanie

- stosowany

- mobilne i webowe

- architekci

- SĄ

- sztuczny

- sztuczna inteligencja

- AS

- aspekty

- oszacować

- oceniać

- oceniając

- oszacowanie

- oceny

- powiązany

- At

- frekwencja

- dostępny

- AWS

- Uczenie maszynowe AWS

- bar

- bariery

- na podstawie

- BE

- stają się

- staje

- jest

- korzyści

- Korzyści

- Ulepsz Swój

- pojemniki

- książka

- szeroki

- budować

- biznes

- ale

- by

- CAN

- możliwości

- zdolny

- przechwytuje

- Kartki okolicznosciowe

- który

- Kariera

- ostrożnie

- walizka

- kategorie

- powodowany

- pewien

- zmiana

- charakteryzować

- ZOBACZ

- Klimat

- Zmiana klimatu

- współpracę

- połączenie

- byliśmy spójni, od początku

- komentarze

- zobowiązany

- kompletny

- spełnienie

- składnik

- Koncepcje

- prowadzenia

- konferencje

- Konsekwencje

- w konsekwencji

- Rozważać

- za

- wobec

- zawartość

- Tworzenie treści

- kontekst

- ciągły

- kontroli

- rdzeń

- Odpowiedni

- mógłby

- Stwórz

- Tworzenie

- tworzenie

- kreatywność

- zespoły wielofunkcyjne

- Aktualny

- Obecnie

- Klientów

- zbiory danych

- Decyzje

- poświęcenie

- określić

- zdefiniowane

- Stopień

- demograficzny

- Demografia

- demonstrowanie

- rozwijać

- Wdrożenie

- Opisujące

- opis

- Wnętrze

- zaprojektowany

- detale

- rozwijanie

- oprogramowania

- różne

- Wymiary

- Wymiary

- kierować

- dyskutować

- zakłócenia

- dynamiczny

- każdy

- zarabiać

- łatwiej

- łatwo

- efekt

- starania

- wschodzących

- umożliwiać

- obejmuje

- zachęcający

- angaże

- Inżynieria

- Inżynierowie

- wzmocnione

- zapewnienie

- Enterprise

- ustanowiony

- ustanowienie

- oszacowanie

- szacunkowa

- oceniane

- ewaluację

- wydarzenie

- wydarzenia

- ewoluuje

- przykład

- ekscytujący

- wykazujące

- eksponaty

- ekspertyza

- odkryj

- Twarz

- fakt

- factoring

- uczciwość

- pole

- Postać

- finał

- budżetowy

- i terminów, a

- Skupiać

- koncentruje

- obserwuj

- następujący

- W razie zamówieenia projektu

- główny

- Fundacja

- Framework

- Ramy

- częsty

- od

- pełny

- funkcjonowanie

- dalej

- Generować

- generatywny

- generatywna sztuczna inteligencja

- otrzymać

- Globalnie

- cel

- dobry

- zarządzanie

- Grupy

- Gość

- zaszkodzić

- szkodliwy

- Have

- he

- głowice

- pomoc

- pomógł

- pomocny

- pomaga

- jej

- Wysoki

- wysokiej jakości

- Najwyższa

- wysoko

- go

- W jaki sposób

- How To

- Jednak

- HTML

- HTTPS

- zidentyfikowane

- zidentyfikować

- if

- Rezultat

- Oddziaływania

- realizacja

- wykonawczych

- ważny

- podnieść

- ulepszony

- in

- włączony

- Włącznie z

- coraz bardziej

- indywidualny

- przemysł

- standardy przemysłowe

- wpływ

- nieodłączny

- początkowy

- Innowacyjny

- Wejścia

- wewnątrz

- Inteligencja

- interakcji

- wewnętrzny

- angażować

- zaangażowany

- ISO

- izolacja

- IT

- samo

- podróż

- jpg

- Trzymać

- Klawisz

- Myśl przewodnia

- Główny mówca

- wiedza

- język

- duży

- uruchomiona

- Laws

- lider

- Przywódcy

- Wyprowadzenia

- UCZYĆ SIĘ

- nauka

- Prawodawstwo

- poziom

- poziomy

- prawdopodobieństwo

- Prawdopodobnie

- linie

- Lista

- poszukuje

- niski

- niższy

- maszyna

- uczenie maszynowe

- zrobiony

- robić

- zarządzanie

- i konserwacjami

- kierownik

- wiele

- mapa

- Matrix

- Maksymalizuj

- Może..

- zmierzyć

- środków

- Mechanizmy

- Poznaj nasz

- może

- nic

- moll

- Złagodzić

- łagodzenie

- ML

- Aplikacje mobilne

- aplikacje mobilne

- model

- modele

- jeszcze

- wielokrotność

- mianowicie

- wymagania

- ujemny

- nigdy

- Następny

- nist

- normy

- noty

- z naszej

- liczny

- Cele

- występowanie

- występujący

- of

- on

- działanie

- operacyjny

- Szanse

- or

- organizacja

- organizacji

- Inne

- Pozostałe

- Inaczej

- ludzkiej,

- na zewnątrz

- Wyjścia

- zasięg

- ogólny

- przegląd

- Pokój

- część

- szczególny

- ścieżka

- dla

- spostrzegany

- Personalizowany

- perspektywy

- PhD

- wybierać

- krok po kroku

- plato

- Analiza danych Platona

- PlatoDane

- punkt

- polityka

- pozytywny

- Post

- potencjał

- potencjalnie

- mocny

- Przygotować

- przedstawione

- głównie

- Zasady

- Proaktywne

- Problem

- wygląda tak

- produkcji

- Produkt

- Program

- Programy

- projektowanie

- promowanie

- zapewniać

- że

- publiczny

- opublikowany

- Wydawniczy

- jakościowy

- jakość

- podnieść

- zasięg

- nośny

- szybko

- RZADKO SPOTYKANY

- ocena

- zrealizować

- zbierać

- niedawno

- zmniejszyć

- odzwierciedlić

- w sprawie

- regulamin

- niezawodność

- pozostały

- powtórzony

- przedstawiciel

- reprezentowane

- reprezentuje

- wymagania

- Wymaga

- Badacze

- badania

- odpowiedzialny

- odpowiedzialnie

- dalsze

- wynikły

- Ryzyko

- ocena ryzyka

- Zarządzanie ryzykiem

- ryzyko

- krzepkość

- role

- "bezpiecznym"

- Bezpieczeństwo

- sagemaker

- sole

- taki sam

- Skala

- waga

- scenariusz

- schemat

- nauka

- naukowy

- Naukowiec

- Naukowcy

- Szukaj

- bezpieczne

- bezpieczeństwo

- senior

- rozsądek

- usługa

- Usługi

- kilka

- Share

- dzielenie

- ona

- powinien

- pokazać

- Targi

- ponieważ

- sytuacja

- Obserwuj Nas

- Społeczeństwo

- Rozwiązania

- kilka

- Głośnik

- specjalista

- specyficzny

- swoiście

- Widmo

- interesariuszy

- interesariusze

- standardy

- początek

- rozpoczęty

- Startowy

- Stan

- Ewolucja krok po kroku

- Cel

- Strategiczny

- strategie

- taki

- Wskazuje

- PODSUMOWANIE

- wsparcie

- system

- systemy

- biorąc

- zespół

- Zespoły

- tech

- Techniczny

- Technologies

- Technologia

- że

- Połączenia

- świat

- ich

- następnie

- Tam.

- Te

- one

- to

- tych

- Przez

- poprzez

- Czasowy

- do

- razem

- Przekształcać

- Zaufaj

- i twitterze

- drugiej

- typowy

- niepewności

- Niepewność

- zrozumienie

- uniwersytet

- odblokowywanie

- posługiwać się

- przypadek użycia

- Użytkownicy

- za pomocą

- początku.

- weteran

- Luki w zabezpieczeniach

- we

- sieć

- usługi internetowe

- DOBRZE

- Co

- jeśli chodzi o komunikację i motywację

- natomiast

- który

- Podczas

- będzie

- w

- w ciągu

- pracował

- workflow

- pracujący

- działa

- świat

- na calym swiecie

- You

- Twój

- zefirnet