Wprowadzenie

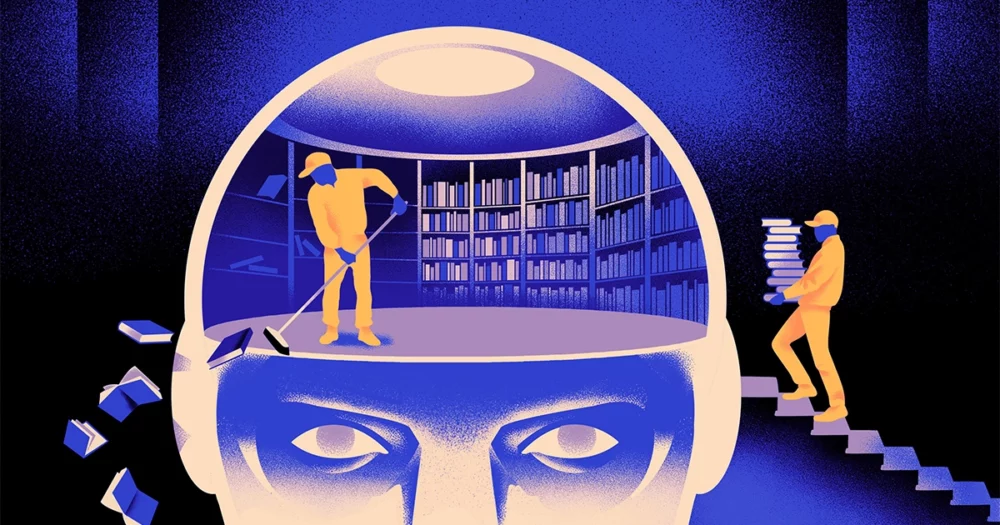

Zespół informatyków stworzył zwinniejszy, bardziej elastyczny typ modelu uczenia maszynowego. Sztuczka: musi okresowo zapominać o tym, co wie. I chociaż to nowe podejście nie zastąpi ogromnych modeli leżących u podstaw największych aplikacji, może ujawnić więcej na temat tego, jak te programy rozumieją język.

Nowe badania oznaczają „znaczący postęp w tej dziedzinie” – stwierdził Jea Kwon, inżynier AI w Instytucie Nauk Podstawowych w Korei Południowej.

Używane obecnie silniki językowe AI są w większości zasilane przez sztuczne sieci neuronowe. Każdy „neuron” w sieci jest funkcją matematyczną, która odbiera sygnały od innych takich neuronów, wykonuje pewne obliczenia i wysyła sygnały dalej przez wiele warstw neuronów. Początkowo przepływ informacji jest mniej więcej losowy, ale w trakcie uczenia przepływ informacji między neuronami poprawia się, gdy sieć dostosowuje się do danych uczących. Jeśli badacz sztucznej inteligencji chce na przykład stworzyć model dwujęzyczny, wytrenuje model z dużą ilością tekstu z obu języków, co dostosuje połączenia między neuronami w taki sposób, aby powiązać tekst w jednym języku z równoważnymi słowa w drugim.

Jednak ten proces uczenia wymaga dużej mocy obliczeniowej. Jeśli model nie sprawdza się zbyt dobrze lub jeśli potrzeby użytkownika później się zmieniają, trudno jest go dostosować. „Załóżmy, że masz model obejmujący 100 języków, ale wyobraź sobie, że jeden z wybranych języków nie jest uwzględniony” – powiedział Mikela Artetxe’a, współautor nowego badania i założyciel startupu AI Reka. „Można zacząć od zera, ale nie jest to idealne rozwiązanie”.

Artetxe i jego współpracownicy próbowali ominąć te ograniczenia. Kilka lat temuArtetxe i inni przeszkolili sieć neuronową w jednym języku, a następnie wymazali wszystko, co wiedzieli o elementach składowych słów, zwanych tokenami. Są one przechowywane w pierwszej warstwie sieci neuronowej, zwanej warstwą osadzającą. Wszystkie pozostałe warstwy modelu zostawili w spokoju. Po wymazaniu tokenów pierwszego języka przeszkolono model na drugim języku, co wypełniło warstwę embedującą nowymi tokenami z tego języka.

Mimo że model zawierał niedopasowane informacje, przekwalifikowanie zadziałało: model mógł uczyć się i przetwarzać nowy język. Naukowcy przypuszczali, że podczas gdy warstwa osadzająca przechowuje informacje specyficzne dla słów używanych w danym języku, głębsze poziomy sieci przechowują bardziej abstrakcyjne informacje na temat pojęć stojących za językami ludzkimi, co następnie pomogło modelowi nauczyć się drugiego języka.

„Żyjemy w tym samym świecie. Konceptualizujemy te same rzeczy różnymi słowami” w różnych językach, powiedział Yihong Chena, główny autor najnowszego artykułu. „Dlatego w modelu zastosowano to samo rozumowanie na wysokim poziomie. Jabłko to coś słodkiego i soczystego, a nie tylko słowo.”

Wprowadzenie

Chociaż podejście polegające na zapominaniu było skutecznym sposobem na dodanie nowego języka do już wytrenowanego modelu, przekwalifikowanie było nadal wymagające — wymagało dużej ilości danych językowych i mocy obliczeniowej. Chen zasugerował ulepszenie: zamiast trenować, usuwać warstwę osadzającą, a następnie ponownie trenować, powinni okresowo resetować warstwę osadzającą podczas pierwszej rundy szkolenia. „Dzięki temu cały model przyzwyczaja się do resetowania” – powiedział Artetxe. „Oznacza to, że gdy chcesz rozszerzyć model na inny język, jest to łatwiejsze, ponieważ właśnie to robiłeś”.

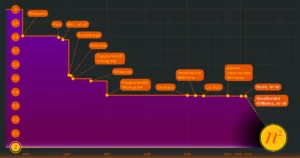

Naukowcy przyjęli powszechnie używany model językowy zwany Roberta, przeszkolili go, stosując technikę okresowego zapominania, i porównali je z wynikami tego samego modelu, gdy był szkolony przy użyciu standardowego podejścia polegającego na niezapominaniu. Model zapominania wypadł nieco gorzej niż model konwencjonalny, uzyskując wynik 85.1 w porównaniu z 86.1 w jednym powszechnym mierniku poprawności językowej. Następnie przeszkolili modele w innych językach, używając znacznie mniejszych zestawów danych zawierających zaledwie 5 milionów tokenów zamiast 70 miliardów, których używali podczas pierwszego szkolenia. Dokładność modelu standardowego spadła średnio do 53.3, natomiast modelu zapominającego spadła jedynie do 62.7.

Model zapominania również wypadł znacznie lepiej, jeśli zespół narzucił ograniczenia obliczeniowe podczas przekwalifikowania. Kiedy badacze skrócili długość treningu ze 125,000 5,000 kroków do zaledwie 57.8, dokładność modelu zapominania spadła średnio do 37.2, podczas gdy modelu standardowego spadła do XNUMX, co nie jest lepsze od przypadkowych domysłów.

Wprowadzenie

Zespół doszedł do wniosku, że okresowe zapominanie sprawia, że model ogólnie lepiej radzi sobie z nauką języków. „Ponieważ [oni] podczas szkolenia ciągle zapominają i uczą się na nowo, późniejsze nauczenie sieci czegoś nowego staje się łatwiejsze” – stwierdził Jewgienij Nikiszyn, badacz w Mila, centrum badań nad głębokim uczeniem się w Quebecu. Sugeruje to, że kiedy modele językowe rozumieją język, robią to na głębszym poziomie niż tylko znaczenia poszczególnych słów.

Podejście jest podobne do działania naszego mózgu. „Ogólnie rzecz biorąc, pamięć ludzka nie jest zbyt dobra w dokładnym przechowywaniu dużych ilości szczegółowych informacji. Zamiast tego ludzie mają tendencję do zapamiętywania istoty naszych doświadczeń, abstrahując i ekstrapolując” – stwierdziła Beniamin Levi, neurolog z Uniwersytetu w San Francisco. „Włączenie sztucznej inteligencji w procesach bardziej przypominających ludzkie, takich jak adaptacyjne zapominanie, to jeden ze sposobów zapewnienia im bardziej elastycznej wydajności”.

Oprócz tego, co może powiedzieć na temat działania rozumienia, Artetxe ma nadzieję, że bardziej elastyczne modele języka zapominającego mogą również pomóc w udostępnieniu najnowszych przełomowych osiągnięć w zakresie sztucznej inteligencji w większej liczbie języków. Chociaż modele AI dobrze radzą sobie z hiszpańskim i angielskim, dwoma językami i mają mnóstwo materiałów szkoleniowych, modele nie radzą sobie tak dobrze z jego ojczystym baskijskim, lokalnym językiem charakterystycznym dla północno-wschodniej Hiszpanii. „Większość modelek z dużych firm technologicznych nie radzi sobie dobrze” – powiedział. „Najlepszym rozwiązaniem jest dostosowanie istniejących modeli do języka baskijskiego”.

Chen nie może się również doczekać świata, w którym kwitnie więcej kwiatów AI. „Mam na myśli sytuację, w której świat nie potrzebuje jednego wielkiego modelu językowego. Mamy ich tak wielu” – powiedziała. „Jeśli istnieje fabryka produkująca modele językowe, potrzebujesz tego rodzaju technologii. Ma jeden model podstawowy, który można szybko dostosować do nowych domen.”

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- PlatoData.Network Pionowe generatywne AI. Wzmocnij się. Dostęp tutaj.

- PlatoAiStream. Inteligencja Web3. Wiedza wzmocniona. Dostęp tutaj.

- PlatonESG. Węgiel Czysta technologia, Energia, Środowisko, Słoneczny, Gospodarowanie odpadami. Dostęp tutaj.

- Platon Zdrowie. Inteligencja w zakresie biotechnologii i badań klinicznych. Dostęp tutaj.

- Źródło: https://www.quantamagazine.org/how-selective-forgetting-can-help-ai-learn-better-20240228/

- :ma

- :Jest

- :nie

- :Gdzie

- ][P

- 000

- 1

- 100

- 125

- 7

- 70

- 8

- a

- O nas

- ABSTRACT

- precyzja

- dokładnie

- przystosować

- adaptive

- dostosowuje się

- Dodaj

- dodatek

- awansować

- Po

- AI

- Modele AI

- Wszystkie kategorie

- sam

- już

- również

- kwoty

- an

- i

- Inne

- Apple

- podejście

- mobilne i webowe

- SĄ

- AS

- At

- autor

- średni

- baza

- podstawowy

- bo

- staje się

- być

- za

- Ulepsz Swój

- pomiędzy

- Duży

- wielka technologia

- Najwyższa

- Miliard

- Bloki

- Kwitnąć

- obie

- przełomy

- przynieść

- Budowanie

- ale

- by

- Obliczenia

- nazywa

- CAN

- Centrum

- zmiana

- chen

- przechytrzyć

- Współautor

- koledzy

- wspólny

- powszechnie

- Firmy

- w porównaniu

- obliczeniowy

- komputer

- computing

- moc obliczeniowa

- Koncepcje

- zawarta

- połączenia

- zawarte

- Konwencjonalny

- mógłby

- pokryty

- Stwórz

- stworzony

- Ciąć

- dane

- zestawy danych

- zmniejszony

- głęboko

- głęboka nauka

- głębiej

- wymagający

- szczegółowe

- ZROBIŁ

- różne

- do

- Nie

- robi

- domeny

- nie

- porzucone

- podczas

- każdy

- łatwiej

- Efektywne

- osadzanie

- inżynier

- silniki

- Angielski

- Cały

- Równoważny

- przykład

- Przede wszystkim system został opracowany

- Doświadczenia

- rozciągać się

- fabryka

- kilka

- pole

- wypełniony

- i terminów, a

- elastyczne

- pływ

- W razie zamówieenia projektu

- Naprzód

- założyciel

- Francisco

- od

- funkcjonować

- Ogólne

- ogólnie

- otrzymać

- GitHub

- Go

- dobry

- Prowadzenie

- Ciężko

- Have

- he

- pomoc

- pomógł

- na wysokim szczeblu

- jego

- ma nadzieję,

- W jaki sposób

- HTTPS

- olbrzymi

- człowiek

- podobny do człowieka

- Ludzie

- idealny

- if

- obraz

- nałożone

- poprawia

- in

- indywidualny

- Informacja

- początkowy

- początkowo

- zamiast

- Instytut

- IT

- właśnie

- Trzymać

- Uprzejmy

- wie

- Korea

- język

- Języki

- duży

- później

- firmy

- warstwa

- nioski

- prowadzić

- UCZYĆ SIĘ

- nauka

- lewo

- Długość

- mniej

- poziom

- poziomy

- lubić

- Ograniczenia

- Limity

- relacja na żywo

- miejscowy

- WYGLĄD

- Partia

- maszyna

- uczenie maszynowe

- magazyn

- robić

- Dokonywanie

- wiele

- materiały

- matematyczny

- znaczenia

- znaczy

- zmierzyć

- Pamięć

- może

- milion

- model

- modele

- jeszcze

- przeważnie

- dużo

- wielokrotność

- musi

- rodzimy

- Potrzebować

- wymagania

- sieć

- nerwowy

- sieci neuronowe

- Neurony

- Nowości

- Nie

- of

- on

- ONE

- tylko

- or

- Inne

- Pozostałe

- ludzkiej,

- koniec

- własny

- Papier

- jest gwarancją najlepszej jakości, które mogą dostarczyć Ci Twoje monitory,

- periodycznie

- plato

- Analiza danych Platona

- PlatoDane

- pogrążony

- power

- powered

- wygląda tak

- procesów

- przetwarzanie

- Moc przetwarzania

- Programy

- Magazyn ilościowy

- Quebec

- szybko

- przypadkowy

- raczej

- otrzymuje

- odbieranie

- niedawny

- pamiętać

- wymagany

- Badania naukowe

- badacz

- Badacze

- ujawniać

- okrągły

- działa

- Powiedział

- taki sam

- San

- San Francisco

- powiedzieć

- nauka

- Naukowcy

- wynik

- zadraśnięcie

- druga

- wydaje

- selektywny

- wysyła

- Zestawy

- ona

- powinien

- Sygnały

- znaczący

- podobny

- sytuacja

- mniejszy

- So

- kilka

- coś

- Południe

- Korea Południowa

- Hiszpania

- hiszpański

- specyficzny

- standard

- początek

- startup

- Cel

- Nadal

- przechowywany

- przechowywania

- taki

- Wskazuje

- słodki

- trwa

- Nauczanie

- zespół

- tech

- tech

- technika

- Technologia

- Tendencję

- XNUMX

- niż

- że

- Połączenia

- Informacje

- świat

- ich

- Im

- następnie

- Te

- one

- rzeczy

- Myślący

- to

- chociaż?

- Przez

- do

- już dziś

- Żetony

- wziął

- Pociąg

- przeszkolony

- Trening

- sztuczka

- wypróbowany

- uszczypnąć

- drugiej

- zrozumieć

- zrozumienie

- uniwersytet

- posługiwać się

- używany

- za pomocą

- początku.

- chcieć

- chce

- była

- Droga..

- we

- webp

- DOBRZE

- Co

- jeśli chodzi o komunikację i motywację

- który

- Podczas

- dlaczego

- w

- słowo

- słowa

- Praca

- pracował

- działa

- świat

- gorzej

- by

- lat

- You

- zefirnet