Wprowadzenie

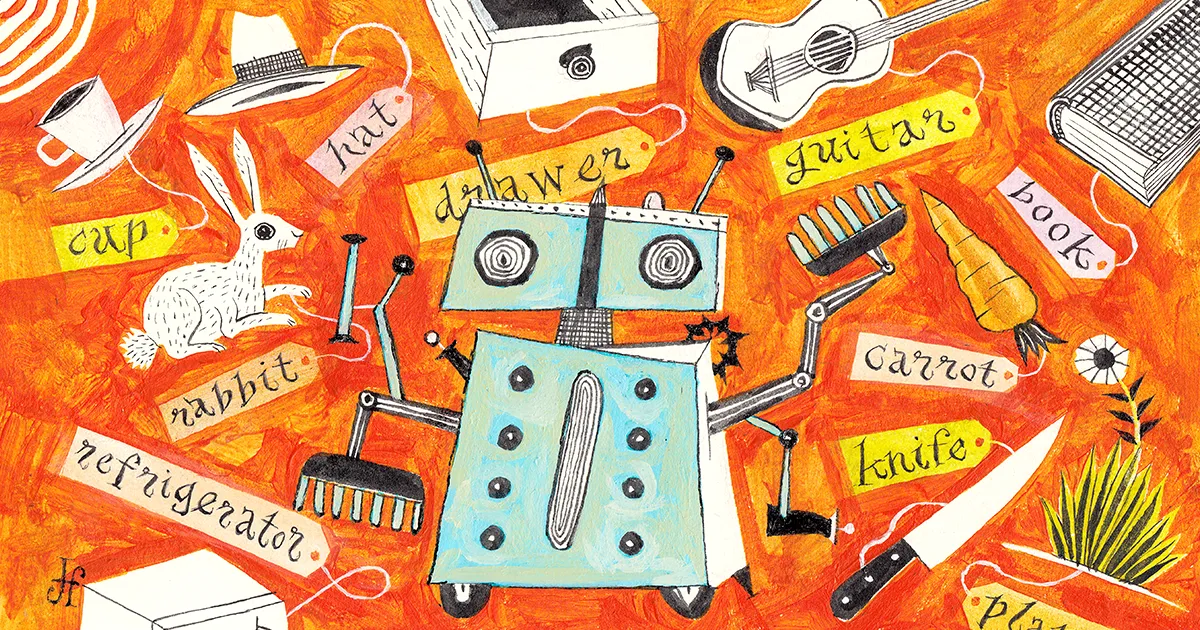

Wyobraź sobie, że twój sąsiad dzwoni z prośbą o przysługę: czy mógłbyś nakarmić jego królika plasterkami marchwi? Pomyślałbyś, że dość łatwo. Możesz sobie wyobrazić ich kuchnię, nawet jeśli nigdy w niej nie byłeś — marchewki w lodówce, szuflada z różnymi nożami. To wiedza abstrakcyjna: nie wiesz, jak dokładnie wyglądają marchewki i noże sąsiada, ale do ogórka nie weźmiesz łyżki.

Programy sztucznej inteligencji nie mogą konkurować. To, co wydaje ci się łatwym zadaniem, jest ogromnym przedsięwzięciem dla obecnych algorytmów.

Robot wyszkolony przez sztuczną inteligencję może znaleźć określony nóż i marchewkę ukrywające się w znajomej kuchni, ale w innej kuchni będzie mu brakować abstrakcyjnych umiejętności, aby odnieść sukces. „Nie generalizują w nowych środowiskach” — powiedział Wiktor Zhong, absolwent informatyki na Uniwersytecie Waszyngtońskim. Maszyna zawodzi, ponieważ jest po prostu zbyt wiele do nauczenia się i zbyt rozległa przestrzeń do zbadania.

Problem polega na tym, że te roboty — i ogólnie agenci AI — nie mają podstaw konceptualnych, na których mogliby się oprzeć. Nie wiedzą, czym tak naprawdę jest nóż lub marchewka, a tym bardziej, jak otworzyć szufladę, wybrać jedną i pokroić w plastry. To ograniczenie wynika częściowo z faktu, że wiele zaawansowanych systemów sztucznej inteligencji jest szkolonych metodą zwaną uczeniem się przez wzmacnianie, która zasadniczo polega na samokształceniu metodą prób i błędów. Agenci AI przeszkoleni w uczeniu się przez wzmacnianie mogą bardzo dobrze wykonywać pracę, do której zostali wyszkoleni, w środowisku, w którym zostali przeszkoleni. Ale zmiana pracy lub środowiska często zawodzi.

Aby obejść to ograniczenie, informatycy zaczęli uczyć maszyny ważnych pojęć, zanim je uwolnią. To tak, jakbyś czytał podręcznik przed użyciem nowego oprogramowania: możesz spróbować odkrywać bez niego, ale dzięki niemu nauczysz się o wiele szybciej. „Ludzie uczą się poprzez połączenie działania i czytania” — powiedział Karthika Narasimhana, informatyk z Uniwersytetu Princeton. „Chcemy, aby maszyny robiły to samo”.

Nowa praca Zhong i inni pokazują, że przygotowanie modelu uczenia się w ten sposób może przyspieszyć naukę w symulowanych środowiskach, zarówno online, jak iw prawdziwym świecie z robotami. I nie tylko sprawia, że algorytmy uczą się szybciej — prowadzi je do umiejętności, których inaczej nigdy by się nie nauczyły. Naukowcy chcą, aby ci agenci stali się generalistami, zdolnymi do nauczenia się wszystkiego, od szachów po zakupy i sprzątanie. A ponieważ demonstracje stają się bardziej praktyczne, naukowcy sądzą, że to podejście może nawet zmienić sposób interakcji ludzi z robotami.

„To był całkiem duży przełom” — powiedział Brian Ichter, naukowiec zajmujący się robotyką w Google. „To niewyobrażalne, jak daleko zaszedł w ciągu półtora roku”.

Rzadkie nagrody

Na pierwszy rzut oka uczenie maszynowe odniosło już ogromny sukces. Większość modeli zwykle używa uczenie się wzmacniania, gdzie algorytmy uczą się, otrzymując nagrody. Zaczynają całkowicie nieświadomi, ale metoda prób i błędów w końcu staje się próbą i zwycięstwem. Agenci uczący się przez wzmacnianie mogą z łatwością opanować proste gry.

Weźmy pod uwagę grę wideo Snake, w której gracze kontrolują węża, który rośnie, gdy zjada cyfrowe jabłka. Chcesz, aby twój wąż jadł jak najwięcej jabłek, nie przekraczał granic i unikał wpadania na jego coraz bardziej masywne ciało. Takie wyraźne dobre i złe wyniki dają dobrze wynagradzanemu agentowi maszyn pozytywne opinie, więc wystarczająca liczba prób może sprawić, że od „nooba” do wysokiego wyniku.

Ale załóżmy, że zasady się zmienią. Być może ten sam agent musi grać na większej siatce iw trzech wymiarach. Podczas gdy gracz-człowiek mógłby szybko się przystosować, maszyna nie może, z powodu dwóch krytycznych słabości. Po pierwsze, większa przestrzeń oznacza, że wąż potrzebuje więcej czasu, aby natknąć się na jabłka, a uczenie się spowalnia wykładniczo, gdy nagrody stają się rzadkie. Po drugie, nowy wymiar zapewnia zupełnie nowe doświadczenie, a uczenie wzmacniające ma trudności z uogólnieniem na nowe wyzwania.

Zhong mówi, że nie musimy akceptować tych przeszkód. „Dlaczego jest tak, że kiedy chcemy zagrać w szachy” — kolejną grę opanowaną przez uczenie się przez wzmacnianie — „trenujemy agenta uczenia się przez wzmacnianie od podstaw?” Takie podejście jest nieskuteczne. Agent wędruje bez celu, dopóki nie natknie się na dobrą sytuację, taką jak mat, a Zhong mówi, że wymaga starannego ludzkiego projektu, aby agent wiedział, co to znaczy, że sytuacja jest dobra. „Dlaczego musimy to robić, skoro mamy już tyle książek o tym, jak grać w szachy?”

Częściowo dzieje się tak dlatego, że maszyny miały trudności ze zrozumieniem ludzkiego języka i rozszyfrowaniem obrazów. Aby robot mógł wykonywać zadania wizyjne, takie jak na przykład znajdowanie i krojenie marchewki, musi wiedzieć, czym jest marchewka — obraz rzeczy musi być „ugruntowany” w bardziej fundamentalnym zrozumieniu, czym ta rzecz jest. Do niedawna nie było na to dobrego sposobu, ale boom w szybkości i skali przetwarzania języka i obrazu umożliwił nowe sukcesy.

Nowości przetwarzanie języka naturalnego modele pozwalają maszynom zasadniczo uczyć się znaczenia słów i zdań — ugruntować je w rzeczach na świecie — zamiast po prostu przechowywać proste (i ograniczone) znaczenie, takie jak cyfrowy słownik.

Wizja komputerowa doświadczyła podobnej cyfrowej eksplozji. Około 2009 roku ImageNet zadebiutował jako baza danych obrazów z adnotacjami do badań wizji komputerowej. Obecnie zawiera ponad 14 milionów zdjęć przedmiotów i miejsc. I programy takie jak OpenAI DALEJ·E generować nowe obrazy na polecenie, które wyglądają na stworzone przez człowieka, mimo że nie mają dokładnego porównania, z którego można by czerpać.

Pokazuje, że maszyny dopiero teraz mają dostęp do wystarczającej ilości danych online, aby naprawdę dowiedzieć się o świecie Anima Anandkumar, informatyk z California Institute of Technology i Nvidia. I to znak, że mogą uczyć się na koncepcjach tak jak my i wykorzystywać je przez całe pokolenie. „Jesteśmy teraz w tak wspaniałej chwili” – powiedziała. „Ponieważ kiedy uda nam się uzyskać pokolenie, możemy zrobić o wiele więcej”.

Granie w system

Badacze tacy jak Zhong zdecydowali, że maszyny nie muszą już rozpoczynać swoich eksploracji całkowicie niedoinformowane. Uzbrojeni w wyrafinowane modele językowe, naukowcy mogli dodać krok przed szkoleniem, w którym program uczył się na podstawie informacji online przed próbami i błędami.

Aby przetestować ten pomysł, on i jego koledzy porównali trening przedtreningowy z tradycyjnym uczeniem się przez wzmacnianie pięć różnych ustawień przypominających grę gdzie agenci maszynowi interpretowali polecenia językowe w celu rozwiązywania problemów. Każde symulowane środowisko stanowiło wyjątkowe wyzwanie dla agenta maszyny. Jeden poprosił agenta o manipulowanie przedmiotami w kuchni 3D; kolejny wymagał przeczytania tekstu, aby poznać dokładną sekwencję działań do walki z potworami. Ale najbardziej skomplikowanym ustawieniem była prawdziwa gra, 35-letni NetHack, w której celem jest poruszanie się po wyrafinowanym lochu w celu odzyskania amuletu.

W przypadku prostych ustawień zautomatyzowany trening przedtreningowy oznaczał po prostu ugruntowanie ważnych koncepcji: to jest marchewka, to jest potwór. W przypadku NetHack agent wyszkolony przez obserwowanie gry ludzi, korzystając z gier przesłanych do Internetu przez ludzkich graczy. Te rozgrywki nie musiały być nawet tak dobre — agent musiał jedynie zbudować intuicję dotyczącą zachowania ludzi. Agent nie miał zostać ekspertem, tylko zwykłym graczem. Budowałaby intuicję poprzez obserwację — co zrobiłby człowiek w danym scenariuszu? Agent decydowałby, które ruchy zakończyły się sukcesem, formułując własną marchewkę i kij.

„Dzięki wstępnemu szkoleniu tworzymy dobre podstawy, jak powiązać opisy językowe z rzeczami, które dzieją się na świecie” – powiedział Zhong. Agent grałby lepiej od samego początku i uczyłby się szybciej podczas późniejszego uczenia się przez wzmacnianie.

W rezultacie agent wyszkolony wcześniej osiągnął lepsze wyniki niż agent wyszkolony tradycyjnie. „Osiągamy korzyści we wszystkich pięciu z tych środowisk” — powiedział Zhong. Prostsze ustawienia wykazywały tylko niewielką przewagę, ale w skomplikowanych lochach NetHack agent uczył się wielokrotnie szybciej i osiągał poziom umiejętności, którego nie było w stanie osiągnąć klasyczne podejście. „Możesz uzyskać 10-krotną wydajność, ponieważ jeśli tego nie zrobisz, po prostu nie nauczysz się dobrej polityki” – powiedział.

„Ci ogólni agenci są dużym skokiem w stosunku do tego, co robi standardowe uczenie się przez wzmacnianie” – powiedział Anandkumar.

Jej zespół szkoli również agentów, aby szybciej się uczyli, osiągając znaczące postępy w najlepiej sprzedającej się grze wideo na świecie, Minecraft. Nazywana jest grą „sandbox”, co oznacza, że daje graczom praktycznie nieskończoną przestrzeń do interakcji i tworzenia nowych światów. Nie ma sensu programować funkcji nagrody dla tysięcy zadań indywidualnie, więc zamiast tego model zespołu („Moje Dojo”) zdobyło wiedzę na temat gry, oglądając filmy instruktażowe z napisami. Nie ma potrzeby kodyfikowania dobrego zachowania.

„Otrzymujemy zautomatyzowane funkcje nagradzania” – powiedział Anandkumar. „To pierwszy test porównawczy z tysiącami zadań i możliwością uczenia się przez wzmacnianie za pomocą otwartych zadań określonych za pomocą monitów tekstowych”.

Poza grami

Gry były świetnym sposobem na pokazanie, że modele przedtreningowe mogą działać, ale nadal są to uproszczone światy. Szkolenie robotów do radzenia sobie w prawdziwym świecie, w którym możliwości są praktycznie nieograniczone, jest znacznie trudniejsze. „Zadaliśmy pytanie: czy jest coś pomiędzy?” — powiedział Narasimhan. Postanowił więc zrobić zakupy przez Internet.

Jego zespół stworzył sklep internetowy. „To w zasadzie jak kamerdyner na zakupach” – powiedział Narasimhan. Użytkownicy mogą powiedzieć na przykład: „Daj mi but Nike, który jest biały i kosztuje mniej niż 100 dolarów, a chcę, aby w recenzjach wskazano, że są bardzo wygodne dla małych dzieci”, a program znajdzie i kupi dany but.

Podobnie jak w przypadku gier Zhonga i Anandkumara, WebShop rozwinął intuicję, trenując z obrazami i tekstem, tym razem ze stron Amazon. „Z biegiem czasu uczy się rozumieć język i odwzorowuje go na działania, które musi podjąć na stronie internetowej”.

Na pierwszy rzut oka kamerdyner w sklepie może nie wydawać się aż tak futurystyczny. Ale podczas gdy najnowocześniejszy chatbot może połączyć Cię z pożądanym sneakersem, interakcje, takie jak złożenie zamówienia, wymagają zupełnie innego zestawu umiejętności. I chociaż Twoje nocne głośniki Alexa lub Google Home mogą składać zamówienia, polegają one na zastrzeżonym oprogramowaniu, które wykonuje z góry ustalone zadania. WebShop porusza się po sieci tak, jak ludzie: czytając, pisząc i klikając.

„To krok bliżej do ogólnej inteligencji” — powiedział Narasimhan.

Wprowadzenie

Oczywiście nakłonienie robotów do interakcji z prawdziwym światem ma swoje własne wyzwania. Weźmy na przykład butelkę. Możesz go rozpoznać po wyglądzie, wiesz, że służy do przechowywania płynów i wiesz, jak manipulować nim rękami. Czy prawdziwe maszyny kiedykolwiek przekształcą słowa i obrazy w złożoną inteligencję ruchu?

Narasimhan współpracował z Anirudha Majumdar, robotyka z Princeton, aby się tego dowiedzieć. Nauczyli robotyczne ramię manipulować narzędziami, których nigdy wcześniej nie widziało, i wstępnie przeszkolili je, używając opisowego języka zaczerpniętego z udanych modeli językowych. Program uczył się szybciej i działał lepiej z prawie każdym narzędziem i czynnością, w porównaniu z programami uczącymi się poprzez tradycyjną eksplorację wyniki opublikowany na serwerze preprint arxiv.org w czerwcu ubiegłego roku.

Inżynierowie zbudowali bibliotekę jeszcze bardziej złożonych poleceń w laboratoriach robotyki Google, również zakorzenioną w szkoleniu wstępnym dotyczącym budowania kontekstu. „Świat możliwości, które trzeba wziąć pod uwagę, jest ogromny” — powiedział Karola Hausmana, naukowiec w zespole robotyki Google. „Dlatego prosimy model językowy, aby go dla nas rozbił”.

Zespół pracował z mobilnym robotem pomocniczym, wyposażonym w siedmioprzegubowe ramię, którego trenowali za pomocą umiejętności językowych. Dla dowolnego polecenia — na przykład „pomóż mi wyczyścić rozlany napój” — program używa modelu językowego, aby zasugerować działania z biblioteki 700 wyuczonych ruchów, takich jak „chwyć” papierowy ręcznik, „podnieś” puszkę lub „ wyrzucić” puszkę. A Hausman mówi, że uznaje swoje ograniczenia za pomocą zwrotów takich jak „Właściwie nie jestem w stanie go wymazać. Ale mogę ci przynieść gąbkę. Zespół niedawno poinformował o wynikach tego projektu, tzw PowiedzCan.

Kolejną zaletą wyposażenia robotów w modele językowe jest to, że tłumaczenie synonimów i słów w innych językach staje się trywialne. Jedna osoba może powiedzieć „obróć”, a druga „obróć”, a robot rozumie oba. „Najbardziej szaloną rzeczą, jakiej próbowaliśmy, jest to, że rozumie również emotikony” – powiedział Fei Xia, naukowiec w Google.

Boty się uczą

SayCan to prawdopodobnie najbardziej zaawansowana jak dotąd demonstracja uczenia się opartego na języku w robotyce. A modele językowe i obrazowe są stale ulepszane, tworząc lepsze i bardziej złożone techniki przedtreningowe.

Ale Xia jest ostrożna, aby złagodzić podekscytowanie. „Ktoś półżartem powiedział, że osiągnęliśmy moment „GPT robota”” — powiedział, odnosząc się do przełomowych modeli językowych, które rozumieją szeroki wachlarz ludzkich poleceń. „Jeszcze tam nie jesteśmy i jest o wiele więcej do odkrycia”.

Na przykład modele te mogą dostarczać nieprawidłowych odpowiedzi lub podejmować błędne działania, które badacze próbują zrozumieć. Roboty też jeszcze nie opanowały”wcielenie”: Podczas gdy ludzie mają fizyczną intuicję zbudowaną w dzieciństwie spędzonym na zabawie zabawkami, roboty nadal wymagają interakcji w świecie rzeczywistym, aby rozwinąć ten rodzaj intuicji. „W przypadku niektórych ustawień istnieje wiele nieoznaczonych demonstracji” — powiedział Zhong — pomyśl o bazach danych interakcji w grach wideo, takich jak Minecraft i NetHack. Żadna baza danych nie jest w stanie szybko nauczyć robotów inteligentnego ruchu.

Mimo to postęp postępuje szybko. Coraz więcej badaczy uważa, że efektem końcowym będzie inteligentniejsza robotyka. Narasimhan śledzi ewolucję człowieka-robota od kart perforowanych do następnej technologii. „Mieliśmy klawiatury i myszy, a potem ekrany dotykowe” – powiedział. Ugruntowany język jest następny. Będziesz rozmawiał ze swoim komputerem w celu uzyskania odpowiedzi i załatwienia spraw. „Całe to marzenie o asystentach, którzy są naprawdę zdolni, jeszcze się nie spełniło” – powiedział. – Ale myślę, że to nastąpi bardzo szybko.

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- Platoblockchain. Web3 Inteligencja Metaverse. Wzmocniona wiedza. Dostęp tutaj.

- Źródło: https://www.quantamagazine.org/machines-learn-better-if-we-teach-them-the-basics-20230201/

- 3d

- a

- zdolność

- O nas

- ABSTRACT

- Akceptuj

- dostęp

- Stosownie

- osiągnięcia

- w poprzek

- Działania

- działania

- faktycznie

- przystosować

- zaawansowany

- Agent

- agentów

- AI

- Alexa

- Algorytmy

- Wszystkie kategorie

- już

- Amazonka

- i

- Inne

- odpowiedzi

- podejście

- awanse

- ARM

- uzbrojony

- na około

- Szyk

- Współpracownik

- Próby

- zautomatyzowane

- Gruntownie

- Podstawy

- bo

- stają się

- staje się

- zanim

- za

- jest

- uwierzyć

- Benchmark

- najlepiej sprzedający się

- Ulepsz Swój

- pomiędzy

- Duży

- deska

- ciało

- Książki

- wysięgnik

- boty

- Granice

- przerwa

- przełom

- Brian

- przynieść

- budować

- wybudowany

- Kupuje

- California

- nazywa

- Połączenia

- Może uzyskać

- zdolny

- Kartki okolicznosciowe

- ostrożny

- zakwestionowany

- wyzwania

- zmiana

- chatbot

- Szachy

- Dodaj

- klasyczny

- Sprzątanie

- jasny

- bliższy

- współpracował

- koledzy

- połączenie

- jak

- wygodny

- w porównaniu

- porównanie

- rywalizować

- kompletny

- kompleks

- skomplikowane

- komputer

- Computer Science

- Wizja komputerowa

- Koncepcje

- Rozważać

- stale

- kontrola

- mógłby

- Kurs

- Stwórz

- stworzony

- Tworzenie

- krytyczny

- Aktualny

- Ciąć

- pionierski nowatorski

- dane

- Baza danych

- Bazy danych

- Data

- zadebiutował

- postanowiła

- Odszyfrować

- Wnętrze

- życzenia

- Mimo

- rozwijać

- rozwinięty

- ZROBIŁ

- różne

- cyfrowy

- Wymiary

- Wymiary

- Nie

- robi

- nie

- na dół

- marzenie

- podczas

- każdy

- z łatwością

- jeść

- krawędź

- zaokrętować

- uprawniającej

- Nieskończony

- dość

- Środowisko

- środowiska

- błąd

- Błędy

- istotnie

- Parzyste

- ostatecznie

- EVER

- Każdy

- ewolucja

- dokładnie

- przykład

- Podniecenie

- wykonać

- doświadczenie

- ekspert

- eksploracja

- odkryj

- zbadane

- wykładniczo

- FAIL

- nie

- znajomy

- FAST

- szybciej

- faworyzować

- informacja zwrotna

- walka

- Znajdź

- znalezieniu

- znajduje

- i terminów, a

- Nasz formularz

- formułowanie

- Fundacja

- od

- funkcjonować

- Funkcje

- fundamentalny

- futurystyczny

- Zyski

- gra

- Games

- Ogólne

- ogólna inteligencja

- Generować

- generacja

- otrzymać

- miejsce

- GitHub

- Dać

- dany

- daje

- Spojrzenie

- cel

- dobry

- Google'a

- absolwent

- wspaniały

- Krata

- Ziemia

- przełomowy

- Rośnie

- Przewodniki

- Pół

- uchwyt

- siła robocza

- zdarzyć

- się

- mający

- Wysoki

- przytrzymanie

- Strona główna

- W jaki sposób

- How To

- HTTPS

- olbrzymi

- człowiek

- Ludzie

- pomysł

- obraz

- zdjęcia

- ważny

- poprawy

- in

- W innych

- coraz bardziej

- Indywidualnie

- niewydajny

- Nieskończony

- Informacja

- przykład

- zamiast

- Instytut

- Inteligencja

- Inteligentny

- interakcji

- Interakcje

- Internet

- IT

- szt

- Praca

- Wiedzieć

- wiedza

- znany

- Labs

- Brak

- język

- Języki

- większe

- Nazwisko

- UCZYĆ SIĘ

- dowiedziałem

- nauka

- poziom

- Biblioteka

- ograniczenie

- Ograniczenia

- Ograniczony

- LINK

- dłużej

- Popatrz

- wygląda jak

- Partia

- maszyna

- uczenie maszynowe

- maszyny

- zrobiony

- robić

- podręcznik

- wiele

- mapa

- mistrz

- znaczenie

- znaczy

- metoda

- może

- milion

- Minecraft

- Aplikacje mobilne

- model

- modele

- moment

- jeszcze

- większość

- ruch

- porusza się

- Nawigacja

- Potrzebować

- Nowości

- Następny

- NIKE

- Nvidia

- obiekty

- Przeszkody

- ONE

- Online

- zakupy online

- koncepcja

- zamówienie

- Zlecenia

- Inne

- Pozostałe

- Inaczej

- Przewyższają

- własny

- Papier

- część

- Ludzie

- jest gwarancją najlepszej jakości, które mogą dostarczyć Ci Twoje monitory,

- może

- osoba

- Zwroty

- fizyczny

- Miejsce

- Miejsca

- wprowadzanie

- plato

- Analiza danych Platona

- PlatoDane

- Grać

- gracz

- gracze

- gra

- Proszę

- polityka

- pozytywny

- możliwości

- możliwy

- napisali

- Praktyczny

- praktycznie

- bardzo

- Problem

- problemy

- przetwarzanie

- Program

- Programy

- Postęp

- projekt

- własność

- zapewniać

- zapewnia

- Magazyn ilościowy

- pytanie

- szybko

- królik

- osiągnięty

- Czytający

- real

- Prawdziwy świat

- niedawno

- rozpoznać

- regularny

- Zgłoszone

- wymagać

- wymagany

- Wymaga

- Badania naukowe

- Badacze

- dalsze

- Efekt

- Recenzje

- Nagradzać

- Nagrody

- robot

- robotyka

- roboty

- reguły

- bieganie

- Powiedział

- taki sam

- Skala

- nauka

- Naukowiec

- Naukowcy

- Ekrany

- druga

- wydaje

- Sekwencja

- zestaw

- ustawienie

- w panelu ustawień

- Zakupy

- pokazać

- Targi

- znak

- znaczący

- podobny

- Prosty

- uproszczony

- po prostu

- sytuacja

- umiejętność

- umiejętności

- zwalnia

- mądrzejszy

- Sneakersy

- So

- Tworzenie

- ROZWIĄZANIA

- kilka

- coś

- wyrafinowany

- Typ przestrzeni

- mówić

- Głośniki

- określony

- prędkość

- spędził

- standard

- początek

- Stan

- pobyt

- Ewolucja krok po kroku

- Nadal

- sklep

- Zmagania

- student

- potyka się

- kolejny

- osiągnąć sukces

- udany

- taki

- doładowania

- systemy

- Brać

- trwa

- Zadanie

- zadania

- zespół

- Techniki

- Technologia

- test

- Połączenia

- Podstawy

- świat

- ich

- rzecz

- rzeczy

- tysiące

- trzy

- Przez

- czas

- czasy

- do

- już dziś

- także

- narzędzie

- narzędzia

- CAŁKOWICIE

- Kontakt

- w kierunku

- tradycyjny

- tradycyjnie

- Pociąg

- przeszkolony

- Trening

- próba

- Próby

- SKRĘCAĆ

- zazwyczaj

- dla

- zrozumieć

- zrozumienie

- rozumie

- niedoinformowany

- uniwersytet

- przesłanych

- us

- posługiwać się

- Użytkownicy

- różnorodny

- Naprawiono

- Wideo

- gra wideo

- Filmy

- prawie

- wizja

- Waszyngton

- oglądania

- sieć

- webp

- Strona internetowa

- Co

- który

- Podczas

- biały

- cały

- całkowicie

- szeroki

- będzie

- wycieranie

- w ciągu

- bez

- słowa

- Praca

- pracował

- świat

- świat

- by

- Źle

- rok

- You

- Twój

- zefirnet

- Zhong