Szybka inżynieria stała się niezbędną umiejętnością dla każdego, kto pracuje z dużymi modelami językowymi (LLM), aby generować wysokiej jakości i trafne teksty. Chociaż inżynieria podpowiedzi tekstowych była szeroko omawiana, inżynieria podpowiedzi wizualnych to nowa dziedzina wymagająca uwagi. Podpowiedzi wizualne mogą obejmować ramki ograniczające lub maski, które kierują modelami wizyjnymi w generowaniu odpowiednich i dokładnych wyników. W tym poście omawiamy podstawy szybkiej inżynierii wizualnej, jej zalety i sposób, w jaki można ją wykorzystać do rozwiązania konkretnego przypadku użycia: segmentacji obrazu na potrzeby jazdy autonomicznej.

W ostatnich latach w dziedzinie widzenia komputerowego nastąpił znaczny postęp w obszarze segmentacji obrazu. Jednym z takich przełomów jest Model dowolnego segmentu (SAM) przez Meta AI, która może zrewolucjonizować segmentację na poziomie obiektu dzięki szkoleniu polegającemu na zerowym lub kilku strzałach. W tym poście używamy modelu SAM jako przykładowego modelu wizji podstawowej i badamy jego zastosowanie do Zbiór danych BDD100K, zróżnicowany zbiór danych dotyczących jazdy autonomicznej do heterogenicznego uczenia się wielozadaniowego. Łącząc mocne strony SAM z bogatymi danymi dostarczonymi przez BDD100K, prezentujemy potencjał szybkiej inżynierii wizualnej w różnych wersjach SAM. Zainspirowany LangChain framework dla modeli językowych, proponujemy łańcuch wizualny do wykonywania podpowiedzi wizualnych poprzez połączenie modeli wykrywania obiektów z SAM.

Chociaż ten post koncentruje się na jeździe autonomicznej, omówione koncepcje mają szerokie zastosowanie w dziedzinach mających bogate zastosowania oparte na wizji, takich jak opieka zdrowotna i nauki przyrodnicze oraz media i rozrywka. Zacznijmy od dowiedzenia się nieco więcej o tym, co kryje się pod maską podstawowego modelu wizji, takiego jak SAM. Użyliśmy Studio Amazon SageMaker w instancji ml.g5.16xlarge dla tego posta.

Model dowolnego segmentu (SAM)

Modele podstawowe to duże modele uczenia maszynowego (ML) szkolone na ogromnej ilości danych i można je wyświetlać lub dostosowywać do przypadków użycia specyficznych dla zadania. W tym miejscu badamy model dowolnego segmentu (SAM), który jest podstawowym modelem widzenia, w szczególności segmentacji obrazu. Jest wstępnie szkolony na ogromnym zbiorze danych składającym się z 11 milionów obrazów i 1.1 miliarda masek, co czyni go największym zbiorem danych segmentacji w chwili pisania tego tekstu. Ten obszerny zbiór danych obejmuje szeroką gamę obiektów i kategorii, zapewniając SAM zróżnicowane źródło danych szkoleniowych na dużą skalę.

Model SAM jest szkolony w zakresie rozumienia obiektów i może generować maski segmentacji dla dowolnego obiektu na obrazach lub klatkach wideo. Model umożliwia szybką inżynierię wizualną, umożliwiając wprowadzenie danych wejściowych, takich jak tekst, punkty, ramki ograniczające lub maski w celu wygenerowania etykiet bez zmiany oryginalnego obrazu. SAM jest dostępny w trzech rozmiarach: podstawowym (ViT-B, 91 milionów parametrów), dużym (ViT-L, 308 milionów parametrów) i ogromnym (ViT-H, 636 milionów parametrów), dostosowanym do różnych wymagań obliczeniowych i przypadków użycia.

Główną motywacją stojącą za SAM jest ulepszenie segmentacji na poziomie obiektu przy minimalnych próbkach szkoleniowych i epokach dla dowolnych obiektów zainteresowania. Siła SAM polega na jego zdolności do dostosowywania się do nowych rozkładów obrazu i zadań bez wcześniejszej wiedzy, jest to funkcja znana jako transfer zero-shot. Tę zdolność adaptacji osiąga się dzięki szkoleniu na rozległym zbiorze danych SA-1B, który wykazał imponującą wydajność od zera, przewyższającą wiele wcześniejszych, w pełni nadzorowanych wyników.

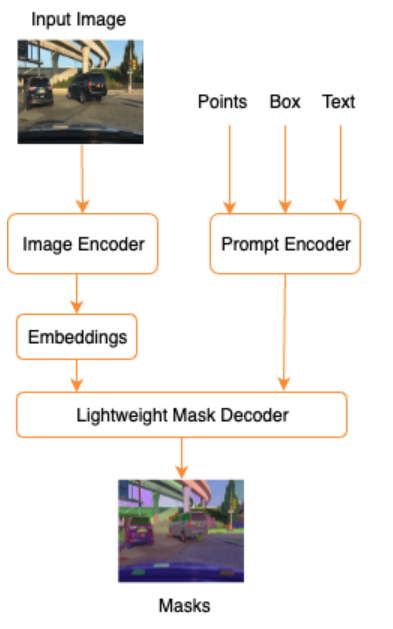

Jak pokazano na poniższej architekturze SAM, proces generowania masek segmentacji składa się z trzech etapów:

- Koder obrazu umożliwia jednorazowe osadzenie obrazu.

- Koder podpowiedzi konwertuje dowolny znak zachęty na wektor osadzania podpowiedzi.

- Lekki dekoder łączy informacje z kodera obrazu i kodera podpowiedzi w celu przewidywania masek segmentacji.

Jako przykład możemy podać dane wejściowe z obrazem i ramką ograniczającą wokół obiektu będącego przedmiotem zainteresowania na tym obrazie (np. srebrny samochód lub pas ruchu), a model SAM utworzy maski segmentacji dla tego obiektu.

Wizualna szybka inżynieria

Szybka inżynieria odnosi się do strukturyzacji danych wejściowych modelu, która sprawia, że model rozumie intencje i daje pożądany wynik. Dzięki inżynierii tekstu tekstowego możesz strukturyzować tekst wejściowy poprzez modyfikacje, takie jak dobór słów, formatowanie, kolejność i inne, aby uzyskać pożądany wynik. Inżynieria podpowiedzi wizualnych zakłada, że użytkownik pracuje w trybie wizualnym (obraz lub wideo) i zapewnia dane wejściowe. Poniżej znajduje się niewyczerpująca lista potencjalnych sposobów dostarczania danych wejściowych do generatywnego modelu sztucznej inteligencji w domenie wizualnej:

- Punkt – pojedynczy punkt współrzędnych (x, y) na płaszczyźnie obrazu

- Punkty – wiele punktów współrzędnych (x, y), niekoniecznie powiązanych ze sobą

- Obwiednia — zestaw czterech wartości (x, y, w, h), które definiują prostokątny obszar na płaszczyźnie obrazu

- Kontur – zbiór punktów współrzędnych (x, y) na płaszczyźnie obrazu, które tworzą zamknięty kształt

- Maska – tablica o tym samym rozmiarze co obraz z częściową maską interesującego obiektu

Mając na uwadze techniki inżynierii wizualnej, przyjrzyjmy się, jak można je zastosować do wstępnie wytrenowanego modelu SAM. Korzystaliśmy z podstawowej wersji wytrenowanego modelu.

Podpowiadanie o zerowym strzale za pomocą wstępnie wyszkolonego modelu SAM

Na początek przyjrzyjmy się podejściu zero-shot. Poniżej znajduje się przykładowy obraz ze zbioru danych treningowych pobrany z przedniej kamery pojazdu.

Możemy uzyskać maski segmentacji dla wszystkich obiektów z obrazu bez wyraźnego podpowiedzi wizualnej automatyczne generowanie masek tylko z obrazem wejściowym. Na poniższym obrazku widzimy, że części samochodu, drogi, znaków drogowych, tablic rejestracyjnych, wiaduktu, słupów, znaków i innych elementów są podzielone na segmenty.

Jednak dane wyjściowe nie są od razu przydatne z następujących powodów:

- Samochody nie są podzielone na segmenty w całości, ale na części. Na przykład w przypadku większości modeli percepcji tak naprawdę nie przejmujemy się tym, że każda z opon ma osobne maski wyjściowe. Dotyczy to również wyszukiwania innych znanych obiektów zainteresowania, takich jak droga, roślinność, znaki i tak dalej.

- Części obrazu przydatne do dalszych zadań, np. obszaru, po którym można jeździć, są dzielone bez wyjaśnienia. Z drugiej strony podobne instancje są identyfikowane osobno i możemy być zainteresowani grupowaniem podobnych obiektów (segmentacja panoptyczna vs. instancyjna).

Wizualna szybka inżynieria przy użyciu wstępnie przeszkolonego modelu SAM

Na szczęście SAM obsługuje wyświetlanie monitów o wprowadzenie danych i możemy używać punktów, tablic punktów i obwiedni jako danych wejściowych. Oczekujemy, że dzięki tym konkretnym instrukcjom SAM będzie lepiej radził sobie z segmentacją skupiającą się na określonych punktach lub obszarach. Można to porównać z szablonem podpowiedzi językowej"What is a good name for a company that makes {product}?"

gdzie dane wejściowe wraz z tym szablonem podpowiedzi od użytkownika to {product}. {product} jest gniazdem wejściowym. W podpowiedziach wizualnych ramki ograniczające, punkty lub maski stanowią szczeliny wejściowe.

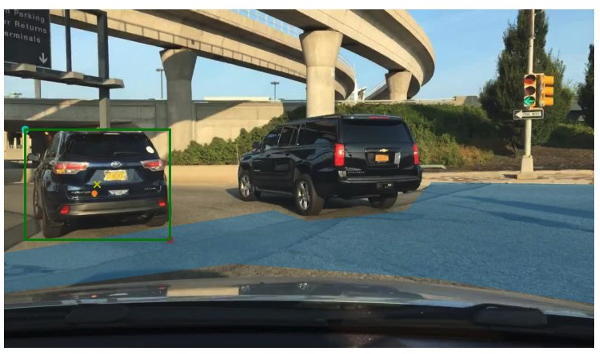

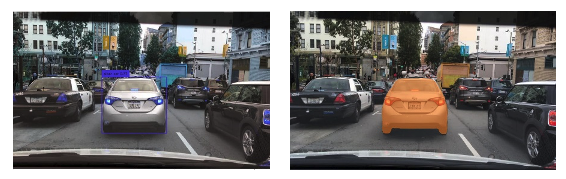

Poniższy obraz przedstawia oryginalną ramkę ograniczającą prawdę o naziemnej powierzchni wokół pojazdów oraz fragment obszaru, po którym można jeździć, na podstawie danych o naziemnej podstawie BDD100K. Obraz pokazuje również punkt wejściowy (żółty X) w środku zielonej ramki ograniczającej, do którego będziemy się odnosić w kilku następnych sekcjach.

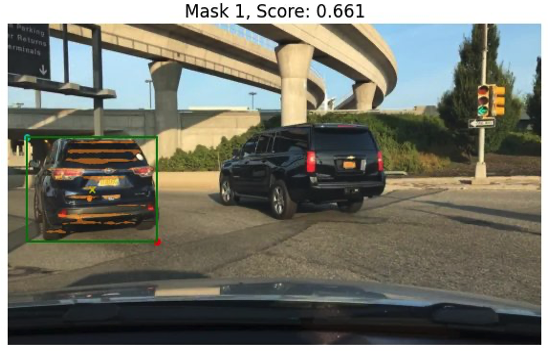

Spróbujmy wygenerować maskę dla samochodu po lewej stronie z zieloną ramką jako dane wejściowe do SAM. Jak pokazano w poniższym przykładzie, podstawowy model SAM tak naprawdę nic nie znajduje. Widać to również po niskim wyniku segmentacji. Kiedy przyjrzymy się bliżej maskom segmentacji, zobaczymy, że istnieją małe obszary zwrócone jako maski (oznaczone czerwonymi strzałkami), które tak naprawdę nie nadają się do dalszych zastosowań.

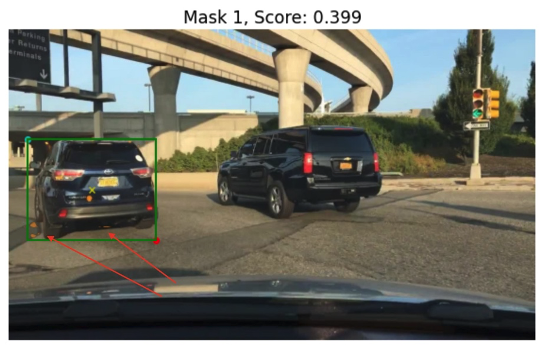

Wypróbujmy kombinację ramki ograniczającej i punktu jako wizualnego monitu wejściowego. Żółty krzyżyk na poprzednim obrazie jest środkiem obwiedni. Podanie współrzędnych (x, y) tego punktu jako zachęty wraz z ograniczeniem ramki ograniczającej daje nam następującą maskę i nieco wyższy wynik. Nadal nie można tego w żaden sposób wykorzystać.

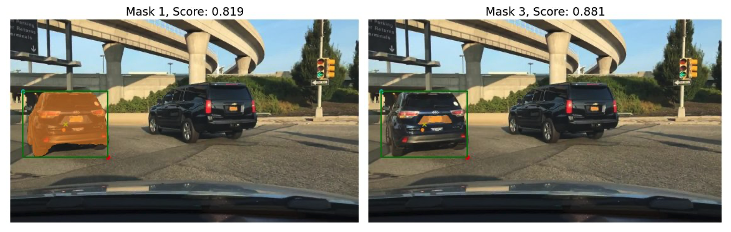

Wreszcie, w przypadku podstawowego, wstępnie wytrenowanego modelu, możemy podać tylko punkt wejściowy jako monit (bez ramki ograniczającej). Poniższe zdjęcia przedstawiają dwie z trzech masek, które naszym zdaniem były interesujące.

Maska 1 segmentuje cały samochód, podczas gdy Maska 3 segmentuje obszar, w którym tablica rejestracyjna samochodu znajduje się blisko żółtego krzyżyka (monit o wprowadzenie). Maska 1 nadal nie jest szczelną, czystą maską wokół samochodu; wskazuje to na jakość modelu, która, jak możemy założyć, wzrasta wraz z rozmiarem modelu.

Możemy wypróbować większe, wstępnie wytrenowane modele z tym samym monitem o wprowadzenie danych. Poniższe zdjęcia przedstawiają nasze wyniki. W przypadku korzystania z ogromnego, wstępnie przeszkolonego modelu SAM, Maska 3 to cały samochód, natomiast Maski 1 i 2 można wykorzystać do wyciągnięcia tablicy rejestracyjnej.

Duża wersja modelu SAM zapewnia również podobne wyniki.

Proces, przez który przeszliśmy, jest podobny do ręcznego projektowania podpowiedzi tekstowych, które być może już znasz. Należy zauważyć, że niedawne ulepszenie modelu SAM polegające na segmentowaniu czegokolwiek w wysokiej jakości zapewnia znacznie lepsze wyniki specyficzne dla obiektu i kontekstu. W naszym przypadku okazuje się, że podpowiedzi zero-shot za pomocą tekstu i podpowiedzi wizualnych (wprowadzanie punktów, ramek oraz punktów i ramek) nie poprawiają drastycznie wyników, jak widzieliśmy powyżej.

Szablony podpowiedzi i łańcuchy wizualne

Jak widać z powyższych przykładów zerowego strzału, SAM ma trudności z zidentyfikowaniem wszystkich obiektów w scenie. To dobry przykład tego, gdzie możemy skorzystać z szablonów podpowiedzi i łańcuchów wizualnych. Łańcuch wizualny jest inspirowany koncepcją łańcucha w popularnym frameworku LangChain dla aplikacji językowych. Pomaga połączyć źródła danych i LLM w celu uzyskania wyników. Na przykład możemy użyć łańcucha API, aby wywołać API i wywołać LLM, aby odpowiedzieć na pytanie w oparciu o odpowiedź API.

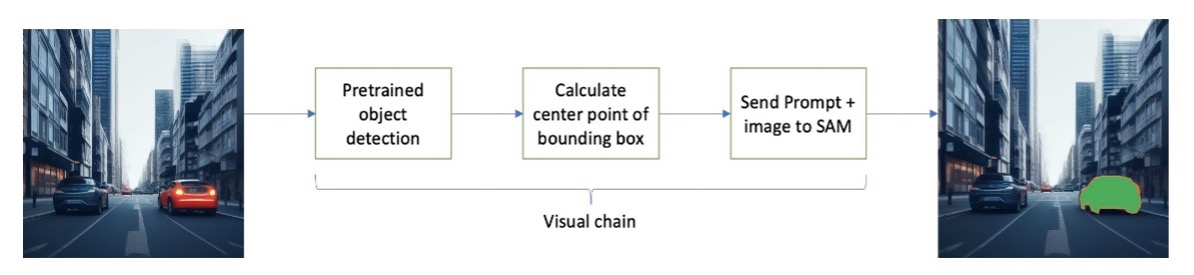

Zainspirowani LangChain, proponujemy sekwencyjny łańcuch wizualny, który wygląda jak na poniższym rysunku. Używamy narzędzia (takiego jak wstępnie wytrenowany model wykrywania obiektów), aby uzyskać początkowe ramki ograniczające, obliczyć punkt w środku ramki ograniczającej i użyć go do wyświetlenia obrazu wejściowego w modelu SAM.

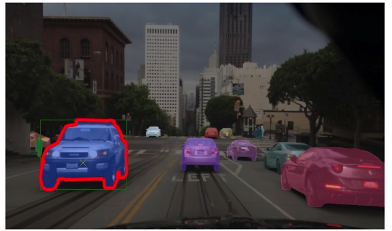

Na przykład poniższy obrazek przedstawia maski segmentacji powstałe w wyniku uruchomienia tego łańcucha.

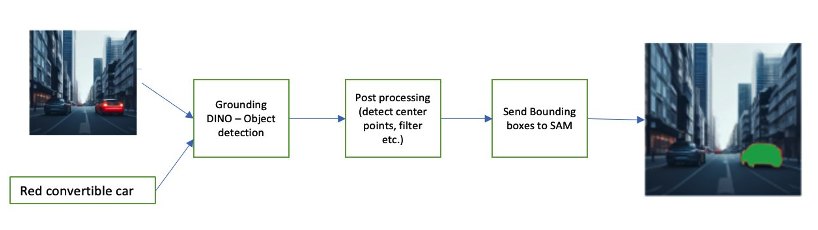

Inny przykładowy łańcuch może obejmować wprowadzenie tekstu obiektu, który użytkownik chce zidentyfikować. Aby to zaimplementować, zbudowaliśmy potok za pomocą Uziemienie DINO, model wykrywania obiektów monitujący SAM o segmentację.

Grounding DINO to model wykrywania obiektów typu zero-shot, który umożliwia wykrywanie obiektów za pomocą tekstu zawierającego nazwy kategorii (takie jak „sygnalizacja świetlna” lub „ciężarówka”) i wyrażenia (takie jak „żółta ciężarówka”). Akceptuje pary tekstu i obrazu w celu wykrycia obiektu. Opiera się na architekturze transformatorowej i umożliwia korzystanie z różnych modalności z danymi tekstowymi i obrazowymi. Aby dowiedzieć się więcej na temat uziemienia DINO, zob Uziemienie DINO: Połączenie DINO z uziemionym szkoleniem wstępnym w zakresie wykrywania obiektów otwartych. Generuje to ramki ograniczające i etykiety, które można dalej przetwarzać w celu wygenerowania punktów środkowych, filtrowania na podstawie etykiet, progów i nie tylko. Jest to używane (pola lub punkty) jako zachęta dla SAM w celu segmentacji, która generuje maski.

Poniżej znajduje się kilka przykładów pokazujących tekst wejściowy, wynik DINO (obramowania) i końcowy wynik SAM (maski segmentacji).

Poniższe obrazy przedstawiają wynik działania „żółtej ciężarówki”.

Poniższe obrazy przedstawiają wynik działania „srebrnego samochodu”.

Poniższy obraz przedstawia dane wyjściowe dla „pasa drogowego”.

Możemy użyć tego potoku do zbudowania łańcucha wizualnego. Poniższy fragment kodu wyjaśnia tę koncepcję:

pipeline = [object_predictor, segment_predictor]

image_chain = ImageChain.from_visual_pipeline(pipeline, image_store, verbose=True)

image_chain.run('All silver cars', image_id='5X3349')Chociaż jest to prosty przykład, koncepcję tę można rozszerzyć na przetwarzanie sygnałów z kamer umieszczonych w pojazdach w celu śledzenia obiektów, redagowania danych osobowych (PII) i nie tylko. Ramki ograniczające możemy również uzyskać z mniejszych modeli lub w niektórych przypadkach przy użyciu standardowych narzędzi widzenia komputerowego. Użycie wstępnie wytrenowanego modelu lub usługi takiej jak Amazon Rekognition w celu uzyskania początkowych (wizualnych) etykiet dla podpowiedzi jest dość proste. W chwili pisania tego tekstu w serwisie Amazon SageMaker Jumpstart dostępnych jest ponad 70 modeli umożliwiających wykrywanie obiektów i Amazon Rekognition już identyfikuje kilka przydatnych kategorii obiektów na obrazach, w tym samochody, pieszych i inne pojazdy.

Następnie przyglądamy się niektórym wynikom ilościowym związanym z wydajnością modeli SAM z podzbiorem danych BDD100K.

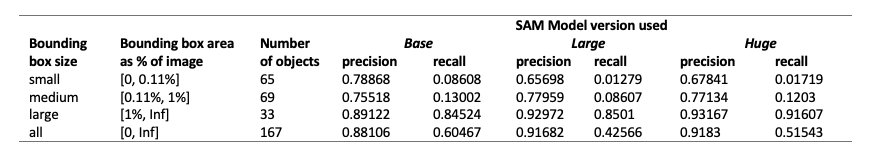

Wyniki ilościowe

Naszym celem jest porównanie wydajności trzech wstępnie wytrenowanych modeli przy użyciu tych samych podpowiedzi wizualnych. W tym przypadku jako danych wejściowych wykorzystujemy środkowy punkt lokalizacji obiektu. Porównujemy wydajność pod względem rozmiarów obiektów (proporcjonalnie do rozmiaru obrazu) — małych (powierzchnia 0.11%). Progi obszaru obwiedni są definiowane przez Common Objects in Context (COCO) metryki oceny [Lin i in., 2014].

Ocena odbywa się na poziomie pikseli i stosujemy następujące metryki oceny:

- Precyzja = (liczba odpowiednich i pobranych instancji) / (całkowita liczba pobranych instancji)

- Przywołanie = (liczba odpowiednich i odzyskanych instancji) / (całkowita liczba odpowiednich instancji)

- Przykładami są tu każdy piksel w ramce ograniczającej obiekt zainteresowania

Poniższa tabela przedstawia wydajność trzech różnych wersji modelu SAM (podstawowej, dużej i ogromnej). Wersje te posiadają trzy różne enkodery: ViT-B (podstawowy), ViT-L (duży), ViT-H (ogromny). Kodery mają różną liczbę parametrów, gdzie model podstawowy ma mniej parametrów niż duże, a duży jest mniejszy niż ogromny. Chociaż zwiększenie liczby parametrów powoduje poprawę wydajności w przypadku większych obiektów, nie jest tak w przypadku mniejszych obiektów.

Dostosuj SAM do swojego przypadku użycia

W wielu przypadkach bezpośrednie użycie wstępnie wytrenowanego modelu SAM może nie być zbyt przydatne. Na przykład spójrzmy na typową scenę w ruchu ulicznym — poniższy obraz przedstawia wynik modelu SAM z losowo próbkowanymi punktami podpowiedzi jako danymi wejściowymi po lewej stronie i rzeczywistymi etykietami z zadania segmentacji semantycznej z BDD100K po prawej stronie. Te są oczywiście bardzo różne.

Stosy percepcji w AV mogą z łatwością korzystać z drugiego obrazu, ale nie z pierwszego. Z drugiej strony istnieje kilka przydatnych wyników z pierwszego obrazu, które można wykorzystać, a model nie został jawnie przeszkolony na przykład pod kątem oznaczeń pasów ruchu, segmentacji chodników, masek tablic rejestracyjnych i tak dalej. Możemy dostroić model SAM, aby poprawić wyniki segmentacji. Aby przeprowadzić to dostrajanie, utworzyliśmy zbiór danych szkoleniowych, korzystając z podzbioru segmentacji instancji (500 obrazów) ze zbioru danych BDD10K. To bardzo mały podzbiór obrazów, ale naszym celem jest udowodnienie, że podstawowe modele wizji (podobnie jak LLM) mogą dobrze działać w Twoim przypadku przy użyciu zaskakująco małej liczby obrazów. Poniższy obraz przedstawia obraz wejściowy, maskę wyjściową (w kolorze niebieskim z czerwoną ramką samochodu po lewej stronie) i możliwe monity (obramowanie na zielono i punkt środkowy X na żółto).

Dostosowaliśmy przy użyciu włączonej biblioteki Hugging Face Studio Amazon SageMaker. Użyliśmy instancji ml.g4dn.xlarge do testów modelu podstawowego SAM i instancji ml.g4dn.2xlarge do testów ogromnego modelu SAM. W naszych początkowych eksperymentach zaobserwowaliśmy, że dostrajanie modelu podstawowego za pomocą samych ramek ograniczających nie zakończyło się sukcesem. Dostrojone i wstępnie wyszkolone modele nie były w stanie nauczyć się masek prawdy specyficznych dla samochodu z oryginalnych zbiorów danych. Dodanie punktów zapytania do dostrajania również nie poprawiło szkolenia.

Następnie możemy spróbować dostroić ogromny model SAM dla 30 epok, z bardzo małym zbiorem danych (500 obrazów). Oryginalna maska prawdy podstawowej wygląda jak na poniższym obrazku dla samochodu z etykietą.

Jak pokazano na poniższych ilustracjach, oryginalna, wstępnie wyszkolona wersja ogromnego modelu z konkretnym monitem o obwiednię (na zielono) nie daje żadnych danych wyjściowych, podczas gdy wersja dostrojona daje dane wyjściowe (wciąż nie jest dokładna, ale dostrajanie zostało usunięte wyłączone po 40 epokach i przy bardzo małym zbiorze danych szkoleniowych składającym się z 500 obrazów). Oryginalny, wstępnie wytrenowany, ogromny model nie był w stanie przewidzieć masek dla żadnego z testowanych przez nas obrazów. Jako przykład zastosowania na dalszym etapie, dokładnie dostrojony model można wykorzystać w przepływach pracy związanych z wstępnym etykietowaniem, takich jak ten opisany w Moduł automatycznego etykietowania dla zaawansowanych systemów wspomagania kierowcy opartych na głębokim uczeniu się w AWS.

Wnioski

W tym poście omówiliśmy podstawowy model wizji znany jako Segment Everything Model (SAM) i jego architekturę. Wykorzystaliśmy model SAM do omówienia podpowiedzi wizualnych i różnych danych wejściowych do inżynierii podpowiedzi wizualnych. Zbadaliśmy działanie różnych podpowiedzi wizualnych i ich ograniczenia. Opisaliśmy również, jak łańcuchy wizualne zwiększają wydajność w porównaniu z użyciem tylko jednego podpowiedzi, podobnie jak w przypadku interfejsu API LangChain. Następnie zapewniliśmy ilościową ocenę trzech wstępnie wyszkolonych modeli. Na koniec omówiliśmy dopracowany model SAM i jego wyniki w porównaniu z oryginalnym modelem podstawowym. Dostrajanie modeli podstawowych pomaga poprawić wydajność modelu w przypadku określonych zadań, takich jak segmentacja. Należy zauważyć, że model SAM ze względu na wymagania dotyczące zasobów ogranicza jego wykorzystanie do przypadków użycia w czasie rzeczywistym i wnioskowania na krawędzi w jego obecnym stanie. Mamy nadzieję, że przyszłe iteracje i ulepszone techniki zmniejszą wymagania obliczeniowe i poprawią opóźnienia.

Mamy nadzieję, że ten post zachęci Cię do zapoznania się z podpowiedziami wizualnymi w swoich przypadkach użycia. Ponieważ jest to wciąż wyłaniająca się forma szybkiej inżynierii, jest wiele do odkrycia w zakresie podpowiedzi wizualnych, łańcuchów wizualnych i wydajności tych narzędzi. Amazon Sage Maker to w pełni zarządzana platforma uczenia maszynowego, która umożliwia konstruktorom eksplorowanie dużych modeli językowych i wizualnych oraz tworzenie generatywnych aplikacji AI. Zacznij budować przyszłość z AWS już dziś.

O autorach

Gopi Krishnamurthy jest starszym architektem rozwiązań AI/ML w Amazon Web Services z siedzibą w Nowym Jorku. Współpracuje z dużymi klientami z branży motoryzacyjnej jako ich zaufany doradca przy przekształcaniu ich obciążeń uczenia maszynowego i migracji do chmury. Jego główne zainteresowania to deep learning i technologie serverless. Poza pracą lubi spędzać czas z rodziną i zgłębiać różne gatunki muzyczne.

Gopi Krishnamurthy jest starszym architektem rozwiązań AI/ML w Amazon Web Services z siedzibą w Nowym Jorku. Współpracuje z dużymi klientami z branży motoryzacyjnej jako ich zaufany doradca przy przekształcaniu ich obciążeń uczenia maszynowego i migracji do chmury. Jego główne zainteresowania to deep learning i technologie serverless. Poza pracą lubi spędzać czas z rodziną i zgłębiać różne gatunki muzyczne.

Shreyas Subramanian jest głównym architektem rozwiązań specjalizującym się w sztucznej inteligencji/uczeniu maszynowym i pomaga klientom, korzystając z uczenia maszynowego, rozwiązywać ich problemy biznesowe za pomocą platformy AWS. Shreyas ma doświadczenie w optymalizacji na dużą skalę i uczeniu maszynowym oraz wykorzystywaniu uczenia maszynowego i uczenia się przez wzmacnianie do przyspieszania zadań optymalizacyjnych.

Shreyas Subramanian jest głównym architektem rozwiązań specjalizującym się w sztucznej inteligencji/uczeniu maszynowym i pomaga klientom, korzystając z uczenia maszynowego, rozwiązywać ich problemy biznesowe za pomocą platformy AWS. Shreyas ma doświadczenie w optymalizacji na dużą skalę i uczeniu maszynowym oraz wykorzystywaniu uczenia maszynowego i uczenia się przez wzmacnianie do przyspieszania zadań optymalizacyjnych.

Sujitha Martin jest naukowcem stosowanym w Centrum Innowacji Generative AI (GAIIC). Jej doświadczenie obejmuje budowanie rozwiązań uczenia maszynowego obejmujących wizję komputerową i przetwarzanie języka naturalnego dla różnych branż. W szczególności ma rozległe doświadczenie w pracy nad świadomością sytuacyjną skupioną na człowieku i uczeniem się opartym na wiedzy dla wysoce autonomicznych systemów.

Sujitha Martin jest naukowcem stosowanym w Centrum Innowacji Generative AI (GAIIC). Jej doświadczenie obejmuje budowanie rozwiązań uczenia maszynowego obejmujących wizję komputerową i przetwarzanie języka naturalnego dla różnych branż. W szczególności ma rozległe doświadczenie w pracy nad świadomością sytuacyjną skupioną na człowieku i uczeniem się opartym na wiedzy dla wysoce autonomicznych systemów.

Franciszka Calderona jest analitykiem danych w Centrum Innowacji Generative AI (GAIIC). Jako członek GAIIC pomaga odkrywać sztukę możliwości wśród klientów AWS korzystających z technologii generatywnej sztucznej inteligencji. W wolnym czasie Francisco lubi grać na gitarze i muzyce, grać w piłkę nożną z córkami i spędzać czas z rodziną.

Franciszka Calderona jest analitykiem danych w Centrum Innowacji Generative AI (GAIIC). Jako członek GAIIC pomaga odkrywać sztukę możliwości wśród klientów AWS korzystających z technologii generatywnej sztucznej inteligencji. W wolnym czasie Francisco lubi grać na gitarze i muzyce, grać w piłkę nożną z córkami i spędzać czas z rodziną.

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- PlatoData.Network Pionowe generatywne AI. Wzmocnij się. Dostęp tutaj.

- PlatoAiStream. Inteligencja Web3. Wiedza wzmocniona. Dostęp tutaj.

- PlatonESG. Węgiel Czysta technologia, Energia, Środowisko, Słoneczny, Gospodarowanie odpadami. Dostęp tutaj.

- Platon Zdrowie. Inteligencja w zakresie biotechnologii i badań klinicznych. Dostęp tutaj.

- Źródło: https://aws.amazon.com/blogs/machine-learning/foundational-vision-models-and-visual-prompt-engineering-for-autonomous-driving-applications/

- :ma

- :Jest

- :nie

- :Gdzie

- $W GÓRĘ

- 1

- 100

- 11

- 179

- 2014

- 214

- 225

- 30

- 40

- 500

- 7

- 70

- 804

- 91

- 97

- a

- zdolność

- Zdolny

- O nas

- powyżej

- przyspieszenie

- Akceptuje

- dokładny

- osiągnięty

- rzeczywisty

- przystosować

- dodanie

- zaawansowany

- postępy

- Korzyść

- doradca

- Po

- AI

- AI / ML

- AL

- Wszystkie kategorie

- pozwala

- wzdłuż

- już

- również

- Chociaż

- Amazonka

- Amazon Rekognition

- Amazon Sage Maker

- Amazon SageMaker JumpStart

- Amazon Web Services

- an

- i

- odpowiedź

- każdy

- ktoś

- wszystko

- api

- odpowiedni

- Zastosowanie

- aplikacje

- stosowany

- podejście

- architektura

- SĄ

- POWIERZCHNIA

- obszary

- na około

- Szyk

- Sztuka

- AS

- Wsparcie

- założyć

- zakłada

- At

- Uwaga

- motoryzacyjny

- autonomiczny

- dostępny

- świadomość

- AWS

- tło

- baza

- na podstawie

- Podstawy

- BE

- bo

- stają się

- być

- rozpocząć

- za

- Korzyści

- Ulepsz Swój

- Miliard

- Niebieski

- granica

- Pudełko

- Skrzynki

- przełom

- szeroko

- budować

- budowniczowie

- Budowanie

- wybudowany

- biznes

- ale

- by

- obliczać

- wezwanie

- aparat fotograficzny

- kamery

- CAN

- Może uzyskać

- wózek

- który

- samochody

- walizka

- Etui

- kategorie

- Kategoria

- catering

- Centrum

- łańcuch

- więzy

- wyzwania

- wybór

- Miasto

- kleń

- Zamknij

- zamknięte

- dokładnie

- Chmura

- coco

- kod

- połączenie

- kombajny

- łączenie

- wspólny

- sukcesy firma

- porównać

- w porównaniu

- obliczeniowy

- obliczać

- komputer

- Wizja komputerowa

- pojęcie

- Koncepcje

- kontekst

- koordynować

- rdzeń

- Okładki

- stworzony

- Krzyż

- Aktualny

- Stan aktulany

- Klientów

- Ciąć

- dane

- naukowiec danych

- zbiory danych

- głęboko

- głęboka nauka

- określić

- zdefiniowane

- wykazać

- opisane

- życzenia

- Wykrywanie

- różne

- dino

- bezpośrednio

- odkryj

- dyskutować

- omówione

- Dystrybucje

- inny

- do

- Nie

- domena

- domeny

- nie

- drastycznie

- kierowca

- jazdy

- z powodu

- e

- E i T

- każdy

- z łatwością

- krawędź

- osadzanie

- wschodzących

- Umożliwia

- umożliwiając

- zachęca

- Inżynieria

- rozrywka

- Cały

- epoki

- niezbędny

- ewaluację

- przykład

- przykłady

- ekspansywny

- oczekiwać

- doświadczenie

- eksperymenty

- ekspertyza

- Objaśnia

- wyjaśnienie

- wyraźnie

- odkryj

- zbadane

- wyrażeń

- rozległy

- Szerokie doświadczenie

- wyciąg

- Twarz

- dość

- znajomy

- członków Twojej rodziny

- Cecha

- kilka

- pole

- Postać

- filtrować

- finał

- Znajdź

- i terminów, a

- koncentruje

- skupienie

- następujący

- W razie zamówieenia projektu

- Nasz formularz

- Fundacja

- podstawowy

- cztery

- Framework

- Francisco

- od

- z przodu

- pełny

- w pełni

- dalej

- przyszłość

- Generować

- generuje

- generujący

- generatywny

- generatywna sztuczna inteligencja

- otrzymać

- dany

- daje

- dobry

- Zielony

- Ziemia

- poprowadzi

- ręka

- Have

- mający

- he

- opieki zdrowotnej

- pomaga

- jej

- tutaj

- Wysoki

- wysokiej jakości

- wyższy

- wysoko

- jego

- posiada

- kaptur

- nadzieję

- W jaki sposób

- HTML

- HTTPS

- olbrzymi

- zidentyfikowane

- identyfikuje

- zidentyfikować

- identyfikacja

- obraz

- zdjęcia

- natychmiast

- wdrożenia

- imponujący

- podnieść

- ulepszony

- poprawa

- in

- zawierać

- Włącznie z

- Zwiększać

- Zwiększenia

- wzrastający

- przemysł

- Informacja

- infuzji

- początkowy

- Innowacja

- wkład

- Wejścia

- inspirowane

- przykład

- Segmentacja instancji

- instrukcje

- zamiar

- odsetki

- zainteresowany

- ciekawy

- zainteresowania

- najnowszych

- angażować

- z udziałem

- IT

- iteracje

- JEGO

- jpg

- właśnie

- tylko jeden

- wiedza

- znany

- Etykieta

- Etykiety

- Tor

- język

- duży

- na dużą skalę

- większe

- największym

- w końcu

- Utajenie

- UCZYĆ SIĘ

- nauka

- lewo

- mniej

- poziom

- Biblioteka

- Licencja

- leży

- życie

- Life Sciences

- lekki

- lubić

- lubi

- Ograniczenia

- Limity

- lin

- Lista

- mało

- LLM

- lokalizacja

- Popatrz

- poszukuje

- WYGLĄD

- niski

- maszyna

- uczenie maszynowe

- WYKONUJE

- Dokonywanie

- zarządzane

- podręcznik

- wiele

- ślub

- maska

- Maski

- masywny

- Może..

- znaczy

- Media

- średni

- członek

- Meta

- Metryka

- migrować

- milion

- nic

- minimalny

- ML

- model

- modele

- Modyfikacje

- Moduł

- jeszcze

- większość

- Motywacja

- dużo

- wielokrotność

- Muzyka

- Nazwa

- Nazwy

- Naturalny

- Przetwarzanie języka naturalnego

- koniecznie

- Nowości

- I Love New York

- nowy jork

- Następny

- Nie

- zauważyć

- numer

- przedmiot

- Wykrywanie obiektów

- cel

- obiekty

- of

- poza

- on

- ONE

- optymalizacja

- or

- oryginalny

- Inne

- ludzkiej,

- na zewnątrz

- Wynik

- wydajność

- Wyjścia

- zewnętrzne

- koniec

- par

- parametr

- parametry

- szczególny

- strony

- Łata

- postrzeganie

- wykonać

- jest gwarancją najlepszej jakości, które mogą dostarczyć Ci Twoje monitory,

- wykonywane

- Osobiście

- obraz

- słupy

- rurociąg

- piksel

- samolot

- Platforma

- plato

- Analiza danych Platona

- PlatoDane

- Grać

- gra

- punkt

- zwrotnica

- Popularny

- możliwy

- Post

- potencjał

- power

- przewidzieć

- pierwotny

- Główny

- Wcześniejszy

- wygląda tak

- Obrobiony

- przetwarzanie

- produkować

- produkuje

- odsetek

- zaproponować

- Udowodnij

- zapewniać

- pod warunkiem,

- zapewnia

- że

- cel

- jakość

- ilościowy

- ilość

- pytanie

- zasięg

- w czasie rzeczywistym

- naprawdę

- Przyczyny

- niedawny

- Czerwony

- zmniejszyć

- odnosić się

- odnosi

- region

- regiony

- związane z

- Raporty

- wymagania

- Wymaga

- Zasób

- poszanowanie

- odpowiedź

- dalsze

- Efekt

- zrewolucjonizować

- Bogaty

- prawo

- droga

- bieganie

- sagemaker

- Sam

- taki sam

- zobaczył

- Skala

- scena

- NAUKI

- Naukowiec

- wynik

- druga

- działy

- widzieć

- widziany

- segment

- segmentacja

- Segmenty

- senior

- oddzielny

- Bezserwerowe

- usługa

- Usługi

- zestaw

- kilka

- ona

- powinien

- pokazać

- prezentacja

- pokazane

- Targi

- znak

- znaczący

- znaki

- Srebro

- podobny

- Prosty

- liczba pojedyncza

- Rozmiar

- rozmiary

- umiejętność

- otwór

- automatach

- mały

- mniejszy

- skrawek

- So

- Piłka nożna

- Rozwiązania

- ROZWIĄZANIA

- kilka

- Źródło

- Źródła

- specjalista

- specyficzny

- swoiście

- wydać

- dzielić

- Półki na książki

- standard

- początek

- Stan

- Cel

- Nadal

- bezpośredni

- silne strony

- Struktura

- strukturyzacja

- Zmagania

- udany

- taki

- podpory

- niezrównany

- systemy

- stół

- Brać

- Zadania

- Zadanie

- zadania

- Techniki

- Technologies

- szablon

- Szablony

- REGULAMIN

- przetestowany

- Testy

- XNUMX

- tekstowy

- niż

- że

- Połączenia

- Strefa

- Podstawy

- Przyszłość

- Informacje

- ich

- Tam.

- Te

- to

- myśl

- trzy

- Przez

- czas

- Opony

- do

- już dziś

- narzędzie

- narzędzia

- Top

- Kwota produktów:

- Śledzenie

- ruch drogowy

- przeszkolony

- Trening

- Przekształcać

- transformator

- ciężarówka

- prawdziwy

- zaufany

- Prawda

- próbować

- drugiej

- rodzaj

- typowy

- dla

- zrozumieć

- us

- nadający się do użytku

- Stosowanie

- posługiwać się

- przypadek użycia

- przypadków użycia

- używany

- Użytkownik

- za pomocą

- Wartości

- różnorodny

- Naprawiono

- wegetacja

- Pojazdy

- wersja

- Wersje

- pionowe

- początku.

- Wideo

- wizja

- wizualny

- vs

- W

- była

- sposoby

- we

- sieć

- usługi internetowe

- DOBRZE

- poszedł

- były

- Co

- Co to jest

- jeśli chodzi o komunikację i motywację

- natomiast

- który

- cały

- szeroki

- Szeroki zasięg

- szeroko

- będzie

- w

- w ciągu

- bez

- świadkiem

- słowa

- Praca

- przepływów pracy

- pracujący

- działa

- by

- pisanie

- X

- lat

- york

- You

- Twój

- zefirnet