Amazońska skała macierzysta zapewnia szeroką gamę modeli od Amazon i dostawców zewnętrznych, w tym Anthropic, AI21, Meta, Cohere i Stability AI, i obejmuje szeroki zakres przypadków użycia, w tym generowanie tekstu i obrazów, osadzanie, czat, agenci wysokiego poziomu z rozumowaniem i orkiestracją i nie tylko. Bazy wiedzy na temat Amazon Bedrock umożliwia tworzenie wydajnych i dostosowanych aplikacji generacji rozszerzonej pobierania (RAG) w oparciu o zasoby wektorowe AWS i innych firm, korzystając zarówno z modeli AWS, jak i innych firm. Bazy wiedzy dla Amazon Bedrock automatyzują synchronizację danych ze sklepem wektorowym, w tym różnicowanie danych podczas ich aktualizacji, ładowanie i dzielenie dokumentów, a także osadzanie semantyczne. Umożliwia płynne dostosowywanie podpowiedzi i strategii wyszukiwania RAG — zapewniamy informację o źródle i automatycznie zajmujemy się zarządzaniem pamięcią. Bazy wiedzy są całkowicie bezserwerowe, więc nie musisz zarządzać żadną infrastrukturą, a korzystając z Baz wiedzy, płacisz tylko za używane modele, bazy danych wektorowych i pamięć masową.

RAG to popularna technika, która łączy wykorzystanie prywatnych danych z dużymi modelami językowymi (LLM). RAG rozpoczyna się od początkowego kroku polegającego na pobraniu odpowiednich dokumentów z magazynu danych (najczęściej z indeksu wektorowego) na podstawie zapytania użytkownika. Następnie wykorzystuje model językowy do wygenerowania odpowiedzi, biorąc pod uwagę zarówno pobrane dokumenty, jak i oryginalne zapytanie.

W tym poście pokazujemy, jak zbudować przepływ pracy RAG, korzystając z baz wiedzy dla Amazon Bedrock na potrzeby odkrywania nowych leków.

Przegląd baz wiedzy na temat Amazon Bedrock

Bazy wiedzy dla Amazon Bedrock obsługują szeroką gamę popularnych typów plików, w tym .txt, .docx, .pdf, .csv i inne. Aby umożliwić skuteczne odzyskiwanie danych prywatnych, powszechną praktyką jest najpierw dzielenie tych dokumentów na łatwe do zarządzania fragmenty. W bazie wiedzy Knowledge Base wdrożono domyślną strategię dzielenia na porcje, która sprawdza się w większości przypadków i umożliwia szybsze rozpoczęcie pracy. Jeśli potrzebujesz większej kontroli, Bazy wiedzy pozwalają kontrolować strategię dzielenia na porcje za pomocą zestawu wstępnie skonfigurowanych opcji. Możesz kontrolować maksymalny rozmiar tokena i stopień nakładania się fragmentów, aby zapewnić spójny kontekst osadzania. Bazy wiedzy dla Amazon Bedrock zarządzają procesem synchronizacji danych z Twojego Usługa Amazon Simple Storage (Amazon S3), dzieli je na mniejsze części, generuje osadzanie wektorów i przechowuje osadzania w indeksie wektorowym. Procesowi temu towarzyszy inteligentne zarządzanie różnicowaniem, przepustowością i awariami.

W czasie wykonywania model osadzania służy do konwertowania zapytania użytkownika na wektor. Następnie sprawdzany jest indeks wektora, aby znaleźć dokumenty podobne do zapytania użytkownika, porównując wektory dokumentów z wektorem zapytania użytkownika. W ostatnim kroku semantycznie podobne dokumenty pobrane z indeksu wektorowego dodawane są jako kontekst dla pierwotnego zapytania użytkownika. Podczas generowania odpowiedzi dla użytkownika w modelu tekstowym wyświetlane są semantycznie podobne dokumenty wraz z podaniem źródła w celu zapewnienia identyfikowalności.

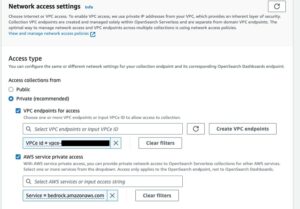

Bazy wiedzy dla Amazon Bedrock obsługują wiele wektorowych baz danych, w tym Amazon OpenSearch bez serwera, Amazonka Aurora, Pinecone i Redis Enterprise Cloud. Interfejsy API Retrieve i RetrieveAndGenerate umożliwiają aplikacjom bezpośrednie wysyłanie zapytań do indeksu przy użyciu ujednoliconej i standardowej składni bez konieczności uczenia się oddzielnych interfejsów API dla każdej innej bazy danych wektorów, co zmniejsza potrzebę pisania niestandardowych zapytań indeksowych względem magazynu wektorów. Interfejs API Retrieve przyjmuje przychodzące zapytanie, konwertuje je na wektor osadzający i wysyła zapytanie do magazynu zaplecza przy użyciu algorytmów skonfigurowanych na poziomie bazy danych wektorów; API RetrieveAndGenerate wykorzystuje skonfigurowany przez użytkownika LLM dostarczony przez Amazon Bedrock i generuje ostateczną odpowiedź w języku naturalnym. Natywna obsługa śledzenia informuje aplikację żądającą o źródłach użytych do odpowiedzi na pytanie. W przypadku wdrożeń korporacyjnych, bazy wiedzy obsługują Usługa zarządzania kluczami AWS szyfrowanie (AWS KMS), Chmura AWS integracyjne i nie tylko.

W poniższych sekcjach pokazujemy, jak zbudować przepływ pracy RAG przy użyciu baz wiedzy dla Amazon Bedrock, wspieranych przez silnik wektorowy OpenSearch Serverless, w celu analizy nieustrukturyzowanego zbioru danych z badań klinicznych pod kątem przypadku użycia nowego leku. Dane te są bogate w informacje, ale mogą być bardzo niejednorodne. Właściwe posługiwanie się specjalistyczną terminologią i koncepcjami w różnych formatach jest niezbędne do wykrywania spostrzeżeń i zapewnienia integralności analitycznej. Dzięki bazom wiedzy dla Amazon Bedrock możesz uzyskać dostęp do szczegółowych informacji za pomocą prostych, naturalnych zapytań.

Zbuduj bazę wiedzy dla Amazon Bedrock

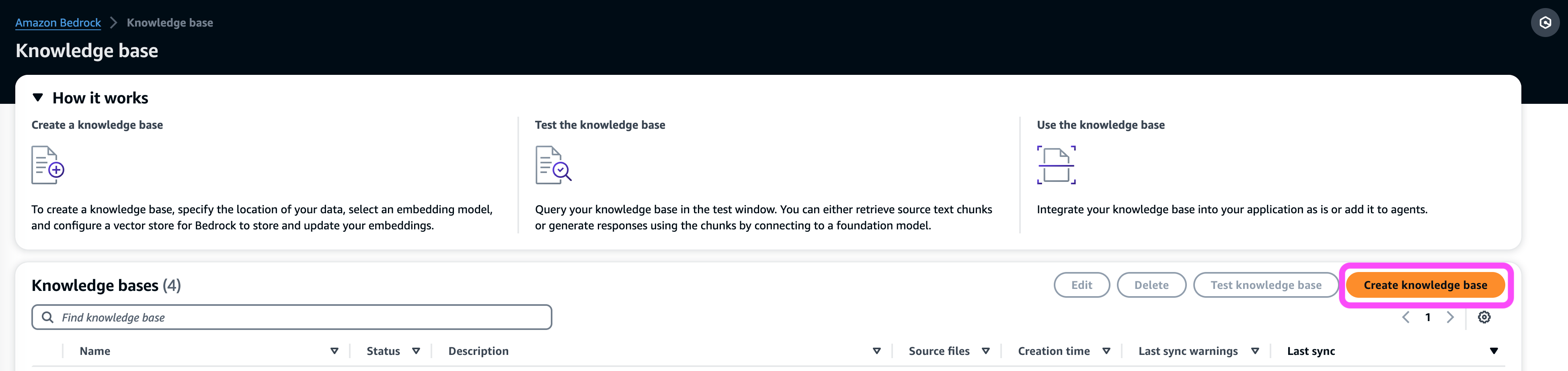

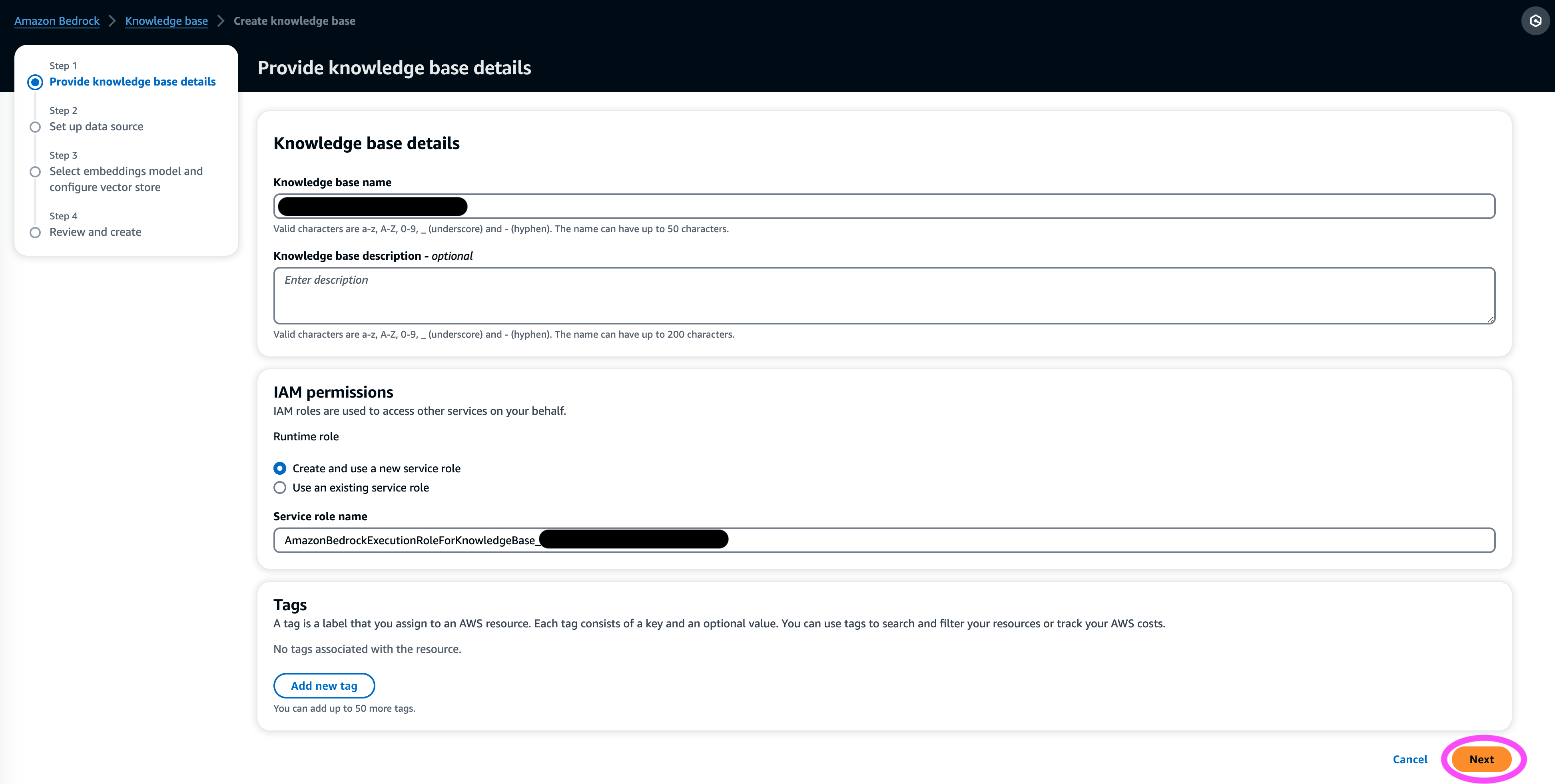

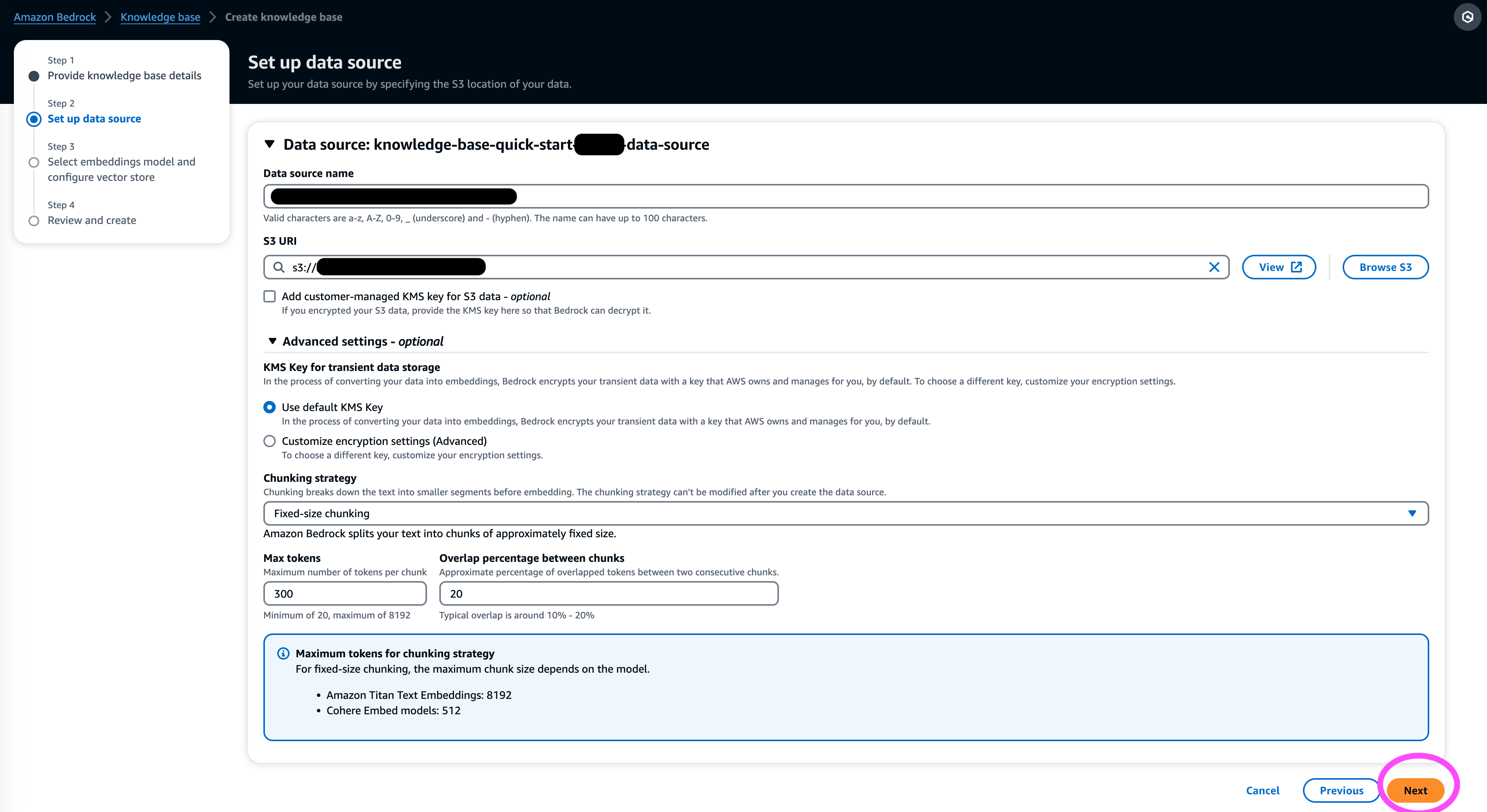

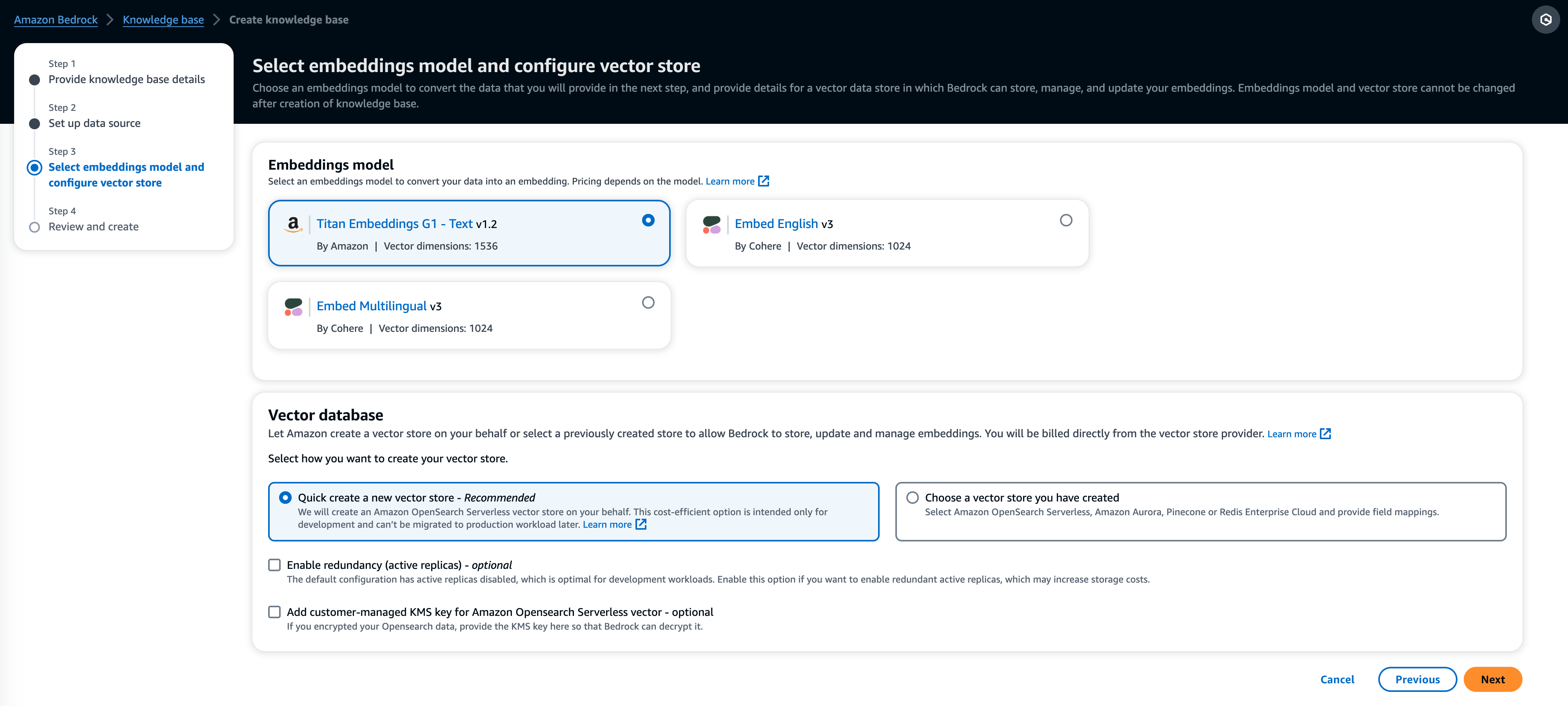

W tej sekcji demonstrujemy proces tworzenia bazy wiedzy dla Amazon Bedrock za pomocą konsoli. Wykonaj następujące kroki:

- Na konsoli Amazon Bedrock w sekcji orkiestracja w okienku nawigacji wybierz Blog.

- Dodaj Utwórz bazę wiedzy.

- W Szczegóły bazy wiedzy sekcji wprowadź nazwę i opcjonalny opis.

- W Uprawnienia sekcja, wybierz Utwórz i użyj nowej roli usługi.

- W razie zamówieenia projektu Rola nazwy usługi, wprowadź nazwę swojej roli, która musi zaczynać się od

AmazonBedrockExecutionRoleForKnowledgeBase_. - Dodaj Następna.

- W Źródło danych wprowadź nazwę źródła danych i identyfikator URI S3, w którym znajduje się zbiór danych. Bazy wiedzy obsługują następujące formaty plików:

- Zwykły tekst (.txt)

- Przecena (.md)

- Język znaczników hipertekstowych (.html)

- Dokument Microsoft Word (.doc/.docx)

- Wartości oddzielone przecinkami (.csv)

- Arkusz kalkulacyjny Microsoft Excel (.xls/.xlsx)

- Przenośny format dokumentu (.pdf)

- Pod Dodatkowe ustawienia¸ wybierz preferowaną strategię dzielenia na porcje (w tym poście wybieramy Porcjowanie o stałym rozmiarze) i określ rozmiar porcji i nakładkę w procentach. Alternatywnie możesz użyć ustawień domyślnych.

- Dodaj Następna.

- W Model osadzania w sekcji wybierz model Titan Embeddings z Amazon Bedrock.

- W Baza danych wektorowych sekcja, wybierz Szybko utwórz nowy sklep wektorowy, który zarządza procesem zakładania sklepu wektorowego.

- Dodaj Następna.

- Przejrzyj ustawienia i wybierz Utwórz bazę wiedzy.

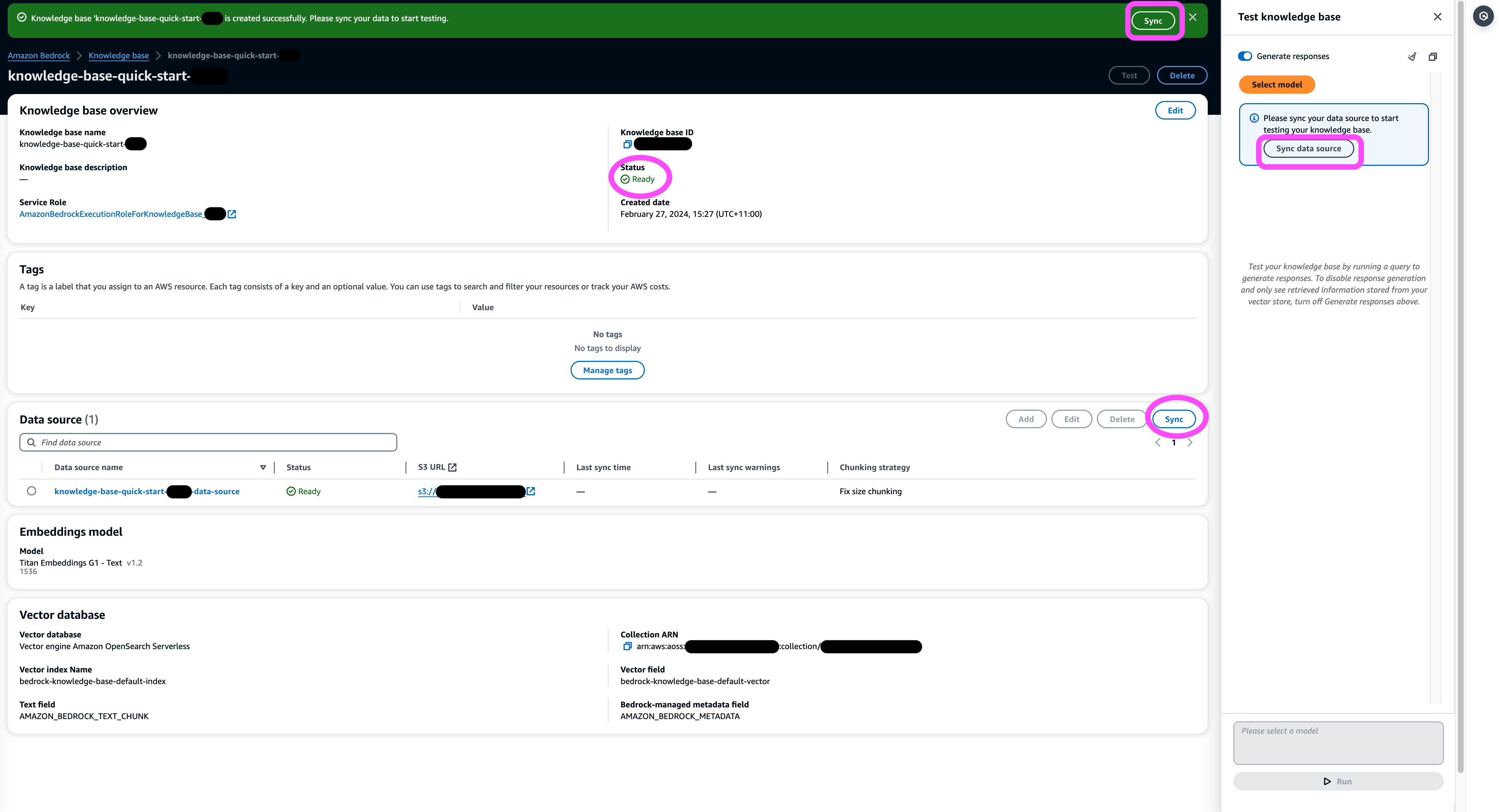

- Poczekaj na zakończenie tworzenia bazy wiedzy i potwierdź jej status Gotowy.

- W Źródło danych sekcji lub na banerze u góry strony lub w wyskakującym okienku w oknie testowym wybierz Sync aby uruchomić proces ładowania danych z segmentu S3, dzielenia ich na fragmenty o określonym rozmiarze, generowania osadzania wektorów przy użyciu wybranego modelu osadzania tekstu i przechowywania ich w magazynie wektorów zarządzanym przez Bazy wiedzy dla Amazon Bedrock.

Funkcja synchronizacji obsługuje pozyskiwanie, aktualizację i usuwanie dokumentów z indeksu wektorowego na podstawie zmian w dokumentach w Amazon S3. Możesz także skorzystać z StartIngestionJob API do wyzwalania synchronizacji za pośrednictwem zestawu SDK AWS.

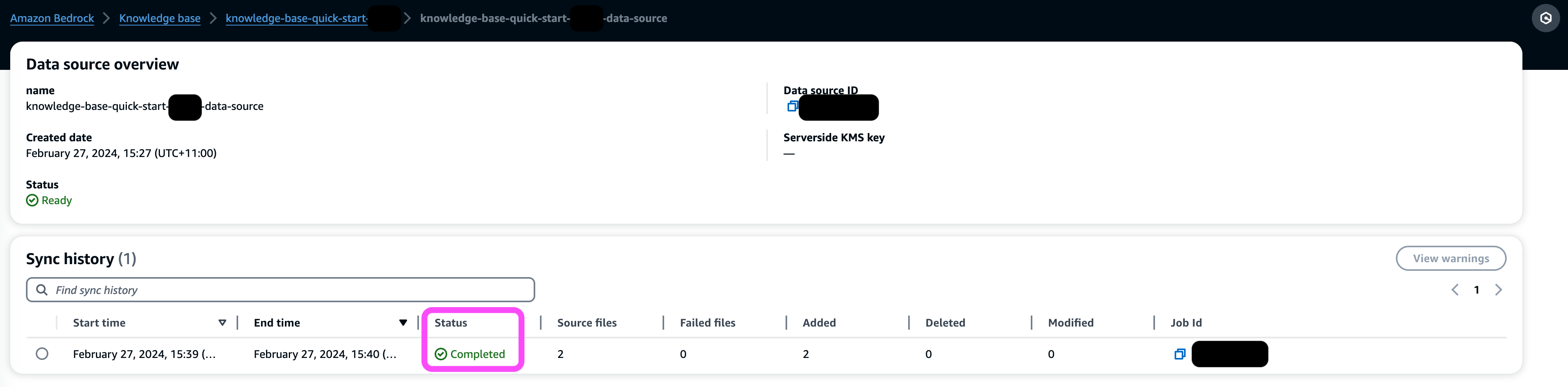

Po zakończeniu synchronizacji historia synchronizacji pokazuje stan Zakończona.

Zapytaj w bazie wiedzy

W tej sekcji pokazujemy, jak uzyskać dostęp do szczegółowych informacji w bazie wiedzy za pomocą prostych i naturalnych zapytań. Korzystamy z nieustrukturyzowanego syntetycznego zbioru danych składającego się z plików PDF, każdy o numerze strony od 10 do 100 stron, symulującego plan badań klinicznych proponowanego nowego leku, obejmujący metody analizy statystycznej i formularze zgody uczestników. Korzystamy z baz wiedzy dotyczących Amazon Bedrock retrieve_and_generate i retrieve API z Integracja Amazon Bedrock LangChain.

Zanim będziesz mógł pisać skrypty korzystające z API Amazon Bedrock, musisz zainstalować odpowiednią wersję pakietu AWS SDK w swoim środowisku. W przypadku skryptów Pythona będzie to plik AWS SDK dla Pythona (Boto3):

Dodatkowo włącz dostęp do modelu Amazon Titan Embeddings i Anthropic Claude v2 lub v1. Aby uzyskać więcej informacji, zobacz Dostęp do modelu.

Generuj pytania za pomocą Amazon Bedrock

Możemy użyć Anthropic Claude 2.1 dla Amazon Bedrock, aby zaproponować listę pytań, które należy zadać w odniesieniu do zbioru danych badania klinicznego:

Użyj interfejsu API Amazon Bedrock RetrieveAndGenerate

Aby uzyskać w pełni zarządzane środowisko RAG, możesz skorzystać z natywnych baz wiedzy dla Amazon Bedrock RetrieveAndGenerate API umożliwiające bezpośrednie uzyskanie odpowiedzi:

Cytowane źródło informacji można uzyskać za pomocą następującego kodu (niektóre dane wyjściowe zostały zredagowane dla zwięzłości):

Przekazując identyfikator sesji RetrieveAndGenerate API, możesz zachować kontekst rozmowy i zadawać pytania uzupełniające. Na przykład, jeśli bez kontekstu poprosisz o więcej szczegółów z poprzedniej odpowiedzi, odpowiedź może nie być poprawna:

Jednak przekazując identyfikator sesji, potok RAG jest w stanie zidentyfikować odpowiedni kontekst i zwrócić odpowiednie odpowiedzi:

Poniższa tabela przedstawia pobrane odpowiedzi na wszystkie odpowiednie pytania.

| Question | Odpowiedź |

| Jaki jest cel badania? Upewnij się, że rozumiesz cele badania i jakie będą jego procedury. | Celem badania jest sprawdzenie, czy lit jest skuteczny w zapobieganiu powtarzającym się samoukierunkowanym aktom samobójczym u pacjentów z depresją lub chorobą afektywną dwubiegunową. |

| Jakie są zagrożenia i potencjalne korzyści? Formularz powinien wyjaśniać wszystkie przewidywalne ryzyko, skutki uboczne lub dyskomforty, których możesz doświadczyć w związku z uczestnictwem. | Możliwe ryzyko lub dyskomfort obejmuje: pytania podczas rozmowy kwalifikacyjnej powodujące dyskomfort, skutki uboczne leków litowych, takie jak nudności, luźne stolce, pragnienie, zmiany w oddawaniu moczu, drżenie, bóle głowy, pocenie się, zmęczenie, zmniejszona koncentracja, wysypka skórna, zmiany w tarczycy, nasilenie trądziku /łuszczyca, toksyczność litu i ryzyko nagłego przerwania leczenia. Potencjalne korzyści są takie, że testy mogą dostarczyć nowych informacji, które pomogą uczestnikowi, a lit może pomóc w zapobieganiu powtarzającym się samobójstwom u osób cierpiących na depresję lub chorobę afektywną dwubiegunową. |

| Na czym będzie polegał udział? Uzyskaj szczegółowe informacje na temat badań, leków, zmian w stylu życia lub procedur, przez które będziesz przechodził, ile czasu to zajmie i jak długo potrwa badanie. | Udział będzie polegał na wypełnieniu wywiadu i kwestionariuszy dotyczących myślenia, zachowań, leczenia zdrowia psychicznego, leków, używania alkoholu i narkotyków, wsparcia domowego i społecznego oraz zrozumienia wyników badania. Zajmuje to około dwóch godzin i można je przeprowadzić podczas kilku sesji, osobiście lub przez telefon. Jeśli kwalifikują się do pełnego badania, w ciągu jednego roku odbędzie się około 20 wizyt studyjnych. Będzie to obejmować przyjmowanie badanego leku, sprawdzanie parametrów życiowych, wypełnianie kwestionariuszy, ocenę skutków ubocznych oraz kontynuowanie normalnej opieki medycznej i psychicznej. |

| Czy są jakieś koszty lub płatności? Zapytaj, czy będziesz ponosić wszelkie koszty związane z badaniem lub czy będziesz otrzymywać wynagrodzenie za udział. | Tak, w wynikach wyszukiwania omawiane są koszty i płatności. Nie poniesiesz żadnych opłat za żadne zabiegi ani procedury będące częścią badania. Jednakże nadal będziesz musiał płacić zwykłe dopłaty VA za opiekę i leki niezwiązane z badaniem. Nie otrzymasz zapłaty za udział, ale badanie zwróci koszty związane z uczestnictwem, takie jak transport, parking itp. Podano kwoty i przebieg zwrotu. |

| W jaki sposób moja prywatność będzie chroniona? Formularz powinien wyjaśniać, w jaki sposób Twoje dane dotyczące zdrowia będą traktowane jako poufne przed, w trakcie i po badaniu. | Twoja prywatność będzie chroniona poprzez przeprowadzanie wywiadów na osobności, przechowywanie pisemnych notatek w zamkniętych aktach i biurach, przechowywanie informacji elektronicznych w plikach zaszyfrowanych i chronionych hasłem oraz uzyskiwanie Certyfikatu Poufności od Departamentu Zdrowia i Opieki Społecznej, aby zapobiec ujawnieniu informacji identyfikujących Cię . Informacje umożliwiające Twoją identyfikację mogą zostać udostępnione lekarzom odpowiedzialnym za Twoją opiekę lub audytom i ocenom przeprowadzanym przez agencje rządowe, ale rozmowy i dokumenty dotyczące badania nie umożliwią Twojej identyfikacji. |

Zapytanie za pomocą interfejsu API Amazon Bedrock Retrieve

Aby dostosować przepływ pracy RAG, możesz użyć interfejsu Retrieve API, aby pobrać odpowiednie fragmenty na podstawie zapytania i przekazać je do dowolnego LLM dostarczonego przez Amazon Bedrock. Aby użyć interfejsu Retrieve API, zdefiniuj go w następujący sposób:

Pobierz odpowiedni kontekst (z niektórymi wynikami zredagowanymi dla zwięzłości):

Wyodrębnij kontekst szablonu podpowiedzi:

Zaimportuj moduły Pythona i skonfiguruj szablon pytania kontekstowego z odpowiedzią na pytanie, a następnie wygeneruj ostateczną odpowiedź:

Zapytanie wykorzystujące integrację z Amazon Bedrock LangChain

Aby stworzyć kompleksową, dostosowaną do indywidualnych potrzeb aplikację pytań i odpowiedzi, Bazy wiedzy dla Amazon Bedrock zapewniają integrację z LangChain. Aby skonfigurować retriever LangChain, podaj identyfikator bazy wiedzy i określ liczbę wyników, które mają zostać zwrócone z zapytania:

Teraz skonfiguruj LangChain RetrievalQA i wygeneruj odpowiedzi z bazy wiedzy:

Spowoduje to wygenerowanie odpowiednich odpowiedzi podobnych do tych wymienionych we wcześniejszej tabeli.

Sprzątać

Pamiętaj, aby usunąć następujące zasoby, aby uniknąć dodatkowych opłat:

Wnioski

Amazon Bedrock zapewnia szeroki zestaw głęboko zintegrowanych usług do obsługi aplikacji RAG dowolnej skali, dzięki czemu rozpoczęcie analizy danych firmy jest proste. Bazy wiedzy dla Amazon Bedrock integrują się z podstawowymi modelami Amazon Bedrock w celu tworzenia skalowalnych potoków osadzania dokumentów i usług wyszukiwania dokumentów w celu obsługi szerokiej gamy aplikacji wewnętrznych i przeznaczonych dla klientów. Jesteśmy podekscytowani nadchodzącą przyszłością, a Twoja opinia będzie odgrywać kluczową rolę w kierowaniu postępem tego produktu. Aby dowiedzieć się więcej o możliwościach Amazon Bedrock i baz wiedzy, zob Baza wiedzy dla Amazon Bedrock.

O autorach

Marka Roya jest głównym architektem uczenia maszynowego dla AWS, pomagając klientom projektować i budować rozwiązania AI/ML. Praca Marka obejmuje szeroki zakres przypadków użycia ML, ze szczególnym uwzględnieniem widzenia komputerowego, głębokiego uczenia się i skalowania ML w całym przedsiębiorstwie. Pomógł firmom z wielu branż, w tym ubezpieczeń, usług finansowych, mediów i rozrywki, opieki zdrowotnej, usług użyteczności publicznej i produkcji. Mark posiada sześć certyfikatów AWS, w tym certyfikat specjalizacji ML. Przed dołączeniem do AWS Mark był architektem, programistą i liderem technologii przez ponad 25 lat, w tym 19 lat w usługach finansowych.

Marka Roya jest głównym architektem uczenia maszynowego dla AWS, pomagając klientom projektować i budować rozwiązania AI/ML. Praca Marka obejmuje szeroki zakres przypadków użycia ML, ze szczególnym uwzględnieniem widzenia komputerowego, głębokiego uczenia się i skalowania ML w całym przedsiębiorstwie. Pomógł firmom z wielu branż, w tym ubezpieczeń, usług finansowych, mediów i rozrywki, opieki zdrowotnej, usług użyteczności publicznej i produkcji. Mark posiada sześć certyfikatów AWS, w tym certyfikat specjalizacji ML. Przed dołączeniem do AWS Mark był architektem, programistą i liderem technologii przez ponad 25 lat, w tym 19 lat w usługach finansowych.

Mani Chanuja jest Tech Lead – Generative AI Specialists, autorką książki – Applied Machine Learning and High Performance Computing on AWS oraz członkiem Rady Dyrektorów Fundacji ds. Kobiet w Edukacji Produkcyjnej. Prowadzi projekty uczenia maszynowego (ML) w różnych dziedzinach, takich jak widzenie komputerowe, przetwarzanie języka naturalnego i generatywna sztuczna inteligencja. Pomaga klientom budować, szkolić i wdrażać duże modele uczenia maszynowego na dużą skalę. Występuje na konferencjach wewnętrznych i zewnętrznych takich jak: Invent, Women in Manufacturing West, webinarach na YouTube i GHC 23. W wolnym czasie lubi długie biegi po plaży.

Mani Chanuja jest Tech Lead – Generative AI Specialists, autorką książki – Applied Machine Learning and High Performance Computing on AWS oraz członkiem Rady Dyrektorów Fundacji ds. Kobiet w Edukacji Produkcyjnej. Prowadzi projekty uczenia maszynowego (ML) w różnych dziedzinach, takich jak widzenie komputerowe, przetwarzanie języka naturalnego i generatywna sztuczna inteligencja. Pomaga klientom budować, szkolić i wdrażać duże modele uczenia maszynowego na dużą skalę. Występuje na konferencjach wewnętrznych i zewnętrznych takich jak: Invent, Women in Manufacturing West, webinarach na YouTube i GHC 23. W wolnym czasie lubi długie biegi po plaży.

Dr Baichuan Sun, obecnie pełniący funkcję starszego architekta rozwiązań AI/ML w AWS, koncentruje się na generatywnej sztucznej inteligencji i wykorzystuje swoją wiedzę z zakresu analityki danych i uczenia maszynowego, aby dostarczać praktyczne rozwiązania biznesowe oparte na chmurze. Dzięki doświadczeniu w doradztwie w zakresie zarządzania i architekturze rozwiązań AI zajmuje się szeregiem złożonych wyzwań, w tym między innymi wizją komputerową robotyki, prognozowaniem szeregów czasowych i konserwacją predykcyjną. Jego praca opiera się na solidnym doświadczeniu w zakresie zarządzania projektami, prac badawczo-rozwojowych nad oprogramowaniem oraz zajęć akademickich. Poza pracą dr Sun ceni równowagę między podróżowaniem a spędzaniem czasu z rodziną i przyjaciółmi.

Dr Baichuan Sun, obecnie pełniący funkcję starszego architekta rozwiązań AI/ML w AWS, koncentruje się na generatywnej sztucznej inteligencji i wykorzystuje swoją wiedzę z zakresu analityki danych i uczenia maszynowego, aby dostarczać praktyczne rozwiązania biznesowe oparte na chmurze. Dzięki doświadczeniu w doradztwie w zakresie zarządzania i architekturze rozwiązań AI zajmuje się szeregiem złożonych wyzwań, w tym między innymi wizją komputerową robotyki, prognozowaniem szeregów czasowych i konserwacją predykcyjną. Jego praca opiera się na solidnym doświadczeniu w zakresie zarządzania projektami, prac badawczo-rozwojowych nad oprogramowaniem oraz zajęć akademickich. Poza pracą dr Sun ceni równowagę między podróżowaniem a spędzaniem czasu z rodziną i przyjaciółmi.

Derricka Choo jest starszym architektem rozwiązań w AWS, skupiającym się na przyspieszaniu podróży klientów do chmury i przekształcaniu ich biznesu poprzez przyjęcie rozwiązań opartych na chmurze. Jego specjalistyczna wiedza dotyczy tworzenia aplikacji typu full-stack i uczenia maszynowego. Pomaga klientom projektować i budować kompleksowe rozwiązania obejmujące frontendowe interfejsy użytkownika, aplikacje IoT, API i integrację danych oraz modele uczenia maszynowego. Wolny czas lubi spędzać z rodziną oraz eksperymentować z fotografią i filmowaniem.

Derricka Choo jest starszym architektem rozwiązań w AWS, skupiającym się na przyspieszaniu podróży klientów do chmury i przekształcaniu ich biznesu poprzez przyjęcie rozwiązań opartych na chmurze. Jego specjalistyczna wiedza dotyczy tworzenia aplikacji typu full-stack i uczenia maszynowego. Pomaga klientom projektować i budować kompleksowe rozwiązania obejmujące frontendowe interfejsy użytkownika, aplikacje IoT, API i integrację danych oraz modele uczenia maszynowego. Wolny czas lubi spędzać z rodziną oraz eksperymentować z fotografią i filmowaniem.

Franka Winklera jest starszym architektem rozwiązań i specjalistą generatywnej sztucznej inteligencji w AWS z siedzibą w Singapurze, specjalizującym się w uczeniu maszynowym i generatywnej sztucznej inteligencji. Współpracuje z globalnymi firmami zajmującymi się technologiami cyfrowymi, aby tworzyć skalowalne, bezpieczne i opłacalne produkty i usługi na platformie AWS. W wolnym czasie spędza czas z synem i córką oraz podróżuje, aby cieszyć się falami w ASEAN.

Franka Winklera jest starszym architektem rozwiązań i specjalistą generatywnej sztucznej inteligencji w AWS z siedzibą w Singapurze, specjalizującym się w uczeniu maszynowym i generatywnej sztucznej inteligencji. Współpracuje z globalnymi firmami zajmującymi się technologiami cyfrowymi, aby tworzyć skalowalne, bezpieczne i opłacalne produkty i usługi na platformie AWS. W wolnym czasie spędza czas z synem i córką oraz podróżuje, aby cieszyć się falami w ASEAN.

Nihira Chadderwali jest starszym architektem rozwiązań AI/ML w globalnym zespole ds. opieki zdrowotnej i nauk przyrodniczych. Jego doświadczenie polega na budowaniu rozwiązań opartych na Big Data i sztucznej inteligencji na problemy klientów, szczególnie w dziedzinie biomedycyny, nauk przyrodniczych i opieki zdrowotnej. Fascynuje go także skrzyżowanie informatyki kwantowej i sztucznej inteligencji. Lubi uczyć się i wnosić wkład w tę przestrzeń. W wolnym czasie lubi grać w tenisa, podróżować i poznawać kosmologię.

Nihira Chadderwali jest starszym architektem rozwiązań AI/ML w globalnym zespole ds. opieki zdrowotnej i nauk przyrodniczych. Jego doświadczenie polega na budowaniu rozwiązań opartych na Big Data i sztucznej inteligencji na problemy klientów, szczególnie w dziedzinie biomedycyny, nauk przyrodniczych i opieki zdrowotnej. Fascynuje go także skrzyżowanie informatyki kwantowej i sztucznej inteligencji. Lubi uczyć się i wnosić wkład w tę przestrzeń. W wolnym czasie lubi grać w tenisa, podróżować i poznawać kosmologię.

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- PlatoData.Network Pionowe generatywne AI. Wzmocnij się. Dostęp tutaj.

- PlatoAiStream. Inteligencja Web3. Wiedza wzmocniona. Dostęp tutaj.

- PlatonESG. Węgiel Czysta technologia, Energia, Środowisko, Słoneczny, Gospodarowanie odpadami. Dostęp tutaj.

- Platon Zdrowie. Inteligencja w zakresie biotechnologii i badań klinicznych. Dostęp tutaj.

- Źródło: https://aws.amazon.com/blogs/machine-learning/use-rag-for-drug-discovery-with-knowledge-bases-for-amazon-bedrock/

- :ma

- :Jest

- :nie

- :Gdzie

- $W GÓRĘ

- 1

- 10

- 100

- 11

- 120

- 121

- 13

- 14

- 150

- 160

- 19

- 20

- 23

- 25

- 29

- 35%

- 40

- 41

- 5 pytania

- 7

- 8

- 9

- a

- Zdolny

- O nas

- akademicki

- przyspieszenie

- dostęp

- w poprzek

- w dodatku

- Dodatkowy

- Adresy

- Skorygowana

- Przyjęcie

- Po

- przed

- agencje

- agentów

- przed

- AI

- Zasilany AI

- AI / ML

- Alkohol

- Algorytmy

- Wszystkie kategorie

- dopuszczać

- pozwala

- wzdłuż

- również

- Amazonka

- Amazon Web Services

- wśród

- ilość

- kwoty

- an

- analiza

- Analityczny

- w czasie rzeczywistym sprawiają,

- Analizując

- i

- odpowiedź

- sekretarka

- odpowiedzi

- Antropiczny

- każdy

- api

- Pszczoła

- Zastosowanie

- aplikacje

- stosowany

- dotyczy

- właściwy

- architektura

- SĄ

- AS

- ASEAN

- zapytać

- oszacować

- przydzielony

- Asystent

- powiązany

- At

- kontrole

- zwiększona

- autor

- automaty

- automatycznie

- uniknąć

- z dala

- AWS

- poparła

- Backend

- tło

- Bilans

- transparent

- baza

- na podstawie

- BE

- Plaża

- być

- zanim

- zachowania

- Korzyści

- Duży

- Big Data

- biomedyczny

- narodziny

- krew

- deska

- Rada dyrektorów

- książka

- obie

- szeroki

- budować

- Budowanie

- biznes

- ale

- by

- CAN

- możliwości

- który

- walizka

- Etui

- spowodowanie

- świadectwo

- Certyfikacja

- certyfikaty

- więzy

- wyzwania

- Zmiany

- naładowany

- Opłaty

- pogawędzić

- w kratę

- Dodaj

- cytowane

- Kliniczne

- Chmura

- kod

- ZGODNY

- kombajny

- byliśmy spójni, od początku

- wspólny

- powszechnie

- Firmy

- sukcesy firma

- w porównaniu

- porównanie

- kompletny

- całkowicie

- wypełniając

- kompleks

- komputer

- Wizja komputerowa

- computing

- stężenie

- Koncepcje

- zwięzły

- przeprowadzone

- prowadzenia

- konferencje

- poufny

- poufność

- skonfigurowany

- Potwierdzać

- zgoda

- wobec

- Składający się

- Konsola

- consulting

- zawartość

- kontekst

- konteksty

- kontynuować

- kontynuując

- przyczyniając

- kontrola

- Rozmowa

- konwertować

- prawidłowo

- Odpowiedni

- Kosmologia

- opłacalne

- Koszty:

- mógłby

- pokrycie

- Okładki

- Stwórz

- stworzony

- Tworzenie

- tworzenie

- CSP

- Obecnie

- zwyczaj

- klient

- Klientów

- dostosować

- dostosowane

- dane

- nauka danych

- Baza danych

- Bazy danych

- córka

- Dni

- zmniejszony

- głęboko

- głęboka nauka

- głęboko

- Domyślnie

- określić

- próbny

- wykazać

- Departament

- rozwijać

- Depresja

- opis

- Wnętrze

- szczegółowe

- detale

- wykryć

- Deweloper

- oprogramowania

- różne

- cyfrowy

- bezpośrednio

- Dyrektorzy

- Ujawnianie

- odkrycie

- omówione

- nieporządek

- do

- Lekarze

- dokument

- dokumenty

- domena

- domeny

- darowizna

- zrobić

- nie

- dawki

- dr

- lek

- podczas

- każdy

- Wcześniej

- Edukacja

- efekt

- Efektywne

- ruchomości

- skuteczność

- bądź

- Opracować

- Elektroniczny

- kwalifikowalne

- więcej

- osadzanie

- zatrudnia

- umożliwiać

- szyfrowane

- szyfrowanie

- zakończenia

- koniec końców

- silnik

- cieszyć się

- zapewnić

- Wchodzę

- Enterprise

- rozrywka

- Środowisko

- szczególnie

- niezbędny

- itp

- oceniać

- oceny

- przykład

- przewyższać

- podniecony

- wydatki

- doświadczenie

- eksperymentować

- ekspertyza

- Wyjaśniać

- zewnętrzny

- fakt

- Brak

- członków Twojej rodziny

- szybciej

- zmęczenie

- informacja zwrotna

- filet

- Akta

- finał

- budżetowy

- usługi finansowe

- Znajdź

- i terminów, a

- koncentruje

- koncentruje

- następnie

- następujący

- następujący sposób

- W razie zamówieenia projektu

- przewidywalny

- Nasz formularz

- format

- formularze

- Fundacja

- Darmowy

- przyjaciele

- od

- frontend

- pełny

- Pełny stos

- w pełni

- funkcjonować

- dalej

- przyszłość

- Generować

- generuje

- generujący

- generacja

- generatywny

- generatywna sztuczna inteligencja

- otrzymać

- Globalne

- globalny cyfrowy

- Go

- Gole

- Goes

- Rząd

- agencje rządowe

- uziemiony

- gwarantowane

- przewodnictwo

- uchwyt

- Prowadzenie

- Have

- mający

- he

- bóle głowy

- Zdrowie

- Opieka zdrowotna

- informacje o zdrowiu

- opieki zdrowotnej

- pomoc

- pomógł

- pomoc

- pomaga

- jej

- Wysoki

- na wysokim szczeblu

- jego

- historia

- posiada

- Strona główna

- GODZINY

- W jaki sposób

- How To

- Jednak

- HTML

- http

- HTTPS

- człowiek

- ID

- identyfikuje

- zidentyfikować

- if

- obraz

- wdrożenia

- realizowane

- importować

- in

- zawierać

- Włącznie z

- Przybywający

- wskaźnik

- przemysłowa

- Informacja

- informuje

- Infrastruktura

- początkowy

- wkład

- spostrzeżenia

- zainstalować

- ubezpieczenie

- zintegrowany

- Integruje się

- integracja

- integracje

- integralność

- Inteligentny

- wzajemne oddziaływanie

- odsetki

- interfejsy

- wewnętrzny

- skrzyżowanie

- Wywiad

- pytania podczas rozmowy kwalifikacyjnej

- Wywiady

- najnowszych

- angażować

- Internet przedmiotów

- IT

- JEGO

- łączący

- podróż

- jpg

- właśnie

- konserwacja

- trzymane

- Klawisz

- Wiedzieć

- Wiedząc

- wiedza

- język

- duży

- Nazwisko

- prowadzić

- lider

- Wyprowadzenia

- UCZYĆ SIĘ

- nauka

- pozwala

- poziom

- poziomy

- życie

- Life Sciences

- lifestyle

- lubić

- lubi

- Lista

- Katalogowany

- LLM

- załadunek

- lokalizacja

- zamknięty

- długo

- maszyna

- uczenie maszynowe

- konserwacja

- robić

- Dokonywanie

- zarządzanie

- wykonalny

- zarządzane

- i konserwacjami

- zarządza

- produkcja

- wiele

- znak

- Znaki

- maksymalny

- Może..

- me

- Media

- medyczny

- badania medyczne

- lek

- leki

- lekarstwo

- członek

- Pamięć

- psychika

- Zdrowie psychiczne

- Meta

- metody

- może

- ML

- model

- modele

- Moduły

- monitorowane

- miesięcznie

- jeszcze

- większość

- dużo

- wielokrotność

- musi

- my

- Nazwa

- rodzimy

- Naturalny

- Przetwarzanie języka naturalnego

- Nawigacja

- Potrzebować

- Nowości

- Nie

- żaden

- normalna

- Uwagi

- numer

- z naszej

- uzyskać

- uzyskane

- uzyskiwanie

- of

- biura

- on

- ONE

- te

- tylko

- Opcje

- or

- orkiestracja

- oryginalny

- Inne

- Pozostałe

- wyniki

- wydajność

- zewnętrzne

- koniec

- zakładka

- strona

- stron

- płatny

- chleb

- Papiery

- parking

- część

- uczestnik

- Uczestnicy

- uczestnictwo

- udział

- przechodzić

- Przechodzący

- Hasło

- pacjenci

- Zapłacić

- płatności

- Ludzie

- procent

- jest gwarancją najlepszej jakości, które mogą dostarczyć Ci Twoje monitory,

- okres

- osoba

- osobisty

- telefon

- fotografia

- sztuk

- rurociąg

- krok po kroku

- plato

- Analiza danych Platona

- PlatoDane

- Grać

- gra

- Popularny

- możliwy

- Post

- potencjał

- power

- Praktyczny

- praktyka

- Korzystny

- Ciąża

- zapobiec

- zapobieganie

- poprzedni

- pierwotny

- Główny

- Wcześniejszy

- prywatność

- prywatny

- problemy

- procedury

- wygląda tak

- przetwarzanie

- Produkt

- Produkty

- Postęp

- projekt

- Zarządzanie projektami

- projektowanie

- monity

- właściwy

- zaproponować

- zaproponowane

- chroniony

- zapewniać

- pod warunkiem,

- dostawców

- zapewnia

- cel

- Python

- Q & A

- Kwant

- informacja kwantowa

- zapytania

- pytanie

- pytanie

- pytania

- R & D

- szmata

- zasięg

- nośny

- wysypka

- RE

- otrzymać

- redukcja

- odnosić się

- region

- związane z

- powtórzony

- z prośbą

- Badania naukowe

- Zasoby

- odpowiedź

- odpowiedzialny

- dalsze

- Efekt

- wyszukiwanie

- powrót

- recenzowanie

- Bogaty

- Ryzyko

- ryzyko

- robotyka

- Rola

- działa

- Czas

- powiedzieć

- skalowalny

- Skala

- waga

- skalowaniem

- nauka

- NAUKI

- wynik

- skrypty

- Sdk

- płynnie

- Szukaj

- Sekcja

- działy

- bezpieczne

- wybierać

- wybrany

- samokierowanie

- semantyczny

- senior

- oddzielny

- Serie

- Bezserwerowe

- usługa

- Usługi

- służąc

- Sesja

- Sesje

- zestaw

- ustawienie

- w panelu ustawień

- shared

- ona

- powinien

- Targi

- bok

- znak

- znaki

- podobny

- Prosty

- Singapur

- siada

- SIX

- Rozmiar

- skóra

- mniejszy

- So

- Obserwuj Nas

- Tworzenie

- solidny

- rozwiązanie

- Rozwiązania

- kilka

- syn

- Źródło

- Źródła

- Typ przestrzeni

- rozpiętość

- Mówi

- specjalista

- Specjaliści

- wyspecjalizowanym

- Specjalność

- specyficzny

- swoiście

- określony

- Spędzanie

- spędza

- dzielić

- Dzieli

- Arkusz kalkulacyjny

- Stabilność

- stos

- standard

- początek

- rozpoczęty

- Startowy

- rozpocznie

- statystyczny

- statystyka

- Rynek

- Ewolucja krok po kroku

- Cel

- Nadal

- zatrzymany

- zatrzymanie

- przechowywanie

- sklep

- sklep

- przechowywania

- bezpośredni

- Strategia

- Badanie

- taki

- samobójstwo

- Niedz

- wsparcie

- podpory

- pewnie

- synchronizacja

- synchronizacja

- składnia

- syntetyczny

- system

- stół

- Brać

- Zadania

- trwa

- biorąc

- Rozmowy

- zespół

- tech

- technika

- Technologia

- szablon

- tenis

- terminologia

- test

- Testy

- XNUMX

- że

- Połączenia

- Przyszłość

- Źródło

- ich

- Im

- sami

- następnie

- Tam.

- Te

- one

- Myślący

- innych firm

- to

- tych

- Przez

- wydajność

- czas

- Szereg czasowy

- tytan

- do

- razem

- żeton

- Top

- top 5

- Możliwość śledzenia

- Pociąg

- transformatorowy

- transport

- Podróżowanie

- podróże

- leczenie

- zabiegi

- próba

- wyzwalać

- próbować

- drugiej

- rodzaj

- typy

- dla

- zrozumieć

- zrozumienie

- Ujednolicony

- nieuporządkowany

- zaktualizowane

- aktualizowanie

- posługiwać się

- przypadek użycia

- używany

- Użytkownik

- zastosowania

- za pomocą

- zwykły

- zazwyczaj

- Użytkowe

- v1

- Wartości

- różnorodny

- bardzo

- wersja

- przez

- Przemoc

- wizja

- Wizyty

- istotny

- chcieć

- była

- fale

- we

- sieć

- usługi internetowe

- Seminaria

- tygodni

- DOBRZE

- Zachód

- Co

- Co to jest

- jeśli chodzi o komunikację i motywację

- czy

- który

- KIM

- szeroki

- Szeroki zasięg

- będzie

- okno

- w

- bez

- Kobieta

- słowo

- Praca

- workflow

- pracujący

- działa

- by

- napisać

- napisany

- rok

- lat

- You

- Twój

- youtube

- zefirnet