Ten blog jest pisany wspólnie z Joshem Reinim, Shayakiem Senem i Anupamem Dattą z TruEra

Amazon SageMaker JumpStart udostępnia różnorodne wstępnie przeszkolone modele fundamentów, takie jak Llama-2 i Mistal 7B, które można szybko wdrożyć w punkcie końcowym. Te podstawowe modele dobrze sprawdzają się w zadaniach generatywnych, od tworzenia tekstu i podsumowań, odpowiadania na pytania, po tworzenie obrazów i filmów. Pomimo dużych możliwości uogólniania tych modeli, często zdarzają się przypadki użycia, w których modele te muszą zostać dostosowane do nowych zadań lub dziedzin. Jednym ze sposobów ujawnienia tej potrzeby jest ocena modelu w oparciu o wyselekcjonowany zbiór danych podstawowych. Gdy potrzeba dostosowania modelu fundamentu stanie się jasna, można zastosować zestaw technik, aby tego dokonać. Popularnym podejściem jest dostrojenie modelu przy użyciu zbioru danych dostosowanego do przypadku użycia. Dokładne dostrojenie może ulepszyć podstawowy model, a jego skuteczność można ponownie zmierzyć w oparciu o podstawowy zbiór danych. Ten notatnik pokazuje, jak dostroić modele za pomocą SageMaker JumpStart.

Jednym z wyzwań związanych z tym podejściem jest to, że utworzenie wyselekcjonowanych zbiorów danych prawdy podstawowej jest kosztowne. W tym poście podejmujemy to wyzwanie, rozszerzając ten przepływ pracy o platformę do rozszerzalnych, zautomatyzowanych ocen. Zaczynamy od podstawowego modelu podstawowego z SageMaker JumpStart i oceniamy go TruLens, biblioteka open source do oceniania i śledzenia aplikacji z dużym modelem językowym (LLM). Po zidentyfikowaniu potrzeby adaptacji możemy zastosować dostrajanie w SageMaker JumpStart i potwierdzić poprawę za pomocą TruLens.

Oceny TruLens wykorzystują abstrakcję funkcje sprzężenia zwrotnego. Funkcje te można wdrożyć na kilka sposobów, w tym w modelach w stylu BERT, odpowiednio podpowiadanych LLM i nie tylko. Integracja TruLens z Amazońska skała macierzysta umożliwia przeprowadzanie ocen przy użyciu LLM dostępnych w Amazon Bedrock. Niezawodność infrastruktury Amazon Bedrock jest szczególnie cenna przy przeprowadzaniu ocen na etapie rozwoju i produkcji.

Ten post służy zarówno jako wprowadzenie do miejsca TruEra w stosie nowoczesnych aplikacji LLM, jak i praktyczny przewodnik po korzystaniu z Amazon Sage Maker i Prawdziwa Era wdrażać, dostrajać i iterować w aplikacjach LLM. Oto całość notatnik z przykładami kodu pokazującymi ocenę wydajności przy użyciu TruLens

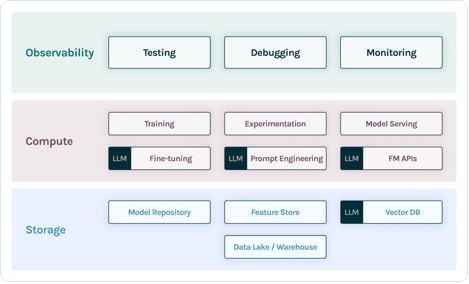

TruEra w stosie aplikacji LLM

TruEra żyje w warstwie obserwowalności aplikacji LLM. Chociaż nowe komponenty przedostały się do warstwy obliczeniowej (dostrajanie, szybka inżynieria, interfejsy API modeli) i warstwy przechowywania (wektorowe bazy danych), nadal istnieje potrzeba obserwowalności. Potrzeba ta rozciąga się od rozwoju po produkcję i wymaga wzajemnie połączonych możliwości testowania, debugowania i monitorowania produkcji, jak pokazano na poniższym rysunku.

W rozwoju możesz użyć open source TruLens aby szybko oceniać, debugować i iterować aplikacje LLM w swoim środowisku. Kompleksowy zestaw wskaźników oceny, obejmujący zarówno wskaźniki oparte na LLM, jak i tradycyjne wskaźniki dostępne w TruLens, umożliwia zmierzenie aplikacji pod kątem kryteriów wymaganych do przeniesienia aplikacji do środowiska produkcyjnego.

W środowisku produkcyjnym te dzienniki i wskaźniki oceny można przetwarzać na dużą skalę za pomocą monitorowania produkcji TruEra. Łącząc monitorowanie produkcji z testowaniem i debugowaniem, można zidentyfikować i skorygować spadki wydajności, takie jak halucynacje, bezpieczeństwo i inne.

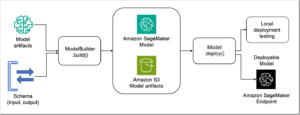

Wdrażaj modele fundamentów w SageMaker

Możesz wdrożyć podstawowe modele, takie jak Llama-2 w SageMaker za pomocą zaledwie dwóch linii kodu Pythona:

Wywołaj punkt końcowy modelu

Po wdrożeniu możesz wywołać punkt końcowy wdrożonego modelu, tworząc najpierw ładunek zawierający dane wejściowe i parametry modelu:

Następnie możesz po prostu przekazać ten ładunek do metody przewidywania punktu końcowego. Pamiętaj, że przy każdym wywołaniu modelu musisz przekazać atrybut, aby zaakceptować umowę licencyjną użytkownika końcowego:

Oceń wydajność za pomocą TruLens

Teraz możesz użyć TruLens do skonfigurowania swojej oceny. TruLens to narzędzie umożliwiające obserwację oferujące rozszerzalny zestaw funkcji informacji zwrotnej umożliwiających śledzenie i ocenę aplikacji wykorzystujących LLM. Funkcje informacji zwrotnej są tutaj niezbędne do sprawdzenia braku halucynacji w aplikacji. Te funkcje informacji zwrotnej są wdrażane przy użyciu gotowych modeli od dostawców takich jak Amazon Bedrock. Modele Amazon Bedrock są tu zaletą ze względu na sprawdzoną jakość i niezawodność. Możesz skonfigurować dostawcę za pomocą TruLens za pomocą następującego kodu:

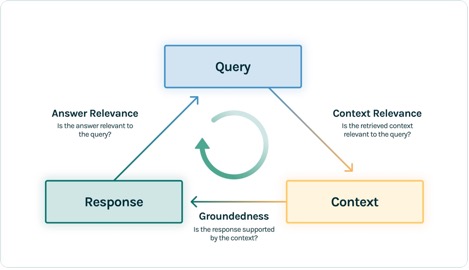

W tym przykładzie używamy trzech funkcji informacji zwrotnej: trafności odpowiedzi, trafności kontekstu i ugruntowania. Oceny te szybko stały się standardem w wykrywaniu halucynacji w kontekstowych aplikacjach odpowiadających na pytania i są szczególnie przydatne w zastosowaniach bez nadzoru, które obejmują zdecydowaną większość dzisiejszych aplikacji LLM.

Przyjrzyjmy się każdej z tych funkcji informacji zwrotnej, aby zrozumieć, jakie korzyści mogą nam one przynieść.

Znaczenie kontekstu

Kontekst ma kluczowe znaczenie dla jakości odpowiedzi naszej aplikacji i przydatne może być programowe zapewnienie, że dostarczony kontekst jest odpowiedni dla zapytania wejściowego. Ma to kluczowe znaczenie, ponieważ ten kontekst zostanie wykorzystany przez LLM do sformułowania odpowiedzi, więc wszelkie nieistotne informacje w kontekście mogą zostać wplecione w halucynacje. TruLens umożliwia ocenę trafności kontekstu przy użyciu struktury serializowanego rekordu:

Ponieważ kontekst dostarczony do LLM jest najważniejszym etapem potoku generacji rozszerzonej wyszukiwania (RAG), znaczenie kontekstu ma kluczowe znaczenie dla zrozumienia jakości wyszukiwania. Pracując z klientami z różnych sektorów, zaobserwowaliśmy, że na podstawie tej oceny zidentyfikowaliśmy różne tryby awarii, takie jak niekompletny kontekst, obcy, nieistotny kontekst, a nawet brak dostępnego wystarczającego kontekstu. Identyfikując charakter tych trybów awarii, nasi użytkownicy mogą dostosować strategie indeksowania (takie jak model osadzania i dzielenie na porcje) oraz strategie wyszukiwania (takie jak okienkowanie zdań i automatyczne łączenie), aby złagodzić te problemy.

Uziemienie

Po pobraniu kontekstu jest on następnie przekształcany w odpowiedź przez LLM. Osoby LLM często mają skłonność do odbiegania od dostarczonych faktów, wyolbrzymiania lub rozszerzania odpowiedzi w kierunku poprawnie brzmiącej odpowiedzi. Aby zweryfikować zasadność wniosku, należy podzielić odpowiedź na osobne stwierdzenia i samodzielnie poszukać dowodów potwierdzających każde z nich w uzyskanym kontekście.

Problemy z uziemieniem często mogą być dalszym skutkiem znaczenia kontekstu. Kiedy LLM nie ma wystarczającego kontekstu, aby sformułować odpowiedź opartą na dowodach, jest bardziej prawdopodobne, że doświadczy halucynacji, próbując wygenerować wiarygodną odpowiedź. Nawet w przypadkach, gdy zapewniony jest pełny i odpowiedni kontekst, LLM może popaść w problemy z zasadnością. Szczególnie dotyczyło to zastosowań, w których LLM reaguje w określonym stylu lub jest używany do wykonania zadania, do którego nie jest dobrze dostosowany. Oceny uziemienia pozwalają użytkownikom TruLens rozbić odpowiedzi LLM na twierdzenia, aby zrozumieć, gdzie LLM najczęściej ma halucynacje. Okazało się to szczególnie przydatne do wskazania dalszych sposobów eliminowania halucynacji poprzez zmiany po stronie modelu (takie jak podpowiedzi, wybór modelu i parametry modelu).

Znaczenie odpowiedzi

Wreszcie odpowiedź nadal musi zawierać pomocną odpowiedź na pierwotne pytanie. Możesz to zweryfikować, oceniając trafność ostatecznej odpowiedzi na dane wprowadzone przez użytkownika:

Osiągając zadowalające oceny dla tej triady, możesz złożyć szczegółowe stwierdzenie na temat poprawności swojej aplikacji; zweryfikowano, że ta aplikacja jest wolna od halucynacji, aż do granic jej bazy wiedzy. Innymi słowy, jeśli baza danych wektorów zawiera wyłącznie dokładne informacje, odpowiedzi udzielone przez kontekstową aplikację odpowiadającą na pytania również będą dokładne.

Ocena prawdy na poziomie podstawowym

Oprócz tych funkcji sprzężenia zwrotnego do wykrywania halucynacji, mamy zestaw danych testowych, DataBricks-Dolly-15k, co pozwala nam dodać podstawowe podobieństwo prawdy jako czwartą metrykę oceny. Zobacz następujący kod:

Zbuduj aplikację

Po skonfigurowaniu ewaluatorów możesz zbudować aplikację. W tym przykładzie używamy kontekstowej aplikacji kontroli jakości. W tej aplikacji podaj instrukcje i kontekst dla silnika uzupełniania:

Po utworzeniu aplikacji i funkcji przesyłania opinii utworzenie opakowanej aplikacji za pomocą TruLens jest proste. Ta opakowana aplikacja, którą nazwiemy base_recorder, będzie rejestrować i oceniać aplikację za każdym razem, gdy zostanie wywołana:

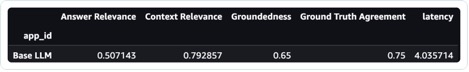

Wyniki z bazą Lama-2

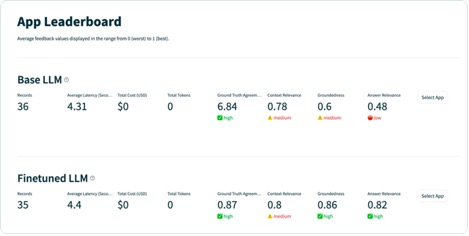

Po uruchomieniu aplikacji na każdym rekordzie w testowym zestawie danych możesz wyświetlić wyniki w notatniku SageMaker za pomocą tru.get_leaderboard(). Poniższy zrzut ekranu przedstawia wyniki oceny. Trafność odpowiedzi jest alarmująco niska, co wskazuje, że model ma trudności z konsekwentnym przestrzeganiem dostarczonych instrukcji.

Dostosuj Lamę-2 za pomocą SageMaker Jumpstart

Znajdują się w nim również kroki umożliwiające dostrojenie modelu Lamy-2 za pomocą programu SageMaker Jumpstart notatnik.

Aby skonfigurować dostrajanie, musisz najpierw pobrać zestaw szkoleniowy i skonfigurować szablon instrukcji

Następnie prześlij zestaw danych i instrukcje do pliku Usługa Amazon Simple Storage Łyżka (Amazon S3) do treningu:

Aby dostroić SageMaker, możesz użyć SageMaker JumpStart Estimator. Najczęściej używamy tutaj domyślnych hiperparametrów, z wyjątkiem ustawienia strojenia instrukcji na true:

Po przeszkoleniu modelu możesz go wdrożyć i utworzyć aplikację tak samo, jak robiłeś to wcześniej:

Oceń dopracowany model

Możesz uruchomić model ponownie na swoim zestawie testowym i obejrzeć wyniki, tym razem w porównaniu z bazową Lamą-2:

Nowy, dopracowany model Llama-2 znacznie poprawił trafność i solidność odpowiedzi, a także podobieństwo do podstawowego zestawu testów prawdy. Ta duża poprawa jakości odbywa się kosztem niewielkiego wzrostu opóźnień. Ten wzrost opóźnienia jest bezpośrednim skutkiem dostrojenia zwiększającego rozmiar modelu.

Wyniki można nie tylko przeglądać w notatniku, ale także przeglądać wyniki w interfejsie użytkownika TruLens, uruchamiając funkcję tru.run_dashboard(). Może to zapewnić te same zagregowane wyniki na stronie tabeli liderów, ale także daje możliwość głębszego zagłębienia się w problematyczne rekordy i zidentyfikowania trybów awarii aplikacji.

Aby zrozumieć ulepszenia aplikacji na rekordowym poziomie, możesz przejść do strony ocen i sprawdzić wyniki opinii na bardziej szczegółowym poziomie.

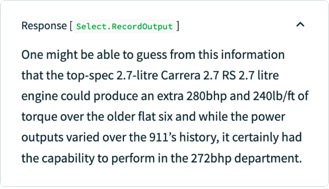

Na przykład, jeśli zadasz podstawowemu LLM pytanie „Jaki jest najmocniejszy sześciocylindrowy silnik Porsche”, model będzie miał halucynacje w następujący sposób.

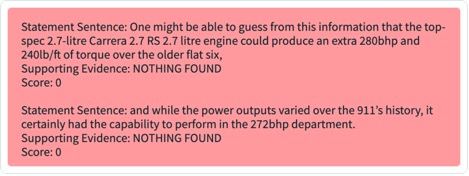

Ponadto możesz sprawdzić programową ocenę tego rekordu, aby poznać wydajność aplikacji w odniesieniu do każdej zdefiniowanej funkcji przesyłania opinii. Analizując wyniki opinii na temat zasadności w TruLens, możesz zobaczyć szczegółowy podział dostępnych dowodów na poparcie każdego twierdzenia wysuniętego przez LLM.

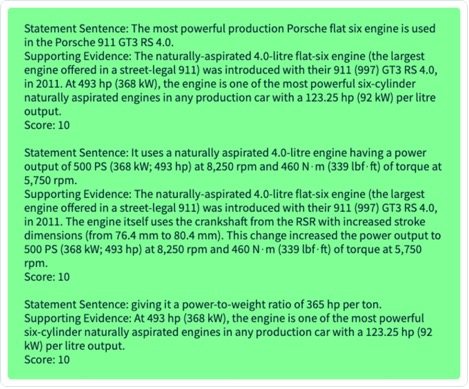

Jeśli wyeksportujesz ten sam rekord do precyzyjnie dostrojonego LLM w TruLens, zobaczysz, że dostrojenie za pomocą SageMaker JumpStart radykalnie poprawiło solidność odpowiedzi.

Korzystając z automatycznego procesu oceny za pomocą TruLens, możesz mierzyć swoją aplikację w oparciu o szerszy zestaw wskaźników, aby lepiej zrozumieć jej wydajność. Co ważne, możesz teraz dynamicznie zrozumieć tę wydajność w każdym przypadku użycia — nawet w tych, w których nie zebrałeś podstawowej prawdy.

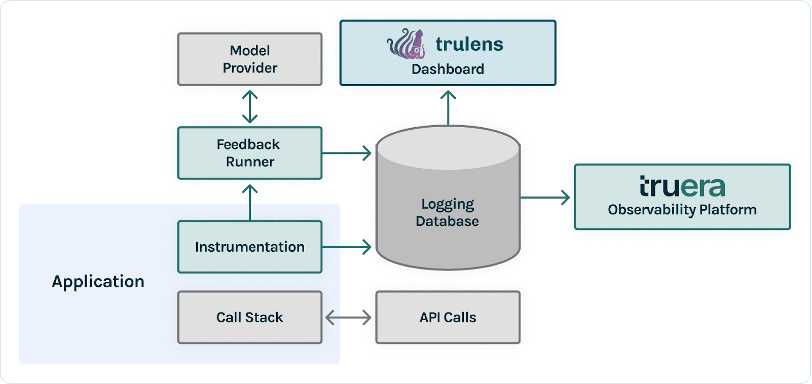

Jak działa TruLens

Po stworzeniu prototypu aplikacji LLM możesz zintegrować TruLens (pokazane wcześniej) w celu instrumentacji stosu wywołań. Po oprzyrządowaniu stosu wywołań można go następnie rejestrować przy każdym uruchomieniu w bazie danych rejestrowania znajdującej się w Twoim środowisku.

Oprócz możliwości oprzyrządowania i rejestrowania, ocena jest kluczowym elementem wartości dla użytkowników TruLens. Oceny te są implementowane w TruLens za pomocą funkcji sprzężenia zwrotnego, które działają na wierzchu stosu wywołań instrumentalnych i z kolei wzywają zewnętrznych dostawców modeli do samodzielnego tworzenia informacji zwrotnych.

Po uwzględnieniu informacji zwrotnych wyniki są zapisywane w bazie danych logowania, z której można uruchomić pulpit TruLens. Pulpit nawigacyjny TruLens działający w Twoim środowisku umożliwia eksplorację, iterację i debugowanie aplikacji LLM.

W dużej skali te dzienniki i oceny można przesyłać do TruEra obserwowalność produkcji który może przetwarzać miliony obserwacji na minutę. Korzystając z platformy obserwacyjnej TruEra, możesz szybko wykryć halucynacje i inne problemy z wydajnością, a także w ciągu kilku sekund przybliżyć się do pojedynczego rekordu dzięki zintegrowanej diagnostyce. Przejście do punktu widzenia diagnostyki pozwala łatwo zidentyfikować i złagodzić tryby awarii aplikacji LLM, takie jak halucynacje, niska jakość wyszukiwania, problemy z bezpieczeństwem i inne.

Oceniaj odpowiedzi pod kątem szczerości, nieszkodliwości i pomocy

Osiągając zadowalające oceny dla tej triady, można osiągnąć wyższy stopień pewności co do prawdziwości udzielanych przez nią odpowiedzi. Oprócz prawdomówności TruLens zapewnia szerokie wsparcie w zakresie ocen niezbędnych do zrozumienia wyników Twojego LLM na osi „Uczciwy, nieszkodliwy i pomocny”. Nasi użytkownicy odnieśli ogromne korzyści dzięki możliwości identyfikowania nie tylko halucynacji, o czym mówiliśmy wcześniej, ale także problemów z bezpieczeństwem, dopasowaniem językowym, spójnością i nie tylko. Są to wszystkie niechlujne, rzeczywiste problemy, z którymi borykają się twórcy aplikacji LLM i które można zidentyfikować od razu za pomocą TruLens.

Wnioski

W tym poście omówiono, w jaki sposób możesz przyspieszyć produkcję aplikacji AI i wykorzystać podstawowe modele w swojej organizacji. Dzięki SageMaker JumpStart, Amazon Bedrock i TruEra możesz wdrażać, dostrajać i iterować na modelach podstawowych dla aplikacji LLM. Sprawdź to link aby dowiedzieć się więcej o TruEra i wypróbować notatnik siebie.

O autorach

Josha Reiniego jest głównym współpracownikiem oprogramowania TruLens o otwartym kodzie źródłowym i założycielem naukowca ds. relacji z programistami w firmie TruEra, gdzie jest odpowiedzialny za inicjatywy edukacyjne i pielęgnowanie kwitnącej społeczności praktyków zajmujących się jakością sztucznej inteligencji.

Josha Reiniego jest głównym współpracownikiem oprogramowania TruLens o otwartym kodzie źródłowym i założycielem naukowca ds. relacji z programistami w firmie TruEra, gdzie jest odpowiedzialny za inicjatywy edukacyjne i pielęgnowanie kwitnącej społeczności praktyków zajmujących się jakością sztucznej inteligencji.

Shayak Sen jest dyrektorem technicznym i współzałożycielem TruEra. Shayak koncentruje się na budowaniu systemów i prowadzeniu badań, dzięki którym systemy uczenia maszynowego będą bardziej zrozumiałe, zgodne z prywatnością i sprawiedliwe.

Shayak Sen jest dyrektorem technicznym i współzałożycielem TruEra. Shayak koncentruje się na budowaniu systemów i prowadzeniu badań, dzięki którym systemy uczenia maszynowego będą bardziej zrozumiałe, zgodne z prywatnością i sprawiedliwe.

Anupama Datty jest współzałożycielem, prezesem i głównym naukowcem firmy TruEra. Przed TruEra spędził 15 lat na wydziale Carnegie Mellon University (2007-22), ostatnio jako profesor zwyczajny inżynierii elektrycznej i komputerowej oraz informatyki.

Anupama Datty jest współzałożycielem, prezesem i głównym naukowcem firmy TruEra. Przed TruEra spędził 15 lat na wydziale Carnegie Mellon University (2007-22), ostatnio jako profesor zwyczajny inżynierii elektrycznej i komputerowej oraz informatyki.

Vivek Gangasani jest architektem rozwiązań AI/ML Startup Solutions dla startupów generatywnej AI w AWS. Pomaga wschodzącym startupom GenAI budować innowacyjne rozwiązania wykorzystujące usługi AWS i przyspieszone obliczenia. Obecnie koncentruje się na opracowywaniu strategii dostrajania i optymalizacji wydajności wnioskowania dużych modeli językowych. W wolnym czasie Vivek lubi wędrować, oglądać filmy i próbować różnych kuchni.

Vivek Gangasani jest architektem rozwiązań AI/ML Startup Solutions dla startupów generatywnej AI w AWS. Pomaga wschodzącym startupom GenAI budować innowacyjne rozwiązania wykorzystujące usługi AWS i przyspieszone obliczenia. Obecnie koncentruje się na opracowywaniu strategii dostrajania i optymalizacji wydajności wnioskowania dużych modeli językowych. W wolnym czasie Vivek lubi wędrować, oglądać filmy i próbować różnych kuchni.

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- PlatoData.Network Pionowe generatywne AI. Wzmocnij się. Dostęp tutaj.

- PlatoAiStream. Inteligencja Web3. Wiedza wzmocniona. Dostęp tutaj.

- PlatonESG. Węgiel Czysta technologia, Energia, Środowisko, Słoneczny, Gospodarowanie odpadami. Dostęp tutaj.

- Platon Zdrowie. Inteligencja w zakresie biotechnologii i badań klinicznych. Dostęp tutaj.

- Źródło: https://aws.amazon.com/blogs/machine-learning/deploy-foundation-models-with-amazon-sagemaker-iterate-and-monitor-with-truera/

- :ma

- :Jest

- :nie

- :Gdzie

- $W GÓRĘ

- 1

- 10

- 100

- 11

- 12

- 120

- 125

- 14

- 15 roku

- 15%

- 16

- 179

- 7

- 72

- 8

- 9

- a

- zdolność

- Zdolny

- O nas

- abstrakcja

- przyśpieszyć

- przyśpieszony

- Akceptuj

- dokładny

- w poprzek

- przystosować

- adaptacja

- Dodaj

- dodatek

- adres

- Korzyść

- Po

- ponownie

- przed

- Umowa

- AI

- AI / ML

- Wszystkie kategorie

- dopuszczać

- pozwala

- wzdłuż

- również

- Chociaż

- Amazonka

- Amazon Sage Maker

- Amazon Web Services

- an

- i

- odpowiedź

- odpowiedzi

- każdy

- Pszczoła

- Aplikacja

- Zastosowanie

- aplikacje

- podejście

- odpowiednio

- mobilne i webowe

- SĄ

- AS

- zapytać

- At

- próba

- zwiększona

- zautomatyzowane

- dostępny

- AWS

- Oś

- baza

- Baseline

- BE

- bo

- stają się

- zanim

- jest

- uwierzyć

- poniżej

- korzyści

- Ulepsz Swój

- pomiędzy

- Poza

- Blog

- obie

- Pudełko

- przerwa

- awaria

- szeroki

- budować

- Budowanie

- ale

- by

- wezwanie

- nazywa

- CAN

- możliwości

- Carnegie Mellona

- nieść

- walizka

- Etui

- Kategoria

- wyzwanie

- Zmiany

- Koszyk

- szef

- wybór

- roszczenie

- klasa

- jasny

- Współzałożyciel

- kod

- kolekcja

- kolumny

- byliśmy spójni, od początku

- społeczność

- porównanie

- kompletny

- Ukończył

- ukończenia

- zgodny

- składnik

- składniki

- wszechstronny

- obliczać

- komputer

- Inżynieria komputerowa

- Computer Science

- pewność siebie

- Potwierdzać

- Podłączanie

- wynikający

- konsekwentnie

- zawiera

- kontekst

- współpracownik

- konwertować

- rdzeń

- główny współtwórca

- poprawione

- mógłby

- pokrywa

- Stwórz

- stworzony

- Tworzenie

- Kryteria

- krytyczny

- CTO

- kurator

- Obecnie

- Klientów

- tablica rozdzielcza

- dane

- naukowiec danych

- Baza danych

- Bazy danych

- zbiory danych

- głębiej

- Domyślnie

- zdefiniowane

- Stopień

- rozwijać

- wdrażane

- Wdrożenie

- opisuje

- Mimo

- szczegółowe

- wykryć

- Wykrywanie

- Deweloper

- deweloperzy

- rozwijanie

- oprogramowania

- diagnostyka

- ZROBIŁ

- różne

- kierować

- omówione

- nurkować

- robi

- domeny

- na dół

- pobieranie

- dramatycznie

- dynamicznie

- każdy

- Wcześniej

- z łatwością

- Edukacja

- efekt

- skuteczność

- eliminując

- osadzanie

- wschodzących

- Umożliwia

- zakończenia

- Punkt końcowy

- silnik

- Inżynieria

- zapewnić

- Środowisko

- szczególnie

- niezbędny

- oceniać

- oceny

- ewaluację

- oceny

- Parzyste

- dowód

- zbadać

- Badanie

- przykład

- Z wyjątkiem

- rozszerzenie

- drogi

- odkryj

- eksport

- zewnętrzny

- ekstrakcja

- Twarz

- fakty

- Brak

- sprawiedliwy

- Spadać

- fałszywy

- informacja zwrotna

- Postać

- filet

- finał

- Znajdź

- w porządku

- i terminów, a

- mieszkanie

- koncentruje

- obserwuj

- następujący

- W razie zamówieenia projektu

- Nasz formularz

- utworzony

- Naprzód

- Fundacja

- założenie

- Czwarty

- Framework

- Darmowy

- od

- funkcjonować

- Funkcje

- dalej

- Generować

- generacja

- generatywny

- generatywna sztuczna inteligencja

- daje

- Go

- ziarnisty

- wspaniały

- Ziemia

- poprowadzi

- hands-on

- Have

- he

- pomocny

- pomaga

- tutaj

- wyższy

- jego

- uczciwy

- W jaki sposób

- How To

- HTML

- http

- HTTPS

- i

- zidentyfikowane

- zidentyfikować

- identyfikacja

- if

- świetlny

- zdjęcia

- realizowane

- importować

- co ważne

- podnieść

- ulepszony

- poprawa

- in

- W innych

- Włącznie z

- Zwiększać

- wzrastający

- niezależnie

- Informacja

- Infrastruktura

- inicjatywy

- Innowacyjny

- wkład

- Wejścia

- instrukcje

- instrument

- integrować

- zintegrowany

- integracja

- połączone

- najnowszych

- Wprowadzenie

- problemy

- IT

- JEGO

- samo

- jpg

- json

- właśnie

- Klawisz

- wiedza

- Brak

- język

- duży

- Utajenie

- warstwa

- prowadzący

- nauka

- poziom

- Biblioteka

- Licencja

- życie

- Prawdopodobnie

- LIMIT

- Linia

- linie

- Lista

- Zyje

- życie

- LLM

- miejscowy

- log

- zalogowany

- zalogowaniu

- niski

- maszyna

- uczenie maszynowe

- zrobiony

- Większość

- robić

- masywnie

- Mecz

- znaczenie

- zmierzyć

- Mellon

- metoda

- metryczny

- Metryka

- miliony

- chwila

- Złagodzić

- ML

- model

- modele

- Nowoczesne technologie

- Tryby

- monitor

- monitorowanie

- jeszcze

- większość

- przeważnie

- ruch

- Kino

- przeniesienie

- musi

- Nazwa

- Natura

- Potrzebować

- potrzebne

- wymagania

- Nowości

- Następny

- noty

- notatnik

- już dziś

- wychowanie

- przedmiot

- of

- poza

- oferuje

- często

- on

- ONE

- tylko

- koncepcja

- open source

- optymalizacji

- or

- organizacja

- oryginalny

- Inne

- ludzkiej,

- na zewnątrz

- wydajność

- strona

- sparowany

- parametry

- szczególny

- szczególnie

- przechodzić

- wykonać

- jest gwarancją najlepszej jakości, które mogą dostarczyć Ci Twoje monitory,

- wykonywania

- rurociąg

- Miejsce

- Platforma

- plato

- Analiza danych Platona

- PlatoDane

- do przyjęcia

- grał

- biedny

- Popularny

- Porsche

- Post

- mocny

- przewidzieć

- prezydent

- prywatność

- problematyczny

- problemy

- wygląda tak

- Obrobiony

- produkować

- produkcji

- Produkcja

- Profesor

- programowy

- zapewniać

- pod warunkiem,

- dostawca

- dostawców

- zapewnia

- popychany

- Python

- Q & A

- jakość

- pytanie

- pytania

- szybko

- przypadkowy

- szybko

- dosięgnąć

- osiągnięcie

- Prawdziwy świat

- niedawno

- rekord

- nagranie

- dokumentacja

- relacje

- mających znaczenie

- niezawodność

- szczątki

- obsługi produkcji rolnej, która zastąpiła

- zażądać

- wymagany

- Wymaga

- Badania naukowe

- odpowiedź

- Odpowiedzi

- odpowiedzialny

- dalsze

- Efekt

- powrót

- run

- bieganie

- Bezpieczeństwo

- sagemaker

- taki sam

- Skala

- nauka

- Naukowiec

- Szukaj

- sekund

- Sektory

- bezpieczeństwo

- widzieć

- widziany

- wybierać

- wyrok

- oddzielny

- służy

- Usługi

- zestaw

- ustawienie

- kilka

- powinien

- pokazać

- pokazane

- Targi

- Prosty

- po prostu

- pojedynczy

- SIX

- Rozmiar

- So

- Rozwiązania

- Źródło

- rozpiętości

- specjalny

- spędził

- dzielić

- stos

- standard

- początek

- startup

- Startups

- Zestawienie sprzedaży

- oświadczenia

- Ewolucja krok po kroku

- Nadal

- przechowywanie

- bezpośredni

- strategie

- Struktura

- Walka

- styl

- taki

- wystarczający

- apartament

- wsparcie

- podpory

- Powierzchnia

- systemy

- dostosowane

- Zadanie

- zadania

- Techniki

- szablon

- test

- Testowanie

- XNUMX

- że

- Połączenia

- ich

- następnie

- Tam.

- Te

- one

- to

- tych

- trzy

- kwitną

- Przez

- A zatem

- czas

- do

- dzisiaj

- narzędzie

- Top

- śledzić

- Śledzenie

- tradycyjny

- Pociąg

- przeszkolony

- Trening

- ogromnie

- TRU

- prawdziwy

- Prawda

- próbować

- stara

- melodia

- strojenie

- SKRĘCAĆ

- drugiej

- ui

- zrozumieć

- zrozumienie

- uniwersytet

- na

- us

- posługiwać się

- przypadek użycia

- używany

- Użytkownik

- Użytkownicy

- za pomocą

- Cenny

- wartość

- różnorodność

- Naprawiono

- zweryfikowana

- zweryfikować

- weryfikacja

- przez

- Filmy

- Zobacz i wysłuchaj

- W

- oglądania

- Droga..

- sposoby

- we

- sieć

- usługi internetowe

- DOBRZE

- jeśli chodzi o komunikację i motywację

- który

- szerszy

- będzie

- w

- w ciągu

- słowa

- pracował

- workflow

- pracujący

- Owinięty

- napisać

- napisany

- lat

- You

- Twój

- siebie

- zefirnet

- zoom