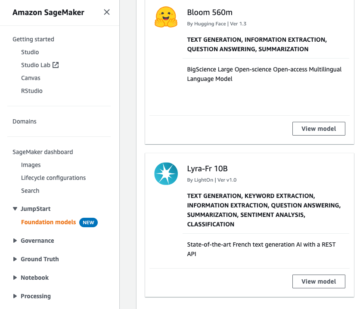

NVIDIA NIM mmikroserwisy teraz zintegruj się z Amazon Sage Maker, umożliwiając wdrażanie wiodących w branży modeli wielkojęzykowych (LLM) oraz optymalizację wydajności i kosztów modeli. Możesz wdrożyć najnowocześniejsze LLM w ciągu kilku minut zamiast dni, korzystając z technologii takich jak NVIDIA TensorRT, NVIDIA TensorRT-LLM, Serwer wnioskowania NVIDIA Triton w instancjach przyspieszanych przez firmę NVIDIA hostowanych przez SageMaker.

NIM, część Przedsiębiorstwo oparte na sztucznej inteligencji NVIDIA platforma oprogramowania wymieniona na Rynek AWS, to zestaw mikrousług wnioskowania, które wnoszą do aplikacji moc najnowocześniejszych rozwiązań LLM, zapewniając przetwarzanie języka naturalnego (NLP) i możliwości zrozumienia, niezależnie od tego, czy tworzysz chatboty, podsumowujesz dokumenty, czy wdrażasz inne rozwiązania NLP zasilane aplikacje. Możesz używać gotowych kontenerów NVIDIA do hostowania popularnych LLM zoptymalizowanych pod kątem określonych procesorów graficznych NVIDIA w celu szybkiego wdrożenia lub używać narzędzi NIM do tworzenia własnych kontenerów.

W tym poście przedstawiamy ogólne wprowadzenie do NIM i pokazujemy, jak można go używać z SageMakerem.

Wprowadzenie do NVIDIA NIM

NIM zapewnia zoptymalizowane i wstępnie wygenerowane silniki dla różnych popularnych modeli do wnioskowania. Te mikrousługi obsługują różne LLM, takie jak Llama 2 (7B, 13B i 70B), Mistral-7B-Instruct, Mixtral-8x7B, NVIDIA Nemotron-3 22B Persona i Code Llama 70B, od razu po wyjęciu z pudełka przy użyciu wstępnie zbudowaliśmy silniki NVIDIA TensorRT dostosowane do konkretnych procesorów graficznych NVIDIA w celu zapewnienia maksymalnej wydajności i wykorzystania. Modele te są dobrane przy użyciu optymalnych hiperparametrów zapewniających wydajność hostowania modeli w celu łatwego wdrażania aplikacji.

Jeśli Twojego modelu nie ma w zestawie wybranych modeli firmy NVIDIA, NIM oferuje niezbędne narzędzia, takie jak Model Repo Generator, który ułatwia tworzenie silnika akcelerowanego przez TensorRT-LLM i katalogu modeli w formacie NIM za pomocą prostego pliku YAML. Co więcej, zintegrowany backend społeczności vLLM zapewnia obsługę najnowocześniejszych modeli i nowych funkcji, które mogły nie zostać bezproblemowo zintegrowane ze stosem zoptymalizowanym pod kątem TensorRT-LLM.

Oprócz tworzenia zoptymalizowanych LLM na potrzeby wnioskowania, NIM zapewnia zaawansowane technologie hostingu, takie jak zoptymalizowane techniki planowania, takie jak przetwarzanie wsadowe w locie, które mogą rozbić ogólny proces generowania tekstu dla LLM na wiele iteracji w modelu. Dzięki przetwarzaniu wsadowemu w trakcie przetwarzania zamiast czekać na zakończenie całej partii przed przejściem do następnego zestawu żądań, środowisko wykonawcze NIM natychmiast usuwa ukończone sekwencje z partii. Następnie środowisko wykonawcze rozpoczyna uruchamianie nowych żądań, podczas gdy inne żądania są nadal realizowane, maksymalnie wykorzystując instancje obliczeniowe i procesory graficzne.

Wdrażanie NIM w SageMaker

NIM integruje się z SageMaker, umożliwiając hostowanie LLM z optymalizacją wydajności i kosztów, jednocześnie korzystając z możliwości SageMaker. Używając NIM w SageMaker, możesz korzystać z takich możliwości, jak skalowanie liczby instancji hostujących Twój model, przeprowadzanie wdrożeń niebieskich/zielonych i ocena obciążeń przy użyciu testów w tle — a wszystko to z najlepszą w swojej klasie obserwowalnością i monitorowaniem za pomocą Amazon Cloud Watch.

Wnioski

Korzystanie z NIM do wdrażania zoptymalizowanych rozwiązań LLM może być świetną opcją zarówno pod względem wydajności, jak i kosztów. Pomaga także w łatwym wdrażaniu LLM. W przyszłości NIM umożliwi także metody dostosowywania z wykorzystaniem efektywnego parametrów (PEFT), takie jak LoRA i P-tuning. NIM planuje także obsługę LLM poprzez obsługę Triton Inference Server, TensorRT-LLM i backendów vLLM.

Zachęcamy Cię do dowiedzenia się więcej o mikrousługach NVIDIA i sposobach wdrażania LLM za pomocą SageMaker oraz wypróbowania dostępnych korzyści. NIM jest dostępny jako oferta płatna w ramach subskrypcji oprogramowania NVIDIA AI Enterprise dostępne na AWS Marketplace.

W najbliższej przyszłości opublikujemy szczegółowy przewodnik po NIM w SageMaker.

O autorach

James Park jest architektem rozwiązań w Amazon Web Services. Współpracuje z Amazon.com przy projektowaniu, budowaniu i wdrażaniu rozwiązań technologicznych w AWS, a szczególnie interesuje się sztuczną inteligencją i uczeniem maszynowym. W wolnym czasie lubi poznawać nowe kultury, nowe doświadczenia i być na bieżąco z najnowszymi trendami technologicznymi. Możesz go znaleźć na LinkedIn.

James Park jest architektem rozwiązań w Amazon Web Services. Współpracuje z Amazon.com przy projektowaniu, budowaniu i wdrażaniu rozwiązań technologicznych w AWS, a szczególnie interesuje się sztuczną inteligencją i uczeniem maszynowym. W wolnym czasie lubi poznawać nowe kultury, nowe doświadczenia i być na bieżąco z najnowszymi trendami technologicznymi. Możesz go znaleźć na LinkedIn.

Saurabha Trikande jest starszym menedżerem produktu w firmie Amazon SageMaker Inference. Pasjonuje go praca z klientami i motywuje go cel, jakim jest demokratyzacja uczenia maszynowego. Koncentruje się na podstawowych wyzwaniach związanych z wdrażaniem złożonych aplikacji ML, wielodostępnych modeli ML, optymalizacji kosztów oraz zwiększaniem dostępności wdrażania modeli uczenia głębokiego. W wolnym czasie Saurabh lubi wędrować, poznawać innowacyjne technologie, śledzić TechCrunch i spędzać czas z rodziną.

Saurabha Trikande jest starszym menedżerem produktu w firmie Amazon SageMaker Inference. Pasjonuje go praca z klientami i motywuje go cel, jakim jest demokratyzacja uczenia maszynowego. Koncentruje się na podstawowych wyzwaniach związanych z wdrażaniem złożonych aplikacji ML, wielodostępnych modeli ML, optymalizacji kosztów oraz zwiększaniem dostępności wdrażania modeli uczenia głębokiego. W wolnym czasie Saurabh lubi wędrować, poznawać innowacyjne technologie, śledzić TechCrunch i spędzać czas z rodziną.

QingLan jest inżynierem rozwoju oprogramowania w AWS. Pracował nad kilkoma wymagającymi produktami w Amazon, w tym wysokowydajnymi rozwiązaniami wnioskowania ML i wysokowydajnym systemem rejestrowania. Zespół Qing z powodzeniem uruchomił pierwszy model miliarda parametrów w Amazon Advertising z wymaganym bardzo niskim opóźnieniem. Qing posiada dogłębną wiedzę na temat optymalizacji infrastruktury i akceleracji Deep Learning.

QingLan jest inżynierem rozwoju oprogramowania w AWS. Pracował nad kilkoma wymagającymi produktami w Amazon, w tym wysokowydajnymi rozwiązaniami wnioskowania ML i wysokowydajnym systemem rejestrowania. Zespół Qing z powodzeniem uruchomił pierwszy model miliarda parametrów w Amazon Advertising z wymaganym bardzo niskim opóźnieniem. Qing posiada dogłębną wiedzę na temat optymalizacji infrastruktury i akceleracji Deep Learning.

Nihil Kulkarni jest programistą w AWS Machine Learning, koncentrującym się na zwiększaniu wydajności obciążeń uczenia maszynowego w chmurze i współtwórcą kontenerów AWS Deep Learning do szkoleń i wnioskowania. Pasjonuje się rozproszonymi systemami głębokiego uczenia się. Poza pracą lubi czytać książki, bawić się na gitarze i robić pizzę.

Nihil Kulkarni jest programistą w AWS Machine Learning, koncentrującym się na zwiększaniu wydajności obciążeń uczenia maszynowego w chmurze i współtwórcą kontenerów AWS Deep Learning do szkoleń i wnioskowania. Pasjonuje się rozproszonymi systemami głębokiego uczenia się. Poza pracą lubi czytać książki, bawić się na gitarze i robić pizzę.

Harisha Tummalacherli jest inżynierem oprogramowania w zespole Deep Learning Performance w SageMaker. Pracuje nad inżynierią wydajności, aby efektywnie obsługiwać duże modele językowe w SageMaker. W wolnym czasie biega, jeździ na rowerze i uprawia narciarstwo alpejskie.

Harisha Tummalacherli jest inżynierem oprogramowania w zespole Deep Learning Performance w SageMaker. Pracuje nad inżynierią wydajności, aby efektywnie obsługiwać duże modele językowe w SageMaker. W wolnym czasie biega, jeździ na rowerze i uprawia narciarstwo alpejskie.

Eliutha Triany Isazy jest menedżerem ds. relacji z programistami w firmie NVIDIA, który umożliwia specjalistom ds. rozwiązań AI MLOps, DevOps, naukowcom i ekspertom technicznym AWS firmy Amazon w opanowaniu stosu obliczeniowego NVIDIA w celu przyspieszania i optymalizacji modeli generatywnej AI Foundation, obejmujących przechowywanie danych, szkolenie GPU, wnioskowanie o modelach i wdrażanie produkcyjne na instancjach GPU AWS . Ponadto Eliuth jest zapalonym kolarzem górskim, narciarzem, tenisistą i pokerzystą.

Eliutha Triany Isazy jest menedżerem ds. relacji z programistami w firmie NVIDIA, który umożliwia specjalistom ds. rozwiązań AI MLOps, DevOps, naukowcom i ekspertom technicznym AWS firmy Amazon w opanowaniu stosu obliczeniowego NVIDIA w celu przyspieszania i optymalizacji modeli generatywnej AI Foundation, obejmujących przechowywanie danych, szkolenie GPU, wnioskowanie o modelach i wdrażanie produkcyjne na instancjach GPU AWS . Ponadto Eliuth jest zapalonym kolarzem górskim, narciarzem, tenisistą i pokerzystą.

Jiahong Liu jest architektem rozwiązań w zespole Cloud Service Provider firmy NVIDIA. Pomaga klientom we wdrażaniu rozwiązań uczenia maszynowego i sztucznej inteligencji, które wykorzystują akcelerowane obliczenia NVIDIA, aby sprostać wyzwaniom związanym ze szkoleniem i wnioskowaniem. W wolnym czasie lubi origami, projekty DIY i grę w koszykówkę.

Jiahong Liu jest architektem rozwiązań w zespole Cloud Service Provider firmy NVIDIA. Pomaga klientom we wdrażaniu rozwiązań uczenia maszynowego i sztucznej inteligencji, które wykorzystują akcelerowane obliczenia NVIDIA, aby sprostać wyzwaniom związanym ze szkoleniem i wnioskowaniem. W wolnym czasie lubi origami, projekty DIY i grę w koszykówkę.

Kszitiz Gupta jest architektem rozwiązań w firmie NVIDIA. Lubi edukować klientów korzystających z chmury na temat technologii GPU AI, które firma NVIDIA ma do zaoferowania, i pomagać im w przyspieszaniu ich aplikacji do uczenia maszynowego i uczenia głębokiego. Poza pracą lubi biegać, wędrować i obserwować dziką przyrodę.

Kszitiz Gupta jest architektem rozwiązań w firmie NVIDIA. Lubi edukować klientów korzystających z chmury na temat technologii GPU AI, które firma NVIDIA ma do zaoferowania, i pomagać im w przyspieszaniu ich aplikacji do uczenia maszynowego i uczenia głębokiego. Poza pracą lubi biegać, wędrować i obserwować dziką przyrodę.

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- PlatoData.Network Pionowe generatywne AI. Wzmocnij się. Dostęp tutaj.

- PlatoAiStream. Inteligencja Web3. Wiedza wzmocniona. Dostęp tutaj.

- PlatonESG. Węgiel Czysta technologia, Energia, Środowisko, Słoneczny, Gospodarowanie odpadami. Dostęp tutaj.

- Platon Zdrowie. Inteligencja w zakresie biotechnologii i badań klinicznych. Dostęp tutaj.

- Źródło: https://aws.amazon.com/blogs/machine-learning/optimize-price-performance-of-llm-inference-on-nvidia-gpus-using-the-amazon-sagemaker-integration-with-nvidia-nim-microservices/

- :ma

- :Jest

- :nie

- $W GÓRĘ

- 100

- 121

- 7

- a

- O nas

- przyśpieszony

- przyspieszenie

- przyśpieszenie

- dostępny

- dodatek

- adres

- Przyjęcie

- zaawansowany

- Reklama

- AI

- dopuszczać

- Pozwalać

- również

- Amazonka

- Amazon Sage Maker

- Amazon Web Services

- Amazon.com

- an

- i

- aplikacje

- SĄ

- AS

- pomoc

- pomaga

- At

- dostępny

- AWS

- Uczenie maszynowe AWS

- Backend

- backendy

- Koszykówka

- partie

- BE

- być

- zanim

- zaczyna się

- korzystne

- Korzyści

- BEST

- Książki

- obie

- Pudełko

- przerwa

- przynieść

- budować

- by

- CAN

- możliwości

- wyzwania

- wyzwanie

- nasze chatboty

- klientów

- Chmura

- kod

- COM

- społeczność

- kompleks

- obliczać

- computing

- Pojemniki

- rdzeń

- Koszty:

- Stwórz

- Tworzenie

- tworzenie

- Hodowle

- kurator

- kuracja

- Klientów

- dostosowywanie

- pionierski nowatorski

- dane

- Data

- Dni

- głęboko

- głęboka nauka

- Demokratyzować

- rozwijać

- wdrażanie

- Wdrożenie

- wdrożenia

- Wnętrze

- Deweloper

- rozwijanie

- oprogramowania

- katalog

- dystrybuowane

- DIY

- dokumenty

- na dół

- łatwość

- edukowanie

- skutecznie

- łatwy

- wschodzących

- uprawniającej

- zachęcać

- silnik

- inżynier

- Inżynieria

- silniki

- Enterprise

- oprogramowanie firmowe

- niezbędny

- oceny

- Doświadczenia

- eksperci

- ułatwia

- członków Twojej rodziny

- Korzyści

- filet

- Znajdź

- koniec

- i terminów, a

- lot

- koncentruje

- skupienie

- następujący

- W razie zamówieenia projektu

- Fundacja

- od

- Ponadto

- przyszłość

- generacja

- generatywny

- generatywna sztuczna inteligencja

- generator

- cel

- GPU

- GPU

- wspaniały

- poprowadzi

- Have

- he

- pomaga

- Wysoki

- na wysokim szczeblu

- go

- jego

- gospodarz

- hostowane

- Hosting

- W jaki sposób

- How To

- http

- HTTPS

- natychmiast

- wykonawczych

- in

- informacje

- Włącznie z

- wiodący w branży

- Infrastruktura

- Innowacyjny

- innowacyjne technologie

- zamiast

- integrować

- zintegrowany

- Integruje się

- integracja

- odsetki

- najnowszych

- Wprowadzenie

- IT

- iteracje

- jpeg

- jpg

- wiedza

- język

- duży

- Utajenie

- firmy

- uruchomiona

- UCZYĆ SIĘ

- nauka

- Dźwignia

- lubić

- Katalogowany

- Lama

- LLM

- zalogowaniu

- niski

- maszyna

- uczenie maszynowe

- robić

- Dokonywanie

- kierownik

- mistrz

- maksymalny

- Może..

- metody

- mikroserwisy

- minut

- ML

- MLOps

- model

- modele

- monitorowanie

- jeszcze

- zmotywowani

- Góra

- przeniesienie

- wielokrotność

- Naturalny

- Przetwarzanie języka naturalnego

- Blisko

- Nowości

- Następny

- nlp

- już dziś

- numer

- Nvidia

- of

- oferta

- oferuje

- Oferty

- on

- Optymalny

- optymalizacja

- optymalizacje

- Optymalizacja

- zoptymalizowane

- optymalizacji

- Option

- or

- Inne

- na zewnątrz

- zewnętrzne

- ogólny

- własny

- płatny

- część

- szczególny

- namiętny

- jest gwarancją najlepszej jakości, które mogą dostarczyć Ci Twoje monitory,

- wykonywania

- Pizza

- plany

- Platforma

- plato

- Analiza danych Platona

- PlatoDane

- gracz

- gra

- poker

- Popularny

- Post

- power

- wygląda tak

- przetwarzanie

- Produkt

- product manager

- Produkcja

- Produkty

- projektowanie

- zapewniać

- dostawca

- zapewnia

- że

- Szybki

- raczej

- Czytający

- związane z

- relacje

- wywołań

- wymagany

- bieganie

- Czas

- sagemaker

- Wnioskowanie SageMakera

- skalowaniem

- szeregowanie

- Naukowcy

- płynnie

- poszukuje

- senior

- serwer

- usługa

- Usługodawca

- Usługi

- służąc

- zestaw

- kilka

- Shadow

- pokazać

- Tworzenie

- rozwoju oprogramowania

- Software Engineer

- rozwiązanie

- Rozwiązania

- napięcie

- specyficzny

- Spędzanie

- stos

- state-of-the-art

- przebywający

- Nadal

- bezpośredni

- subskrypcja

- Z powodzeniem

- taki

- wsparcie

- Wspierający

- system

- systemy

- dostosowane

- zespół

- TechCrunch

- Techniczny

- Techniki

- Technologies

- Technologia

- tenis

- XNUMX

- niż

- że

- Połączenia

- Przyszłość

- ich

- Im

- następnie

- Te

- to

- Przez

- czas

- do

- narzędzia

- Trening

- Trendy

- Tryton

- próbować

- zrozumienie

- posługiwać się

- za pomocą

- Użytkowe

- różnorodność

- początku.

- Czekanie

- oglądania

- we

- sieć

- usługi internetowe

- jeśli chodzi o komunikację i motywację

- czy

- który

- Podczas

- cały

- będzie

- w

- Praca

- pracujący

- działa

- jamla

- You

- Twój

- zefirnet