Uczenie maszynowe (ML) pomaga organizacjom zwiększać przychody, napędzać rozwój firmy i zmniejszać koszty poprzez optymalizację podstawowych funkcji biznesowych w wielu branżach, takich jak prognozowanie popytu, ocena kredytowa, ustalanie cen, przewidywanie rezygnacji klientów, identyfikowanie kolejnych najlepszych ofert, przewidywanie opóźnionych dostaw i poprawa jakości produkcji. Tradycyjne cykle rozwoju ML trwają miesiące i wymagają niewielkich umiejętności w zakresie nauki o danych i inżynierii ML. Pomysły analityków dotyczące modeli ML często tkwią w długich zaległościach w oczekiwaniu na przepustowość zespołu zajmującego się badaniem danych, podczas gdy naukowcy zajmujący się danymi koncentrują się na bardziej złożonych projektach ML, wymagających pełnego zestawu umiejętności.

Aby pomóc przełamać ten impas, mamy: wprowadzono Amazon SageMaker Canvas, rozwiązanie ML bez kodu, które może pomóc firmom przyspieszyć dostarczanie rozwiązań ML do kilku godzin lub dni. SageMaker Canvas umożliwia analitykom łatwe korzystanie z danych dostępnych w jeziorach danych, hurtowniach danych i magazynach danych operacyjnych; budować modele ML; i używać ich do interaktywnego tworzenia prognoz i oceniania zbiorczego zbiorczych zestawów danych — a wszystko to bez pisania ani jednego wiersza kodu.

W tym poście pokazujemy, w jaki sposób SageMaker Canvas umożliwia współpracę między analitykami danych i analitykami biznesowymi, osiągając szybszy czas wprowadzania produktów na rynek i przyspieszając rozwój rozwiązań ML. Analitycy uzyskują własny obszar roboczy ML bez kodu w SageMaker Canvas, bez konieczności zostania ekspertem ML. Analitycy mogą następnie kilkoma kliknięciami udostępniać swoje modele z Canvas, z którymi analitycy danych będą mogli pracować w Studio Amazon SageMaker, kompleksowe zintegrowane środowisko programistyczne (IDE) ML. Współpracując, analitycy biznesowi mogą wnieść swoją wiedzę domenową i wyniki eksperymentów, podczas gdy analitycy danych mogą skutecznie tworzyć potoki i usprawniać proces.

Przyjrzyjmy się dokładniej, jak wyglądałby przepływ pracy.

Analitycy biznesowi budują model, a następnie go udostępniają

Aby zrozumieć, w jaki sposób SageMaker Canvas upraszcza współpracę między analitykami biznesowymi a analitykami danych (lub inżynierami ML), najpierw podchodzimy do tego procesu jako analityk biznesowy. Zanim zaczniesz, zapoznaj się z Przedstawiamy Amazon SageMaker Canvas — wizualną możliwość uczenia maszynowego bez kodu dla analityków biznesowych aby uzyskać instrukcje dotyczące budowania i testowania modelu za pomocą SageMaker Canvas.

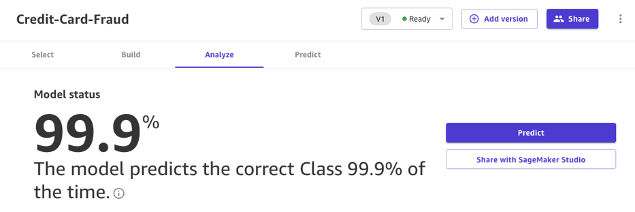

W tym poście używamy zmodyfikowanej wersji Zbiór danych wykrywania oszustw kart kredytowych z Kaggle, dobrze znanego zbioru danych dla problemu klasyfikacji binarnej. Zbiór danych jest pierwotnie wysoce niezrównoważony — zawiera bardzo niewiele wpisów sklasyfikowanych jako klasa ujemna (transakcje anomalne). Bez względu na docelową dystrybucję funkcji, nadal możemy używać tego zestawu danych, ponieważ SageMaker Canvas radzi sobie z tym brakiem równowagi podczas automatycznego uczenia i dostrajania modelu. Ten zbiór danych składa się z około 9 milionów komórek. Możesz również pobrać zmniejszona wersja tego zbioru danych. Rozmiar zestawu danych jest znacznie mniejszy i wynosi około 500,000 0 komórek, ponieważ został losowo podpróbkowany, a następnie nadpróbkowany za pomocą techniki SMOTE, aby zapewnić utratę jak najmniejszej ilości informacji podczas tego procesu. Przeprowadzenie całego eksperymentu z tym zredukowanym zestawem danych kosztuje XNUMX USD w ramach bezpłatnej warstwy SageMaker Canvas.

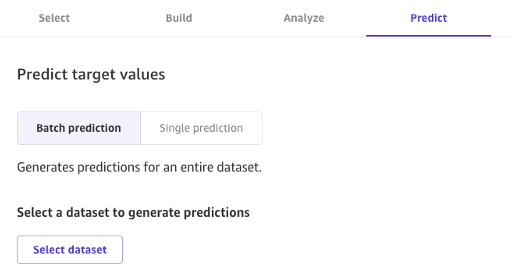

Po zbudowaniu modelu analitycy mogą używać go do tworzenia prognoz bezpośrednio w kanwie dla poszczególnych żądań lub zbiorczo dla całego wejściowego zestawu danych.

Modele zbudowane za pomocą Canvas Standard Build można również łatwo udostępniać jednym kliknięciem naukowcom danych i inżynierom ML, którzy korzystają z SageMaker Studio. Pozwala to naukowcom zajmującym się danymi na sprawdzenie wydajności zbudowanego modelu i przekazanie informacji zwrotnych. Inżynierowie ML mogą wybrać Twój model i zintegrować go z istniejącymi przepływami pracy i produktami dostępnymi dla Twojej firmy i klientów. Pamiętaj, że w chwili pisania tego tekstu nie jest możliwe udostępnianie modelu utworzonego za pomocą szybkiej kompilacji Canvas ani modelu prognozowania szeregów czasowych.

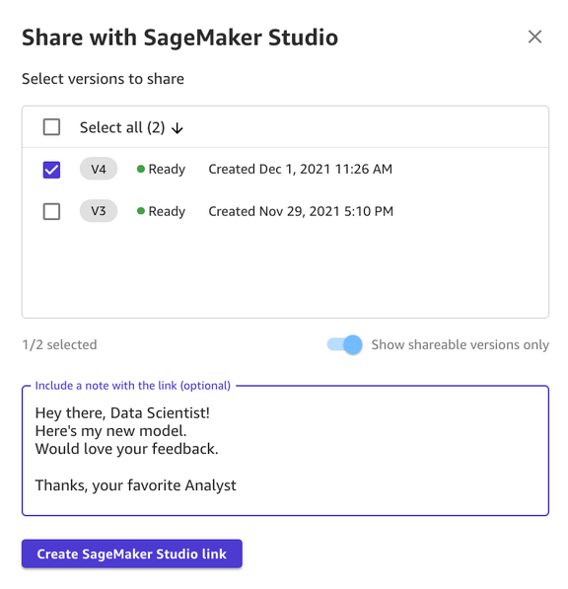

Udostępnianie modelu za pośrednictwem interfejsu użytkownika Canvas jest proste:

- Na stronie przedstawiającej modele, które utworzyłeś, wybierz model.

- Dodaj Share.

- Wybierz jedną lub więcej wersji modelu, które chcesz udostępnić.

- Opcjonalnie dołącz notatkę zawierającą więcej kontekstu na temat modelu lub pomocy, której szukasz.

- Dodaj Utwórz łącze do SageMaker Studio.

- Skopiuj wygenerowany link.

I to wszystko! Możesz teraz udostępnić łącze swoim współpracownikom za pośrednictwem Slacka, poczty e-mail lub dowolnej innej preferowanej metody. Analityk danych musi znajdować się w tej samej domenie SageMaker Studio, aby uzyskać dostęp do Twojego modelu, więc upewnij się, że tak jest w przypadku administratora Twojej organizacji.

Analitycy danych uzyskują dostęp do informacji o modelu z SageMaker Studio

Teraz wcielmy się w rolę naukowca danych lub inżyniera ML i zobaczmy rzeczy z ich punktu widzenia za pomocą SageMaker Studio.

Łącze udostępnione przez analityka prowadzi nas do SageMaker Studio, pierwszego IDE opartego na chmurze dla kompleksowego przepływu pracy ML.

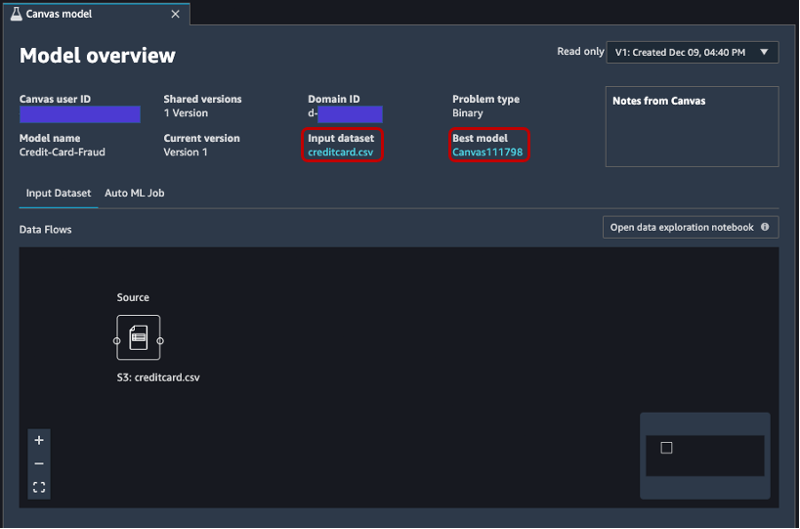

Karta otwiera się automatycznie i pokazuje przegląd modelu stworzonego przez analityka w SageMaker Canvas. Możesz szybko zobaczyć nazwę modelu, typ problemu ML, wersję modelu oraz użytkownika, który utworzył model (w polu Identyfikator użytkownika kanwy). Masz również dostęp do szczegółowych informacji o wejściowym zestawie danych i najlepszym modelu, który SageMaker był w stanie wyprodukować. Zagłębimy się w to później w poście.

Na Wejściowy zbiór danych można również zobaczyć przepływ danych ze źródła do zestawu danych wejściowych. W takim przypadku używane jest tylko jedno źródło danych i nie zastosowano żadnych operacji łączenia, więc wyświetlane jest jedno źródło. Możesz analizować statystyki i szczegóły dotyczące zbioru danych, wybierając Otwórz notatnik do eksploracji danych. Ten notatnik umożliwia eksplorowanie danych, które były dostępne przed trenowaniem modelu, i zawiera analizę zmiennej docelowej, próbkę danych wejściowych, statystyki i opisy kolumn i wierszy, a także inne przydatne informacje dla naukowców zajmujących się danymi. dowiedz się więcej o zbiorze danych. Aby dowiedzieć się więcej o tym raporcie, zapoznaj się z Raport z eksploracji danych.

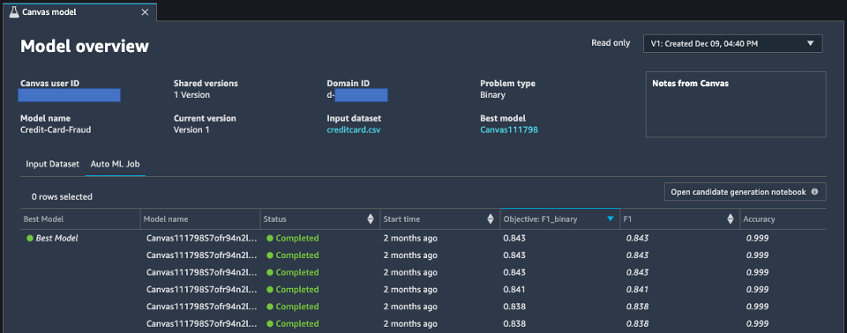

Po przeanalizowaniu wejściowego zbioru danych przejdźmy do drugiej zakładki przeglądu modelu, Zadanie AutoML. Ta karta zawiera opis zadania AutoML po wybraniu opcji Standardowa kompilacja w programie SageMaker Canvas.

Technologia AutoML pod SageMaker Canvas eliminuje podnoszenie ciężarów budynków modeli ML. Automatycznie buduje, szkoli i dostraja najlepszy model ML na podstawie Twoich danych, stosując zautomatyzowane podejście, jednocześnie pozwalając zachować pełną kontrolę i widoczność. Ta widoczność wygenerowanych modeli kandydujących, a także hiperparametrów używanych podczas procesu AutoML jest zawarta w notatnik generacji kandydatów, który jest dostępny na tej karcie.

Połączenia Zadanie AutoML zawiera również listę wszystkich modeli zbudowanych w ramach procesu AutoML, posortowanych według metryki celu F1. Aby wyróżnić najlepszy model spośród uruchomionych zadań szkoleniowych, w Najlepszy model kolumna. Możesz także łatwo zwizualizować inne metryki używane w fazie szkolenia i oceny, takie jak wynik dokładności i obszar pod krzywą (AUC). Aby dowiedzieć się więcej o modelach, które można trenować podczas zadania AutoML oraz metrykach używanych do oceny wydajności trenowanego modelu, zapoznaj się z Obsługa modeli, metryki i walidacja.

Aby dowiedzieć się więcej o modelu, możesz teraz kliknąć prawym przyciskiem myszy najlepszy model i wybrać Otwórz w szczegółach modelu. Alternatywnie możesz wybrać Najlepszy model link na górze Przegląd modeli sekcja, którą odwiedziłeś po raz pierwszy.

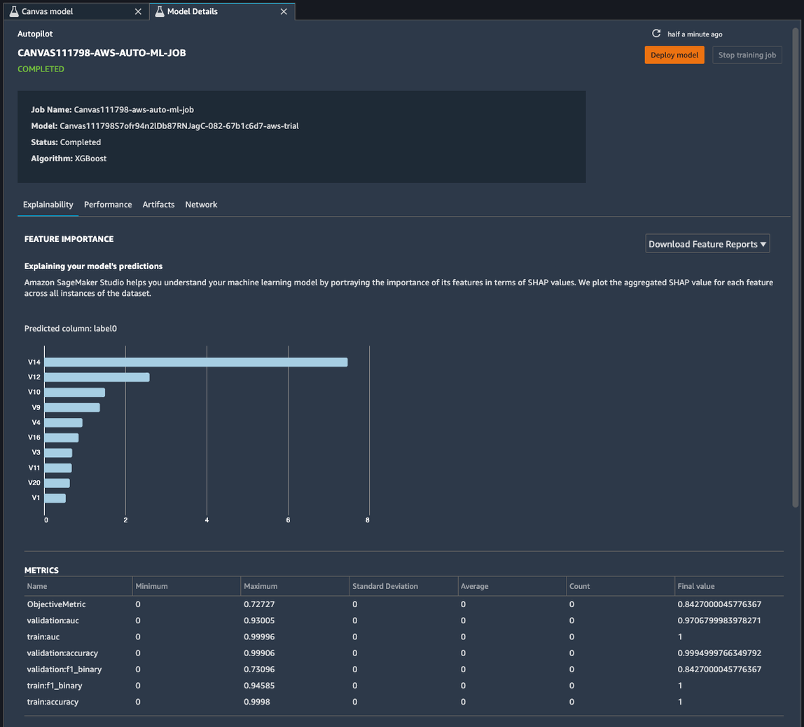

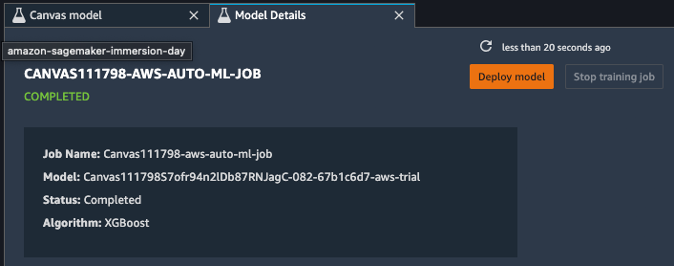

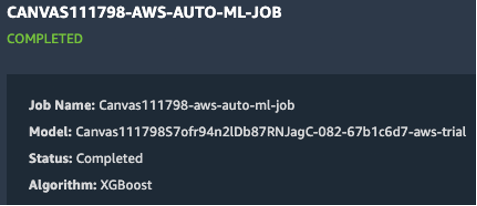

Strona szczegółów modelu zawiera mnóstwo przydatnych informacji dotyczących modelu, który działał najlepiej z tymi danymi wejściowymi. Skupmy się najpierw na podsumowaniu u góry strony. Powyższy przykładowy zrzut ekranu pokazuje, że spośród setek uruchomień uczenia modelu model XGBoost działał najlepiej w wejściowym zestawie danych. W chwili pisania tego tekstu SageMaker Canvas może trenować trzy typy algorytmów ML: liniowy uczący się, XGBoost i wielowarstwowy perceptron (MLP), każdy z szeroką gamą potoków przetwarzania wstępnego i hiperparametrów. Aby dowiedzieć się więcej o każdym algorytmie, zobacz strona obsługiwanych algorytmów.

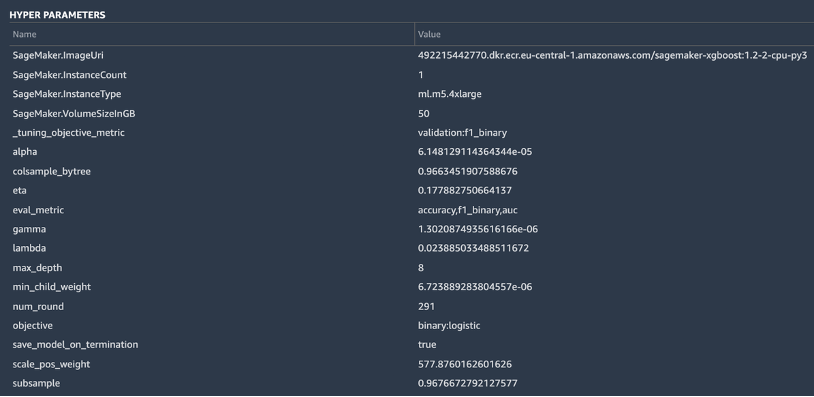

SageMaker zawiera również objaśniającą funkcjonalność dzięki skalowalnej i wydajnej implementacji JądroSHAP, w oparciu o koncepcję wartości Shapleya z dziedziny teorii gier kooperacyjnych, która przypisuje każdej funkcji wartość ważności dla określonej prognozy. Pozwala to na przejrzystość sposobu, w jaki model doszedł do swoich prognoz, i bardzo przydatne jest zdefiniowanie ważności funkcji. Pełny raport wyjaśniający, w tym znaczenie funkcji, można pobrać w formacie PDF, notatnika lub surowych danych. W raporcie tym wyświetlany jest szerszy zestaw metryk, a także pełna lista hiperparametrów używanych podczas zadania AutoML. Aby dowiedzieć się więcej o tym, jak SageMaker zapewnia zintegrowane narzędzia wyjaśniające dla rozwiązań AutoML i standardowych algorytmów ML, zobacz Korzystaj ze zintegrowanych narzędzi wyjaśniających i popraw jakość modelu za pomocą Amazon SageMaker Autopilot.

Na koniec, inne zakładki w tym widoku pokazują informacje o szczegółach wydajności (matryca pomyłek, krzywa przywracania precyzji, krzywa ROC), artefakty użyte do danych wejściowych i wygenerowane podczas zadania AutoML oraz szczegóły sieci.

W tym momencie specjalista ds. danych ma dwie możliwości: bezpośrednio wdrożyć model lub utworzyć potok szkolenia, który można zaplanować lub wyzwolić ręcznie lub automatycznie. Poniższe sekcje zawierają wgląd w obie opcje.

Wdróż model bezpośrednio

Jeśli analityk danych jest zadowolony z wyników uzyskanych w ramach zadania AutoML, może bezpośrednio wdrożyć model z Szczegóły modelu strona. To tak proste, jak wybór Wdróż model obok nazwy modelu.

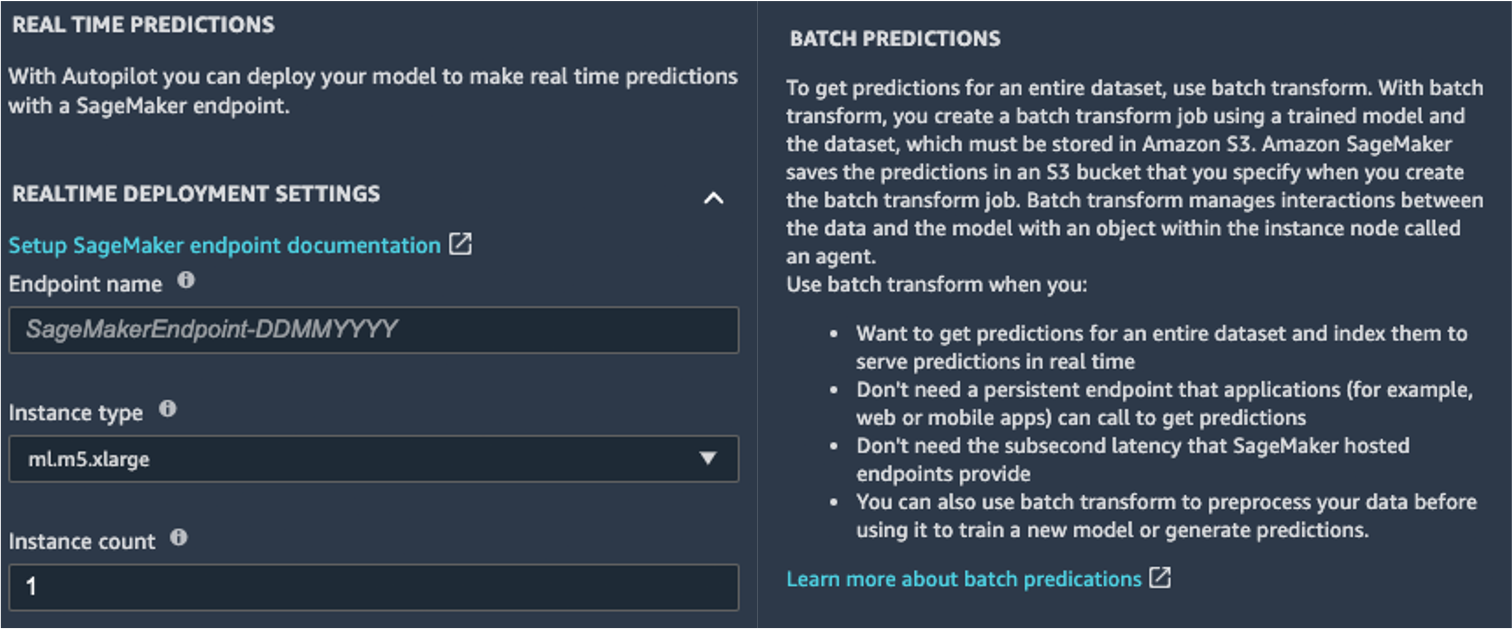

SageMaker pokazuje dwie opcje wdrożenia: punkt końcowy w czasie rzeczywistym, zasilany przez Punkty końcowe Amazon SageMakeri wnioskowanie wsadowe, obsługiwane przez Transformacja wsadowa Amazon SageMaker.

SageMaker zapewnia również inne sposoby wnioskowania. Aby dowiedzieć się więcej, zobacz Wdrażaj modele do wnioskowania.

Aby włączyć tryb przewidywania w czasie rzeczywistym, po prostu nadaj punktowi końcowemu nazwę, typ instancji i liczbę instancji. Ponieważ ten model nie wymaga dużych zasobów obliczeniowych, możesz użyć instancji opartej na procesorze CPU z początkową liczbą 1. Więcej informacji o różnych rodzajach dostępnych instancji i ich specyfikacjach znajdziesz na stronie Strona cenowa Amazon SageMaker (w Ceny na żądanie wybierz sekcję Wnioskowanie w czasie rzeczywistym patka). Jeśli nie wiesz, którą instancję wybrać dla swojego wdrożenia, możesz również poprosić SageMaker o znalezienie najlepszego dla Ciebie zgodnie z Twoimi KPI, korzystając z Polecający wnioskowanie SageMaker. Możesz również podać dodatkowe parametry opcjonalne, dotyczące tego, czy chcesz przechwytywać dane żądań i odpowiedzi do lub z punktu końcowego. Może się to przydać, jeśli planujesz dalej monitorowanie twojego modelu. Możesz także wybrać zawartość, którą chcesz dostarczyć jako część odpowiedzi — czy jest to tylko przewidywanie, czy prawdopodobieństwo przewidywania, prawdopodobieństwo wszystkich klas i etykiety docelowe.

Aby uruchomić zadanie oceniania wsadowego, uzyskując jednocześnie prognozy dla całego zestawu danych wejściowych, możesz uruchomić zadanie transformacji wsadowej z poziomu Konsola zarządzania AWS lub za pośrednictwem pakietu SDK SageMaker Python. Aby dowiedzieć się więcej o transformacji wsadowej, zobacz Użyj transformacji wsadowej i przykładowe zeszyty.

Zdefiniuj potok treningowy

Modele ML bardzo rzadko, jeśli w ogóle, mogą być uważane za statyczne i niezmienne, ponieważ odbiegają od punktu odniesienia, na którym zostały przeszkolone. Dane ze świata rzeczywistego ewoluują w czasie i wyłania się z nich więcej wzorców i spostrzeżeń, które mogą, ale nie muszą, zostać przechwycone przez oryginalny model wyszkolony na danych historycznych. Aby rozwiązać ten problem, możesz skonfigurować potok uczenia, który automatycznie przeszkoli Twoje modele przy użyciu najnowszych dostępnych danych.

Podczas definiowania tego potoku jedną z opcji naukowca danych jest ponowne użycie AutoML dla potoku szkoleniowego. Możesz uruchomić zadanie AutoML programowo, wywołując funkcję API create_auto_ml_job() z poziomu SDK AWS Boto3. Możesz wywołać tę operację z AWS Lambda funkcjonować w ramach Funkcje kroków AWS przepływ pracy lub z LambdaStep w Rurociągi Amazon SageMaker.

Alternatywnie badacz danych może wykorzystać wiedzę, artefakty i hiperparametry uzyskane z zadania AutoML do zdefiniowania pełnego potoku szkoleniowego. Potrzebujesz następujących zasobów:

- Algorytm, który najlepiej sprawdził się w przypadku użycia – Uzyskałeś już te informacje z podsumowania modelu wygenerowanego na płótnie. W tym przypadku użycia jest to wbudowany algorytm XGBoost. Aby uzyskać instrukcje dotyczące używania pakietu SageMaker Python SDK do uczenia algorytmu XGBoost za pomocą programu SageMaker, zobacz Użyj XGBoost z pakietem SDK SageMaker Python.

- Hiperparametry uzyskane przez zadanie AutoML – Są one dostępne w Wyjaśnialność Sekcja. Możesz ich użyć jako danych wejściowych podczas definiowania zadania szkoleniowego za pomocą SDK SageMaker Python.

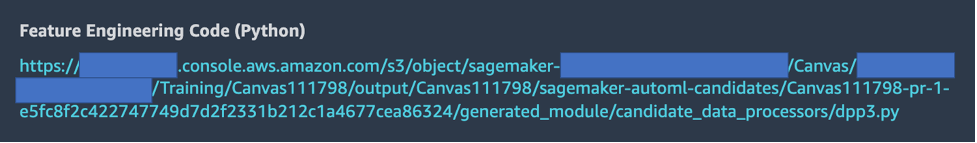

- Kod inżynierii funkcji podany w sekcji Artefakty – Możesz użyć tego kodu zarówno do wstępnego przetwarzania danych przed trenowaniem (na przykład przez przetwarzanie Amazon SageMaker), jak i przed wnioskowaniem (na przykład jako część potoku wnioskowania SageMaker).

Możesz połączyć te zasoby w ramach potoku SageMaker. Pomijamy szczegóły implementacji w tym poście — bądź na bieżąco z kolejnymi treściami dotyczącymi tego tematu.

Wnioski

SageMaker Canvas pozwala używać ML do generowania prognoz bez konieczności pisania kodu. Analityk biznesowy może samodzielnie zacząć używać go z lokalnymi zbiorami danych, a także z danymi już przechowywanymi Usługa Amazon Simple Storage (Amazonka S3), Amazonka Przesunięcie ku czerwienilub płatek śniegu. Wystarczy kilka kliknięć, aby przygotować i połączyć swoje zestawy danych, przeanalizować szacowaną dokładność, zweryfikować, które kolumny mają wpływ, wytrenować model o najwyższej wydajności i wygenerować nowe indywidualne lub wsadowe prognozy, a wszystko to bez konieczności korzystania z ekspertów zajmujących się danymi. Następnie, w razie potrzeby, mogą udostępnić model zespołowi analityków danych lub inżynierom MLOps, którzy importują modele do SageMaker Studio i współpracują z analitykiem, aby dostarczyć rozwiązanie produkcyjne.

Analitycy biznesowi mogą niezależnie uzyskiwać wgląd w swoje dane bez dyplomu z ML i bez konieczności pisania nawet jednej linijki kodu. Analitycy danych mogą teraz mieć dodatkowy czas na pracę nad trudniejszymi projektami, które mogą lepiej wykorzystać ich rozległą wiedzę na temat sztucznej inteligencji i uczenia maszynowego.

Wierzymy, że ta nowa współpraca otwiera drzwi do budowania wielu potężniejszych rozwiązań ML dla Twojej firmy. Masz teraz analityków, którzy dostarczają cenne informacje biznesowe, a jednocześnie pozwalasz analitykom danych i inżynierom ML na udoskonalanie, dostrajanie i rozszerzanie zgodnie z potrzebami.

Dodatkowe zasoby

- Aby dowiedzieć się więcej o tym, jak SageMaker może jeszcze bardziej pomóc analitykom biznesowym, zobacz Amazon SageMaker dla analityków biznesowych.

- Aby dowiedzieć się więcej o tym, jak SageMaker umożliwia analitykom danych opracowywanie, szkolenie i wdrażanie ich modeli ML, sprawdź Amazon SageMaker dla naukowców zajmujących się danymi.

- Aby uzyskać więcej informacji o tym, jak SageMaker może pomóc inżynierom MLOps w usprawnieniu cyklu życia ML za pomocą MLOps, zobacz Amazon SageMaker dla inżynierów MLOps.

O autorach

Davide Gallitelli jest Specjalistą Architektem Rozwiązań dla AI/ML w regionie EMEA. Ma siedzibę w Brukseli i ściśle współpracuje z klientami w krajach Beneluksu. Jest programistą od najmłodszych lat, zaczął kodować w wieku 7 lat. Zaczął uczyć się AI/ML na uniwersytecie i od tego czasu się w nim zakochał.

Davide Gallitelli jest Specjalistą Architektem Rozwiązań dla AI/ML w regionie EMEA. Ma siedzibę w Brukseli i ściśle współpracuje z klientami w krajach Beneluksu. Jest programistą od najmłodszych lat, zaczął kodować w wieku 7 lat. Zaczął uczyć się AI/ML na uniwersytecie i od tego czasu się w nim zakochał.

Marka Roya jest głównym architektem uczenia maszynowego dla AWS, pomagając klientom projektować i budować rozwiązania AI / ML. Praca Marka obejmuje szeroki zakres przypadków użycia ML, z głównym zainteresowaniem widzeniem komputerowym, głębokim uczeniem się i skalowaniem ML w całym przedsiębiorstwie. Pomagał firmom z wielu branż, w tym ubezpieczeń, usług finansowych, mediów i rozrywki, opieki zdrowotnej, usług komunalnych i produkcji. Mark posiada sześć certyfikatów AWS, w tym ML Specialty Certification. Przed dołączeniem do AWS Mark był architektem, programistą i liderem technologicznym przez ponad 25 lat, w tym 19 lat w usługach finansowych.

Marka Roya jest głównym architektem uczenia maszynowego dla AWS, pomagając klientom projektować i budować rozwiązania AI / ML. Praca Marka obejmuje szeroki zakres przypadków użycia ML, z głównym zainteresowaniem widzeniem komputerowym, głębokim uczeniem się i skalowaniem ML w całym przedsiębiorstwie. Pomagał firmom z wielu branż, w tym ubezpieczeń, usług finansowych, mediów i rozrywki, opieki zdrowotnej, usług komunalnych i produkcji. Mark posiada sześć certyfikatów AWS, w tym ML Specialty Certification. Przed dołączeniem do AWS Mark był architektem, programistą i liderem technologicznym przez ponad 25 lat, w tym 19 lat w usługach finansowych.

- Coinsmart. Najlepsza w Europie giełda bitcoinów i kryptowalut.

- Platoblockchain. Web3 Inteligencja Metaverse. Wzmocniona wiedza. DARMOWY DOSTĘP.

- CryptoJastrząb. Radar Altcoin. Bezpłatna wersja próbna.

- Źródło: https://aws.amazon.com/blogs/machine-learning/build-share-deploy-how-business-analysts-and-data-scientists-achieve-faster-time-to-market-using-no- kod-ml-i-amazon-sagemaker-canvas/

- "

- 000

- 100

- 7

- 9

- O nas

- przyśpieszyć

- przyspieszenie

- dostęp

- Stosownie

- w poprzek

- Dodatkowy

- Admin

- AI

- algorytm

- Algorytmy

- Wszystkie kategorie

- Pozwalać

- już

- Amazonka

- analiza

- analityk

- api

- podejście

- POWIERZCHNIA

- na około

- zautomatyzowane

- dostępny

- AWS

- Baseline

- stają się

- BEST

- granica

- Bruksela

- budować

- Budowanie

- Buduje

- wbudowany

- biznes

- wezwanie

- Etui

- Certyfikacja

- wybory

- Okrągłe

- klasyfikacja

- kod

- współpraca

- Kolumna

- przyjście

- Firmy

- sukcesy firma

- kompleks

- obliczać

- pojęcie

- zamieszanie

- zawiera

- zawartość

- kontrola

- spółdzielnia

- rdzeń

- Koszty:

- kredyt

- krzywa

- Klientów

- dane

- nauka danych

- naukowiec danych

- dostawa

- Kreowanie

- rozwijać

- Wdrożenie

- Wnętrze

- Wykrywanie

- rozwijać

- Deweloper

- oprogramowania

- różne

- 分配

- Nie

- domena

- na dół

- z łatwością

- wydajny

- Punkt końcowy

- inżynier

- Inżynieria

- Inżynierowie

- Enterprise

- rozrywka

- Środowisko

- szacunkowa

- przykład

- eksperyment

- eksploracja

- rozciągać się

- szybciej

- Cecha

- informacja zwrotna

- budżetowy

- usługi finansowe

- i terminów, a

- pływ

- Skupiać

- następujący

- format

- oszustwo

- Darmowy

- pełny

- funkcjonować

- Funkcjonalność

- gra

- Generować

- miejsce

- Dający

- Zielony

- Wzrost

- mający

- opieki zdrowotnej

- pomoc

- pomaga

- Atrakcja

- wysoko

- historyczny

- posiada

- W jaki sposób

- How To

- HTTPS

- Setki

- znaczenie

- podnieść

- zawierać

- Włącznie z

- Zwiększać

- indywidualny

- przemysłowa

- Informacja

- spostrzeżenia

- ubezpieczenie

- integrować

- zintegrowany

- odsetki

- IT

- Praca

- Oferty pracy

- przystąpić

- wiedza

- Etykiety

- firmy

- uruchomić

- UCZYĆ SIĘ

- nauka

- Linia

- LINK

- Lista

- mało

- miejscowy

- długo

- poszukuje

- miłość

- maszyna

- uczenie maszynowe

- i konserwacjami

- ręcznie

- produkcja

- znak

- rynek

- Matrix

- Media

- Metryka

- milion

- ML

- model

- modele

- miesięcy

- ruch

- sieć

- notatnik

- Oferty

- otwiera

- operacje

- Option

- Opcje

- zamówienie

- organizacja

- organizacji

- Inne

- jest gwarancją najlepszej jakości, które mogą dostarczyć Ci Twoje monitory,

- spektakle

- faza

- planowanie

- Grać

- Punkt widzenia

- możliwy

- mocny

- przepowiednia

- Przewidywania

- wycena

- pierwotny

- Główny

- Problem

- wygląda tak

- produkować

- Produkcja

- Produkty

- projektowanie

- zapewniać

- zapewnia

- ciągnięcie

- jakość

- szybko

- zasięg

- Surowy

- w czasie rzeczywistym

- zmniejszyć

- raport

- wymagać

- Zasoby

- odpowiedź

- Efekt

- dochód

- run

- bieganie

- skalowalny

- skalowaniem

- nauka

- Naukowiec

- Naukowcy

- Sdk

- wybrany

- Serie

- Usługi

- zestaw

- Share

- shared

- Prosty

- SIX

- Rozmiar

- umiejętności

- luźny

- So

- Rozwiązania

- ROZWIĄZANIA

- początek

- rozpoczęty

- statystyka

- przechowywanie

- sklep

- studio

- wsparcie

- cel

- zespół

- Technologia

- Testowanie

- Źródło

- poprzez

- czas

- razem

- narzędzia

- Top

- tradycyjny

- Trening

- pociągi

- transakcje

- Przekształcać

- Przezroczystość

- ui

- zrozumieć

- uniwersytet

- us

- posługiwać się

- wartość

- Zobacz i wysłuchaj

- widoczność

- wizja

- Co

- czy

- KIM

- w ciągu

- bez

- Praca

- pracował

- pracujący

- działa

- pisanie

- lat