Dziś z radością ogłaszamy, że modele fundamentów Llama 2 opracowane przez Meta są dostępne dla klientów za pośrednictwem Amazon SageMaker JumpStart. Rodzina dużych modeli językowych (LLM) Llama 2 to zbiór wstępnie wytrenowanych i precyzyjnie dostrojonych generatywnych modeli tekstowych o skali od 7 miliardów do 70 miliardów parametrów. Dopracowane LLM, zwane Llama-2-chat, są zoptymalizowane pod kątem zastosowań dialogowych. Możesz łatwo wypróbować te modele i używać ich w SageMaker JumpStart, będącym centrum uczenia maszynowego (ML), które zapewnia dostęp do algorytmów, modeli i rozwiązań ML, dzięki czemu możesz szybko rozpocząć korzystanie z ML.

W tym poście opisujemy, jak używać modeli Llama 2 za pośrednictwem SageMaker JumpStart.

Co to jest Lama 2

Lama 2 to model języka autoregresyjnego, który wykorzystuje zoptymalizowaną architekturę transformatora. Lama 2 jest przeznaczona do użytku komercyjnego i badawczego w języku angielskim. Jest dostępny w różnych rozmiarach parametrów — 7 miliardów, 13 miliardów i 70 miliardów — a także w wstępnie wytrenowanych i precyzyjnie dostrojonych odmianach. Według Meta dostrojone wersje wykorzystują nadzorowane dostrajanie (SFT) i uczenie się przez wzmacnianie na podstawie informacji zwrotnej od człowieka (RLHF), aby dostosować się do ludzkich preferencji pod względem przydatności i bezpieczeństwa. Llama 2 została wstępnie przeszkolona na 2 bilionach tokenów danych z publicznie dostępnych źródeł. Dostrojone modele są przeznaczone do czatu przypominającego asystenta, natomiast wstępnie wyszkolone modele można dostosować do różnych zadań związanych z generowaniem języka naturalnego. Niezależnie od tego, z której wersji modelu korzysta programista, plik przewodnik odpowiedzialnego użytkowania firmy Meta może pomóc w dodatkowym dostrojeniu, które może być konieczne w celu dostosowania i optymalizacji modeli przy zastosowaniu odpowiednich środków ograniczających bezpieczeństwo.

Co to jest SageMaker JumpStart

Dzięki SageMaker JumpStart praktycy ML mogą wybierać spośród szerokiej gamy podstawowych modeli open source. Praktycy ML mogą wdrażać modele podstawowe w dedykowanych Amazon Sage Maker instancje z izolowanego środowiska sieciowego i dostosowywać modele za pomocą SageMaker do trenowania i wdrażania modeli.

Możesz teraz odkryć i wdrożyć Lamę 2 za pomocą kilku kliknięć Studio Amazon SageMaker lub programowo za pośrednictwem pakietu SageMaker Python SDK, co pozwala uzyskać wydajność modelu i elementy sterujące MLOps za pomocą funkcji SageMaker, takich jak Rurociągi Amazon SageMaker, Debuger Amazon SageMakerlub dzienniki kontenerów. Model jest wdrażany w bezpiecznym środowisku AWS i pod kontrolą VPC, co pomaga zapewnić bezpieczeństwo danych. Modele Llama 2 są już dostępne w Amazon SageMaker Studio, początkowo w us-east 1 i us-west 2 regionów.

Odkryj modele

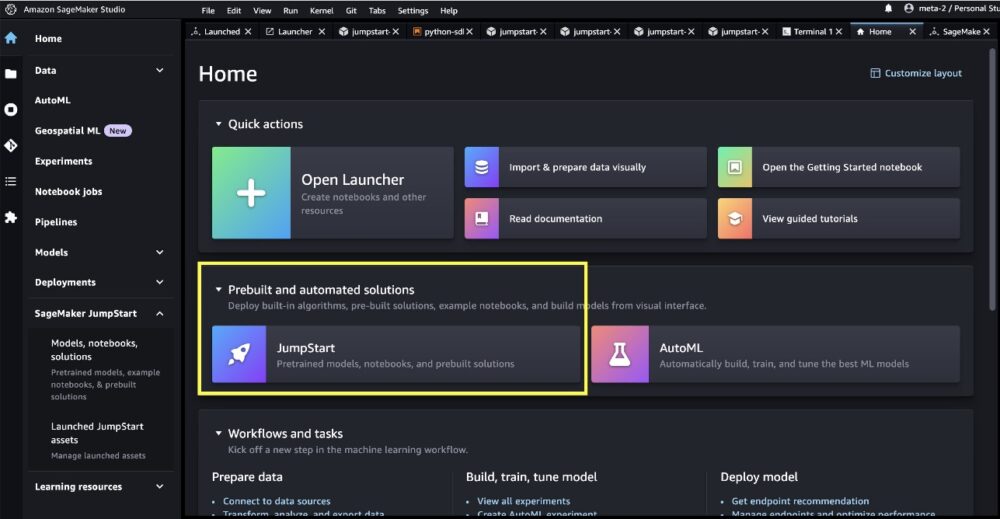

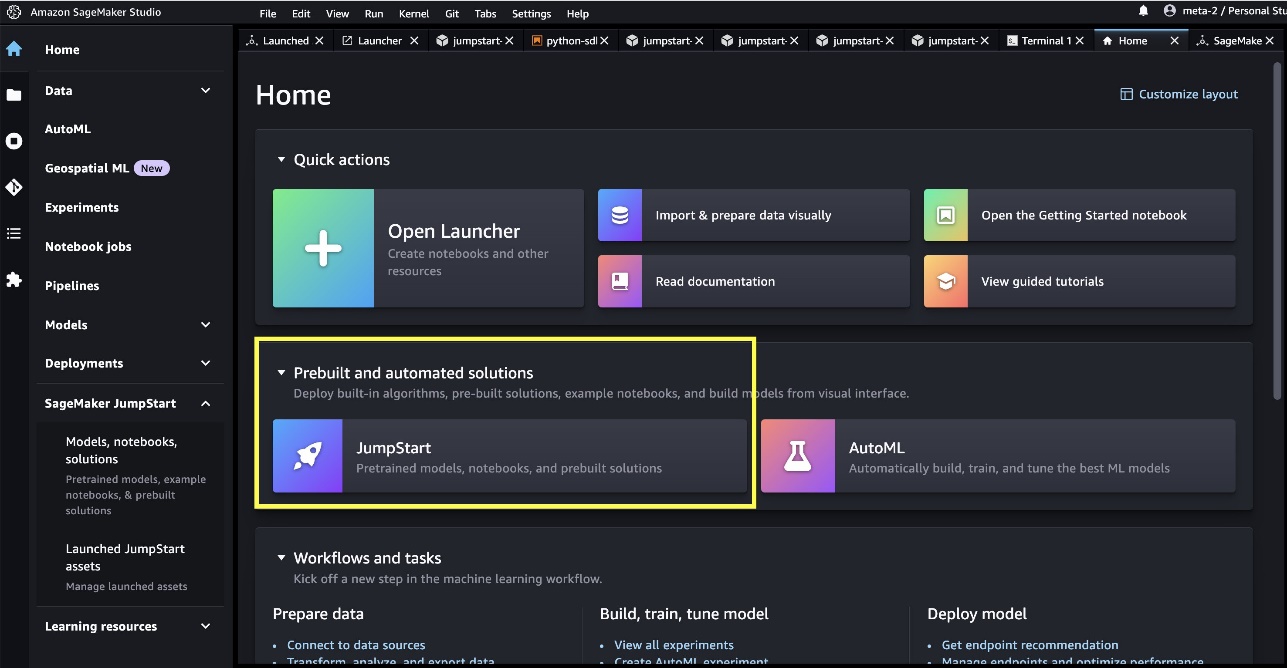

Dostęp do podstawowych modeli można uzyskać poprzez SageMaker JumpStart w interfejsie użytkownika SageMaker Studio i SageMaker Python SDK. W tej sekcji omówimy, jak odkryć modele w SageMaker Studio.

SageMaker Studio to zintegrowane środowisko programistyczne (IDE) zapewniające pojedynczy internetowy interfejs wizualny, w którym można uzyskać dostęp do specjalnie zaprojektowanych narzędzi umożliwiających wykonanie wszystkich etapów programowania ML, od przygotowania danych po budowanie, trenowanie i wdrażanie modeli ML. Aby uzyskać więcej informacji na temat rozpoczęcia i konfiguracji SageMaker Studio, zobacz Studio Amazon SageMaker.

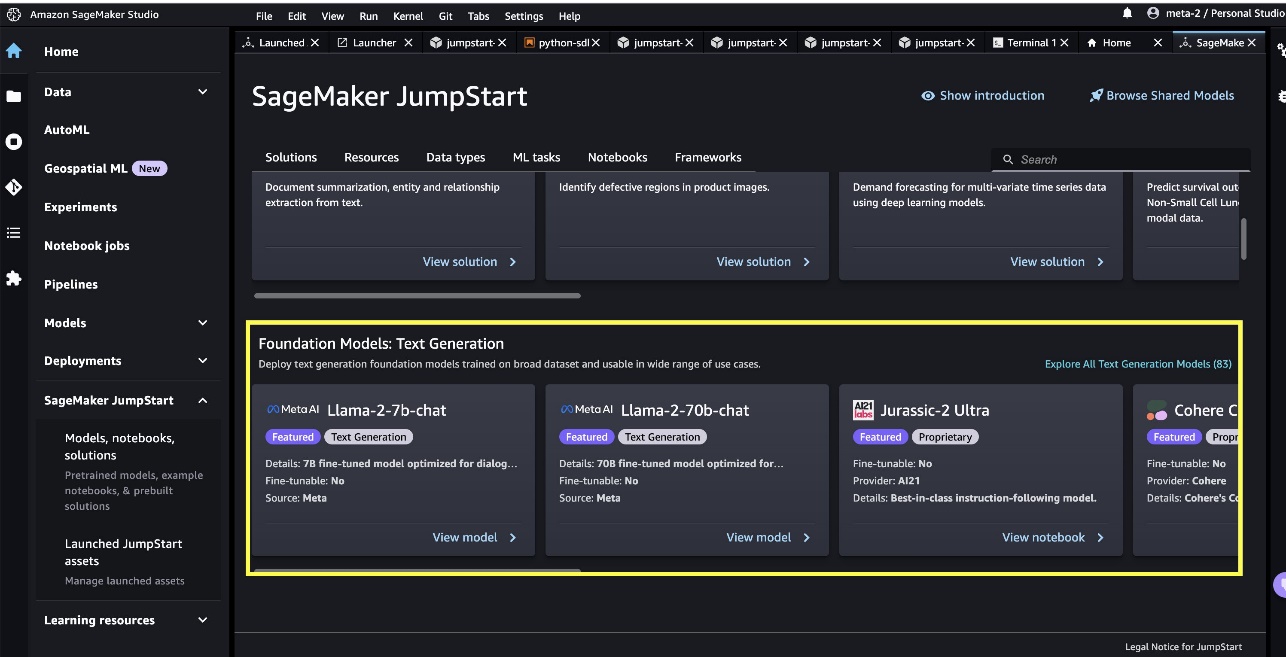

Po wejściu do SageMaker Studio możesz uzyskać dostęp do SageMaker JumpStart, który zawiera wstępnie wytrenowane modele, notatniki i gotowe rozwiązania, w zakładce Gotowe i zautomatyzowane rozwiązania.

Na stronie docelowej SageMaker JumpStart możesz przeglądać rozwiązania, modele, notatniki i inne zasoby. W ofercie znajdziesz dwa flagowe modele Llama 2 Modele fundamentów: Generowanie tekstu karuzela. Jeśli nie widzisz modeli Lamy 2, zaktualizuj wersję SageMaker Studio, wyłączając i uruchamiając ponownie. Aby uzyskać więcej informacji na temat aktualizacji wersji, zobacz Zamknij i zaktualizuj aplikacje Studio.

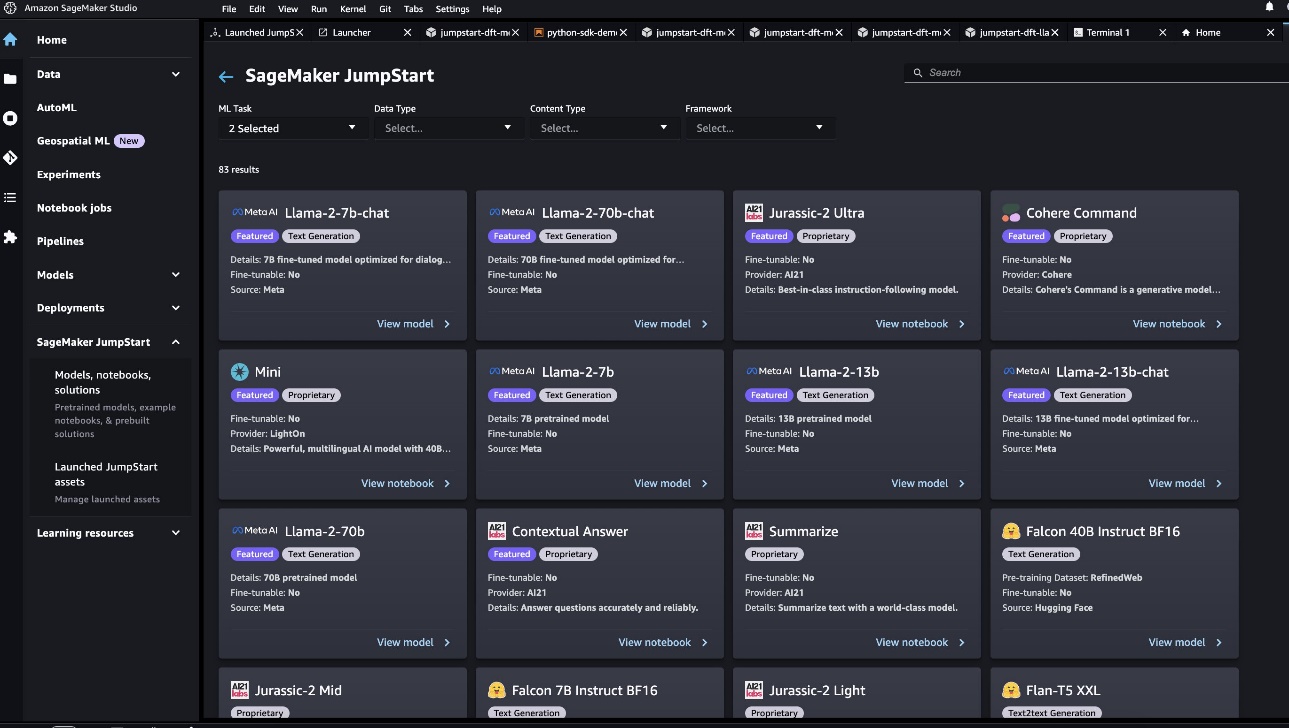

Wybierając, możesz znaleźć także pozostałe cztery warianty modelu Poznaj wszystkie modele generowania tekstu lub szukając llama w polu wyszukiwania.

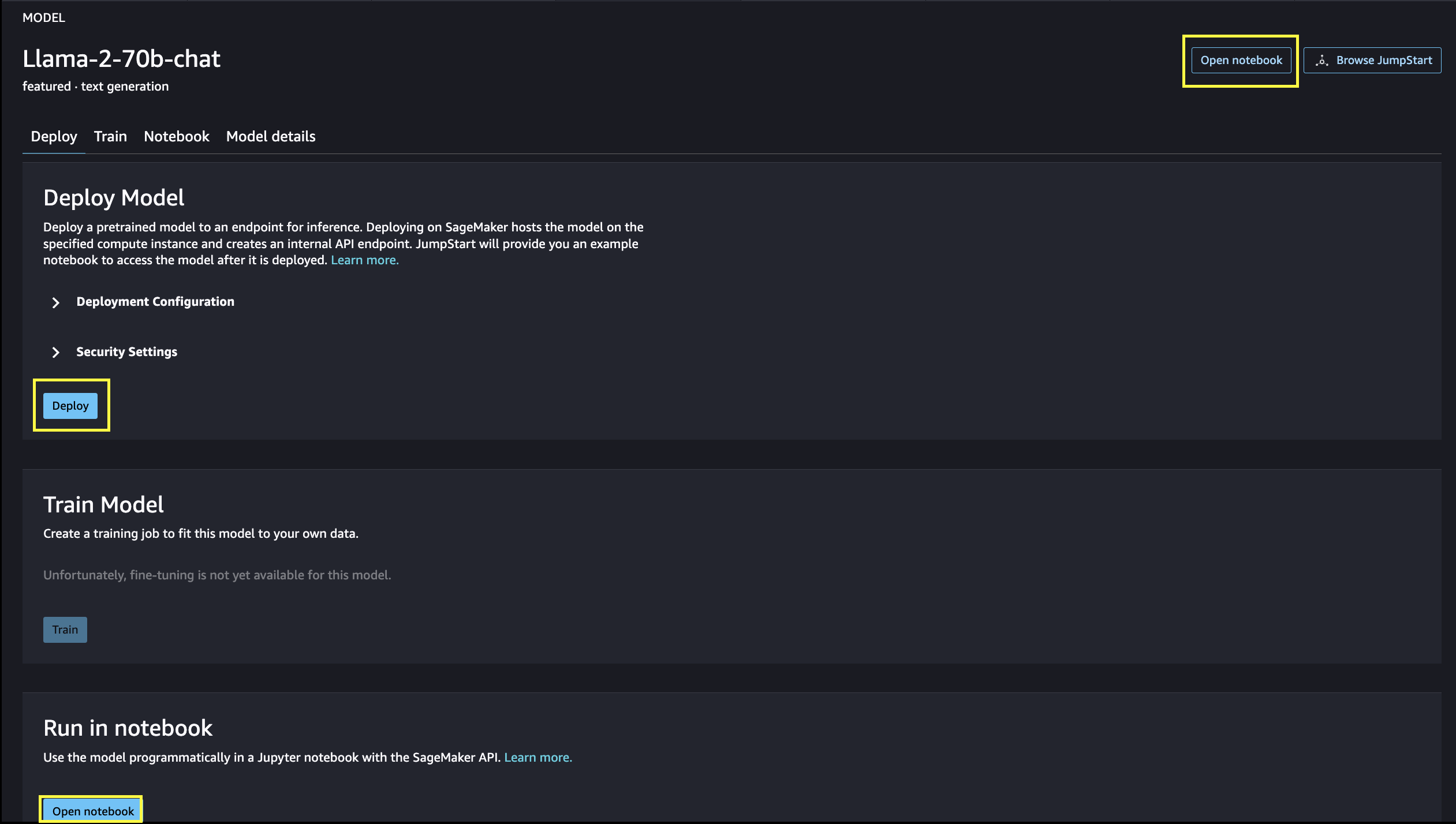

Możesz wybrać kartę modelu, aby wyświetlić szczegółowe informacje na temat modelu, takie jak licencja, dane użyte do szkolenia i sposób korzystania. Znajdują się tu także dwa przyciski, Rozmieścić i Otwórz notatnik, które ułatwiają korzystanie z modelu.

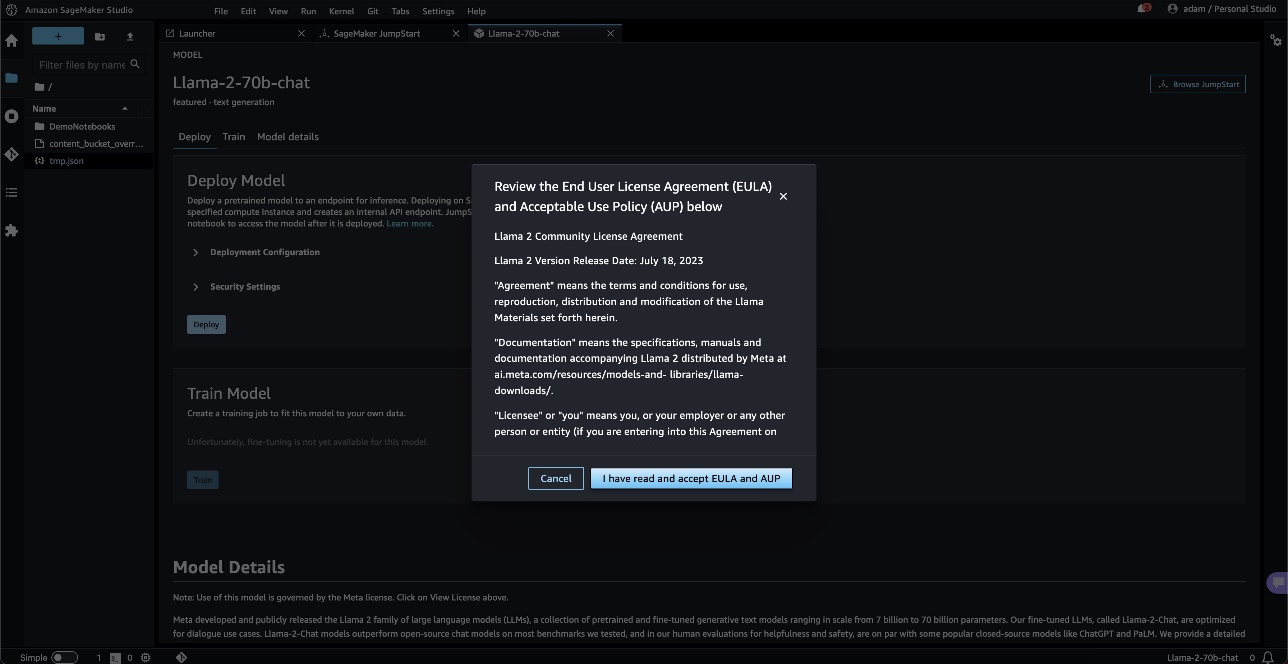

Po wybraniu dowolnego przycisku w wyskakującym okienku zostanie wyświetlona umowa licencyjna użytkownika końcowego i zasady dopuszczalnego użytkowania, które należy potwierdzić.

Po potwierdzeniu przejdziesz do następnego kroku, aby użyć modelu.

Wdróż model

Kiedy wybierzesz Rozmieścić i zaakceptuj warunki, rozpocznie się wdrażanie modelu. Alternatywnie możesz wdrożyć za pomocą przykładowego notesu, który pojawi się, wybierając Otwórz notatnik. Przykładowy notes zawiera kompleksowe wskazówki dotyczące wdrażania modelu na potrzeby wnioskowania i czyszczenia zasobów.

Aby wdrożyć za pomocą notebooka, zaczynamy od wybrania odpowiedniego modelu, określonego przez model_id. Możesz wdrożyć dowolny z wybranych modeli w SageMaker za pomocą następującego kodu:

Spowoduje to wdrożenie modelu w SageMaker z domyślnymi konfiguracjami, w tym domyślnym typem instancji i domyślnymi konfiguracjami VPC. Można zmienić te konfiguracje, określając wartości inne niż domyślne w Model JumpStart. Po wdrożeniu możesz uruchomić wnioskowanie na temat wdrożonego punktu końcowego za pomocą predyktora SageMaker:

Dopracowane modele czatów (Llama-2-7b-chat, Llama-2-13b-chat, Llama-2-70b-chat) akceptują historię rozmów pomiędzy użytkownikiem a asystentem czatu i generują kolejny czat. Wstępnie wytrenowane modele (Llama-2-7b, Llama-2-13b, Llama-2-70b) wymagają podpowiedzi w postaci ciągu znaków i wykonują uzupełnianie tekstu w podanym wierszu zachęty. Zobacz następujący kod:

Pamiętaj, że domyślnie accept_eula ma wartość false. Musisz ustawić accept_eula=true aby pomyślnie wywołać punkt końcowy. Robiąc to, akceptujesz umowę licencyjną użytkownika i zasady dopuszczalnego użytkowania, jak wspomniano wcześniej. Możesz również pobieranie umowę licencyjną.

Custom_attributes używane do przekazywania umowy EULA to pary klucz/wartość. Klucz i wartość są oddzielone znakiem = i pary są oddzielone przez ;. Jeśli użytkownik przekaże ten sam klucz więcej niż raz, ostatnia wartość zostanie zachowana i przekazana do procedury obsługi skryptu (tj. w tym przypadku używanej w logice warunkowej). Na przykład, jeśli accept_eula=false; accept_eula=true jest następnie przesyłany do serwera accept_eula=true jest zachowywany i przekazywany do procedury obsługi skryptu.

Parametry wnioskowania kontrolują proces generowania tekstu w punkcie końcowym. Maksymalna kontrola nowych tokenów odnosi się do wielkości wyjścia generowanego przez model. Należy pamiętać, że nie jest to to samo, co liczba słów, ponieważ słownictwo modelu nie jest takie samo jak słownictwo języka angielskiego, a każdy token może nie być słowem w języku angielskim. Temperatura kontroluje losowość sygnału wyjściowego. Wyższa temperatura skutkuje bardziej kreatywnymi i halucynacyjnymi wynikami. Wszystkie parametry wnioskowania są opcjonalne.

Poniższa tabela zawiera listę wszystkich modeli lam dostępnych w SageMaker JumpStart wraz z model_ids, domyślne typy instancji oraz maksymalną liczbę tokenów ogółem (suma liczby tokenów wejściowych i liczby wygenerowanych tokenów) obsługiwaną dla każdego z tych modeli.

| Nazwa modelu | ID modelu | Maksymalna suma tokenów | Domyślny typ instancji |

| Lama-2-7b | meta-textgeneracja-llama-2-7b | 4096 | ml.g5.2xduży |

| Lama-2-7b-czat | meta-textgeneracja-llama-2-7b-f | 4096 | ml.g5.2xduży |

| Lama-2-13b | meta-textgeneracja-llama-2-13b | 4096 | ml.g5.12xduży |

| Lama-2-13b-czat | meta-textgeneracja-llama-2-13b-f | 4096 | ml.g5.12xduży |

| Lama-2-70b | meta-textgeneracja-llama-2-70b | 4096 | ml.g5.48xduży |

| Lama-2-70b-czat | meta-textgeneracja-llama-2-70b-f | 4096 | ml.g5.48xduży |

Należy pamiętać, że punkty końcowe SageMaker mają limit czasu wynoszący 60 sekund. Zatem nawet jeśli model może wygenerować 4096 tokenów, jeśli generowanie tekstu zajmie więcej niż 60 s, żądanie zakończy się niepowodzeniem. W przypadku modeli 7B, 13B i 70B zalecamy ustawienie max_new_tokens nie większej niż odpowiednio 1500, 1000 i 500, przy zachowaniu łącznej liczby tokenów mniejszej niż 4K.

Wnioskowanie i przykładowe monity dla Lamy-2-70b

Możesz użyć modeli lamy do uzupełnienia tekstu dla dowolnego fragmentu tekstu. Dzięki generowaniu tekstu możesz wykonywać różnorodne zadania, takie jak odpowiadanie na pytania, tłumaczenie językowe, analiza nastrojów i wiele innych. Ładunek wejściowy do punktu końcowego wygląda jak następujący kod:

Poniżej znajdują się przykładowe monity i tekst wygenerowany przez model. Wszystkie dane wyjściowe są generowane z parametrami wnioskowania {"max_new_tokens":256, "top_p":0.9, "temperature":0.6}.

W następnym przykładzie pokazujemy, jak używać modeli Lamy z kilkukrotnym uczeniem się w kontekście, gdzie udostępniamy próbki szkoleniowe dostępne dla modelu. Należy pamiętać, że wyciągamy wnioski tylko na podstawie wdrożonego modelu i podczas tego procesu wagi modeli nie ulegają zmianie.

Wnioskowanie i przykładowe monity dla czatu Llama-2-70b

W przypadku modeli Llama-2-Chat, które są zoptymalizowane pod kątem zastosowań dialogowych, danymi wejściowymi do punktów końcowych modelu czatu jest poprzednia historia pomiędzy asystentem czatu a użytkownikiem. Możesz zadawać pytania kontekstowe w związku z dotychczasową rozmową. Możesz także podać konfigurację systemu, np. persony definiujące zachowanie asystenta czatu. Ładunek wejściowy do punktu końcowego wygląda jak następujący kod:

Poniżej znajdują się przykładowe monity i tekst wygenerowany przez model. Wszystkie dane wyjściowe są generowane z parametrami wnioskowania {"max_new_tokens": 512, "top_p": 0.9, "temperature": 0.6}.

W poniższym przykładzie użytkownik rozmawiał z asystentem na temat atrakcji turystycznych w Paryżu. Następnie użytkownik pyta o pierwszą opcję rekomendowaną przez asystenta czatu.

W poniższych przykładach ustalamy konfigurację systemu:

Sprzątać

Po zakończeniu uruchamiania notesu pamiętaj o usunięciu wszystkich zasobów, aby wszystkie zasoby utworzone w procesie zostały usunięte, a rozliczenia zostały zatrzymane:

Wnioski

W tym poście pokazaliśmy, jak rozpocząć pracę z modelami Llama 2 w SageMaker Studio. Dzięki temu masz dostęp do sześciu modeli fundamentów Llama 2, które zawierają miliardy parametrów. Ponieważ modele podstawowe są wstępnie wytrenowane, mogą również pomóc w obniżeniu kosztów szkoleń i infrastruktury oraz umożliwić dostosowanie do konkretnego przypadku użycia. Aby rozpocząć korzystanie z SageMaker JumpStart, odwiedź następujące zasoby:

O autorach

Wygrana czerwca jest menedżerem produktu w SageMaker JumpStart. Koncentruje się na ułatwianiu odkrywania i wykorzystywania modeli podstawowych, aby pomóc klientom w tworzeniu generatywnych aplikacji AI. Jego doświadczenie w Amazon obejmuje także aplikację do zakupów mobilnych i dostawę „ostatniej mili”.

Wygrana czerwca jest menedżerem produktu w SageMaker JumpStart. Koncentruje się na ułatwianiu odkrywania i wykorzystywania modeli podstawowych, aby pomóc klientom w tworzeniu generatywnych aplikacji AI. Jego doświadczenie w Amazon obejmuje także aplikację do zakupów mobilnych i dostawę „ostatniej mili”.

Dr Vivek Madan jest naukowcem w zespole Amazon SageMaker JumpStart. Uzyskał doktorat na Uniwersytecie Illinois w Urbana-Champaign i był badaczem podoktoranckim w Georgia Tech. Jest aktywnym badaczem w dziedzinie uczenia maszynowego i projektowania algorytmów. Publikował artykuły na konferencjach EMNLP, ICLR, COLT, FOCS i SODA.

Dr Vivek Madan jest naukowcem w zespole Amazon SageMaker JumpStart. Uzyskał doktorat na Uniwersytecie Illinois w Urbana-Champaign i był badaczem podoktoranckim w Georgia Tech. Jest aktywnym badaczem w dziedzinie uczenia maszynowego i projektowania algorytmów. Publikował artykuły na konferencjach EMNLP, ICLR, COLT, FOCS i SODA.  dr Kyle Ulrich jest naukowcem stosowanym w zespole Amazon SageMaker JumpStart. Jego zainteresowania badawcze obejmują skalowalne algorytmy uczenia maszynowego, wizję komputerową, szeregi czasowe, nieparametrykę Bayesa i procesy Gaussa. Jego doktorat uzyskał na Duke University i opublikował artykuły w czasopismach NeurIPS, Cell i Neuron.

dr Kyle Ulrich jest naukowcem stosowanym w zespole Amazon SageMaker JumpStart. Jego zainteresowania badawcze obejmują skalowalne algorytmy uczenia maszynowego, wizję komputerową, szeregi czasowe, nieparametrykę Bayesa i procesy Gaussa. Jego doktorat uzyskał na Duke University i opublikował artykuły w czasopismach NeurIPS, Cell i Neuron.  Dr Ashish Khetan jest starszym naukowcem w Amazon SageMaker JumpStart i pomaga opracowywać algorytmy uczenia maszynowego. Stopień doktora uzyskał na Uniwersytecie Illinois w Urbana-Champaign. Jest aktywnym badaczem w dziedzinie uczenia maszynowego i wnioskowania statystycznego. Opublikował wiele artykułów na konferencjach NeurIPS, ICML, ICLR, JMLR, ACL i EMNLP.

Dr Ashish Khetan jest starszym naukowcem w Amazon SageMaker JumpStart i pomaga opracowywać algorytmy uczenia maszynowego. Stopień doktora uzyskał na Uniwersytecie Illinois w Urbana-Champaign. Jest aktywnym badaczem w dziedzinie uczenia maszynowego i wnioskowania statystycznego. Opublikował wiele artykułów na konferencjach NeurIPS, ICML, ICLR, JMLR, ACL i EMNLP.  Sundara Ranganathana jest globalnym szefem specjalistów GenAI/Frameworks GTM w AWS. Koncentruje się na opracowywaniu strategii GTM dla dużych modeli językowych, GenAI i dużych obciążeń ML w usługach AWS, takich jak Amazon EC2, EKS, EFA, AWS Batch i Amazon SageMaker. Jego doświadczenie obejmuje role kierownicze w zarządzaniu produktami i ich rozwoju w NetApp, Micron Technology, Qualcomm i Mentor Graphics.

Sundara Ranganathana jest globalnym szefem specjalistów GenAI/Frameworks GTM w AWS. Koncentruje się na opracowywaniu strategii GTM dla dużych modeli językowych, GenAI i dużych obciążeń ML w usługach AWS, takich jak Amazon EC2, EKS, EFA, AWS Batch i Amazon SageMaker. Jego doświadczenie obejmuje role kierownicze w zarządzaniu produktami i ich rozwoju w NetApp, Micron Technology, Qualcomm i Mentor Graphics.

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- PlatoData.Network Pionowe generatywne AI. Wzmocnij się. Dostęp tutaj.

- PlatoAiStream. Inteligencja Web3. Wiedza wzmocniona. Dostęp tutaj.

- PlatonESG. Motoryzacja / pojazdy elektryczne, Węgiel Czysta technologia, Energia, Środowisko, Słoneczny, Gospodarowanie odpadami. Dostęp tutaj.

- Przesunięcia bloków. Modernizacja własności offsetu środowiskowego. Dostęp tutaj.

- Źródło: https://aws.amazon.com/blogs/machine-learning/llama-2-foundation-models-from-meta-are-now-available-in-amazon-sagemaker-jumpstart/

- :ma

- :Jest

- :nie

- :Gdzie

- $W GÓRĘ

- 1

- 10

- 100

- 11

- 13

- 15%

- 17

- 19

- 20

- 30

- 31

- 33

- Stopień 360

- 40

- 4k

- 500

- 7

- 70

- 8

- 9

- a

- Zdolny

- O nas

- Akceptuj

- do przyjęcia

- dostęp

- dostępność

- dostępny

- Stosownie

- uznać

- w poprzek

- aktywny

- Dodaj

- dodanie

- Dodatkowy

- adres

- Po

- ponownie

- przed

- Umowa

- AI

- algorytm

- Algorytmy

- wyrównać

- Wszystkie kategorie

- dopuszczać

- wzdłuż

- również

- zawsze

- am

- Amazonka

- Amazon EC2

- Amazon Sage Maker

- Amazon SageMaker JumpStart

- Studio Amazon SageMaker

- Amazon Web Services

- amerykański

- an

- analiza

- i

- i infrastruktura

- Ogłosić

- Inne

- odpowiedź

- każdy

- ktoś

- Zastosowanie

- aplikacje

- stosowany

- doceniać

- właściwy

- Łuk

- architektura

- SĄ

- Sztuka

- AS

- pomagać

- Asystent

- At

- Atmosfera

- atrakcje

- zautomatyzowane

- dostępny

- AWS

- Banan

- podstawowy

- Bitwa

- Bayesian

- BE

- piękny

- Uroda

- stał

- bo

- stają się

- być

- piwo

- zanim

- zachowanie

- Beijing

- uwierzyć

- Uważa

- BEST

- pomiędzy

- billing

- Miliard

- miliardy

- Czarny

- Pudełko

- przerwa

- zapierający dech

- szeroki

- budować

- Budowanie

- wybudowany

- ale

- przycisk

- by

- nazywa

- CAN

- kapitał

- wózek

- karta

- karuzela

- walizka

- Etui

- CAT

- zmiana

- Czekolada

- Dodaj

- Wybierając

- Miasto

- klasyczny

- kod

- kolekcja

- połączony

- kombajny

- byliśmy spójni, od początku

- przyjście

- handlowy

- sukcesy firma

- ukończenia

- komputer

- Wizja komputerowa

- konferencje

- pewność

- systemu

- za

- stały

- Budowa

- zawierać

- Pojemnik

- zawiera

- zawartość

- kontekstowy

- kontynuować

- bez przerwy

- kontrola

- kontroli

- Wygodny

- Rozmowa

- Koszty:

- kraj

- odwaga

- pokrywa

- Stwórz

- stworzony

- Twórczy

- kulturalny

- kultura

- Kubek

- Klientów

- dostosowywanie

- dostosować

- dane

- bezpieczeństwo danych

- dedykowane

- poświęcenie

- Domyślnie

- określić

- dostawa

- rozwijać

- wdrażane

- wdrażanie

- Wdrożenie

- wdraża się

- Wnętrze

- zaprojektowany

- życzenia

- miejsce przeznaczenia

- Cele podróży

- detale

- rozwijać

- rozwinięty

- Deweloper

- rozwijanie

- oprogramowania

- Dialog

- różnica

- różne

- trudny

- odkryj

- charakterystyczny

- do

- dokumentalne

- robi

- zrobić

- nie

- podwojona

- na dół

- Książę

- uniwersytet książęcy

- podczas

- e

- każdy

- Wcześniej

- z łatwością

- łatwo

- Edward

- Einstein

- bądź

- umożliwiać

- umożliwiając

- zakończenia

- koniec końców

- Punkt końcowy

- Inżynieria

- Angielski

- cieszyć się

- dość

- zapewnić

- Środowisko

- sprzęt

- Eter

- Parzyste

- wydarzenia

- wszyscy

- przykład

- przykłady

- podniecony

- doświadczenie

- eksperyment

- eksperymenty

- ekspresowy

- FAIL

- Failed

- sprawiedliwy

- fałszywy

- członków Twojej rodziny

- sławny

- daleko

- wyczyn

- polecane

- Korzyści

- informacja zwrotna

- stopy

- kilka

- filmy

- finał

- W końcu

- Znajdź

- i terminów, a

- flagowy

- pływak

- Przepływy

- koncentruje

- następujący

- W razie zamówieenia projektu

- Naprzód

- znaleziono

- Fundacja

- cztery

- Francja

- francuski

- od

- w pełni

- dalej

- przyszłość

- Ogólne

- Generować

- wygenerowane

- generacja

- generatywny

- generatywna sztuczna inteligencja

- otrzymać

- Dać

- szkło

- Globalne

- Go

- będzie

- grafika

- wspaniały

- większy

- przełomowy

- Rosnąć

- poradnictwo

- poprowadzi

- miał

- Uchwyty

- się

- Zaoszczędzić

- Ciężko

- ciężka praca

- Have

- mający

- he

- głowa

- pomoc

- pomoc

- pomaga

- tutaj

- hi

- Wysoki

- wyższy

- jego

- historyczny

- historia

- obudowa

- W jaki sposób

- How To

- HTML

- HTTPS

- Piasta

- człowiek

- i

- ikoniczny

- pomysł

- if

- ii

- Illinois

- Rezultat

- importować

- ważny

- imponujący

- in

- zawierać

- obejmuje

- Włącznie z

- Rejestrowy

- Informacja

- Infrastruktura

- początkowo

- wkład

- inspirowane

- inspirującym

- przykład

- natychmiast

- instrukcje

- zintegrowany

- zamierzony

- zainteresowania

- Interfejs

- najnowszych

- odosobniony

- IT

- JEGO

- podróż

- jpg

- właśnie

- konserwacja

- trzymane

- Klawisz

- Uprzejmy

- Wiedzieć

- znany

- lądowanie

- punkt orientacyjny

- język

- duży

- na dużą skalę

- największym

- Nazwisko

- Późno

- uruchomić

- Laws

- Przywództwo

- UCZYĆ SIĘ

- Ucz się i rozwijaj

- nauka

- najmniej

- mniej

- poziomy

- Licencja

- życie

- lekki

- lubić

- LIMIT

- wykazy

- literatura

- ll

- Lama

- logika

- długo

- długi czas

- poszukuje

- WYGLĄD

- miłość

- "kochanym"

- niższy

- maszyna

- uczenie maszynowe

- zrobiony

- robić

- WYKONUJE

- Dokonywanie

- i konserwacjami

- kierownik

- wiele

- cud

- Materia

- maksymalny

- Może..

- znaczenie

- zmierzyć

- Media

- średni

- wzmiankowany

- wiadomość

- Meta

- mikron

- chwila

- minut

- mieszanina

- ML

- MLOps

- Aplikacje mobilne

- model

- modele

- moment

- miesięcy

- jeszcze

- większość

- Najbardziej popularne posty

- ruch

- film

- dużo

- muzeum

- Muzea

- Muzyka

- Nazwa

- Naturalny

- niezbędny

- Potrzebować

- potrzebne

- sieć

- Nowości

- I Love New York

- Następny

- Nie

- notatnik

- już dziś

- numer

- liczny

- NY

- of

- oferta

- oferuje

- Oferty

- Olej

- on

- pewnego razu

- ONE

- tylko

- koncepcja

- open source

- Optymalizacja

- zoptymalizowane

- Option

- or

- Inne

- Pozostałe

- Inaczej

- ludzkiej,

- na zewnątrz

- wydajność

- koniec

- ogólny

- strona

- par

- Papier

- Papiery

- parametr

- parametry

- Paryż

- część

- przechodzić

- minęło

- przebiegi

- Przeszłość

- pokój

- wykonać

- jest gwarancją najlepszej jakości, które mogą dostarczyć Ci Twoje monitory,

- stały

- telefon

- fotografie

- Fizyka

- kawałek

- Pizza

- Plastikowy

- plato

- Analiza danych Platona

- PlatoDane

- grał

- polityka

- pop-up

- Popularny

- Post

- za pośrednictwem tradycyjnej poczty

- Urządzenie prognozujące

- preferencje

- przygotowanie

- teraźniejszość

- poprzedni

- wygląda tak

- procesów

- Produkt

- rozwój produktów

- zarządzanie produktem

- product manager

- Propozycje

- dumny

- zapewniać

- pod warunkiem,

- zapewnia

- że

- publiczny

- transport publiczny

- publicznie

- opublikowany

- cel

- położyć

- Python

- Qualcomm

- pytania

- Szybki

- szybko

- Rampy

- przypadkowość

- zasięg

- nośny

- gotowy

- Przyczyny

- otrzymać

- Przepis

- polecić

- Zalecana

- odnosi

- Bez względu

- regiony

- względny

- względność

- powtórzony

- reprezentować

- zażądać

- Wymaga

- Badania naukowe

- badacz

- Zasoby

- odpowiednio

- Odpowiadać

- REST

- dalsze

- Efekt

- Rzeka

- Rola

- role

- run

- bieganie

- s

- Bezpieczeństwo

- sagemaker

- sól

- taki sam

- skalowalny

- Skala

- Naukowiec

- Naukowcy

- Sdk

- SEA

- Szukaj

- poszukiwania

- Sekcja

- bezpieczne

- bezpieczeństwo

- widzieć

- widzenie

- wydawało się

- wybrany

- wybierając

- wybór

- wysłać

- senior

- sentyment

- Serie

- Usługi

- służąc

- zestaw

- ustawienie

- Shape

- rekin

- Zakupy

- powinien

- pokazać

- pokazał

- Targi

- wyłączania

- znaczenie

- znaczący

- Prosty

- po prostu

- pojedynczy

- witryna internetowa

- Witryny

- SIX

- Rozmiar

- Powoli

- mały

- So

- dotychczas

- Obserwuj Nas

- Media społecznościowe

- Rozwiązania

- kilka

- Źródło

- Źródła

- specjalny

- Specjaliści

- określony

- prędkość

- stojaki

- początek

- rozpoczęty

- Stan

- Zjednoczone

- statystyczny

- Ewolucja krok po kroku

- Cel

- zatrzymany

- Strategia

- sznur

- Struktura

- studio

- Oszałamiający

- przedmiot

- kolejny

- sukces

- Z powodzeniem

- taki

- Utrzymany

- pewnie

- symbol

- system

- stół

- Brać

- trwa

- zadania

- klucze

- zespół

- tech

- Technologia

- tymczasowy

- REGULAMIN

- niż

- Podziękowania

- że

- Połączenia

- Stolica

- Przyszłość

- Źródło

- świat

- ich

- Im

- teoria

- Tam.

- Te

- one

- rzeczy

- myśleć

- to

- chociaż?

- Przez

- Tygrys

- czas

- Szereg czasowy

- czasy

- Tytuł

- do

- już dziś

- razem

- żeton

- Żetony

- narzędzia

- Top

- Kwota produktów:

- Wieża

- Pociąg

- Trening

- transformator

- tłumaczyć

- Tłumaczenie

- transport

- Trylion

- próbować

- drugiej

- rodzaj

- typy

- ui

- dla

- niezapomniany

- wyjątkowy

- uniwersytet

- aż do

- Aktualizacja

- Nowości

- nadający się do użytku

- posługiwać się

- przypadek użycia

- używany

- Użytkownik

- Użytkownicy

- zastosowania

- za pomocą

- wartość

- Wartości

- różnorodność

- wersja

- Wersje

- początku.

- przez

- Zobacz i wysłuchaj

- widoki

- wizja

- Odwiedzić

- odwiedzający

- Tom

- poszukiwany

- wojna

- była

- we

- sieć

- usługi internetowe

- Web-based

- Strona internetowa

- DOBRZE

- Wieloryb

- Co

- Co to jest

- jeśli chodzi o komunikację i motywację

- natomiast

- który

- Podczas

- dlaczego

- będzie

- okna

- w

- słowo

- słowa

- Praca

- działa

- świat

- światowej sławy

- owinąć

- lat

- york

- You

- Twój

- siebie

- zefirnet

- Zamek błyskawiczny