Amazon Sage Maker ułatwia wdrażanie modeli uczenia maszynowego (ML) na potrzeby wnioskowania w czasie rzeczywistym i oferuje szeroki wybór instancji ML obejmujących procesory i akceleratory, takie jak Inferencja AWS. Dzięki w pełni zarządzanej usłudze możesz skalować wdrożenia modeli, minimalizować koszty wnioskowania i efektywniej zarządzać modelami w środowisku produkcyjnym, przy zmniejszonym obciążeniu operacyjnym. Punkt końcowy wnioskowania w czasie rzeczywistym SageMaker składa się z punktu końcowego HTTP i instancji ML wdrożonych w wielu strefach dostępności w celu zapewnienia wysokiej dostępności. SageMaker automatyczne skalowanie aplikacji może dynamicznie dostosowywać liczbę instancji ML udostępnionych dla modelu w odpowiedzi na zmiany obciążenia. Punkt końcowy równomiernie dystrybuuje przychodzące żądania do instancji ML przy użyciu algorytmu okrężnego.

Gdy modele uczenia maszynowego wdrożone w instancjach odbierają wywołania API od dużej liczby klientów, losowa dystrybucja żądań może działać bardzo dobrze, gdy nie ma dużej zmienności w żądaniach i odpowiedziach. Jednak w systemach z generatywnymi obciążeniami AI żądania i odpowiedzi mogą być niezwykle zmienne. W takich przypadkach często pożądane jest równoważenie obciążenia poprzez uwzględnienie pojemności i wykorzystania instancji, a nie losowe równoważenie obciążenia.

W tym poście omawiamy strategię routingu LOR (najmniej oczekujących żądań) SageMaker oraz sposób, w jaki może ona zminimalizować opóźnienia w przypadku niektórych typów obciążeń wnioskowania w czasie rzeczywistym, biorąc pod uwagę pojemność i wykorzystanie instancji ML. Mówimy o jego zaletach w porównaniu z domyślnym mechanizmem routingu oraz o tym, jak włączyć LOR dla wdrożeń modelu. Na koniec przedstawiamy analizę porównawczą poprawy opóźnień dzięki LOR w porównaniu z domyślną strategią routingu losowego.

Strategia SageMaker LOR

Domyślnie punkty końcowe SageMaker mają strategię losowego routingu. SageMaker obsługuje teraz strategię LOR, która pozwala SageMakerowi optymalnie kierować żądania do instancji, która najlepiej nadaje się do obsługi tego żądania. SageMaker umożliwia to poprzez monitorowanie obciążenia instancji za punktem końcowym oraz modeli lub komponentów wnioskowania wdrożonych w każdej instancji.

Poniższy interaktywny diagram przedstawia domyślne zasady routingu, w których żądania przychodzące do punktów końcowych modelu są przekazywane w sposób losowy do wystąpień ML.

Poniższy interaktywny diagram przedstawia strategię routingu, w której SageMaker przekieruje żądanie do instancji, która ma najmniejszą liczbę oczekujących żądań.

Ogólnie rzecz biorąc, routing LOR działa dobrze w przypadku modeli podstawowych lub generatywnych modeli AI, gdy model odpowiada w ciągu setek milisekund do minut. Jeśli odpowiedź Twojego modelu ma mniejsze opóźnienia (do setek milisekund), możesz zyskać więcej na losowym routingu. Niezależnie od tego zalecamy przetestowanie i określenie najlepszego algorytmu routingu dla Twoich obciążeń.

Jak ustawić strategie routingu SageMaker

SageMaker umożliwia teraz ustawienie RoutingStrategy parametr podczas tworzenia EndpointConfiguration dla punktów końcowych. Inny RoutingStrategy wartości obsługiwane przez SageMaker to:

LEAST_OUTSTANDING_REQUESTSRANDOM

Poniżej znajduje się przykładowe wdrożenie modelu w punkcie końcowym wnioskowania z włączoną funkcją LOR:

- Utwórz konfigurację punktu końcowego, ustawiając

RoutingStrategyasLEAST_OUTSTANDING_REQUESTS: - Utwórz punkt końcowy, korzystając z konfiguracji punktu końcowego (bez zmian):

Wyniki osiągów

Przeprowadziliśmy testy porównawcze wydajności, aby zmierzyć kompleksowe opóźnienie wnioskowania i przepustowość codegen2-7B model hostowany na instancjach ml.g5.24xl z domyślnym routingiem i inteligentnymi punktami końcowymi routingu. Model CodeGen2 należy do rodziny autoregresyjnych modeli językowych i generuje kod wykonywalny po otrzymaniu monitu w języku angielskim.

W naszej analizie zwiększyliśmy liczbę instancji ml.g5.24xl za każdym punktem końcowym dla każdego uruchomienia testu wraz ze wzrostem liczby jednoczesnych użytkowników, jak pokazano w poniższej tabeli.

| Testowanie | Liczba jednoczesnych użytkowników | Liczba instancji |

| 1 | 4 | 1 |

| 2 | 20 | 5 |

| 3 | 40 | 10 |

| 4 | 60 | 15 |

| 5 | 80 | 20 |

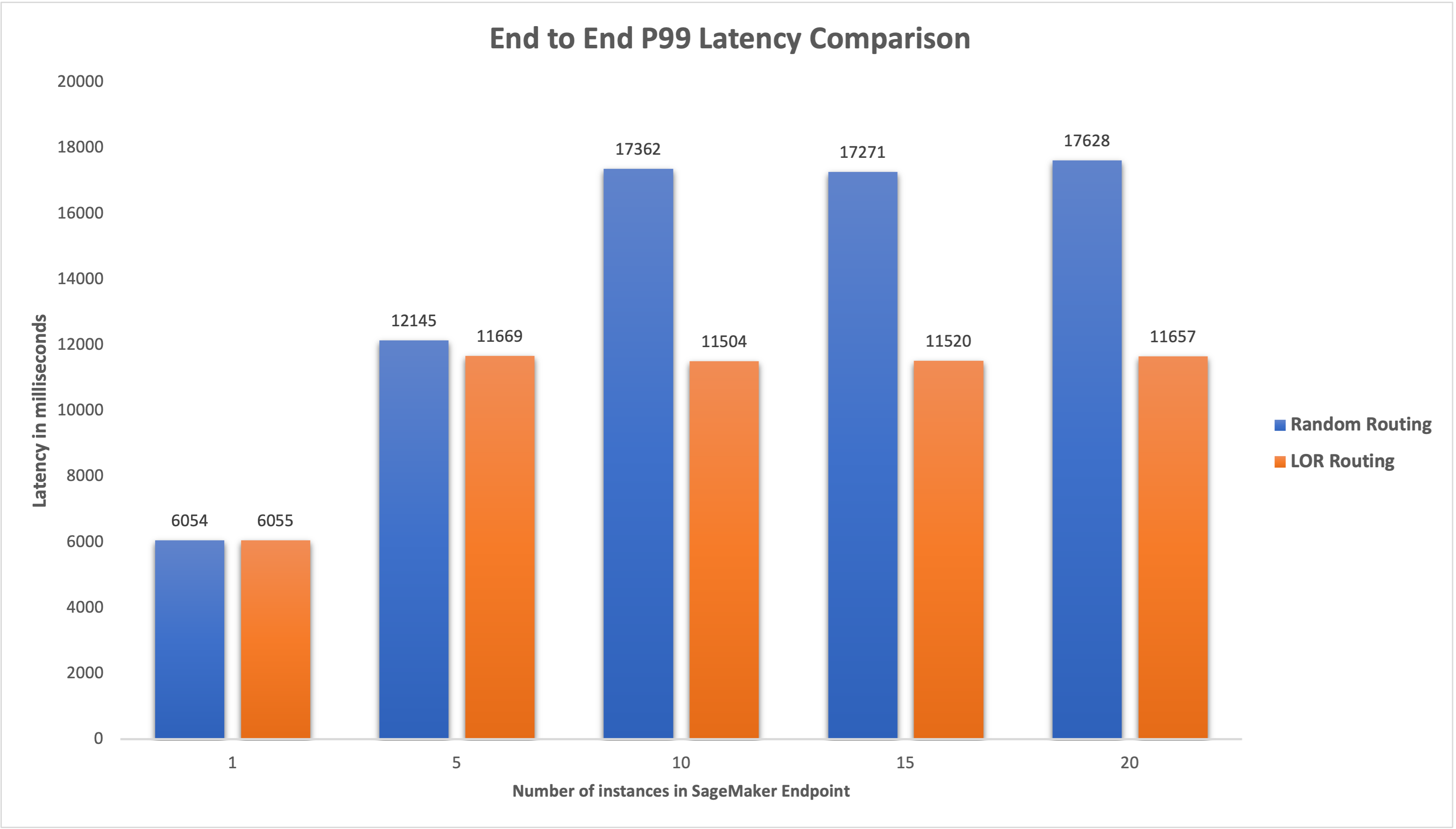

Zmierzyliśmy opóźnienie P99 od końca do końca dla obu punktów końcowych i zaobserwowaliśmy poprawę opóźnienia o 4–33%, gdy liczba instancji wzrosła z 5 do 20, jak pokazano na poniższym wykresie.

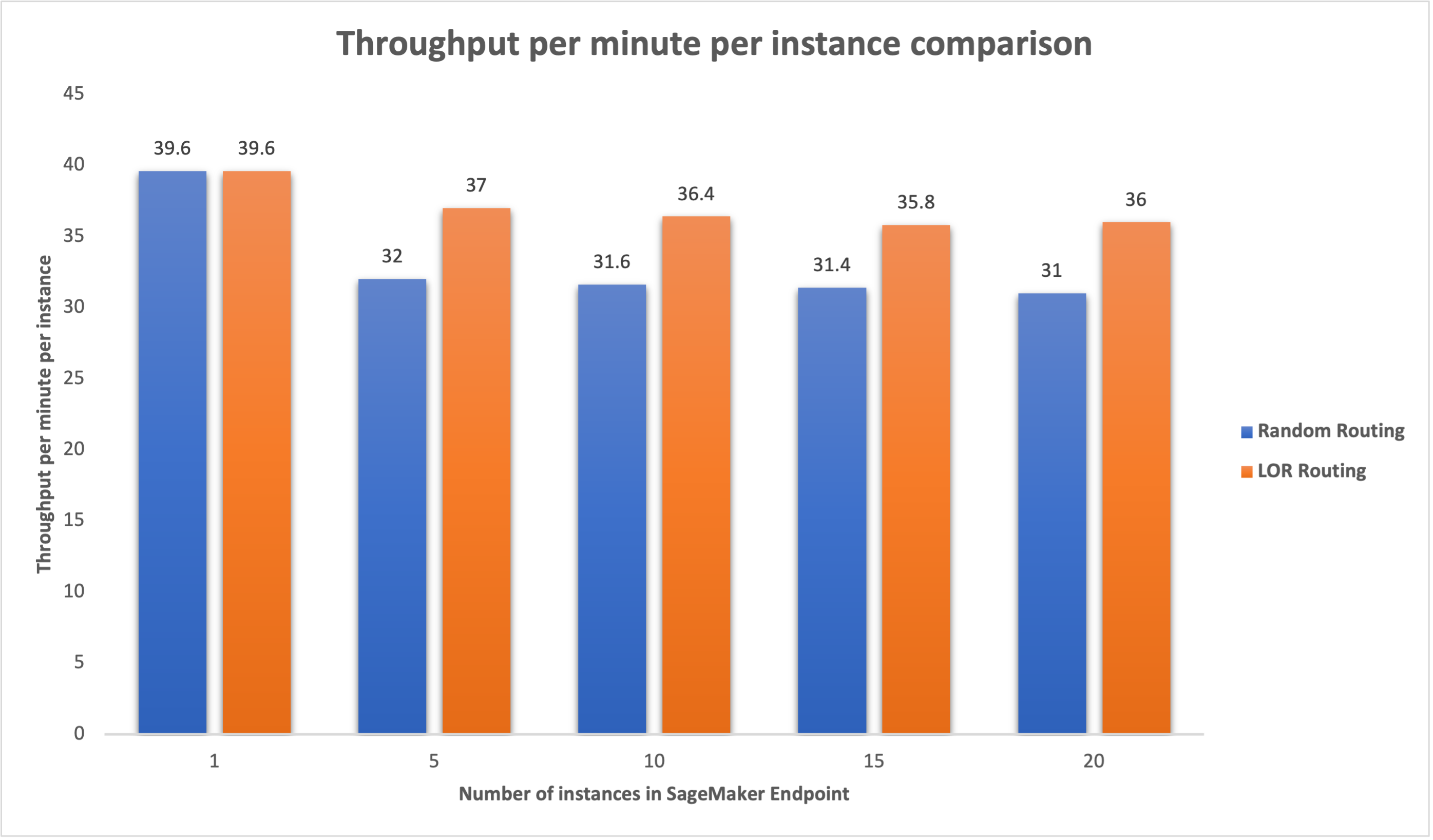

Podobnie zaobserwowaliśmy poprawę przepustowości na minutę na instancję o 15–16%, gdy liczba instancji wzrosła z 5 do 20.

To pokazuje, że inteligentny routing może poprawić dystrybucję ruchu pomiędzy punktami końcowymi, prowadząc do poprawy kompleksowych opóźnień i ogólnej przepustowości.

Wnioski

W tym poście wyjaśniliśmy strategie routingu SageMaker i nową opcję włączania routingu LOR. Wyjaśniliśmy, jak włączyć LOR i jakie korzyści może to przynieść wdrożeniu modelu. Nasze testy wydajności wykazały poprawę opóźnień i przepustowości podczas wnioskowania w czasie rzeczywistym. Aby dowiedzieć się więcej o funkcjach routingu SageMaker, zobacz dokumentacja. Zachęcamy do oceny obciążeń związanych z wnioskowaniem i ustalenia, czy strategia routingu jest optymalnie skonfigurowana.

O autorach

James Park jest architektem rozwiązań w Amazon Web Services. Współpracuje z Amazon.com przy projektowaniu, budowaniu i wdrażaniu rozwiązań technologicznych w AWS, a szczególnie interesuje się sztuczną inteligencją i uczeniem maszynowym. W wolnym czasie lubi szukać nowych kultur, nowych doświadczeń i być na bieżąco z najnowszymi trendami technologicznymi. Znajdziesz go na LinkedIn.

James Park jest architektem rozwiązań w Amazon Web Services. Współpracuje z Amazon.com przy projektowaniu, budowaniu i wdrażaniu rozwiązań technologicznych w AWS, a szczególnie interesuje się sztuczną inteligencją i uczeniem maszynowym. W wolnym czasie lubi szukać nowych kultur, nowych doświadczeń i być na bieżąco z najnowszymi trendami technologicznymi. Znajdziesz go na LinkedIn.

Venugopal Pai jest architektem rozwiązań w AWS. Mieszka w Bengaluru w Indiach i pomaga klientom z branży cyfrowej skalować i optymalizować ich aplikacje na platformie AWS.

Venugopal Pai jest architektem rozwiązań w AWS. Mieszka w Bengaluru w Indiach i pomaga klientom z branży cyfrowej skalować i optymalizować ich aplikacje na platformie AWS.

Dawid Nigenda jest starszym inżynierem ds. rozwoju oprogramowania w zespole Amazon SageMaker, obecnie pracującym nad udoskonaleniem przepływów pracy w zakresie uczenia maszynowego w środowisku produkcyjnym, a także nad uruchomieniem nowych funkcji wnioskowania. W wolnym czasie stara się dotrzymać kroku swoim dzieciom.

Dawid Nigenda jest starszym inżynierem ds. rozwoju oprogramowania w zespole Amazon SageMaker, obecnie pracującym nad udoskonaleniem przepływów pracy w zakresie uczenia maszynowego w środowisku produkcyjnym, a także nad uruchomieniem nowych funkcji wnioskowania. W wolnym czasie stara się dotrzymać kroku swoim dzieciom.

Deepti Ragha jest inżynierem rozwoju oprogramowania w zespole Amazon SageMaker. Jej obecna praca koncentruje się na budowaniu funkcji do efektywnego hostowania modeli uczenia maszynowego. W wolnym czasie lubi podróżować, wędrować i uprawiać rośliny.

Deepti Ragha jest inżynierem rozwoju oprogramowania w zespole Amazon SageMaker. Jej obecna praca koncentruje się na budowaniu funkcji do efektywnego hostowania modeli uczenia maszynowego. W wolnym czasie lubi podróżować, wędrować i uprawiać rośliny.

Alana Tana jest starszym menedżerem produktu w firmie SageMaker, kierując pracami nad wnioskowaniem na dużych modelach. Pasjonuje go zastosowanie uczenia maszynowego w obszarze analityki. Poza pracą lubi przebywać na świeżym powietrzu.

Alana Tana jest starszym menedżerem produktu w firmie SageMaker, kierując pracami nad wnioskowaniem na dużych modelach. Pasjonuje go zastosowanie uczenia maszynowego w obszarze analityki. Poza pracą lubi przebywać na świeżym powietrzu.

Dawal Patel jest głównym architektem uczenia maszynowego w AWS. Pracował z organizacjami od dużych przedsiębiorstw po średniej wielkości start-upy w zakresie problemów związanych z przetwarzaniem rozproszonym i sztuczną inteligencją. Koncentruje się na uczeniu głębokim, w tym w domenach NLP i Computer Vision. Pomaga klientom uzyskać wnioskowanie o wysokiej wydajności modelu w SageMaker.

Dawal Patel jest głównym architektem uczenia maszynowego w AWS. Pracował z organizacjami od dużych przedsiębiorstw po średniej wielkości start-upy w zakresie problemów związanych z przetwarzaniem rozproszonym i sztuczną inteligencją. Koncentruje się na uczeniu głębokim, w tym w domenach NLP i Computer Vision. Pomaga klientom uzyskać wnioskowanie o wysokiej wydajności modelu w SageMaker.

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- PlatoData.Network Pionowe generatywne AI. Wzmocnij się. Dostęp tutaj.

- PlatoAiStream. Inteligencja Web3. Wiedza wzmocniona. Dostęp tutaj.

- PlatonESG. Węgiel Czysta technologia, Energia, Środowisko, Słoneczny, Gospodarowanie odpadami. Dostęp tutaj.

- Platon Zdrowie. Inteligencja w zakresie biotechnologii i badań klinicznych. Dostęp tutaj.

- Źródło: https://aws.amazon.com/blogs/machine-learning/minimize-real-time-inference-latency-by-using-amazon-sagemaker-routing-strategies/

- :ma

- :Jest

- :nie

- :Gdzie

- $W GÓRĘ

- 1

- 100

- 125

- 150

- 17

- 1870

- 20

- 7

- 9

- a

- Zdolny

- O nas

- akceleratory

- Osiągać

- w poprzek

- AI

- Modele AI

- Alan

- algorytm

- pozwala

- Amazonka

- Amazon Sage Maker

- Amazon Web Services

- Amazon.com

- wśród

- an

- analiza

- analityka

- i

- api

- aplikacje

- Stosowanie

- SĄ

- POWIERZCHNIA

- sztuczny

- sztuczna inteligencja

- AS

- At

- samochód

- dostępność

- AWS

- Bilans

- równoważenie

- BE

- za

- należy

- Benchmarkingu

- korzyści

- Korzyści

- BEST

- obie

- szeroki

- budować

- Budowanie

- ciężar

- ale

- by

- Połączenia

- CAN

- Pojemność

- Etui

- pewien

- zmiana

- Zmiany

- klientów

- kod

- COM

- przyjście

- składniki

- komputer

- Wizja komputerowa

- computing

- równoległy

- systemu

- skonfigurowany

- wynagrodzenie

- wobec

- składa się

- Koszty:

- Tworzenie

- Aktualny

- Obecnie

- Klientów

- Data

- głęboko

- głęboka nauka

- Domyślnie

- rozwijać

- wdrażane

- Wdrożenie

- wdrożenia

- Wnętrze

- Ustalać

- oprogramowania

- różne

- dyskutować

- dystrybuowane

- przetwarzanie rozproszone

- 分配

- domeny

- podczas

- dynamicznie

- każdy

- faktycznie

- skutecznie

- starania

- umożliwiać

- włączony

- zachęcać

- koniec końców

- Punkt końcowy

- inżynier

- Angielski

- przedsiębiorstwa

- oceniać

- przykład

- Doświadczenia

- wyjaśnione

- niezwykle

- członków Twojej rodziny

- Korzyści

- W końcu

- Znajdź

- koncentruje

- następujący

- W razie zamówieenia projektu

- podstawowy

- od

- w pełni

- Ogólne

- generuje

- generatywny

- generatywna sztuczna inteligencja

- gif

- dany

- wykres

- Rozwój

- Have

- he

- pomaga

- jej

- Wysoki

- go

- jego

- gospodarz

- hostowane

- W jaki sposób

- How To

- HTML

- HTTPS

- Setki

- zidentyfikować

- if

- ilustruje

- podnieść

- poprawa

- ulepszenia

- poprawy

- in

- Włącznie z

- Przybywający

- wzrosła

- Indie

- przykład

- Inteligencja

- interaktywne

- odsetki

- najnowszych

- IT

- JEGO

- jpg

- Trzymać

- dzieci

- język

- duży

- Duże przedsiębiorstwa

- Utajenie

- firmy

- wodowanie

- prowadzący

- UCZYĆ SIĘ

- nauka

- najmniej

- Zyje

- załadować

- Partia

- niższy

- maszyna

- uczenie maszynowe

- WYKONUJE

- zarządzanie

- zarządzane

- kierownik

- sposób

- Może..

- zmierzyć

- mechanizm

- milisekund

- chwila

- minut

- ML

- model

- modele

- monitorowanie

- jeszcze

- wielokrotność

- Nowości

- nlp

- Nie

- już dziś

- numer

- of

- Oferty

- często

- on

- operacyjny

- Optymalizacja

- Option

- or

- organizacji

- ludzkiej,

- na zewnątrz

- na zewnątrz

- zewnętrzne

- wybitny

- koniec

- ogólny

- parametr

- szczególny

- namiętny

- dla

- jest gwarancją najlepszej jakości, które mogą dostarczyć Ci Twoje monitory,

- Rośliny

- plato

- Analiza danych Platona

- PlatoDane

- polityka

- możliwy

- Post

- teraźniejszość

- Główny

- problemy

- Produkt

- product manager

- Produkcja

- monity

- przypadkowy

- nośny

- raczej

- w czasie rzeczywistym

- otrzymać

- polecić

- Zredukowany

- odnosić się

- Bez względu

- związane z

- zażądać

- wywołań

- odpowiedź

- Odpowiedzi

- Trasa

- Routing

- run

- sagemaker

- Skala

- poszukuje

- wybór

- senior

- służyć

- usługa

- Usługi

- zestaw

- ustawienie

- ona

- pokazał

- pokazane

- Targi

- mądry

- Tworzenie

- rozwoju oprogramowania

- Rozwiązania

- napięcie

- Startups

- przebywający

- bezpośredni

- strategie

- Strategia

- taki

- Utrzymany

- podpory

- systemy

- stół

- biorąc

- Mówić

- zespół

- Technologia

- test

- Testy

- niż

- że

- Połączenia

- Strefa

- ich

- Tam.

- Te

- to

- wydajność

- czas

- do

- ruch drogowy

- Podróżowanie

- Trendy

- typy

- Użytkownicy

- za pomocą

- Wartości

- zmienna

- początku.

- wizja

- we

- sieć

- usługi internetowe

- DOBRZE

- były

- jeśli chodzi o komunikację i motywację

- który

- Podczas

- będzie

- w

- Praca

- pracował

- przepływów pracy

- pracujący

- działa

- You

- Twój

- zefirnet

- Strefy